连接人工智能与神经科学的桥梁:具有内部复杂性的神经网络模型|Nat. Comput. Sci. 速递

论文题目:Network model with internal complexity bridges artificial intelligence and neuroscience

论文地址:https://www.nature.com/articles/s43588-024-00674-9

期刊名称:Nature Computational Science

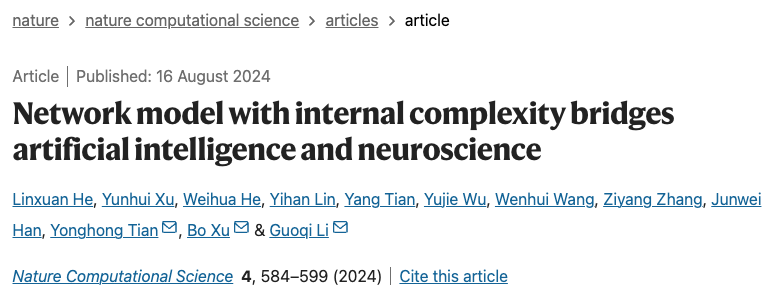

当今人工智能研究人员普遍认为,通用人工智能的构建需要依靠更深、更大规模和更泛化的神经网络模型。然而,这种外部复杂性高的大模型瓶颈也是显而易见:消耗过多算力,理解网络中神经元的行为十分困难。近期发表在Nature Computational Science 的一项研究,通过给单个神经元添加丰富的属性,构建了一种具有神经元内部复杂性的小模型,可与外部复杂性的大模型等效。

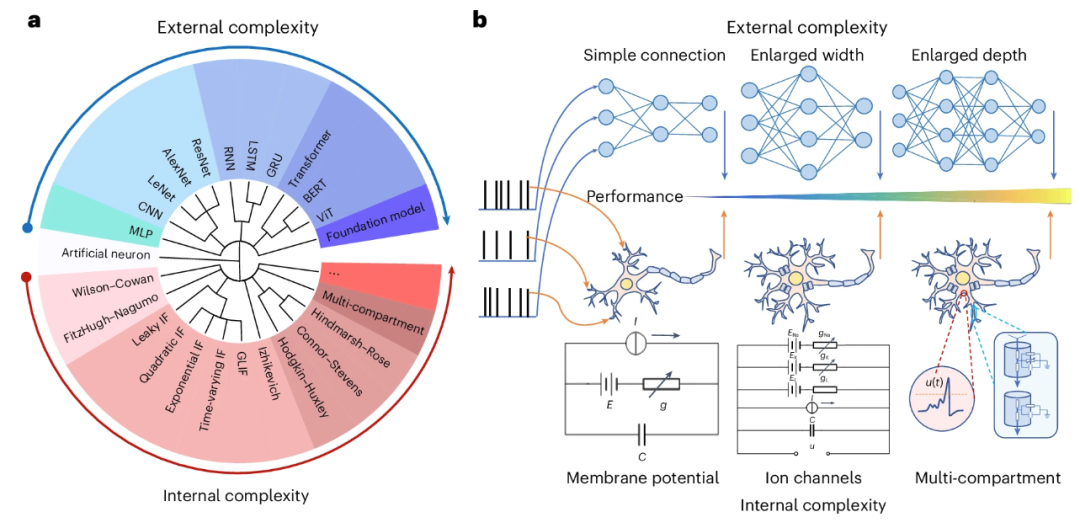

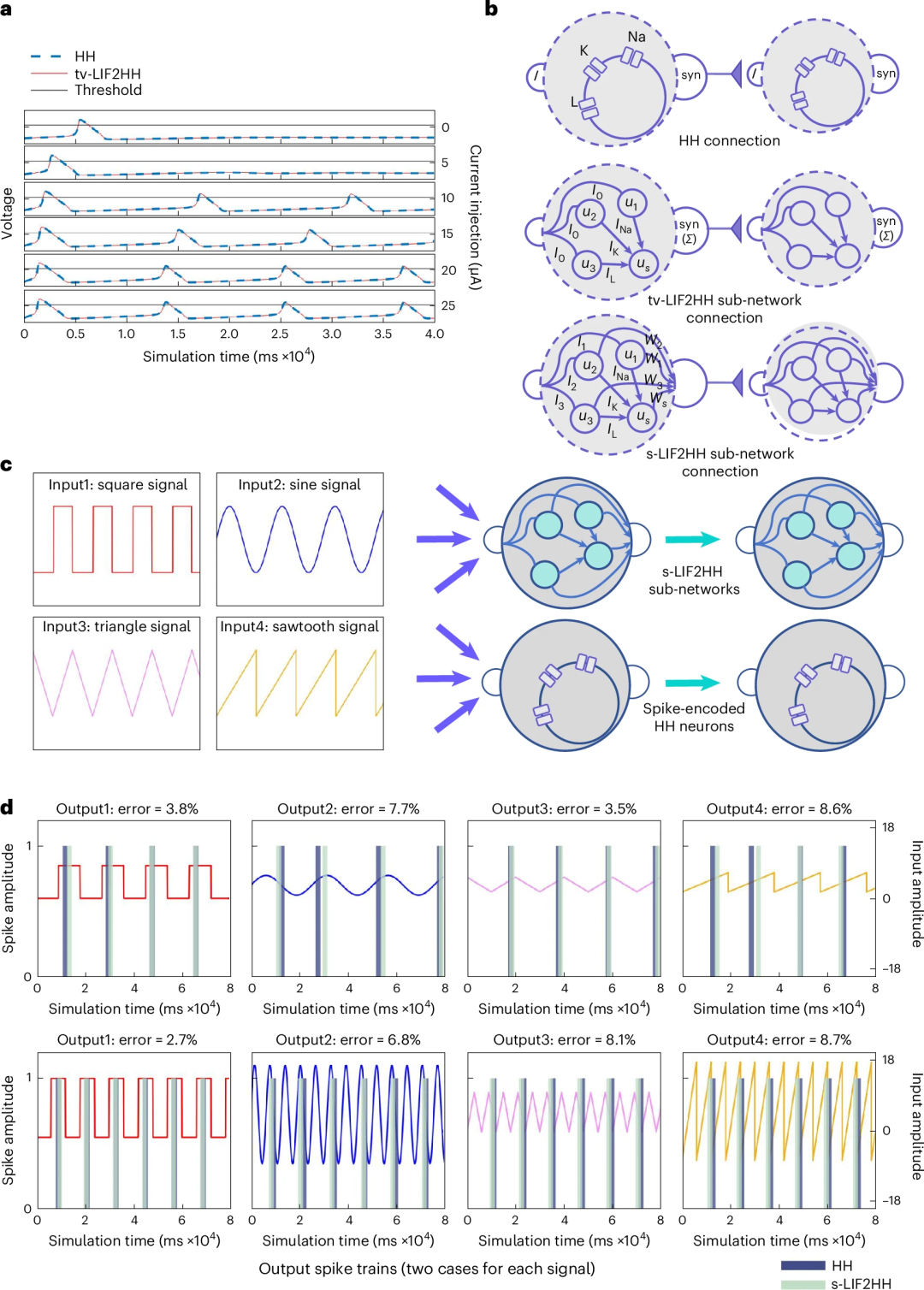

研究者认为通过找到计算神经科学与人工智能的交叉点,模仿大脑皮层并利用丰富的时空动态,可以帮助解决现有大模型的瓶颈问题。本研究中引入了由4个具有时变电导的LIF神经元组成的子网络结构 tv-LIF2HH。首先,在理论上推导出内部复杂度较低的 LIF2HH 模型和内部复杂度较高的 HH 模型,二者在激发特性上等价。而后在实验中,为解决实际训练中的复杂性问题,研究者使用了一系列近似简化的方法,包括近似发放函数,在网络中使用直接连接,固定神经元电导等(图2c),构建得到s-LIF2HH网络。结果显示,两种神经元模型对不同波形的发放模式都非常相似,放电时间之间的相对误差均低于10%。

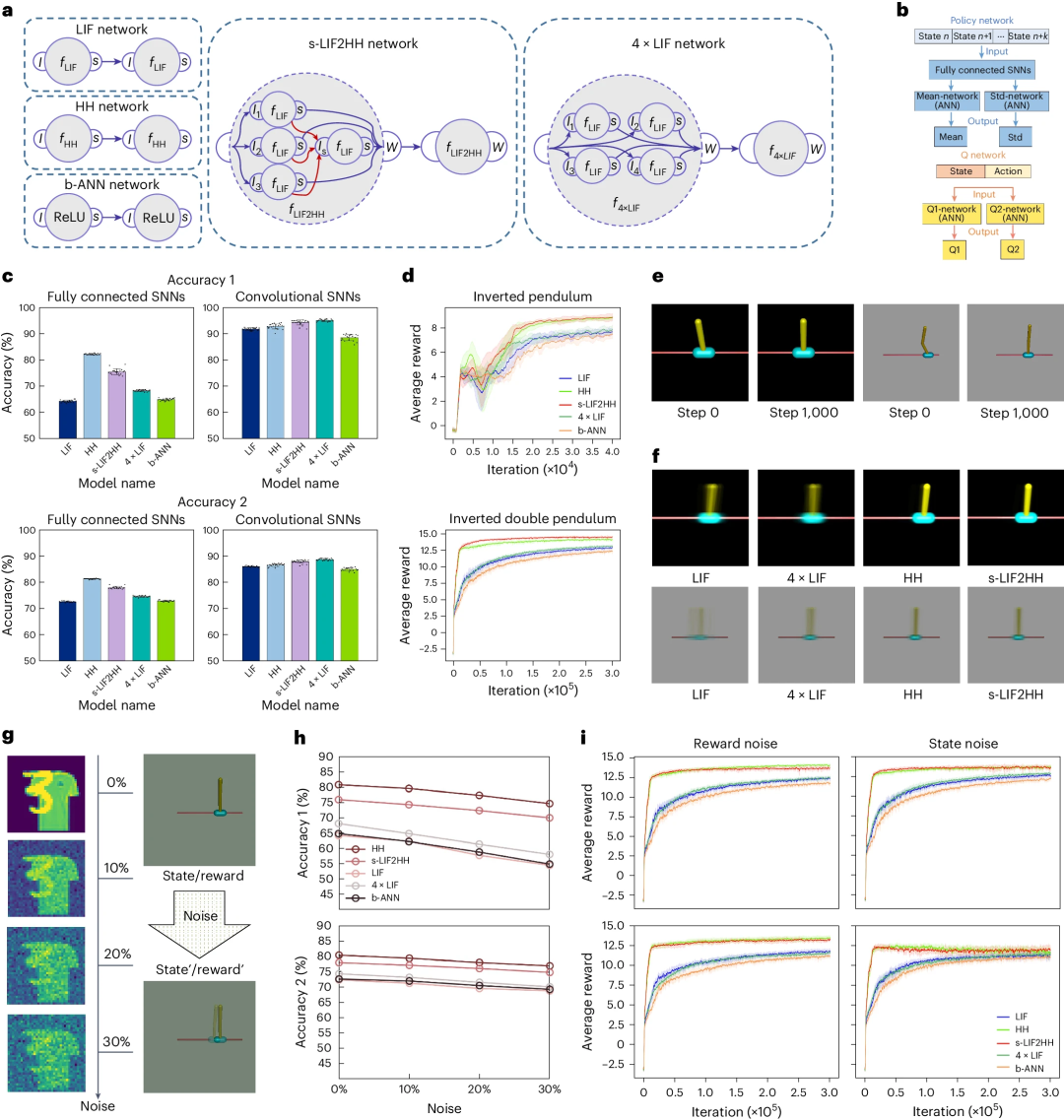

在深度学习任务中,研究者发现HH和s-LIF2HH网络结构都具有较强的空间和时间信息提取能力,单个HH神经元信息处理能力的增强补偿了其简单的拓扑结构;HH和s-LIF2HH网络具有相似的噪声鲁棒性,鲁棒性来源于HH神经元的动态复杂性和s-LIF2HH的复杂拓扑结构,而不仅仅是神经元数量。这支持了模型内部和外部复杂性之间的可比性,以及在深度学习任务中,超越了神经元动态模式简单但规模大的模型。此外,与s-LIF2HH网络相比,HH网络提供了可观的计算效率,表明将外部复杂性转换为内部复杂性提高了深度学习模型的效率。

彭晨 | 编译

计算神经科学读书会

详情请见:计算神经科学读书会启动:从复杂神经动力学到类脑人工智能

AI By Complexity读书会

6. 加入集智,一起复杂!