向大脑学习:寻找反向传播的生物机制

导语

深度学习之所以在过去几年引领人工智能,得益于反向传播算法。该算法使得深度网络能够从数据中学习,赋予它们分类图像、识别语音、翻译语言、理解无人驾驶汽车的路况以及完成大量其他任务的能力。虽然人工神经网络的诞生借鉴了真实的大脑神经网络,但在大脑中并没有直接对应于反向传播的机制。如果我们能揭示大脑的学习机制或学习方法,那么人工智能将获得新的发展。反馈对齐、平衡传播、预测编码、椎体神经元、注意力机制等方向的研究已经铺开。 Anil Ananthaswamy | 作者郭瑞东 | 译者

Anil Ananthaswamy | 作者郭瑞东 | 译者

赵雨亭 | 审校

邓一雪 | 编辑

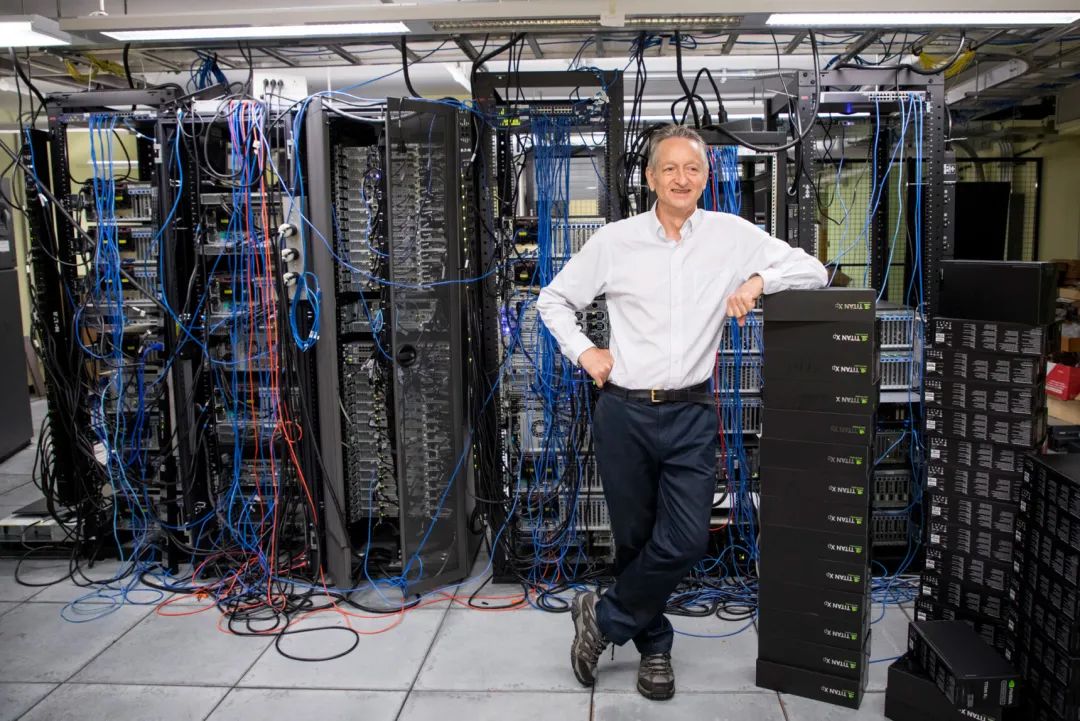

2007年,在一次著名的年度人工智能会议的间隙,深层神经网络领域的一些主要学者组织了一次非正式的“卫星”会议。该会议以私下研讨方式进行,旨在讨论深层神经网络距离占领人工智能还有多远。多伦多大学的 Geoffrey Hinton 成为了这次非正式会议的压轴讲者——作为一位认知心理学家兼计算机科学家。他的演讲以一句俏皮话开始:“大约一年前,在回到家吃晚饭的时候,我说完‘我想我终于弄明白大脑是怎么工作的了’的时候,我15岁的女儿说,‘哦,爸爸,别再这样了。’”

观众大笑起来。Hinton 继续说道,“其实,这就是它的工作原理。”更多的笑声随之而来。

Geoffrey Hinton,多伦多大学认知心理学家与计算机科学家,发展了反向传播算法,引领了深度学习的技术突破

Hinton 的笑话隐喻了一个严肃的追求:利用人工智能理解大脑。今天,深层网络引领了人工智能的部分优势是基于反向传播(backprop)算法。该算法使得深度网络能够从数据中学习,赋予它们分类图像、识别语音、翻译语言、理解无人驾驶汽车的路况以及完成大量其他任务的能力。

但是真正的大脑不太可能以同样的方式运作。蒙特利尔大学的计算机科学家 Yoshua Bengio 表示,这不仅是因为“大脑能够比最先进的人工智能系统表现更好、更快地进行概括和学习”,而是基于更多更复杂的原因,反向传播算法不符合大脑的解剖学及生理学结构,尤其是在大脑皮层层面。

Yoshua Bengio,蒙特利尔大学的人工智能研究员与计算机科学家,他是研究具有生物合理性的学习算法的科学家之一。这些算法与反向传播一样具有学习能力,且在生物学上更加合理与可信

Yoshua Bengio,蒙特利尔大学的人工智能研究员与计算机科学家,他是研究具有生物合理性的学习算法的科学家之一。这些算法与反向传播一样具有学习能力,且在生物学上更加合理与可信

Bengio 和其他许多受 Hinton 启发的人一样,一直在思考更具生物学意义的学习机制——至少可能与反向传播的优良表现相匹配。其中反馈比对法(feedback alignment)、均衡传播(equilibrium propagation)和预测性编码(predictive coding)具有很好的应用前景。一些研究人员还在他们构建的模型中,加入诸如某些类型皮层神经元和注意力等过程中的特性。所有努力使得我们愈发理解可能在大脑中起作用的算法。

“大脑是一个巨大的谜团。人们普遍认为,如果我们能够解开它的一些原理,可能对人工智能有所助益。”“但它本身也有价值。”

1. 通过反向传播学习

1949年,加拿大心理学家唐纳德 · 赫布(Donald Hebb)提出了赫布理论(Hebbian theory),指导了几十年来,众多神经科学家关于大脑如何学习理论的研究方向。这个重要猜想通常被解释为:“连接在一起的神经元同步激活。”即,相邻神经元的活动越相关,它们之间的突触联系就越紧密。这个猜想的变体,成功地解释了某些有限类型的学习和视觉分类任务。

但是,对于需要从错误中学习的大型神经元网络来说,这种方法的效果要差得多:神经网络深处的神经元没有直接利用针对性的方法来学习已有的错误、更新自己,以及减少错误。斯坦福大学计算神经学家兼计算机科学家丹尼尔 · 亚明斯(Daniel Yamins)表示,赫布理论是一种非常狭隘、特殊且不敏感的、使用错误信息的方法。

Daniel Yamins,斯坦福大学计算神经学家与计算机科学家。他正在研究如何识别生物大脑中“运行着”的算法

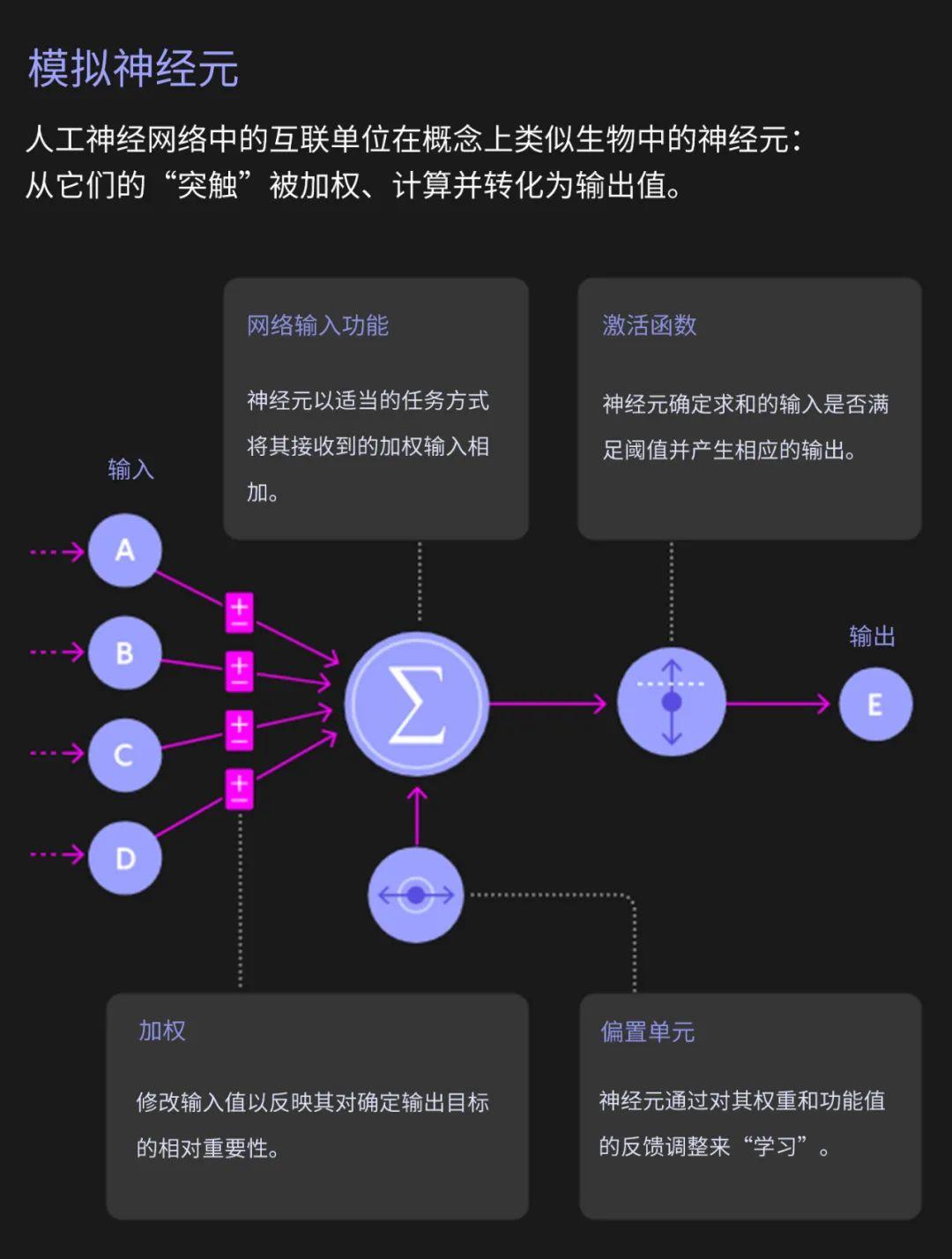

尽管赫布理论并非完美,但它仍然是神经科学家所拥有的最好的科研基准——甚至在主导神经科学之前,就已经于20世纪50年代后期推动了第一个人工神经网络的发展。在神经网络中,每个人工神经元接收多个输入并产生一个输出——就像其生物对应物一样。神经元使用一个所谓的“突触”权重(一个表示该输入重要性的数字),将每个输入乘以权重,然后对加权输入进行总和。这个和即神经元的输出。到了20世纪60年代,这样的神经元可以组织成一个网络——分为输入层及输出层——从而得到的人工神经网络可以经由训练来解决一些简单的问题。在训练过程中,神经网络为其神经元确定最佳权值,以减少乃至消除错误。

然而很明显的是,即使在20世纪60年代,解决更复杂的问题也需要在输入层和输出层之间加入一个或多个神经元“隐藏”层。截至1986年 Hinton、已故的 David Rumelhart 与 Ronald Williams (现任职于东北大学)发表反向传播算法之前,没有人知道如何有效地训练带有隐藏层的人工神经网络。

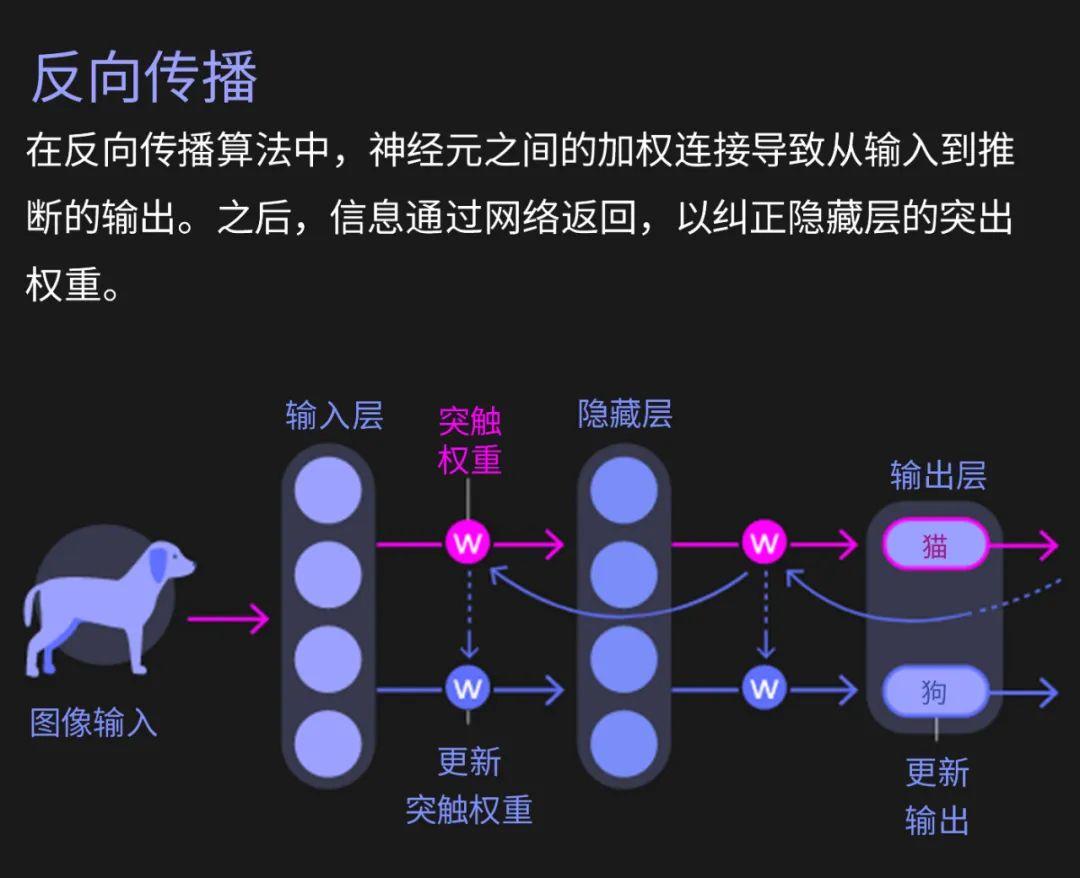

该算法分两个阶段工作。在“前向传播”阶段,当给予网络一个输入时,它推断出一个输出可能是错误的。第二个“反向传播”阶段更新突触的权重,使输出与目标值更加接近。

为了理解这个过程,可以考虑一个“损失函数”,损失函数将推断出的结果和期望的结果之间的差异描述为丘陵和山谷的差异。当一个网络通过一组给定的突触权重进行优化时,网络权重最终会出现在损失函数的某个位置。为了学习,梯度会沿着斜坡向下移动,朝着某个山谷移动,在那里损失会尽可能地减少到最小。反向传播是一种更新突触权重以降低梯度的方法。

本质上,算法的反向传播阶段即计算每个神经元的突触权重对错误的贡献程度,然后更新这些权重以提高网络的性能。这种计算顺序从输出层反向反馈到输入层,因此称为反向传播。对于一组输入和期望输出,反复进行该操作,最终研究人员得到一组适合整个神经网络的权重。

2. 反向传播对大脑来说是不可能的

反向传播的发明立即引起了一些神经科学家的强烈反对,他们认为这种方法与真正大脑的工作方式大相径庭。最著名的反对者为弗朗西斯·克里克(Francis Crick) ——诺奖得主、 DNA 结构的共同发现者,并在之后从事神经学方面的工作。1989年,克里克写道:“就学习过程而言,大脑实际上不太可能使用反向传播。”

基于以下几个主要原因,反向传播理论被认为不可能在生物学中发挥作用:首先,尽管计算机可以很容易地在两个阶段实现该算法,但是对于生物神经网络来说,这样做并不简单。第二个问题是,计算神经科学家所描述的权重传递问题:反向传播算法复制或“传输”关于推理所涉及的所有突触权重的信息,并更新这些权重以获得更高的准确性。但是在生物网络中,神经元只能看到其他神经元的输出,而不能识别到影响输出的突触权重或内部过程。从神经元的角度来看,“知道自己的突触权重是完全可以做到的,”Yamins 表示。“研究人员无法实现让一个神经元得知其他神经元的突触权重。”

任何生物学上似乎可行的学习规则也需要遵守神经元只能从相邻神经元获取信息的限制;反向传播可能需要从更远的神经元获取信息。因此,“如果你反过来研究,这意味着大脑似乎不可能计算。”Bengio 总结道。

尽管如此,Hinton 与其他科学家立即接受了挑战,研究反向传播在生物学上可信的变体。宾夕法尼亚大学的计算神经科学家 Konrad Kording 表示,第一篇有关大脑会进行类似反向传播的事情的论文,其历史和反向传播一样久远。在过去十年左右的时间里,随着人工神经网络的成功,使得反向传播在人工智能研究中一步步占据主导地位。由此看来,寻找支撑反向传播在生物体中等效物的动力更强了。

3. 反馈对齐和平衡传播

举个例子,2016年,来自伦敦谷歌 DeepMind 的 Timothy lillirap 和他的同事提出了一个解决权重传输问题的最奇怪的方法。他们的算法并非依赖前向传播的权重矩阵,而使用一个随机值初始化的矩阵进行反向传播。一旦分配,这些值永远不会改变,因此这些权重不需要被反向传播。

这个新方法令人惊叹:网络学到了一些东西。由于用于推理的前向权值随着每次反向传输的更新而更新,因此网络仍然沿着不同的路径降低损失函数的梯度。向前的权重慢慢地与随机选择而来的、向后的权重对齐,最终得到正确的答案。这个算法被命名为:反馈对齐(feedback alignment)。

“实际上,这并没有我们想象的那么糟糕,”亚明斯表示,“至少对于简单的问题来说情况如此。”对于大规模的问题和具有更多隐藏层的更深层次的网络,反馈对齐不如反向传播表现优异:因为前向权重的更新在每次通过时都不如真正的反向传播信息准确,所以训练网络需要更多的数据。

研究人员还探索了在保持经典的赫布学习要求:即“神经元只对相邻神经元做出反应的前提下”,如何让神经元的达到反向传播的性能。可以认为,反向传播是一组神经元进行推理,另一组神经元进行更新突触权重计算的统计方式。Hinton的创新之处在于研究每个神经元同时进行两组计算的算法。“这基本上就是Hinton在2007年谈论的内容。”

在 Hinton 研究的基础上,Bengio 的团队在2017年提出了新的一个学习规则,要求神经网络具有循环连接(即,如果神经元 a 激活神经元 b,那么神经元 b 反过来激活神经元 a)。如果给予这样一个网络一些输入,它会造成网络中的“回响”,即每个神经元响应并反作用于其临近神经元。

最终,神经网络达到一个状态——神经元之间的输入处于平衡状态,它产生一个输出,这个输出可能是错误的。然后,该算法将输出神经元推向预期结果。这引起了另一个向后传播的信号通过网络,触发了类似的动态。网络找到了新的平衡点。

Bengio 表示,数学的美妙之处在于,如果你比较这两种配置,在推动之前和推动之后,可以得到了找到梯度所需要的所有信息。从实践角度,训练网络只需简单地在大量标记数据上进行“平衡传播”过程的迭代。

4. 预测编码

神经元只有对所处环境做出反应才能突破学习的限制,这一特点也在大脑如何感知的新理论中得到了体现。Beren Millidge 和他的同事们一直在调和预测编码理论和反向传播算法。Millidge总结道,如果以某种方式设置预测编码理论,将产出一个似乎合理的生物学学习规则。

预测编码假定大脑不断地对感觉输入的原因进行预测。这个过程包括神经处理的层次结构。为了产生特定的输出,每一层都必须预测下一层的神经活动。如果最高层期望看到一张脸,它预测后续层的活动,可以证明这种感知。后续的图层对更下层的神经元层做出了类似的预测,诸如此类。最低层能够预测实际的感觉输入,比如说,光子落在视网膜上。通过这种方式,预测从较高的层流向较低的层。

但是错误可能发生在层次结构的每个级别:每一层对它所期望的输入和实际输入的预测之间总是存在差异。最底层根据接收到的感觉信息调整突触的权重,以最大限度减少错误。这种调整导致了最新更新的最低层和上面一层之间的差距,因此较高层必须重新调整它的突触权重,以尽量减少它的预测错误。这些错误信号向上传递。网络来回移动,直到每一层都最小化了它的预测误差。

Millidge已经表明,通过适当的设置,预测编码网络可以收敛到和反向传播几乎相同的学习梯度。“你可以非常,非常,非常接近反向传播的梯度。”他表示。

然而,对于深度神经网络中传统的反向传递算法,预测编码网络必须迭代多次。这在生物学上是否合理,取决于真正的大脑需要多长时间。至关重要的是,网络必须在来自外外界环境改变之前达成一个解决方案。

Millidge 补充,“不能像‘有只老虎在我身边跳来跳去,让我来回重复100次,让我的大脑上下运转’这样进行研究。”他总结道,“尽管如此,这个系统可以容忍较小的误差,预测编码可以很快得到一般有用的解。”

5. 锥体神经元

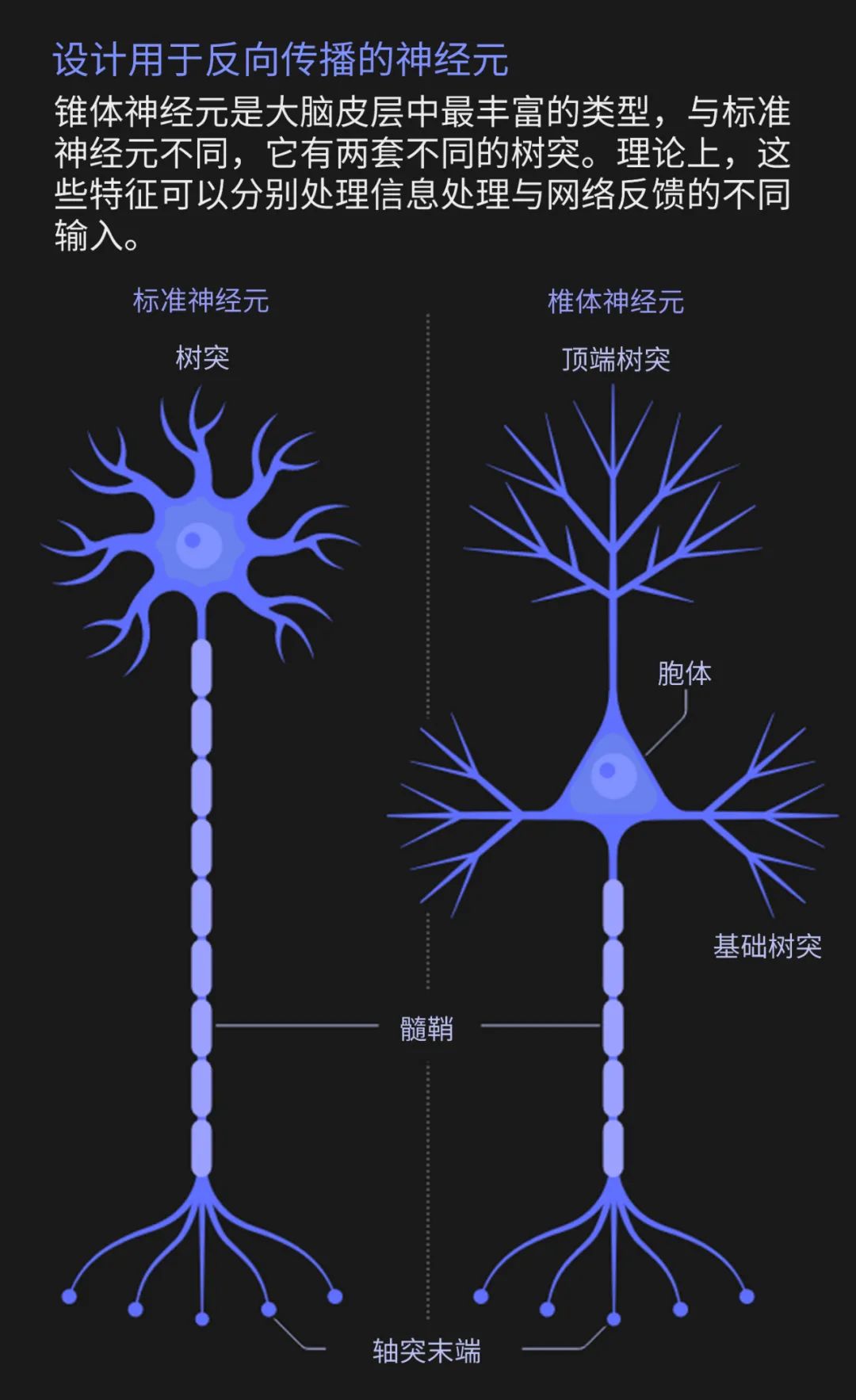

一些科学家已经开始着手基于单个神经元的已知特性建立类似支持反向传播的模型。标准神经元拥有树突,它们从其他神经元的轴突中收集信息。树突传递信号到神经元的细胞体,在那里信号进行整合。如果刺激不够强烈,从神经元轴突传递到突触后神经元的树突的动作电位将停止继续传递。

但并非所有的神经元都有这种结构。特别是皮层中最丰富的神经元类型——椎体神经元——有着明显的不同。锥体神经元不仅具有树状结构,而且有两套不同的树突。树突向上伸展,分枝形成所谓的顶端树突。靠近胞体的部分向下延伸,分枝形成基部树突。

2001年由 Kording 独立开发、以及最近由麦吉尔大学和魁北克人工智能研究所的 Blake Richards 与他的同事开发的数个模型已经表明,锥体神经元可以通过同时进行前向和反向传播,从而构成深度学习网络的基本单元。模型的关键是分离进入神经元的、用于前向推断和反向传播的误差信号,这两种误差可以通过基树突和顶树突分别处理。这两种信号的信息都可以被编码在神经元传递给轴突,参与输出的电活动的电位变化中。

Kording团队的最新研究表明,科研人员已经达到了通过相当真实的神经元模拟,训练锥体神经元网络来完成各种任务。” Kording 表示,使用对这些模型稍微抽象的版本,科研工作者可以得到锥体神经元网络,从而学习人们在机器学习中所达成的困难任务。

6. 注意力的作用

对于使用反向传播的深度网络,一个隐含的要求就是“老师”的角色:一种能够计算神经元网络所犯错误的存在。荷兰神经科学研究所(Netherlands Institute for Neuroscience)的彼得 · 罗夫斯玛(Pieter Roelfsema)表示,但是大脑中没有一个老师会告诉运动皮层的每一个神经元,“你应该被打开,你应该被关闭。”

目前来说,主流观点认为,大脑解决问题的方法是注意力。在20世纪90年代后期,Roelfsema和他的同事发现,当猴子盯着一个物体时,代表该物体的神经元在大脑皮层变得更加活跃。猴子集中注意力的行为为负责任的神经元产生了反馈信号。Roelfsema 表示,这是一个高度选择性的、而非错误的反馈信号。它只是在告诉所有这些神经元:你要为(一个行动)负责。”

Roelfsema 的洞见是,当这种反馈信号与某些其他神经科学发现所揭示的过程结合起来时,可以实现反向传播式的学习。例如,剑桥大学的 Wolfram Schultz 与其他研究人员已经证明,当动物执行一个行动,产生比预期更好的结果时,大脑的多巴胺系统就会被激活。Roelfsema 表示,这类任务让整个大脑充满了神经调节信号。多巴胺水平就像一个全局强化信号。

Roelfsema 补充,理论上,注意力反馈信号只能启动那些负责对整体强化信号做出反应的神经元,通过更新它们的突触权重来实现。他和他的同事利用这个想法构建了一个深层神经网络,并研究了其数学特性。“结果是错误反向传播。你得到的基本上是相同的网络,”他解释道。“但现在,这在生物学上变得可行了。”

这个团队在12月的NIPS在线会议上展示了这项工作。“我们可以训练深层网络,”Roelfsema 表示,这只比反向传播放缓两到三倍。因此,“它打败了所有其他被认为在生物学上合理的算法。”

尽管如此,仍然没有明确的经验性证据,说明人类活体大脑使用上述机制。“我认为我们仍然遗漏了某些东西,”Bengio 补充。“根据我的经验,这可能无所谓,也可能会对现有方法之一进行一些改进,从而真正产生影响。”

与此同时,Yamins 和他在斯坦福大学的同事对如何确定哪些学习规则是正确的提出了一些建议。通过分析1,056个实现不同学习模型的人工神经网络,他们发现管理网络的学习规则类型可以通过一段时间内神经元子集的活动来识别。这些信息有可能从猴子的大脑中得到记录。Yamins 表示:“事实证明,只要存在正确的观察对象,就有可能想出一个相当简单的方案,让科研人员识别学习规则。”

鉴于这些进步,计算神经学家们对此持乐观态度。“大脑可以通过很多不同的方式进行反向传播,”Kording补充。“进化论非常有价值。反向传播是可行的。我认为,进化在某种程度上会带领科研前进。”

原文链接:

https://www.quantamagazine.org/artificial-neural-nets-finally-yield-clues-to-how-brains-learn-20210218/

网络科学新课推荐:网络动力学

集智学园特邀陈关荣、项林英、樊瑛、宣琦、李翔、史定华、李聪、荣智海、周进、王琳等网络科学专家作为导师,依托汪小帆、李翔、陈关荣的经典教材《网络科学导论》,自2月27日起开展系列上线课程,以网络动力学为主线构建网络科学知识体系。欢迎希望进入网络科学领域、提高网络分析能力、与一线专家探讨问题的朋友报名参加!

点击查看课程详情:2021重磅新课:探索网络动力学——网络科学第二期

推荐阅读

Nature 长文综述:类脑智能与脉冲神经网络前沿

前沿综述:大脑结构网络、功能网络和网络控制中的物理学

为什么大脑不是预测机器

PNAS前沿:遨游在双曲空间中的大脑网络

“幂律与临界”支配神经网络,深度学习技术要向大脑学习

基于垫脚石原理的神经进化算法:为人工智能注入创造力

点击“阅读原文”,追踪复杂科学顶刊论文