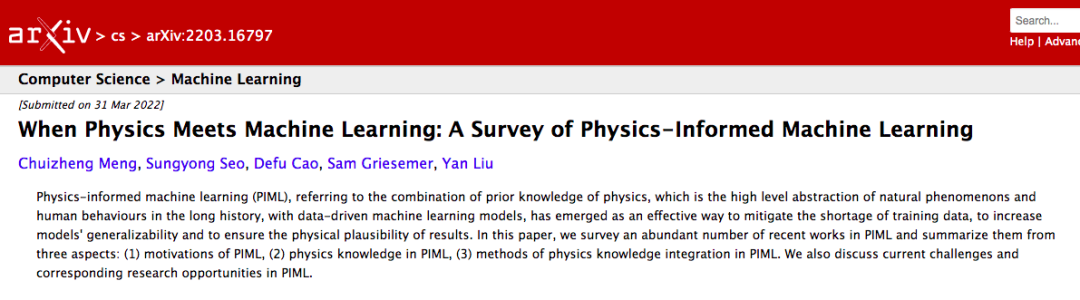

物理信息机器学习(Physics-informed machine learning,PIML),指的是将物理学的先验知识(历史上自然现象和人类行为的高度抽象),与数据驱动的机器学习模型相结合,这已经成为缓解训练数据短缺、提高模型泛化能力和确保结果的物理合理性的有效途径。在本文中,我们调查了最近在PIML方面的大量工作,并从三个方面进行了总结:(1)PIML发展的动机,(2)PIML中的物理知识,(3)PIML中的物理知识整合方法。我们还讨论了当前PIML的挑战和相应的研究机会。

研究领域:机器学习,物理学

潘佳栋 | 作者

梁金 | 审校

邓一雪 | 编辑

论文题目:

When Physics Meets Machine Learning: A Survey of Physics-Informed Machine Learning

https://arxiv.org/abs/2203.16797

机器学习/深度学习模型已经在一些领域取得了巨大的成功,如计算机视觉[1-5]和自然语言处理[6-14],大量的训练数据和高表现力的神经网络架构给出了超越之前方法的解决问题的方案。因此,研究人员也开始探索应用机器学习模型来推进科学发现和进一步改善传统分析建模的可能性[15-21]。

虽然给定一组输入和输出对,深度神经网络能够在充分的大量数据上通过适当的优化来得到输入和输出之间的复杂关系,但先验知识仍然在寻找最优解方面起着重要作用。作为对数据分布和任务属性的高层次提取,先验知识如果纳入得当,可以提供在有限的训练数据中不存在或难以提取的丰富信息,并有助于提高数据效率、泛化能力和产生模型的合理性。

在漫长的历史中,物理知识在理论和实验上都得到了明确的收集和验证,在许多重要的科学和工程应用中包含了对自然现象和人类行为的抽象和总结。因此本文重点讨论了将先验物理知识整合到机器学习模型中的课题,即物理信息机器学习(PIML)。与其他类型的先验知识,如知识图谱、逻辑规则和人类反馈[22]的整合相比,由于物理知识的特殊属性和形式,物理知识的整合需要特殊设计。

本文调查了最近在PIML方面的大量工作,并从三个方面对其进行总结。(1) PIML的动机,可以进一步归类为使用机器学习来服务于物理领域的任务,和将物理学原理融入到现有机器学习模型中用于现实世界的任务。(2) PIML中的物理知识,每一类都是涵盖广泛问题的一般原则。(3) PIML中物理学知识整合的方法。根据知识整合的位置,我们将这些方法分为数据增强、神经网络架构设计和物理信息优化。

本文的结构如下。第2节使用 PIML分析了两大动机:一类主要服务于物理领域的任务,另一类服务于现实世界的问题。第3节介绍了PIML中广泛使用的几个通用物理原理。第4节研究物理知识整合的方法。第5节讨论了PIML的挑战和潜在的未来研究方向。第6节是整篇论文的总结。

2. PIML的动机:

物理用于机器学习,机器学习用于物理

物理科学问题涉及各种数据密集型任务,包括时空数据建模、因果推理、计算机视觉、概率推理等。由于机器学习方法在这些任务中取得了巨大的成功,近年来使用机器学习模型来促进物理学的科学发现越来越受到关注。

另一方面,与现有的基于数值或纯物理的方法相比,基于物理的机器学习方法在灵活性、通用性和计算成本方面具有优势。同时,它们仍然具有物理上的合理性。本节介绍了将机器学习用于若干物理相关任务的最新进展,包括替代模型模拟、数据驱动的PDE求解器、物理模型的参数化、降维模型和知识发现。

本节介绍了集成在PIML中的几类通用物理知识。虽然有更多的领域/任务特定的知识可以用于相应的解决方案,但我们在本节中介绍的每个类别都涵盖了广泛的问题,并给出了一系列普遍适用的解决途径,而不是仅仅解决一两个特定任务的方案。

首先是经典力学和能量守恒定律。牛顿力学、拉格朗日力学和哈密顿力学是描述经典力学系统的三种典型方法。牛顿力学被广泛用于描述位置、速度、加速度和力之间的关系,而拉格朗日和哈密顿力学则提供了有效的工具,遵守动力学系统建模中的能量守恒定律。

其次是对称性和不变量。定义在一个物体或系统上的对称性是一些保持某些属性不变的变换。典型的对称性包括视觉对象分类问题中的移动、分子属性预测问题中的旋转以及粒子系统中的排列组合。

PIML中的通用物理知识还包括偏微分方程的数值方法和Koopman理论。

机器学习问题的典型解决方案涉及三个关键部分:数据、模型和优化,每个部分都可以与物理知识相结合。接下来的部分分别介绍将物理知识结合到每个部分的现有技术。但是,我们应该注意到,这些技术并不是相互排斥的:物理知识可以集成到机器学习解决方案的多个部分中。

我们根据物理知识的形式和整合方法对现有的工作进行分类。我们注意到,对于具有分析形式的知识,现有的工作可以将知识整合到所有三个方面,包括数据、模型和优化。然而,关于整合其他通用类型物理知识的研究工作,包括能量守恒定律、对称性、偏微分方程的数值方法和Koopman理论,主要侧重于将相应的知识纳入计算图。主要原因是这种通用的物理知识有可能转化为可重复使用的网络架构中的归纳偏差,这在预测性能和数据效率方面比数据增强和基于物理知识的损失函数有优势。这是由于 (1) 通用的物理知识适用于各种问题,从而导致通用的网络架构,(2) 与为特定领域问题(如天气和湍流)设计的复杂数值模拟器相比,归纳偏差具有更简单的形式,可以转化为有限数量的不同可微算子的组合。

现有工作需要对任务特定领域的专业知识有所了解,以选择最合适的物理学知识。虽然这能够利用领域知识缓解纯数据驱动方法的缺陷,但它缺乏根据任务确定正确物理知识的灵活性。因此,一个研究方向是自动识别要纳入的适当的物理知识。这需要在特定领域的知识和纯数据驱动的方式之间找到一个中间点。

综合性的基准已经显示出对相应研究领域发展的巨大推动作用。例如,计算机视觉领域的ImageNet Large Scale Visual Recognition Challenge(ILSVRC)[23]和Common Objects in Context(COCO)[24],自然语言处理领域的Workshop on Statistical Machine Translation(WMT)[25]和 Stanford Question Answering Dataset(SQuAD)[26]。然而,由于问题设置的复杂性,PIML仍然缺乏评估各种知识整合方法的全面基准,这给PIML的发展带来了障碍。首先,PIML中的大多数问题来自于物理或工程应用,在这些应用中,获取数据和形式化任务对于没有领域知识和经验的再搜索者来说可能是一种挑战。其次,现有的工作,有些严重依赖特定领域数据集,这大大增加了公平比较不同PIML方法的难度。构建PIML的综合基准是推动其发展的迫切需要。

挑战三:现有神经网络架构的次优性和PIML的优化方法

神经网络架构和优化方法的理论和经验结论大多是在神经网络方法首先获得优势的领域发展起来的,如计算机视觉和自然语言处理。然而,它们在PIML中可能不再有效。原因是PIML方法通常涉及在前向过程和目标函数中明确使用梯度,导致在反向过程中存在高阶导数,这使得优化空间的形状与典型的深度学习模型明显不同。例如,常规的参数初始化方法,如Kaiming和Xavier是不够的,因为不寻常的优化目标是特殊的非线性的。PIML的新型神经网络设计和传统的深度学习任务在网络结构和目标上存在巨大差异,这意味着PIML的新型神经网络设计在结构和优化方面都很重要。

本文对现有的PIML工作进行了彻底和全面的调查。文章从三个方面进行总结:(1)PIML的动机;(2)PIML中的物理知识;(3)PIML中的知识整合方法。最后讨论了PIML的现有挑战,并相应地指出了未来潜在的研究方向。我们希望本文能成为PIML用户选择合适的物理知识和适当的整合方法的指南,也能成为PIML研究者确定现有差距和有前景的研究方向的指南。

[1] Yann LeCun, Léon Bottou, Yoshua Bengio, and Patrick Haffner. Gradient-based learning applied to document recognition. Proceedings of the IEEE, 86(11):2278–2324, 1998.

[2] Alex Krizhevsky,Ilya Sutskever, and Geoffrey E.Hinton. Imagenet classification with deep convolutional neural networks. In Advances in neural information processing systems, pages 1097–1105, 2012.

[3] Kaiming He, Xiangyu Zhang, Shaoqing Ren, and Jian Sun. Deep residual learning for image recognition. In Proceedings of the IEEE conference on computer vision and pattern recognition, pages 770–778, 2016.

[4] Joseph Redmon, Santosh Divvala, Ross Girshick, and Ali Farhadi. You only look once: Unified, real-time object detection. In Proceedings of the IEEE conference on computer vision and pattern recognition, pages 779–788, 2016.

[5] Kaiming He, Georgia Gkioxari, Piotr Dollár, and Ross Girshick. Mask r-cnn. In Proceedings of the IEEE international conference on computer vision, pages 2961–2969, 2017.

[6] Tomas Mikolov, Kai Chen, Greg Corrado, and Jeffrey Dean. Efficient estimation of word representations in vector space. International Conference on Learning Representations, 2013.

[7] Richard Socher, Alex Perelygin, Jean Wu, Jason Chuang, Christopher D Manning, Andrew Y Ng, and Christopher Potts. Recursive deep models for semantic compositionality over a sentiment treebank. In Proceedings of the 2013 conference on empirical methods in natural language processing, pages 1631–1642, 2013.

[8] Ilya Sutskever, Oriol Vinyals, and Quoc V Le. Sequence to sequence learning with neural networks. Advances in Neural Information Processing Systems, 2014.

[9] Yoon Kim. Convolutional neural networks for sentence classification. In Proceedings of the 2014 Conference on Empirical Methods in Natural Language Processing (EMNLP), pages 1746–1751, Doha, Qatar, October 2014. Association for Computational Linguistics.

[10] Dzmitry Bahdanau, Kyunghyun Cho, and Yoshua Bengio. Neural machine translation by jointly learning to align and translate. arXiv preprint arXiv:1409.0473, 2014.

[11] Ankit Kumar, Ozan Irsoy, Peter Ondruska, Mohit Iyyer, James Bradbury, Ishaan Gulrajani, Victor Zhong, Romain Paulus, and Richard Socher. Ask me anything: Dynamic memory networks for natural language processing. In International conference on machine learning, pages 1378–1387. PMLR, 2016.

[12] Ashish Vaswani, Noam Shazeer, Niki Parmar, Jakob Uszkoreit, Llion Jones, Aidan N Gomez, Ł ukasz Kaiser, and Illia Polosukhin. Attention is all you need. In I. Guyon, U. V. Luxburg, S. Bengio, H. Wallach, R. Fergus, S. Vishwanathan, and R. Garnett, editors, Advances in Neural Information Processing Systems, volume 30, pages 5998–6008. Curran Associates, Inc., 2017.

[13] Matthew E Peters, Mark Neumann, Mohit Iyyer, Matt Gardner, Christopher Clark, Kenton Lee, and Luke Zettlemoyer. Deep contextualized word representations. arXiv preprint arXiv:1802.05365, 2018.

[14] Jacob Devlin, Ming-Wei Chang, Kenton Lee, and Kristina Toutanova. BERT: Pre-training of deep bidirectional transformers for language understanding. In Proceedings of the 2019 Conference of the North American Chapter of the Association for Computational Linguistics: Human Language Technologies, Volume 1 (Long and Short Papers), pages 4171–4186, Minneapolis, Minnesota, June 2019. Association for Computational Linguistics.

[15] William W Hsieh. Machine learning methods in the environmental sciences: Neural networks and kernels. Cambridge university press, 2009.

[16]ŽeljkoIvezic ́,AndrewJConnolly,JacobTVanderPlas,andAlexanderGray. Statistics,datamining,and machine learning in astronomy: a practical Python guide for the analysis of survey data, volume 1. Princeton University Press, 2014.

[17] Anuj Karpatne, Gowtham Atluri, James H Faghmous, Michael Steinbach, Arindam Banerjee, Auroop Ganguly, Shashi Shekhar, Nagiza Samatova, and Vipin Kumar. Theory-guided data science: A new paradigm for scien- tific discovery from data. IEEE Transactions on knowledge and data engineering, 29(10):2318–2331, 2017.

[18] Anuj Karpatne, Imme Ebert-Uphoff, Sai Ravela, Hassan Ali Babaie, and Vipin Kumar. Machine learning for the geosciences: Challenges and opportunities. IEEE Transactions on Knowledge and Data Engineering, 31(8):1544–1554, 2018.

[19] J Nathan Kutz. Deep learning in fluid dynamics. Journal of Fluid Mechanics, 814:1–4, 2017.

[20] Markus Reichstein, Gustau Camps-Valls, Bjorn Stevens, Martin Jung, Joachim Denzler, Nuno Carvalhais, et al. Deep learning and process understanding for data-driven earth system science. Nature, 566(7743):195–204, 2019.

[21] Zhen Wang,Hai bin Di,Muhammad Amir Shafiq,Yazeed Alaudah,and Ghassan AlRegib. Successful leveraging of image processing and machine learning in seismic structural interpretation: A review. The Leading Edge, 37(6):451–461, 2018.

[22] Laura von Rueden, Sebastian Mayer, Katharina Beckh, Bogdan Georgiev, Sven Giesselbach, Raoul Heese, Birgit Kirsch, Julius Pfrommer, Annika Pick, Rajkumar Ramamurthy, et al. Informed machine learning–a taxonomy and survey of integrating knowledge into learning systems. arXiv preprint arXiv:1903.12394, 2019.

[23]Olga Russakovsky, Jia Deng, Hao Su, Jonathan Krause, Sanjeev Satheesh, Sean Ma, Zhiheng Huang, Andrej Karpathy, Aditya Khosla, Michael Bernstein, Alexander C. Berg, and Li Fei-Fei. ImageNet Large Scale Visual Recognition Challenge. International Journal of Computer Vision (IJCV), 115(3):211–252, 2015.

[24]Tsung-Yi Lin, Michael Maire, Serge Belongie, James Hays, Pietro Perona, Deva Ramanan, Piotr Dollár, and C Lawrence Zitnick. Microsoft coco: Common objects in context. In European conference on computer vision, pages 740–755. Springer, 2014.

[25]Ondˇrej Bojar, Christian Buck, Christian Federmann, Barry Haddow, Philipp Koehn, Johannes Leveling, Christof Monz, Pavel Pecina, Matt Post, Herve Saint-Amand, et al. Findings of the 2014 workshop on sta- tistical machine translation. In Proceedings of the ninth workshop on statistical machine translation, pages 12–58, 2014.

[26]Pranav Rajpurkar, Jian Zhang, Konstantin Lopyrev, and Percy Liang. Squad: 100, 000+ questions for machine comprehension of text. In EMNLP, 2016.

集智斑图顶刊论文速递栏目上线以来,持续收录来自Nature、Science等顶刊的最新论文,追踪复杂系统、网络科学、计算社会科学等领域的前沿进展。现在正式推出订阅功能,每周通过微信服务号「集智斑图」推送论文信息。扫描下方二维码即可一键订阅:

点击“阅读原文”,追踪复杂科学顶刊论文