神经网络的统计力学课程优惠上线!

导语

课程介绍

课程介绍

第 28 讲:随机矩阵之非厄米篇:索普林斯基遇见麦克斯韦

课程负责人

课程负责人

加入课程,开始学习

加入课程,开始学习

为了庆祝课程完整上线1年,让更多的人体验学习课程的优质内容,我们特做出如下优惠方案:

1. 价格调整为49元;

2. 同时对于2个月内(2024年4月15日-至今)购买本课程的用户,将返还价值200元的积分到账户,可以用户消费(不可提现);

3. 加入「AI by Complexity」读书会的成员,开放4个月课程学习权限(2024年7月-10月)。

课程链接:https://campus.swarma.org/course/4543?from=wechat

第一步:扫码付费

第二步:在课程详情页面,填写“学员信息登记表”

第三步:扫码添加助教微信,入群本课程可开发票。

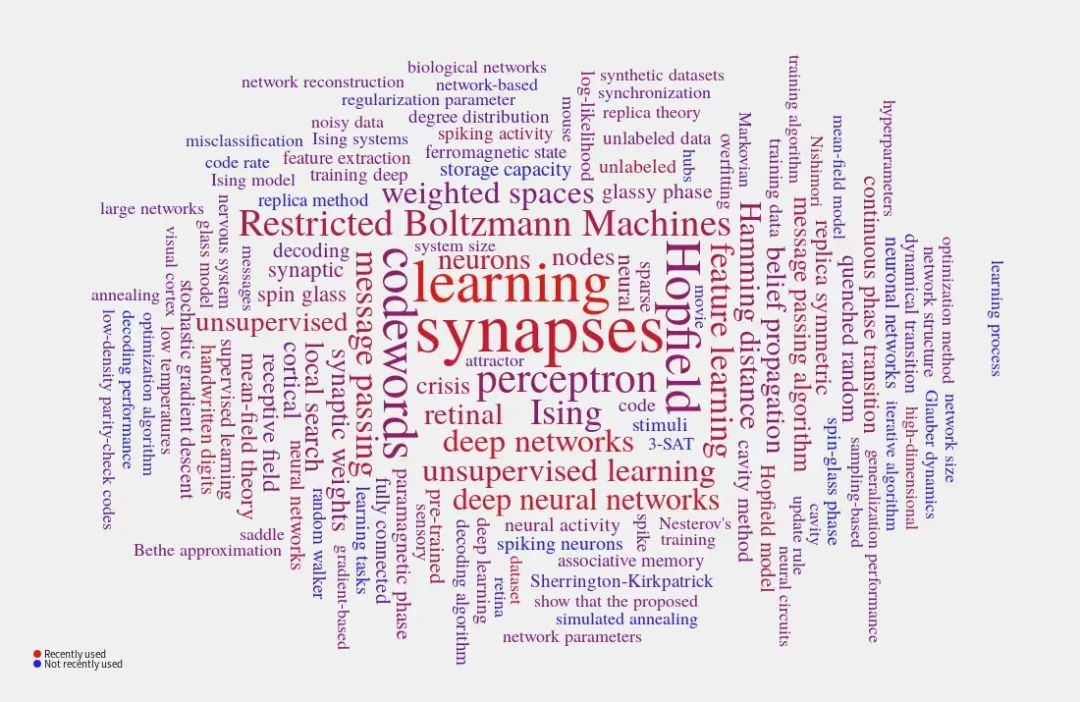

核心参考书籍

核心参考书籍

书籍目录(详版):

Chapter 1: IntroductionChapter 2: Spin Glass Models and Cavity Method

-

2.1 Multi-spin Interaction Models

-

2.2 Cavity Method

-

2.3 From Cavity Method to Message Passing Algorithms

Chapter 3: Variational Mean-Field Theory and Belief Propagation

-

3.1 Variational Method

-

3.2 Variational Free Energy

-

3.3 Mean-Field Inverse Ising Problem

Chapter 4: Monte Carlo Simulation Methods

-

4.1 Monte Carlo Method

-

4.2 Importance Sampling

-

4.3 Markov Chain Sampling

-

4.4 Monte Carlo Simulations in Statistical Physics

Chapter 5: High-Temperature Expansion

-

5.1 Statistical Physics Setting

-

5.2 High-Temperature Expansion

-

5.3 Properties of the TAP Equation

Chapter 6: Nishimori Line

-

6.1 Model Setting

-

6.2 Exact Result for Internal Energy

-

6.3 Proof of No RSB Effects on the Nishimori Line

Chapter 7: Random Energy Model

-

7.1 Model Setting

-

7.2 Phase Diagram

Chapter 8: Statistical Mechanical Theory of Hopfield Model

-

8.1 Hopfield Model

-

8.2 Replica Method

-

8.3 Phase Diagram

-

8.4 Hopfield Model with Arbitrary Hebbian Length

Chapter 9: Replica Symmetry and Replica Symmetry Breaking

-

9.1 Generalized Free Energy and Complexity of States

-

9.2 Applications to Constraint Satisfaction Problems

-

9.3 More Steps of Replica Symmetry Breaking

Chapter 10: Statistical Mechanics of Restricted Boltzmann Machine

-

10.1 Boltzmann Machine

-

10.2 Restricted Boltzmann Machine

-

10.3 Free Energy Calculation

-

10.4 Thermodynamic Quantities Related to Learning

-

10.5 Stability Analysis

-

10.6 Variational Mean-Field Theory for Training Binary RBMs

Chapter 11: Simplest Model of Unsupervised Learning with Binary

-

11.1 Model Setting

-

11.2 Derivation of sMP and AMP Equations

-

11.3 Replica Computation

-

11.4 Phase Transitions

-

11.5 Measuring the Temperature of Dataset

Chapter 12: Inherent-Symmetry Breaking in Unsupervised Learning

-

12.1 Model Setting

-

12.2 Phase Diagram

-

12.3 Hyper-Parameters Inference

Chapter 13: Mean-Field Theory of Ising Perceptron

-

13.1 Ising Perceptron model

-

13.2 Message-Passing-Based Learning

-

13.3 Replica Analysis

Chapter 14: Mean-Field Model of Multi-layered Perceptron

-

14.1 Random Active Path Model

-

14.2 Mean-Field Training Algorithms

-

14.3 Spike and Slab Model

Chapter 15: Mean-Field Theory of Dimension Reduction in Neural Networks

-

15.1 Mean-Field Model

-

15.2 Linear Dimensionality and Correlation Strength

-

15.3 Dimension Reduction with Correlated Synapses

Chapter 16: Chaos Theory of Random Recurrent Neural Networks

-

16.1 Spiking and Rate Models

-

16.2 Dynamical Mean-Field Theory

-

16.3 Lyapunov Exponent and Chaos

-

16.4 Excitation-Inhibition Balance Theory

-

16.5 Training Recurrent Neural Networks

Chapter 17: Statistical Mechanics of Random Matrices

-

17.1 Spectral Density

-

17.2 Replica Method and Semi-circle Law

-

17.3 Cavity Approach and Marchenko

-

17.4 Spectral Densities of Random Asymmetric Matrices

Chapter 18: Perspectives

AI By Complexity读书会招募中

集智俱乐部联合加利福尼亚大学圣迭戈分校助理教授尤亦庄、北京师范大学副教授刘宇、北京师范大学系统科学学院在读博士张章、牟牧云和在读硕士杨明哲、清华大学在读博士田洋共同发起「AI By Complexity」读书会,探究如何度量复杂系统的“好坏”?如何理解复杂系统的机制?这些理解是否可以启发我们设计更好的AI模型?在本质上帮助我们设计更好的AI系统。读书会于6月10日开始,每周一晚上20:00-22:00举办。欢迎从事相关领域研究、对AI+Complexity感兴趣的朋友们报名读书会交流!

点击“阅读原文”,报名课程