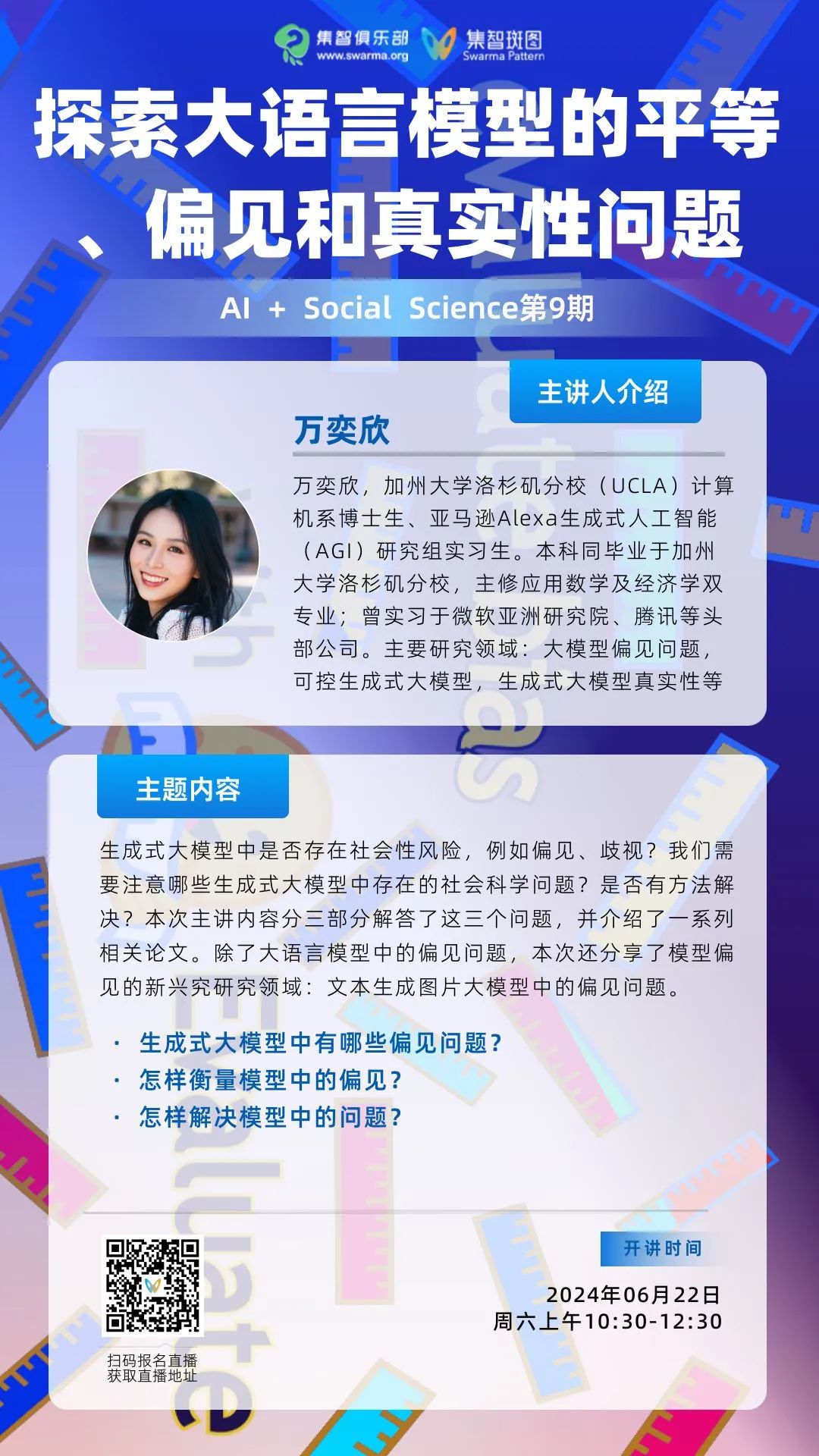

探索大语言模型的平等、偏见和真实性问题丨周六直播·AI+Social Science读书会

图源:Hugging Face。https://huggingface.co/blog/evaluating-llm-bias

导语

该分享与读书会整体主题之间的关系

该分享与读书会整体主题之间的关系

简介

简介

参考论文

参考论文

本次分享分为三部分:(1)生成式大模型中是否存在偏见问题?(2)怎样衡量模型中的偏见?(3)如何解决模型中的偏见?每一部分的分享都包含了相关最新论文的解读。以下是计划在每一部分分享的相关论文。

• 第一部分:生成式大模型中是否存在偏见问题?

-

Wan, Y., Pu, G., Sun, J., Garimella, A., Chang, K.-W., & Peng, N. (2023). “Kelly is a warm person, Joseph is a role model”: Gender biases in LLM-Generated reference letters. ArXiv.org. https://arxiv.org/abs/2310.09219

-

Wan, Y., Subramonian, A., Ovalle, A., Lin, Z., Suvarna, A., Chance, C., Bansal, H., Pattichis, R., & Chang, K.-W. (2024). Survey of bias in text-to-image generation: Definition, evaluation, and mitigation. ArXiv.org. https://arxiv.org/abs/2404.01030

• 第二部分:怎样衡量模型中的偏见?

-

Wan, Y., & Chang, K.-W. (2024). White men lead, black women help? Benchmarking language agency social biases in LLMs. ArXiv.org. https://arxiv.org/abs/2404.10508

-

Wan, Y., Zhao, J., Chadha, A., Peng, N., & Chang, K.-W. (2023). Are personalized stochastic parrots more dangerous? Evaluating persona biases in dialogue systems. ArXiv.org. https://arxiv.org/abs/2310.05280

-

Wan, Y., & Chang, K.-W. (2024). The male CEO and the female assistant: Probing gender biases in text-to-image models through paired stereotype test. ArXiv.org. https://arxiv.org/abs/2402.11089

• 第三部分:如何解决模型中的偏见?现有方法存在什么问题?

-

Zhao, J., Wang, T., Yatskar, M., Ordonez, V., & Chang, K.-W. (2017). Men also like shopping: Reducing gender bias amplification using corpus-level constraints. ArXiv.org. https://arxiv.org/abs/1707.09457

-

Bansal, H., Yin, D., Monajatipoor, M., & Chang, K.-W. (2022). How well can text-to-image generative models understand ethical natural language interventions? ArXiv.org. https://arxiv.org/abs/2210.15230

-

The factuality tax of diversity-intervened text-to-image generation: Benchmark and fact-augmented intervention

大纲

大纲

-

生成式大模型中有哪些偏见问题?

-

大语言模型

-

文本生成图片大模型

-

怎样衡量模型中的偏见?

-

量化方法

-

可视化方法

-

怎样解决模型中的问题?

-

现有方法(指令微调方法,训练方法,推理环节方法)

-

存在问题

-

未来研究方向

涉及到的关键知识概念

涉及到的关键知识概念

-

大语言模型 large language model

-

文本生成图片大模型 large text-to-image (T2I) model

-

模型偏见 model bias

-

模型平等 model fairness

-

偏见解决方案 bias mitigation method

-

模型真实性 model factuality

主讲人

主讲人

直播信息

直播信息

直播时间:

参与方式:

集智俱乐部 B 站账号直播,扫码可预约:

扫码预约本次直播

若需要观看视频回放,文末扫码付费参加AI+Social Science读书会可加入腾讯会议,可提问交流、加入群聊、获取视频回放及更多学习资料,成为计算社会科学社区种子用户,与700余名计算社会科学的一线科研工作者沟通交流,共同推动计算社会科学社区的发展。

报名成为主讲人

报名成为主讲人

读书会成员均可以在读书会期间申请成为主讲人。主讲人作为读书会成员,均遵循内容共创共享机制,可以获得报名费退款,并共享本读书会产生的所有内容资源。具体见系列读书会详情:AI+Social Science:大模型怎样重塑社会科学 | 计算社会科学读书会第三季启动

AI+Social Science读书会启动

点击“阅读原文”,报名读书会