随着科学进步,对引文网络、研究成效、科学政策等的研究越来越受关注,逐渐形成了一个交叉学科——科学学(the Science of Science)。2018 年,网络科学家Albert-László Barabási 领衔多位学者,在 Science 上发表了一篇重磅综述,从科学学的跨学科方法、科学学对提高科研生产力的指导等方面,全面介绍了这门“高阶学科”。

SANTO FORTUNATO, CARL T. BERGSTROM, KATY BÖRNER等 | 作者

陈曦 | 译者

崔浩川 | 审校

王怡蔺、邓一雪 | 编辑

1. 背景

如今,随着对科学研究全过程——包括科研基金资助、学术生产、科学家合作到文章的引用和科学家的事业移动——的数字化获取能力的日益提高,人们获得了探索科学的结构和发展的前所未有的机会。科学学(The science of science,后文缩写为科学学SciSci)提供了对不同空间和时间尺度的科学单位之间相互作用的定量理解:它让我们了解“创造力”背后的条件和科学发现的过程,其最终目标是发展一系列能加速科学研究的政策和工具。

在过去十年中,科学学吸引了自然、计算机和社会学等研究背景的科学家。他们一起构建了用来进行实证分析和生成模型研究的科研大数据, 以捕捉科学背后的生产力与从业者的发展变化。科学学希望更深入地理解和推动科学研究中的种种因素,从而更有效地解决环境、社会和技术问题。

科学可以被视为一个不断扩大和演化的思想、学者和论文网络。科学学探寻基于科学结构和动态的普遍或特定领域的普世规律。

科学可以被描述为一个复杂的、自组织的,不断进化的网络。它由学者、论文和思想组成。这种描述问题的方法解释了很多潜在的模式,例如,对合作网络的研究和对引用网络的研究解释了新学科的诞生和重大发现的诞生过程。微观模型追踪了引文积累的动态,使我们能够预测单个论文在未来的影响力。

科学学揭示了科学家在他们扩展职业生涯和科学视野道路上面临的选择和权衡。例如,分析表明学者们不喜欢风险,更愿意研究与他们当前专业知识相关的主题,这限制了他们未来发现的潜力。那些愿意打破这种模式的人会从事风险更高的职业,但更有可能取得重大突破。

总之,最革新的科学是基于传统的学科组合,但是这种组合往往是前所未有的。最后,随着研究工作更多的从个体转移到团队中,科学学越来越关注团队在科研中的影响和意义。一些研究发现有革命性的思想通常诞生于小团队。相比之下,大型团队倾向于推进前沿领域的研究,获得高却通常也短暂的影响力。

科学学提供了关于科学家、研究机构和思想之间结构框架的定量理解。它有助于识别负责科学发现背后的基本机制。这些跨学科数据驱动的内容补充了科学计量学(scientometrics)和有关科学的经济学与科学社会学等相关领域的内容。

尽管科学学渴求适用于各个科学领域的长期普遍的规律和机制,但首先需要面对不同领域和国家之间文化、习惯和偏好之间难以避免的差异。这种变化使得一些跨领域的见解难以理解,并且相关的科学政策难以实施。科研问题、数据之间的差异,一般是与领域所关联的,这也暗示在将来科学学的研究会因“学科特色”而产生相应的变化。

科学界限的致密化(densification)过程也是跨学科探索、融合和创新的信号。

识别科学发展背后的动力,构造能够捕捉科技发展的模型能够指导人们设计促进科学进步的政策。例如,通过加强科学家的职业道路的政策设计,更好的科学绩效考核,更有效的经费设计,甚至是识别将要诞生的前沿研究。科学学使用关于科学生产的大规模数据来寻找普遍和特定学科的规律和模式。在这里,我们回顾了科学学这个跨学科领域的最新发展。

大量关于学术输出的数字数据为探索表征科学结构和演化的模式提供了前所未有的机会。科学学将科学发展过程置于显微镜下,对科学发现、创造力和实践的起源有定量的理解。它能开发加速科学进步的工具和政策。

首先是数据的可用性。除了专有的Web of Science(WoS),它是历史悠久的第一引文索引,今天还有多种数据源(Scopus,PubMed,Google Scholar,Microsoft Academic,美国专利和商标局等)。其中一些来源是免费提供的,涵盖了与科学家及其成果有关的数百万个数据点,这些数据来自各行各业,大江南北。

其次,科学学受益于自然,计算和社会科学家的涌入和合作,他们开发了基于数据的工具,使关键测试能在生成模型(generative models)上运行,旨在揭示科学发现的现象,其内部机理和驱动力。

这个新兴领域的亮点之一是打破学科边界的过程,科学学整合了来自多个学科的研究发现和理论,并使用了广泛的数据和方法。

从科学计量学中,学会了分析和衡量大规模数据集的方法; 从科学社会学,它学会了一些理论概念和社会过程; 从创新研究中,它探索从科学发现到发明和经济变革的途径。

科学学依赖于广泛的定量方法的整合,从描述性统计和数据可视化到高级计量经济学(econometric)方法,网络科学方法,机器学习算法,数学分析和计算机模拟,包括基于主体的建模方法(agent-based modeling)。

科学学的价值主张基于这样一个假设:随着对成功的科学突破背后因素的深入理解,从整体上把握科学的研究进展,从而更有效地解决社会问题。

当代科学是由社会结构、知识表征(knowledge representations)和自然世界之间复杂的相互作用驱动的一个动力系统。科学知识是由研究论文、书籍、专利、软件和其他学术领域人造产物中的概念和关系构成的。这些内容被按照距离亲疏组织分类成学科和更广泛的领域。这些社会、概念和物质要素通过正式和非正式的信息、思想、科研实践、工具和案例信息流相互联系。

因此,科学可以被描述为一个复杂的、自组织的、不断发展的多尺度网络(multiscale network)。

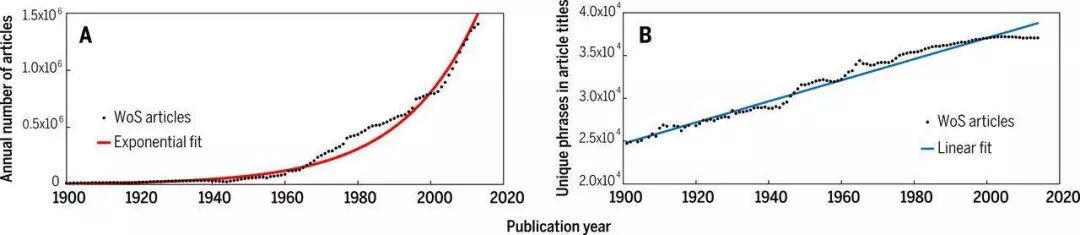

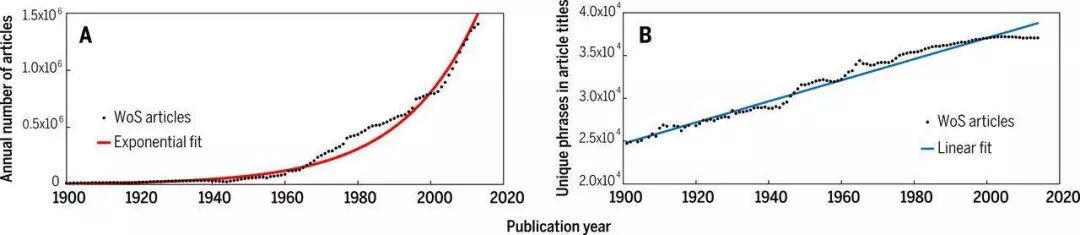

早期研究发现科学文献的数量随着时间呈指数积累(2),平均15年,文献数量就会翻倍(图1)。然而不要因此就以为科学思想就因此跟着文献的数量一起成倍增长了。出版界的技术和经济也随着时间而改善,发表文章制作效率也因此而提高。此外,科学领域的新发表文章往往聚集在不同的知识领域(3)。

研究者们通过大规模的文本分析,使用从标题和摘要中提取的短语来衡量科学文献的认知程度。他们发现科学概念的范围随着时间的推移而线性扩展。换句话说,虽然发表文章的数量呈指数增长,但新概念是随着时间的推移是以线性增加的,如图1所示。(4)

图1 科学的成长。(A)在WoS数据库中摘录文献的年度产出量与时间的关系。(B)WoS中索引到的文献涵盖的科学新发现的增长。这是通过计算固定数量文章中概念数量来确定的(4)。

图1 科学的成长。(A)在WoS数据库中摘录文献的年度产出量与时间的关系。(B)WoS中索引到的文献涵盖的科学新发现的增长。这是通过计算固定数量文章中概念数量来确定的(4)。

文章标题和摘要中常用的单词和短语通过引文网络传播,形成一种模式,而这种模式又会在某一时空被新出现的范式所取代(5)。通过将网络科学方法应用到引文网络中进行研究,研究人员能够识别由经常互相引用的发表文章子集所对应的社群(6)。这些社群通常对应于对特定问题持有共同立场的作者群体(7)或在相同的专门科学话题上工作的从业者(8)。最近,关注生物医学科学工作的一篇文章说明了发表物的增长如何强化了“学科社区”(9)。

一旦新论文被发表,科学家、被研究的药物、疾病和方法(“这些事物”即网络分析中的节点(nodes))之间的关联,(即网络分析中的超边(hyperedge))就会更新和加强。大多数新建立的链接距离彼此仅一两步,这意味着当科学家选择新研究课题时,更喜欢选择与当前的专业知识或其合作者的专业知识直接相关的内容。这种致密化(densification)表明,现有的科学结构可能会限制将来人们的研究内容。

科学界限的致密化(densification)过程也是跨学科探索,融合和创新的信号。

对八个研究领域(10)的生命周期分析表明,成功的领域经历了知识和社交统一的过程,这导致协作网络(104)中的巨大通路,可以类比正常条件下相当大的一组共同作者。一个科学家在合作网络上随机游走(random walks)选择合作者的数学模型成功地再现了作者生产力、每个学科的作者数量和论文内容与作者的跨学科性(11)。

科学家如何决定研究哪些研究问题?科学社会学家早就推测,这些选择是由进行传统研究和创新的风险之间的紧张博弈而决定的(12,13)。坚持其领域研究传统的科学家通常会通过发布一系列稳定不断的研究成果来推动重心话题的究进程,从而显得富有成效。

但是,太过专注某一议题可能会限制研究人员感知和抓住机会的能力。这些机会可以找出促进该领域发展的新想法。例如,一个研究生物医学家选择新型化学药品和已有化学药品关系的案例研究表明,随着研究领域的成熟,研究人员越来越多的关注已有的知识(3)。

虽然创新文章往往比保守文章产生更大的影响,但高风险、高创新的策略却很少见,因为额外的奖励并不能弥补发表失败的风险。奖励和荣誉似乎能够作为,抵制保守倾向的主要激励因素,它们能够打破传统,给予人们新的惊喜。尽管有许多因素影响着科学家要做的工作,但是在科学事业中控制研究兴趣变化的宏观模式是明显有迹可循的,这些规律就隐藏在科研和科学家的职业道路中。(14)。

科学家对研究课题的选择主要影响了他们的个人事业以及依赖他们的人的职业生涯。然而,科学家群体的决策有时候在决定科学发现方向上作用更大(图2)。研究策略保守意味着(15)个人职业发有稳定良好的前景,但对整个学科的促进效果较差。这种策略被名为文件抽屉问题(file drawer problem)的现象放大了(16):与已建立的假设不一致的结果很少被发表,导致已发表研究的系统性偏见。站不住脚的和虚假的内容有时甚至被奉为经典(17)。

指研究员对参考文献的选择偏见,与研究目不符的文献会停留在抽屉里而不是拿出来作为参考。

更多大胆的假设可能已被几代科学家测试过,但只有那些成功足以产出文章的人才能为我们所知。解决这个保守陷阱问题的一种方法是敦促资助机构主动赞助那些测试全新假设的风险项目,让特殊利益群体承担起针对特殊疾病的研究。

定量分析结果表明,美国生物医学资源的分配是与历史分配和研究相关,而不是与疾病实际问题严重程度相关的(18),指出了生物医学需求与资源之间的系统性错位。这种错位使人们怀疑资助机构在没有额外监督,激励和反馈的情况下,由嵌入稳固习惯的科学家经营着的这些资金能多大程度上影响科学的发展。

针对文章和专利的分析共同证明了科学发现和发明中的罕见组合倾向于获得更高的引用率(3)。跨学科研究是一个标志性的重组过程(19); 因此,历史上不相关的思想和资源的成功结合对跨学科研究至关重要,往往反直觉,并导致了具有高度影响力的新思想(20)。不过,从基金申请的证据表明,面对真正新颖的(21-23)或跨学科(24)的研究议题的时候,专家评估系统通常给予较低的分数。

(A.)一项研究衡量了2010年MEDLINE(医学数据库)发表的所有新药物的发现效率。该模型没有考虑特定实验的难度或费用的差异。这个全球科学战略的效率图体现了新发表的生物化学新通路(横轴)与平均实验次数(纵轴)之间的关系。与此对应的,可以制作药物之间的网络图。研究者使用了各种假想的策略效率来与现实情况的策略效率来进行对比,用完全随机,以及50%和100%发现最佳网络的优化策略。纵轴上的较低值表示更有效的策略,进行新发现的模式并不是最优的。实际策略最适合发现13%的化学网络,而50%优化的策略对于发现50%的化学网络有效,但两者都不如揭示整个网络的100%最佳策略一样好。

(B)现实中药物发现网络可以被绘制成图表的形式。该策略诞生的新连接是围绕着一些“重要的”、高度相关的化学物质进行的研究,如图中的热点,但是100%效率的研究策略则显示了更加均匀的发现规律,并且不太可能在科学可能性的空间中“从众”。(15)

最具影响力的科学工作主要出自常规内容的组合,但它同时也出自不寻常的组合(25-27)。这种类型的论文获得高引用率的可能性是其两倍(26)。换句话说,新的和既有元素的混合是成功科学进步的最安全的途径。

在知识生产和利用的广阔市场背景下,各种学术职业出现了(28)。所以,科学的职业成绩不仅被研究个人激励和边际生产力(相对增益与精力)(29),也在机构激励(30,31)和竞争(32)两方面的背景下被检验着。需要组合高内容分辨率的个人、地理和时间的大型元数据哭(metadata)(33)来构建可以从不同角度分析的职业轨迹。例如,一项研究发现,容忍早期失败的资助计划(奖励长期成功)比短期审查周期的资助更有可能产生影响力大的发表文章(31)。

具有时间尺度的竞争交互系统是复杂系统科学中的经典问题。科学的多角度性质是生成模型的驱动力,这种模型能突出了政策的意外后果。例如,职业发展模型表明,短期合同是生产力波动的重要原因,因为这通常会导致某事业的突然结束。

生产力和职业长度的差异可以解释男女科学家之间的合作模式(38)和招聘率(35)上的差异。另一方面,实验证据表明,对女性的偏见发生在职业阶段的早期。当性别在一组申请人的履历中被随机分配时,招聘委员会系统性轻视女性候选人的成果(40)。

迄今为止,大多数研究都集中在相对较小的样本上,改进和编制大规模科学家数据集,利用来自不同来源信息(例如,出版记录,拨款申请和奖励),将有助于更深入地了解不平等的原因。建立可以为政策解决方案提供信息的动机模型。

科学家的流动性是提供多元职业机会的另一个重要因素之一。大多数针对人才流动性的研究都集中在量化国家或地区的人才流入和流出上(41,42),这种研究尤其发生在政策变化之后。然而,对个人流动性及其职业影响的研究仍然很少,主要是由于难以获得关于科学家迁移的纵向信息以及流动决策背后原因的说明。

根据文章引用数量发现,离开原籍国家的科学家,比起那些没有离开的,在文章引用量上表现更好。这可能源于一种选择偏好:好的学者(有能力出国)容易获得更好的职位(更强的团队)。(43,44)。此外,科学家倾向于在名声对等的机构之间移动(45)。然而,当通过引用来量化科学家跳槽影响时,没有发现系统的增加或减少,即使科学家搬到一个相当高或低级别的机构(46)。换句话说,产生影响的不是机构而是组成机构的个体研究人员。

另一个影响职业的潜在因素是名声,以及它为出发点审核文献、评估提案和决策带来的两难困境。作者的声誉,以其先前产出的总引用量来衡量能够显着提高该论文在出版后的头几年所得的引用次数(47)。然而,在这个初始阶段之后,影响取决于科学界对工作的接受程度。这一发现以及引文(46)的工作表明,对于富有成效的科学事业而言,声誉不是第一生产力,努力工作,天分和知难而进才是驱动因素。

和政策相关的一个问题是创造力和创新是否与年龄或职业阶段有关。对优秀研究人员和创新者的数十年研究认为,重大突破发生在职业生涯中相对较早的阶段,其中位年龄为35岁(48)。

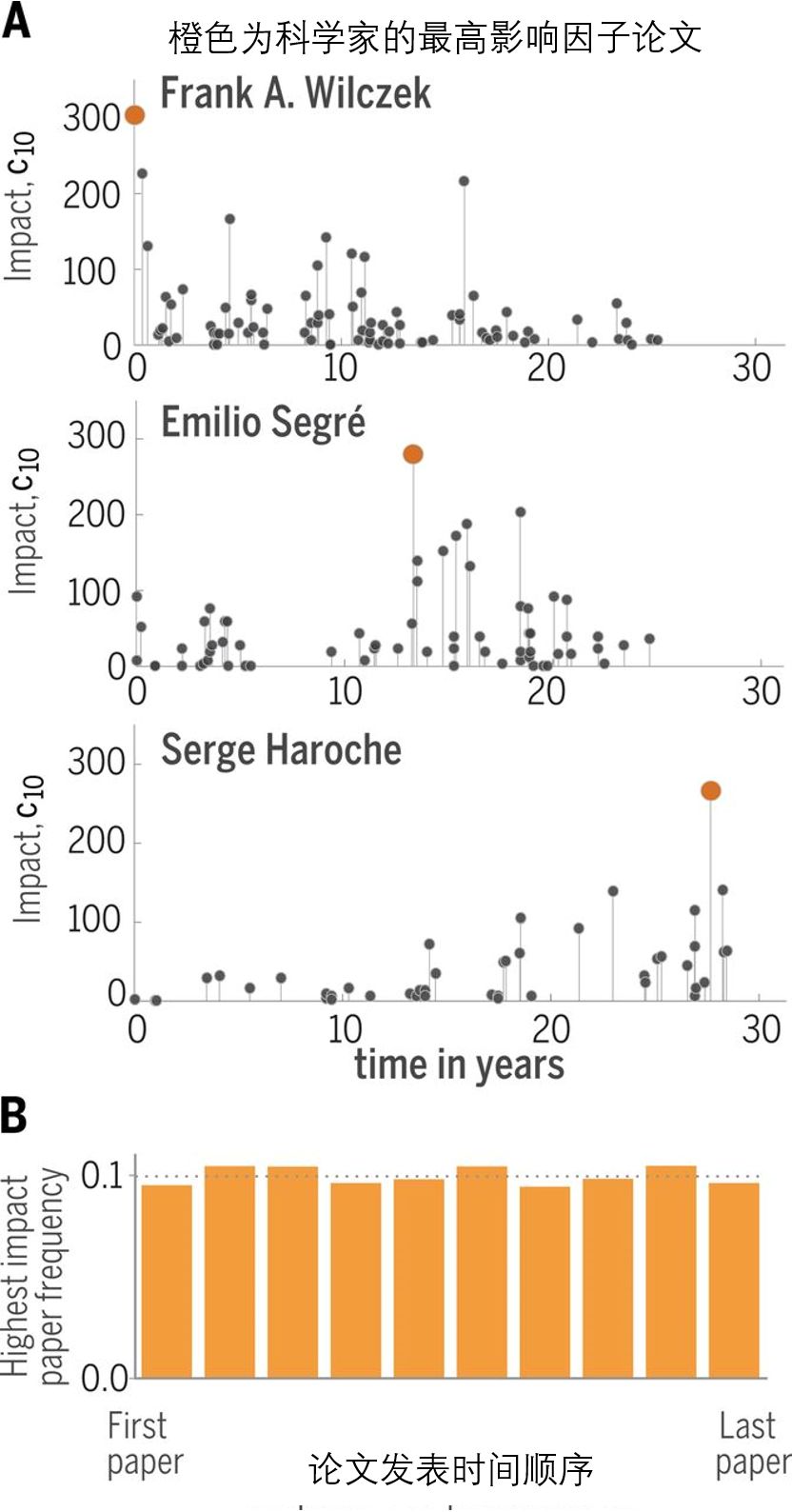

但是,最近的工作表明,早期职业发现的这种充分记录的倾向完全由生产力倾向解释,生产力在科学家的职业生涯的早期阶段很高,并且后来下降(49)。换句话说,创新中没有年龄模式:学者引用最多的论文可以是他或她的任何论文,与论文发表时的年龄或职业阶段无关(图3)。描述影响力发展的随机模型也表明,突破是由科学家的能力和挑选具有高潜力的问题直觉与运气相结合而产生的(49)。

图3 科学学对科学职业的影响

(A)三位诺贝尔物理学奖获得者的发表记录。水平轴表示获奖者首次发表文章后的年数,每个圆圈对应一篇研究论文,圆圈的高度c10代表论文的影响,意为文章10年后的引用次数。获奖者的最高影响论文用橙色圆圈表示。

(B)科学家的论文序列中发生最高影响的论文的直方图,为10,000名科学家计算。直方图的平坦性表明,在科学家发表的论文序列中,影响最大的工作的出现的时间可能具有相同的概率(49)

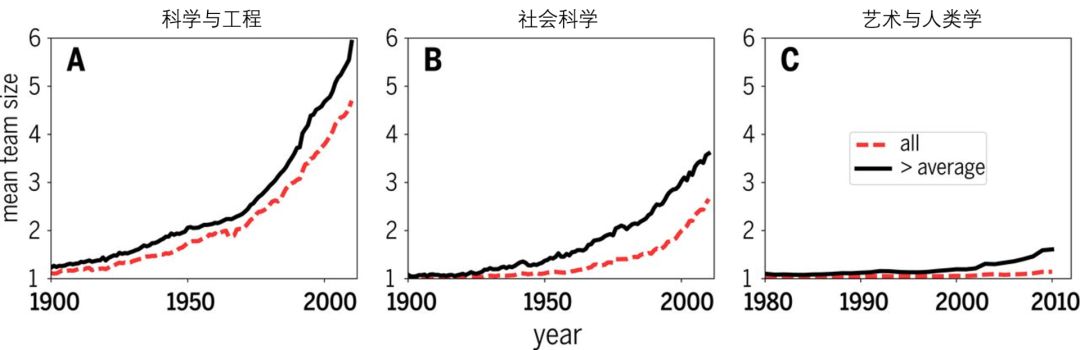

去的几十年里,科研对团队合作的依赖程度与日俱增,这代表了科学研究方式的根本转变。对1,990万篇研究论文和210万项专利的作者进行的研究发现了一个几乎是普遍的科研领域的团队化趋势(50)(图4)。例如,在1955年,科学和工程团队撰写了与单个作者相同的论文数量。然而到2013年,团队撰写的论文比例增加到90%(51)。

如今,在科学和工程团队撰写的论文有6.3倍的可能获得1000以上的引用,或大于个体论文的引用,这种现象并不能由自我引用(self-citations)来解释(50,52)。一个可能的原因是团队能够提出更多新颖的想法组合(26)或生产其他研究者可以后续使用的资源(例如,基因组学)。

数据表明,团队比单独作者多了38%的可能将科研突破内容组合进熟悉的知识领域,证明了团队可以将不同专业结合在一起的前提,从而有效促进科学的突破。拥有更多的协作意味着通过更多的共同作者提高在学者们之间的可见度,他们可能会因此将彼此的工作引入科研的内部网络中,这方面的强化意味着每个研究员要和同事分享声誉(29)。

图4 团队的规模和影响

在过去的一个世纪里,平均团队规模一直在稳步扩大。红色虚线表示所有论文中共同作者的平均数; 黑色曲线考虑那些引用数高于领域平均值的文章的团队平均大小。黑色曲线系统地位于红色虚线之上,这意味着大型团队比小型团队更容易产生高影响力的工作。每张图表对应WoS规定的一个学科大类(A)科学与工程,(B)社会科学,(C)艺术与人文科学。

平均而言,来自大型团队的研究员可以在各种领域获得更多的引用。研究表明,小型团队倾向于用新想法和机会变革科学和技术,而大型团队则推动现有的研究的进程(53)。因此,资助和培养各种规模的团队来缓和科学的官僚化可能很重要的(28)。

同时,团队大小也在以平均每十年17%的速度增加(50,54,105)这个变化趋势因团队的底层架构已经变化。科学团队包括小型,稳定的“核心”团队和大型团队,动态扩展的团队(55)。大多数领域不断增加的团队规模是由动态扩展团队的不断扩增而产生的,扩展团队从小型核心团队开始,但随后通过生产力为基础的原始积累吸引新成员。规模是团队生存策略的关键决定因素:如果小团队保持稳定的核心,那么他们的存活时间会更长,但大团队表现出会员流动机制,才能存活更长时间(56)。

随着科学的加速和日益复杂,扩展知识前沿所需的工具在规模和精度上都日益提升。对大多数个人调查员来说,研究工具价值过高,有价无市,但对大多数机构来说也是如此。学术合作一直是解决这个问题的关键方案,这样就能将资源更多集中到科研上。

欧洲核子研究中心的大型强子对撞机是世界上最大和最强大的粒子对撞机,她的诞生不能忽视学术合作,来自100多个国家的10,000多名科学家和工程师参与了这台对撞击的建立。然而,随着规模的增加,与“大科学”相关的价值和风险的权衡随即产生(2)。尽管可以解决更大的问题,但是科学重复性问题要求你重复实验,这可能在实际上或经济上不可行。

合作者会对科学产生巨大影响。根据最近的研究(57,58),失去明星合作者的科学家会经历生产力的大幅下降,特别是如果这位散伙的合作者是一位普通的研究人员的情况下。与极强合作者合作的发表文章平均引用次数会增加17%,这表明职业合作的价值(59)。

鉴于研究论文中作者的数量越来越多,谁应该并且确实获得最多的名誉?科学中名誉的错误分配的经典理论是马太效应(60),其中参与合作工作的较高地位的科学家因其贡献而获得超额名誉。为协作参与人员分配信誉是很困难的,因为不能轻易区分个人贡献(61)。但是,有可能检查共同作者论文的共同模式,以确定群体中的每个共同作者分配的信誉(62)。

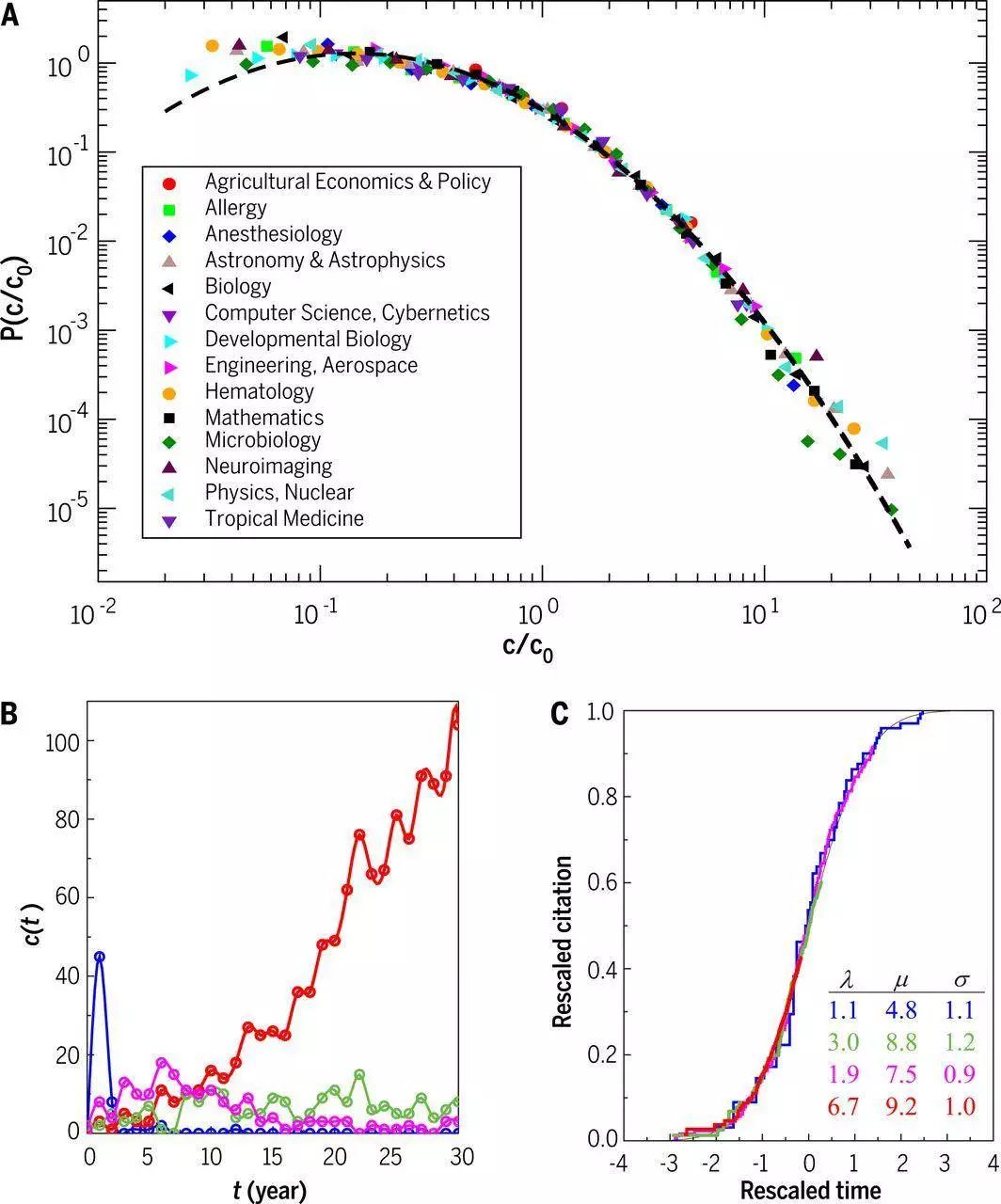

学术引用仍然是科学中衡量学术成就的主流方式。鉴于对主流引用标准的长期依赖(63-66),引文积累的动态规律已被几代学者所验证。根据Price(67)开创性的研究,科学论文引文的分布是高度具有倾向性的:许多论文从未被引用,但开创性论文可以累积10,000或更多的引用。这种不均匀的引文分布是科学变动的一种强大的,自然出现的,革新的属性。当论文按机构分组时,它也成立(68)。并且如果一个论文的引用的次数除以论文同学科同年的平均引文,得到的分数分布是所有学科基本上无区别的(69,70)(图5A)。

这意味着通过查看相对引用量可以比较不同学科发表的论文的影响力。例如,一篇收集100篇引文的数学论文比300篇引文的微生物学论文具有更高的学科影响。

图 5 引文动态的普遍性

(A)如果每篇论文的引用次数c除以该学科所有论文的平均引用次数c0,那么在同一学科和年份上发表的论文的引用分布,各个学科基本上都是统一的。虚线是对数正态拟合曲线。(69)

(B)1964年发表于“ 物理评论(Physical Review)”的四篇论文的引文历史,根据其独特的动态选择,显示出“跳跃衰变”模式(蓝色),峰值延迟(紫红),引文数量稳定模式(绿色),和引文指数上升(红色)。(C.单个纸)引文由三个参数确定:fitness λ ,immediacy μ ,和longevity σ 。通过适当的(λ,μ,σ)参数重新调整(B)中每篇论文的引用,四篇论文将其合并为一个通用函数,这对所有学科都是相同的。(77)

分布的尾部信息能够捕捉高影响力论文的数量,揭示驱动引用数量累计的机制。最近的分析表明,它遵循幂律分布(71-73)。幂律的尾部可以通过累积优势的过程产生(74),网络科学中将其称为偏好依附(preferential attachment)(75),表明引用论文的概率随着它已经积累的引用次数增长而增长。

这样的模型可以与引用动力学的其他特征,比如知识的过时共同使用来增强模型说明性。文章引用数量随着时间增加而下降(76,79,106),或者也可以利用一个拟合参数( fitness parameter)对应每个论文对科学界的吸引力(77,78)。只有一小部分论文不能被以上假设所描述,称为“睡美人”,因为它们在发表后一段时间内都无人问津,但是在经过一段时间后,突然收到大量的关注和引用(80,81)。

上述形成机制可用于预测单个论文的引用动态。一个预测模型(77)假设论文的引用概率取决于先前引用的数量,并且考虑每篇文章的过时因子(obsolescence factor)和适应度参数(fitness parameter)(图5,B,C)就能预测这篇文章的引用数量。可以推断出某个科研工作的长期影响(77)。其他研究已经确定了论文影响因子相关的预测指标(82),例如期刊影响因子(72)。有的研究则表示一个科学家的h-index(83)可以被准确预测(84)。尽管如果考虑科学家的职业生涯阶段和h-指数的累积性,非递减性在内,预测准确性会降低(85)。

消除在科学中使用定量评估指标的不一致性和常用统计数据背后,生成这些数据的内在机制是科学学研究中十分重要的机制。

尽管科学研究确实有它的普遍性,但文化、习惯和偏好方面的实质性学科背景差异使得某些领域内的某些跨领域见解变得难以理解,与其对应的政策则难以实施。每个学科所要求的问题、数据和技能之间的差异表明,可以从特定领域的科学学研究中获得进一步的见解。这些研究模拟和预测适应每个学科领域中的需求和机会。对于年轻的科学家来说,科学学的研究结果提供了过去科研有效的见解,有助于指导他们对未来的预见(Box1)。

-

坚持:只要一直保持研究状态,科学家的概念中永远不存在“太老“而无法做出重大发现的情况(49)。

-

合作:如今研究模式正在向团队转移,因此参与协作是大有益处的。小团队的作品往往是更具颠覆性,而那些强队往往有更大的资源去做更有影响力的大工作(4,50,53)。

-

声誉:大多数名誉将归属于在文献发表的领域中进行始终如一工作的共同作者(62)。

-

资金:虽然评审小组承诺支持创新,但他们实际上更倾向于忽视创新。资助机构应要求审稿人评估创新,而不仅仅是他们头脑中预料的成功(24)。

科学学的贡献是:对科学家、制度和思想之间的关系结构开始进行细致的理解,这是识别它背后运作机制的关键起点。总之,这些数据驱动的(data-driven)工作补充了相关研究领域欠缺的内容,如经济学(30)和科学社会学(60,86)。

因果估计(Causal estimation)是一个经济学中的典型例子,计量经济学研究会收集并利用全面的数据源来进行需要的模拟(31,42)。评估因果关系是科学学最需要的未来发展之一:许多描述性研究揭示了科研结构与成功结果之间的强烈相关性,但特定结构“导致”结果的程度仍未得到探索——我们不知道相关关系背后的因果关系。

通过与研究人员建立更紧密的合作关系,科学学将能够更好地识别从模型和大规模数据中发现的联系,这些数据具有促使相关政策诞生的潜力。但是科学学的实验可能是科学学尚未面临的最大挑战。运行随机对照试验将改变由税收所支持的个人或科学机构的研究进程,如此之高的成本必然会引发批评和阻碍(87)。

因此,在不久的将来,准-实验方法(quasi-experimental approaches)将在科学学调查中占主导地位。

大多数科学学研究都将科研文献作为主要数据来源,这意味着这个学科思考和发现的研究对象都是那些成功的案例。然而,大多数科学研究存在失败,有时甚至是巨大的失败。鉴于科学家失败的次数多于成功失败,因此了解理念何时何地,为什么,怎么样失败对理解和改进科学系统至关重要。这些研究可以为重现性危机提供有意义的指导,并帮助我们解决文件抽屉问题(file drawer problem)。通过揭示创造性活动,这些研究还可以大大促进对人类创造力的解释。

科学系统和经济系统类似,它是一个使用一维“货币”引文的经济系统。这暗示阶层也存在于科研系统,其中“富人愈富”抑制了新思想的传播,特别是那些新晋科学家和那些不符合特定领域传统身份的人。

通过扩大绩效指标的数量和范围可以改善科学系统。在这方面,制定衡量科学界覆盖网络(metrics covering web )(88)、社交媒体(89)活跃度和社会影响(90)的替代指标至关重要。其他可衡量的维度也包括科学家与竞争对手分享的信息(例如数据)(91),以及他们向同行提供的帮助(92),以及他们作为同行作品审稿人的可靠性(93)。

但是,由于需要大量的指标,需要做更多的工作来了解每个指标的作用和不捕获的内容,以确保有意义的解释并避免滥用。科学学可以通过提供模型做出种种贡献,这些模型可以更深入地理解科学绩效指标的覆盖范围以及背后的机制。例如,当使用替代指标(例如,文献下载的分布)时观察到的经验模型将使我们能够探索它们与基于引用数量的度量系统之间的关系(94)并且识别暗箱操作。

将基于引用数量的指标与其他指标相结合将促进科研的多元发展,并实现科研生产力的分工,由此科学家可以通过不同方式取得成就。科学是一个生态系统,不仅需要出版,还需要传播者、教师和注重细节的专家。我们需要能够提出新颖的,改变革新的问题,以及能够回答问题的人。如果好奇心、创造力和知识能有效交流——特别是关于科学技术的应用和社会影响之类的信息——更多元化的方法可以减少重复,科学便能蓬勃发展(95)。

科学学试图解决的一个问题是科学资金的分配。目前的同行评审制度存在偏见和矛盾(96)。几种替代方案已经被提出,例如随机分配资金(97),不涉及提案和审查制度的向专门人员导向的资金(31),向在线人群开放的审查机制(98),去除审稿人绩效的评审机制(99)和科学家众筹(100)资金。

科学学(SciSci)未来研究的一个关键领域是与机器学习和人工智能的整合,让客观的机器和人类一起工作。这些新工具将会有一个令人愉快的深远,因为机器可能比人类合作者更能拓宽科学家的视野。例如,自动驾驶车辆是机器学习技术,是由人类已知的驾驶技术和未知的驾驶习惯信息的成功组合。心智-机器伙伴关系的研究给广泛的卫生、经济、社会、法律等领域的决策上提供了广泛的正面作用(101 – 103)。如何通过机器与心灵关系改善科学,以及怎么安排能够让科学发展更具成效?这些问题有助于我们了解未来的科学。

1. E. Garfield, Citation indexes for science; a new dimension in documentation through association of ideas. Science 122, 108–111 (1955). doi: 10.1126/science.122.3159.108;

2. D. J. S. Price, Little Science, Big Science (Columbia Univ. Press, 1963).

3. J. G. Foster, A. Rzhetsky, J. A. Evans, Tradition and innovation in scientists’ research strategies. Am. Sociol. Rev. 80, –908 (2015). 875doi: 10.1177/

4. S. Milojević, Quantifying the cognitive extent of science. J. Informetr. 9, 962–973 (2015). doi: 10.1016/j.joi.2015.10.005

5. T. Kuhn, M. Perc, D. Helbing, Inheritance patterns in citation networks reveal scientific memes. Phys. Rev. X 4, 041036 (2014). doi: 10.1103/PhysRevX.4.041036

6. R. Klavans, K. W. Boyack, Which type of citation analysis generates the most accurate taxonomy of scientific and technical knowledge? J. Assoc. Inf. Sci. Technol. 68, 984–998 (2016). doi: 10.1002/asi.23734

7. U. Shwed, P. S. Bearman, The temporal structure of scientific consensus formation. Am. Sociol. Rev. 75, 817–840 (2010). doi: 10.1177/0003122410388488; pmid: 21886269

8. J. Bruggeman, V. A. Traag, J. Uitermark, Detecting communities through network data. Am. Sociol. Rev. 77, 1050–1063 (2012). doi: 10.1177/0003122412463574

9. F. Shi, J. G. Foster, J. A. Evans, Weaving the fabric of science:

Dynamic network models of science’s unfolding structure. Soc. Networks 43, 73–85 (2015). doi: 10.1016/j.socnet.2015.02.006

10. L. M. A. Bettencourt, D. I. Kaiser, J. Kaur, Scientific discovery and topological transitions in collaboration networks. J. Informetr. 3, 210–221 (2009). doi: 10.1016/

11. X. Sun, J. Kaur, S. Milojević, A. Flammini, F. Menczer, Social dynamics of science. Sci. Rep. 3, 1069 (2013). doi: 10.1038/srep01069; pmid: 23323212

12. T. S. Kuhn, The Essential Tension: Selected Studies in Scientific Tradition and Change (Univ. of Chicago Press, 1977).

13. P. Bourdieu, The specificity of the scientific field and the social conditions of the progress of reasons. Soc. Sci. Inf. (Paris) 14, 19–47 (1975). doi: 10.1177/

14. T. Jia, D. Wang, B. K. Szymanski, Quantifying patterns of research-interest evolution. Nat. Hum. Behav. 1, 0078 (2017).doi: 10.1038/s41562-017-0078

15. A. Rzhetsky, J. G. Foster, I. T. Foster, J. A. Evans, Choosing experiments to accelerate collective discovery. Proc. Natl. Acad. Sci. U.S.A. 112, 14569–14574 (2015).

doi: 10.1073/pnas.1509757112; pmid: 26554009

16. R. Rosenthal, The file drawer problem and tolerance for null results. Psychol. Bull. 86, 638–641 (1979). doi: 10.1037/0033-2909.86.3.638

17. S. B. Nissen, T. Magidson, K. Gross, C. T. Bergstrom, Publication bias and the canonization of false facts. eLife 5, e21451 (2016). doi: 10.7554/eLife.21451; pmid: 27995896

18. L. Yao, Y. Li, S. Ghosh, J. A. Evans, A. Rzhetsky, Health ROI as a measure of misalignment of biomedical needs and resources. Nat. Biotechnol. 33, 807–811 (2015). doi: 10.1038/nbt.3276; pmid: 26252133

19. C. S. Wagner et al., Approaches to understanding and measuring interdisciplinary scientific research (IDR): A review of the literature. J. Informetr. 5, 14–26 (2011). doi: 10.1016/j.joi.2010.06.004

20. V. Larivière, S. Haustein, K. Börner, Long-distance interdisciplinarity leads to higher scientific impact. PLOS ONE 10, e0122565 (2015). doi: 10.1371/journal.pone.0122565;pmid: 25822658

21. K. J. Boudreau, E. C. Guinan, K. R. Lakhani, C. Riedl, Looking across and looking beyond the knowledge frontier:

Intellectual distance, novelty, and resource allocation in science. Manage. Sci. 62, 2765–2783 (2016). doi: 10.1287/mnsc.2015.2285; pmid: 27746512

22. E. Leahey, J. Moody, Sociological innovation through subfield

integration. Soc. Currents 1, 228–256 (2014). doi: 10.1177/2329496514540131

23. A. Yegros-Yegros, I. Rafols, P. D’Este, Does interdisciplinary

research lead to higher citation impact? The different effect of proximal and distal interdisciplinarity. PLOS ONE 10, e0135095 (2015). doi:10.1371/journal.pone.0135095; pmid: 26266805

24. L. Bromham, R. Dinnage, X. Hua, Interdisciplinary research has consistently lower funding success. Nature 534, 684–687 (2016). doi: 10.1038/nature18315; pmid: 27357795

25. D. Kim, D. B. Cerigo, H. Jeong, H. Youn, Technological novelty profile and inventions future impact. EPJ Data Sci. 5, 8 (2016). doi: 10.1140/epjds/s13688-016-0069-1

26. B. Uzzi, S. Mukherjee, M. Stringer, B. Jones, Atypical combinations and scientific impact. Science 342, 468–472 (2013). doi: 10.1126/science.1240474; pmid: 24159044

27. J. Wang, R. Veugelers, P. Stephan, “Bias against novelty in science: A cautionary tale for users of bibliometric indicators” (NBER Working Paper No. 22180, National Bureau of Economic Research, 2016).

28. J. P. Walsh, Y.-N. Lee, The bureaucratization of science. Res. Policy 44, 1584–1600 (2015). doi: 10.1016/j.respol.2015.04.010

29. A. M. Petersen, M. Riccaboni, H. E. Stanley, F. Pammolli, Persistence and uncertainty in the academic career.Proc. Natl. Acad. Sci. U.S.A. 109, 5213–5218 (2012). doi: 10.1073/pnas.1121429109; pmid: 22431620

30. P. E. Stephan, How Economics Shapes Science (Harvard Univ.

31. P. Azoulay, J. S. Graff Zivin, G. Manso, Incentives and creativity: Evidence from the academic life sciences. Rand J. Econ. 42, 527–554 (2011). doi: 10.1111/

32. R. Freeman, E. Weinstein, E. Marincola, J. Rosenbaum, F. Solomon, Competition and careers in biosciences. Science

294, 2293–2294 (2001). doi: 10.1126/science.1067477; pmid: 11743184

33. J. A. Evans, J. G. Foster, Metaknowledge. Science 331, 721–725 (2011). doi: 10.1126/science.1201765; pmid: 21311014

34. V. Larivière, C. Ni, Y. Gingras, B. Cronin, C. R. Sugimoto, Bibliometrics: Global gender disparities in science. Nature 504, 211–213 (2013). doi: 10.1038/504211a;

35. S. F. Way, D. B. Larremore, A. Clauset, in Proceedings of the 25th International Conference on World Wide Web (WWW ‘16) (ACM, 2016), pp. 1169–1179.

36. J. Duch et al., The possible role of resource requirements and academic career-choice risk on gender differences in publication rate and impact. PLOS ONE 7, e51332 (2012). doi: 10.1371/journal.pone.0051332; pmid: 23251502

37. J. D. West, J. Jacquet, M. M. King, S. J. Correll, C. T. Bergstrom, The role of gender in scholarly authorship. PLOS ONE 8, e66212 (2013). doi: 10.1371/journal.pone.0066212; pmid: 23894278

38. X. H. T. Zeng et al., Differences in collaboration patterns across discipline, career stage, and gender. PLOS Biol. 14, e1002573 (2016). doi: 10.1371/journal.pbio.1002573; pmid: 27814355

39. T. J. Ley, B. H. Hamilton, The gender gap in NIH grant applications. Science 322, 1472–1474 (2008). doi: 10.1126/ science.1165878; pmid: 19056961

40. C. A. Moss-Racusin, J. F. Dovidio, V. L. Brescoll, M. J. Graham, J. Handelsman, Science faculty’s subtle gender biases favor male students. Proc. Natl. Acad. Sci. U.S.A. 109, 16474–16479

(2012). doi: 10.1073/pnas.1211286109; pmid: 22988126

41. R. Van Noorden, Global mobility: Science on the move. Nature 490, 326–329 (2012). doi: 10.1038/490326a; pmid: 23075963

42. O. A. Doria Arrieta, F. Pammolli, A. M. Petersen, Quantifying

the negative impact of brain drain on the integration of European science. Sci. Adv. 3, e1602232 (2017). doi: 10.1126/

sciadv.1602232; pmid: 28439544

43. C. Franzoni, G. Scellato, P. Stephan, The mover’s advantage: The superior performance of migrant scientists. Econ. Lett. 122, 89–93 (2014). doi: 10.1016/j.econlet.2013.10.040

44. C. R. Sugimoto et al., Scientists have most impact when they’re free to move. Nature 550, 29–31 (2017). doi: 10.1038/550029a; pmid: 28980663

45. A. Clauset, S. Arbesman, D. B. Larremore, Systematic inequality and hierarchy in faculty hiring networks. Sci. Adv.1, e1400005 (2015). doi: 10.1126/sciadv.1400005; pmid: 26601125

46. P. Deville et al., Career on the move: Geography, stratification, and scientific impact. Sci. Rep. 4, 4770 (2014). pmid: 24759743

47. A. M. Petersen et al., Reputation and impact in academic careers. Proc. Natl. Acad. Sci. U.S.A. 111, 15316–15321 (2014). doi: 10.1073/pnas.1323111111; pmid: 25288774

48. D. K. Simonton, Creative productivity: A predictive and explanatory model of career trajectories and landmarks. Psychol. Rev. 104, 66–89 (1997). doi: 10.1037/

49. R. Sinatra, D. Wang, P. Deville, C. Song, A.-L. Barabási, Quantifying the evolution of individual scientific impact. Science 354, aaf5239 (2016). doi: 10.1126/science.aaf5239; pmid: 27811240

50. S. Wuchty, B. F. Jones, B. Uzzi, The increasing dominance of teams in production of knowledge. Science 316, 1036–1039 (2007). doi: 10.1126/science.1136099; pmid: 17431139

51. N. J. Cooke, M. L. Hilton, Eds., Enhancing the Effectiveness of Team Science (National Academies Press, 2015).

52. V. Larivière, Y. Gingras, C. R. Sugimoto, A. Tsou, Team size matters: Collaboration and scientific impact since 1900. J. Assoc. Inf. Sci. Technol. 66, 1323–1332 (2015).

53. L. Wu, D. Wang, J. A. Evans, Large teams have developed science and technology; small teams have disrupted it. arXiv:1709.02445 [physics.soc-ph] (7 September 2017).

54. B. F. Jones, The burden of knowledge and the “death of the renaissance man”: Is innovation getting harder? Rev. Econ. Stud. 76, 283–317 (2009). doi: 10.1111/j.1467-937X.2008.00531.x

55. S. Milojević, Principles of scientific research team formation and evolution. Proc. Natl. Acad. Sci. U.S.A. 111, 3984–3989 (2014). doi: 10.1073/pnas.1309723111; pmid: 24591626

56. G. Palla, A.-L. Barabási, T. Vicsek, Quantifying social group evolution. Nature 446, 664–667 (2007). doi: 10.1038/nature05670; pmid: 17410175

57. G. J. Borjas, K. B. Doran, Which peers matter? The relative impacts of collaborators, colleagues, and competitors. Rev. Econ. Stat. 97, 1104–1117 (2015). doi: 10.1162/REST_a_00472

58. P. Azoulay, J. G. Zivin, J. Wang, Superstar extinction. Q. J. Econ. 125, 549–589 (2010). doi: 10.1162/qjec.2010.125.2.549

59. A. M. Petersen, Quantifying the impact of weak, strong, and super ties in scientific careers. Proc. Natl. Acad. Sci. U.S.A. 112, E4671–E4680 (2015). doi: 10.1073/pnas.1501444112; pmid: 26261301

60. R. K. Merton, The Matthew effect in science. Science 159, 56–63 (1968). doi: 10.1126/science.159.3810.56

61. L. Allen, J. Scott, A. Brand, M. Hlava, M. Altman, Publishing: Credit where credit is due. Nature 508, 312–313 (2014). doi: 10.1038/508312a; pmid: 24745070

62. H.-W. Shen, A.-L. Barabási, Collective credit allocation in science. Proc. Natl. Acad. Sci. U.S.A. 111, 12325–12330 (2014). doi: 10.1073/pnas.1401992111; pmid: 25114238

63. L. Waltman, A review of the literature on citation impact indicators. J. Informetr. 10, 365–391 (2016). doi: 10.1016/j.joi.2016.02.007

64. J. E. Hirsch, An index to quantify an individual’s scientific

research output. Proc. Natl. Acad. Sci. U.S.A. 102, 16569–16572 (2005). doi: 10.1073/pnas.0507655102; pmid: 16275915

65. H. F. Moed, Citation Analysis in Research Evaluation (Springer, 2010).

66. E. Garfield, Citation analysis as a tool in journal evaluation.

Science 178, 471–479 (1972). doi: 10.1126/science.178.4060.471; pmid: 5079701

67. D. J. de Solla Price, Networks of scientific papers. Science

149, 510–515 (1965). doi: 10.1126/science.149.3683.510; pmid: 14325149

68. Q. Zhang, N. Perra, B. Gonçalves, F. Ciulla, A. Vespignani,

Characterizing scientific production and consumption in physics. Sci. Rep. 3, 1640 (2013). doi: 10.1038/srep01640; pmid: 23571320

69. F. Radicchi, S. Fortunato, C. Castellano, Universality of citation distributions: Toward an objective measure of scientific impact. Proc. Natl. Acad. Sci. U.S.A. 105,

17268–17272 (2008). doi: 10.1073/pnas.0806977105;

70. L. Waltman, N. J. van Eck, A. F. J. van Raan, Universality of citation distributions revisited. J. Assoc. Inf. Sci. Technol. 63, 72–77 (2012). doi: 10.1002/asi.21671

71. M. Golosovsky, S. Solomon, Runaway events dominate the heavy tail of citation distributions. Eur. Phys. J. Spec. Top. 205, 303–311 (2012). doi: 10.1140/epjst/e2012-01576-4

72. C. Stegehuis, N. Litvak, L. Waltman, Predicting the long-term citation impact of recent publications. J. Informetr. 9, 642–657 (2015). doi: 10.1016/j.joi.2015.06.005

73. M. Thelwall, The discretised lognormal and hooked power law distributions for complete citation data: Best options for modelling and regression. J. Informetr. 10, 336–346 (2016). doi: 10.1016/j.joi.2015.12.007

74. D. de Solla Price, A general theory of bibliometric and other cumulative advantage processes. J. Am. Soc. Inf. Sci. 27, 292–306 (1976). doi: 10.1002/asi.4630270505

75. A.-L. Barabási, R. Albert, Emergence of scaling in random networks. Science 286, 509–512 (1999). doi: 10.1126/science.286.5439.509; pmid: 10521342

76. P. D. B. Parolo et al., Attention decay in science. J. Informetr. 9, 734–745 (2015). doi: 10.1016/j.joi.2015.07.006

77. D. Wang, C. Song, A.-L. Barabási, Quantifying long-term scientific impact. Science 342, 127–132 (2013). doi: 10.1126/science.1237825; pmid: 24092745

78. Y.-H. Eom, S. Fortunato, Characterizing and modeling citation dynamics. PLOS ONE 6, e24926 (2011). doi: 10.1371/journal.pone.0024926; pmid: 21966387

79. M. Golosovsky, S. Solomon, Stochastic dynamical model of a growing citation network based on a self-exciting point process. Phys. Rev. Lett. 109, 098701 (2012). doi: 10.1103/PhysRevLett.109.098701; pmid: 23002894

80. A. F. J. van Raan, Sleeping Beauties in science. Scientometrics 59, 467–472 (2004). doi: 10.1023/B:SCIE.0000018543.82441.f1

81. Q. Ke, E. Ferrara, F. Radicchi, A. Flammini, Defining and

identifying Sleeping Beauties in science. Proc. Natl. Acad. Sci. U.S.A. 112, 7426–7431 (2015). doi: 10.1073/pnas.1424329112; pmid: 26015563

82. I. Tahamtan, A. Safipour Afshar, K. Ahamdzadeh, Factors affecting number of citations: A comprehensive review of the literature. Scientometrics 107, 1195–1225 (2016). doi: 10.1007/s11192-016-1889-2

83. J. E. Hirsch, Does the h index have predictive power? Proc. Natl. Acad. Sci. U.S.A. 104, 19193–19198 (2007). doi: 10.1073/pnas.0707962104; pmid: 18040045

84. D. E. Acuna, S. Allesina, K. P. Kording, Future impact: Predicting scientific success. Nature 489, 201–202 (2012). doi: 10.1038/489201a; pmid: 22972278

85. O. Penner, R. K. Pan, A. M. Petersen, K. Kaski, S. Fortunato, On the predictability of future impact in science. Sci. Rep. 3, 3052 (2013). doi: 10.1038/srep03052; pmid: 24165898

86. J. R. Cole, H. Zuckerman, in The Idea of Social Structure: Papers in Honor of Robert K. Merton, L. A. Coser, Ed. (Harcourt Brace Jovanovich, 1975), pp. 139–174.

87. P. Azoulay, Research efficiency: Turn the scientific method on

ourselves. Nature 484, 31–32 (2012). doi: 10.1038/484031a;

88. M. Thelwall, K. Kousha, Web indicators for research evaluation. Part 1: Citations and links to academic articles from the Web. Prof. Inf. 24, 587–606 (2015). doi: 10.3145/epi.2015.sep.08

89. M. Thelwall, K. Kousha, Web indicators for research evaluation. Part 2: Social media metrics. Prof. Inf. 24, 607–620 (2015). doi: 10.3145/epi.2015.sep.09

90. L. Bornmann, What is societal impact of research and how can it be assessed? A literature survey. Adv. Inf. Sci. 64, 217–233 (2013).

91. C. Haeussler, L. Jiang, J. Thursby, M. Thursby, Specific and general information sharing among competing academic researchers. Res. Policy 43, 465–475 (2014). doi: 10.1016/j.respol.2013.08.017

92. A. Oettl, Sociology: Honour the helpful. Nature 489, 496–497(2012). doi: 10.1038/489496a; pmid: 23018949

93. S. Ravindran, “Getting credit for peer review,” Science, 8 February 2016; www.sciencemag.org/careers/2016/02/getting-credit-peer-review.

94. R. Costas, Z. Zahedi, P. Wouters, Do “altmetrics” correlate with citations? Extensive comparison of altmetric indicators with citations from a multidisciplinary perspective. J. Assoc. Inf. Sci. Technol. 66, 2003–2019 (2015). doi: 10.1002/asi.23309

75. A.-L. Barabási, R. Albert, Emergence of scaling in random networks. Science 286, 509–512 (1999). doi: 10.1126/science.286.5439.509; pmid: 10521342

76. P. D. B. Parolo et al., Attention decay in science. J. Informetr. 9, 734–745 (2015). doi: 10.1016/j.joi.2015.07.006

77. D. Wang, C. Song, A.-L. Barabási, Quantifying long-term scientific impact. Science 342, 127–132 (2013). doi: 10.1126/science.1237825; pmid: 24092745

78. Y.-H. Eom, S. Fortunato, Characterizing and modeling citation dynamics. PLOS ONE 6, e24926 (2011). doi: 10.1371/journal.pone.0024926; pmid: 21966387

79. M. Golosovsky, S. Solomon, Stochastic dynamical model of a growing citation network based on a self-exciting point process. Phys. Rev. Lett. 109, 098701 (2012). doi: 10.1103/PhysRevLett.109.098701; pmid: 23002894

80. A. F. J. van Raan, Sleeping Beauties in science. Scientometrics 59, 467–472 (2004). doi: 10.1023/B:SCIE.0000018543.82441.f1

81. Q. Ke, E. Ferrara, F. Radicchi, A. Flammini, Defining and identifying Sleeping Beauties in science. Proc. Natl. Acad. Sci. U.S.A. 112, 7426–7431 (2015). doi: 10.1073/pnas.1424329112; pmid: 26015563

82. I. Tahamtan, A. Safipour Afshar, K. Ahamdzadeh, Factors affecting number of citations: A comprehensive review of the literature. Scientometrics 107, 1195–1225 (2016). doi: 10.1007/s11192-016-1889-2

83. J. E. Hirsch, Does the h index have predictive power? Proc. Natl. Acad. Sci. U.S.A. 104, 19193–19198 (2007). doi: 10.1073/pnas.0707962104; pmid: 18040045

84. D. E. Acuna, S. Allesina, K. P. Kording, Future impact: Predicting scientific success. Nature 489, 201–202 (2012). doi: 10.1038/489201a; pmid: 22972278

85. O. Penner, R. K. Pan, A. M. Petersen, K. Kaski, S. Fortunato, On the predictability of future impact in science. Sci. Rep. 3, 3052 (2013). doi: 10.1038/srep03052;

86. J. R. Cole, H. Zuckerman, in The Idea of Social Structure: Papers in Honor of Robert K. Merton, L. A. Coser, Ed. (Harcourt Brace Jovanovich, 1975), pp. 139–174.

87. P. Azoulay, Research efficiency: Turn the scientific method on ourselves. Nature 484, 31–32 (2012). doi: 10.1038/484031a; pmid: 22481340

88. M. Thelwall, K. Kousha, Web indicators for research evaluation. Part 1: Citations and links to academic articles from the Web. Prof. Inf. 24, 587–606 (2015). doi: 10.3145/epi.2015.sep.08

89. M. Thelwall, K. Kousha, Web indicators for research evaluation. Part 2: Social media metrics. Prof. Inf. 24, 607–620 (2015). doi: 10.3145/epi.2015.sep.09

90. L. Bornmann, What is societal impact of research and how can it be assessed? A literature survey. Adv. Inf. Sci. 64, 217–233 (2013).

91. C. Haeussler, L. Jiang, J. Thursby, M. Thursby, Specific and general information sharing among competing academic researchers. Res. Policy 43, 465–475 (2014). doi: 10.1016/j.respol.2013.08.017

92. A. Oettl, Sociology: Honour the helpful. Nature 489, 496–497 (2012). doi: 10.1038/489496a; pmid: 23018949

93. S. Ravindran, “Getting credit for peer review,” Science, 8

February 2016; www.sciencemag.org/careers/2016/02/

getting-credit-peer-review.

94. R. Costas, Z. Zahedi, P. Wouters, Do “altmetrics” correlate with citations? Extensive comparison of altmetric indicators with citations from a multidisciplinary perspective. J. Assoc. Inf. Sci. Technol. 66, 2003–2019 (2015). doi: 10.1002/asi.23309

编译:集智俱乐部翻译组

来源:science

原题:science of science

原文地址:

https://science.sciencemag.org/content/359/6379/eaao0185

科学是研究实践、是理性精神,也是一个由学者、文献、科研项目、科学思想与灵感等一起构成的自组织、自生长的复杂系统。科学学这门学科,旨在深入理解科学研究的种种因素并推动科学发展。科学的迅猛发展在积累科学知识的同时,也遭遇诸多社会、伦理、政策问题:开放科学的范式如何影响科学研究的实践?阶层、性别、种族、国家等视角如何揭示科学不平等的起源?期刊编辑和审稿人如何塑造当今的科学活动?科学人口结构、人才激励、科技人才流动如何影响科学发展?AI大模型如何重塑科学研究的各个环节?

为了思考和回应科学的多元化挑战、科学开放性面临的危机,以及新兴技术对科学的冲击,集智俱乐部联合美国匹兹堡大学博士后崔浩川、东南大学副研究员孙烨、田纳西大学信息学院助理教授李恺、纽约大学阿布扎比分校博士研究生刘逢源、南京大学地理与海洋科学学院研究员古恒宇,共同发起「面向未来的科学学读书会」。读书会从2024年8月25日开始,每周六晚19:00-21:00,持续时间预计8-10周。欢迎感兴趣的朋友报名参与!

认知层面上,从复杂系统的视角研究科学,能否给我们带来对科学更深刻的理解?个人科研实践中,什么样的论文高引?怎样规划科研路线?哪些课题大有可为?集智俱乐部组织了6期「复杂系统视角下的科学学」读书会,讨论科学学相关的科研进展和经典文献,形成了包括数十位相关领域的研究者和硕博在内的科学学社区。欢迎感兴趣的朋友报名加入交流讨论。

图1 科学的成长。(A)在WoS数据库中摘录文献的年度产出量与时间的关系。(B)WoS中索引到的文献涵盖的科学新发现的增长。这是通过计算固定数量文章中概念数量来确定的(4)。

图1 科学的成长。(A)在WoS数据库中摘录文献的年度产出量与时间的关系。(B)WoS中索引到的文献涵盖的科学新发现的增长。这是通过计算固定数量文章中概念数量来确定的(4)。