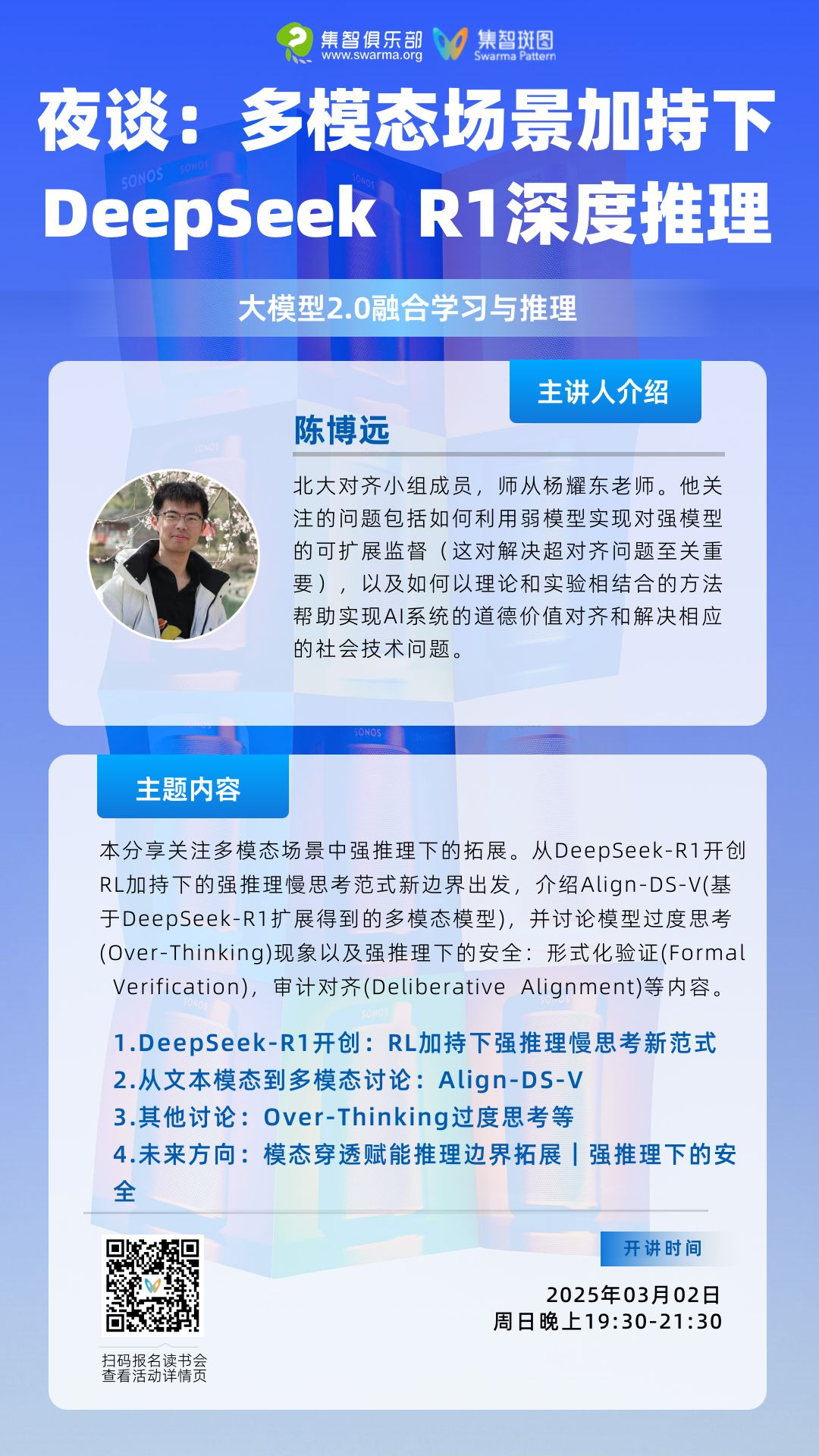

夜谈:多模态场景加持下的 DeepSeek R1 深度推理丨周日分享·大模型2.0读书会

导语

分享内容简介

分享内容简介

DeepSeek R1-Zero 和 R1 在纯文本模态上取得的优异表现十分惊艳,这也不经让人期待:多模态场景加持下 DeepSeek R1 深度推理模型将会是怎样的表现?满血671B微调是否有框架支持?能否将DeepSeek微调用于交叉领域以及本土化价值对齐和部署?

-

模态穿透和模态联动将有望进一步提升强推理能力。人类在日常生活中接收到的信息往往是全模态的,不同的感官渠道能够互相补充,帮助我们更全面地理解和表达复杂的概念。

-

全模态扩展将成为DeepSeek R1的下一个重大突破。首先,在复杂决策场景中构建起”感知-理解-推演”的闭环认知体系,在多个场景下扩展智能边界。

分享大纲

分享大纲

-

DeepSeek-R1 开创RL加持下强推理慢思考范式新边界

-

DeepSeek-R1 Zero 及 R1 技术剖析

-

Pipeline 总览 DeepSeek-V3 Base DeepSeek-R1 Zero 及 R1 细节分析 -

强推理路径对比 (DS-R1 Kimi-1.5 o-series)

-

从文本模态到多模态 -

其他讨论:Over-Thinking 过度思考等 -

未来方向分析探讨

-

模态穿透赋能推理边界拓展:Align-DS-V -

强推理下的安全:形式化验证 Formal Verification 审计对齐 Deliberative Alignment

主讲人介绍

主讲人介绍

陈博远,北大对齐小组(PKU-Alignment Team)成员,师从北京大学杨耀东老师。他关注的问题包括如何利用弱模型实现对强模型的可扩展监督(这对解决超对齐问题至关重要),以及如何以理论和实验相结合的方法帮助实现AI系统的道德价值对齐和解决相应的社会技术问题。

涉及到的参考文献

涉及到的参考文献

-

强推理 & DS-R1

-

DeepSeek-R1 技术报告 https://github.com/deepseek-ai/DeepSeek-R1 -

DeepSeek-V3 技术报告 : Liu, A., Feng, B., Xue, B., Wang, B., Wu, B., Lu, C., … & Piao, Y. (2024). Deepseek-v3 technical report. arXiv preprint arXiv:2412.19437

-

多模态 & 全模态

-

Align-Anything Github Repo: https://github.com/PKU-Alignment/align-anything -

多模态 Align-DeepSeek-V: https://huggingface.co/PKU-Alignment/Align-DS-V -

Align-Anything: Ji, J., Zhou, J., Lou, H., Chen, B., Hong, D., Wang, X., … & Yang, Y. (2024). Align anything: Training all-modality models to follow instructions with language feedback. arXiv preprint arXiv:2412.15838.

-

可扩展监督 & 形式化验证 & 拒绝对齐

-

Language Models Resist Alignment: Ji, J., Wang, K., Qiu, T., Chen, B., Zhou, J., Li, C., … & Yang, Y. (2024). Language models resist alignment. arXiv preprint arXiv:2406.06144. -

s1: Simple test-time scaling:Muennighoff, N., Yang, Z., Shi, W., Li, X. L., Fei-Fei, L., Hajishirzi, H., … & Hashimoto, T. (2025). s1: Simple test-time scaling. arXiv preprint arXiv:2501.19393. -

RedStar: Does Scaling Long-CoT Data Unlock Better Slow-Reasoning Systems?: Xu, H., Wu, X., Wang, W., Li, Z., Zheng, D., Chen, B., … & Zhang, D. (2025). RedStar: Does Scaling Long-CoT Data Unlock Better Slow-Reasoning Systems?. arXiv preprint arXiv:2501.11284.

参与信息

参与信息

时间:

2025年3月2日(本周日)晚上19:30-21:30。

参与方式:

扫码报名

大模型2.0读书会启动

o1模型代表大语言模型融合学习与推理的新范式。集智俱乐部联合北京师范大学系统科学学院教授张江、Google DeepMind研究科学家冯熙栋、阿里巴巴强化学习研究员王维埙和中科院信工所张杰共同发起「大模型II:融合学习与推理的大模型新范式 」读书会,本次读书会将关注大模型推理范式的演进、基于搜索与蒙特卡洛树的推理优化、基于强化学习的大模型优化、思维链方法与内化机制、自我改进与推理验证。希望通过读书会探索o1具体实现的技术路径,帮助我们更好的理解机器推理和人工智能的本质。

从2024年12月7日开始,预计每周六进行一次,持续时间预计 6-8 周左右。欢迎感兴趣的朋友报名参加,激发更多的思维火花!

详情请见:大模型2.0读书会:融合学习与推理的大模型新范式!