Science最新重磅综述:如何应对人工智能产生的伦理学危机?

Good Robot | Алексей Лукинский

AI悄然普及,伴随而来的伦理挑战越发不容忽视,其不可见性和影响力威胁着人类的自决能力。为了应对AI带来的风险,必须确定一套正确的基本伦理准则,来指导AI 的设计、管理和使用,并在尊重个人和社会的前提下从中获益。当然,这并非易事。这篇文章将对此进行讨论。

编译:集智俱乐部翻译组

来源:Science

原题:How AI can be a force for good

人工智能(AI)已经不仅仅是一项需要监管的新技术,它也是一种重塑日常实践、个人和专业的交互与环境的强大力量。这种力量被用在有利的方面对于人类福祉是至关重要的。

伦理在这一进程中发挥着关键作用,因为它确保了AI善用其潜力和降低风险的约束。

AI的定义可能有很多种。错误地对其进行定义的话,任何AI伦理挑战的评估充其量只是科幻小说,甚至在最坏的情况下,就像诡辩一样会使人们不负责任地分心到无关事物上。

一个科学的方法是利用经典的定义:

-

AI是一种不断增长的互动的、自主的、自学的智能体,它可以使得计算硬件执行原本需要人类智能才能成功完成的任务。

-

AI可以根据其所依赖的计算模型或技术的结构等特征来进一步定义。但是涉及到伦理和政策问题时,后面的区别不是必要的。

-

一方面,AI由数据驱动,因此面临着数据管理方面的伦理挑战,包括了许可权、所有权以及隐私权。AI可能加剧了与数据相关的挑战,但是即使没有AI也会出现这种情况。另一方面,AI是一种独特的自主和自学的智能体,因此出现了新的伦理挑战。而后者是本文的重点。

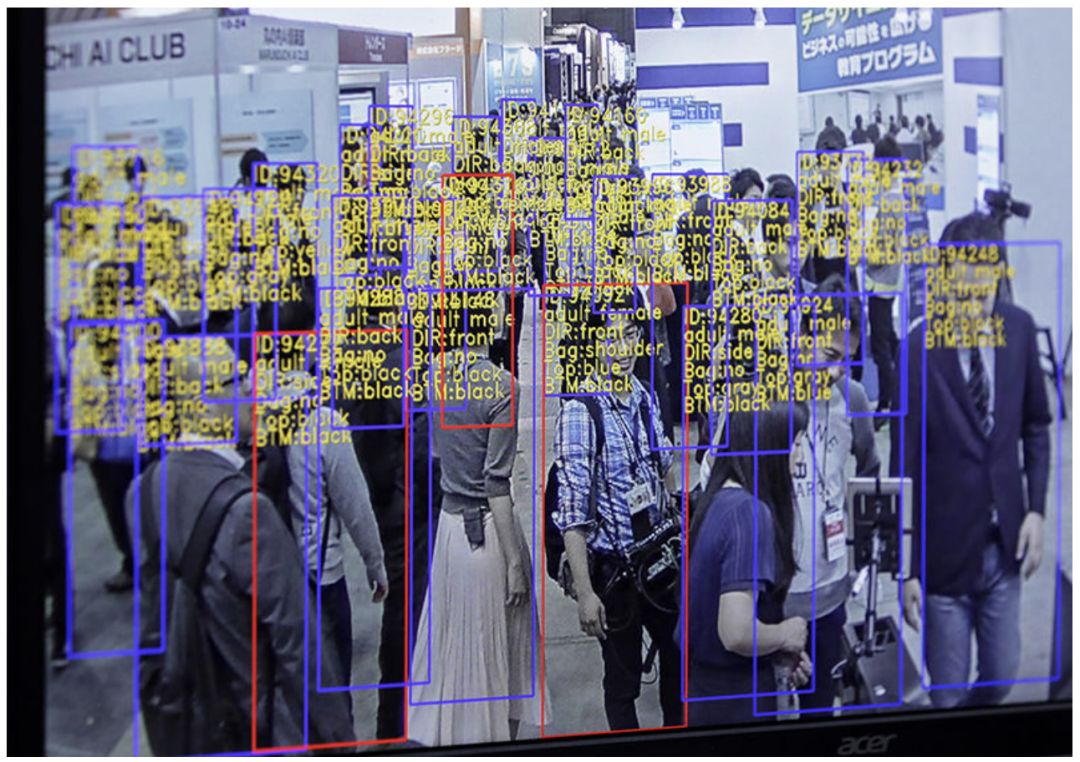

神经网络中的目标识别与跟踪技术 | Science

AI作为一种新形式的智能体,其面临的伦理争论可以追溯到1960年代了。从那时候开始,许多相关的问题都与授权和责任有关。由于AI从招聘到医疗保健的广泛使用,了解哪些任务和决策委托到了AI上,以及如何为其表现承担责任,这些都是迫切的伦理问题。

与此同时,随着AI悄然普及,新的伦理挑战就出现了。

人类自决权利的保护(the protection of human self-determination)是最重要的问题,必须要加紧解决。正如”剑桥分析公司干涉选举”(Cambridge Analytica)事件所揭示那样,在线服务的提供商将AI应用于建立用户画像来做广告推广和政治运动,于是AI能够捕捉用户的偏好和特征来塑造他们的目标并在一定程度上推动其行为,从而削弱其自决能力。

委托与责任

AI的应用正变得越来越普遍。用户依赖它们来处理从货物交付到国防保障等各式各样的任务。将这些任务分配给AI将会给社会带来巨大的好处(见图片)。它降低了成本和风险,提供了一致性和可靠性,并且能为复杂的问题提供新的解决方案。列如,AI应用可以减低85%的乳腺癌诊断错误率,AI网络安全系统可以将网络攻击的识别和抵御的平均时间从101天减少到几个小时。

Avatar Kids计划可以使得住院儿童通过一个可以远程操控的机器人出现在教室中。 | Science

然而,委托还可能导致有害的意外后果,特别是那些排除人类监督且涉及到敏感的决策和任务。COMPAS是一个臭名昭著的AI法律系统,因为它在做出准予假释决策时歧视非裔美国人和西班牙人。我们需要强有力的监管程序来尽量减少这种非预期的后果,并纠正AI任何不公平的影响。

尽管如此,如果我们只能做到事后诸葛亮,那么人类的监管是不够的。解释AI并预测其结果的技术也是必要的。DARPA(国防高级研究计划局)的AI解释程序就是一个很好的例子。这个程序的目的是定义新的技术来解释AI系统的决策过程。这使得用户可以了解AI系统是如何工作的,设计者和开发者可以改进系统以避免错误和降低滥用风险。要想获得成功,类似的项目必须从一开始就进行伦理影响分析,评估AI的利益和风险,并确定AI的设计和使用在伦理上要遵循的准则。

一位军队的网络安全专家正在调试AI。 | Science

基于人工智能的决策或行为的影响往往是许多行动者无数互动的结果,其中包括了设计师、开发者、用户、硬件、软件。这就是所谓的分布式智能体。因为智能体是分布式的导致了责任分配也是分布式的。现有的伦理框架涉及个体的责任,其目标是根据个体的行为和意图分配奖惩。但它们并不能处理分布式的责任分配。

直到最近,新定义的伦理理论才考虑到分布式的智能体。它所提出的理论依赖于合约和侵权责任并采用了一个完美无缺的责任模型。这个模型将一个智能体的责任与其采取某种行为的意图或控制其结果的能力分开,这个模型包括了分布式系统的智能体,比如责任公司等。

这是思考AI的关键,因为它在设计者,监管者和用户之间分配伦理责任。在这样做的过程中,模型在预防作恶和培养善心方面起着核心作用,因为它促使所有参与者采取负责任的行为。

要抓住AI创造的机会,并应对相关的挑战,我们必须建立良好的授权实践方法并建立一个新的模型来归因伦理责任,但是这些做法仍然不够。伦理分析必须扩大以解释AI对人类行为的无形影响。

不可见与影响力

AI的支持服务、平台和设备无处不在而且无时无刻不在运行和使用。2017年,国际机器人联合会表示,到2020年全球范围内的工厂需要安装170万台AI驱动的机器人。同一年,公司 Juniper Networks 发布了一份报告,估计到 2022 年,全球55%的家庭将拥有像Amazon Alexa这样的语音助手。

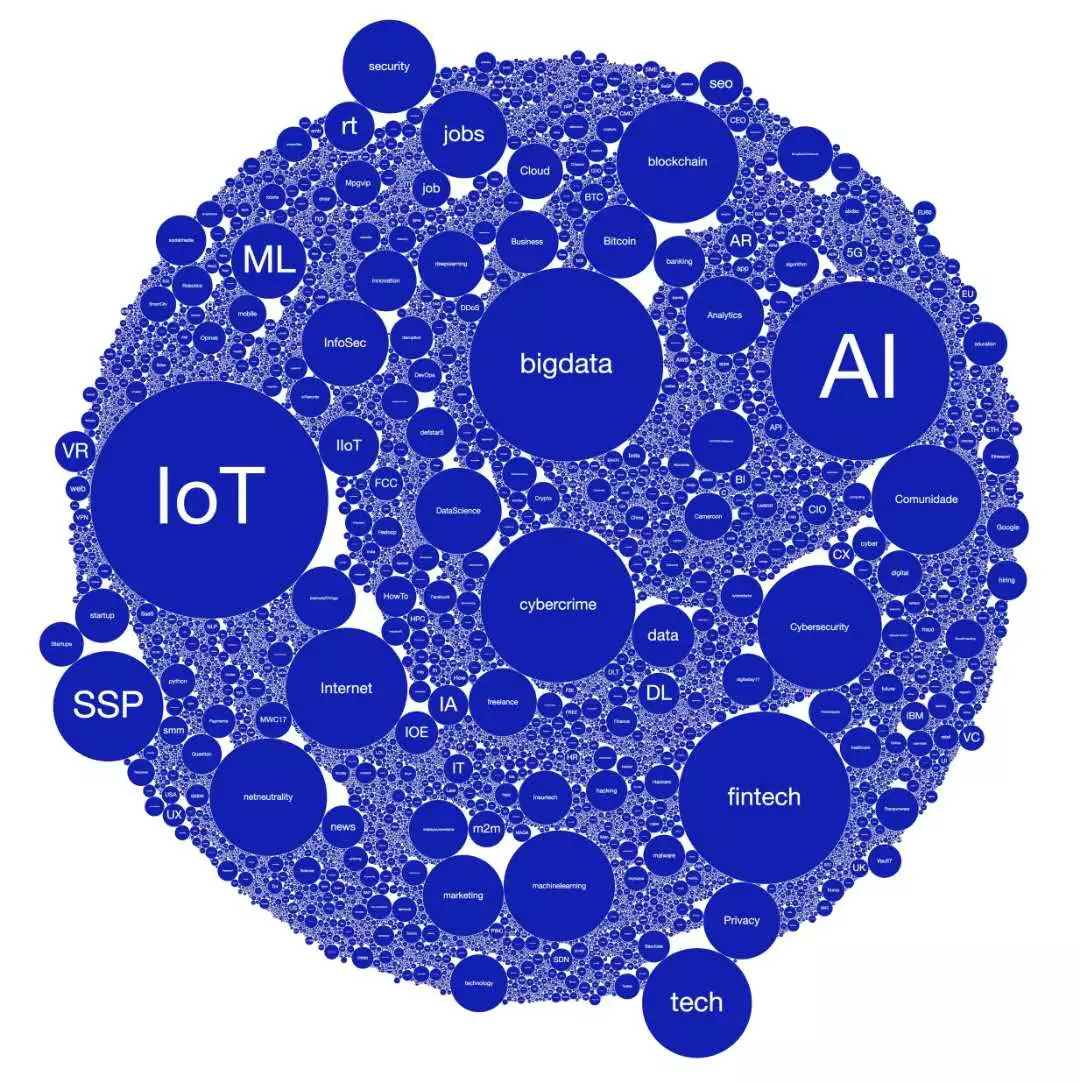

| AI4People

随着AI的成熟与传播,它融入了我们的生活、经历和环境,成为了一个看不见的协调者,并以一种便捷的,几乎不引人注意的方式来协调我们的互动。在创造新的机会的同时,这种无形地进入我们环境的AI也会带来更多的伦理问题。

有一些伦理问题是领域特定的。比如,当家庭、学校和医院要使用AI解决方案时,信任和透明是至关重要的。相同的,在工作场景中结合AI时,平等、公平和保护雇员的创造力和权利是至关重要的。但是AI的整合也带来了另一个基本风险:由于人工智能的不可见性和影响力,人类的自决(Self-determination)将受到侵蚀。

这种不可见性提高了AI的影响力。AI系统凭借其预测能力和不懈的努力,使其无处不在却又难以察觉,AI系统可以轻松、安静地塑造我们的选择和行为。这不一定是有害的。例如,它可以促进社会互动和合作。

然而,AI也可能施加超出我们意愿或理解的影响力,来破坏我们对环境和社会的控制,最终影响我们的选择、预测、身份和生活。我们有决定我们自己生活和身份的并保持我们选择开放性的能力,但是AI的错误设计和无形的使用可能会威胁到我们脆弱的自我决定能力。

转化伦理学

为了应对AI带来的风险,必须确定一套正确的基本伦理准则,来指导AI 的设计、管理和使用,并在尊重个人和社会的前提下从中获益。

这不是一项容易的任务,因为道德准则可能会因为文化背景和分析领域的不同而有所不同。这是IEEE全球自主和智能系统伦理协会倡议处理的一个问题,其目的是推动公众就应该支持AI伦理使用的价值观和原则进行讨论。

更重要的是,一些对基本准则的共识正在形成。最近一项对比分析强调了国际立法机构对AI伦理的原则和生物伦理学的一些关键性原则——互惠、非暴力、自主和正义——是有实质性重叠的。

我们有理由对它们的进一步趋同持乐观态度,因为其他的原则可以从世界人权宣言中提取出来。这种趋同将促进AI的不同伦理框架的一致性和相容性,并为AI这一技术的设计、规章和使用提供总体的伦理指导。

一旦确定了伦理准则,就必须将其转化为可执行的指导方针,以塑造基于AI的创新。这种转化是有先例的,特别是在医学领域,转化研究是建立在生物学研究进展的基础上,这样便可以开发新的疗程和疗法。

同理,转化伦理学是建立在学术进步的基础上形成监管和治理方法的。这种方法支持了即将由 AI4People 项目提出的关于AI设计和伦理规范的建议。

| AI4People

AI4People 于2018年2月在欧洲议会上成立,旨在帮助AI朝向社会和社会中每一个人都有利的方向上去。该倡议由国际专家科学委员会和利益攸关方论坛与欧盟委员会AI问题高级专家组协商,为AI的伦理和社会可持续发展提出一系列具体和可行的建议。

AI的转化伦理需要制定预见性的方法来表明可能的伦理分析,以防止意外后果。影响评估分析就是这种方法的一个例子。它们对某一组织部署的方法或技术对隐私、透明度或责任等方面的影响进行逐步的评估。

即使是富有远见的方法也永远无法描绘AI系统的所有可能性、风险和意外后果,但是可以制定可取的替代方案和有价值的行动方案并确定可能的风险和降低风险的策略。

这有一个双重优势。作为一种机会战略,预见性的方法可以帮助利用伦理的解决方案。作为风险管理的一种形式,它们通过避免伦理上不能接受的决策或行为来帮助预防或降低代价高昂的错误。这将降低由于不明确或者害怕反对,而没有做出的选择或没有抓住选择的机会成本。

AI的设计和使用的伦理规范是一项复杂却又是必要的任务。另一种选择可能会导致个人权利和社会价值的贬值,并拒绝以AI为基础的创新,最终错失利用AI改善个人福祉和社会福利的机会。人类早期没有规范工业革命对劳动力的影响,没有认识到大规模工业化和全球消费主义对环境的影响,才花费了大力气学到了这些教训。为了保护工人的权利和建立可持续发展的框架,人类付出了很多代价:几个世纪的时间、社会动荡,甚至是革命。

The Ethics of AI| medium.com

AI革命是同样重要的,人类不能再犯同样的错误。必须解决关于后AI时代社会的性质以及在这种社会中应支持AI的设计、管理和使用的价值观。这就是为什么诸如上述AI4People和IEEE项目、欧盟的AI国际战略、欧盟AI合作宣言以及AI造福人类与社会等倡议是如此地重要。

民间社会、政治、商业和学术界的协调努力将有助于确定和实施最佳战略,使得AI成为一股有益的力量,释放其在尊重人类尊严的同时促进人类繁荣的潜力。

参考文献:

-

J. McCarthy et al., AI Mag. 27, 12 (2006).

-

A. L. Samuel, Science 132, 741 (1960).

-

G.-Z. Yang et al., Sci. Robot. 3, eaar7650 (2018).

-

N. Wiener, Science 131, 1355 (1960).

-

M. Taddeo, L. Floridi, Nature 556, 296 (2018).

-

D. Wang et al., arXiv:1606.05718 [q-bio.QM] (18 June 2016).

-

P. Asaro, Int. Rev. Red Cross 94, 687 (2012).

-

S. Russell, Nature 521, 415 (2015).

-

J. Larson et al., “How We Analyzed the COMPAS Recidivism Algorithm” (May 2016);

www.propublica.org/article/ how-we-analyzed-the-compas-recidivism-algorithm.

-

L. Floridi, Sci. Eng. Ethics 19, 727 (2013).

-

U. Pagallo, in Human Law and Computer Law: Comparative Perspectives, M. Hildebrandt, J. Gaakeer, Eds. (Springer, Netherlands, 2013), pp. 47–65.

-

L. Floridi, Philos. Trans. R. Soc. Math. Phys. Eng. Sci. 374, 20160112 (2016).

-

H. Shirado, N. A. Christakis, Nature 545, 370 (2017).

-

IEEE Standards Association, Ethically Aligned Design, Version 2.

-

J. Cowls, L. Floridi, Prolegomena to a White Paper on an Ethical Framework for a Good AI Society, Social Science Research Network, Rochester, NY, SSRN Scholarly Paper ID3198732, 19 June 2018.

翻译:夏佳豪

编辑:王怡蔺

原文:

http://science.sciencemag.org/content/361/6404/751.full

推荐阅读

推荐课程

课程地址:https://campus.swarma.org/gpac=10553

集智俱乐部QQ群|292641157

商务合作及投稿转载|swarma@swarma.org

◆◆◆

搜索公众号:集智俱乐部

加入“没有围墙的研究所”

让苹果砸得更猛烈些吧!

始发于微信公众号: 集智俱乐部