一周上线课程视频速览 | 11.9-11.15

-

陈关荣:网络鲁棒性

-

理解生命复杂性的两条线索 | 生命复杂性系列读书会第一期

-

如何用少量数据学习一套动力学方程:Taylor Mapping技术 | 课程上新

-

因果推理与稳定学习 | 因果科学与Casual AI读书会第 7 期

-

复杂系统自动建模专题 | 集智凯风研读营2020(更新)

-

脑科学研究内容概述和学科交叉情况

-

James Evans:科学如何思考 | 字幕版上线狄增如:刻画度相关性 | 字幕版上线

-

张江:演化网络——将时间维度引入复杂网络模型 | 字幕版上线

陈关荣:网络鲁棒性

课前介绍和课程概览

本课程中,主要讲解作为分析工具的渗流理论、无标度网络的鲁棒性、 网络对攻击的耐受性、网络受损后的级联故障原因及其建模、构筑具有坚强鲁棒性的网络的思路,以及讨论复杂网络鲁棒性与脆弱性的内在矛盾和本质原因。

课程学习

学习地址:

https://campus.swarma.org/course/1751?from=wechat

理解生命复杂性的两条线索 | 生命复杂性系列读书会第一期

课程概览

本课程中,介绍了关于生命的复杂性和简单性这两面现象,以及现象背后的两条线索。

课程学习

课程学习

学习地址:

https://campus.swarma.org/course/2004?from=wechat

如何用少量数据学习一套动力学方程:Taylor Mapping技术 | 课程上新

课程概览

本期分享将介绍Taylor mapping技术,它可以将微分方程翻译成polynomial neural network。利用此神经网络,我们只需一个sample就可以模拟出整个系统的近似动力学。

课程学习

学习地址:

https://campus.swarma.org/course/2067?from=wechat

因果推理与稳定学习 | 因果科学与Casual AI读书会第 7 期

Causality and Its Connection to Robust Machine Learning (论文解读)

——课程概览

本次分享主要包含对于因果稳定预测和分布鲁棒优化两个方面经典论文的分享和解读,并通过一定的形式化建立起因果发现和鲁棒机器学习之间的桥梁,提供一个更加统一的视角来看待因果和机器学习。

Causal Inference and Stable Learning——课程概览

因果发现能够在不引入先验知识的情况下,自动化地在大规模时序数据中找到因果联系,本次会详细介绍因果发现的两类方法: 基于条件约束的方法 (constraint-based methods) 的和基于功能因果模型的方法 (functional causal model-based approaches)。

本课程是“因果科学与Casual AI”读书会将进行第七期的线上论文分享,主题是“因果推理与稳定学习”,将由清华大学计算机系在读博士生沈哲言和清华大学计算机系在读博士生刘家硕来进行分享。

课程学习

课程学习

学习地址:

https://campus.swarma.org/course/2071?from=wechat

复杂系统自动建模专题 | 集智凯风研读营2020(更新)

本次主题将定位为“面向复杂系统人工智能研究”,该研读营旨在实现对复杂系统的自动建模,从「复杂系统」的理论出发,借助人工智能的方法和技术,揭开人工智能的黑箱,突破现有人工智能可解释性瓶颈,推动通用、可解释性强的系统在相关应用领域的落地并解决实际问题。

本课程是集智俱乐部举办的集智凯风研读营活动录像,由张江、臧承熙、王硕等为大家介绍基于复杂系统的自动建模技术。

分享一:复杂系统自动建模概述与展望(张江)

分享二:Neural Dynamics on Complex Networks(臧承熙)

分享三:复杂网络自动建模在大气污染中的应用(王硕)

分享四:标准化流技术简介(刘晶)

分享五:神经网络归因(许菁)

分享六:Gradient-Based Neural DAG Learning(李垚鑫)

分享七:Relational State-Space Model for Stochastic Multi-Object Systems(黄龙吉)

分享八:Scalable Gradients for Stochastic Differential Equations(杜伟韬)

分享九:一个基于深度学习的通用网络重构和动力学学习方法(张章)

分享十:基于深度学习的轨迹数据挖掘(姚迪)

分享十一:Gumbel-softmax-based Optimization:A Simple General Framework for Optimization Problems on Graphs(李垚鑫)

分享十二:Temporal attention recurrent graph neural network(陈昱中)

分享十三:Wide neural networks and its tangent kernel(杜伟韬)

分享十四:对复杂系统连续变化自动建模——Neural Ordinary Differential Equations解读(张江)

分享十五:图上的连续标准化流技术:Graph Continuous Flow(张章)

课程学习

课程学习

学习地址:

https://campus.swarma.org/course/1996?from=wechat

脑科学研究内容概述和学科交叉情况

课程概览

课程背景

课程背景

大脑是人类最重要的器官,但由于其结构复杂性和功能特殊性,几百年来科学家们的探索曲折艰难。大脑是如何工作的?神经元之间的信息传递机制是什么?大脑的结构是怎么样的?为什么会产生意识和智能?一系列谜题尚未完全揭开。而且随着人工智能技术的发展遭遇瓶颈,对人脑的认识,显得尤为重要,如何借助大脑的生物智能,发展更具有智能的机器也成为了最前沿的热点问题。

所以清华大学脑科学协会、集智学园、探悉大脑成长学院、集智未来人工智能产业创新基地,发起了一系列脑科学跨界融合与产业化主题论坛,希望能一起来探索脑科学的前沿科学和产业化问题。

第一次活动,集智学园邀请了TalkingBrain 联合创始人兼CEO林思恩博士进行分享,主要面向脑与认知科学专业的学生和爱好者,以及相关交叉领域从业者,概括性介绍和探讨脑科学学科主体与相关交叉学科,普及概念知识、启发探索志趣、激发使命成就。

课程学习

课程学习

学习地址:

https://campus.swarma.org/course/2057?from=wechat

James Evans:科学如何思考 | 字幕版上线

科学作为复杂系统,有多样的成分,各个成分间有紧密的互动,展现出自然发生的、涌现的集体行为,且具有不同层次。科学的发展和持续,来自于对现有研究成果中成分的重组。

Evans提出两个概念:Content(内容)与Context(语境),Content指论文中有科技革新意义的实质内容,Context指现有的学术研究提供的语境。科学“进化”的过程,就是content与context混合的过程。Evans提出的数学模型,将每三篇论文编进一个模组(block),通过一定指标建立起公式计算论文的倾向性(propensity),研究什么样的论文有稳健型(robustness)和一般化的潜质。

Evans得出结论,科学“思考”的方式,是贝叶斯式的,展现出自我纠正的机制。论文中的模糊、深奥性(ambiguity)会吸引更多注意,并发展出更多分枝,因此不应该要求绝对的精确(precision)。

研究结果对政策有指导作用,Evans认为,为了让政策鼓励创新、有效的研究,应该去资助更小型的团队,使他们维生的需求不影响到科研生产力;应该资助人才,而非项目;对于成功率低、有风险的项目,应该降低壁垒,让人们多多去投资他们。

课程学习

课程学习

学习地址:

https://campus.swarma.org/course/707?from=wechat

狄增如:刻画度相关性 | 字幕版上线

课程概览

本课程中,将讨论如何度量度相关性,并探讨其对网络拓扑结构的影响。

-

INTRODUCTION

-

ASSORTATIVITY AND DISASSORTATIVITY

-

MEASURING DEGREE CORRELATIONS

-

STRUCTURAL CUTOFFS

-

CORRELATIONS IN REAL NETWORK

-

GENERATING CORRELATED NETWORK

-

THE IMPACT OF DEGREE CORRELATIONS

-

SUMMARY

课程学习

课程学习

学习地址:

https://campus.swarma.org/course/1750?from=wechat

张江:演化网络——将时间维度引入复杂网络模型 | 字幕版上线

课程概览

Barabasi-Albert(BA)模型是否能够描述真实的复杂网络生长?为什么科学家之间的智商差距并不大,然而引用量却有着天壤之别?复杂网络的玻色-爱因斯坦凝聚现象是怎么回事儿?为什么说真实的网络很可能生长在一个双曲空间中?什么样的模型能够描述复杂网络的加速生长现象?

-

Bianconi-Barabasi Model

-

Network Evolution Models

-

Matching Growth Model

-

Network Model in Hyperbolic Space

课程学习

课程学习

学习地址:

https://campus.swarma.org/course/1749?from=wechat

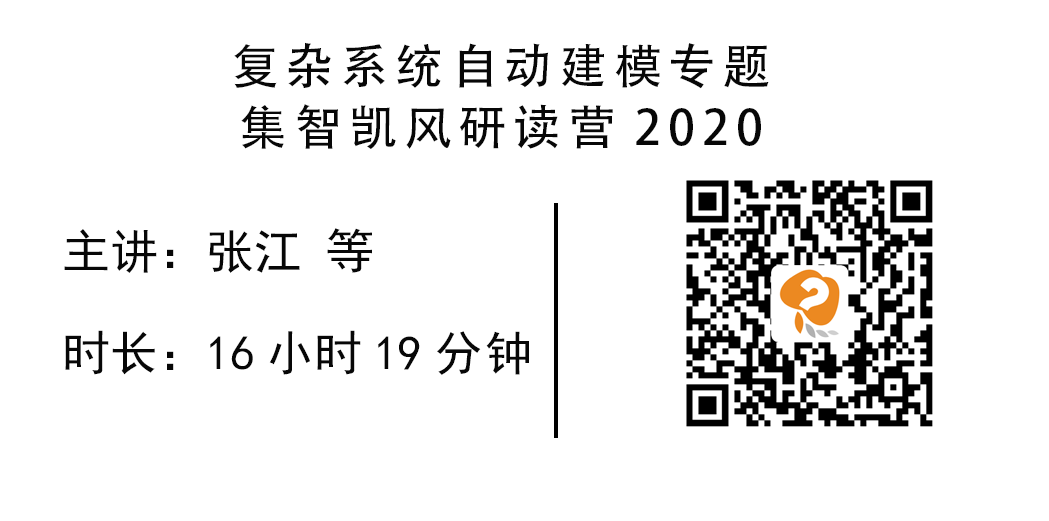

集智学园超级VIP开放

如果你是长期关注集智的老朋友,还有另一个好消息告诉你:我们首次对外公开了VIP申请通道。

成为集智VIP,你就是集智自己人了。话不多说,上图: