大脑认知的「复杂性红利」:简单就足够好

导语

我们必须经常从嘈杂和变化的观察中推断世界的潜在特性。应对这一挑战的复杂的、概率性的方法,如贝叶斯推理是准确的,但对认知要求很高,依赖于大量的工作记忆和适应性处理。简单的试探法很容易实现,但可能不太准确。复杂性和准确性之间的适当平衡是什么?在Nature Human Behaviour上的最新一篇文章中,建立了一个复杂程度可变的策略层次模型,并发现了一个收益递减的幂律:复杂性的增加在准确性上带来的收益越来越小。收益递减率系统地取决于世界上的统计不确定性,因此当不确定性太高或太低时,复杂的策略不会比简单的策略提供实质性的好处——在这两者之间,有一个“复杂性红利”。研究在两个心理物理学实验中证实了关于工作记忆和适应性如何被不确定性调节的特定模型预测。

研究领域:认知控制,学习算法,人类行为

刘志航 | 作者

邓一雪 | 编辑

论文题目:Human inference reflects a normative balance of complexity and accuracy

论文链接:https://www.nature.com/articles/s41562-022-01357-z

我们经常利用一系列的感官观察来推理周围世界当前和未来的状态,但这种推理的一些基本原则尚不清楚,因为推理在形式、准确性和复杂性方面差异很大。如果需要对复杂的推理获得准确的认知,则需要依赖于大量的工作记忆和适应性处理。这篇文章的作者认为,认知推理的复杂性可以代表一种认知成本,平衡推理的有效和高效,即足够准确但又符合有限理性的计算和信息收集约束,是推理中的重要基本原则。

1. 推理模型的层次结构

1. 推理模型的层次结构

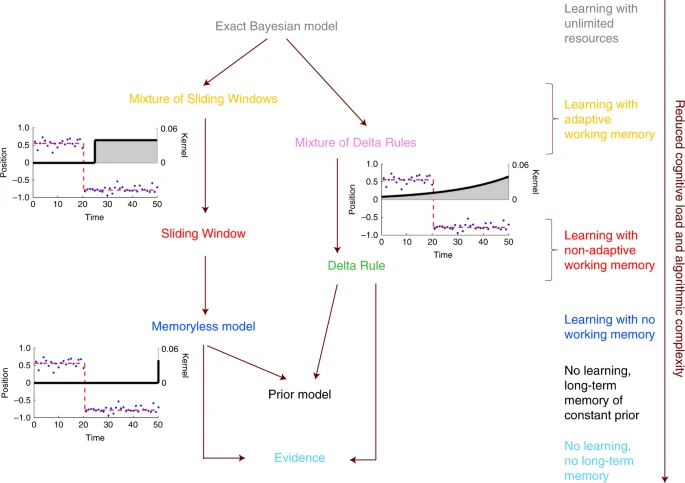

为了验证这一想法,作者构建了一个分层的推理模型,用以模拟人类的认知过程,这个模型可以在准确性和计算复杂性两个方面进行评级。

处于层次结构顶端的是精确贝叶斯推理模型,它使用一个概率框架将噪声和波动性结合到一个策略中,在所有先前的观察基础上对世界的当前和未来状态做出最准确的推断,但它也可能需要几乎无限的计算资源,因此也提供了一个最大复杂度的基准。然后,层次结构之下构建了两个嵌套的模型,表明精确的贝叶斯推理可以使用更简单的计算单元的加权组合来近似,产生了越来越简单的贝叶斯推理的近似(图1)。沿着层次结构往下,模型的适应性和内存(工作记忆)要求逐渐降低,同时准确度和复杂度也随之降低。

作者研究了这些嵌套模型在一般任务上的表现,这些任务需要在有噪声(观察中的随机波动)和波动(环境结构的根本变化)的情况下进行推理,并确定了两个基本原则。第一个原则是收益递减法则,即无论环境中的不确定性有多大,随着复杂性的增加,准确性的提高会逐渐变小。第二个原则是不确定性和最有效模型的复杂性之间的非单调关系:当不确定性很高或很低时,简单的模型是最有效的,而更复杂的模型在不确定性的中间水平上是有用的。

最后,作者还用两个行为实验来证明这些原则适用于人类行为。总的来说,这些结果提供了对认知过程的见解,在不同的条件下,这些认知过程可能被不同的参与,以执行高效和有效的推理。

2. 复杂性的收益递减幂律

2. 复杂性的收益递减幂律

学界已经提出了许多模型来解决动态、嘈杂环境下的推理问题。这些模型的范围从贝叶斯概率策略到更简单的启发式更新过程,如非适应性的 Delta 规则。当从有限的样本中推断出概率分布时,复杂的模型对新数据的概括能力比简单的模型差。

即使一个复杂的模型有较低的预测误差,相对于一个简单的模型,其准确性的提高是否“值得”?什么时候以及如何将复杂的模型简化为更简单的模型?

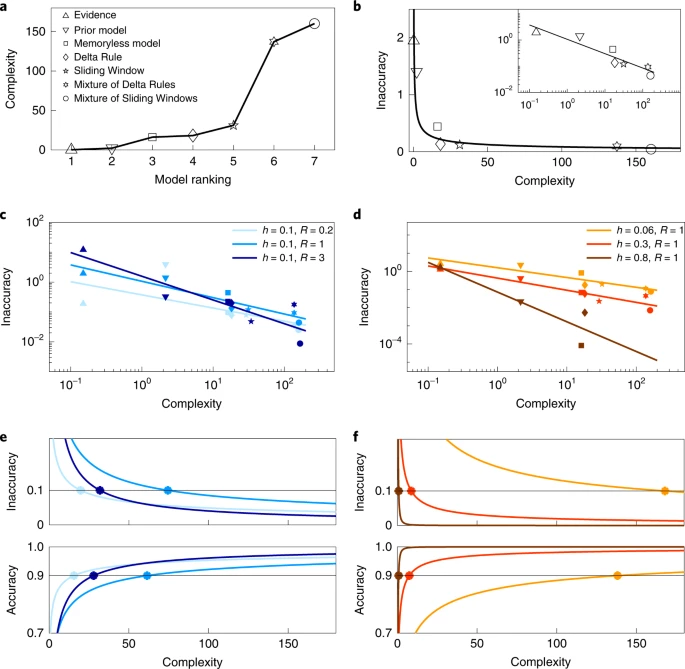

为了研究模型性能与计算成本的确切比例,作者以实现模型所需的平均计算和内存操作数来评估图1中模型的算法复杂性(图2a)。对于非参数贝叶斯模型,这一成本随着观测值的增加而线性增长,因此算法复杂性发散到无穷大。

通过将每个模型的算法复杂性与它相对于贝叶斯基准的性能联系起来,发现了一个收益递减的幂律:如图2所示,增加一个模型的复杂性会使预测的改进逐渐变小(图2b-f)。通过使用最复杂的模型,预测精度达到最大。然而,在高噪音和低噪音下,低复杂度的模型已经在贝叶斯最优模型的10%以内(图2e中浅蓝色和深蓝色的线条)。

同样地,当波动性较大时,低复杂度策略的表现几乎与完整的贝叶斯模型一样好(图2f 中的红色和棕色线条)。这些结果表明,复杂的推理程序只在有中等数量的噪声和低基本波动率的狭窄范围内有用。这些结论在“足够好”的阈值范围内是稳健的(图2e, f中黑色阈值线的移动),并且对非常不同的模型实现方式也是如此。

3. 简单通常就足够好

3. 简单通常就足够好

上面确定的收益递减幂律表明,复杂的模型只有在狭窄的条件范围内才是必要的,否则较简单的模型就足够好。对于预测问题,使用适应性和工作记忆的相对复杂的策略是必要的,以便在低波动性和中等噪音的相对较小的条件范围内最大限度地提高准确性。

相比之下,极其简单的策略(例如,证据、先验和无记忆模型)在广泛的条件下几乎达到了准确率的峰值。例如,当波动率很高时,最简单的模型几乎和贝叶斯模型一样好,因为世界是如此多变,过去的观察并不能提供很多有用的信息。当波动性低的时候,潜在的变量在一段时间内是持续存在的,所以过去的观察对预测未来变得更加有用。

然而,这种有用性取决于噪声,当噪声过高(所有模型的表现都一样差)或过低(甚至简单模型的表现也很好)时,复杂推理的好处就不复存在了。因此,当波动率较低时,存在一种非单调性(’倒U’)模式,这样简单的模型在低和高噪音时就足够了,但在中等噪音时就需要复杂的策略;当波动率较高时,简单的策略总是足够好。

对于估计问题,出现了稍微不同的模式(图3b)。对于高噪音和高波动率,以及低噪音跨波动率,某些简单的策略几乎和复杂的策略一样有效,比如对于预测问题。在固定的波动率下,随着噪声从零增加,复杂的模型对于平衡当前的噪声证据和过去的观察结果以及先验数据变得有用。但是当噪声变得很高时(观察结果不可靠),越来越简单的模型又足以达到接近最佳的估计性能。因此,就像预测问题一样,当波动性较低时,良好估计所需的复杂性与噪声之间存在倒U型关系。然而,在噪声-波动的大部分情况下,估计问题比预测问题更能从使用复杂的推理方案中受益。

为了证实上述的原则与人类推理的一致性,作者最后还进行了两个不同的心理物理实验,将理论与人类推理联系起来。这一不同的任务在理论上和实验上支持了模型复杂度与噪声的倒 U 趋势的普遍性以及模型复杂度随波动性的下降趋势。

总体而言,该研究表明。使用适应性过程或工作记忆的复杂策略只在有限的条件范围内是必要的,这些条件的特点是低波动性和中等噪音,而工作记忆在稍宽的不确定性水平上是有用的(特别是对高噪音)。这些依赖性导致了认知需求和任务难度之间的倒U型关系:当推理容易时,简单的策略就足够了,例如当来自环境的当前证据高度可靠,因此不需要历史信息;当推理困难时,例如当传入的信息非常嘈杂或不稳定,复杂的推理没有什么好处。

这种关系让人想起了组合优化问题的一个已知特征。NP-complete 问题,如K-satisfiability、图形着色、旅行推销员和哈密尔顿路径问题,在寻找解决方案所需的计算复杂度方面都具有易-难-易的特征。困难的问题通常聚集在一个关键的中间值的秩序参数上,这标志着从可解决性到不可解决性的阶段性转变。从广义上讲,这个顺序参数在我们的推理任务中扮演着类似于任务难度或环境不确定性的角色。

这项研究的发现暗示了认知过程的分层(嵌套)组织以及大脑可以参与或脱离它们的自然、有效的方式。这种组织意味着大脑可以通过调整单一、灵活的推理过程的参数来满足各种不同环境和任务的需求。

论文 Abstract

复杂科学最新论文

集智斑图顶刊论文速递栏目上线以来,持续收录来自Nature、Science等顶刊的最新论文,追踪复杂系统、网络科学、计算社会科学等领域的前沿进展。现在正式推出订阅功能,每周通过微信服务号「集智斑图」推送论文信息。扫描下方二维码即可一键订阅:

推荐阅读

-

神经复杂系统前沿:关于认知大脑的两种观念 -

前沿综述:绘制大脑因果图 -

渗流是大脑效率、鲁棒性和经济性的起源? -

《张江·复杂科学前沿27讲》完整上线! -

成为集智VIP,解锁全站课程/读书会 -

加入集智,一起复杂!

点击“阅读原文”,追踪复杂科学顶刊论文