重磅Science论文:用人工神经网络解决量子多体问题

近年来,人们发现了越来越多的基础物理学与人工智能之间的联系。首先,深度学习与物理系统存在着本质上的对应关系,例如受限玻尔兹曼机与自旋系统,深度神经网络与重整化群;其次,机器学习是一种比传统的数值模拟、蒙特卡洛模拟更有效的对复杂问题近似求解的方法。这种有效性让人们开始思考物理与机器学习更深层次的联系,也许它能帮我们获得对智能以及宇宙本质的真知灼见。

本文是于2017年2月发表在科学上的重磅文章,作者提出了基于神经网络的量子态表示方案,并展示了它在多个经典量子多体问题上的高精度和表达能力。这篇文章甚至引发了我们对量子系统更本质的思考:是否那些让我们困惑的反直觉的量子特性,特别是哥本哈根解释压根儿就不存在,而只不过是更复杂的经典系统的某种表象呢?而这种表象却恰恰能被神经网络很好地表达出来。换个角度思考,一个经典的复杂的神经网络有可能展现出那些匪夷所思的量子系统特征,如量子遂穿、不确定性原理等等。

用人工神经网络解决量子多体问题

Giuseppe Carleo1* and Matthias Troyer1,2

摘要

量子物理中的量子多体问题给我们带来的很多挑战都起源于对编码在多体波函数中指数级复杂性中的非平凡关联特性如何描述。在本文中,我们对于几个物理学感兴趣的问题,展示了如何通过机器学习的方式来学习波函数,从而可以将量子多体问题的复杂性简化为可计算的程度。我们引入了一种量子状态的变分表示方法,该方法基于隐层神经元数量可变的人工神经网络来完成。我们将说明强化学习方案既能找到基态,又能描述复杂相互作用的量子系统的幺正时间演化。我们的方法在描述一维和二维的交互自旋模型这样的简单系统时,达到了很高的精度。

波函数Ψ是量子物理学中最基本的对象,也是从古典物理框架下最难被理解的东西了。Ψ是一个庞大的数学量,因为它包含了一个量子态的所有信息,无论是单个粒子还是一个复杂的分子。原则上,对通用的多体量子态进行充分编码需要指数级数量的信息;然而,真实的情况是描述许多物理多体系统的波函数却只需要有限的信息就够了,其容量远比相应的Hilbert空间所能容纳的最大容量要小得多。在这样的系统中,我们用现代的方法可以根据有限数量的量子纠缠和少量的物理状态就能用有限的经典资源解出多体的薛定谔方程。

人们通常会使用直接依赖于波函数的数值近似方法,来对物理相关构型进行有限采样,也可以对量子态进行有效的压缩。例如人们常用的量子蒙特卡罗(Quantum Monte Carlo,QMC)方法(即统计模拟方法)等随机方法就属于第一类,它们都依赖于概率框架,并通常要求一个半正定的波函数(1-3)。而另一种压缩的方法依赖于波函数的有效表征,例如矩阵乘积态(Matrix Product Space, MPS)(4-6)或更常见的张量网络(Tensor Network,7-9)。然而,采用现有方法也有很多失败的例子,这主要是由于QMC(10)(量子蒙特卡罗方法)本身的问题,以及当前的压缩方法在高维度系统中表现低效的问题。因此,尽管这些方法取得了显著的成功,但仍有大量未经探索的物理条件存在,其中也包括许多未解决的问题,从高维度系统的动力学特性(11、12)到强相互作用的费米子(13、14)的精确基态属性这样的基础问题。这种问题的核心就在于找到一种普遍的策略,以减少庞大的多体波函数的指数级复杂性,从而降低其最基本的特征维度(15)。

广义地看,实际上这些问题的本质就是对数据进行降维和特征提取。而这恰恰就是人工神经网络最擅长的事情(16)。它们已经在各种各样的问题和环境,包括图像和语音识别(17)再到博弈(18)中表现突出。最近,神经网络被引入到了物理学研究中(19-23),但这些研究都集中在对物相的分类上,前提条件是从这些物相的状态中进行精确采样是可能的。而在没有精确样本的先验知识的情况下,解决多体问题的挑战性目标仍然未被探索,而这恰恰是人工智能有可能发挥作用的领域。因此,认识人工神经网络是否能够修改和调整自己以适应分析和描述这样的量子多体系统是一个非常基本,也是具有实际意义的问题。这种能力可以被用来解决在某种物理条件下,那些用现有的精确数值方法难以解决的量子多体问题。

这里我们介绍一种用人工神经网络方法来表达波函数的方法,它由一组内部参数W指定。我们给出了一个随机框架,用于加强对参数W的强化学习,使给定量子哈密顿量H的基态和时间依赖的物理状态能得到最好的表示,然后对神经网络的参数进行训练。或者当我们对动态属性感兴趣时,我们还可以通过静态变分蒙特卡罗(Varational Monte Carlo,VMC)采样(24)或时间依赖的VMC(25,26)方法来求解。接下来,我们就通过对一维和二维Ising(伊辛)模型和海森堡(Heisenberg)模型来验证这种方法的正确性。我们证明了神经网络量子态(Neural network Quantum State,NQS)的强大能力,并在基态和非平衡动力学等问题中获得了目前所能达到的最好的精度。

考虑一个量子系统, 这个系统有N个离散取值的自由度S=(S1,S2,…,SN), 这些自由度有可能是自旋, 玻色子占据数, 或者其他类似的值. 该系统的多体波函数是一个从N维的集合S(数量呈指数增长的)到复数之间的映射, 这些复数能够完全表征量子态的振幅和相位。我们看待这个问题的视角是, 将波函数理解成一个可计算的黑匣子, 这个黑匣子能够对给定的多体系统的构型S, 依据Ψ(S)返回一组相位和振幅. 我们的目标是用一个神经网络来近似这个能进行计算的黑匣子, 使得它经过训练后可以极好地表征我们关心的系统。针对特定的任务, 人们已经提出了不同的人工神经网络结构作为备选方法.。同理, 用来描述一个多体系统所需要的最好的(神经网络)结构也因问题而异。更具体地说, 我们将讨论限定在受限玻尔兹曼机(Ristricted Boltzman Machine,RBM)这种特殊的结构上, 用它来描述自旋1/2的量子系统。

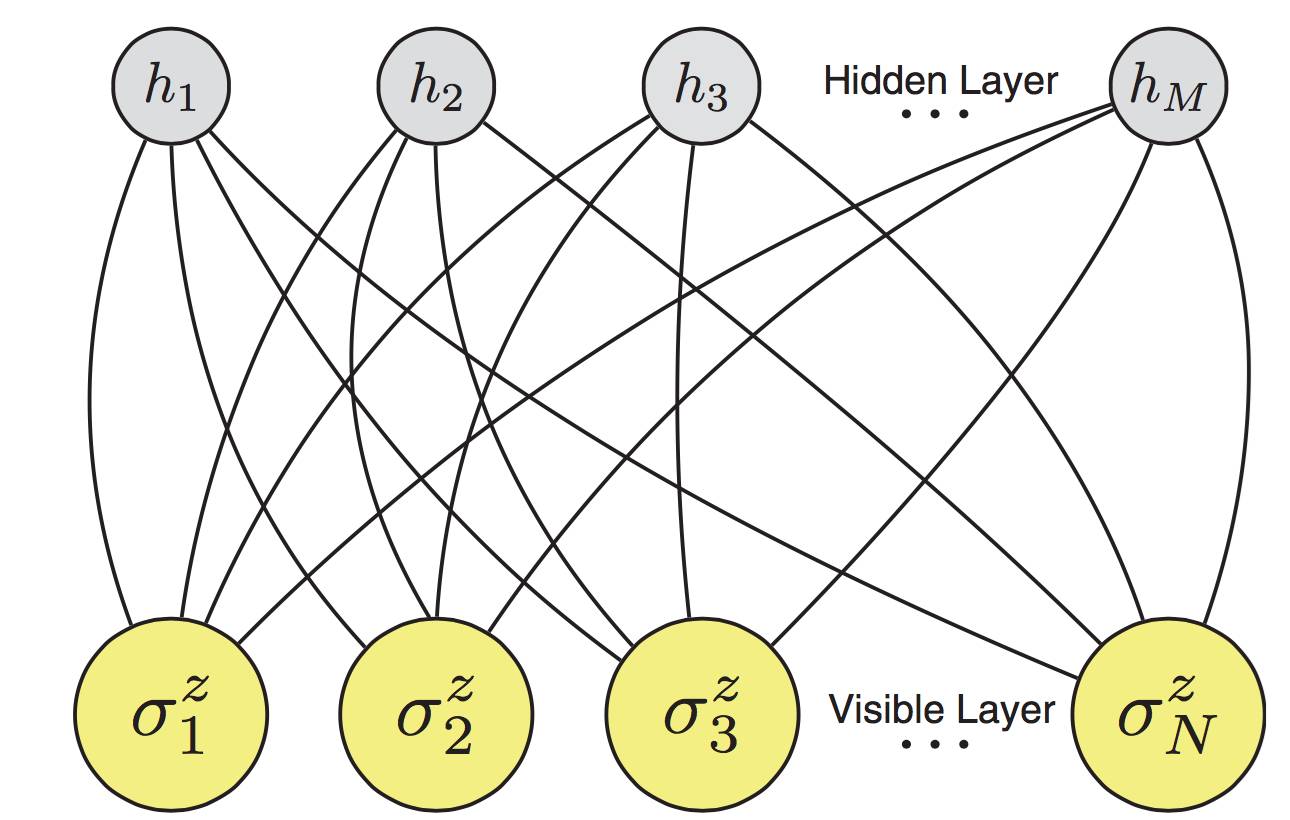

图1:人工神经网络编码了N个自旋的多体量子态

这是一个受限玻耳兹曼机的体系结构,它是由N个可见的人工神经元(黄点)和M个隐藏层神经元(灰点)组成的。对于多体自旋状态的每一个值S=(σ^z_1,σ^z_2,…,σ^z_N),人工神经网络计算波函数Ψ(S)的值。

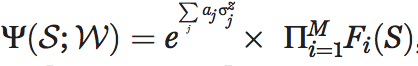

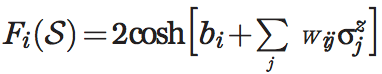

在这个情况下, RBM人工网络拥有一层具有N个节点的可见层, 可见层对应一组选定基矢下的自旋物理量(如: S=(σ^z_1,σ^z_2,…,σ^z_N) , 还拥有一层具有M个辅助变量的隐藏层(h1,h2,…,hM) (图1). 这样的描述对应量子态的变分表达式:

这里,hi={-1,1}是一组M个隐含自旋变量,网络参数:W={a,b,W}完全表征了这个网络对于一个给定的输入状态S的响应。由于这个结构的特点是没有层内部的相互作用, 这些隐变量可以显式地通过求迹来消除, 求迹后波函数就变成了:

且有

这个网络的权重一般来说取复数, 这样能同时完整描述波函数的振幅和相位。

数学上人们已经证明了所谓的”表示定理”(27-29),这个定理能够保证用(神经)网络来近似足够光滑且规则的高维函数。该定理同样能够保证NQS(Neural network Quantum States,神经网络量子态)能够描述错综复杂的多体波函数, 只要多体波函数满足这些条件。我们有理由相信NQS结构是一个合理的选择。

这个表述方式的一个实际好处是, 原则上它的(训练)效果能够通过增加隐变量的数量得到系统性的提高. 数量M(或者, 等价的说, 比例a = M/N,其中M为隐含层单元数量,N为可见层单元数量)扮演了类似MPS里成键维度的角色。但是, 这些隐层单元导致的关联本质上是非局域的, 因此, 这种关联十分适合描述具有任意维度的量子系统。

NQS另一个便利之处是, 特定的对称性会降低,例如, 具有平移不变性的受限波尔兹曼机中考虑晶格平移对称性可以减少NQS方案(NQS Ansatz)的变分参数的数量。具体点来说, 对于整数的隐变量密度a = 1,2,…, 权重矩阵取特征过滤器的形式W_j^{f},其中f属于[1,a]。这些过滤器总共有aN个变分元素, 而不是非对称情况下的aN^2个元素。

如果现在给定一个一般的量子多体态的表达式, 我们余下的任务就是用机器学习,通过最优化网络参数W, 来求解多体问题。一个非常有意思的应用是, 具体的多体状态我们并不知道, 一般我们通过给定的哈密顿量H来求解静态薛定谔方程H|Ψ>=E|Ψ>或含时方程:H|Ψ(t)>=id/dt |Ψ>。在没有真实的波函数提供样本的情况下,通过监督学习得到Ψ并不可行。但是, 我们推出了一个自恰的强化学习方法. 在这个方法中, 基态波函数或者含时波函数可以基于变分原理提供的反馈进行学习得到.

为了证明NQS在复杂多体量子态的描述中的准确性,我们首先关注于找到给定哈密顿函数H的未知基态的最好的神经网络表示的目标。在这种情况下,实现强化学习需要通过使网络权重W的能量E(W) = <Ψ_M|H|Ψ_M >/<Ψ_M |Ψ_M>的期望值最小化来达到。在随机设置下,这是通过迭代方案实现的。在每次迭代k中,对于给定的一组参数W_k实现|Ψ_M(S;W_k)|^2的蒙特卡罗采样。同时,获得能量梯度的随机估计。然后,使用一种改进的梯度下降优化(32)来给出下一组权重W_{k+1}。这个方法的总体计算成本与标准基态量子蒙特卡罗模拟的总体计算成本相当(参见原论文补充材料)。

为了验证我们的方案,我们考虑了两个典型的自旋模型的基态问题,横向场Ising (TFI)模型和反铁磁海森堡 (AFH)模型。他们的哈密尔顿算子分别是:

和:

其中σ_x,σ_y和σ_z是泡利矩阵。

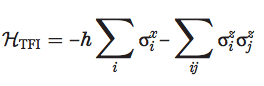

图2: 多体基态的神经网络表示

这些结果是一维二维Ising这样的原型系统产生的。在最顶端的图中,我们展示了在临界点h=1下面的一维横向场Ising模型(TFI)以及反铁磁模型(AFH)模型的特征图。在这两种情况下, 隐含层的密度都是a=4,格点包含了80个。每一个水平的色图展示了第f个特征图W_j^{(f)}在第j个格点的取值(为了图像更清楚,我们将横坐标轴加宽了)。在下面一组图中,我们展示了立方网格上的2D海森堡模型,其中a=16。在这种情况下,水平(或竖直)坐标轴对应了x(或y)在10*10格点上的坐标。每一个有效的特征图都相当于一个有效的可以对自旋构型进行过滤的滤波器,捕获了最重要的量子关联。

接下来,我们将考虑具有周期边界条件(PBCs)的一维和二维(1D和2D)晶格的情况。在图2中,我们展示了两个隐含变量密度α = 4的两个自旋模型的基态的最优网络结构,并且我们规定这些结构具有平移对称性。我们发现每个过滤器f = [1,…α]能够学习在基态波函数中涌现的特定的关联特征。例如,在二维情况下(如图2所示,右边的面板)神经网络学习与反铁磁性关联的模式。NQS的一般行为完全类似于在卷积神经网络中观察到的那样,在不同层次学习输入数据的特定结构。

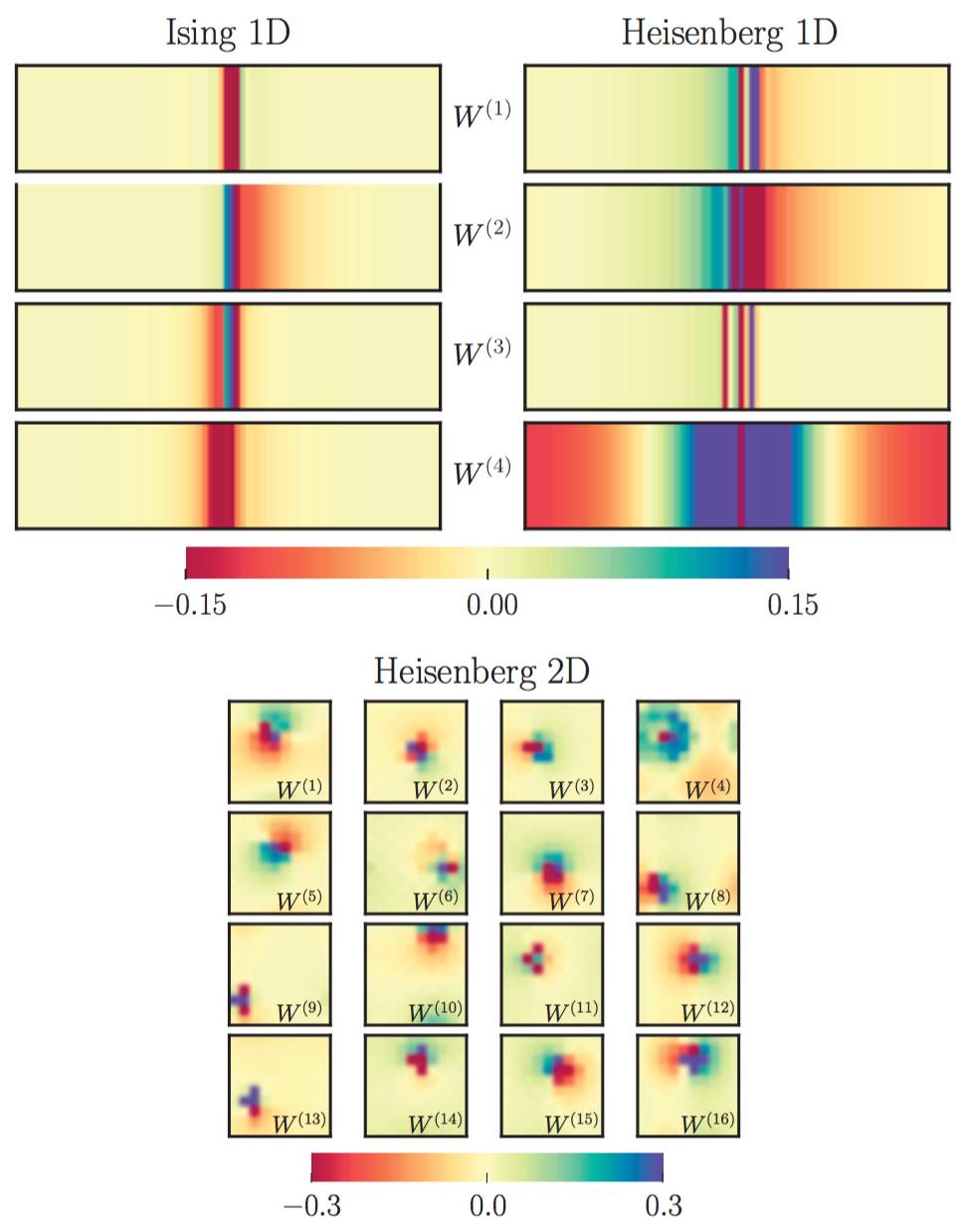

图3.用神经网络量子态(NQS)寻找多体基态能量

几个测试用例显示了NQS基态能量相对于精确值的误差。可以通过增加隐藏单元密度α获得基态能量的任意精度。(A) 在给定磁场强度h的几个不同取值下,1维TFI模型的精度,该模型由80个格点组成自旋链,具有周期性边界条件(PBCs)(我们隐去了低于10^{–8} 的点以提高可读性)。(B) 80个格点具有周期边界条件的自旋链得到的精度与Jastrow 假设的精度(水平虚线)对比。(C) 在10×10格点上具有周期边界条件的AFH模型精度与采用EPS [上虚线(35)]和PEPS [下虚线(36)]的精度对比。对于这里考虑的所有情况,NQS方法在一维上达到了MPS级精度,并系统性地改进了2维有限格点系统的最佳已知变分状态。

在图3中,我们展示了NQS的精度,将其量化为基态能量E_{rel} = (E_{NQS}(α)-E_{exact})/|E_{exact}|相对误差在不同α和模型参数下的取值。在图3A,我们在具有PBCs的1维链上用费米化的TFI模型的精确结果与NQS的能量变化进行了比较。最明显的结果是,NQS实现了一个可控且任意精准的准确性,与对于α的幂律行为相符。最难学习的基态是在量子临界点h = 1附近,尽管如此,我们可以通过相对适度的隐藏单元密度轻松实现每一个百万分之一的显著精度。同样的精度可以在更复杂的一维AFH模型中得到(图3B)。在这种情况下,我们还观察到基态能量误差的系统性下降,对于小的α = 4,在临界点获得与TFI模型相同的高精度。我们的模型的精度比自旋Jastrow 方案高几个数量级(虚线图3B)。同样有趣的是将α值与能够达到相同精度水平所需要的MPS约束维度M进行比较。例如,在有PBCs的AFH模型中,我们发现如果应用标准的密度矩阵重整化群(Density Matrix Renormalization Group,DMRG)(33),我们需要M~160才能达到NQS在α = 4的准确度。这表明了NQS方案可以对多体状态进行更紧凑的表示,这比相应的MPS方案所需要的变分参数少了约三个数量级。

我们接下来研究了二维正方形阵列上的AFH模型(与QMC结果的比较,见图3C)(34)。考虑到量子态有纠缠,对于NQS来说,研究二维情况会更加困难。尽管如此,随着α的增加,我们总能发现变量会有系统性的改进,定量上这与一维情况类似。难度增加反映在收敛性更慢了。当然,我们还是能得到和现有最先进方法不相上下的结果的,甚至更好。特别是在隐单元密度相对较小的情况下(α〜4),我们已经获得了与最有名的有限大小集群变分方程(variational results)相同的结果[(35)的纠缠plaquette状态(EPS)和(36)投影纠缠对状态(PEPS)]。进一步增加α能得到一个可观的改进,最终产生迄今为止在有限网格上该2维模型的最佳变分结果。

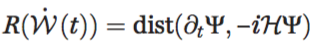

神经网络量子态(NQS)并不仅限于基态问题的研究,还可以扩展到含时的薛定谔方程。关于这个问题,我们定义了复数域上的含时网络权值W(t)。在不同的时间t下,根据狄拉克的非定态原理(37, 38),可以训练W(t)并衍生出最好的量子动力学。在这个条件下,变分残差:

成为了关于时间权值导数的目标函数,要通过训练求其最小值来找到。在随机结构中,这个过程通过包含时间的VMC方法(25,26)来实现。在每一个时间都对|Ψ_M(S;W(t))|^2进行采样,随后通过计算给出使损失R(t)^2最小的W(t)的随机估量,其计算成本为O(aN^2)。当由时间产生的附加项得到确定,并且对时间整合后,就可以通过这个方法方便的获得全部的时间演化结果。

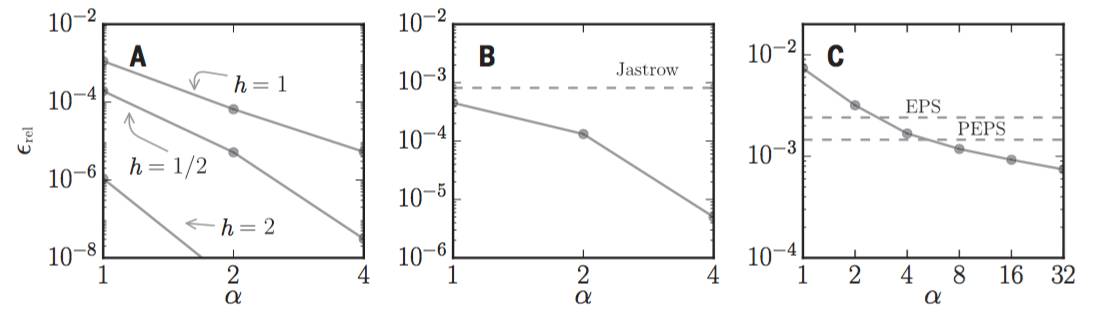

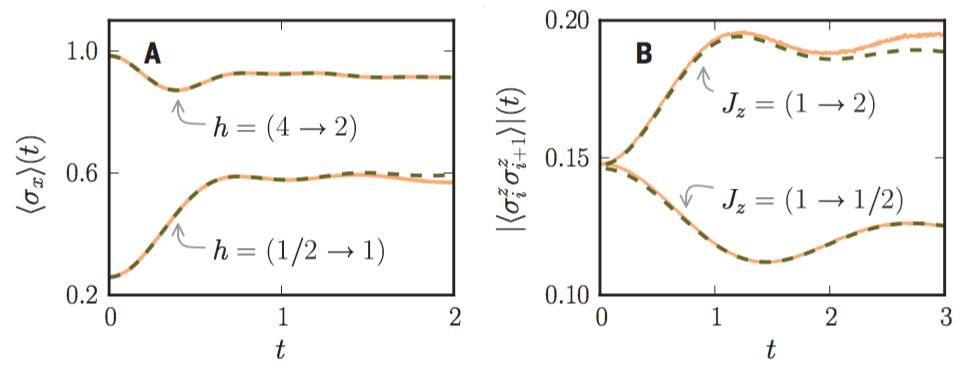

图4:NQS的多体幺正时间演化

该图显示了由量子退火(Quantum quench)引起的NQS时间演化结果(实线)。(A)TFI随时间改变的横向自旋极化,与准确结果(虚线)对比。(B)AFH模型中演化后的依赖近邻自旋统计,与在t-DMRG中获得的准确结果(虚线)对比。所有的结果都参照热力学限定的一维链代表,同时有限尺寸修正小于线宽。

为了证明在动力学环境下NQS的效率,我们考虑在自旋模型中的耦合常数进行量子退火所诱导出的幺正动力学。在TFI模型中,我们通过迅速改变横向场的方法引起非线性的量子动力学:这个系统首先处在某一个场hi的TFI模型基态,然后在横向场hf<>hi下演化。我们将我们的结果和在控制系统中的具有PBCs的一维链的费米化的TFI模型获得的解析解对比。在图4A中,准确的由时间决定的横向自旋极化的结果与在α=4时的NQS系统进行了对比。在AFH模型中(图4B),我们研究了纵向耦合Jz的量子退火,并且监控了最近邻的时间演化相关性。我们将时间演化结果(α=4)和已经存在数字的开放边界的MPS动力学系统(39-41)相对比(图4B)。

结果表明,幺正动力学的预测仍然可以获得很高的精度,这更加证实了以神经网络法为基础的途径可以用来解决量子多体问题,不仅在基态下适用,在建立的由复杂原因引起的激发态模型也适用。

展望

基于人工神经网络的变分量子态能够用来有效的捕获了一维和二维的纠缠多体问题的复杂性。尽管这里用到的受限玻尔兹曼机很简单,但是我们在基态和典型自旋模型的动力学演化方面都取得了很高的精度。在不远的将来,人们会设计出更多的研究方法。机器学习的新进展,比如深度网络架构和卷积神经网络都可以成为更先进的NQS的基础,因此这有可能大大增强它的表达能力。此外,将我们的方法延伸到除自旋系统以外的量子系统中去也是相当直接的。我们期待着利用这种方法来求解最具挑战性的二维费米子的问题。最后,作为张量网络状态的一种变体,NQS具备内在的非局域关联特性,这就使得对多体量子态的表达可以更简洁。因此对NQS纠缠特性的形式化分析可能给量子信息理论带来本质上的新概念。(点击阅读原文下载原文pdf)

翻译志愿者介绍:

本文译者是集智俱乐部志愿者孙金薇 、黄 晨 、李丽京 、王宇剑 ,感谢大家的辛勤翻译。

黄晨 物理学博士在读,主要方向为凝聚态物理,对量子计算和机器学习感兴趣。(同时也是本期的优秀译者,撒花!)

王宇剑,来自内蒙古呼和浩特,研究生三年级,物理专业,喜欢跆拳道,羽毛球,游泳。

孙金薇,目前大三,感兴趣的领域是html5和css。

李丽京,服装设计师,感兴趣的方向是复杂科学、人工智能、认知神经科学等。

想加入集智俱乐部,成为翻译志愿者?扫码即可申请~

参考文献与注记

1. D. Ceperley, B. Alder, Science 231, 555–560 (1986).

2. W. M. C. Foulkes, L. Mitas, R. J. Needs, G. Rajagopal, Rev. Mod. Phys. 73, 33–83 (2001).

3. J. Carlson et al., Rev. Mod. Phys. 87, 1067–1118 (2015). 4. S. R. White, Phys. Rev. Lett. 69, 2863–2866 (1992).

5. S. Rommer, S. Ostlund, Phys. Rev. B 55, 2164–2181 (1997).

6. U. Schollwöck, Ann. Phys. 326, 96–192 (2011).

7. R. Orús, Ann. Phys. 349, 117–158 (2014).

8. F. Verstraete, V. Murg, J. I. Cirac, Adv. Phys. 57, 143–224 (2008).

9. K. H. Marti, B. Bauer, M. Reiher, M. Troyer, F. Verstraete, New J. Phys. 12, 103008 (2010).

10. M. Troyer, U.-J. Wiese, Phys. Rev. Lett. 94, 170201 (2005). 11. A. Polkovnikov, K. Sengupta, A. Silva, M. Vengalattore, Rev. Mod. Phys. 83, 863–883 (2011).

12. J. Eisert, M. Friesdorf, C. Gogolin, Nat. Phys. 11, 124–130 (2015).

13. A. Montorsi, The Hubbard Model: A Collection of Reprints (World Scientific, 1992).

14. D. J. Thouless, The Quantum Mechanics of Many-Body Systems (Reprint of the Academic Press, ed. 2, 1972).

15. J. K. Freericks, B. K. Nikolić, O. Frieder, Int. J. Mod. Phys. B 28, 1430021 (2014).

16. G. E. Hinton, R. R. Salakhutdinov, Science 313, 504–507 (2006).

17. Y. LeCun, Y. Bengio, G. Hinton, Nature 521, 436–444 (2015).

18. D. Silver et al., Nature 529, 484–489 (2016).

19. S. S. Schoenholz, E. D. Cubuk, D. M. Sussman, E. Kaxiras, A. J. Liu, Nat. Phys. 12, 469–471 (2016).

20. J. Carrasquilla, R. G. Melko, https://arxiv.org/abs/1605.01735 (2016).

21. L. Wang, Phys. Rev. B 94, 195105 (2016).

22. G. Torlai, R. G. Melko, Phys. Rev. B 94, 165134 (2016).

23. M. H. Amin, E. Andriyash, J. Rolfe, B. Kulchytskyy, R. Melko, https://arxiv.org/abs/1601.02036 (2016).

24. W. L. McMillan, Phys. Rev. 138, A442–A451 (1965).

25. G. Carleo, F. Becca, M. Schiró, M. Fabrizio, Sci. Rep. 2, 243 (2012).

26. G. Carleo, F. Becca, L. Sanchez-Palencia, S. Sorella, M. Fabrizio, Phys. Rev. A 89, 031602 (2014).

27. A. N. Kolmogorov, Dokl. Akad. Nauk SSSR 108, 179–182 (1961).

28. K. Hornik, Neural Netw. 4, 251–257 (1991).

29. N. Le Roux, Y. Bengio, Neural Comput. 20, 1631–1649 (2008).

30. K. Sohn, H. Lee, “Learning invariant representations with local transformations,” in Proceedings of the 29th International Conference on Machine Learning, Edinburgh, Scotland, 26 June to 1 July 2012 (Omnipress, 2012), pp. 1311–1318.

31. M. Norouzi, M. Ranjbar, G. Mori, “Stacks of convolutional restricted Boltzmann machines for shift-invariant feature learning,” in Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition, 20 to 25 June 2009 (IEEE, 2009), pp. 2735–2742.

32. S. Sorella, M. Casula, D. Rocca, J. Chem. Phys. 127, 014105 (2007).

33. M. Dolfi et al., Comput. Phys. Commun. 185, 3430–3440 (2014).

34. A. W. Sandvik, Phys. Rev. B 56, 11678–11690 (1997).

35. F. Mezzacapo, N. Schuch, M. Boninsegni, J. I. Cirac, New J. Phys. 11, 083026 (2009).

36. M. Lubasch, J. I. Cirac, M.-C. Bañuls, Phys. Rev. B 90, 064425 (2014).

37. P. A. M. Dirac, Math. Proc. Camb. Philos. Soc. 26, 376–385 (1930).

38. Y. I. Frenkel, Wave Mechanics: Advanced General Theory (International Series of Monographs on Nuclear Energy: Reactor Design Physics, The Clarendon Press, 1934). 39. S. R. White, A. E. Feiguin, Phys. Rev. Lett. 93, 076401 (2004).

40. G. Vidal, Phys. Rev. Lett. 93, 040502 (2004).

41. A. J. Daley, C. Kollath, U. Schollwock, G. Vidal, J. Stat. Mech. 2004, P04005 (2004).

42. B. Bauer et al., J. Stat. Mech. 2011, P05001 (2011).

推荐阅读:

集智QQ群|292641157

商务合作|zhangqian@swarma.org

投稿转载|wangting@swarma.org

◆ ◆ ◆

搜索公众号:集智俱乐部

加入“没有围墙的研究所”

让苹果砸得更猛烈些吧!

始发于微信公众号: 集智俱乐部