当神经网络学会辨识小猫,它就忘记了如何分类小狗,这一现象被称为人工神经网络的灾难性遗忘(catastrophic forgetting)。人工神经网络容易遭受灾难性遗忘:当依次学习多个任务时,它们在最近的任务中表现良好,但以牺牲之前学习的任务为代价。在大脑中,睡眠通过回放最近和过去相互冲突的记忆痕迹,在持续学习(incremental learning)中发挥着重要作用。近日发表于 Nature Communications 的最新研究测试了这样一个假设:在人工神经网络中实施类睡眠阶段,可以在新的训练过程中保护旧的记忆,减轻灾难性遗忘。

睡眠被实施为离线训练,使用局部无监督的 Hebbian 可塑性规则和噪声输入。在持续学习框架下,睡眠能够恢复原来被遗忘的任务。以前学过的记忆在睡眠期间自发地回放,对每一类输入形成独特的表征。与旧任务相对应的表征稀疏度和神经元活动增加,而与新任务相关的活动减少。这项研究表明,模拟睡眠式的动力学的自发回放可以减轻人工神经网络中的灾难性遗忘。

论文题目:

Sleep-like unsupervised replay reduces catastrophic forgetting in artificial neural networks

https://www.nature.com/articles/s41467-022-34938-7

任何一个智能体,都需要在稳定性和可塑性中取得权衡。一方面,神经网络必须是可塑的,这样网络的参数可以改变,以便准确地表示和响应新的任务。另一方面,网络必须是稳定的,这样才能保持对旧任务的了解。尽管深层神经网络可以在从复杂游戏到图像识别等任务中达到超人的表现水平,但它们在稳定性-可塑性的权衡上处于次优。

在动物和人类中,睡眠时与清醒学习时的自发神经元活动相互关联,这种现象被称为睡眠回放。睡眠期间,神经元在没有外部输入的情况下自发活动,并在大脑各区域产生复杂的同步活动模式。最近学习的记忆与相关的旧记忆的在睡眠过程中的回放,使网络能够形成正交记忆表征,重叠的神经元群体内的竞争记忆共存,从而促成局部可塑性,允许突触的改变只影响相关的记忆,如此,人脑得以“温故而知新”。

来自神经科学的结果表明,应用于神经网络的类睡眠回放,原理上可以减少机器学习模型中的灾难性遗忘。而该研究提出的睡眠重放巩固(Sleep Replay Consolidation,SRC)算法证实了这一发现。该算法先使用反向传播算法训练一个人工神经网络,接下来,模拟类似于睡眠的自发性大脑动力学,运行一次性的网络模拟,通过网络向前传播自发性活动。接下来对网络进行反向传播,以便应用局部 Hebbian 可塑性规则来修正神经元权重。在运行这个无监督训练阶段多次之后,使用常规反向传播进行测试或进一步训练。

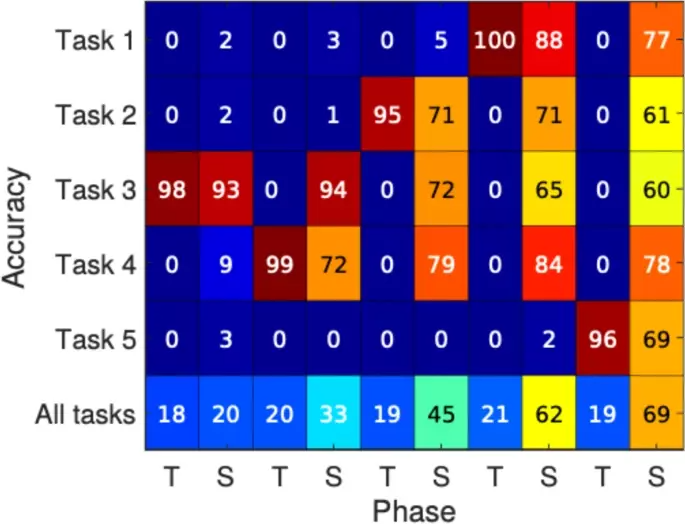

图1展示了在MINST数据集上,让神经网络在每次学到一个新的分类任务后经过一个类睡眠回放,可以看到最终各个任务的准确率都偏高,因此可以说,SRC算法避免了灾难性遗忘。

图1. MINST数据集上,在训练完新任务后加入类睡眠回复后,各任务及总任务的准确性

SRC 可以单独使用,也可以与其它训练方法结合使用,以进一步提高这些方法的域泛化性能和对抗攻击时的鲁棒性,解决连续学习问题。研究表明,学习到新任务后,在睡眠期间神经元的自发重新激活参与局部可塑性规则,可以恢复旧任务的表现,从而克服灾难性遗忘。

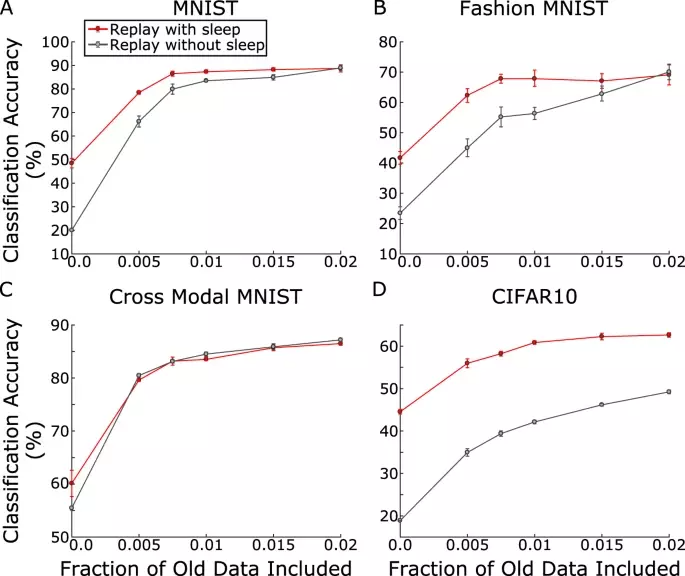

图2展示了在当前流行的应对灾难性遗忘的方法预演(rehearsal)之上,当旧数据的比例增加后,使用SRC的模型在各种数据集中的表现都优于不使用的方法,尤其是大数据集CIFAR10上的差异更加明显。

图2. 在MINST、Fashion MINST、Cross Model MINST及CIRFAR10 数据集上,加入和未加入类睡眠回放时的分类准确度对比。

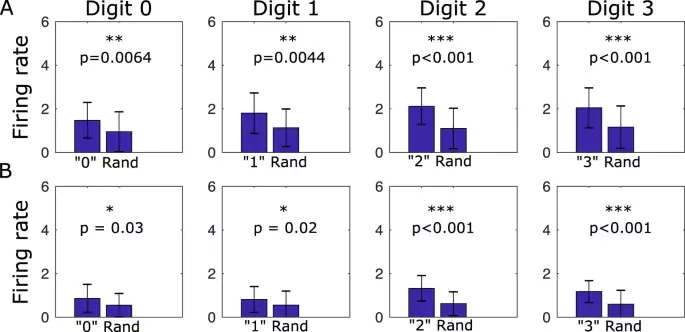

研究者还考察了SRC算法发挥作用的机制,发现在类睡眠回放时激活的神经元,属于和旧任务相关的(见图3)。类睡眠回放不仅通过增加旧任务的连接性,而且通过减少代表最新任务的连接性来避免灾难性遗忘。

图3. 数字特异性神经元在睡眠期间的激活率大于第一(A)和第二(B)隐层神经元的随机子集的激活率。

研究还发现,当最初的任务表现不好时,通过类睡眠回放还可以提升之前任务上的性能,即可提高模型的泛化能力。当网络训练不足,初始性能低时,SRC 可以大大提高性能,而不涉及任何新的训练数据。然而,如果旧任务训练良好,SRC 不能提高甚至略微降低性能。这与神经科学的数据一致,表明睡前学习表现与人类睡后程序技能增加之间呈负相关,即好的学习者在睡眠后表现出的表现增加小于差的学习者。

该研究提出了一个受到已知生物睡眠作用启发的无监督睡眠回放巩固算法SRC,可结合其他方法(例如正则化或预演),恢复神经网络在训练习得新任务后,旧任务相关的连接模式。SRC算法模拟生物睡眠回放的基本特性,包括:(a) 睡眠期间神经元的自发活动导致先前学习的激活模式被回放,(b) 无监督的 Hebbian可塑性修改连接矩阵,以增加任务特异性连接,并修剪旧任务特异神经元之间的过度连接,从而增加表征的稀疏性,并减少不同输入类之间的表征重叠。

未来的工作可能需要探索更复杂的睡眠活动模式(例如睡眠波)和不同睡眠周期的学习规则,如何应用于神经网络的训练。

Artificial neural networks are known to suffer from catastrophic forgetting: when learning multiple tasks sequentially, they perform well on the most recent task at the expense of previously learned tasks. In the brain, sleep is known to play an important role in incremental learning by replaying recent and old conflicting memory traces. Here we tested the hypothesis that implementing a sleep-like phase in artificial neural networks can protect old memories during new training and alleviate catastrophic forgetting. Sleep was implemented as off-line training with local unsupervised Hebbian plasticity rules and noisy input. In an incremental learning framework, sleep was able to recover old tasks that were otherwise forgotten. Previously learned memories were replayed spontaneously during sleep, forming unique representations for each class of inputs. Representational sparseness and neuronal activity corresponding to the old tasks increased while new task related activity decreased. The study suggests that spontaneous replay simulating sleep-like dynamics can alleviate catastrophic forgetting in artificial neural networks.

神经科学和人工智能领域的多位著名学者近日发表 NeuroAI 白皮书认为,神经科学长期以来一直是推动人工智能(AI)发展的重要驱动力,NeuroAI 领域的基础研究将推动下一代人工智能的进程。文章发表后引发热议:神经科学是否推动了人工智能?未来的人工智能是否需要神经科学?

本着促进神经科学、计算机科学、认知科学和脑科学等不同领域的学术工作者的交流与合作,集智俱乐部联合北京师范大学柳昀哲、北京大学鲍平磊和昌平实验室吕柄江三位研究员共同发起了「NeuroAI」读书会,聚焦在视觉、语言和学习领域中神经科学与人工智能的相关研究,期待能够架起神经科学与人工智能领域的合作桥梁,激发跨学科的学术火花。