Nat. Mach. Intell. 速递:Regression Transformer 支持分子语言建模的并发序列回归和生成

关键词:生成模型,Regression Transformer,多任务语言模型

论文题目:Regression Transformer enables concurrent sequence regression and generation for molecular language modelling 论文来源:Nature Machine Intelligence

论文链接:https://www.nature.com/articles/s42256-023-00639-z

生成模型(generative model)在自然科学中取得了巨大进步,但其可控性仍然具有挑战性。分子或蛋白质生成模型的一个致命弱点是归纳偏差(inductive bias),可能反映感兴趣的连续性质。

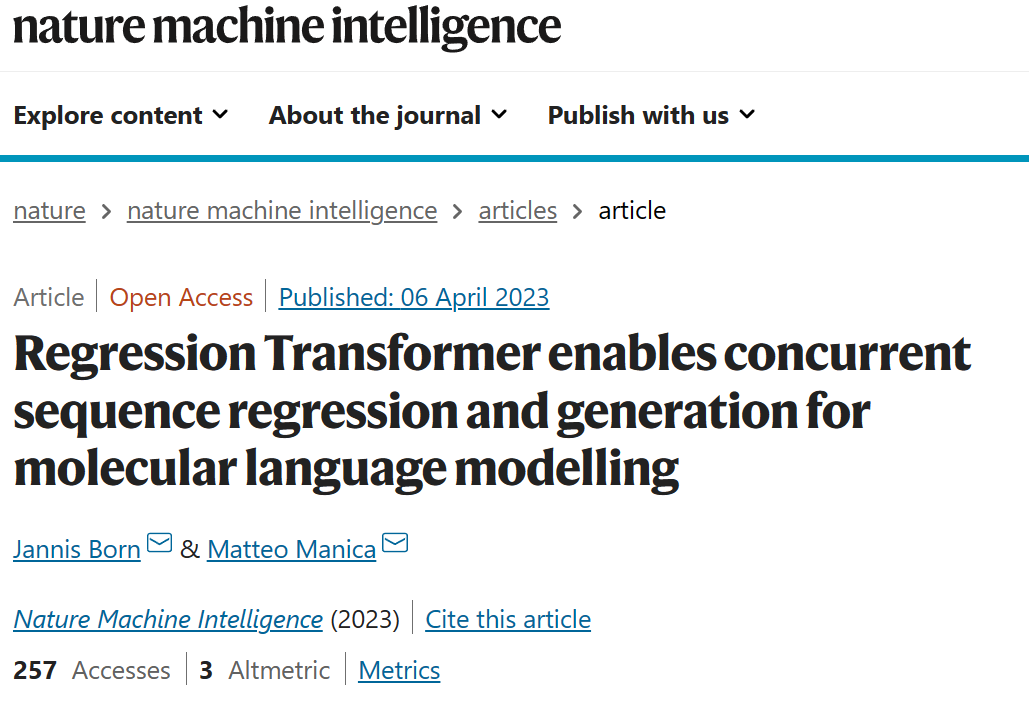

最近发表在 Nature Machine Intelligence 的这篇文章提出了一种将回归抽象为条件序列建模问题的方法,称为回归转换器(Regression Transformer,RT)。这是一种新型的多任务模型,可以在数字和文本标记的组合上进行训练,与 Transformer 中处理回归的规范方式不同。这为多任务语言模型引入了一个新的方向,无缝地桥接了序列回归和条件序列生成。他们证明,尽管使用标称尺度(nominal-scale)训练目标,Regression Transformer 在小分子、蛋白质和化学反应的性质预测中的效果,可能超过常规回归模型的性能。

更重要的是,用连续属性启动同一个模型,产生了一个强大的条件生成模型(conditional generative model),该模型在子结构约束的、属性驱动的分子生成基准中优于专门的方法。他们由交替的训练方案训练二分法,使模型能够基于期望的属性约束来修饰种子序列。此种多任务方法有望成为材料设计的基础模型。

图1. Regression Transformer 概览

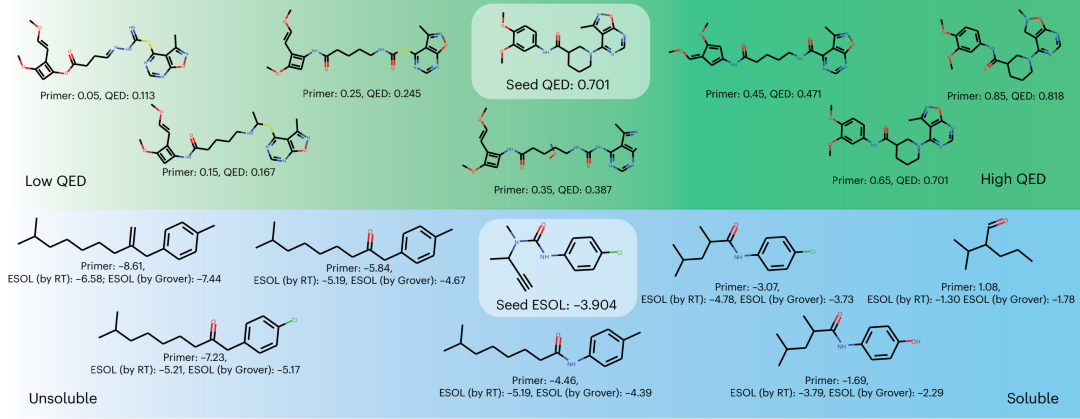

图2. 用 Regression Transformer 进行属性驱动和局部优化的分子设计

AI+Science 读书会启动

推荐阅读