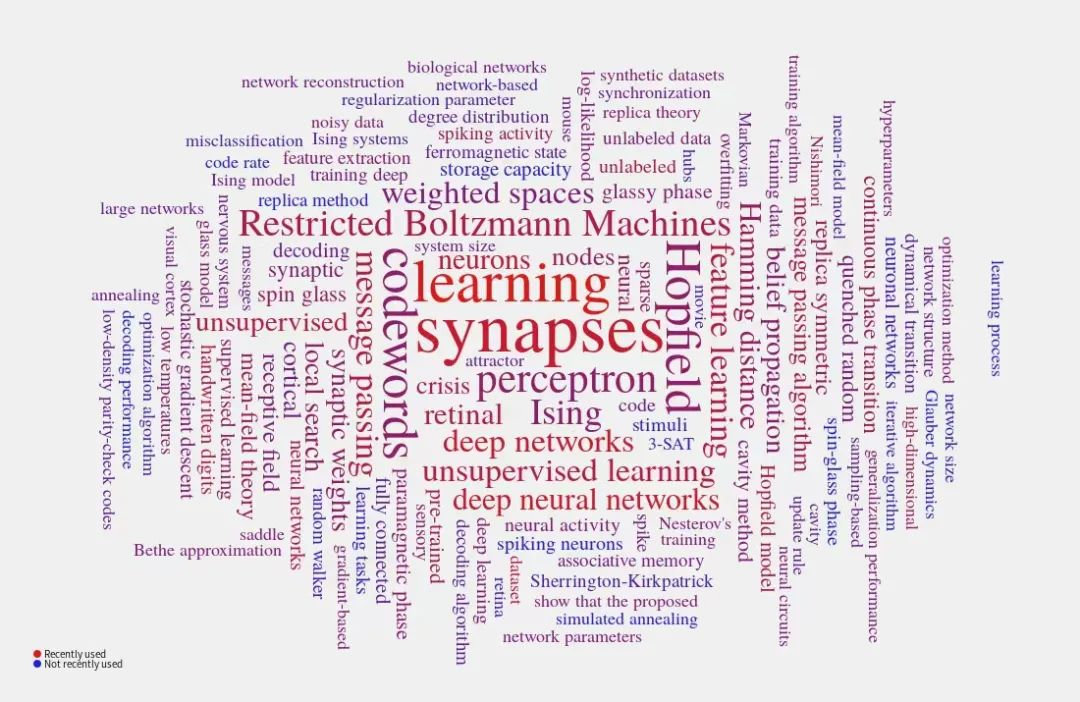

理解大脑是最具挑战的学科之一。像人工神经网络一样,大脑有广泛的不同抽象层次,特别在理论研究方面。虽然更抽象的模型失去了对于低层次细节的预测能力,但拥有了精确解释系统如何行之有效的概念上的好处,而且数学描述可以是普适的,不受具体细节影响(或称琐碎的变量)[1]。一个开创性的例子是霍普菲尔德模型[2],其精确揭示了在大脑中观察到的联想记忆的机制[3,4]。虽然作为物理学家的玩具模型从神经生物学上看十分不合理,但这些不合理之处被后来的研究柔和,更重要的是,从这个模型诞生了理论神经科学这门在 21 世纪十分有生命力的学科,并与当今 AI 的盛行息息相关。该模型的详细介绍可见专著[59]或中文综述[105]。近年来,由于大型语言模型的迅速发展,对于霍普菲尔德网络的研究兴趣被重新点燃(物理学家霍普菲尔德获得了 2023 年在东京大学颁发的玻尔兹曼奖章)[5,6]。

马尔(David Marr)认为[7],理解神经系统可以分为三个层次:计算(即大脑解决任务)、算法(即大脑如何解决任务,也是信息处理的层次)和实现(即神经回路层次)。对于人工神经网络,研究人员将前两个层次简单映射到一个玩具模型层次上(特别是在理论研究中)。在深度学习[8,9]的驱动下,即使是前两个层次,现在也变成了解决具有挑战性的现实世界问题的想法。并且,生物学细节也被纳入到神经网络[10–13]模型中,甚至用于设计新的学习规则[14]。事实上,关于知觉、认知、记忆和行动的生物学机制的神经科学研究已经提供了各种富有成效的洞见,并启发了人工神经网络的实证/科学研究,这反过来又启发了神经科学研究人员设计模型来理解大脑机制[15-17]。因此,将物理学、统计学、计算机科学、心理学、神经科学和工程学相结合起来,提供理论预测,揭示深层(生物)网络甚至智能[18]的内部工作原理是很有希望的。人工智能可能与自然智能有不同的原理,但两者都可以相互启发,其理解可能需要建立新的数学与物理基础。

为神经计算提供一个统一的理论框架的目标是非常具有挑战性的。由于人们对于神经网络的研究兴趣愈发强烈,出现了许多重要而亟待解决的科学问题。我们将在[104]下面列出其中我们认为最重要的八个问题,并提供我们对这些基本问题的背后可能构建的统计力学理论的个人观点。

从旨在从原始数据中提取统计规律的无监督学习的角度来看,我们可以问,什么是这些规律的好的表示,以及有意义的表示是如何实现的?目前这些问题尚未有满意的答案。一个很有前景的论点是,在深度网络结构中,浅层的纠缠流形随着层数变深逐渐解纠缠并且在输出层变成线性可分的特征[19–23]。因为可以分离神经活动的重叠模式[24],流形观点在系统神经科学的研究中也很有前景。关于流形变换的完整自洽的理论仍然缺乏,这使我们仍无法充分理解哪些关键网络参数控制着流形的几何,更重要的是不知道学习如何重塑流形。例如,突触之间的相关性(在学习过程中产生的)会减弱在网络由浅到深时发生的去相关过程,但与正交的突触[22,25]相比,会有利于降维。此外,还可能存在其他生物学上可信的因素,如归一化、注意力、稳态控制[26,27],也可以用于检验流形变换假设。

另一个从信息论的角度出发的论点表明,根据信息瓶颈理论[28, 29],输入信息被最大程度地压缩成隐层表示,其中与任务相关的信息应该在输出层最大程度地被提取出来。从这个意义上说,信息论上的最优表示必须在无关变量变化下保持不变,且其组成部分必须最大程度地独立,这可能与解释观察结果的因果因素(潜在原因)有关(参见下面的第五个挑战)。用物理学的语言来说,与细粒度的表示在浅层中形成相比,更粗粒度(或更抽象)的表示在更深的层次中形成。微观水平上突触之间的相互作用如何决定这种表示的转换仍然难以捉摸,因此值得未来加以研究[30, 31]。

智力在某种程度上可以被认为就是泛化的能力,特别是在学习的样本数很少的情况下。因此,泛化也是当前深度学习研究中的一个热点。传统的统计学习理论认为,当样本数量远远少于需要学习的参数数量时,过拟合效应应该很强,因此不能解释目前深度学习的成功。一个很有前景的观点是研究损失函数景观和泛化特性[32–35]之间的因果关系。这一点在一个单层感知机的情况下,一个统计力学理论可以被系统地推导出来[36,37]。与经典的偏置-方差均衡(测试误差随模型复杂度增加的 U 形曲线)[38]不同,深度学习在过参数化的区域[34,39]中能达到最先进的表现。然而,对于多层感知机模型,如何提供关于过拟合效应与不同参数化机制(例如,欠量参数、过量参数化,甚至超量参数)的分析论证成为一个非平庸的任务[40]。最近的一项对单隐层网络的研究表明,第一次相变发生在插值点,在那里完美的拟合是可能的。这种相变反映了典型解(平衡态物理)难以采样的性质。随着过参数量的增加,非典型解的不连续出现会发生第二次相变(非平衡或大偏差稀有事件物理)。它们是有良好泛化性质的宽极小值。这第二个相变为学习算法的有效性设置了一个上界[41]。

对于一个无限宽的神经网络,存在一个懒惰学习机制,其中过量参数的神经网络可以很好地用初始化附近的一阶泰勒展开相对应的线性模型来近似,因而复杂的学习动力学仅仅是训练一个核机器[42]。此外,阐明懒惰学习(或神经切向核极限)和特征学习(或平均场极限)哪个可以解释深度监督学习的成功仍然是一个未解之谜,富有挑战性[43–45]。

对抗样本是指那些在人类难以察觉的修改下,却导致深度学习决策系统出现意外错误的输入。深度神经网络的这种对抗脆弱性给实际应用带来了重大挑战,包括现实世界的问题和 AI4S 研究(用于科学研究的人工智能)。在物理学中,具有大量自由度的系统可以用低维宏观参数来描述。从几何角度解释分层计算可能有助于揭示网络对于对抗样本的神秘的易受攻击性质[31, 46, 47]。从这个意义上说,通过一些序参量来解释对抗脆弱性起源的低维度理论仍然缺乏。尽管近期有一些努力致力于这个方向的工作[47–49],但在即将到来的研究中预计会有更加令人激动的结果。

即使在新任务领域中只有少数几个示例,生物大脑仍擅长将从类似任务中获得的知识适应到新任务的领域中。然而,稳定适应不断变化的环境,也就是终身学习的本质,对于现代人工智能来说仍然是一个重大挑战。更准确地说,神经网络通常在多任务学习方面表现较差,尽管近年来已经取得了令人瞩目的进展。例如,在学习过程中,会计算衡量之前任务权重重要性的对角费舍尔信息项(然后对于那些重要的权重不允许快速变化)[50]。后来提出了一种改进方法,允许突触随着时间积累与任务相关的信息[51]。在综述文章[52]中总结了更多减轻灾难性遗忘效应的机器学习技术。然而,我们仍然不知道以一种原则性的方式缓解灾难性遗忘效应的确切机制,这需要对深度学习在适应领域转换训练方面进行理论研究,即将一个任务的连接权重转换为有助于在相关任务上学习的权重的解决方案。此外,假设两个任务在隐空间中共享共同的语义,目前尚不清楚源任务中包含的相关知识如何能够有效地转移到目标任务中。

最近的一项理论研究使用 Franz-Parisi 势能的统计力学框架解释了持续学习的机制[53],其中来自先前任务的知识在 Franz-Parisi 势能公式中充当参考构型[54],作为学习新知识的锚点。这个框架还与弹性权重巩固 [50]、启发式权重不确定性调节 [55] 和受神经科学启发的元可塑性 [56] 相关,为深度网络在现实世界的多任务学习提供了一个基于理论基础的方法。

深度学习被批评为仅仅是将输入与输出进行简单关联的一个精致的曲线拟合工具,换句话说,这个工具无法区分相关性和因果性。深度网络所学到的不是概念,而仅仅是统计相关性,因而使网络无法进行反事实推理(智能的标志性能力)。类似人类的人工智能必须善于从感官输入中获取特征组分之间的因果关系,从而从含大量无关噪声的数据中提取相关信息[57, 58]。因此,理解深度学习系统中的因与果对于下一代人工智能尤为重要。目前的深度学习算法是否能够进行因果推理仍然是一个悬而未决的问题。因此,发展分析性玩具模型成为解决这个问题的关键,尽管通过简单的物理方程来确定深度学习中观察到的效果的原因将非常具有挑战性,这是由于体系的结构和学习的复杂性所致[59]。这个挑战与大语言模型的惊人性能密切相关(参见下面的第七个挑战)。

关注集智俱乐部因果科学读书会:

因果科学读书会:连接统计学、机器学习与自动推理的新兴交叉领域

人们认为,大脑通过自发神经活动作为计算(例如,采样)的“蓄水池”来[60]学习构建外部世界的内部模型。自发活动与刺激引发的活动之间的一致性在发育过程中增加,尤其是对自然刺激[61],而自发活动描绘了刺激引发的神经反应的范围[62]。研究表明刺激形成一个具有内禀层级结构的神经空间 [63, 64]。那么,一个有趣的问题就是自发神经空间的形状是怎样的,以及这个空间如何动态演变,特别是在适应变化的环境的时候。此外,感觉输入如何与正在进行的皮层活动相结合来决定动物的行为仍然是一个未解之谜,并且极具挑战性。另一方面,强化学习被用来构建有结构化环境的世界模型 [65]。在强化学习中,数据被用来驱动行为,这些行为根据智能体从环境中接收的奖励信号来进行评估。因此,有趣的是智能体通过与环境的互动学习建立了什么样的内部模型。这可以与前面表示学习和泛化的挑战联系起来。此外,最近的一项工作显示了强化学习与统计物理之间的联系 [66],其表明可以潜在地建立一个统计力学理论来理解强化学习,并可能对研究基于奖励的大脑的神经计算产生深刻影响 [67]。

另一个理解大脑的内部模型的角度是从神经动力学的角度来看,这种动力学置于一个低维表面上,对于单个神经元或局部神经回路的详细属性的变化具有鲁棒性 [68-70]。刺激、任务或条件的表示可以被提取出来,以推导实验可验证的假设 [71]。一个具有挑战性的问题是神经活动和突触可塑性之间如何相互作用,以产生一个低维的内部表示来实现认知功能。近期一个结合了连接概率、局部突触噪声和神经活动的关于突触可塑性的进展表明,可以实现一个适应时间相关的输入的动态网络 [72]。这项工作将学习解释为一种变分推断问题,使得在一个局部神经回路中实现不确定性下的最优学习成为可能。学习和神经活动都被置于低维子空间中。未来的工作必须包含更多符合生物学的因素来测试在神经生理实验中的假设。

大脑的状态可以被看作是动力学吸引子的系综 [73]。关键挑战是学习如何塑造稳定的吸引子景观。可以将学习解释为贝叶斯推断问题,例如以无监督的方式,而不是自回归方式(见下一节)。学习可以通过突触权重的对称性破缺来驱动 [74, 75],破缺将区分识别网络本身和隐藏在感觉输入中的规则分两个不同的相。看看这幅物理图像是否仍然适用于支持动态吸引子的循环学习是非常有趣的,例如应该发展解释学习的动态平均场理论 [76]。

Chat-GPT 具有令人印象深刻的解决问题的能力,正引领着第四次工业革命,其中 GPT 是生成式预训练转换器的一个缩写。Chat-GPT 是基于大型语言模型(LLMs)训练的[77],而 LLMs 将语言信息表示为高维环境空间中的向量,并以自回归方式(类比于大脑是一个预测机器的假设)在大型文本语料库上进行训练,从而得到训练数据中语言单元(tokens)之间的复杂统计模型[78]。因此,这种计算模型展现出强大的形式语言能力[79]。此外,LLM 还是一种少样本提示甚至零样本提示学习器[80, 81],即语言模型可以仅通过提示(例如,思维链提示[82])来执行各种计算上具有挑战性的任务。值得注意的是,LLMs 在模型复杂性和样本复杂性的规模同时增加时显示出质的飞跃[83],这种质变类似于热力学系统中的相变。

与形式语言能力相比,LLMs 的功能语言能力被认为较弱[79]。这引发了一个根本性的问题,即智能的本质是什么,或者单一的下一个词单元的上下文条件预测是否是人工通用智能的标准模型[84-86]?人类在实际问题中的推理能力通常也依赖于非语言信息,例如,科学家在面对一个具有挑战性的问题何时会产生创造性的想法是不可预测的,这依赖于基于对长时间深度思考的推理过程。在生物实现中,语言模块与涉及高级认知的其他模块是分离的[79]。LLM 解释了训练语料库中词单元之间的层次相关性,而不是隐藏的因果依赖关系。换句话说,神经网络没有构建世界的心智模型,这需要异质模块化网络,所以与人类不同。因此,LLM 并不理解它生成的内容(作为生成模型而言)。即使在训练数据中缺少某些关键的统计规律模式,该模型也可以在语法方面生成完美的文本。然而,这些文本可能与事实相去甚远。知其然,知其所以然是智能系统的一个关键特征[86]。从这个意义上说,LLM 的内部工作方式在很大程度上是不透明的,需要付出巨大的努力来数学地阐述其形式语言能力,并进一步确定开发一个稳健的世界模型所必须包括的关键要素。这样,就可以揭示出当前观察到的假阳性(例如幻觉)的机制[87]。

最重要的是,我们目前对于如何构建一个能够将性能和意识相连接的附加网络没有任何了解[88],这与什么让我们产生意识相关(参见最后一个挑战)。按照马尔的框架,意识的计算和神经关联仍然是未知的[89-91]。目前的一个物理方法是考虑到控制 LLM 的复杂神经计算的李雅普诺夫函数[5, 6]。李雅普诺夫函数的视角或将打开具有足够多可能性的大门来思考控制信息如何通过自我注意和其他潜在的门控机制得到提炼并涌现出真正意义上的超级智能。

最具争议的问题之一就是意识的起源——意识是否是一个由各种精心设计的区域所组成的高度异构和模块化大脑电路的涌现行为(例如,人脑总共约有1014量级的神经元连接,以及拥有许多功能特定的模块化结构,如前额叶皮层、海马体、小脑等[92,93])。意识体验的主观性与科学解释的客观性是相矛盾的。根据 Damasio 的[94]模型,在世界中识别自我的能力及其与世界的关系被认为是意识状态的一个中心特征。一个机器算法能否实现自我意识仍然难以捉摸。自我监控能力(或元认知[95])可能会让机器(如 LLMs)知道它们生成的是什么。在一般情况下,阐明自我模型是如何与大脑的内部模型相关联的,可能是很重要的科学任务。例如,卡尔·弗里斯顿认为,意识处理可以解释为从感官观察中推断原因的统计推断问题。因此,最小化“惊奇”(事件的负对数概率)可能导致自我意识[96],这与认为大脑是一个预测机器的假设一致[86]。

目前有两种主要的意识认知理论。一种是全局工作空间框架[97],它将意识与大范围持续传播的皮层神经活动相关联,并认为意识是专门模块的信息处理计算所产生的。另一种是综合信息理论,它通过综合信息量提供了对意识状态的定量描述[98]。在这第二种理论中,无意识状态被认为具有较低的信息内容,而意识状态具有较高的信息内容。这两种理论都采用自上而下的方法,与统计力学方法形成鲜明对比,后者采用自下而上的方式建立微观相互作用与宏观行为之间的桥梁。尽管这两个假设能够解释一些认知实验,但它们仍受到大量的批判[99]。我们指出,意识状态可能是神经活动的涌现性质,只在比神经活动更高的层次上存在。目前尚不清楚如何连接这两个层次,这需要一个新的统计力学理论。从信息论的角度来看,意识状态可能需要大脑子网络之间多样化的相互作用来支撑,这与物理学中的熵概念相关联[100]。更大的熵导致信息的最佳分离和整合[101]。从非平衡的观点来看,最大化信息处理能力的混沌边缘也被推测为意识与无意识大脑状态的分界线[102]。

综上所述,意识是否可以通过复杂神经基质内部动力学的相互作用来产生仍然未解决[103]。如果可能的话,统计力学理论总是具有潜力的(霍普菲尔德模型是一个典型例子),因为我们可以仅从几个物理参数来进行理论预测,这是通过高度抽象实现的,因此可以期待存在普适原理。但创建这样的理论框架绝非简单,需要多学科知识融汇贯通。(延伸阅读:《意识理论综述:众多竞争的意识理论如何相互关联?》)

作为总结,在这篇观点评述中,我们对与神经网络相关的基本重要问题提出了一些天真的想法,因而建立一个好的理论(描述和预测功能兼具)远未完成。传统的神经网络的统计物理研究分为两个主要流派:一方面是工程领域,发展以理论为基础的算法;另一方面是神经科学领域,通过物理方法来解决描述大脑计算的数学模型。在物理学中,我们有最小作用量原理,从中可以推导出经典力学或电动力学规律。我们不确定在神经网络(甚至大脑)的物理学中是否存在可以用简洁的数学形式表达的普遍原理,但是十分鼓励对物理理论与神经计算之间的相互作用感兴趣的读者痴迷于推动这些令人激动但具有风险的研究方向的进展。正如我们上面展示的八个开放问题所示,这些问题的挑战性逐渐增加。在未来几年中,我们期待有许多令人兴奋的进展。

注:这是杜文康的译文,经黄海平修改,原文在 arXiv:2306.11232 发表,

链接:https://arxiv.org/abs/2306.11232v1

[1] Daniel Levenstein, Veronica A. Alvarez, Asohan Amarasingham, Habiba Azab, Zhe S. Chen, Richard C. Gerkin, Andrea Hasenstaub, Ramakrishnan Iyer, Renaud B. Jolivet, Sarah Marzen, Joseph D. Monaco, Astrid A. Prinz, Salma Quraishi, Fidel Santamaria, Sabyasachi Shivkumar, Matthew F. Singh, Roger Traub, Farzan Nadim, Horacio G. Rotstein, and A. David Redish. On the role of theory and modeling in neuroscience. Journal of Neuroscience, 43(7):1074–1088, 2023.

[2] J. J. Hopfield. Neural networks and physical systems with emergent collective computational abilities. Proc. Natl. Acad. Sci. USA, 79:2554, 1982.

[3] Daniel J Amit, Hanoch Gutfreund, and H Sompolinsky. Statistical mechanics of neural networks near saturation. Annals of Physics, 173(1):30–67, 1987.

[4] M. Griniasty, M. V. Tsodyks, and Daniel J. Amit. Conversion of temporal correlations between stimuli to spatial correlations between attractors. Neural Computation, 5(1):1–17, 1993.

[5] Hubert Ramsauer, Bernhard Sch¨afl, Johannes Lehner, Philipp Seidl, Michael Widrich, Thomas Adler, Lukas Gruber, Markus Holzleitner, Milena Pavlovi´c, Geir Kjetil Sandve, Victor Greiff, David Kreil, Michael Kopp, G¨unter Klambauer, Johannes Brandstetter, and Sepp Hochreiter. Hopfield networks is all you need. arXiv:2008.02217, 2020. in ICLR 2021.

[6] Dmitry Krotov and John Hopfield. Large associative memory problem in neurobiology and machine learning. arXiv:2008.06996, 2020. in ICLR 2021.

[7] D. Marr. Vision: A Computational Investigation into the Human Representation and Processing of Visual Information. MIT Press, Cambridge, MA, 1982.

[8] Jurgen Schmidhuber. Deep learning in neural networks: An overview. Neural Networks, 61:85–117, 2015.

[9] Yann LeCun, Yoshua Bengio, and Geoffrey Hinton. Deep learning. Nature, 521(7553):436– 444, 2015.

[10] L F Abbott, Brian DePasquale, and Raoul-Martin Memmesheimer. Building functional networks of spiking model neurons. Nature Neuroscience, 19(3):350–355, 2016.

[11] Adam H. Marblestone, Greg Wayne, and Konrad P. Kording. Toward an integration of deep learning and neuroscience. Frontiers in Computational Neuroscience, 10:94, 2016. [12] Blake A Richards, Timothy P Lillicrap, Philippe Beaudoin, Yoshua Bengio, Rafal Bogacz, Amelia Christensen, Claudia Clopath, Rui Ponte Costa, Archy de Berker, Surya Ganguli, Colleen J Gillon, Danijar Hafner, Adam Kepecs, Nikolaus Kriegeskorte, Peter Latham, Grace W Lindsay, Kenneth D Miller, Richard Naud, Christopher C Pack, Panayiota Poirazi, Pieter Roelfsema, Jo˜ao Sacramento, Andrew Saxe, Benjamin Scellier, Anna C Schapiro, Walter Senn, Greg Wayne, Daniel Yamins, Friedemann Zenke, Joel Zylberberg, Denis Therien, and Konrad P Kording. A deep learning framework for neuroscience. Nature Neuroscience, 22(11):1761–1770, 2019.

[13] Timothy P. Lillicrap, Adam Santoro, Luke Marris, Colin J. Akerman, and Geoffrey Hinton. Backpropagation and the brain. Nature Reviews Neuroscience, 21(6):335–346, 2020.

[14] Samuel Schmidgall, Jascha Achterberg, Thomas Miconi, Louis Kirsch, Rojin Ziaei, S. Pardis Hajiseyedrazi, and Jason Eshraghian. Brain-inspired learning in artificial neural networks: a review. arXiv:2305.11252, 2023.

[15] Yamins Daniel L K and DiCarlo James J. Using goal-driven deep learning models to understand sensory cortex. Nat Neurosci, 19(3):356–365, 2016.

[16] Andrew Saxe, Stephanie Nelli, and Christopher Summerfield. If deep learning is the answer, then what is the question? Nat. Rev. Neurosci., 22:55, 2020.

[17] Demis Hassabis, Dharshan Kumaran, Christopher Summerfield, and Matthew Botvinick. Neuroscience-inspired artificial intelligence. Neuron, 95(2):245–258, 2017.

[18] Yi Ma, Doris Tsao, and Heung-Yeung Shum. On the principles of parsimony and self�consistency for the emergence of intelligence. Frontiers of Information Technology & Electronic Engineering, 23(9):1298–1323, 2022.

[19] James J. DiCarlo and David D. Cox. Untangling invariant object recognition. Trends in Cognitive Sciences, 11(8):333–341, 2007.

[20] Yoshua Bengio, Aaron Courville, and Pascal Vincent. Representation learning: A review and new perspectives. IEEE transactions on pattern analysis and machine intelligence, 35(8):1798–1828, 2013.

[21] P. P. Brahma, D. Wu, and Y. She. Why deep learning works: A manifold disentanglement perspective. IEEE Transactions on Neural Networks and Learning Systems, 27(10):1997– 2008, 2016.

[22] Haiping Huang. Mechanisms of dimensionality reduction and decorrelation in deep neural networks. Phys. Rev. E, 98:062313, 2018.

[23] Uri Cohen, SueYeon Chung, Daniel D Lee, and Haim Sompolinsky. Separability and geometry of object manifolds in deep neural networks. Nature Communications, 11(1):1–13, 2020.

[24] N. Alex Cayco-Gajic and R. Angus Silver. Re-evaluating circuit mechanisms underlying pattern separation. Neuron, 101(4):584–602, 2019.

[25] Jianwen Zhou and Haiping Huang. Weakly-correlated synapses promote dimension reduction in deep neural networks. Phys. Rev. E, 103:012315, 2021.

[26] Gina G. Turrigiano and Sacha B. Nelson. Homeostatic plasticity in the developing nervous system. Nature Reviews Neuroscience, 5(2):97–107, 2004.

[27] John H. Reynolds and David J. Heeger. The normalization model of attention. Neuron, 61(2):168–185, 2009.

[28] Ravid Shwartz-Ziv and Naftali Tishby. Opening the black box of deep neural networks via information. arXiv:1703.00810, 2017.

[29] Alessandro Achille and Stefano Soatto. A separation principle for control in the age of deep learning. arXiv:1711.03321, 2017.

[30] Chan Li and Haiping Huang. Learning credit assignment. Phys. Rev. Lett., 125:178301, 2020.

[31] Chan Li and Haiping Huang. Emergence of hierarchical modes from deep learning. Phys. Rev. Res., 5:L022011, 2023.

[32] Haiping Huang and Yoshiyuki Kabashima. Origin of the computational hardness for learning with binary synapses. Physical Review E, 90:052813, 2014.

[33] Carlo Baldassi, Christian Borgs, Jennifer T Chayes, Alessandro Ingrosso, Carlo Lucibello, Luca Saglietti, and Riccardo Zecchina. Unreasonable effectiveness of learning neural networks: From accessible states and robust ensembles to basic algorithmic schemes. Proceedings of the National Academy of Sciences, 113(48):E7655–E7662, 2016.

[34] S Spigler, M Geiger, S d’Ascoli, L Sagun, G Biroli, and M Wyart. A jamming transition from under- to over-parametrization affects generalization in deep learning. Journal of Physics A: Mathematical and Theoretical, 52:474001, 2019.

[35] Wenxuan Zou and Haiping Huang. Data-driven effective model shows a liquid-like deep learning. Phys. Rev. Res., 3:033290, 2021.

[36] G Gyorgyi. First-order transition to perfect generalization in a neural network with binary synapses. Physical Review A, 41(12):7097–7100, 1990.

[37] H. Sompolinsky, N. Tishby, and H. S. Seung. Learning from examples in large neural networks. Physical review letters, 65:1683–1686, 1990.

[38] Pankaj Mehta, Marin Bukov, Ching-Hao Wang, Alexandre G.R. Day, Clint Richardson, Charles K. Fisher, and David J. Schwab. A high-bias, low-variance introduction to machine learning for physicists. Physics Reports, 810:1–124, 2019.

[39] Mikhail Belkin, Daniel Hsu, Siyuan Ma, and Soumik Mandal. Reconciling modern machine learning practice and the classical bias-variance trade-off. Proceedings of the National Academy of Sciences of the United States of America, 116(32):15849–15854, 2019.

[40] Ben Adlam and Jeffrey Pennington. The neural tangent kernel in high dimensions: Triple descent and a multi-scale theory of generalization. In ICML 2020: 37th International Conference on Machine Learning, 2020.

[41] Carlo Baldassi, Clarissa Lauditi, Enrico M. Malatesta, Rosalba Pacelli, Gabriele Perugini, and Riccardo Zecchina. Learning through atypical phase transitions in overparameterized neural networks. Phys. Rev. E, 106:014116, 2022.

[42] Mikhail Belkin. Fit without fear: remarkable mathematical phenomena of deep learning through the prism of interpolation. arXiv:2105.14368, 2021.

[43] Arthur Jacot, Franck Gabriel, and Cl´ement Hongler. Neural tangent kernel: Convergence and generalization in neural networks. In Advances in Neural Information Processing Systems, volume 31, pages 8571–8580, 2018.

[44] Cong Fang, Hanze Dong, and Tong Zhang. Mathematical models of overparameterized neural networks. Proceedings of the IEEE, 109(5):683–703, 2021.

[45] Peter L. Bartlett, Andrea Montanari, and Alexander Rakhlin. Deep learning: a statistical viewpoint. arXiv:2103.09177, 2021.

[46] Justin Gilmer, Luke Metz, Fartash Faghri, Samuel S. Schoenholz, Maithra Raghu, Martin Wattenberg, and Ian Goodfellow. Adversarial spheres. arXiv:1801.02774, 2018.

[47] Luca Bortolussi and Guido Sanguinetti. Intrinsic geometric vulnerability of high-dimensional artificial intelligence. arXiv:1811.03571, 2018.

[48] Richard Kenway. Vulnerability of deep learning. arXiv:1803.06111, 2018.

[49] Zijian Jiang, Jianwen Zhou, and Haiping Huang. Relationship between manifold smoothness and adversarial vulnerability in deep learning with local errors. Chin. Phys. B, 30:048702, 2021.

[50] James Kirkpatrick, Razvan Pascanu, Neil C. Rabinowitz, Joel Veness, Guillaume Desjardins, Andrei A. Rusu, Kieran Milan, John Quan, Tiago Ramalho, Agnieszka Grabska-Barwinska, Demis Hassabis, Claudia Clopath, Dharshan Kumaran, and Raia Hadsell. Overcoming catastrophic forgetting in neural networks. Proceedings of the National Academy of Sciences of the United States of America, 114(13):3521–3526, 2017.

[51] Friedemann Zenke, Ben Poole, and Surya Ganguli. Continual learning through synaptic intelligence. In Proceedings of the 34th International Conference on Machine Learning – Volume 70, volume 70, pages 3987–3995, 2017.

[52] German I. Parisi, Ronald Kemker, Jose L. Part, Christopher Kanan, and Stefan Wermter. Continual lifelong learning with neural networks: A review. Neural Networks, 113:54–71, 2019.

[53] Chan Li, Zhenye Huang, Wenxuan Zou, and Haiping Huang. Statistical mechanics of continual learning: variational principle and mean-field potential. PHYSICAL REVIEW E 108, 014309 (2023).

[54] Silvio Franz and Giorgio Parisi. Recipes for metastable states in spin glasses. Journal De Physique I, 5(11):1401–1415, 1995.

[55] Sayna Ebrahimi, Mohamed Elhoseiny, Trevor Darrell, and Marcus Rohrbach. Uncertainty guided continual learning with bayesian neural networks. In International Conference on Learning Representations, 2020.

[56] Axel Laborieux, Maxence Ernoult, Tifenn Hirtzlin, and Damien Querlioz. Synaptic metaplasticity in binarized neural networks. Nature Communications, 12(1):2549, 2021.

[57] Bernhard Sch¨olkopf. Causality for machine learning. arXiv:1911.10500, 2019.

[58] Judea Pearl and Dana Mackenzie. The Book of Why: The New Science of Cause and Effect. Basic Books, New York, NY, 2018.

[59] Haiping Huang. Statistical Mechanics of Neural Networks. Springer, Singapore, 2022.

[60] Dario L Ringach. Spontaneous and driven cortical activity: implications for computation. Current Opinion in Neurobiology, 19(4):439–444, 2009.

[61] Pietro Berkes, Gergo Orban, Mate Lengyel, and Jozsef Fiser. Spontaneous Cortical Activity Reveals Hallmarks of an Optimal Internal Model of the Environment. Science, 331:83, 2011.

[62] Luczak Artur, Bartho Peter, and Harris Kenneth D. Spontaneous Events Outline the Realm of Possible Sensory Responses in Neocortical Populations. Neuron, 62:413, 2009.

[63] Haiping Huang and Taro Toyoizumi. Clustering of neural code words revealed by a first-order phase transition. Phys. Rev. E, 93:062416, 2016.

[64] Michael J Berry and Gaˇsper Tkaˇcik. Clustering of neural activity: A design principle for population codes. Frontiers in computational neuroscience, 14:20, 2020.

[65] David Ha and Jurgen Schmidhuber. World models. arXiv: 1803.10122, 2018.

[66] Jad Rahme and Ryan P. Adams. A theoretical connection between statistical physics and reinforcement learning. arXiv:1906.10228, 2019.

[67] Emre O. Neftci and Bruno B. Averbeck. Reinforcement learning in artificial and biological systems. Nature Machine Intelligence, 1(3):133–143, 2019.

[68] David Sussillo and L.F. Abbott. Generating coherent patterns of activity from chaotic neural networks. Neuron, 63(4):544–557, 2009.

[69] Dean V. Buonomano and Wolfgang Maass. State-dependent computations: spatiotemporal processing in cortical networks. Nature Reviews Neuroscience, 10(2):113–125, 2009.

[70] Saurabh Vyas, Matthew D. Golub, David Sussillo, and Krishna V. Shenoy. Computation through neural population dynamics. Annual Review of Neuroscience, 43(1):249–275, 2020.

[71] Mehrdad Jazayeri and Srdjan Ostojic. Interpreting neural computations by examining intrinsic and embedding dimensionality of neural activity. Current Opinion in Neurobiology, 70:113–120, 2021.

[72] Wenxuan Zou, Chan Li, and Haiping Huang. Ensemble perspective for understanding temporal credit assignment. Physical Review E, 107(2):024307, 2023.

[73] Christoph von der Malsburg. Concerning the neural code. arXiv:1811.01199, 2018.

[74] Tianqi Hou, K Y Michael Wong, and Haiping Huang. Minimal model of permutation symmetry in unsupervised learning. Journal of Physics A: Mathematical and Theoretical, 52(41):414001, 2019.

[75] Tianqi Hou and Haiping Huang. Statistical physics of unsupervised learning with prior knowledge in neural networks. Phys. Rev. Lett., 124:248302, 2020.

[76] Wenxuan Zou and Haiping Huang. Introduction to dynamical mean-field theory of generic random neural networks. arXiv:2305.08459, 2023.

[77] OpenAI. Gpt-4 technical report. arXiv:2303.08774, 2023.

[78] Ashish Vaswani, Noam Shazeer, Niki Parmar, Jakob Uszkoreit, Llion Jones, Aidan N. Gomez, Lukasz Kaiser, and Illia Polosukhin. Attention is all you need. In Proceedings of the 31st International Conference on Neural Information Processing Systems, NIPS’17, page 6000–6010, Red Hook, NY, USA, 2017. Curran Associates Inc.

[79] Kyle Mahowald, Anna A. Ivanova, Idan A. Blank, Nancy Kanwisher, Joshua B. Tenenbaum, and Evelina Fedorenko. Dissociating language and thought in large language models: a cognitive perspective. arXiv:2301.06627, 2023.

[80] Tom Brown, Benjamin Mann, Nick Ryder, Melanie Subbiah, Jared D Kaplan, Prafulla Dhariwal, Arvind Neelakantan, Pranav Shyam, Girish Sastry, Amanda Askell, Sandhini Agarwal, Ariel Herbert-Voss, Gretchen Krueger, Tom Henighan, Rewon Child, Aditya Ramesh, Daniel Ziegler, Jeffrey Wu, Clemens Winter, Chris Hesse, Mark Chen, Eric Sigler, Mateusz Litwin, Scott Gray, Benjamin Chess, Jack Clark, Christopher Berner, Sam McCandlish, Alec Radford, Ilya Sutskever, and Dario Amodei. Language models are few-shot learners. In H. Larochelle, M. Ranzato, R. Hadsell, M.F. Balcan, and H. Lin, editors, Advances in Neural Information Processing Systems, volume 33, pages 1877–1901. Curran Associates, Inc., 2020.

[81] Takeshi Kojima, Shixiang Shane Gu, Machel Reid, Yutaka Matsuo, and Yusuke Iwasawa. Large language models are zero-shot reasoners. arXiv:2205.11916, 2022. in NeurIPS 2022.

[82] Jason Wei, Xuezhi Wang, Dale Schuurmans, Maarten Bosma, Ed Huai hsin Chi, F. Xia, Quoc Le, and Denny Zhou. Chain of thought prompting elicits reasoning in large language models. arXiv:2201.11903, 2022. in NeurIPS 2022.

[83] Jared Kaplan, Sam McCandlish, Tom Henighan, Tom B. Brown, Benjamin Chess, Rewon Child, Scott Gray, Alec Radford, Jeffrey Wu, and Dario Amodei. Scaling laws for neural language models. arXiv:2001.08361, 2020.

[84] Terrence J. Sejnowski. Large Language Models and the Reverse Turing Test. Neural Computation, 35(3):309–342, 2023.

[85] Brenden M. Lake, Tomer D. Ullman, Joshua B. Tenenbaum, and Samuel J. Gershman. Building machines that learn and think like people. Behavioral and Brain Sciences, 40:e253, 2017.

[86] Marcel van Gerven. Computational foundations of natural intelligence. Frontiers in Computational Neuroscience, 11:112, 2017.

[87] Noam Chomsky, Ian Roberts, and Jeffrey Watumull. Noam chomsky: The false promise of chatgpt. The New York Times, 8, 2023.

[88] Axel Cleeremans. Connecting conscious and unconscious processing. Cognitive Science, 38(6):1286–1315, 2014.

[89] Francis Crick and Christof Koch. A framework for consciousness. Nature Neuroscience, 6(2):119–126, 2003.

[90] Lenore Blum and Manuel Blum. A theory of consciousness from a theoretical computer science perspective: Insights from the conscious turing machine. Proceedings of the National Academy of Sciences of the United States of America, 119(21):e2115934119, 2022.

[91] Abhilash Dwarakanath, Vishal Kapoor, Joachim Werner, Shervin Safavi, Leonid A. Fedorov, Nikos K. Logothetis, and Theofanis I. Panagiotaropoulos. Bistability of prefrontal states gates access to consciousness. Neuron, 111(10):1666–1683, 2023.

[92] K. Harris and G. Shepherd. The neocortical circuit: themes and variations. Nat Neurosci, 18:170–181, 2015.

[93] Liqun Luo. Architectures of neuronal circuits. Science, 373(6559):eabg7285, 2021.

[94] A. Damasio. Fundamental feelings. Nature, 413:781, 2001.

[95] Stanislas Dehaene, Hakwan Lau, and Sid Kouider. What is consciousness, and could machines have it? Science, 358(6362):486–492, 2017.

[96] Karl Friston. Am i self-conscious? (or does self-organization entail self-consciousness?).Frontiers in Psychology, 9:579, 2018.

[97] Stanislas Dehaene, Michel Kerszberg, and Jean-Pierre Changeux. A neuronal model of a global workspace in effortful cognitive tasks. Proceedings of the National Academy of Sciences of the United States of America, 95(24):14529–14534, 1998.

[98] Giulio Tononi. An information integration theory of consciousness. BMC Neuroscience, 5(1):42, 2004.

[99] Christof Koch, Marcello Massimini, Melanie Boly, and Giulio Tononi. Neural correlates of consciousness: progress and problems. Nature Reviews Neuroscience, 17(5):307–321, 2016.

[100] R. Guevara Erra, D. M. Mateos, R. Wennberg, and J. L. Perez Velazquez. Statistical mechanics of consciousness: Maximization of information content of network is associated with conscious awareness. Physical Review E, 94(5):52402, 2016.

[101] David W. Zhou, David D. Mowrey, Pei Tang, and Yan Xu. Percolation model of sensory transmission and loss of consciousness under general anesthesia. Phys. Rev. Lett., 115:108103, 2015.

[102] Daniel Toker, Ioannis Pappas, Janna D Lendner, Joel Frohlich, Diego M Mateos, Suresh Muthukumaraswamy, Robin Carhart-Harris, Michelle Paff, Paul M Vespa, Martin M Monti, et al. Consciousness is supported by near-critical slow cortical electrodynamics. Proceedings of the National Academy of Sciences, 119(7):e2024455119, 2022.

[103] Patrick Krauss and Andreas Maier. Will we ever have conscious machines? Frontiers in Computational Neuroscience, 14:556544, 2020.

[104] Most of them were roughly provided in the book of statistical mechanics of neural networks [59]. Here we give an expanded version.

[105] Haiping Huang, statistical physics, disordered systems and neural networks 《科学》(上海科学技术出版社,1915 年创刊)2022 年 74 卷 01 期 40 页.