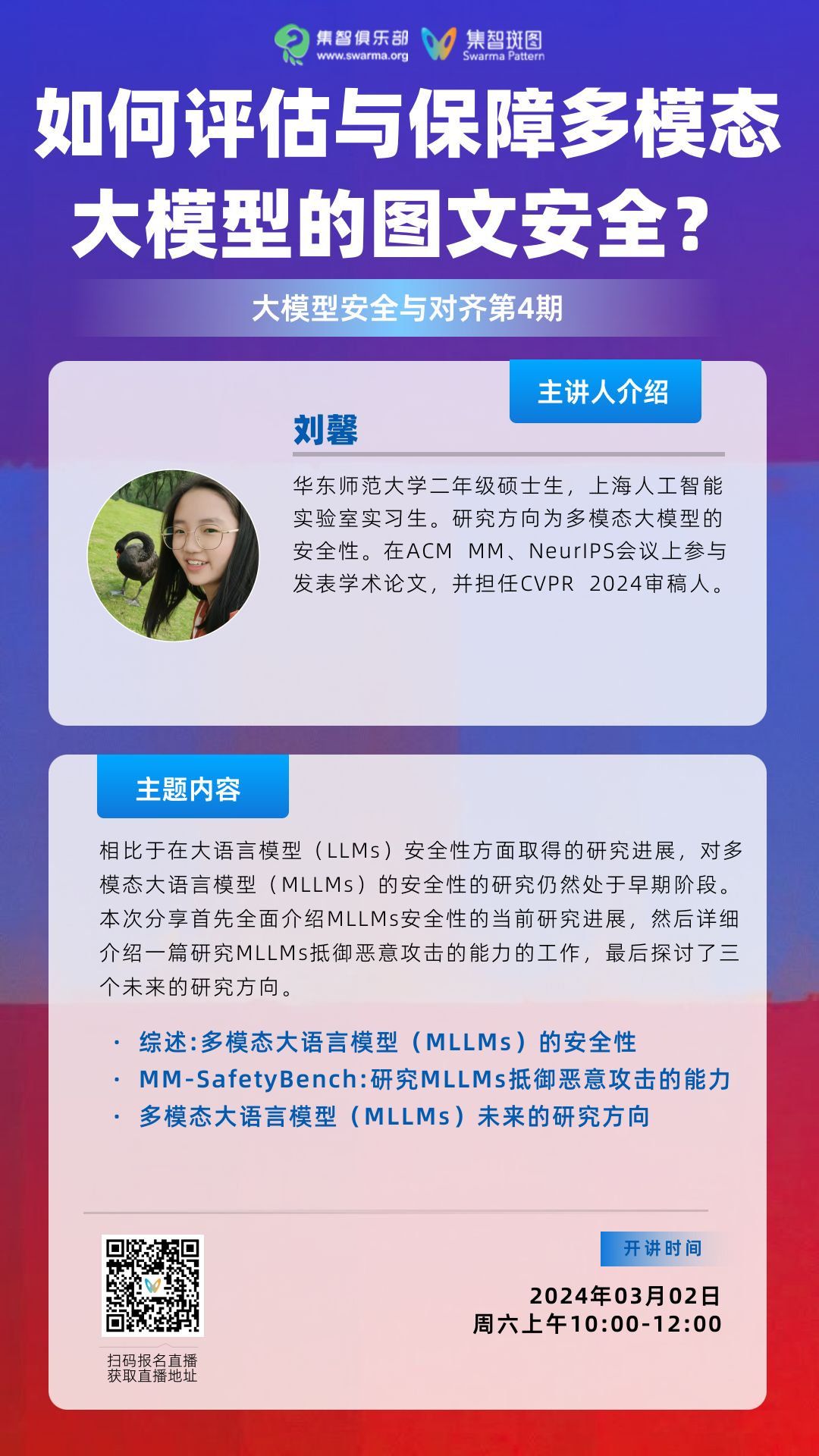

如何评估与保障多模态大模型的图文安全?丨大模型安全与对齐读书会·周六直播

导语

分享内容简介

分享内容简介

分享内容大纲

分享内容大纲

-

综述:多模态大语言模型(MLLMs)的安全性

-

安全的概念理解

-

评估方法

-

攻击方法

-

防御方法

-

MM-SafetyBench:研究MLLMs抵御恶意攻击的能力

-

动机

-

核心方法

-

构建评估数据集

-

实验

-

未来的研究方向

-

可靠的安全评估

-

对安全风险的深入研究

-

安全对齐

主要涉及到的前置知识

主要涉及到的前置知识

多模态大语言模型

主要涉及到的话题讨论

主要涉及到的话题讨论

-

Sora爆火背后,如何降低文生视频模型的滥用风险?

-

如何评估/衡量多模态大模型的攻击/防御效果?

-

我们如何应对攻击手段更多样、数据结构更复杂等多模态大模型的独特挑战?

主讲人介绍

主讲人介绍

主持人介绍

主持人介绍

段雅文,安远AI技术项目经理,致力于AI安全技术社区建设。他是未来生命研究所AI Existential Safety PhD学者,关注大模型安全和对齐研究。他曾在UC Berkeley的Stuart Russell组和剑桥大学David Krueger实验室进行AI安全和对齐研究。他曾在NeurIPS组织Socially Responsible Language Model Research工作坊,参与的研究项目曾在CVPR、ECCV、ICML、ACM FAccT、NeurIPS MLSafety Workshop等ML/CS会议和工作坊上发表。他拥有剑桥大学机器学习硕士学位和香港大学理学士学位。

研究方向:人工智能安全与对齐等。

涉及到的参考文献

涉及到的参考文献

[1] H Liu, C Li, et al. Visual instruction tuning. NeurIPS, 2023.

[2] W Dai, J Li, et al. InstructBLIP: Towards General-purpose Vision-Language Models with Instruction Tuning. NeurIPS, 2023.

[3] A Awadalla, I Gao, et al. OpenFlamingo: An Open-Source Framework for Training Large Autoregressive Vision-Language Models . arXiv:2308.01390, 2023.

[4] Y Dong, H Chen, et al. How Robust is Google’s Bard to Adversarial Image Attacks? arXiv:2309.11751 2308, 2023.

直播信息

直播信息

大模型安全与对齐读书会

大模型的狂飙突进唤醒了人们对AI技术的热情和憧憬,也引发了对AI技术本身存在的社会伦理风险及其对人类生存构成的潜在威胁的普遍担忧。在此背景下,AI安全与对齐得到广泛关注,这是一个致力于让AI造福人类,避免AI模型失控或被滥用而导致灾难性后果的研究方向。集智俱乐部和安远AI联合举办「大模型安全与对齐」读书会,由多位海内外一线研究者联合发起,旨在深入探讨大模型安全与对齐所涉及的核心技术、理论架构、解决路径以及安全治理等交叉课题。

点击“阅读原文”,报名读书会