本文根据作者在2025年4月在河南师范大学数学系和计算机系的报告撰写,谈计算机和人工智能理论使用范畴学的一些例子。希望借助这些例子鼓励更多计算机科学与数学的交流,相互促进更大的创新发展,希望人工智能有一天用上更深刻的数学。

也给你推荐集智学园范畴论系列课程,包含两季的“范畴论入门系列课程”,和最新的「范畴论与机器学习」课程:

1943-1945年,美国宾夕法尼亚大学电机工程学院物理学家莫奇利(John William Mauchly)和工程师埃克特(John Presper Eckert Jr.)建成了世界上第一台、重约30吨可设定程序的通用电子计算机ENIAC。当偶然听说了这个项目之后,数学家冯·诺依曼(Johnvon Neumann)后来以顾问的形式参与到ENIAC的研制计划之中。

据标准的课本(如 参考文献[11][14][27][39]),1943年,心理学家WarrenMcCulloch和数学家WalterPitts最早提出了一种基于简单逻辑运算的人工神经网络。1950年图灵(Alan Turing)发表题目为《计算机器和智能》的论文。1956年,在Dartmouth会议上,McCarthy提出了人工智能的定义:人工智能就是要让机器的行为看起来就像是人所表现出的智能行为一样。美国心理学家和计算机科学家弗兰克·罗森布拉特(Frank Rosenblatt)则在1958年提出了一种称为感知器(Perceptron)的、以模拟人类感知能力为特征的神经网络模型。1983年,物理学家John Joseph Hopfield提出了一种用于联想记忆(Associative Memory)的神经网络,称为Hopfield网络。1984年,加拿大计算机科学家Geoffrey Hinton提出一种随机化版本的Hopfield网络,即玻尔兹曼机(BoltzmannMachine)。因为这些工作,Hopfield和Hinton获得2024年诺贝尔物理学奖。2017年,在NeurlPS会议上,谷歌的8人团队在文章“Attention Is All You Need” (arXiv:1706.03762)中发表了Transformer ——一个创新的生成式人工智能(Generative AI)架构。不同于传统的人工智能仅对输入数据进行处理和分析,生成式人工智能使用深度学习通过训练、优化和生成来学习并模拟事物的内在规律,根据输入的资料生成具有逻辑性和连贯性的新内容。由此,人工智能进入了“大型语言模型” (LLM) 的时代。2024年,EpochAI[43]提出FrontierMath, 这是一个用于评估人工智能数学推理能力的基准测试,六个当今世界最领先的模型 : o1、Claude 3.5、Sonnet、GPT-4o、Grok和Gemini 1.5 Pro在这个测试下的成功率都低于2%。这个测试是基于三百多个涵盖了现代数学的大多数主要分支的问题而来的。

这些问题有两个特征:(1)解决方案是自动可验证的,从而实现高效的评估;(2)所有问题都是新的且未发表的,以防止数据污染——这是说LLM利用计算机的超级速度对关联的大数据进行实时采掘, 对没有收录在它们数据库的全新內容, LLM是没有办法的, 更何况人类自已也不知道的猜想的答案呢! 讲个笑话:网上的人工智能工具可以谈恋爱, 但距离可以创新数学、物理学和其他基础理论科学还远, 大家是仍然有很多机会的。

我们可以说: 人工智的“起飞”是始于OpenAI使用英伟达建造的微超级计算机(mini-super-computer)向公众提供ChatGPT——这就是我们所说的计算机与人工智能的结合。

这张照片是2016 年 8 月英伟达 (Nvidia) 黄仁勋亲手赠送给时在OpenAI的马斯克(Elon Reeve Musk)全球第一部 AI 超级计算机 DGX-1,这部计算机更适合用于AI的计算。2023 年5月25 日英伟达的市值增加2千亿美元(破纪录),到月底时全球市值排第六,超过Walmart 加上ExxonMobil。2025 年 1 月 28 日, DeepSeek 发布 R1,英伟达的市值暴跌 5 千亿美元 (破纪录)。

下图是英伟达的人工智能计算机芯片GB2000——这是上面的两个GPU作平行计算实时与下面的一个作线性计算的CPU转换。现时英伟达的H20芯片是禁运我国的,我们可以进口的是低一档的H200。

下图是我国生产的华为AI推理芯片(其中NPU是搭载了8颗昇腾910B,而CPU是配备了4颗鲲鹏920,左图)和人工智能超级计算机华为昇腾 Atlas900(右图)。

计算机系的老师开的数学课以数理逻辑为主,他们会讲模态逻辑(如[6])或与函数程序设计相关的λ演算(如[17])。至于计算机与范畴学,也许大家不相信两者有关系。我们不打算说明,但是我们希望用几本(例如[2][12][24][25][32][42]) 给计算机系的学生上范畴学的课本支持我们观点——范畴学是可以帮助明白和解决计算机理论问题的。

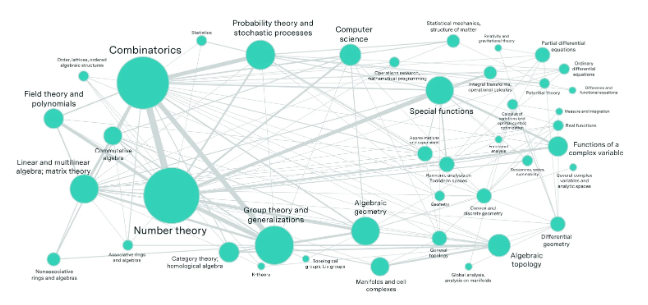

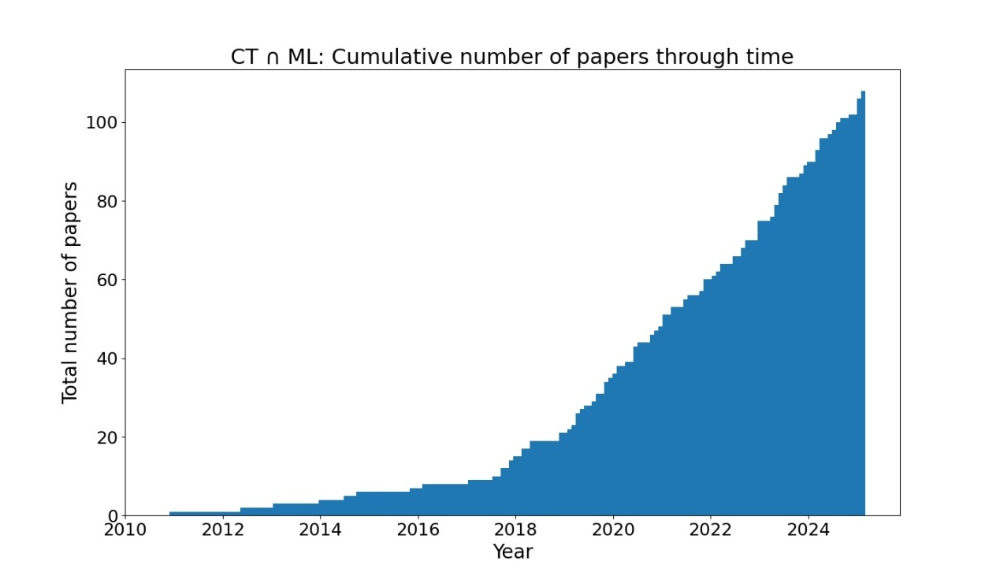

余下我们专注讨论人工智能与范畴学。从下图可见github收录的范畴与机器学习的文章出现了快速增长 (在arXiv上亦类似)。

最近人们发现: 计算机、人工智能和范畴学好像有共同的理论结构。我们举范畴学进入神经网络理论的三个例子来说明这个现象:

(2)数学是研究结构的科学。当两个绝不相同的系统有共同结构的时候,这两个系统便可以经过共同结构使用数学对话。

(3)什么是一个数学结构?每当一个系统有一个过程把两件事(或说两个元素)合成为新的一件事,便有一个数学结构。例如在代数学我们说‘群’G 是一种数学结构。G的任何两个元x,y可以合成为一个属于G的元x◦y。整数Z的加法是“群”的例子,两个整数 x, y可以用整数的加法合成为一个整数x+y。

(4)一个“范畴”也是一种数学结构。不过, “范畴”是可以用来研究数学结构的数学结构。例如:我们可以考虑由所有“群”组成的范畴Grp。

一个“范畴”C有两个部分。(1)是C的对象。(2)是C的态射。例如: 所有“集”组成的范畴Set的对象就是任何一个“集”;Set的态射就是任何一个“集的映射”f:X→Y。 我们用一个“集的映射” f:X→Y来比较两个集X,Y;我们用一个“范畴的函”’F:C→D 来比较两个范畴C,D。

(5)拓扑空间是刻划连续性的数学结构[40]。由所有‘拓扑空间’组成的范畴记为Top。范畴学的第一个重要的函子是基本群函子π:Top →Grp。使用函子π可以简单的解决关于拓扑空间的性质的问题[41]。我们当留意这是一件很神奇的事, Top是讲连续, Grp是讲加法, 左右两边看起来沒有半点关系, 但是数学, 即是函子π, 把两边联络起来!这个把两种事物联络起来的想法应会对人工智能理论有所贡献。

(6)目前我国比较成熟的数学系的本科生能学到一点范畴学。范畴学大师、美国数学家Francis William Lawvere为中学生写了一本学习范畴学的教材[22](不单范畴学,美国人亦鼓励青少年学习人工智能编程语言Python[8])。本文以下出现的范畴都是幺半范畴 (symmetric monoidal category),定义见[21]李文威的代数学方法。定义数学结构是需要使用数理逻辑的,不过看看[19][20]亦可以增加理解。

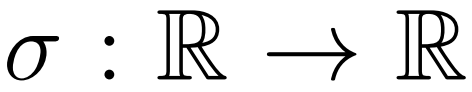

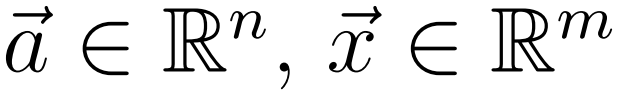

以

![]() 记实数,

记实数,

![]() 记n维实数向量空间,以P记参数空间

记n维实数向量空间,以P记参数空间

![]() ,称可微函数I:P×

,称可微函数I:P×

![]() →

→

![]() 为从

为从

![]() 至

至

![]() 的带参数可微函数。

给出从

的带参数可微函数。

给出从

![]() 至

至

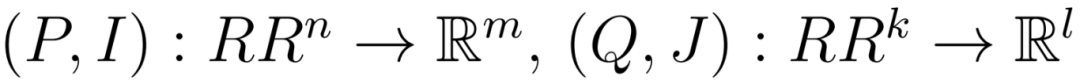

![]() 的带参数可微函数(P,I) 和(P′,I′),若有可微函数 f : P →P′ 使得 ∀p∈P, a∈

的带参数可微函数(P,I) 和(P′,I′),若有可微函数 f : P →P′ 使得 ∀p∈P, a∈

![]() 有I′(f(p),a) =I(p,a) ,便记 (P,I) ∼ (P′,I′)。∼是等价关系。

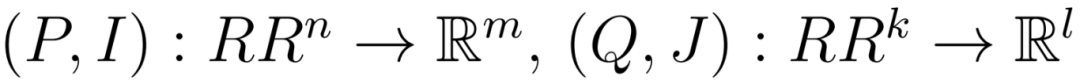

定义范Para的对象是

有I′(f(p),a) =I(p,a) ,便记 (P,I) ∼ (P′,I′)。∼是等价关系。

定义范Para的对象是

![]() , 从

, 从

![]() 至

至

![]() 的态射是从

的态射是从

![]() 至

至

![]() 的帶参数可微函数的等价类。取

的帶参数可微函数的等价类。取

![]() 。

设k=m则合成(Q,J)◦(P,I) 是 (P×Q,I∗J) ,其中(I∗J)(p,q,a) = J(q,I(p,a))。

定义(P,I)⊗(Q,J) 为 (P×Q,I∥J) ,其中 (I ∥ J)(p,q,a,c) = (I(p,a),J(q,c)).

。

设k=m则合成(Q,J)◦(P,I) 是 (P×Q,I∗J) ,其中(I∗J)(p,q,a) = J(q,I(p,a))。

定义(P,I)⊗(Q,J) 为 (P×Q,I∥J) ,其中 (I ∥ J)(p,q,a,c) = (I(p,a),J(q,c)).

接下来我们说明怎样把神经网络放在一起成为一个范畴,这是我们讨论人工智能与范畴学的第一个例子。

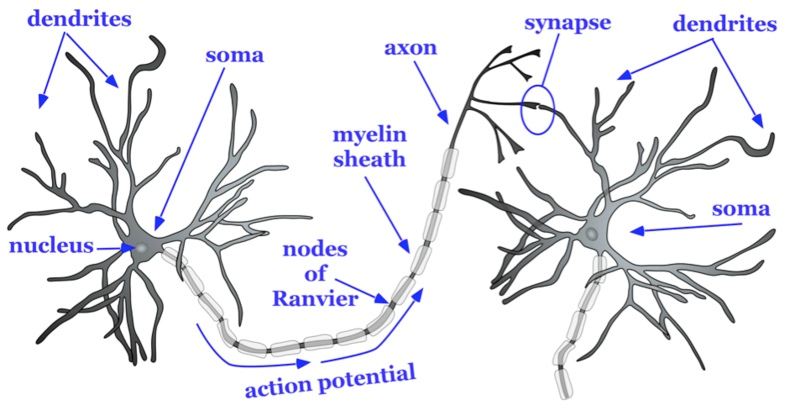

人脑由860亿个神经元 (neuron) 组成, 这些神经元由100万亿个突触 (synapse) “联络起来。以下是一张美丽的显微镜下的人脑神经网络图:

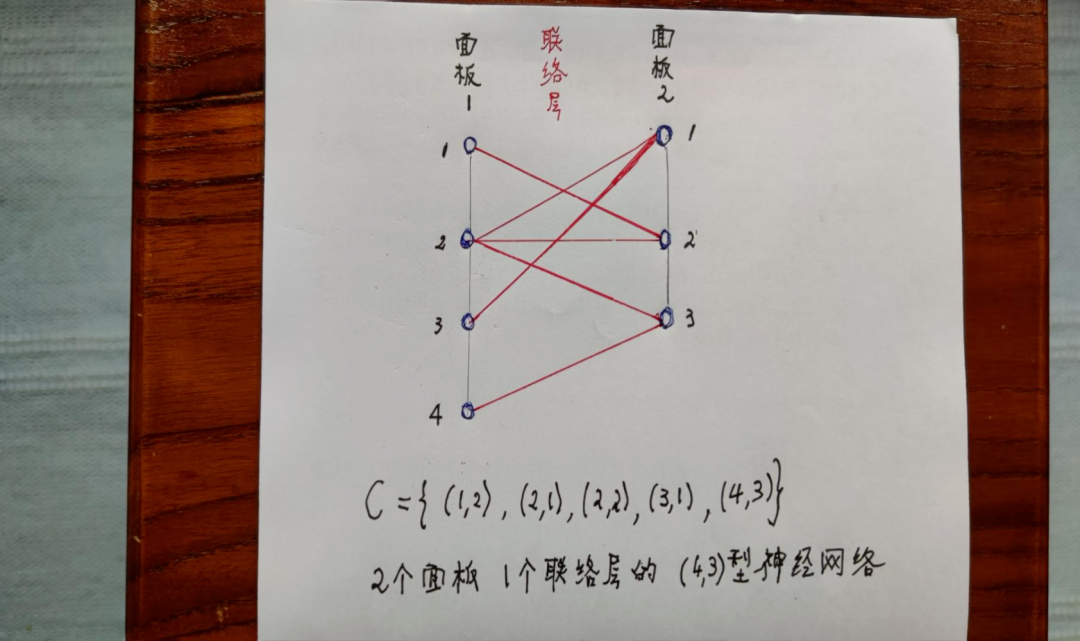

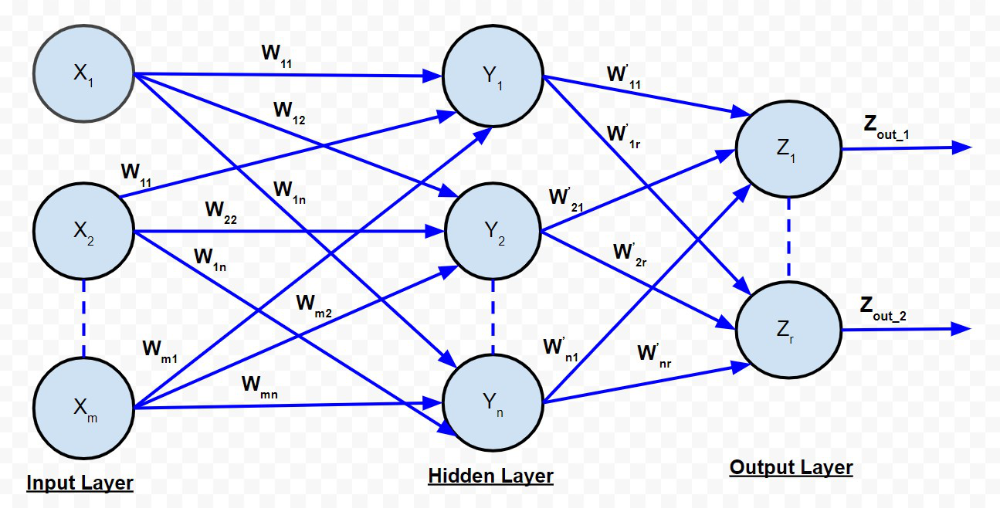

我们假设人工智能是用计算机建模来模仿人脑。我们简化实况——把神经元安排在一系列的面板 (panel),我们用线条代表突起(包括轴突和树突)以显示两个相继的面板的神经元的联络。我们称两个面板之间的所有联络线条为神经网络的联络层 (layer), 就是说从一个面板上的神经元到另一面板上所有的神经元的突起组成两个面板之间的一个联络层。

我们用一个集C={(i,j): 1 ≤i ≤m, 1 ≤j ≤n}来记录一个(m,n)-型联络层:这是说有m个神经元在第一个面板,n个神经元在第二个面板,若一对整数(i,j)在集C出现是指左边面板第i个神经元是联络至右边面板第j个神经元。以下是一个简単的例子——一个(4,3)-型神经网络。

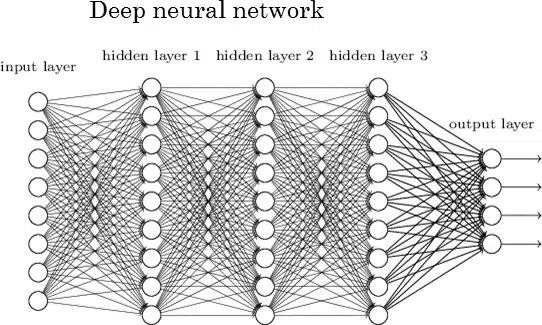

我们推广一点,定义(n0,nk)-型(前馈)神经网络N是有k+1个面板排起来, 第i个面板到第i+1个面板是一个(ni,ni+1)–型联络层Ci。我们亦可以说神经网络N是C1, C2,…, Ck-型的。

定义神经网络范畴NNet的对象为自然数, 态射$Hom (m,n)为所有(m,n)-型神经网络。用拼接 (concatenation) 定义网络的合成,恒等态射是0层神经网络。

这样我们达到了第一个目标:神经网络放在一起是一个范畴。

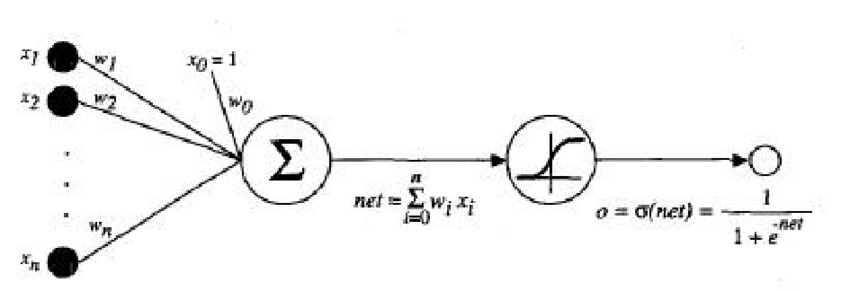

一个面板的神经元怎样输出信息:我们假设第i个神经元的电势是xi,而输出强度是xi的wi倍 (称wi为权), 于是总输出电势是net=∑wixi,然后设σ是个管线路开关的函数,即当电势达到某个数字便打开线路,把信号输出到下一个面板的某一个神经元。

把这个想法推广一下,下图是三块面板两层的网络, 这时每一层的权便写为矩阵(wij)。

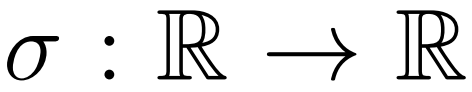

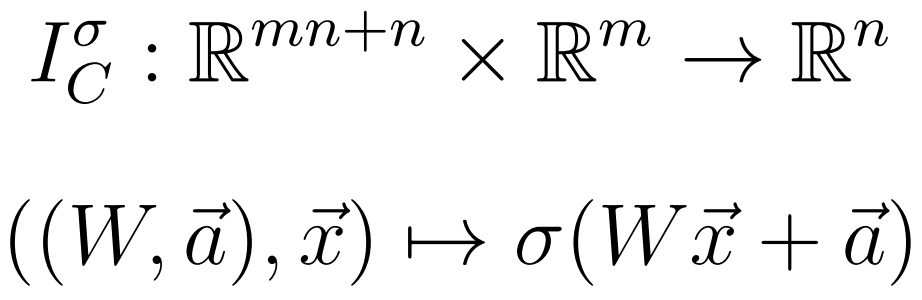

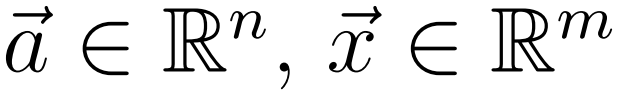

取可微函数

![]() 。定义Iσ把1-层(m,n)-型神经网络C映为带参数可微函数 :

其中W是n×m矩阵,

。定义Iσ把1-层(m,n)-型神经网络C映为带参数可微函数 :

其中W是n×m矩阵,

![]() ,向量a是在

,向量a是在

![]() , 向量x是在

, 向量x是在

![]() 。若神经网络

。若神经网络

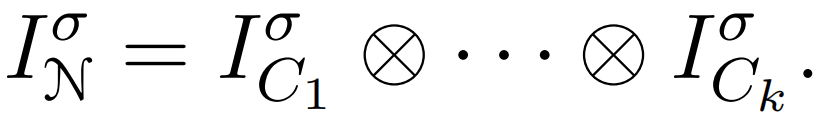

![]() 是C1, ⋯,Ck–型的,则设

我们可以构造一个范畴Learn使得Learn 的对象是集,态射是学习算法等价类; 并且构造一个函子L:Para→Learn。于是得函子L∘Iσ : NNet→Learn。可以利用这个函子的性质去了解学习算法的代数结构。以上来自MIT计算机系的文章[13]。

是C1, ⋯,Ck–型的,则设

我们可以构造一个范畴Learn使得Learn 的对象是集,态射是学习算法等价类; 并且构造一个函子L:Para→Learn。于是得函子L∘Iσ : NNet→Learn。可以利用这个函子的性质去了解学习算法的代数结构。以上来自MIT计算机系的文章[13]。

以T记绝对温度,Q记热量,热动力学用以下公式引入函数熵(entropy)S:dS =dQ/T。

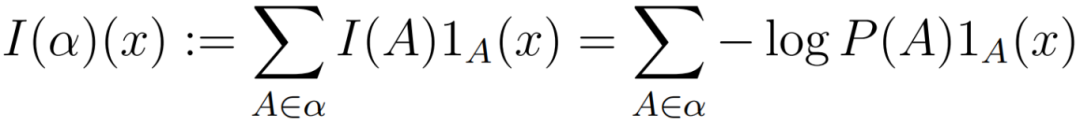

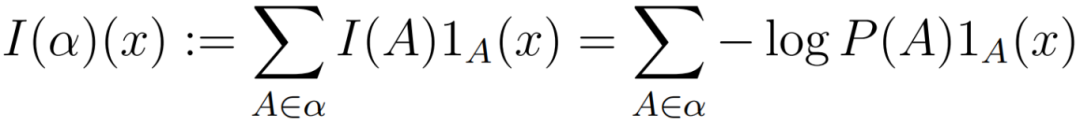

(1) 定义事件A的信息內容为I(A) :=-log P(A), 其中P为概率。

(2) 概率空间的有限可测分割 α= {A1, ⋯, AN }的信息內容是

![]() ,其中1A是A的特征函数。

(3) 有限可测分割α的熵定义为α的信息內容的平均值([10] 2.1节)

现代信息论是从Shannon 1948年Bell Journal[28]及Carnap和Bar-Hillel 1952年MIT Electronics Laboratory的文章[9]开始。之后的发展主要是在应用。到2015年拓扑进入信息论, Baudot和Bennequin[5]指出信息论的熵是上同调类, 这是信息论的一个划时代的更新。到了2020年Vigneaux[30]提出信息结构 (information structures) 统一各个观点。

我们范畴S的对象为定义在有限概率空间上的实数值随机变元, 以MX记X的象。要求范畴S的态射π: X→ Y满足条件:MX是MY的子集。以F记有限集范畴,则有函子M : S→F把X映为MX; 把态射π: X→ Y映为单射M(π) : MX→MY。称(S, M)为一个信息结构。

定义范畴InfoStr的对象为信息结构(S, M);态射为φ=(φ0,φ1): (S, M) → (S’, M’)其中φ0 : S →S’,φ1 : M → M’ ∘φ0。

,其中1A是A的特征函数。

(3) 有限可测分割α的熵定义为α的信息內容的平均值([10] 2.1节)

现代信息论是从Shannon 1948年Bell Journal[28]及Carnap和Bar-Hillel 1952年MIT Electronics Laboratory的文章[9]开始。之后的发展主要是在应用。到2015年拓扑进入信息论, Baudot和Bennequin[5]指出信息论的熵是上同调类, 这是信息论的一个划时代的更新。到了2020年Vigneaux[30]提出信息结构 (information structures) 统一各个观点。

我们范畴S的对象为定义在有限概率空间上的实数值随机变元, 以MX记X的象。要求范畴S的态射π: X→ Y满足条件:MX是MY的子集。以F记有限集范畴,则有函子M : S→F把X映为MX; 把态射π: X→ Y映为单射M(π) : MX→MY。称(S, M)为一个信息结构。

定义范畴InfoStr的对象为信息结构(S, M);态射为φ=(φ0,φ1): (S, M) → (S’, M’)其中φ0 : S →S’,φ1 : M → M’ ∘φ0。

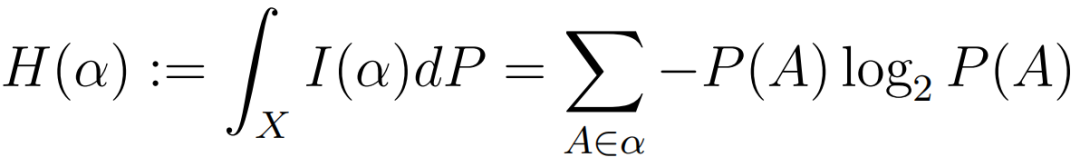

(1) 生理神经元在接收输入(光或外部电输入等感官刺激)或被细菌攻击时会被激活而产生电势。

(2)神经通讯:神经元之间的通讯通过电信号和化学信号进行。当一个神经元接收到来自其他神经元的信号时,它会在细胞体内处理这些信息,如果累积的输入足够强,就会产生一种称为动作电势的电脉冲。

(3) 如果我们在神经网络加入神经元,用发射脉冲 (spike) 序列传输信息,我们得到SNN (spiking neural network) [26](如下图)。

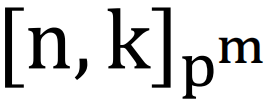

神经元在特定时间间隔内要么活跃, 即有一个脉冲;要么不活跃, 即没有脉冲。假设我们把观察时段分为n段,使得每个小时段最多只有一个脉冲。若第i个小时段有脉冲我们记1,没有则记0, 于是我们得一个n位二进数, 例如1011。假如我们做k个观察便生成一个二进码C。

今年华为已开始生产3进制AI芯片,而量子码是pm进制(p是素数) ([33][34])。到今天还未见医学或生物学的理论说人脑不可能做量子计算。

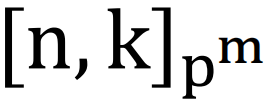

设F是有pm个元素的域。一个[n,k]pm码是指Fn的有pmk个元素的子集C。以dC(c, c’)记集{1 ≤i≤ n : ci不等于c’i} 的元素个数。

定义范畴Codes(n)的对象为

![]() 码,态射是映射φ : C→ C’使得φ(C) 是 C’的子集和dC’( φc, φc’) ≤dC(c, c’)。

设C是

码,态射是映射φ : C→ C’使得φ(C) 是 C’的子集和dC’( φc, φc’) ≤dC(c, c’)。

设C是

![]() 码,取I(C )为随机变元X : C →R组成的集。取Codes(n)的态射φ : C→ C’, 若X’ 属于I(C ‘)则取I(φ )(X’) = X’° φ。

定理. : Codes(n)→InfoStr是函子。

这是德国Bonn Max Planck Institute的工作[23]。

码,取I(C )为随机变元X : C →R组成的集。取Codes(n)的态射φ : C→ C’, 若X’ 属于I(C ‘)则取I(φ )(X’) = X’° φ。

定理. : Codes(n)→InfoStr是函子。

这是德国Bonn Max Planck Institute的工作[23]。

一个Topos是一个有丰富结构的范畴。一直以来Topos理论只是小部份的代数几何学家([35][37])和几何逻辑学家的工具([36])。但是进入了21世纪便看见Topos在信息系统控制 ([1])、网路管理([7])、神经网络([4][5][19])、6G通讯([3])、人工智能 ([18])和量子人工智能([31])的应用。

我们假设面板是按偏序≤排列。我们引入图Γ。取网络N的面板为Γ的顶点; 若有a≤b,则以a→b为Γ的箭。

以C(Γ)记Γ的路范畴; 在C(Γ)op取Grothendieck拓扑得位形。

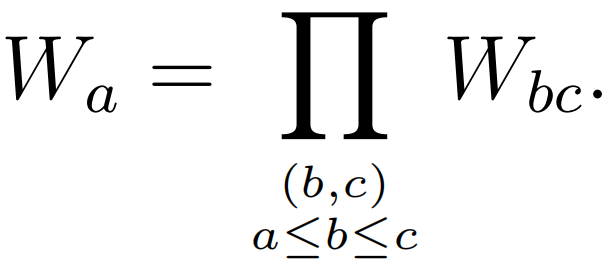

对b≤c, 设集Wbc的元素为从面板b上的神经元至面板c上的神经元的突触的权。取顶点a,设

则{Wa,Wa→b} 决定函子 W: C(Γ)→Set。并且 W 是层, 是属于C(Γ)op的Topos。

定理.每一个深度神经网络(DNN)N 有一个ToposT(N) 使得 N的动力系统是属于T(N)的层(sheaf)。

以上来自华为巴黎实验室Bennequin, Belfiore 2022年的工作[4]。

为了鼓励学生学习,老师常说“数学很有用”。老师说:今天你掌握多少数学就是你可以掌握多少你明天的前程 ! 在此我们让企业说同样的话。2020年9月12日,华为徐文伟在由中国工业与应用数学学会举办的数学促进企业创新发展论坛提出通讯数学的华为10大问题。这是值得我们下载看看生产前线对数学的求助。此外2021年剑桥大学出版社为华为出版文集[16], 书中华为的不同部门的主管谈他们工作上遇到的数学。我们相信华为之外像阿里巴巴、腾讯等也在使用大量数学。不过从文献[14][38][39]所见,人工智能用的数学只是微积分、线性代数、数值算法、Bayes统计、Monte Carlo方法和随机梯度下降。我们只能希望有一天人工智能可以用上更深刻的数学。

黎景辉,1974年数学博士,论文导师是朗兰兹。毕业后在中国香港、中国台湾和国外的大学当老师。自1978年曾在中山大学、华东师范大学、北京大学、首都师范大学、山东大学、河南大学、东北师范大学、河南师范大学等大学讲课。研究方向是代数数论和数学教育。在科学出版社、高等教育出版社、北京大学出版社和河南大学出版社出版多部数学专著。

[1] Avsykevich D,Formalization ofcontrol systems based on the topos theory, Military Space Academy, St. Petersburg,(2021).

[2] Barr M, Wells C ,Category Theory for Computing Science,Grundlehren dermath. Wiss. 278, Springer-Verlag, Berlin, (1985).

[3] Belfiore J, Debbah M, Towards an intelligent 6G – a Topos perspective, Huawei Algo. Lab. Paris (2019).

[4] Belfiore J, Bennequin D, Topos and stacks of deep neural networks, Huawei Adv. Wireless Lab. Paris arXiv, 2106.14587, (2022).

[5]Baudot P, Bennequin D, The homological nature of entropy, Entropy, 17(5):3253–3318, (2015).

[6]Blackburn P, de Rijke M, Venema Y, Modal Logic. Cambridge University Press (2002).

[7]Bonick J,Higher category theory as a paradigm for network applications,Signal Processing, Sensor Fusion, and Target Recognition,United States Defense and Security Symposium, (2006).

[8] Briggs J, Python for Kids: A Playful Introduction to Programming, No Starch Press; ( 2022)

[9] Carnap R, Bar-Hillel Y, An outline of a theory of semantic information, MIT

Lab. Of Electronics, Technical Report 247 (1952).

[10] Cover T, Thomas J, Elements of Information Theory, Wiley, (2006)

[11]Fausett L, Fundamentals of Neural Networks_ Architectures, Algorithms, and Applications, Prentice Hall, Englewood Cliffs (1993).

[12]Fiadero J, Categories for Software Engineering, Springer. (2005).

[13]Fong B, Spivak D, Tuyeras R, Backprop as functor, ArXiv 1171.10455, (2019)

[14]Goodfellow I, Bengio Y, Courville A, Deep Learning, MIT Press,(2016).

[15]Gust H,Learning Models of Neural Networks Based onTopos Theory, (2007).

[16]Heng L, McColl B(Editors), Mathematics for Future Computing and Communications-Huawei volume, Cambridge University Press, (2021).

[17]Hindley J, Seldin J, Lambda Calculus and Combinatorics, Cambridge University Press, (2008).

[18]Lafforgue L, Some possible roles for AIof Grothendieck topos theory, Huawei Research Center, France, (2022).

[19]黎景辉, 冯淑霞,梁志斌,俞小祥,朱一心, 中学数学和大学数学的本质区别对学习和教学的影响, 数学通报, 59(3), 1-6; 59(4), 7-10,17; (2020).

[20] 黎景辉, 形式系统和数学, 数学文化, 11-3 (2020) 37-44.

[21] 李文威,代数学方法, 卷一,二, 北京, 高等教育出版社 (2016).

[22] Lawvere W, Schanuel S, Conceptual Mathematics: A First Introduction to Categories Cambridge University Press; ( 2009)

[23]Manin Y, Marcolli M, Homotopy-theoretic and categorical models of neural informationnetworks, Compositionality, 6 (2024).

[24]Milewski B, Category Theory for Programmers,Creative CommonsAttribution (2017).

[25]Pierce B, Basic Category Theory for Computer Scientists,MITP ress,1991.

[26] Quiroga R, Panzeri S(Ed),Principles of Neural Coding, CRC Press, (2013).

[27] 邱锡鹏, 神经网络与深度学习,复旦大学(2021)https://nndl.github.io

[28]Shannon C, A mathematical theory of communication. Bell System Technical Journal,27:379–423, 623–656,(1948.)

[29]Vallani M, Topos of Google Transformer Networks, arXiv, 2403.18415(2024).

[30] Vigneaux J, Information structures and their cohomology, Theory and Applications of Categories, Vol. 35, No. 38, (2020), 1476–1529.

[31]D. Youvan, Topos Theory and the Evolution of Quantum AI, (2024)

[32]Walters R, Categories and Computer Science, Cambridge University Press (2009).

[33] 冯克勤, 陈豪, 量子纠错码, 科学出版社 (2010).

[34]W.F. Ke, 黎景辉,R. B. Zhang, Quantum codes from Hadamard matrices, Linear and Multilinear Algebra, 58 (2010) 847–854.

[35]Grothendieck A, et. al.,Seminaire de Geometric Algebrique, [SGA 4], Springer Lect. Notes Math., 269 (1972).

[36] Johnstone P, Topos Theory, Dover Books, (2014).

[37]黎景辉,TOPOS理论, 高等教育出版社, 2025年将出版。

[38]Hardt M, Recht B, Singer Y, Train faster, generalize better: Stability of stochastic gradient descent, Proceedings of The 33rd International Conference on Machine Learning, J. Machine Learing Research, 48 (2016) 1225– 234.

[39] Murphy K, Machine Learning, MIT Press (2012).

[40] 江辉有, 拓扑学基础, 北京:科学出版社(2001).

[41] Massey W,Algebraic Topology–an introduction, Springer (1977)

[42] Pitt D, Rydeheard D, Johnstone P (eds.), Category Theory and Computer Science, Springer Lecture Notes in Computer Science 953, (1995).

[43]E. Glazer, et.al. , FrontierMath: A Benchmark for Evaluating Advanced Mathematical Reasoning in AI, (2024), arXiv:2411.04872v5

范畴论被称为是“数学的数学”,为现代数学提供了一套基础语言。范畴论是一个关于关系的理论,描述并研究关系的所有可能性质。它提供了一种系统、精确、抽象的跨领域科学方法论,可直接付诸于各领域考察的问题,寻求跨领域的解决之道。这种数学语言与复杂性科学有众多相似之处,加之其本身作为数学工具的严密性,后续可能能为解决复杂性科学问题提供一把钥匙。范畴论系列课程包含两季的“范畴论入门系列课程”,和最新的「范畴论与机器学习」课程,该课程从范畴观点切入机器学习,包括对机器学习的某些方法论建立背景的具体范畴的研究方法,以及从神经网络架构等出发研究在范畴上的某些结构。参看:

6. 加入集智,玩转复杂,共创斑图!集智俱乐部线下志愿者招募