基于神经网络的智能控制技术及其发展趋势讲座回顾2 | 原创精选

你以为这篇和昨天发的是一样的?那你就out了!这是一篇全新的干货炸弹!不信,你自己看完就知道了~

上周贾梓筠女神的讲座出席人数爆满,座无虚席,大家都认真地享受着这场知识的饕餮盛宴!女神将晦涩难懂的知识通过形象化、具体化、简洁化的阐述,让在座的所有人,不管是兢兢业业的程序猿还是霸气外露的企业高管、不管是朝气蓬勃的初中生还是知识渊博的博士生,都对女神的讲座赞不绝口!(想勾搭女神?文末有彩蛋哟~~~)

昨天张泽鑫小帅哥的笔记分享一经发出,获得了大家的一致好评!除了对笔记干货的超高评价外,还有小粉丝留言勾搭~哈哈哈哈我们大集智就是这么人才济济,汇聚英才!(如果你也觉得自己很有才,就来找我们,给你舞台!)

接下来,小编使出自己的洪荒之力,继续为大家送上超级福利!你想知道清华的男神们是怎么学习的吗?哈哈哈跟着下面这位颜值与才华齐飞的男神一起去探索机器智能的世界吧~

(小编语:要是有妹子看上的请后台留言,小编可以给你联系方式!如果是汉子的话就自己去清华勾搭吧~后台留言互动抽取一名幸运观众赠送集智精品T恤一件~有钱任性)

崔昊天 清华大学研究人工智能的在读硕士,一边研究机器的循环神经网络,强化学习,一边也关注真实的大脑。

前言

讲座中贾女神倾囊相赠,公式满天飞,据说是包括了一堆尚未发表的内容。因此这部分总结,我就放上一些感受最深的点,以及转述一下讲者的思考。没听到具体细节的同志,只能怨没来现场了。

1.

智能控制介绍

Figure 1. 波士顿动力的机器人们

Figure 1. 波士顿动力的机器人们

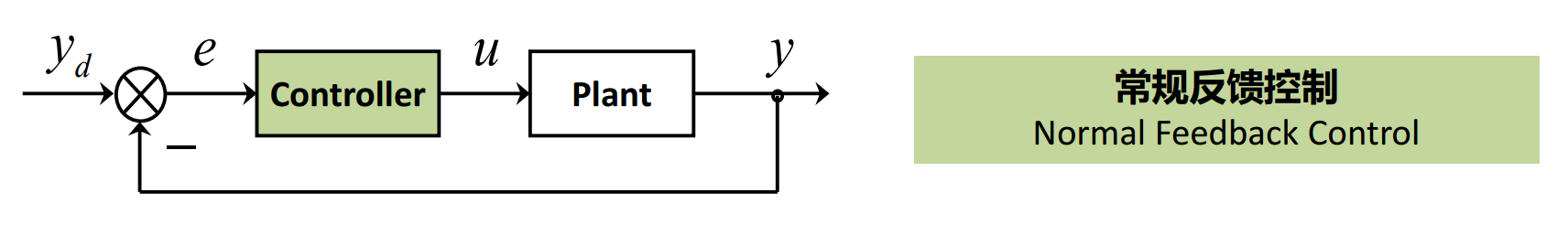

控制是干什么的:通俗的举例比如你拿到了一款新款的机器人,机器人的关节就是执行器,机器人的脑子就是控制器。你想让机器人平稳的走路,就需要脑子发出指挥信号,控制的过程就是研究控制器怎么样成功产生指挥执行器的最佳指令的。

Figure 2. 反馈控制

Figure 2. 反馈控制

传统控制方法往往依赖于对控制对象系统的建模,建模越精确,控制也会越准确。这一系列的方法也遇到种种的问题:线性时不变的模型会相对简单(比如PID方法),然而简单抽象出的模型会带来与实际系统的脱节;相比之下复杂的,非线性的模型又会使得控制方法变得复杂,建模的人力成本提高,维护困难等等。

之所以智能控制能成为研究的前沿和发展方向,也是因为能摆脱建模过程中的复杂性,而提高在问题模型之间跨越的适应性,相较于传统方法表现出明显优势。

下面要讲的神经网络控制方法,就是属于智能控制领域中的一个方面。

——————————分割线————————————

以上都是背景,后半部分才是重头戏(好戏总是留在后头~)

2.

神经控制新方法

2.1什么是神经网络控制

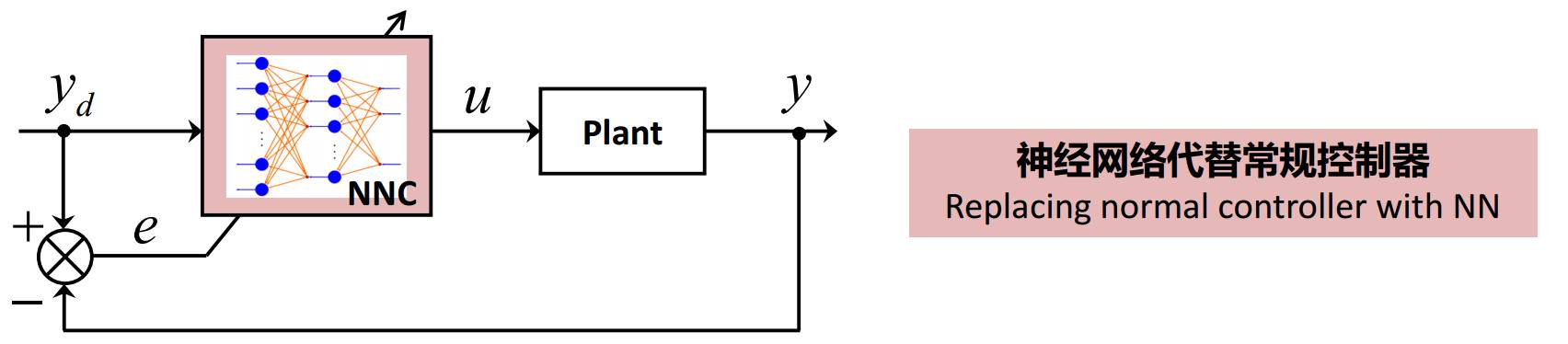

所谓神经网络控制方法,可以简单地理解成把传统反馈控制中的控制器换成了神经网络。

Figure 4. 神经网络控制,注意与Figure2的差别

为什么要做这样的改变,我的理解神经网络控制的优势一是省去了对每个不同模型都要建模的过程,二是神经网络更容易实现在鲁棒性,容错性方面的提升,三是网络本身结构复杂度的改变能够反映不同任务复杂度的需要,实现适应性。

2.2线上自适应学习

与machine learning中的神经网络不同,在控制领域应用神经网络,有独特之处:比如运算时间要能满足控制任务的需要(想一想实时控制机器人平衡的场景),比如网络计算消耗要适合控制器的运算能力(想一想alphaGo下一盘棋要耗多少电用多少服务器)。这里贾女神首先提出的是线上自适应学习,我理解为控制器在控制的过程中要学习不断适应新的变化。

Figure 5. 线上自适应学习

这一点就区别于Machine Learning中训练集,测试集的设置,以及训练集测试集同分布的假设。讲座中在这里放了很形象的图,据说来自控制领域大牛S.S.Ge曾经的slides:

Figure 6. 骑摩托车中的自适应控制

Figure 6. 骑摩托车中的自适应控制

意思是人开摩托车的时候,后面驼了一筐猪也是开,什么都不驼也是开。不会说负重变了,系统模型不一样了就不会开了。做神经网络控制器也需要这种适应性,就是线上自适应学习。

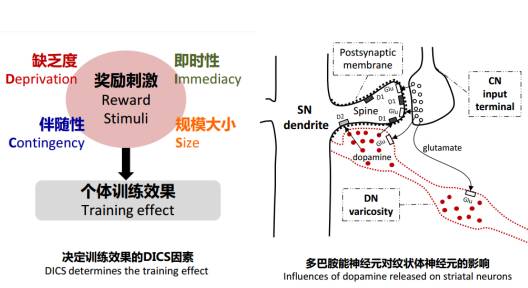

贾女神的工作:操作性条件反射学习机制,是一种可以实现线上自适应学习的方法(当然这个学习方法还有其他种种优点)。这个学习机制在控制过程中不断监测执行器的表现,通过适当的方式发出奖励机制进行学习。贾女神自己介绍,想法源自认知科学与神经科学研究的启发。

Figure 7. 左:行为学中的奖励机制。

右:纹状体内部的奖励回路

2.3对神经网络的其他改进

传统的三层前馈神经网络在设置网络超参数之后是一个固定结构,贾女神在工作中做出改变,实现能够在学习中动态改变的网络,包括时变的理想权值,多样化基函数,神经元数量(受reward的指导控制)自增减。我理解这是在自适应的前提下从各个方向为神经网络控制器增加自由度,实际上在网络规模比较小的情况下(讲座中涉及到的应用的确如此),这些增加的自由度大大增加了对任务的适应能力。

另一方面,在这种设置下面临的是一个复杂的优化问题,穿插了可微与不可微的组成部分,广泛适用的梯度反向传播(BP)的优化方法并不适用。贾女神也似乎从来没有考虑过BP,而是开发了利用受限李雅普诺夫函数保证渐进有效性的方法。

3.

问题与思考

贾女神的讲座着实精彩,触发了许多新思考,包括我的一些疑问:

1.与深度网络的规模差别

深度学习实际上引领了近几年人工智能和机器学习研究的潮流。与一些相应工作相比,讲座中涉及到网络规模差别巨大。比如贾女神仿真中采用50个神经元的网络,与resnet[1]上百层,每层上百个filter相比,参数量差了3个数量级以上。

而深度学习的研究发现网络复杂度和深度的提升能够明显提高效果性能,在卷积网络中也能有超越以往的特征提取效果。能否借鉴这些经验,比如将卷积网络,循环神经网络等结构引入控制问题中呢。

2.与强化学习的联系

贾女神对奖励机制的应用与强化学习的思路不谋而合(甚至早期的强化学习也有来源于心理学行为学的研究)。不同点是,(1)贾女神将reward信号与网络结构的改变结合起来,而现有的深度强化学习方法尚未考虑到这一点,是否是一个可以借鉴到深度强化学习领域的思路呢(Jake讲座后提出了这个问题)。(2)强化学习中有众多独到的概念[2],如state value function(可以看作对未来好坏的估计),Temporal Difference Learning等,又是否可以借鉴到控制领域的神经网络中呢。

3.与大脑奖励机制的联系

Figure 8. 经过训练产生的多巴胺能神经元可以在reward发生前进行准确预测。

但是reward与预测相左时又会减少发放率。

大脑的奖励机制中会有与强化学习中state value类似的预测效果,但是事实与预测相左时又会立即给出“惩罚”(对应上图中最后一种情况中多巴胺能神经元发放的减少)[3]。这种惩罚机制在控制领域或者在强化学习中有适用之处吗?

4.

结构动态的神经网络

结构上的动态,是贾女神的工作中的一大亮点。这种动态网络的研究也曾出现在machine learning的研究中,只不过在最近的深度学习浪潮中并不被广泛关注。即使性能上一时没有明显优势,也要长远来看,结构动态的网络会不会在某些方面胜出呢?比如可以对不同的任务搜索优化的拓扑结构呢。

Reference:

[1] He K, Zhang X, Ren S, et al. Deep residual learning for image recognition[J]. arXiv preprint arXiv:1512.03385, 2015.

[2] Sutton R S, Barto A G. Reinforcement learning: An introduction[M]. Cambridge: MIT press, 1998.

[3] Schultz W, Dayan P, Montague P. A neural substrate of prediction and reward[J], Science, 1997, 275:1593-1599.

– NOT END –

是不是看完之后想要勾搭女神与女神进行交流却苦于没有途径呢?哈哈哈,贴心的小编为大家准备了入群通道~

科普一下女神的群!

本群由贾梓筠创建,目前是北交大在读PhD,MIT海归。以多学科融合为特色,专注于智能控制理论、人工神经网络、机器人、嵌入式控制系统设计领域研究和开发,期待来自不同领域的专业和非专业小伙伴加入;致力于为热爱探索科学新知、对未知有强烈好奇心、乐于将理论付诸实践的小伙伴们提供一个认知升级、专业探讨、资源链接的社群平台;不管你是做人工智能、机器人系统、生物工程、脑科学还是产品开发,欢迎来这里一起在热爱的领域尽情努力地玩儿~

1、扫描二维码或者点击阅读原文填写麦克表单。

2、通过集智相关人员的好友申请即可入群。

最后的最后,送上福利!(下期内容更精彩呦~~)

– END –

集智俱乐部

英文名: Swarm Agents Club ,简称“ SA Club ”,成立于 2008 年 , 是一个从事学术研究、享受科学乐趣的探索者的团体 。它倡导以平等开放的态度、科学实证的精神,进行跨学科的研究与交流,力图搭建一个中国的 “ 没有围墙的研究所 ”

集智俱乐部的口号:

让苹果砸得更猛烈些吧!!!

集智俱乐部的使命(即目标):

营造自由交流学术思想的小生境,

孕育开创性的科学发现

集智每周精品推荐

深度学习征服复杂性 | 深度“深度学习”读书会第1期笔记随想

基于神经网络的智能控制技术及其发展趋势讲座回顾 | 原创精选

让苹果砸得更猛烈些吧!

长按识别二维码,关注集智Club,

让我们离科学探索更近一步。

始发于微信公众号: 集智俱乐部