复杂网络动力学机器学习自动建模

背 景

问 题

问 题

论文题目:

Neural Dynamics on Complex Networks

论文地址:

https://www.kdd.org/kdd2020/accepted-papers/view/neural-dynamics-on-complex-networks

不同网络结构与动力学下的节点状态变化情况

相关工作

相关工作

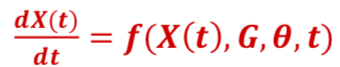

基本思路

基本思路

算法框架

算法框架

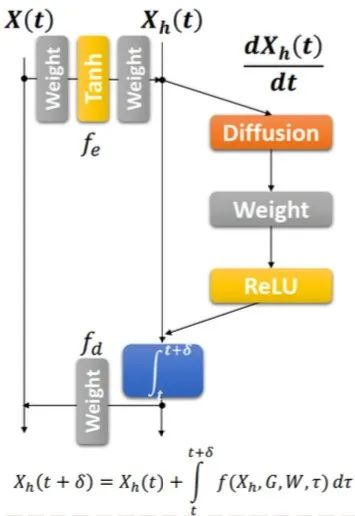

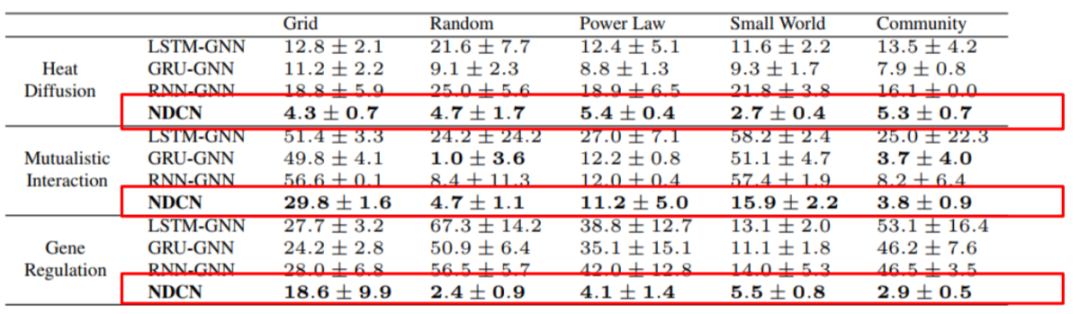

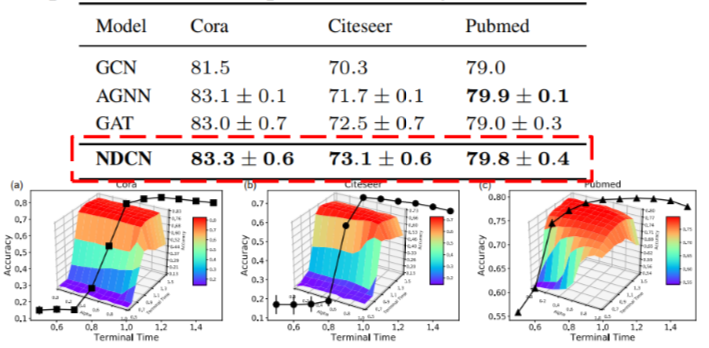

实 验

实 验

总 结

总 结

讲者:臧承熙 整理:张章 编辑:邓一雪

复杂科学最新论文

集智斑图收录来自 Nature、Science 等顶刊及arXiv预印本网站的最新论文,包括复杂系统、网络科学、计算社会科学等研究方向。每天持续更新,扫码即可获取:

推荐阅读

集智俱乐部QQ群|877391004

商务合作及投稿转载|swarma@swarma.org

◆ ◆ ◆

搜索公众号:集智俱乐部

加入“没有围墙的研究所”

让苹果砸得更猛烈些吧!

👇点击“阅读原文”,追踪复杂科学顶刊论文