近日,MIT的研究人员在 Nature Machine Intelligence 杂志上发表论文,提出了一类新的机器学习模型——闭合形式连续时间神经网络(Closed-form continuous-time neural networks,CfC),以闭合的形式逼近神经元和突触之间的相互作用。CfC模型具有因果性、紧凑性和可解释性,在通过运动传感器识别人类活动,模拟步行机器人的物理动力学建模,以及基于事件的序列图像处理方面具有更快的速度和更好的性能。此外,模型还可以帮助建立具有数十亿细胞的大脑计算模型,为理解智能开启新的研究途径。

王佳馨 | 作者

张振宇 | 审校

邓一雪 | 编辑

去年,麻省理工学院的研究人员开发出“液态”神经网络,这是一类灵活的,鲁棒性强的机器学习模型,其灵感来自只有302个神经元的线虫的大脑。它不仅可以在任务中学习,还能适应不断变化的条件,可用于现实世界的关键任务,如驾驶和飞行。“液态”神经网络的灵活性也意味着增强我们与世界的连接,为许多涉及时间序列数据的任务提供更好的决策,比如大脑和心脏监测、天气预报和股票定价。

但随着神经元和突触数量的增加,这些模型的计算成本变得昂贵,需要笨拙的计算机程序来解决其潜在的复杂数学问题。所有这些数学问题,就像许多物理现象一样,成规模来解决变得更加困难,这意味着计算许多小步骤才能得到一个解决方案。

最近,该团队又发现了一种缓解这一瓶颈问题的方法,即通过突触求解两个神经元相互作用背后的微分方程,从而解锁一种新型快速高效的人工智能算法。这些模式具有与液态神经网络相同的特征——灵活、因果性、鲁棒性和可解释性——但速度要快几个数量级,而且可扩展。因此,这种类型的神经网络可以用于任何需要长期了解数据的任务,因为即使经过训练,它们也非常紧凑和适应性强——而许多传统模型都是固定的。

该模型被称为“闭合形式连续时间” (CfC) 神经网络,在一系列任务中该方案优于最先进的同类模型,在通过运动传感器识别人类活动,模拟步行机器人的物理动力学建模,以及基于事件的序列图像处理方面具有更高的速度和性能。例如,在一项医疗预测任务中,新模型对8000名患者的采样速度要快220倍。

麻省理工学院计算机科学和人工智能实验室 (CSAIL) 主任、这篇新论文的资深作者Daniela Rus教授说:“我们称之为‘CfC’的新机器学习模型,用一个闭合的近似形式取代了定义神经元计算的微分方程,保留了液态网络的美丽属性,而不需要数值积分。”她还说到,“CfC模型具有因果性、紧凑性、可解释性,以及训练和预测的有效性。它们为安全关键的应用打开了可信机器学习的道路。”

关于这项工作的论文以 Closed-form continuous-time neural networks 为题,于近日发表在 Nature Machine Intelligence 杂志上。

Closed-form continuous-time neural networks

https://www.nature.com/articles/s42256-022-00556-7

根据论文,连续时间神经网络是这样一类机器学习系统,它可以处理时空决策任务的表示学习。这些模型通常用连续微分方程表示,其在复杂动态数据建模中非常有用。这些模型将静态神经网络的深度维和循环神经网络 (RNNs) 的时间维转化为一个连续的向量场,实现了对非均匀采样数据的参数共享、自适应计算和函数逼近。

虽然基于常微分方程(ODE)的神经网络具有细致的记忆和梯度传播设计,在相对较小的基准上与先进的离散化循环模型具有竞争力,但由于使用先进的数值差分方程(DE)求解器,它们的训练和推理速度较慢。随着数据、任务和状态空间复杂性的增加(即要求更高的精度),这变得更加麻烦。

突触是自然和人工神经网络的组成部分,该研究团队展示了神经元和突触之间的相互作用是可以逼近的,推导了一个闭合的连续深度模型,它具有基于ODE的模型的建模能力,但不需要任何求解器来建模数据。与基于微分方程的对应模型相比,得到的模型在训练和推理方面要快1~5个数量级,并且具有显著的扩展性,在时间序列建模中表现出了良好的性能。

在这项工作中,研究人员用相应的非线性算子替换了描述神经元与其输入非线性突触连接相互作用的非线性差分方程的积分 (即ODE的解)。这在原则上可以通过函数式泰勒展开来实现。然而,在液态时间常数 (LTC) 网络的特定情况下,可以利用闭合表达式来表示系统对输入的响应。

该项研究所提出的连续神经网络提供了更快的训练和推理速度,同时像基于ODE的对应网络一样具有表达力。研究人员给出了一类解释时间模型的连续神经网络近似闭合解的推导。

研究人员应用线性ODE理论来解析求解 LTC DE 的动力学。然后将解简化到剩下一个积分需要解的点,然后分析了得到的闭型解的性质,并设计了一类新的神经网络模型,称之为闭合形式连续深度网络 (CfC)。CfC在其公式中具有显式的时间依赖性,不需要数值ODE求解器来获得其时间展开。因此,它们最大限度地权衡了求解器的准确性和效率。

与基于ODE的同类算法相比,这种显式的时间依赖性使得CfC在训练和推理时间方面至少快一个数量级,且不会损失准确性。

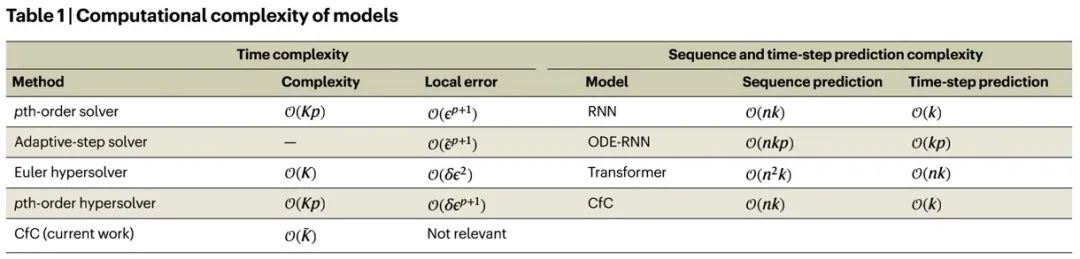

在序列建模任务中,可以根据整个观察序列进行预测,或者执行自回归建模,其中模型在给定当前时间步输入的情况下预测下一个时间步输出。表1描述了对于长度为n的给定序列和包含k个隐藏单元的神经网络,不同神经网络实例在推理时的时间复杂度。根据研究观察,在序列预测和自回归建模 (时间步长预测) 框架中,基于ODE的网络和Transformer模块的复杂性至少比离散RNN和CfC高出一个数量级。

这是可取的,因为CfC不仅建立了类似于ODE模型的连续流,以在表示学习中获得更好的表达能力,而且具有离散RNN模型的效率。

此外,CfC还配备了新型的时间依赖型遗传机制,可以显式地控制它们的记忆。CfC与基于ODE的同类一样具有表达能力,并且可以提供混合内存架构,以避免在具有长期依赖的顺序数据处理应用程序中出现梯度问题。除了准确性和性能指标,研究结果表明,当考虑到每次计算时间的准确性时,CfC比基于ODE的分区表现出超过150倍的改进。

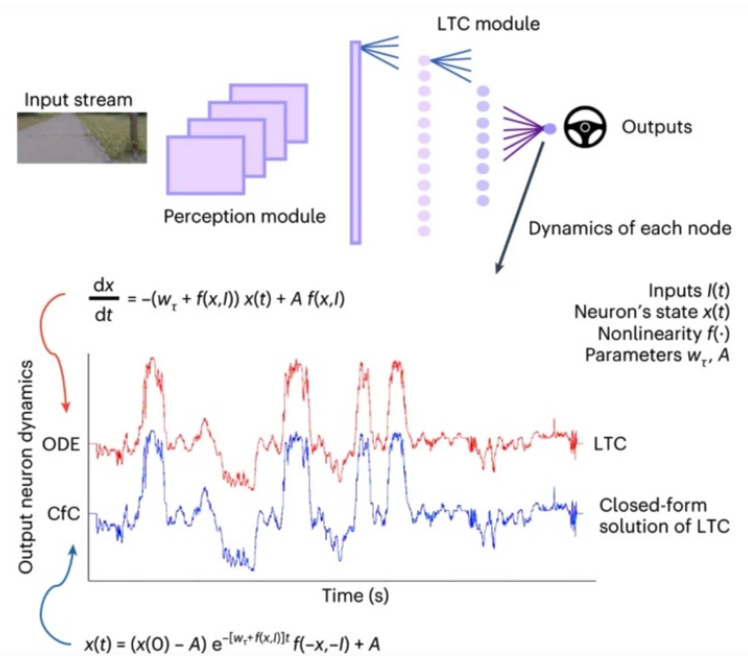

图2显示了一个基于LTC的自动驾驶训练网络[22]。该图进一步说明了所提出的解决方案与给定相同参数化的单神经元ODE所显示的实际动力学是多么接近。

近似计算LTC网络的一个闭合形式解,同时在很大程度上保留了它们的等效ODE系统的轨迹。研究人员将解决方案开发为CfC模型,在复杂时间序列预测任务的训练和推理方面,CfC模型的速度至少是神经ODE的100倍。

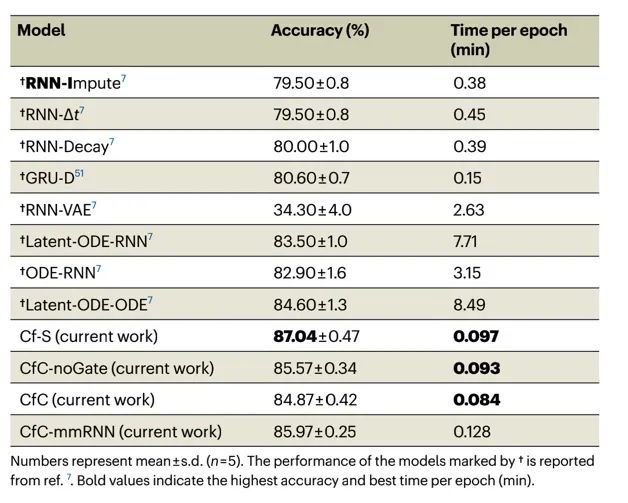

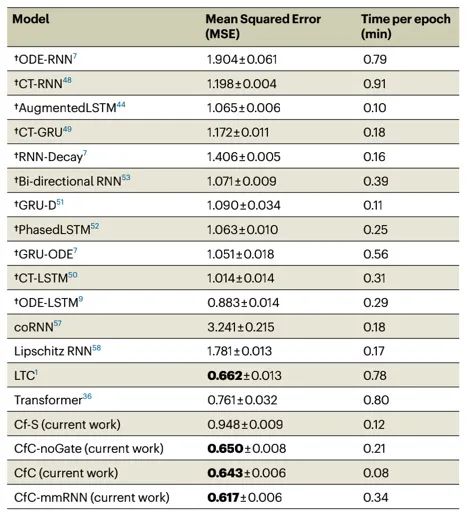

研究人员评估了CfC在一系列连续数据处理任务中的性能,例如位流预测、文本数据的情感分析、医疗时间序列预测、人类活动识别、顺序图像处理和机器人运动学建模等,CfC 在一系列任务上的表现优于最先进的同类模型。例如人类活动识别,CfC性能比其他模型高,而且速度比性能最好的基于ODE的实例提高了超过8,752%。

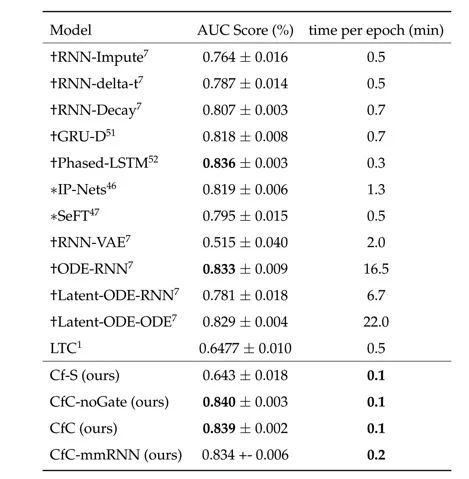

在基于事件的序列图像处理任务中,所有的CfC变体都能很好地完成这一任务,并在这一任务中建立了最先进的技术,CfC-mmRNN在分类不规则采样序列方面达到了98.09%的准确率,CfC-noGate达到了96.99%的准确率。值得一提的是,它们的速度比基于ODE的模型 (如ODE-ODE和ODE-RNN) 快200-400%。

PhysioNet挑战中CfC的训练时间比ODE-RNN快160倍,比连续潜模型快220倍,与其他基线相比具有竞争力。平均而言,CfC比先进的离散门控循环模型快三倍。

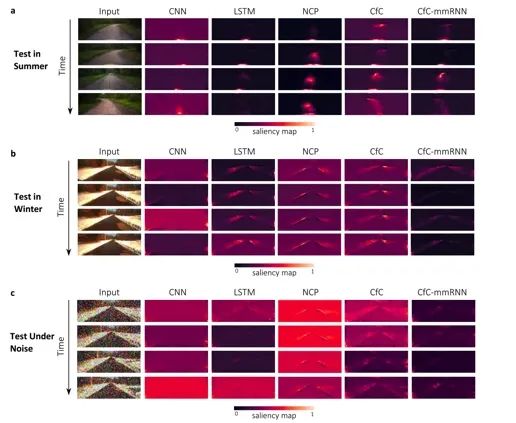

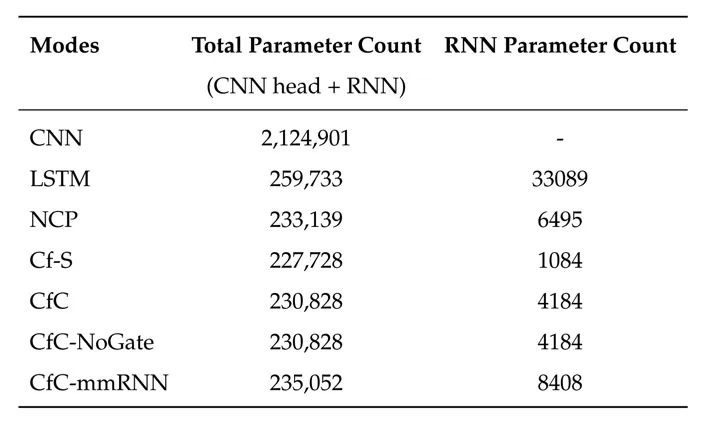

在自动驾驶中实验中,研究人员的目标是评估CfC与基于ODE的LTC网络相比,如何强健地学习执行自主导航。任务是将进入的高维像素观测映射到转向曲率命令。他们观察到,与NCP类似的CfC在每个子任务中表现出一致的注意模式,同时在重噪声下保持它们的注意剖面。与此同时,其他网络 (如CNN和LSTMs) 的注意力分布受到附加输入噪声的阻碍。

该实验验证了CfC与ODE具有相似的鲁棒性,即基于LTC的网络。此外,与NCP类似,CfC具有参数高效性。他们在RNN组件中使用约4000个可训练参数执行端到端自主车道保持任务。

总而言之,这篇文章介绍了一个由LTC网络的近似闭合形式解建立的连续时间神经模型,该模型具有基于ODE网络的强大建模能力,同时明显更快、更准确和更稳定。

对于大规模的时间序列预测任务以及闭环性能非常重要的情况,CfC可以带来巨大的价值。这是因为它们捕捉了基于ODE的网络(如LTC网络)的灵活、因果和连续时间的特性,同时效率更高。

“基于微分方程的神经网络系统很难解决,而且难以扩展到数百万乃至数十亿个参数。获得神经元如何相互作用的描述,不仅仅是阈值,而是解决细胞之间的物理动力学,这使我们能够建立更大规模的神经网络,”论文第一作者 Hasani 说到,“这个框架可以帮助解决更复杂的机器学习任务——实现更好的表示学习——并应该成为未来任何嵌入式智能系统的基本构件。”

波音公司Aurora Flight Sciences的人工智能和机器学习小组负责人Sildomar Monteirop 评价说:“最近的神经网络架构,如神经 ODE 和液态神经网络,都有由代表无限潜在状态的特定动力系统组成的隐藏层,而不是明确的层堆栈。这些隐式定义的模型显示了最先进的性能,而所需的参数比传统架构少得多。然而,由于训练和推理所需的高计算成本,它们的实际应用受到了限制。这篇论文显示了这类神经网络在计算效率方面的显著改进……并且有潜力实现与关键性安全相关的商业和国防系统的更广泛的实际应用。”

神经科学和人工智能领域的多位著名学者近日发表 NeuroAI 白皮书认为,神经科学长期以来一直是推动人工智能(AI)发展的重要驱动力,NeuroAI 领域的基础研究将推动下一代人工智能的进程。文章发表后引发热议:神经科学是否推动了人工智能?未来的人工智能是否需要神经科学?

本着促进神经科学、计算机科学、认知科学和脑科学等不同领域的学术工作者的交流与合作,集智俱乐部联合北京师范大学柳昀哲、北京大学鲍平磊和昌平实验室吕柄江三位研究员共同发起了「NeuroAI」读书会,聚焦在视觉、语言和学习领域中神经科学与人工智能的相关研究,期待能够架起神经科学与人工智能领域的合作桥梁,激发跨学科的学术火花。