人工神经网络和人脑中的语言表征与加工 | 周日直播·NeuroAI读书会

导语

神经科学和人工智能领域的多位著名学者近日发表 NeuroAI 白皮书认为,神经科学长期以来一直是推动人工智能(AI)发展的重要驱动力,NeuroAI 领域的基础研究将推动下一代人工智能的进程。文章发表后引发热议:神经科学是否推动了人工智能?未来的人工智能是否需要神经科学?

本着促进神经科学、计算机科学、认知科学和脑科学等不同领域的学术工作者的交流与合作,集智俱乐部联合北京师范大学柳昀哲、北京大学鲍平磊和昌平实验室吕柄江三位研究员共同发起了「NeuroAI」读书会,聚焦在视觉、语言和学习领域中神经科学与人工智能的相关研究,期待能够架起神经科学与人工智能领域的合作桥梁,激发跨学科的学术火花。

读书会线上进行,11月27日开始,每周日晚上19:00-21:00,持续时间预计10周。读书会详情及参与方式见后文。

分享内容简介

分享内容简介

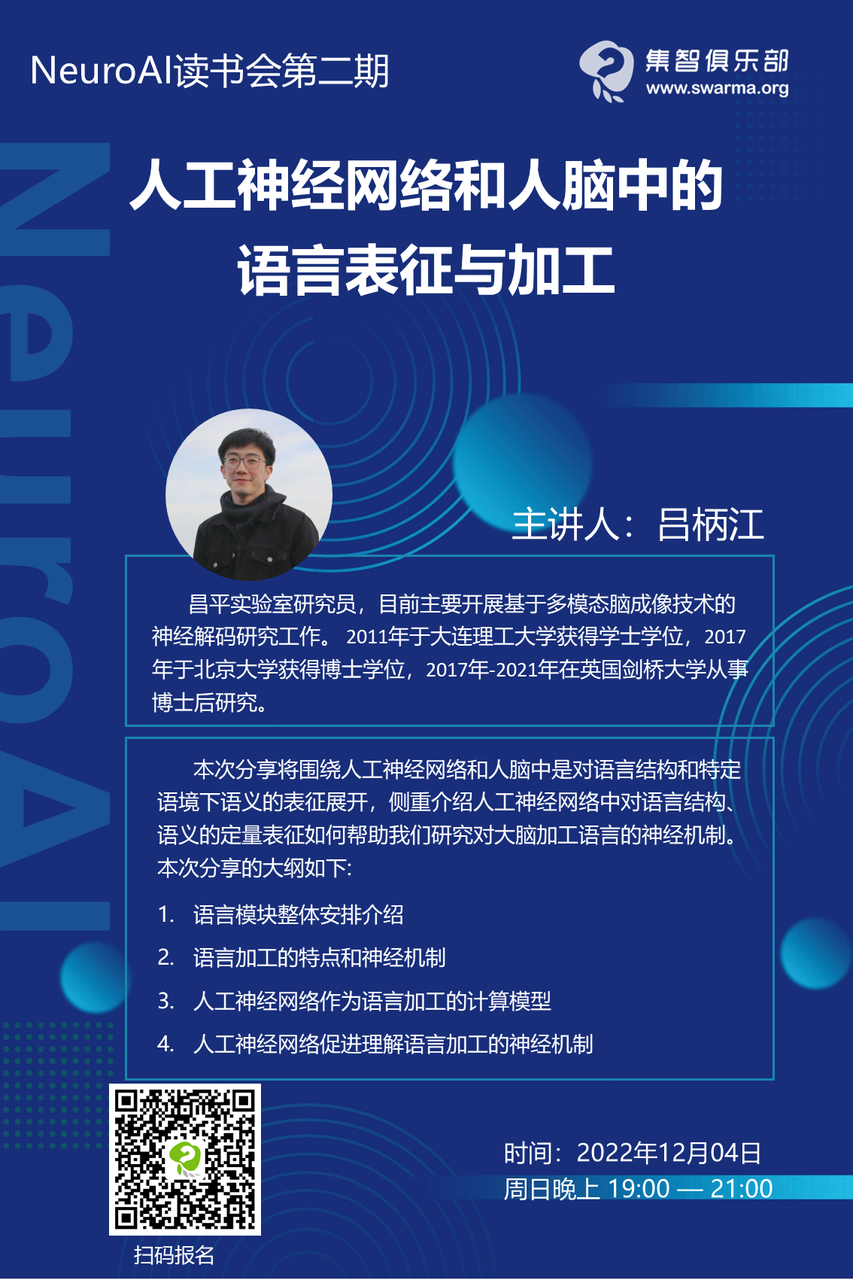

人类语言的核心是从线性排列语音或文字输入中构建结构化的表征,在具体语境和句法规则的约束下构建层级结构,将字词组合为短语,将短语合并为句子,从而理解他人的意图或表达自己的想法。本次分享将围绕人工神经网络和人脑中是对语言结构和特定语境下语义的表征展开,侧重介绍人工神经网络中对语言结构、语义的定量表征如何帮助我们研究对大脑加工语言的神经机制。

分享内容大纲

分享内容大纲

背景介绍

-

语言加工的特点

-

语言加工的神经机制

人工神经网络作为语言加工的计算模型

-

词向量表征

-

预训练语言模型中的结构信息

人工神经网络促进对语言加工神经机制的理解

-

语义合成

-

构建结构化表征

主要涉及到的知识概念

主要涉及到的知识概念

语言加工双流模型(Dual-stream model of speech processing)

认知计算神经科学(Cognitive computational neuroscience)

脑磁图/脑电图(MEG/EEG)

表征相似性分析(Representational similarity analysis)

自然语言处理(Natural language processing)

主讲人介绍

主讲人介绍

主要涉及到的参考文献

主要涉及到的参考文献

本次分享与读书会主题之间的关系

本次分享与读书会主题之间的关系

语言承载了我们的思维活动和信息传递,让不同时期人类社会的智慧结晶能够不断延续和积累。通过语言,我们能从感官信息中高效地构建和表达对外部世界认知。因此,实现语言智能或许是构建通用人工智能最为重要的里程碑。本次分享通过介绍当前人工神经网络对语言的结构、语义信息的表征,以及它们如何促进我们对大脑加工语言的理解,为语言智能模块接下来比较人工神经网络和人脑语言加工的讨论提供基本框架和背景知识。

直播信息

直播信息

时间:

NeuroAI读书会招募中

详情请见:

点击“阅读原文”,报名读书会