黄海平:神经网络的统计力学系列课程上学期结课 | 另开放20名免费名额

导语

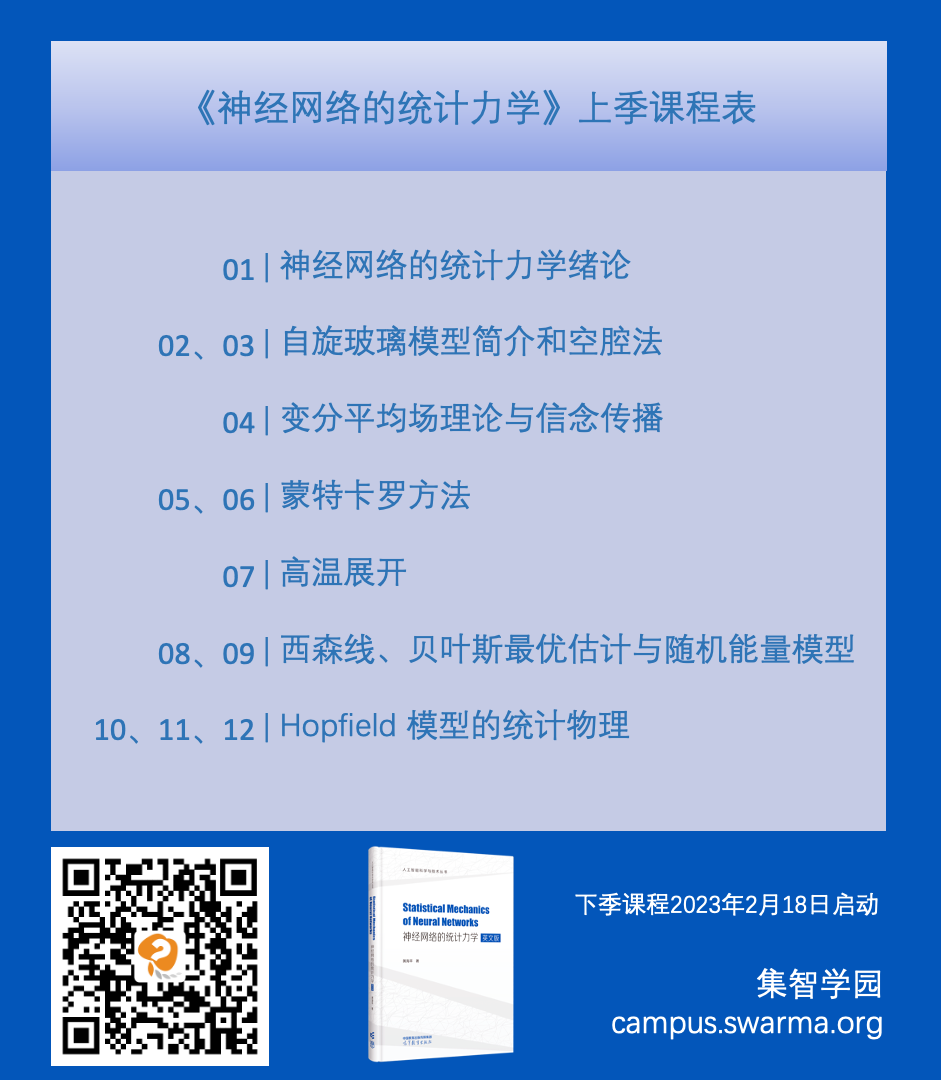

为了帮助学生学习统计力学的基本原理及其在理解神经网络内部工作原理的应用,中山大学教授、PMI Lab的黄海平老师组织了《神经网络的统计力学》在线课程,课程从2022年9月持续到2023年6月。目前上季课程从2022年9月-2022年12月,共计8章内容、12讲课程,已完整上线。欢迎扫描文中二维码报名加入学习。

下季课程将于2023年2月18日正式开始。本季将根据同学的学习情况在下一季开始前淘汰部分学员。下一季课程将开放招收20名新的正式学员,具体申请条件、流程见正文。申请截止时间为2023年2月8日,请感兴趣的同学尽快提交材料。

负责人介绍

负责人介绍

黄海平,中山大学物理学院教授。本科毕业于中山大学理工学院,博士毕业于中国科学院理论物理研究所,随后在香港科技大学物理系、东京工业大学计算智能系 (2012年获日本学术振兴会资助) 以及日本理化学研究所 (RIKEN) 脑科学中心从事统计物理与机器学习、 神经计算交叉的基础理论研究,2017年因在无监督学习方面的研究获得 RIKEN 杰出研究奖。于2018年入选中山大学百人计划,在物理学院组建了“物理、机器与智能” (PMI)研究小组,专注于各种神经计算的理论基础,长期目标是使用基于物理的近似来揭示机器及大脑智能的基本原理。曾主持国家自然科学基金青年基金、优秀青年基金等国家级项目。

本季课程回顾

本季课程回顾

第1课绪论,对课程进行概览性介绍。(对应书籍第一章)

第2、3课自旋玻璃模型简介和空腔法,包括两部分内容,第一部分会对自旋玻璃系统进行一个简单的介绍,帮助没有统计物理背景的朋友快速了解自旋玻璃模型的基本定义、解决问题的基本框架、和与现实生活中问题的对应。自旋玻璃模型是从统计物理的角度理解神经网络最为重要的桥梁之一,同时也是现代神经网络的起源,在后续的课程中会对自旋玻璃进行更详尽的介绍。第二部分会以一个信息编码中的一个例子讲解空腔方法的基本思想,具体过程和空腔方法与消息传递算法的关系及其在计算神经科学中的应用。空腔方法是复杂系统研究中一种很重要的方法,能让我们能以较低的计算代价得到系统的自由能,从而推断出系统的各种性质,在优化组合,信息编码和神经网络中都有很多应用。这节课主要了解它的基本思想,将在后续的课程里看到它在神经网络中的应用。(对应书籍第二章)

第4课变分平均场理论与信念传播,介绍了变分法及消息传递算法。构建变分自由能并引入平均场近似或Bethe近似求解体系的自由能。在考虑Bethe近似时,我们会得到计算机科学中经典的消息传递算法,通过进一步的整理发现其恰好等价于统计物理中的空腔方法。在后续的课程中,采用空腔法求解自由能时往往会先写出消息传递方程。因此,我们将通过简单的例子了解消息传递算法中每个变量的物理含义,并总结如何快速从波尔兹曼分布得到其对应的消息传递方程。最后,会简要介绍逆伊辛问题及几种逆伊辛算法。(对应书籍第三章)

第5、6课蒙特卡罗方法,在2-4课中介绍了空腔方法和变分自由能的办法来估计多体相互作用的自由能,进而得到其宏观性质,然而平衡态物理中的大部分系统是无法解析的,因此我们需要数值技巧来估计它们的性质。一种常用的数值技巧是蒙特卡罗采样方法,包括它的几种变体。事实上,除了在物理领域,蒙特卡罗采样方法在机器学习领域中也被广泛使用。例如,玻尔兹曼机中的吉布斯抽样就是在经典的蒙特卡罗方法的帮助下进行的。本讲详细介绍采样方法的基本知识及其在标准物理模型中的应用。(对应书籍第四章)

第7课高温展开,介绍了基于变分方法的高温展开技术,并学习如何通过高温展开得到TAP方程。TAP方程是自旋玻璃理论中最为重要的方程之一,在推断和学习问题中有着广泛的应用。(对应书籍第五章)

第8、9课西森线、贝叶斯最优估计与随机能量模型,介绍了自旋玻璃理论的两个精确可解模型:西森模型和随机能量模型。这两个模型在理解玻璃态扮演重要的角色,而且对于贝叶斯推断(当前深度学习理论的重要分支)和深度学习能量景观研究亦有深刻的启发。(对应书籍第六、七章)

第10、11、12课Hopfield模型的统计物理,Hopfield 模型可以建模联想记忆过程,因此对计算神经科学,乃至于现代机器学习都有很重要的意义。介绍了Hopfield模型的复本方法计算,鞍点分析,Hopfield 模型的相图,以及新模型中发现的新物理。(对应书籍第八章)

说明:课程顺序按照内容进行了调整。“西森线、贝叶斯最优估计与随机能量模型”课程内容因疫情调整了分享顺序,现在调整为合理的内容顺序。

往期回顾

书籍目录(详版):

Chapter 1: Introduction

Chapter 2: Spin Glass Models and Cavity Method

-

2.1 Multi-spin Interaction Models -

2.2 Cavity Method -

2.3 From Cavity Method to Message Passing Algorithms

Chapter 3: Variational Mean-Field Theory and Belief Propagation

-

3.1 Variational Method -

3.2 Variational Free Energy -

3.3 Mean-Field Inverse Ising Problem

Chapter 4: Monte Carlo Simulation Methods

-

4.1 Monte Carlo Method -

4.2 Importance Sampling -

4.3 Markov Chain Sampling -

4.4 Monte Carlo Simulations in Statistical Physics

Chapter 5: High-Temperature Expansion

-

5.1 Statistical Physics Setting -

5.2 High-Temperature Expansion -

5.3 Properties of the TAP Equation

Chapter 6: Nishimori Line

-

6.1 Model Setting -

6.2 Exact Result for Internal Energy -

6.3 Proof of No RSB Effects on the Nishimori Line

Chapter 7: Random Energy Model

-

7.1 Model Setting -

7.2 Phase Diagram

Chapter 8: Statistical Mechanical Theory of Hopfifield Model

-

8.1 Hopfifield Model -

8.2 Replica Method -

8.3 Phase Diagram -

8.4 Hopfifield Model with Arbitrary Hebbian Length

下季内容预告

下季内容预告

下季内容将围绕书籍第9章-17章进行介绍,在下半学期,我们将讲授现代神经网络的前沿理论,覆盖监督学习,无监督学习,深度网络降维理论,循环神经网络的动力学平均场理论,随机矩阵理论等。我们将在学习理论的同时穿插各种小项目和文献阅读,帮助学生全方位的鸟瞰神经网络理论研究的全貌。

Chapter 9: Replica Symmetry and Replica Symmetry Breaking

-

9.1 Generalized Free Energy and Complexity of States -

9.2 Applications to Constraint Satisfaction Problems -

9.3 More Steps of Replica Symmetry Breaking

Chapter 10: Statistical Mechanics of Restricted Boltzmann Machine

-

10.1 Boltzmann Machine -

10.2 Restricted Boltzmann Machine -

10.3 Free Energy Calculation -

10.4 Thermodynamic Quantities Related to Learning -

10.5 Stability Analysis -

10.6 Variational Mean-Field Theory for Training Binary RBMs

Chapter 11: Simplest Model of Unsupervised Learning with Binary

-

11.1 Model Setting -

11.2 Derivation of sMP and AMP Equations -

11.3 Replica Computation -

11.4 Phase Transitions -

11.5 Measuring the Temperature of Dataset

Chapter 12: Inherent-Symmetry Breaking in Unsupervised Learning

-

12.1 Model Setting -

12.2 Phase Diagram -

12.3 Hyper-Parameters Inference

Chapter 13: Mean-Field Theory of Ising Perceptron

-

13.1 Ising Perceptron model -

13.2 Message-Passing-Based Learning -

13.3 Replica Analysis

Chapter 14: Mean-Field Model of Multi-layered Perceptron

-

14.1 Random Active Path Model -

14.2 Mean-Field Training Algorithms -

14.3 Spike and Slab Model

Chapter 15: Mean-Field Theory of Dimension Reduction in Neural Networks

-

15.1 Mean-Field Model -

15.2 Linear Dimensionality and Correlation Strength -

15.3 Dimension Reduction with Correlated Synapses

Chapter 16: Chaos Theory of Random Recurrent Neural Networks

-

16.1 Spiking and Rate Models -

16.2 Dynamical Mean-Field Theory -

16.3 Lyapunov Exponent and Chaos -

16.4 Excitation-Inhibition Balance Theory -

16.5 Training Recurrent Neural Networks

Chapter 17: Statistical Mechanics of Random Matrices

-

17.1 Spectral Density -

17.2 Replica Method and Semi-circle Law -

17.3 Cavity Approach and Marchenko -

17.4 Spectral Densities of Random Asymmetric Matrices

正式学员申请要求与流程

正式学员申请要求与流程

从2023年2月底~6月底,本课程(下)将讲授现代神经网络的前沿理论,讨论对象包括无监督学习,监督学习,动力学平均场理论,随机矩阵理论等等(对应书上第九至十七章)。课程将穿插丰富的小项目和前沿文献阅读分享。

学习名额:本季将根据同学的学习情况在下一季开始前淘汰部分学员。下一季课程将开放招收20名新的正式学员,如果你身边有同学或朋友有感兴趣的可以推荐申请。正式学员受课程负责人黄海平老师进行严格的课程学习管理,完成课程作业、课程小项目论文等。

培养目标:培养一批有望在神经网络理论深耕的青年学者(侧重学生)

申请人要求:对书的上半部有一定程度了解并且对剖析神经网络工作机制(含计算神经科学)有强烈兴趣。

申请方法:附简历至huanghp7@mail.sysu.edu.cn

截止日期:2023年2月8日

结果通知:2023年2月13日前

申请成功学员福利:本课程会由集智学园进行免费直播,收费录播。但是经黄海平老师筛选,被成功录取的正式学员可免费获取视频录播权限。具体在确认学员名单后,会统一开通。

课程书籍介绍

课程书籍介绍

本书涵盖了用于理解神经网络原理的必要统计力学知识,包括复本方法、空腔方法、平均场近似、变分法、随机能量模型、Nishimori条件、动力学平均场理论、对称性破缺、随机矩阵理论等,同时详细描述了监督学习、无监督学习、联想记忆网络、感知器网络、随机循环网络等神经网络及其功能的物理模型以及解析理论。本书通过简洁的模型展示了神经网络原理的数学美和物理深度,并介绍了相关历史和展望未来研究的重要课题,可供对神经网络原理感兴趣的学生、研究人员以及工程师阅读参考。

课程涉及黄海平老师最新出版的书籍《Statistical Mechanics of Neural Networks》的大部分内容,目标是学习统计力学的基本原理及其在理解神经网络内部工作原理的应用。

关键词:统计力学,神经网络,机器学习,随机矩阵,非线性动力学

Statistical Mechanics of Neural Networks

本书海外版由 Springer 发行,目前可在 Amazon 平台购买。国内由高教出版社发行,预计8月中旬书籍上架,可在国内各大平台购买。

报名加入课程

报名加入课程

如果你对课程「统计力学的基本原理」内容感兴趣,但未成功申请成为正式学员,欢迎加入【神经网络的统计力学】课程!

本课程可开发票。