复本对称与破缺 | 周六直播·神经网络的统计力学课程第13讲

导语

统计物理方法是一座架起微观作用到宏观涌现的桥梁,2021年诺贝尔物理学奖得主帕里西在无序系统方面作出开创之举,他提出复本对称破缺方法解决自旋玻璃问题,这一方法也对神经网络等交叉学科产生深厚影响,激发学者对人工智能和人脑等复杂系统的进一步研究。由中山大学黄海平教授组织的【神经网络的统计力学】系列课程,系统性梳理统计力学的基本原理及其在理解神经网络内部工作原理的应用,自2022年9月持续到2023年6月,周六授课。课程视频将在集智学园网站同步,购课回看录播请扫二维码或下拉至文末报名。

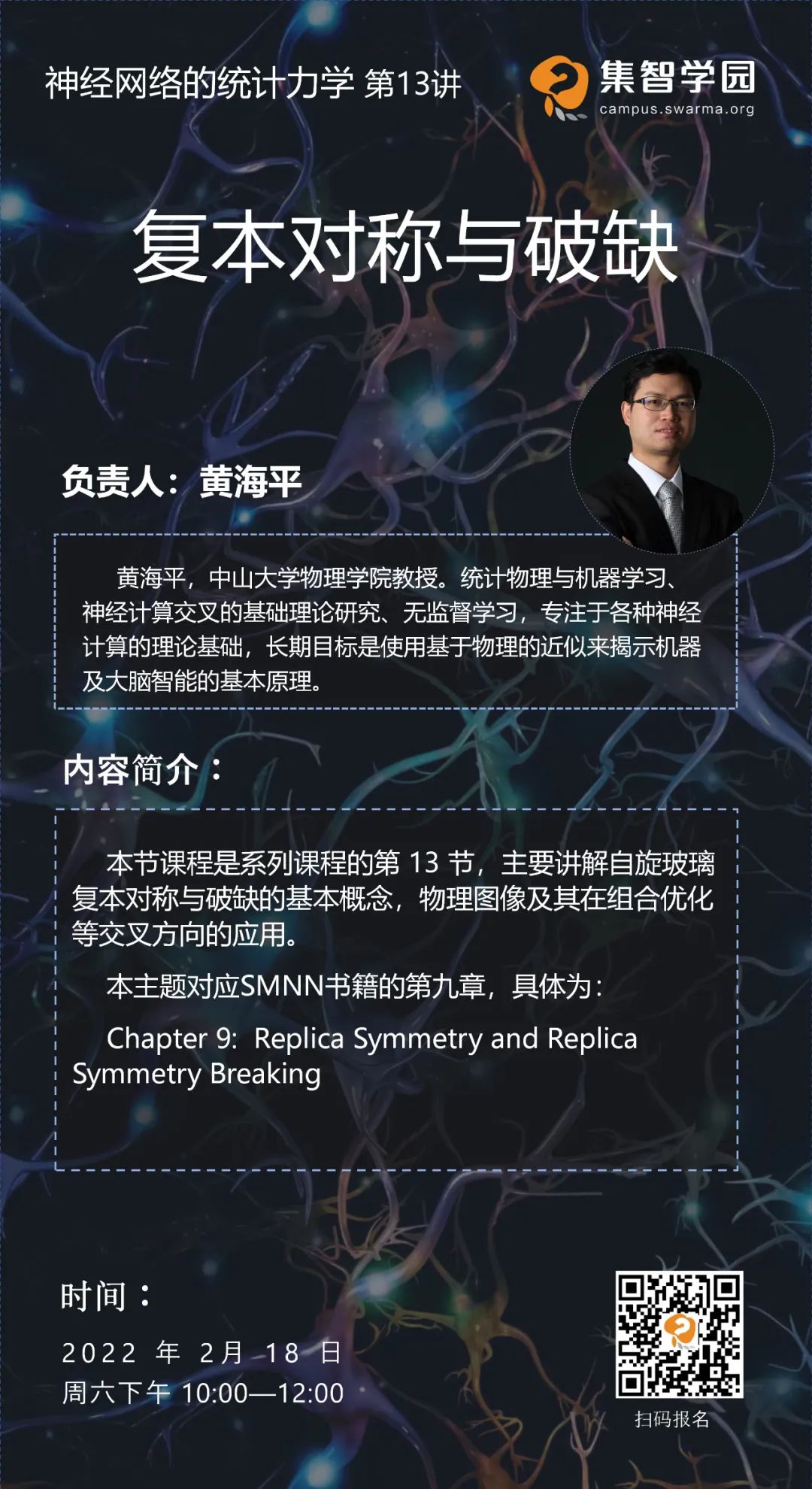

2月18日(周六)10:00-12:00 将进行系列课程的第13讲,将主要讲解自旋玻璃复本对称与破缺的基本概念,物理图像及其在组合优化等交叉方向的应用。本节课程会在集智学园视频号和B站直播,预约及付费报名方式见下文。

课程简介

课程简介

本节课程是系列课程的第 13 节,主要讲解自旋玻璃复本对称与破缺的基本概念,物理图像及其在组合优化等交叉方向的应用。

本主题对应SMNN书籍的第九章,具体为:

Chapter 9: Replica Symmetry and Replica Symmetry Breaking

-

9.1 Generalized Free Energy and Complexity of States

-

9.2 Applications to Constraint Satisfaction Problems

-

9.3 More Steps of Replica Symmetry Breaking

课程大纲

课程大纲

-

广义自由能及自旋玻璃复杂度

-

组合优化问题应用

-

高阶复本对称破缺

负责人介绍

负责人介绍

黄海平,中山大学物理学院教授。本科毕业于中山大学理工学院,博士毕业于中国科学院理论物理研究所,随后在香港科技大学物理系、东京工业大学计算智能系 (2012年获日本学术振兴会资助) 以及日本理化学研究所 (RIKEN) 脑科学中心从事统计物理与机器学习、 神经计算交叉的基础理论研究,2017年因在无监督学习方面的研究获得 RIKEN 杰出研究奖。于2018年入选中山大学百人计划,在物理学院组建了“物理、机器与智能” (PMI)研究小组,专注于各种神经计算的理论基础,长期目标是使用基于物理的近似来揭示机器及大脑智能的基本原理。曾主持国家自然科学基金两项。

直播信息

直播信息

-

集智学园视频号预约

-

集智学园 B 站免费直播,房间号 https://live.bilibili.com/6782735

参与方式二:付费加入课程,查看课程回放

付费后,可参与集智学园平台直播并加入交流群获得视频回放权限。欢迎对统计力学的基本原理感兴趣的你,加入【神经网络的统计力学】课程!

课程定价:499元

课程时间:从2023年2月18日起,每周六 10:00-12:00(节假日除外)

扫码付费报名课程

https://campus.swarma.org/course/4543

付费流程:

第一步:扫码付费

第二步:在课程详情页面,填写“学员信息登记表”

第三步:扫码添加助教微信,入群

神经网络的统计力学

每周更新,持续报名中

本学期内容介绍

系列课程大纲

-

2.1 Multi-spin Interaction Models -

2.2 Cavity Method -

2.3 From Cavity Method to Message Passing Algorithms

-

3.1 Variational Method -

3.2 Variational Free Energy -

3.3 Mean-Field Inverse Ising Problem

-

4.1 Monte Carlo Method -

4.2 Importance Sampling -

4.3 Markov Chain Sampling -

4.4 Monte Carlo Simulations in Statistical Physics

-

5.1 Statistical Physics Setting -

5.2 High-Temperature Expansion -

5.3 Properties of the TAP Equation

-

6.1 Model Setting -

6.2 Exact Result for Internal Energy -

6.3 Proof of No RSB Effects on the Nishimori Line

-

7.1 Model Setting -

7.2 Phase Diagram

-

8.1 Hopfield Model -

8.2 Replica Method -

8.3 Phase Diagram -

8.4 Hopfield Model with Arbitrary Hebbian Length

-

9.1 Generalized Free Energy and Complexity of States -

9.2 Applications to Constraint Satisfaction Problems -

9.3 More Steps of Replica Symmetry Breaking

-

10.1 Boltzmann Machine -

10.2 Restricted Boltzmann Machine -

10.3 Free Energy Calculation -

10.4 Thermodynamic Quantities Related to Learning -

10.5 Stability Analysis -

10.6 Variational Mean-Field Theory for Training Binary RBMs

-

11.1 Model Setting -

11.2 Derivation of sMP and AMP Equations -

11.3 Replica Computation -

11.4 Phase Transitions -

11.5 Measuring the Temperature of Dataset

-

12.1 Model Setting -

12.2 Phase Diagram -

12.3 Hyper-Parameters Inference

-

13.1 Ising Perceptron model -

13.2 Message-Passing-Based Learning -

13.3 Replica Analysis

-

14.1 Random Active Path Model -

14.2 Mean-Field Training Algorithms -

14.3 Spike and Slab Model

-

15.1 Mean-Field Model -

15.2 Linear Dimensionality and Correlation Strength -

15.3 Dimension Reduction with Correlated Synapses

-

16.1 Spiking and Rate Models -

16.2 Dynamical Mean-Field Theory -

16.3 Lyapunov Exponent and Chaos -

16.4 Excitation-Inhibition Balance Theory -

16.5 Training Recurrent Neural Networks

-

17.1 Spectral Density -

17.2 Replica Method and Semi-circle Law -

17.3 Cavity Approach and Marchenko -

17.4 Spectral Densities of Random Asymmetric Matrices

报名加入课程

扫码付费报名课程