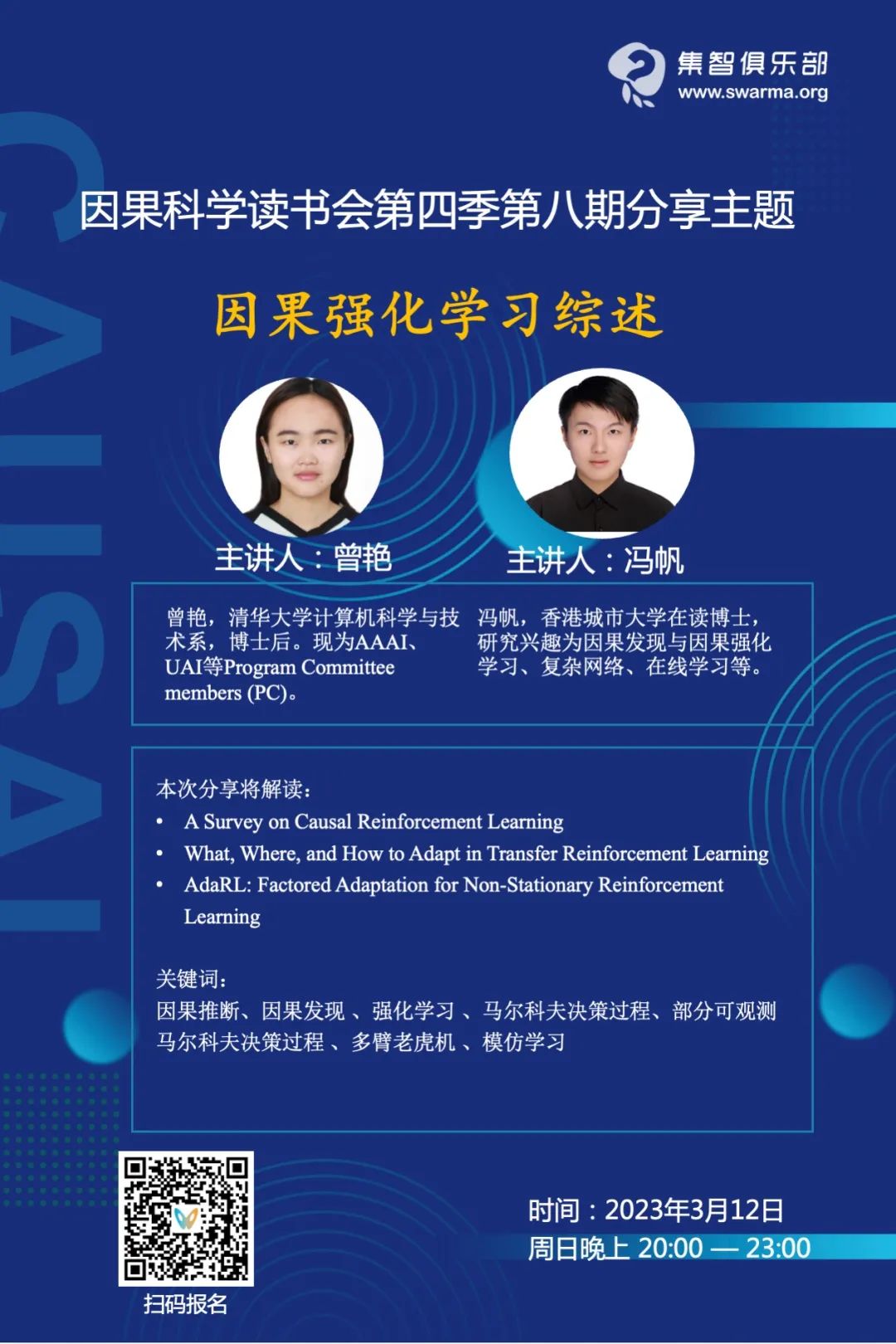

因果强化学习综述 | 周日直播·因果表征学习读书会

导语

因果科学读书会第四季主要围绕因果表征学习引论、理论基础、技术框架,以及在机器学习领域和在工业界中的具体的应用进行深度探讨,系统梳理因果表征学习领域并促进相关的研究。自2022年12月31日开始,每周六晚上20:00-22:00举办,持续时间预计 10 周。欢迎对本话题感兴趣的朋友报名参加!

分享内容简介

分享内容简介

分享简介

分享简介

• 参考文献:

分享内容大纲

分享内容大纲

-

引言 Introduction -

出发点 Motivation -

强化学习与因果的简单介绍 Brief Intro to RL and Causality -

因果强化学习 Causal RL -

总结 Summary -

基于先验因果信息的因果强化学习 CRL with prior causal information -

基于未知因果信息的因果强化学习 CRL with unknown causal information -

未来方向 Future Directions -

论文解读一 Related Publication I -

论文解读二 Related Publication II

主要涉及到的知识概念

主要涉及到的知识概念

-

因果推断 Causal Inference -

因果发现 Causal Discovery -

强化学习 Reinforcement Learning -

马尔科夫决策过程 Markov Decision Process -

部分可观测马尔科夫决策过程 Partially Observed Markov Decision Process -

多臂老虎机 Multi-Armed Bandit -

模仿学习 Imitation Learning

主持人简介

主持人简介

主要涉及到的参考文献

主要涉及到的参考文献

[1] Zeng Y, Cai R, Sun F, et al. A Survey on Causal Reinforcement Learning[J]. arXiv preprint arXiv:2302.05209, 2023.

这是一篇因果强化学习的研究综述,较全面地阐释了因果强化学习的基本问题、基础假设、技术框架、应用场景和未来可能的研究方向。

[2] B. Huang, F. Feng, C. Lu, S. Magliacane, K. Zhang. AdaRL: What, Where, and How to Adapt in Transfer Reinforcement Learning. ICLR’22.

这篇文章提出了一种高效的迁移强化学习模型,可以在目标领域中利用少量样本可靠且高效地适应跨领域的变化。该方法利用因果图对RL系统中变量之间的结构关系进行刻画。通过利用图表征去推断领域变化量和不变量之间的关系,可以将策略适应到目标领域中来实现高效的迁移强化学习。

[3] F. Feng, B. Huang, K. Zhang, S. Magliacane. Factored Adaptation for Non-Stationary Reinforcement Learning. NeurIPS’22

这篇文章提出了一种新的方法来处理强化学习中的非稳态性问题,该方法利用因果关系文献中的见解,将非稳态性建模为个体潜在变化因素和环境模型之间的因果图。该方法可以通过学习环境模型中的联合适应性,以应对环境状态状态和目标的变化。

本次分享与读书会主题之间的关系

本次分享与读书会主题之间的关系

直播信息

直播信息

因果科学读书会第四季启动

因果科学读书会第四季主要围绕因果表征学习引论、理论基础、技术框架,以及在机器学习领域和在工业界中的具体的应用进行深度探讨,系统梳理因果表征学习领域并促进相关的研究。自2022年12月31日开始,每周六晚上20:00-22:00举办,持续时间预计 10 周。欢迎对本话题感兴趣的朋友报名参加!(附第四季资源列表)