论文清单:一文梳理因果推理在自然语言处理中的应用

导语

这篇文章是由笔者根据自然语言顶级会议收录有关于因果推断的文献整理而成,内容包括论文的基本信息以及阅读笔记。

肖之仪(北京邮电大学) | 作者

邓一雪 | 编辑

1. 他山之石

1. 他山之石

2. 因果工具

2. 因果工具

3. 数据集

3. 数据集

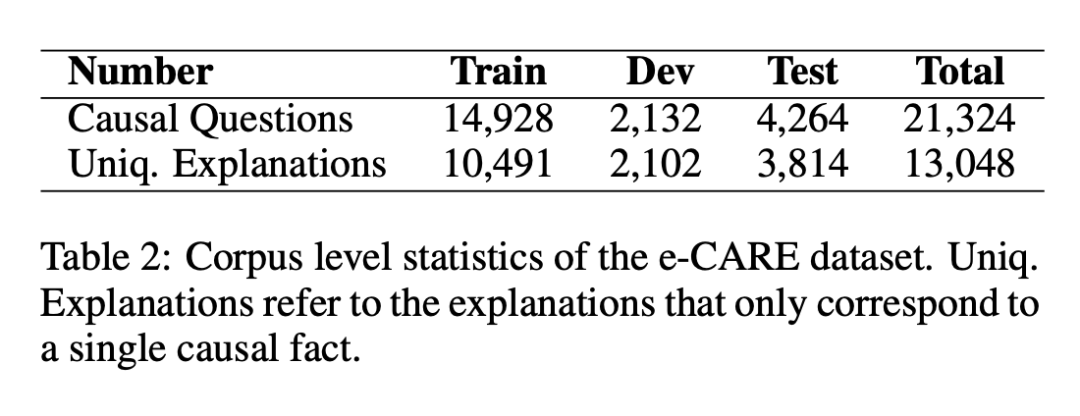

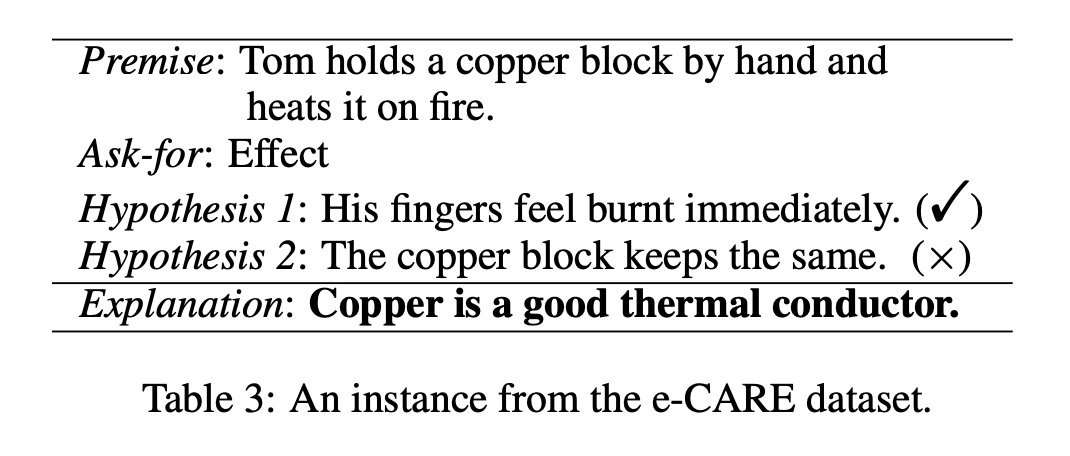

e-CARE: a New Dataset for Exploring Explainable Causal Reasoning https://arxiv.org/abs/2205.05849 https://github.com/waste-wood/e-care

4. 综述类文章

4. 综述类文章

A Review of Dataset and Labeling Methods for Causality Extraction https://aclanthology.org/2020.coling-main.133

文献贡献总结如下:

1. 总结了因果关系的关系的概念并介绍了现有因果关系挖掘的工作;

2. 针对现有因果关系实验数据的缺陷和不足,对公开可用的数据集进行了总结,并从多个方面进行了分析;

3. 对现有针对序列标记的因果研究方法(the causal research method of sequence labeling)进行了全面的总结和分析。

Causal Inference in Natural Language Processing: Estimation, Prediction, Interpretation and Beyond https://arxiv.org/abs/2109.00725

文献概述如下:

1. 不同类型的因果推理问题及其挑战;

2. 面向文本数据和 NLP 方法所独有的统计和因果挑战;

5. 在NLP任务建模中融合因果关系

5. 在NLP任务建模中融合因果关系

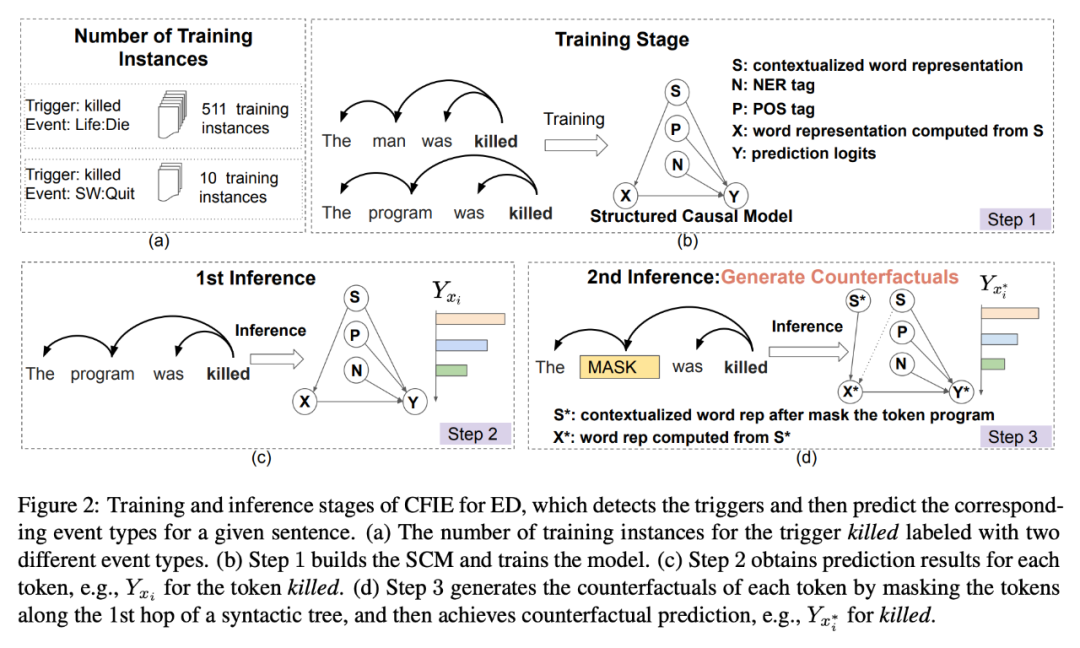

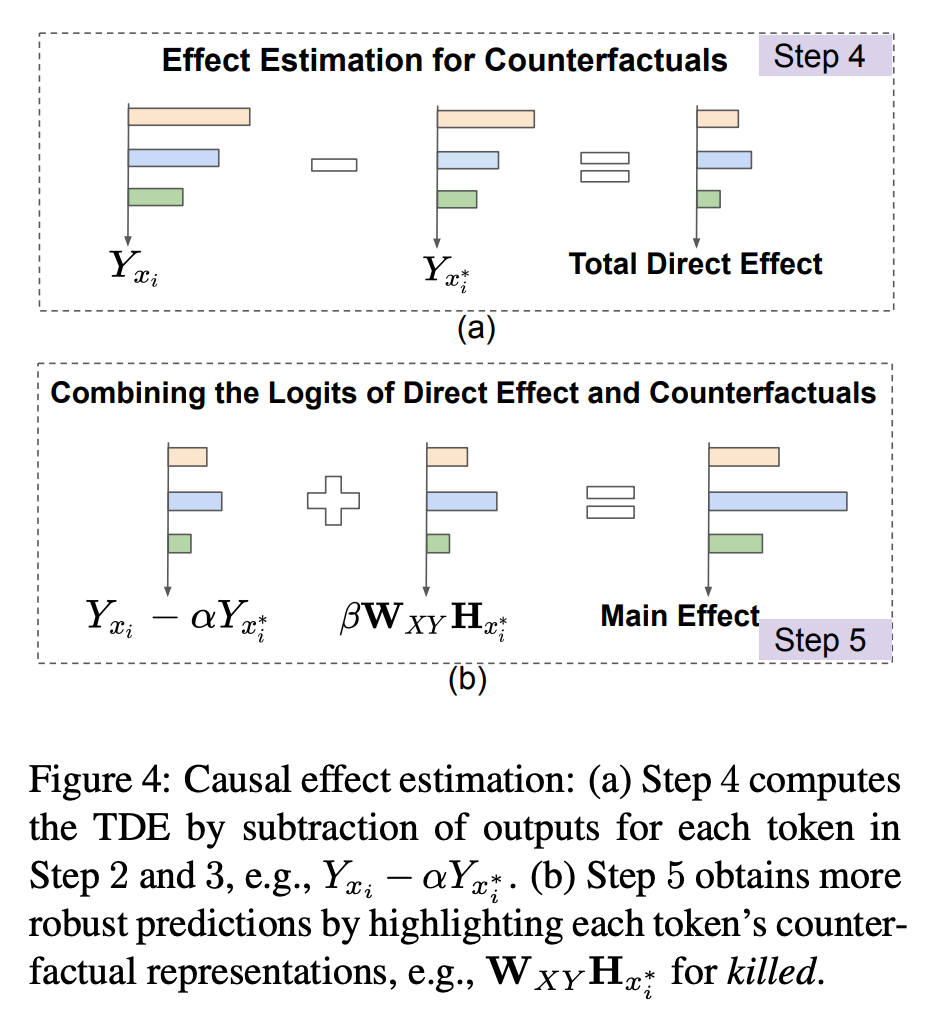

Uncovering Main Causalities for Long-tailed Information Extraction (EMNLP 2021) 场景:Information Extraction 问题:由数据集的选择偏移带来的长尾分布可能会对数据集产生不正确的关联关系 https://arxiv.org/abs/2109.05213 https://github.com/HeyyyyyyG/CFIE

本文献提出的 CFIE 拟解决上述问题,具体贡献如下:

1. 对多种信息抽取任务(RE,NER 和 ED)构建统一的结构因果模型(structural causal model)并描述不同变量之间的因果关系;

2. 基于上述的结构因果模型,使用相应的语言结构生成反事实样本,以此在推理阶段更好的计算直接因果效应(direct causal effect);

CFIE 的模型设计如上图所示,分成如下五个步骤:

1. 构造 SCM 并训练模型;

2. 预测每个 token 结果;

3. 沿着 1st hop 语法书给 token 加上 mask 以此生成反事实的样本;

4. 计算 Total Direct Effect;

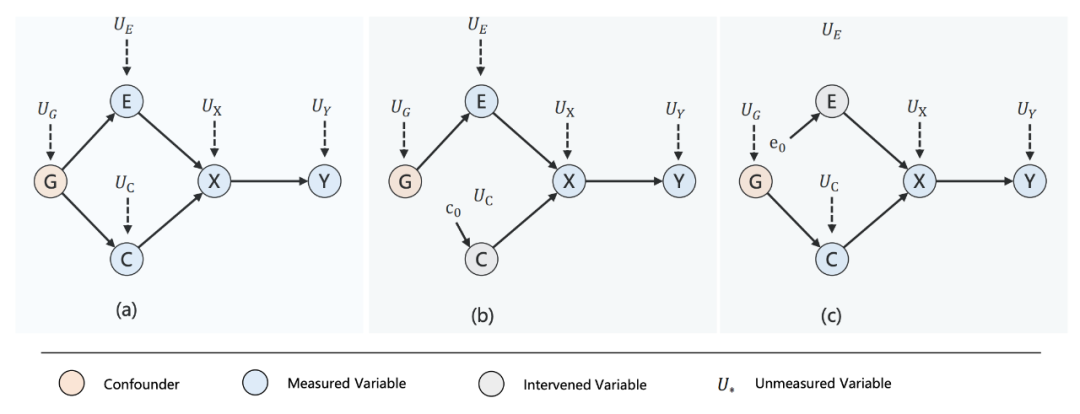

Counterfactual Generator: A Weakly-Supervised Method for Named Entity Recognition (EMNLP 2020) 场景:命名实体识别 问题:命名实体识别的数据标注是一项劳动密集性、耗时且昂贵的任务且「实体」的上下文本和实体之间有许多可疑的关联关系 https://aclanthology.org/2020.emnlp-main.590.pdf https://github.com/xijiz/cfgen

论文主要贡献如下:

1. 基于因果关系的视角描述了 NER 模型推断机制的理论基础,研究了模型输入特征与输出标签之间存在的可疑的关联关系;

Structural Causal Models (SCMs) that describes the mechanism of the NER model inference.

An example of the workflow of the Counterfactual Generator on the medical dataset.

论文中的模型的流程如上图所示,分成三个步骤:

1. 从已有的本地数据中抽出实体集合;

2. 从实体集合中选取与待干预样本实体相同类别的实体进行替换从而生成反事实样本;

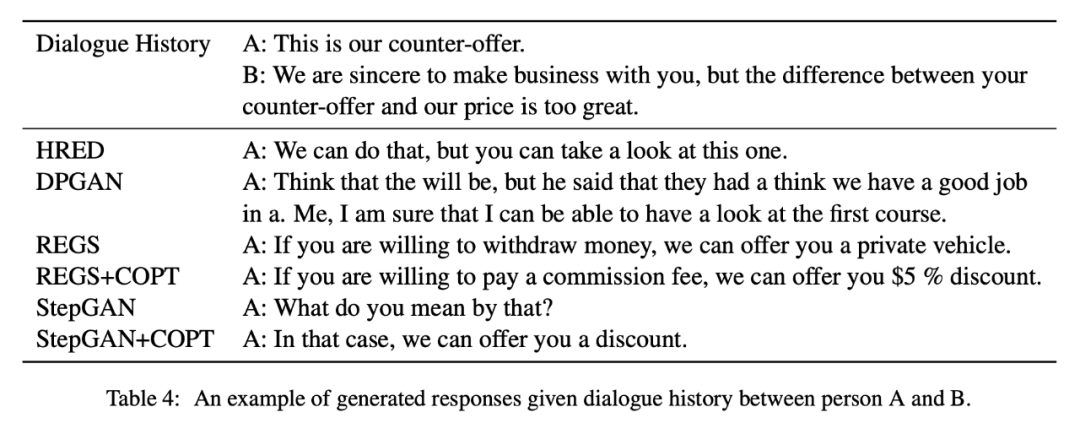

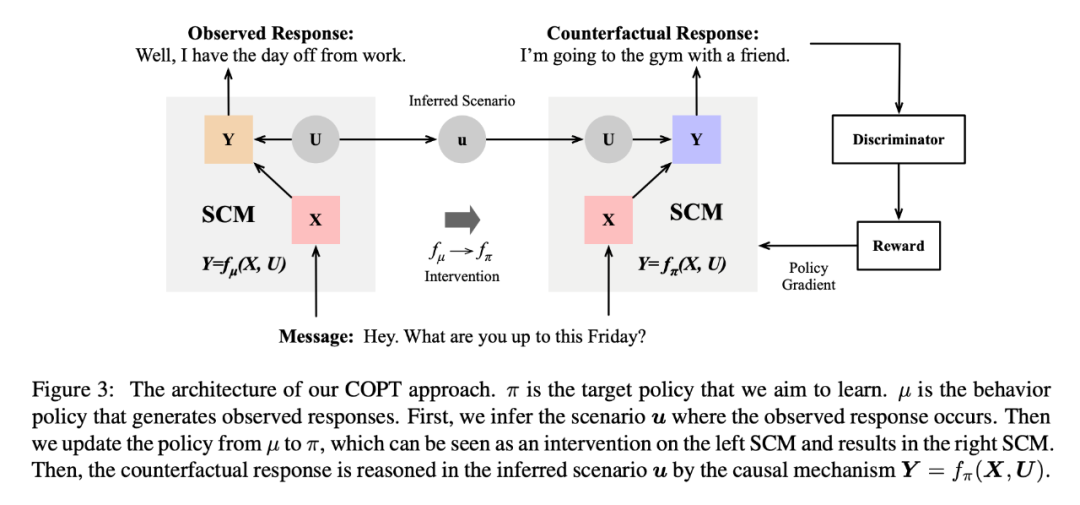

Counterfactual Off-Policy Training for Neural Dialogue Generation (EMNLP 2020) 场景:开放域对话生成 问题:由于潜在可能的回应数量过于庞大,开放域对话生成往往处于数据集不足的问题。 https://arxiv.org/abs/2004.14507

论文主要贡献如下:

1. 以「结构因果模型」对「对话生成模型」建模,从而在「对话生成模型」中融合「反事实推理」;

2. 论文中提出的模型所生成的反事实回应相较于其他标准的基于对抗学习从头开始生成的回应的质量要高得多;

An example of generated responses given dialogue history between person A and B.

文中提出的「counterfactual off-policy training (COPT) approach」步骤如下:

1. 构造生成式对话模型的 SCM,将其描述为两个组成部分即——场景(scenarios)和因果机制(causal mechanisms);

2. 给出观测回复数据中推断的场景,COPT 将场景(scenario)以及对话历史(dialogue history)根据 SCM 生成相应的反事实回复;

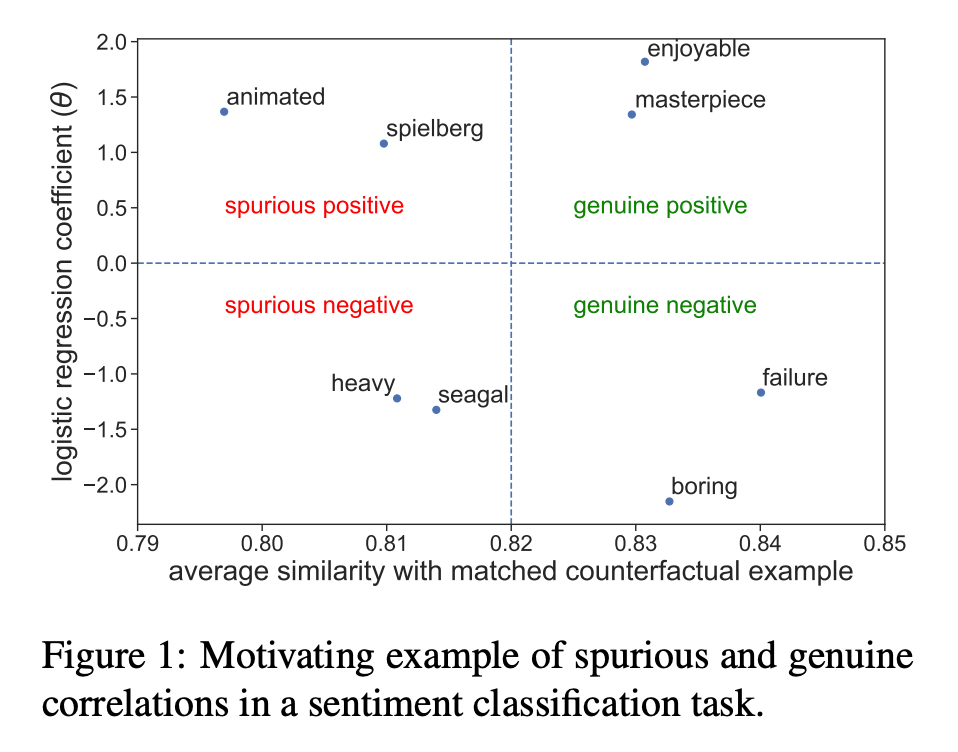

Identifying Spurious Correlations for Robust Text Classification (EMNLP Findings 2020) 场景:文本分类 问题:文本分类器通常依赖于可疑的关联关系,通常这部分关系不会影响模型最终的准确性,因为关联关系同时出现在训练集和测试集中。但在测试集和训练集分布不同(dataset shift) 和 训练测试集只在小部分样本(algorithmic fairness)的情况下会影响模型准确性。 https://aclanthology.org/2020.findings-emnlp.308 https://github.com/tapilab/emnlp-2020-spurious

Motivating example of spurious and genuine correlations in a sentiment classification task.

因此,本文提出了一个监督文本分类方法旨在认出文本分类中的伪相关性和真相关性,文章提出的方法如下:

1. 用原始数据集训练分类器 f;

2. 从分类器 f 中提取出与每个类别强相关的若干个词汇;

3. 对前序步骤提取出来的每个词汇计算其真实或可疑的可能值;

4. 对第二步产生词汇的子集进行人工标注,并训练成词汇分类器 h;

6. 对语言模型进行因果分析

6. 对语言模型进行因果分析

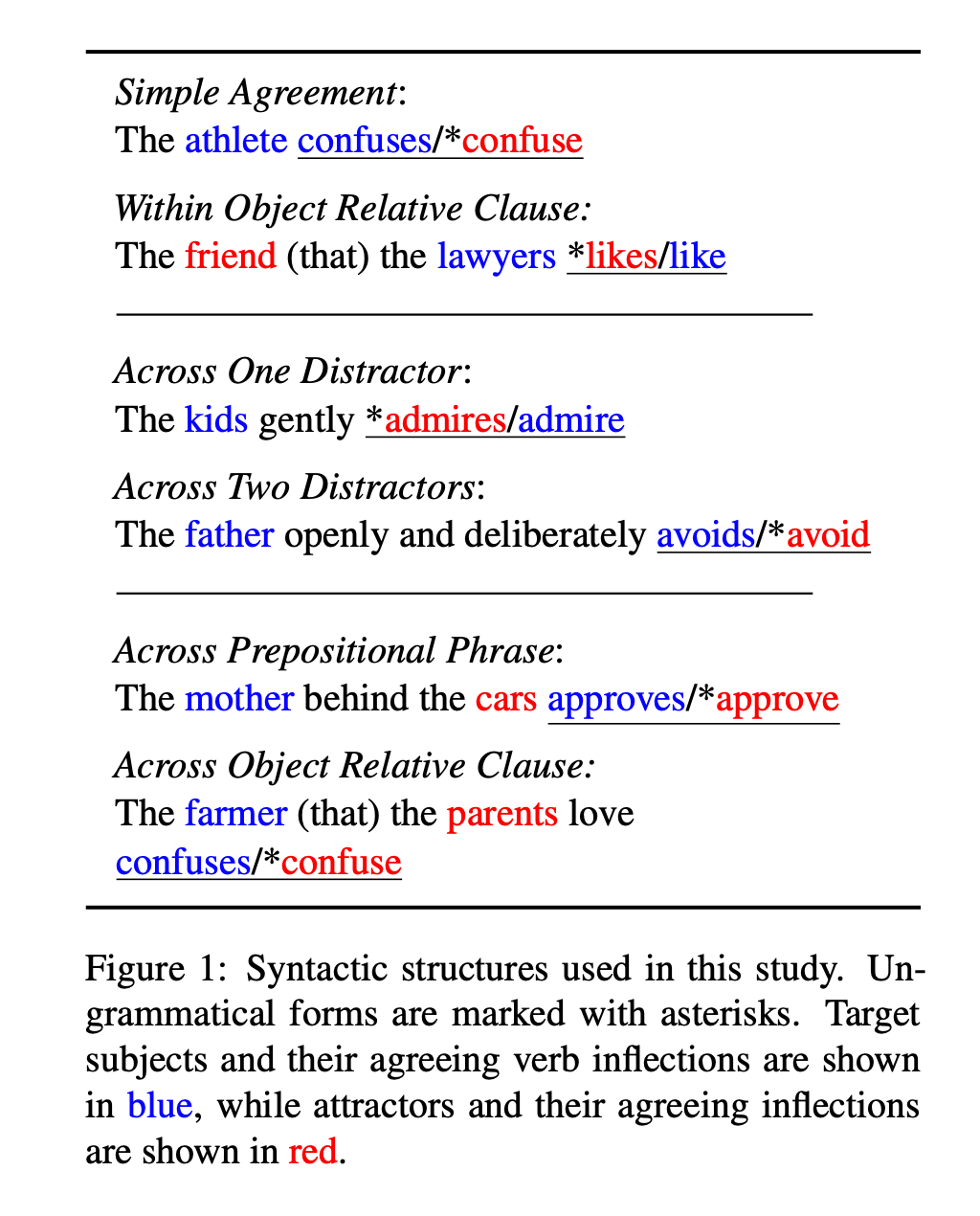

Causal Analysis of Syntactic Agreement Mechanisms in Neural Language Models (ACL 2021) 场景:Syntactic Agreement Mechanisms https://arxiv.org/abs/2106.06087 https://github.com/mattf1n/lm-intervention

7. 因果关系挖掘

7. 因果关系挖掘

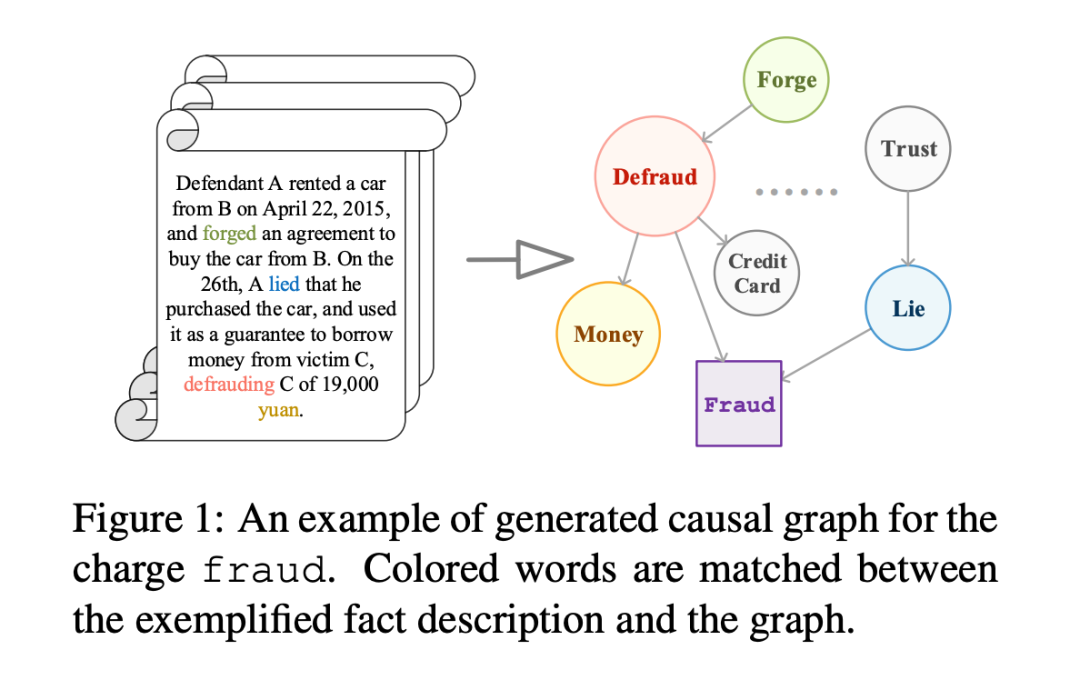

Everything Has a Cause: Leveraging Causal Inference in Legal Text Analysis (NAACL 2021) 场景:法律文本分析(Legal Text Analysis) 问题:现有的因果推断研究大多关注结构化数据,在类似法律文本这样的非结构化数据较少被关注。 https://arxiv.org/abs/2104.09420 https://github.com/xxxiaol/GCI/

一言以蔽之,文献的主要贡献如下所示:

1. 文献提出了一个新的基于图的因果推断框架,可以自动地对非结构化数据进行因果推断;

2. 文献将 GCI 框架所得出的因果知识与神经网络相结合;

Two ways of integrating causal analysis and neural networks.

8. 因果常识推理及其生成

8. 因果常识推理及其生成

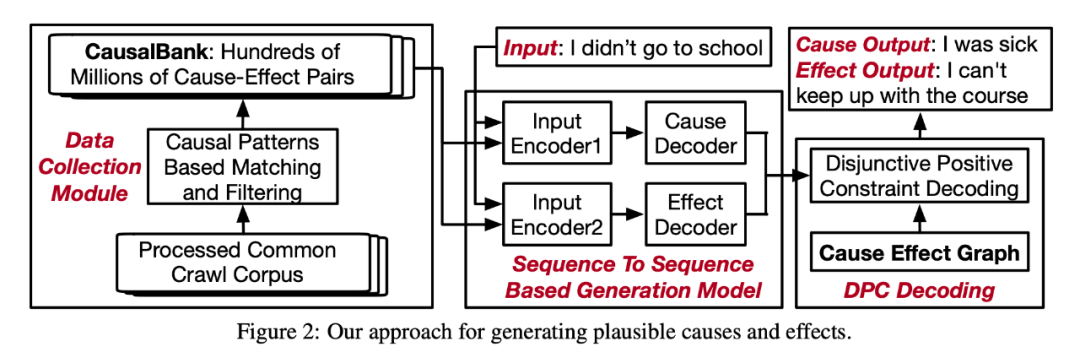

Guided Generation of Cause and Effect (IJCAI 2020) 场景:文本生成 问题:对于各种人工智能任务来说,因果知识的习得至关重要,例如:因果图的构建、阅读理解和事件预测。 https://arxiv.org/abs/2107.09846 https://github.com/eecrazy/CausalBank

论文作出如下贡献:

1. 提出了开放式因果生成的任务:对任意格式的文本生产出其可能的原因与结果;

2. 构造了因果数据集 CausalBank,其包含有 3.14 亿个因果对(cause-effect pairs);

Possible causes and effects generated by our model, conditioned on the input sentence “babies cry”.

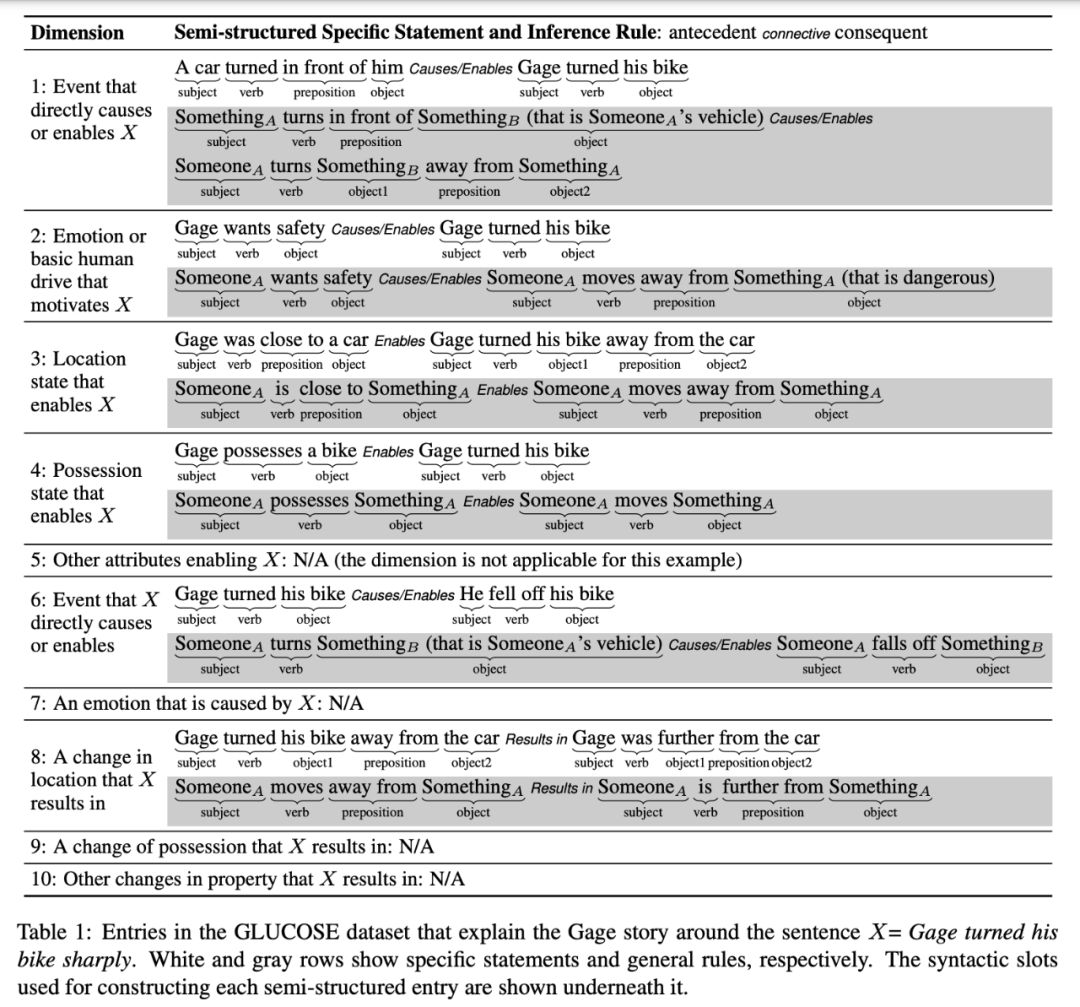

GLUCOSE: GeneraLized and COntextualized Story Explanations (EMNLP 2020) 场景:常识推理 问题:AI 系统能无法拥有常识推理的能力是因为有两个瓶颈:一是很难大规模的获得常识数据集,二是如何将常识融合至现有 AI 系统。 https://arxiv.org/abs/2009.07758 https://github.com/ElementalCognition/glucose/

Entries in the GLUCOSE dataset that explain the Gage story around the sentence X= Gage turned his bike sharply.

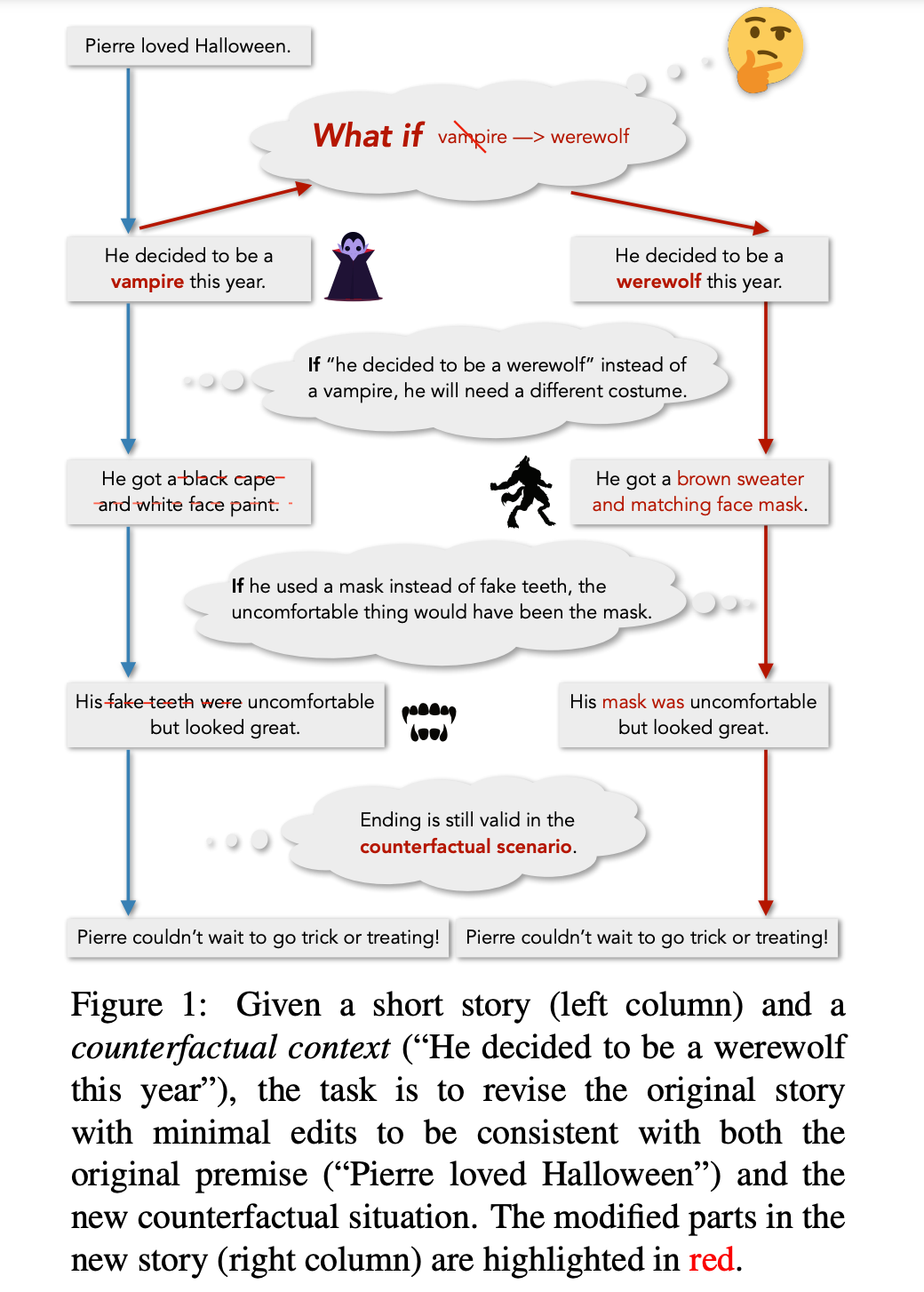

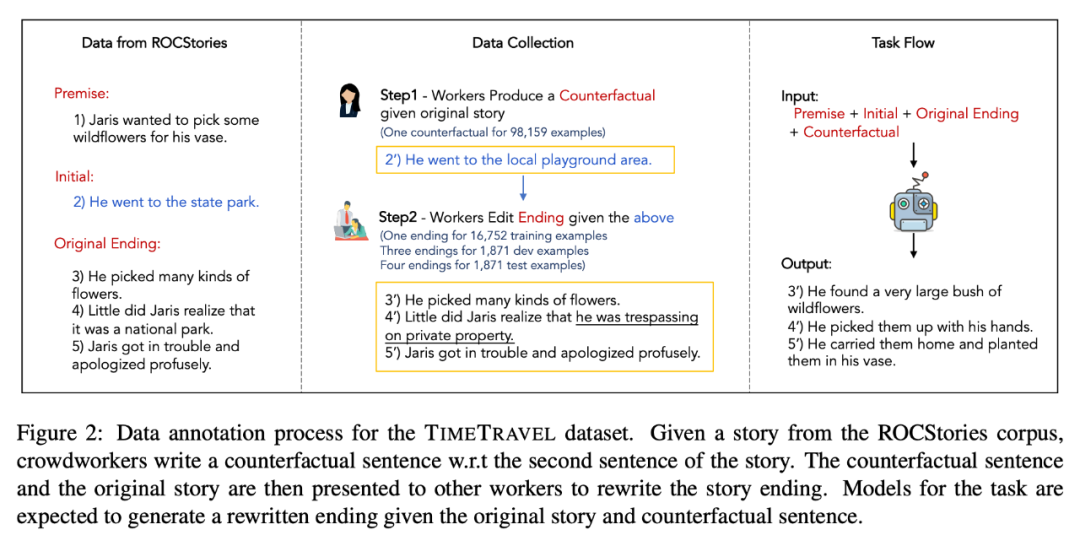

Counterfactual Story Reasoning and Generation (EMNLP 2019) 场景:反事实推理 问题:对于 AI 完备的系统来说,拥有反事实推理能力是一个充要条件,即当实际发生的事情改变时,模型能给出相应的结果。 https://arxiv.org/abs/1909.04076 https://github.com/qkaren/Counterfactual-StoryRW

参考文献

(参考文献可上下滑动查看)

因果表征学习读书会启动

随着“因果革命”在人工智能与大数据领域徐徐展开,作为连接因果科学与深度学习桥梁的因果表征学习,成为备受关注的前沿方向。以往的深度表征学习在数据降维中保留信息并过滤噪音,新兴的因果科学则形成了因果推理与发现的一系列方法。随着二者结合,因果表征学习有望催生更强大的新一代AI。

集智俱乐部组织以“因果表征学习”为主题、为期十周的读书会,聚焦因果科学相关问题,共学共研相关文献。欢迎从事因果科学、人工智能与复杂系统等相关研究领域,或对因果表征学习的理论与应用感兴趣的各界朋友报名参与。集智俱乐部已经组织三季“因果科学”读书会,形成了超过千人的因果科学社区,因果表征学习读书会是其第四季,现在加入读书会即可参与因果社区各类线上线下交流合作。

后ChatGPT读书会招募中

2022年11月30日,一个现象级应用程序诞生于互联网,这就是OpenAI开发的ChatGPT。从问答到写程序,从提取摘要到论文写作,ChatGPT展现出了多样化的通用智能。于是,微软、谷歌、百度、阿里、讯飞,互联网大佬们纷纷摩拳擦掌准备入场……但是,请先冷静一下…… 现在 all in 大语言模型是否真的合适?要知道,ChatGPT的背后其实就是深度学习+大数据+大模型,而这些要素早在5年前的AlphaGo时期就已经开始火热了。5年前没有抓住机遇,现在又凭什么可以搭上大语言模型这趟列车呢?

集智俱乐部特别组织“后 ChatGPT”读书会,由北师大教授、集智俱乐部创始人张江老师联合肖达、李嫣然、崔鹏、侯月源、钟翰廷、卢燚等多位老师共同发起,旨在系统性地梳理ChatGPT技术,并发现其弱点与短板。本系列读书会线上进行,2023年3月3日开始,每周五晚 19:00-21:00,欢迎报名交流。

推荐阅读