圆桌探讨:大语言模型与科学的双向奔赴 | AI+Science × 后chatGPT读书会联动

导语

什么是LLM+Science?大模型对科学发现和科学研究有什么启发?如何基于大模型开展Science领域的工作?哪些是潜在可能瓶颈以及中期解决方案?麻省理工大学在读博士刘子鸣同学将介绍他们最新的工作,用“知识量子”的想法来解释神经标度律,与此同时,刘子鸣同学也发起了一个圆桌讨论,邀请了来自加州大学圣地亚哥分校的助理教授尤亦庄、复旦大学计算机系副教授马兴军、集智科学家,后chatGPT读书会发起人之一李嫣然、斯坦福大学计算机科学系博士后研究员吴泰霖,希望来讨论LLM与Science之间在结合过程中的问题和挑战。本次分享也是集智俱乐部AI+Science读书会与“后chatGPT”读书会的一次梦幻联动,在两个社区会同步分享。

AI+Science 是近年兴起的将人工智能和科学相结合的一种趋势。集智俱乐部联合斯坦福大学计算机科学系博士后研究员吴泰霖(Jure Leskovec 教授指导)、哈佛量子计划研究员扈鸿业、麻省理工学院物理系博士生刘子鸣(Max Tegmark 教授指导),共同发起以“AI+Science”为主题的读书会,从2023年3月26日开始,每周日早上 9:00-11:00 线上举行,持续时间预计10周。欢迎对探索这个激动人心的前沿领域有兴趣的朋友报名参与。

简介

简介

人工智能 (AI) 一直在开发和改进大型语言模型 (LLM),这些模型在各种领域和任务中展现出卓越的能力,挑战我们对学习和认知的理解。除了对语言的掌握之外,GPT-4 还可以解决跨越数学、编码、视觉、医学、法律、心理学等,无需任何特殊提示。此外,在所有这些任务中,GPT-4 的性能都非常接近人类水平,并且常常大大超过 ChatGPT 等先前的模型。产生科学假设和研究想法的过程是一项复杂而耗时的任务,需要创造力、批判性思维和对该领域的透彻理解。通过使用LLM,科学家可以访问庞大的知识库并以更快的速度产生新的想法,从而有可能带来新的突破和发现。

(3)神经标度律对AI+Science的启发。

在第二部分,我将着重介绍我最近参与的一项工作,用“知识量子”的想法来解释神经标度律。

分享大纲

分享大纲

(1) 标度律简单介绍:

等等。

(2) 神经标度律:

(b)离散量子理论(我参与的工作)

讨论的问题列表

讨论的问题列表

(5) 随着更先进的AGI出现,如何监管AI以保证结果可信。

直播信息

直播信息

参与方式:

主讲人简介

主讲人简介

刘子鸣,目前是麻省理工学院(MIT)物理系博士生,导师是Max Tegmark。此前2020年他从北京大学获得物理学士学位。他的研究兴趣在AI和物理的交叉:一方面AI for Physics,利用AI工具自动化物理规律和概念的发现;另一方面Physics for AI,利用物理启发构建AI理论和更具可解释性的模型。

个人主页:https://kindxiaoming.github.io/

参考文献:

https://arxiv.org/abs/2303.12712 ”Sparks of Artificial General Intelligence: Early experiments with GPT-4”

圆桌嘉宾

圆桌嘉宾

尤亦庄,加利福尼亚大学圣迭戈分校助理教授。研究领域为理论凝聚态物理,强关联系统,量子拓扑物态,多体局域化与热化,纠缠,张量网络,以及全息原理与机器学习。

个人网页:https://everettyou.github.io/

马兴军,复旦大学计算机科学系副教授,复旦视觉与学习实验室成员,墨尔本大学的荣誉研究员。主要研究领域包括可信机器学习,旨在为各种人工智能应用开发安全、健壮、可解释、保护隐私和公平的机器学习模型。

个人主页:http://xingjunma.com/

李嫣然,集智学园讲师、集智俱乐部核心成员。曾任小米人工智能实验室高级算法工程师及场景对话团队研发负责人,同时也兼任着北京大学心理与认知学院的行业导师。其多年担任 AAAI,ACL,EMNLP等国际顶级会议的审稿人,并担任 EMNLP 2022 领域主席。其曾在国际顶级会议及期刊上发表论文二十余篇,涵盖情感计算、人机对话、自然语言生成等研究领域,谷歌学术累计引用逾2000次。

集智斑图个人主页:https://pattern.swarma.org/user/39

吴泰霖,斯坦福大学计算机科学系的博士后研究员,由Jure Leskovec教授指导。他的研究兴趣为AI+Science,包括开发机器学习方法用于大规模科学和工程模拟,开发神经符号方法用于科学发现,以及由科学问题启发的表示学习(运用图神经网络、信息理论和物理等方法)。

个人主页:https://tailin.org/

背景介绍

背景介绍

什么是神经标度律?

神经标度律是大脑神经元数量与连接方式的变化会随着动物体型的增大或减小而发生调整,以维持相对稳定的神经系统功能。神经标度律对于研究大脑结构和功能的演化以及神经系统的可塑性具有重要的意义。

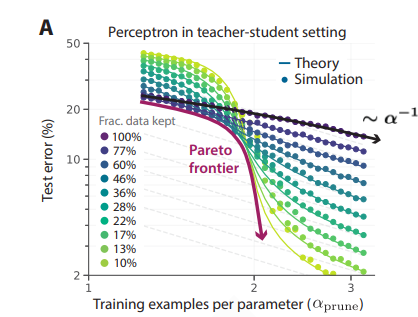

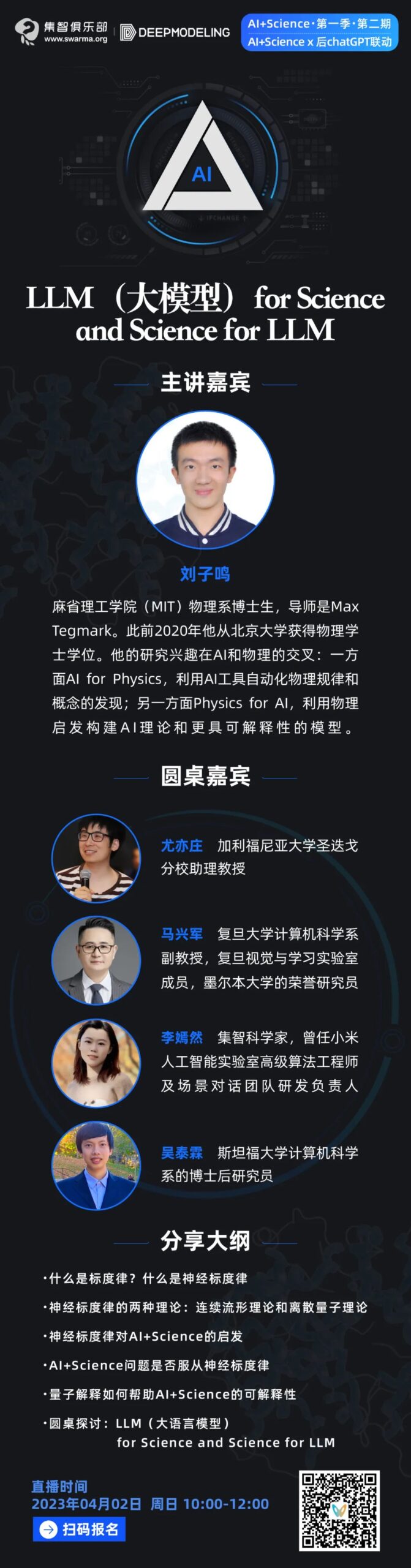

(图片来源:Scaling Laws for Neural Language Models)

为什么需要研究和理解自然语言系统(NLP)?

语言和文字的出现使得人类能够思考、想象和构建未来。机器学习和人工智能能够帮助人们做数据分析、提升模拟速度以及在各种应用上实现很好的效果。然而,一个几乎还没有被探索的问题是:能否用大语言模型来加深我们对于物理的理解,就如同物理学家那样?未来,人工智能的爆发点基于对语言文字系统的认知、解构和重组,超越人类智能获得新的突破。

神经标度律对人工智能和科学有何影响?

随着人工神经网络(ANN)规模的增加,神经标度律的性能将趋于平稳或下降,这限制了它们处理更复杂任务的能力。科学家需要考虑其他方法,例如开发将人工智能技术与传统科学方法相结合的混合系统,以获得更好的结果。利用幂律缩放的特性,我们可以在不增加计算资源的情况下提高神经网络的性能,在图像分类、神经机器翻译和语言建模等领域具有广泛的应用。在未来,物理知识将强化人工智能的能力,同时提高其可解释性,从而提加深我们对物理规律的理解。

推荐阅读资料

推荐阅读资料

集智推文:

Science Advances前沿:睡眠和体型大小之间的幂律法则

课程推荐:

为了帮助大家更多的了解幂律等特性,给大家推荐由北京师范大学教授陈清华老师所准备的复杂系统入门必修课–复杂系统中的幂律分布,本课程结合实际数据和丰富的学术文献,展示幂律分布其特征和意义,以及如何应用,为大家打造了体系完整的幂律分布学习框架!

https://campus.swarma.org/mobile/course/647?from=wechat

“后ChatGPT”读书会启动

AI+Science 读书会启动

点击“阅读原文”,报名读书会