量子神经网络的过参数化理论与临界相变 | Nature Computational Science 速递

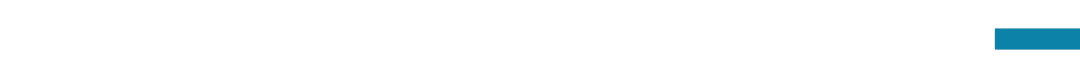

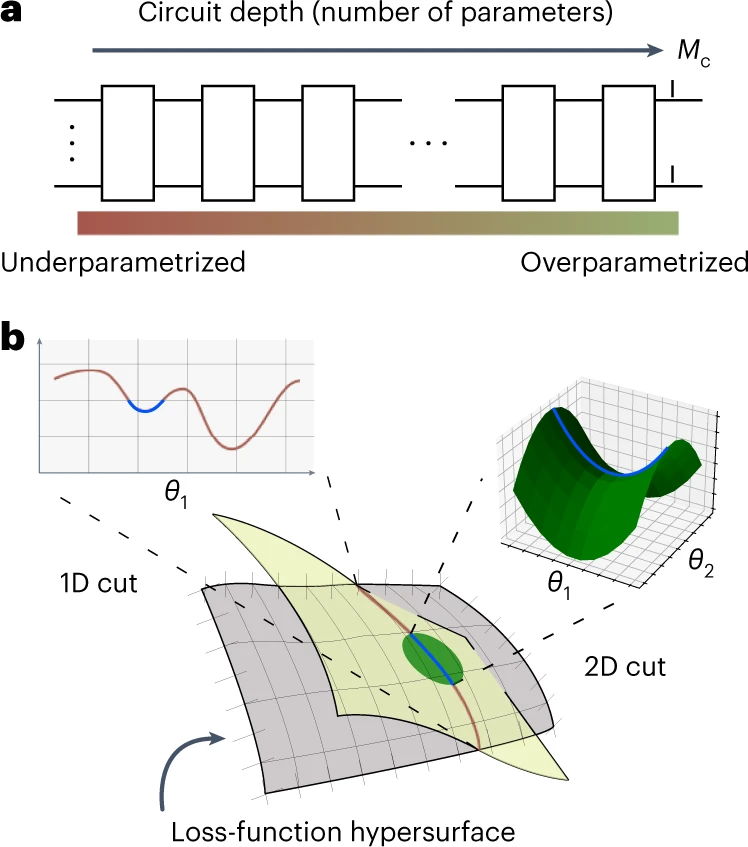

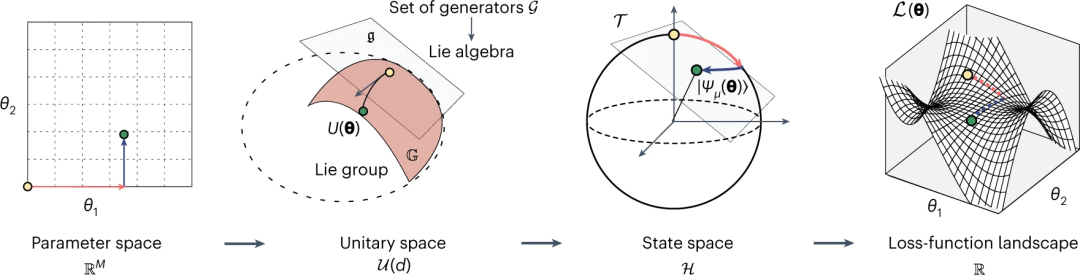

关键词:量子神经网络,过参数化现象,临界相变,信息论,计算复杂性

论文题目:Theory of overparametrization in quantum neural networks 期刊来源:Nature Computational Science 斑图链接:https://pattern.swarma.org/paper/ba7fb5e4-1477-11ee-9f2e-0242ac17000d

AI+Science 读书会

推荐阅读