关键词:社会观点极化,虚假信息传播,机器学习,时序信息流,回声室效应

论文题目:How do social media feed algorithms affect attitudes and behavior in an election campaign?

斑图地址:https://pattern.swarma.org/paper/becb28fc-2cd4-11ee-a849-0242ac17000d

论文地址:https://www.science.org/doi/full/10.1126/science.abp9364

社交媒体公司所使用的机器学习算法,对于公开选举有着各种各样潜在影响,例如创造政治话题的“过滤气泡”,促进了社会观点极化,加剧了现有的社会不平等,并促使虚假信息传播。社交媒体公司的算法整体上是保密不透明的,因此对其工作方式及产生的效果,存在各种民间假设,对其真实影响也存在诸多分歧。算法效应以往研究中往往把社交媒体作为一个“整体”分析,既包括算法,也包括个体选择、人际网络等,算法效应很少被独立拆分研究。因此了解算法系统如何影响社交网络中关键个体的政治态度和行为,在科研和实践中都有重大意义。另一方,反馈排序等机器学习算法,针对多因素进行个性化设计,并且夹杂A/B测试等不同条件,因此评估算法影响在技术上具有相当大的挑战性。

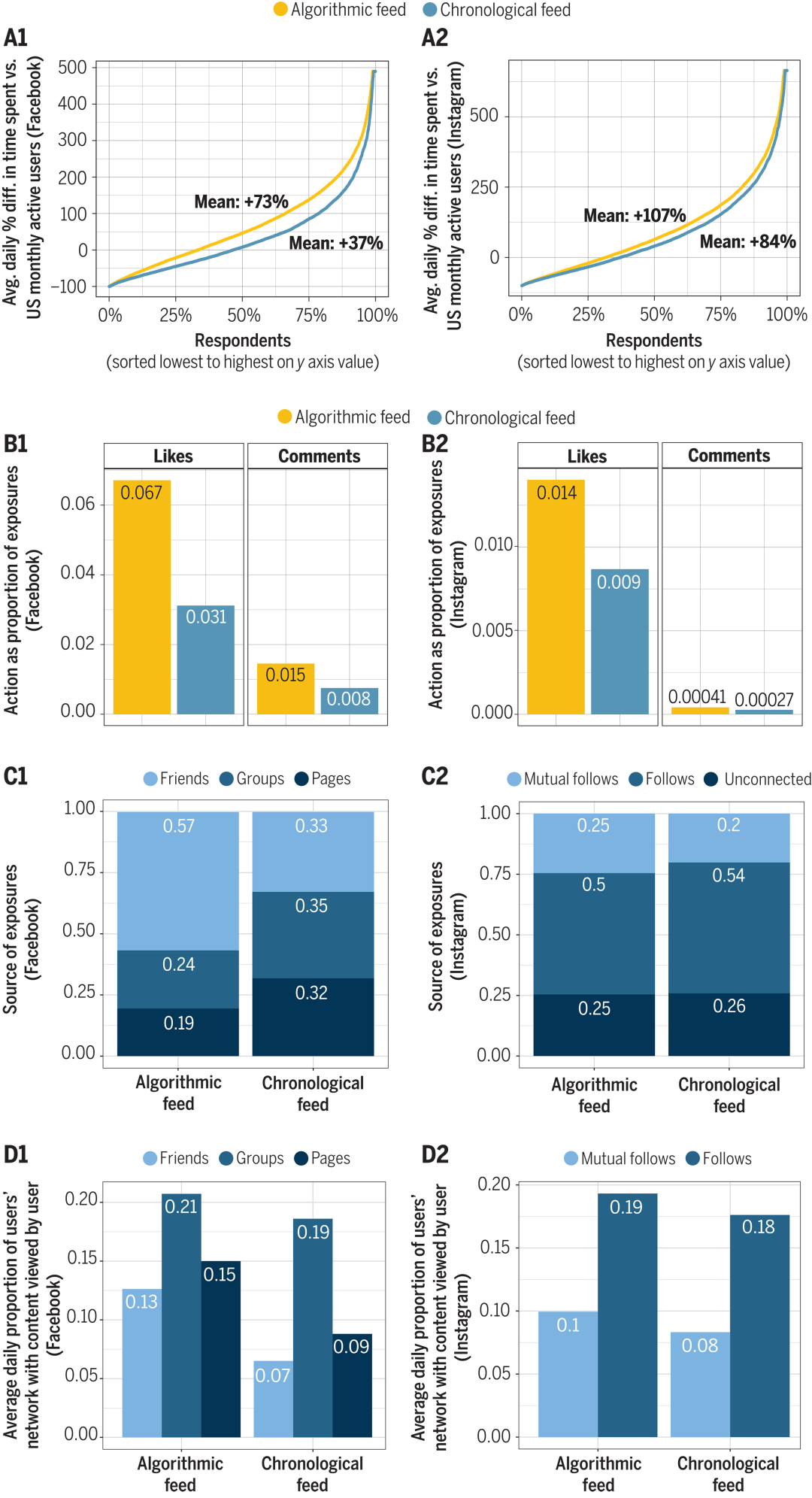

Science杂志近期刊发了一篇由普林斯顿大学、斯坦福大学等多所高校和Mate公司的合作论文,该工作通过调整数万人接收和分享政治新闻等信息的方式,系统研究了Facebook和Instagram(均为Mate产品)在2020年美国选举期间的信息流算法效果。研究团队将问题聚焦在“时序信息流内容如何影响人们所看到的内容”这一核心问题。基于三个核心假设展开实验设计:1. 按时间排序的内容将减少个体层面的情感极化;2. 用户关闭算法反馈,将减少其在社交媒体平台的停留时间和参与程度,从而减少接触政治信息。3.政治参与会受到反馈算法的多种影响,包括调整在线时长、便利政治动员、交叉观点内容排序等。

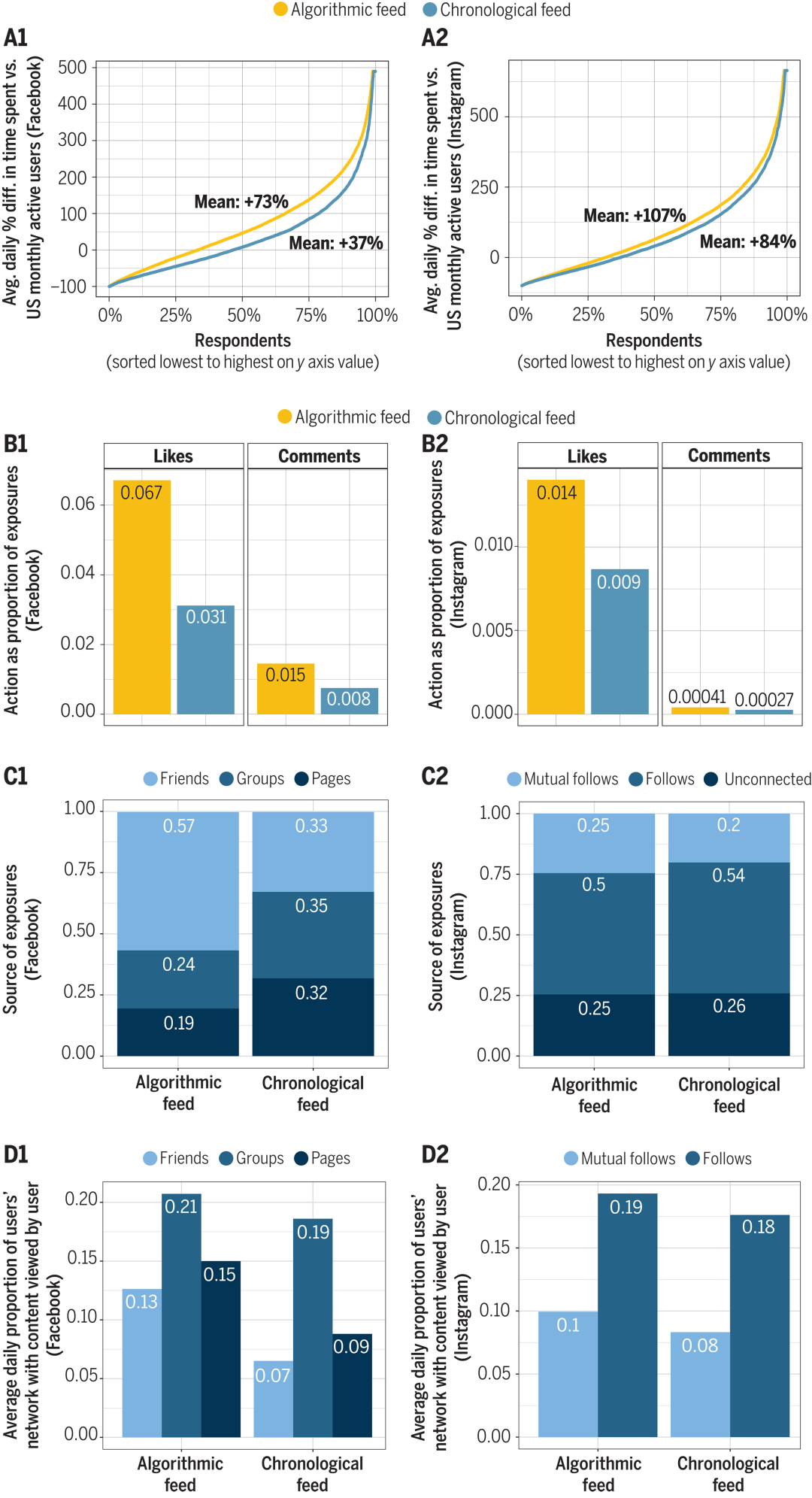

在具体实验中,研究团队将一部分同意参与的用户从默认算法中转移到了按时间顺序排列的信息流。发现将用户从信息流中移出,显著减少了他们在平台上的时间和活动。按时间顺序排列的信息流也影响了内容的曝光:用户在两个平台上看到的政治和不可信内容都增加了,而在Facebook上看到的不文明或包含侮辱性词语的内容减少了,同时在Facebook上看到的来自中立朋友和具有意识形态混合受众的来源的内容增加了。尽管用户在平台上的体验发生了上述重大变化,但在3个月的研究期间中,按时间顺序排列的信息流并没有显著改变用户群体的观点极化、情感极化、政治知识水平等。

以往学界认为调整人们在社交媒体平台访问新闻的方式,减少回声室效应,就能够改变用户的政治观点、知识或行为,本文作者认为新的实验结果颠覆了旧有认知。不过该实验发生在2020年美国选举即将结束时,当时党派观点在很大程度上已经被锁定了,这可能减弱该研究的效力。

图1 在Facebook和Instagram上,时间顺序信息流和算法推荐信息流两种情景下的用户体验和行为比较。左侧一列为Facebook,右侧一列为Instagram。

详情请见:

数据与计算前沿方法整合:计算社会科学读书会第二季启动

推荐阅读