Nat. Mach. Intell. 速递:通过概念相关性传播提高人工智能可解释性

2023-10-05

1,969

关键词:可解释人工智能,机器学习,概念相关传播

论文标题:From attribution maps to human-understandable explanations through Concept Relevance Propagation

论文来源:Nature Machine Intelligence

斑图链接:https://pattern.swarma.org/paper/cfb90f4c-580a-11ee-813d-0242ac17000d

原文链接:https://www.nature.com/articles/s42256-023-00711-8

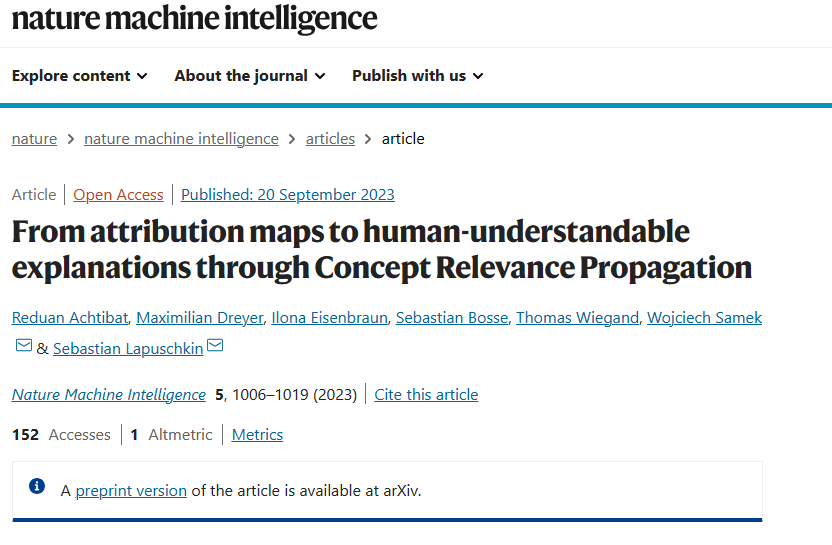

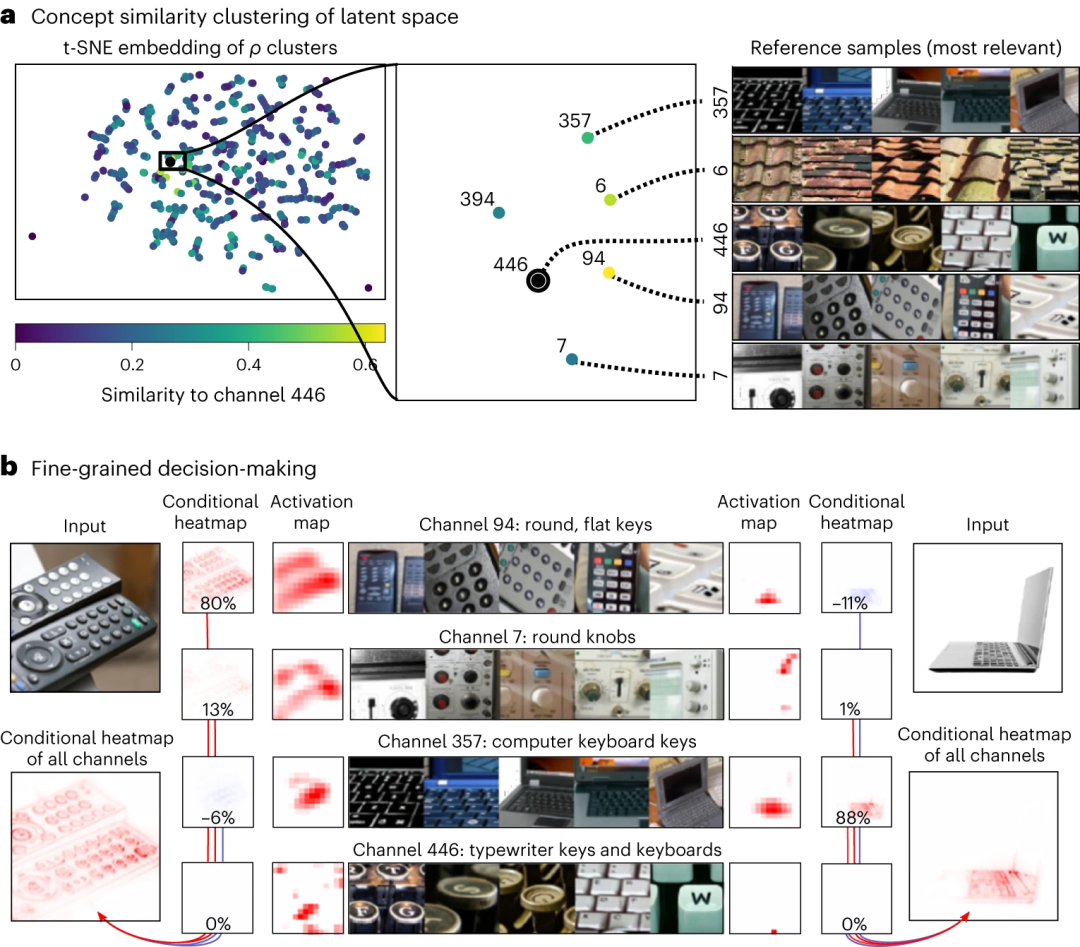

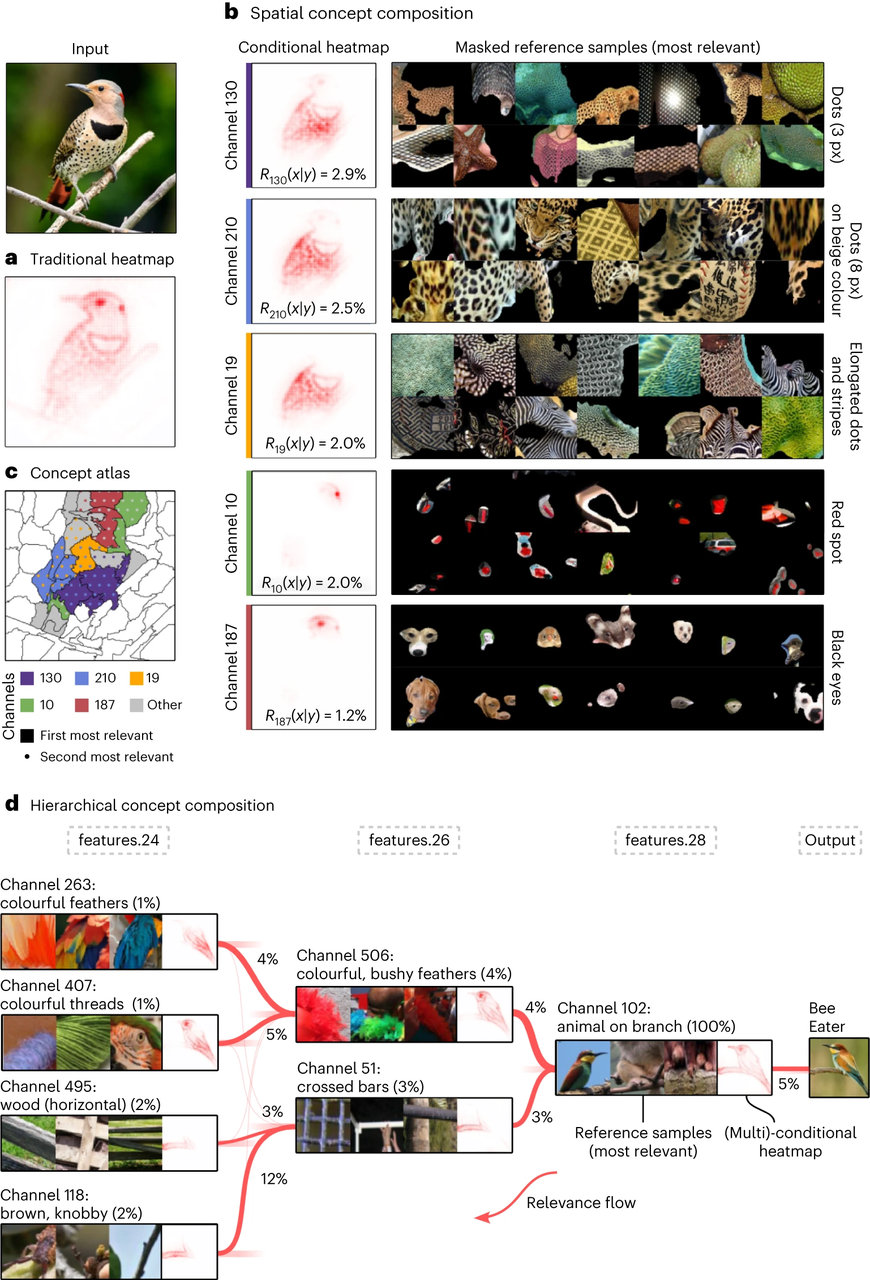

可解释人工智能(explainable artificial intelligence, XAI)领域旨在为当今强大但不透明的深度学习模型提供透明度,虽然局部XAI方法以归因图(attribution map)的形式解释个别预测,从而确定重要特征发生的位置,但不提供关于它们代表什么的信息,全局解释技术可视化了模型通常学会编码的概念。因此,这两种方法仅提供了部分见解,将解释模型的推理负担留给用户。

在此,文章介绍了概念相关传播(Concept Relevance Propagation, CRP)方法,它结合了局部和全局视角,因此允许回答个别预测的“何处”和“什么”的问题。

作者在各种情景下展示了该方法的能力,展示了CRP可以提供更容易理解的人类解释,并通过概念图、概念组合分析和定量研究概念子空间及其在细粒度决策中的作用,深入探讨了模型的表示和推理。

作者认为,这项工作中提出的工具以及由于样本特定神经网络解释中发现的语义和细节的增加,将推动事后XAI方法在新颖或以前难以处理的模型、问题和数据领域中的应用。

详情请见:

AGI 读书会启动:迈向通用人工智能的跨学科路径

推荐阅读