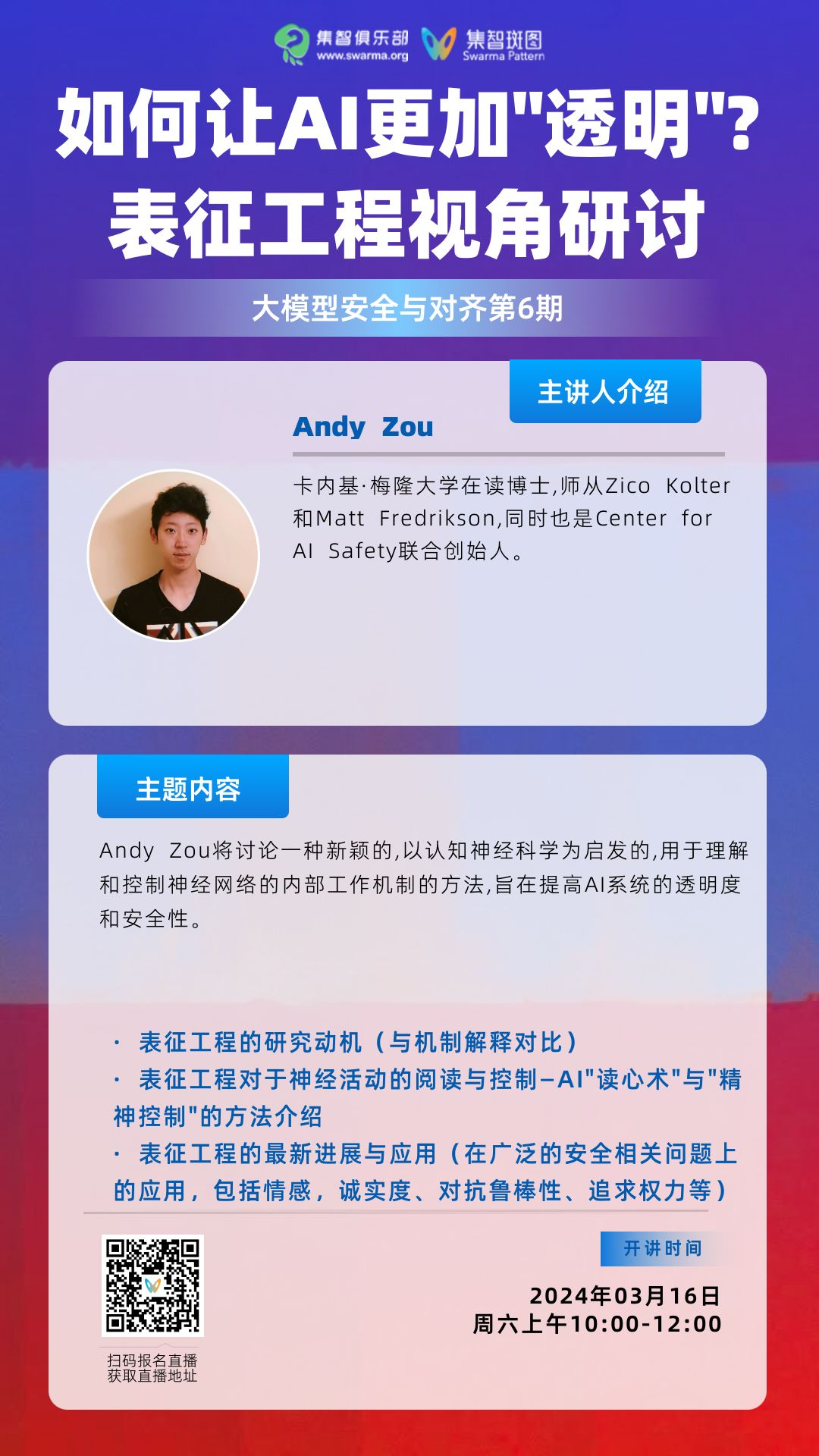

如何让AI更加“透明”?表征工程视角研讨丨大模型安全与对齐读书会·周六直播

导语

分享内容大纲

分享内容大纲

表征工程(Representation Engineering)

-

研究动机(与机制解释Mechanistic Interpretability进行对比)

-

RepE 包括对于神经活动的阅读与控制 – AI“读心术”与“精神控制”的方法介绍

-

RepE 的最新进展与应用(在广泛的安全相关问题上的应用,包括情感,诚实度、对抗鲁棒性、追求权力等)

涉及到的参考文献

涉及到的参考文献

主讲人介绍

主讲人介绍

涉及到的参考文献

涉及到的参考文献

-

Zou A, Phan L, Chen S, et al. Representation engineering: A top-down approach to ai transparency[J]. arXiv preprint arXiv:2310.01405, 2023.

-

Pan A, Chan J S, Zou A, et al. Do the rewards justify the means? measuring trade-offs between rewards and ethical behavior in the Machiavelli benchmark[C]//International Conference on Machine Learning. PMLR, 2023: 26837-26867.

-

Zou A, Wang Z, Kolter J Z, et al. Universal and transferable adversarial attacks on aligned language models[J]. arXiv preprint arXiv:2307.15043, 2023.

直播信息

直播信息

报名成为主讲人

报名成为主讲人

大模型安全与对齐读书会

大模型的狂飙突进唤醒了人们对AI技术的热情和憧憬,也引发了对AI技术本身存在的社会伦理风险及其对人类生存构成的潜在威胁的普遍担忧。在此背景下,AI安全与对齐得到广泛关注,这是一个致力于让AI造福人类,避免AI模型失控或被滥用而导致灾难性后果的研究方向。集智俱乐部和安远AI联合举办「大模型安全与对齐」读书会,由多位海内外一线研究者联合发起,旨在深入探讨大模型安全与对齐所涉及的核心技术、理论架构、解决路径以及安全治理等交叉课题。

点击“阅读原文”,报名读书会