图源:MIT News。https://news.mit.edu/2024/large-language-models-use-surprisingly-simple-mechanism-retrieve-stored-knowledge-0325

大型语言模型(LLMs)中的诚实与帮助性议题与计算社会科学紧密相关,它们共同探索了人工智能在理解和生成人类语言时的道德和行为准则。现有基于代理的模型虽然能够模拟个体行为及其相互作用,但它们在捕捉人类复杂行为和观点形成过程方面存在局限性。因此,如何增强这些LLM代理与人类行为的一致性成为一个待解决的问题。

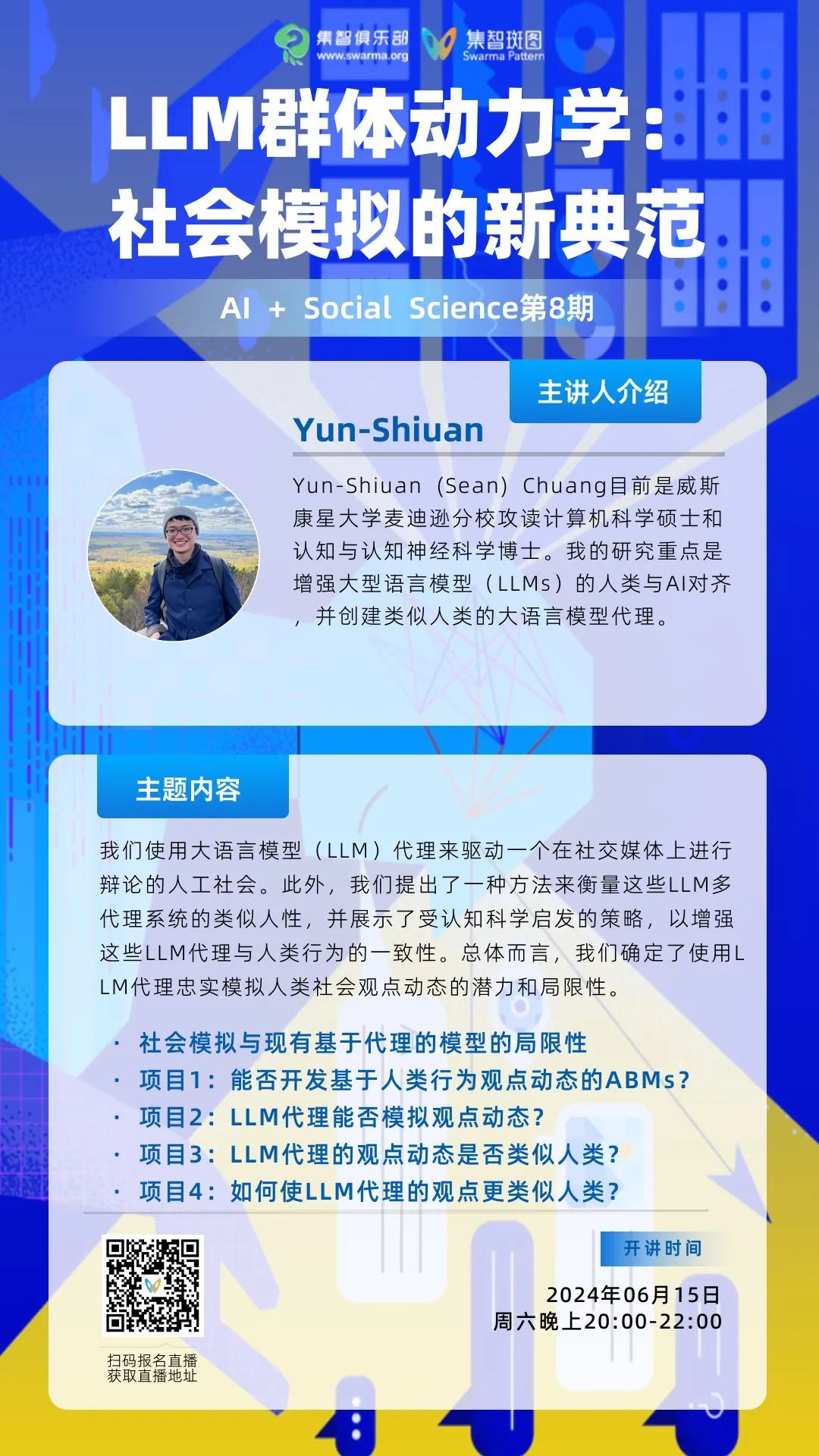

本次分享,我们邀请到普林斯顿大学计算机科学系博士生刘晨,探讨大型语言模型在面临诚实和助人这两大对齐核心目标矛盾时的行为;我们还邀请到威斯康星大学麦迪逊分校认知神经科学博士&计算机科学硕士Yun-Shiuan (Sean) Chuang,讨论使用LLM代理准确模拟人类社会观点动态的潜力和局限性。

本期读书会时间为:6月15日20:00-22:00(周六),直播报名入口见后文。

分享一:

大语言模型如何应对诚实与助人之间的矛盾?

该分享与读书会整体主题之间的关系:

大型语言模型(LLMs)中的诚实与帮助性议题与计算社会科学紧密相关,它们共同探索了人工智能在理解和生成人类语言时的道德和行为准则。计算社会科学作为一门交叉学科,它运用计算机科学、数据科学和社会科学的方法来分析社会互动和行为模式。LLMs的决策过程可以被量化和评估,为计算社会科学提供了实验设计和数据分析的新工具。LLMs中的诚实与帮助性不仅对人工智能的道德框架至关重要,也为计算社会科学提供了新的视角和研究方法。

简介:

本次分享借助心理学的核心概念和实验范式,探讨了机器学习对齐中的一个重要前沿话题。具体而言,我们研究了大型语言模型在面临诚实和助人这两大对齐核心目标矛盾时的行为。通过我们的研究,我们展示了心理学理论和实验能够被严格而全面地应用于大型语言模型相关关键问题的研究,并在此过程中揭示了一些有趣且有见的发现。

参考论文:

Liu, R., Sumers, T. R., Dasgupta, I., & Griffiths, T. L. (2024). How do large language models navigate conflicts between honesty and helpfulness?

大纲:

-

-

-

GPT-4 turbo出人意料地表现出类似人类的特征

7. 要点

涉及到的关键知识概念:

-

大语言模型: Large Language Model

-

对齐 / 诚实和助人: Alignment / Honesty & Helpfulness

-

心理学实验: Psychology Experiments

-

对话价值观: Conversational Values

-

强化学习辅以人类反馈: RLHF

-

主讲人:

刘晨(Ryan Liu)是普林斯顿大学计算机科学系第一年博士生,由汤姆·格里菲斯(Tom Griffiths)和安德烈斯·蒙罗伊·赫尔南德斯(Andres Monroy Hernandez)指导。之前在卡内基梅隆大学完成本科和硕士学位。研究领域是人工智能如何改变人类的交流方式,以及如何更好地改进人工智能与人类的交流。

该分享与读书会整体主题之间的关系:

社会模拟、基于代理的模型(ABMs)、大型语言模型(LLM)代理以及它们在观点动态中的应用,与计算社会科学紧密相关,共同构成了理解和预测社会行为的新方法论。计算社会科学利用计算模型和数据分析来探索社会结构、过程和行为,而社会模拟提供了一个实验平台,可以在此平台上测试不同的干预措施,以识别那些在社会系统中产生期望效果的策略。现有基于代理的模型虽然能够模拟个体行为及其相互作用,但它们在捕捉人类复杂行为和观点形成过程方面存在局限性。因此,如何增强这些LLM代理与人类行为的一致性成为一个待解决的问题。

简介:

一个模拟类似人类社会的系统拥有巨大的潜力,其应用范围从设计有说服力的错误信息纠正信息到策划成功的广告活动。在此次分享的研究项目中,我们使用大型语言模型(LLM)代理来驱动一个在社交媒体上进行辩论的人工社会。此外,我们提出了一种方法来衡量这些LLM多代理系统的类似人性,并展示了受认知科学启发的策略,以增强这些LLM代理与人类行为的一致性。总体而言,我们确定了使用LLM代理准确模拟人类社会观点动态的潜力和局限性。

参考论文:

(1)Chuang, Y.-S., Goyal, A., Harlalka, N., Suresh, S., Hawkins, R., Yang, S., Shah, D., Hu, J., & Rogers, T. T. (2023). Simulating opinion dynamics with networks of LLM-based agents.

(2)Chuang, Y.-S., Suresh, S., Harlalka, N., Goyal, A., Hawkins, R., Yang, S., Shah, D., Hu, J., & Rogers, T. T. (2023). The wisdom of partisan crowds: Comparing collective intelligence in humans and LLM-based agents.

(3)Beyond Demographics: Human-like LLM Agent Construction through Infusing Topic-Specific Opinions based on Belief Network

大纲

-

社会模拟:识别有效的干预措施

-

目标

-

现有基于代理的模型的局限性

-

项目1:我们能否开发基于人类行为的观点动态的ABMs(代理模型)?

-

项目2:大型语言模型(LLM)代理能否模拟观点动态?

-

项目3:LLM代理的观点动态是否类似人类?

-

涉及到的关键知识概念:

主讲人:

Yun-Shiuan (Sean) Chuang目前是威斯康星大学麦迪逊分校攻读计算机科学硕士和认知与认知神经科学博士。我的研究重点是增强大型语言模型(LLMs)的人类-人工智能对齐,并创建类似人类的大语言模型代理。

嘉宾

此外,本季读书会发起人之一,白雪纯子,将一起参与讨论,与两位主讲人、与大家,探讨大语言模型与心理学。

白雪纯子是普林斯顿大学心理学系博士,同时隶属于公共与国际事务学院、认知科学项目以及统计与机器学习中心。她研究动态社会心智,即个体决策过程与社会现象在社会认知领域的相互作用。她当前的工作探索社会刻板印象的心理学起源。白雪纯子将于2024年7月加入芝加哥大学心理学系担任助理教授。

个人主页:https://www.xuechunzibai.com/。

直播时间:

2024年6月15日(周六)20:00 – 22:00

参与方式:

集智俱乐部 B 站账号直播,扫码可预约:

扫码预约本次直播

若需要观看视频回放,文末扫码付费参加AI+Social Science读书会可加入腾讯会议,可提问交流、加入群聊、获取视频回放及更多学习资料,成为计算社会科学社区种子用户,与700余名计算社会科学的一线科研工作者沟通交流,共同推动计算社会科学社区的发展。

读书会成员均可以在读书会期间申请成为主讲人。主讲人作为读书会成员,均遵循内容共创共享机制,可以获得报名费退款,并共享本读书会产生的所有内容资源。具体见系列读书会详情:AI+Social Science:大模型怎样重塑社会科学 | 计算社会科学读书会第三季启动

集智俱乐部联合美国东北大学博士后研究员杨凯程、密歇根大学安娜堡分校博士候选人裴嘉欣,宾夕法尼亚大学沃顿商学院人力资本分析研究组博士后研究员吴雨桐、即将入职芝加哥大学心理学系的助理教授白雪纯子,共同发起AI+Social Science读书会,从3月24日开始,每周日晚20:00-22:00,探究大语言模型、生成式AI对计算社会科学领域带来的新思想新价值。

点击“阅读原文”,报名读书会