自由能原理在感知和学习领域的一个应用是预测加工理论,该理论解释大脑如何通过最小化预测误差来理解环境。此次「自由能原理与强化学习」读书会是预测加工理论部分的第一期,由中山大学物理学院统计物理与神经计算实验室(PMI Lab)黄海平老师和硕士生邱俊斌介绍发表于 Physical Review E 的最新工作,他们提出基于平均场的预测编码学习——元预测学习算法。此次读书会将从自由能原理视角出发,探讨预测编码与自由能最小化的关系,以及大脑计算、大模型预测和通用智能之间的联系。

当自由能原理应用于大脑与认知学习方面时,激发了一系列具体的理论和实践框架,例如预测编码理论(Predictive Coding)和预测加工模型(Predictive Processing)。预测编码理论和预测加工模型是两个紧密相关的概念,预测编码理论提供了一个关于大脑如何运作的高层次描述,而预测加工模型则提供了一个具体的计算框架来实现这一理论。它们在认知科学和神经科学中描述了大脑如何处理信息。

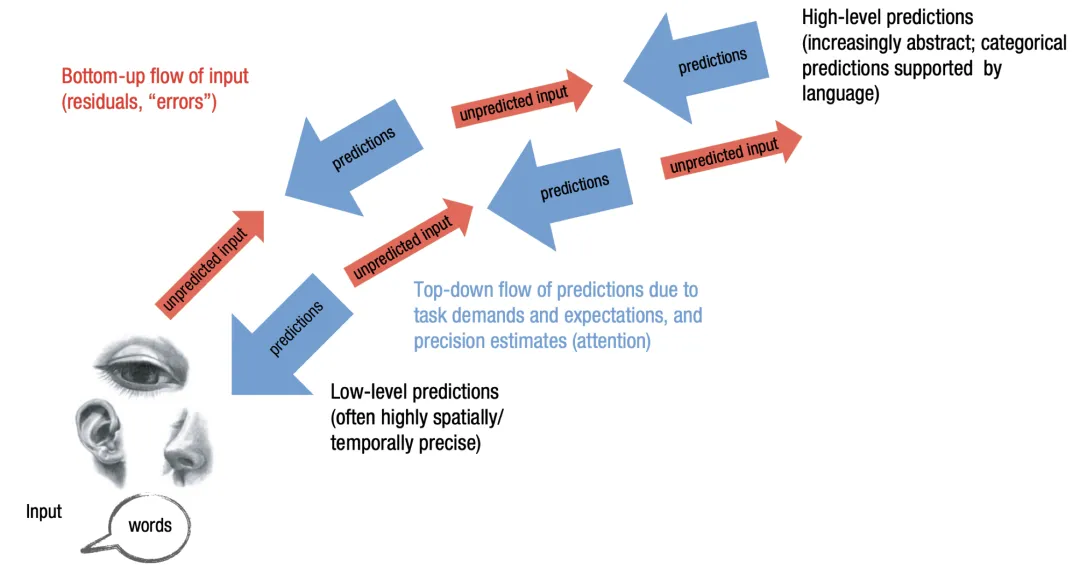

预测编码理论认为,大脑通过不断生成关于外部世界和内部状态的预测,并将其与实际感觉输入相比较来执行其功能。这种比较如果出现偏差,将产生预测误差,这一误差信号随后会被反馈至大脑的更高层次,用以调整和优化内部模型,目的是减少未来的预测误差。这个过程体现了自上而下的预测信息流和自下而上的感觉信息流的交互。

预测加工模型可以看作是预测编码理论的一个具体实现,它提供了一个计算和数学框架来描述大脑如何通过预测和更新来处理信息,这一模型和上述提到的贝叶斯定理出发的主动推理路径一脉相承,为解释大脑的认知行为现象提供了有力工具。

基于自注意力机制的大语言模型在工程和商业上取得了巨大的成功,诞生了诸如ChatGPT、Sora等著名的人工智能产品。但是,这类模型通常采用的是梯度下降反向传播的方式进行学习,这与我们真实大脑的学习机制并不相同。 预测编码框架是目前大脑学习最具影响力的假设之一,其核心是希望通过局域学习来最小化大脑对外部世界的预测误差。此外,为了得到神经网络的信用分配机制,我们提出了基于平均场的预测编码学习(元预测学习),假设神经元的突触服从脉冲高斯分布(Spike-and-Slab)分布,神经网络训练的是突触的分布本身,而不是具体的取值。

我们首先在MNIST手写数字图像分类的任务上使用元预测学习算法进行验证,发现其效果比单纯的预测编码学习算法效果更优。此外,我们还在玩具和真实语料库上进行了验证,发现大多数连接在学习后变得更加确定,而输出层的连接的变化范围更大。随着数据量的增加,网络的性能也在上升,这类似于大语言模型的涌现行为。总的来说, 我们的模型是对探讨大脑计算、大模型预测和通用智能之间联系的一次尝试。

此次读书会将介绍 PMI Lab 的一项最新研究 Meta predictive learning model of languages in neural circuits,于近期发表在 Physical Review E 杂志上。

-

引入

-

元预测学习算法

-

预测编码框架介绍

-

预测编码与自由能最小化的关系

-

信用分配——Spike-and-Slab分布介绍

-

实验验证

-

MNIST手写数字图像分类

-

玩具语言模型和真实语言模型

-

Li, Chan, Junbin Qiu, and Haiping Huang. Meta predictive learning model of languages in neural circuits. Physical Review E 109.4 (2024): 044309.

黄海平,中山大学物理学院教授。本科毕业于中山大学理工学院,博士毕业于中国科学院理论物理研究所,随后在香港科技大学物理系、东京工业大学计算智能系(2012年获日本学术振兴会资助)以及日本理化学研究所(RIKEN)脑科学中心从事统计物理与机器学习、 神经计算交叉的基础理论研究,2017年因在无监督学习方面的研究获得 RIKEN 杰出研究奖。于2018年入选中山大学百人计划,在物理学院组建了“物理、机器与智能” (PMI)研究小组,专注于各种神经计算的理论基础,长期目标是使用基于物理的近似来揭示机器及大脑智能的基本原理。

PMI Lab:https://www.labxing.com/hphuang2018。

邱俊斌,中山大学物理学院统计物理与神经计算实验室(PMI Lab)硕士生,导师为黄海平老师。研究方向:统计物理,神经网络,随机矩阵,动力学平均场。

时间:2024年6月15日(本周六)上午9:00-11:00

斑图地址:https://pattern.swarma.org/study_group_issue/632

扫码参与自由能原理与强化学习读书会,加入群聊,获取系列读书会回看权限,加入集智社区,与社区的一线科研工作者沟通交流,共同推动这一前沿领域的发展。

自由能原理被认为是“自达尔文自然选择理论后最包罗万象的思想”,从第一性原理出发解释智能体更新认知、探索和改变世界的机制,被认为有可能成为智能的第一性原理的重要候选方案,并有望成为新时代复杂系统的大统一理论。集智俱乐部「自由能原理与强化学习」读书会邀请到 Karl Friston、敖平、牟牧云、张正泉、张德祥、陈湛、何真、罗凡明等研究者,从自由能原理的基础理论到强化学习世界模型等前沿应用,系统介绍了自由能原理主动推理框架。欢迎感兴趣的朋友报名参与,和我们一起开启自由能之旅,探索智能的第一性原理!

点击“阅读原文”,报名读书会