复杂性怎样量化和驱动下一代AI系统|周一直播·AI by Complexity读书会

导语

分享流程

分享流程

-

18:50-19:00 集智俱乐部与读书会介绍 -

19:00-19:30 张章:机器学习系统中的复杂网络 & 作为复杂系统的大模型 -

19:30-19:55 于玉国:从能量约束角度理解大脑结构和功能的优化设计规则 -

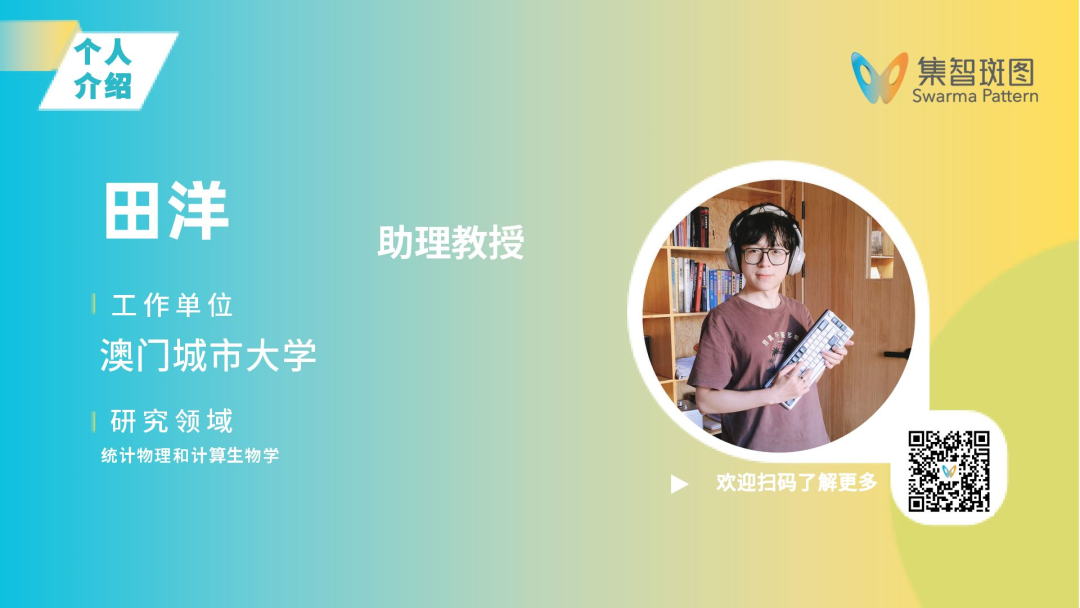

19:55-20:20 田洋:当动力系统理论遇见神经网络参数化 -

20:20-20:45 牟牧云:自由能原理与强化学习 -

20:45-21:10 刘宇:“压缩即智能”与算法信息论 -

21:10-21:40 杨明哲:因果涌现 for AI、复杂系统临界性 for AI -

21:40-22:00 互动交流

内容及主讲人介绍

内容及主讲人介绍

机器学习系统中的复杂网络 & 作为复杂系统的大模型

内容简介

近年来,大型神经网络,特别是大型语言模型,在技术能力上取得显著进展,显示出与复杂系统类似的现象,包括神经网络规模的扩展(neural scaling law)和涌现行为(emergent behavior)。我们将分享关于这两种现象的前沿研究,并尝试从复杂系统的视角解释大型模型的内在机制如何运作。

核心概念

复杂网络、库计算、neural scaling law、emergent behavior

参考文献

-

Carroll, Thomas L., and Louis M. Pecora. “Network structure effects in reservoir computers.” Chaos: An Interdisciplinary Journal of Nonlinear Science 29.8 (2019).

-

Li, Xin, et al. “Higher-order Granger reservoir computing: simultaneously achieving scalable complex structures inference and accurate dynamics prediction.” Nature Communications 15.1 (2024): 2506.

-

Bahri, Yasaman, et al. “Explaining neural scaling laws.” arXiv preprint arXiv:2102.06701 (2021).

-

Song, Jinyeop, et al. “A Resource Model For Neural Scaling Law.” arXiv preprint arXiv:2402.05164 (2024).

主讲人:张章

从能量约束角度理解大脑结构和功能的优化设计规则

内容简介

在自然界的进化过程中,有限的能量可获取性是生物体和动物大脑演化的关键制约因素。为了在有限能量下实现高度竞争力的感知、学习、决策和运动等智能行为,生物大脑必然朝着能量-功能最优化的方向演化。这种演化在生物物理参数、结构和功能网络布线、电化学信号活动以及神经信号表征方法等多个方面展现出高能效比的机制和现象。发现和揭示这些机制和现象规律,不仅能加深我们对大脑高效运行的理解,更能为设计受脑启发的超低功耗新一代人工智能模型和算法提供重要启示。

核心概念

神经信号表征策略、能量高效的神经计算和信息处理机制、脉冲神经网络

参考文献

-

CHKLOVSKII, Dmitri B.; SCHIKORSKI, Thomas; STEVENS, Charles F. Wiring optimization in cortical circuits. Neuron, 2002, 34.3: 341-347.

-

Laughlin, S. B., & Sejnowski, T. J. (2003). Communication in neuronal networks. Science, 301(5641), 1870-1874.

-

Shu, Y., Hasenstaub, A., Duque, A., Yu, Y., & McCormick, D. A. (2006). Modulation of intracortical synaptic potentials by presynaptic somatic membrane potential. Nature, 441(7094), 761-765.

-

Alle, H., Roth, A., and Geiger, J. R. (2009). Energy-efficient action potentials in hippocampal mossy fibers. Science 325, 1405–1408.

-

Bullmore, E., & Sporns, O. (2012). The economy of brain network organization. Nature reviews neuroscience, 13(5), 336-349.

-

Sterling, Peter, and Simon Laughlin. Principles of neural design. MIT press, 2015.

-

Yu, Y., et al. Sparse coding and lateral inhibition arising from balanced and unbalanced dendrodendritic excitation and inhibition. Journal of Neuroscience, 2014, 34.41: 13701-13713.

-

Lu, Zhongmin, et al. “High-probability neurotransmitter release sites represent an energy-efficient design.” Current Biology 26.19 (2016): 2562-2571.

-

CHALK, Matthew; MARRE, Olivier; TKAČIK, Gašper. Toward a unified theory of efficient, predictive, and sparse coding. Proceedings of the National Academy of Sciences, 2018, 115.1: 186-191.

-

Yu, Y., Herman, P., Rothman, D. L., Agarwal, D., & Hyder, F. (2018). Evaluating the gray and white matter energy budgets of human brain function. Journal of Cerebral Blood Flow & Metabolism, 38(8), 1339-1353.

-

LEVY, William B.; CALVERT, Victoria G. Communication consumes 35 times more energy than computation in the human cortex, but both costs are needed to predict synapse number. Proceedings of the National Academy of Sciences, 2021, 118.18.

-

Yu Y, Herman P, Rothman DL, Agarwal D, & *Hyder F. A 3D atlas of functional human brain energetic connectome based on neuropil distribution, Cerebral Cortex, 2023

-

Castrillon, G., Epp, S., Bose, A., Fraticelli, L., Hechler, A., Belenya, R., … & Riedl, V. (2023). An energy costly architecture of neuromodulators for human brain evolution and cognition. Science advances, 9(50).

主讲人:于玉国

当动力系统理论遇见神经网络参数化

内容简介

在科学计算领域,一大类代表性研究问题可以概括为两种情况:一种是系统符合的微分方程组已知时,对该方程组进行数值求解。一种是系统符合的微分方程组未知时,基于局部观测的数据预测该动力系统的演化轨迹。前者催生了有限元、谱方法等各类微分方程数值解法,构成了工业制造、计算物理、量子化学和材料科学的计算基石。后者顺应了现代观测技术的发展,在地球物理和生物物理等领域有着重要价值,影响着气象预测、地质反演和生物系统建模技术的发展。在本次报告中,我们需要讨论是否可能基于统计物理或数学知识设计更好的机器学习框架、以更高的效率实现前述两类情况中的问题求解,从而发挥机器学习在科学计算领域的潜力。在本次报告中,我们以动力系统理论的神经网络参数化为着手点,发散讨论如何使用动力系统理论设计微分方程神经网络求解器或动力系统预测器,畅想各种物理和机器学习的结合可能性,也为后续多场相关学术报告奠定基础。

核心概念

动力系统理论、神经网络参数化、科学计算

参考文献

-

Xiong, W., Ma, M., Huang, X., Zhang, Z., Sun, P. and Tian, Y., 2023. Koopmanlab: machine learning for solving complex physics equations. APL Machine Learning, 1(3).

-

Xiong, W., Huang, X., Zhang, Z., Deng, R., Sun, P. and Tian, Y., 2023. Koopman neural operator as a mesh-free solver of non-linear partial differential equations. arXiv preprint arXiv:2301.10022. Accepted by Journal of Computational Physics, in press.

-

Mizera, S., 2023. Scattering with neural operators. Physical Review D, 108(10), p.L101701.

-

Brunton, S.L., Budišić, M., Kaiser, E. and Kutz, J.N., 2022. Modern Koopman Theory for Dynamical Systems. SIAM Review, 64(2), pp.229-340.

-

Azizzadenesheli, K., Kovachki, N., Li, Z., Liu-Schiaffini, M., Kossaifi, J. and Anandkumar, A., 2024. Neural operators for accelerating scientific simulations and design. Nature Reviews Physics, pp.1-9.

-

Kovachki, N., Li, Z., Liu, B., Azizzadenesheli, K., Bhattacharya, K., Stuart, A. and Anandkumar, A., 2023. Neural operator: Learning maps between function spaces with applications to pdes. Journal of Machine Learning Research, 24(89), pp.1-97.

主讲人:田洋

自由能原理与强化学习

内容简介:

自由能的概念起源于统计物理,后被引入机器学习和信息加工领域,表示对世界表征状态与其真实状态间的差异。自由能原理认为,所有可变的量,只要作为系统的一部分,都会为最小化自由能而变化。本质上,自由能原理希望阐明在生物系统中实现自组织的可能性。自由能原理可以从两个角度进行理解,一种是从贝叶斯定理出发的认知的视角。另一种视角是从随机动力系统以及非平衡稳态等视角出发探究自由能原理与智能体感知和行动之间的联系,这对于构建决策AI智能体或许能够带来新的启发。

核心概念

自由能原理、贝叶斯定理、随机动力系统

参考文献

-

Smith R, Friston K J, Whyte C J. A step-by-step tutorial on active inference and its application to empirical data[J]. Journal of mathematical psychology, 2022, 107: 102632.

-

Karl, Friston. “A free energy principle for biological systems.” Entropy 14.11 (2012): 2100-2121.

-

Friston, Karl, and Ping Ao. “Free energy, value, and attractors.” Computational and mathematical methods in medicine 2012 (2012).

-

Friston, Karl, et al. “The free energy principle made simpler but not too simple.” Physics Reports 1024 (2023): 1-29.

-

Mazzaglia, Pietro, et al. “The free energy principle for perception and action: A deep learning perspective.” Entropy 24.2 (2022): 301.

-

Hafner, Danijar, et al. “Action and perception as divergence minimization.” arXiv preprint arXiv:2009.01791 (2020).

主讲人:牟牧云

“压缩即智能”与算法信息论

内容简介

近几年来,包括Ilya Sutskever、Marcus Hutter、Jack Rae等的众多研究者均对压缩与智能之间的关系进行了探讨,有观点甚至将这一理论视为OpenAI的核心哲学。实际上,探究压缩和智能的联系已有悠久历史,至少可追溯至图灵关于可计算性的研究。此后,1960年代Solomonoff、Kolmogorov 和 Chaitin独立提出并发展算法信息论(紧随香农的信息论之后),该领域逐渐引入了诸如柯式复杂度这样的重要概念:即复杂度衡量的是在通用图灵机上生成某个对象的最短程序长度。虽然后面证明严格的柯式复杂度是不可计算的,但有很多方式可以去逼近,有效的压缩算法就是一个途径。而将柯式复杂度和压缩算法结合起来,就可以定义出距离。而距离是很多研究的出发点,比如两个词向量意义很接近就是因为它们的距离很近、两个药物分子的功能相近也可能是因为它们本身或某部分之间的距离很近、若干物种间的进化关系也是通过距离构建的。

核心概念

算法信息论、信息距离、压缩算法

参考文献

-

Cilibrasi, Rudi, and Paul MB Vitányi. “Clustering by compression.” IEEE Transactions on Information theory 51.4 (2005): 1523-1545.

-

Delétang, Grégoire, et al. “Language modeling is compression.” arXiv preprint arXiv:2309.10668 (2023).

-

Johnston, Iain G., et al. “Symmetry and simplicity spontaneously emerge from the algorithmic nature of evolution.” Proceedings of the National Academy of Sciences 119.11 (2022): e2113883119.

-

Sharma, Abhishek, et al. “Assembly theory explains and quantifies selection and evolution.” Nature 622.7982 (2023): 321-328.

-

Zecheng Zhang, Chunxiuzi Liu, Yingjun Zhu, et al. Evolutionary Tinkering Enriches the Hierarchical and Interlaced Structures in Amino Acid Sequences

主讲人:刘宇

因果涌现 for AI、复杂系统临界性 for AI

内容简介

核心概念

因果涌现、有效信息、信息瓶颈、自组织临界、储备池动力学

参考文献

-

Mattsson, S., Michaud, E. J., & Hoel, E. (2020). Examining the causal structures of deep neural networks using information theory (arXiv:2010.13871). arXiv.

-

Yang, M., Wang, Z., Liu, K., Rong, Y., Yuan, B., & Zhang, J. (2023). Finding emergence in data by maximizing effective information (arXiv:2308.09952). arXiv.

-

Yuan, B., Zhang, J., Lyu, A., Wu, J., Wang, Z., Yang, M., Liu, K., Mou, M., & Cui, P. (2024). Emergence and Causality in Complex Systems: A Survey of Causal Emergence and Related Quantitative Studies. Entropy, 26(2), 108.

-

Kanders, K., Lorimer, T., & Stoop, R. (2017). Avalanche and edge-of-chaos criticality do not necessarily co-occur in neural networks. Chaos: An Interdisciplinary Journal of Nonlinear Science, 27(4), 047408.

-

Katsnelson, M. I., Vanchurin, V., & Westerhout, T. (2021). Self-organized criticality in neural networks (arXiv:2107.03402). arXiv.

-

Mattsson, S., Michaud, E. J., & Hoel, E. (2020). Examining the causal structures of deep neural networks using information theory (arXiv:2010.13871). arXiv.

-

Tetzlaff, C., Okujeni, S., Egert, U., Wörgötter, F., & Butz, M. (2010). Self-Organized Criticality in Developing Neuronal Networks. PLoS Computational Biology, 6(12), e1001013.

-

Wang, L., Fan, H., Xiao, J., Lan, Y., & Wang, X. (2022). Criticality in Reservoir Computer of Coupled Phase Oscillators. Physical Review E, 105(5), L052201.

主讲人:杨明哲

直播信息

直播信息

时间:2024年6月17日(周一)晚18:50-22:00

报名参与读书会:

斑图链接:https://pattern.swarma.org/study_group/45?from=wechat

报名成为主讲人

读书会成员均可以在读书会期间申请成为主讲人。主讲人作为读书会成员,均遵循内容共创共享机制,可以获得报名费退款,并共享本读书会产生的所有内容资源。详情请见:AI by Complexity 读书会启动:复杂性怎样量化和驱动下一代AI系统

AI By Complexity读书会招募中