-

Huang, G. Is this a unified theory of the brain?New Scientist 2658, 30–33 (2008).

-

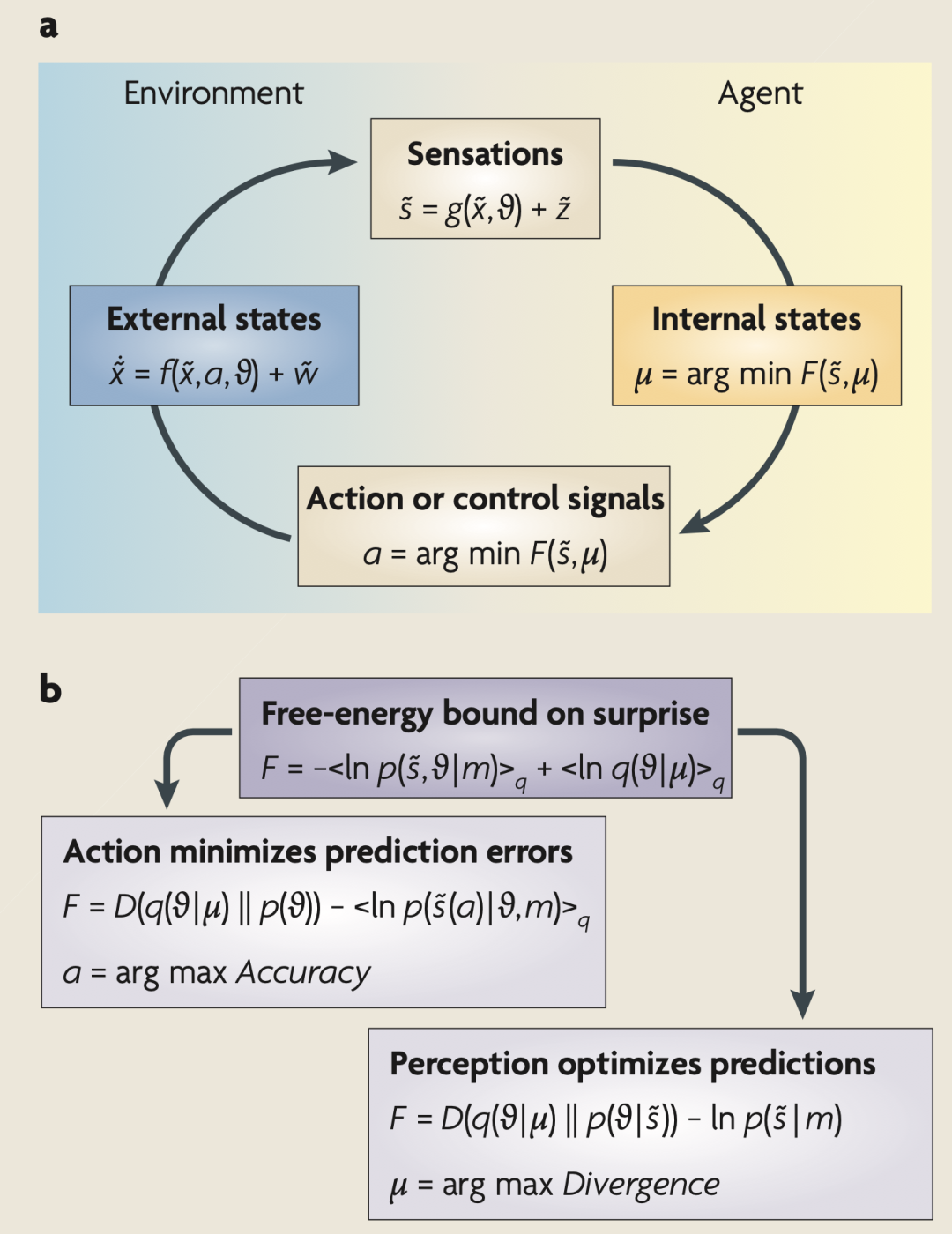

Friston K., Kilner, J. & Harrison, L. A free energy principle for the brain. J. Physiol. Paris 100, 70–87 (2006).An overview of the free-energy principle that describes its motivation and relationship to generative models and predictive coding. This paper focuses on perception and the neurobiological infrastructures involved.

-

Ashby, W. R. Principles of the self-organising dynamic system. J. Gen. Psychol. 37, 125–128 (1947).

-

Nicolis, G. & Prigogine, I. Self‑Organisation in Non‑ Equilibrium Systems (Wiley, New York, 1977).

-

Haken, H. Synergistics: an Introduction. Non‑ Equilibrium Phase Transition and Self‑Organisation in Physics, Chemistry and Biology 3rd edn (Springer, New York, 1983).

-

Kauffman, S. The Origins of Order: Self‑Organization and Selection in Evolution (Oxford Univ. Press, Oxford, 1993).

-

Bernard, C. Lectures on the Phenomena Common to Animals and Plants (Thomas, Springfield, 1974).

-

Applebaum, D. Probability and Information: an Integrated Approach (Cambridge Univ. Press, Cambridge, UK, 2008).

-

Evans, D. J. A non-equilibrium free energy theorem for deterministic systems. Mol. Physics 101, 15551–11554 (2003).

-

Crauel, H. & Flandoli, F. Attractors for random dynamical systems. Probab. Theory Relat. Fields 100, 365–393 (1994).

-

Feynman, R. P. Statistical Mechanics: a Set of Lectures (Benjamin, Reading, Massachusetts, 1972).

-

Hinton, G. E. & von Cramp, D. Keeping neural networks simple by minimising the description length of weights. Proc. 6th Annu. ACM Conf. Computational Learning Theory 5–13 (1993).

-

MacKay. D. J. C. Free-energy minimisation algorithm for decoding and cryptoanalysis. Electron. Lett. 31, 445–447 (1995).

-

Neal, R. M. & Hinton, G. E. in Learning in Graphical Models (ed. Jordan, M. I.) 355–368 (Kluwer Academic, Dordrecht, 1998).

-

Itti, L. & Baldi, P. Bayesian surprise attracts human attention. Vision Res. 49, 1295–1306 (2009).

-

Friston, K., Daunizeau, J. & Kiebel, S. Active inference or reinforcement learning? PLoS ONE 4, e6421 (2009).

-

Knill, D. C. & Pouget, A. The Bayesian brain: the role of uncertainty in neural coding and computation. Trends Neurosci. 27, 712–719 (2004).A nice review of Bayesian theories of perception and sensorimotor control. Its focus is on Bayes optimality in the brain and the implicit nature of neuronal representations.

-

von Helmholtz, H. in Treatise on Physiological Optics Vol. III 3rd edn (Voss, Hamburg, 1909).

-

MacKay, D. M. in Automata Studies (eds Shannon, C. E. & McCarthy, J.) 235–251 (Princeton Univ. Press, Princeton, 1956).

-

Neisser, U. Cognitive Psychology (Appleton-Century-Crofts, New York, 1967).

-

Gregory, R. L. Perceptual illusions and brain models. Proc. R. Soc. Lond. B Biol. Sci. 171, 179–196 (1968).

-

Gregory, R. L. Perceptions as hypotheses. Philos. Trans. R. Soc. Lond. B Biol. Sci. 290, 181–197 (1980).

-

Ballard, D. H., Hinton, G. E. & Sejnowski, T. J. Parallel visual computation. Nature 306, 21–26 (1983).

-

Kawato, M., Hayakawa, H. & Inui, T. A forward-inverse optics model of reciprocal connections between visual areas. Network: Computation in Neural Systems 4, 415–422 (1993).

-

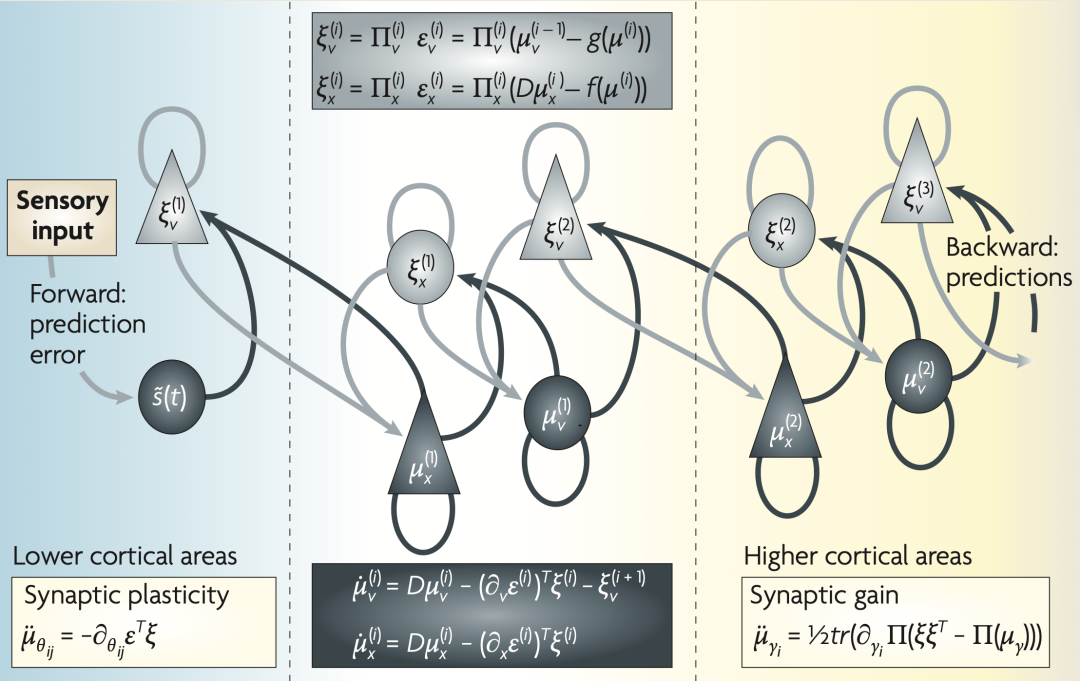

Dayan, P., Hinton, G. E. & Neal, R. M. The Helmholtz machine. Neural Comput. 7, 889–904 (1995). This paper introduces the central role of generative models and variational approaches to hierarchical self-supervised learning and relates this to the function of bottom-up and top-down cortical processing pathways.

-

Lee, T. S. & Mumford, D. Hierarchical Bayesian inference in the visual cortex. J. Opt. Soc. Am. A Opt. Image Sci. Vis. 20, 1434–1448 (2003).

-

Kersten, D., Mamassian, P. & Yuille, A. Object perception as Bayesian inference. Annu. Rev. Psychol. 55, 271–304 (2004).

-

Friston, K. J. A theory of cortical responses. Philos. Trans. R. Soc. Lond. B Biol. Sci. 360, 815–836 (2005).

-

Beal, M. J. Variational Algorithms for Approximate Bayesian Inference. Thesis, University College London (2003).

-

Efron, B. & Morris, C. Stein’s estimation rule and its competitors – an empirical Bayes approach. J. Am. Stats. Assoc. 68, 117–130 (1973).

-

Kass, R. E. & Steffey, D. Approximate Bayesian inference in conditionally independent hierarchical models (parametric empirical Bayes models). J. Am. Stat. Assoc. 407, 717–726 (1989).

-

Zeki, S. & Shipp, S. The functional logic of cortical connections. Nature 335, 311–317 (1988). Describes the functional architecture of cortical hierarchies with a focus on patterns of anatomical connections in the visual cortex. It emphasizes the role of functional segregation and integration (that is, message passing among cortical areas).

-

Felleman, D. J. & Van Essen, D. C. Distributed hierarchical processing in the primate cerebral cortex. Cereb. Cortex 1, 1–47 (1991).

-

Mesulam, M. M. From sensation to cognition. Brain 121, 1013–1052 (1998).

-

Sanger, T. Probability density estimation for the interpretation of neural population codes. J. Neurophysiol. 76, 2790–2793 (1996).

-

Zemel, R., Dayan, P. & Pouget, A. Probabilistic interpretation of population code. Neural Comput. 10, 403–430 (1998).

-

Paulin, M. G. Evolution of the cerebellum as a neuronal machine for Bayesian state estimation. J. Neural Eng. 2, S219–S234 (2005).

-

Ma, W. J., Beck, J. M., Latham, P. E. & Pouget, A. Bayesian inference with probabilistic population codes. Nature Neurosci. 9, 1432–1438 (2006).

-

Friston, K., Mattout, J., Trujillo-Barreto, N., Ashburner, J. & Penny, W. Variational free energy and the Laplace approximation. Neuroimage 34, 220–234 (2007).

-

Rao, R. P. & Ballard, D. H. Predictive coding in the visual cortex: a functional interpretation of some extra-classical receptive field effects. Nature Neurosci. 2, 79–87 (1998).Applies predictive coding to cortical processing to provide a compelling account of extra-classical receptive fields in the visual system. It emphasizes the importance of top-down projections in providing predictions, by modelling perceptual inference.

-

Mumford, D. On the computational architecture of the neocortex. II. The role of cortico-cortical loops. Biol. Cybern. 66, 241–251 (1992).

-

Friston, K. Hierarchical models in the brain. PLoS Comput. Biol. 4, e1000211 (2008).

-

Murray, S. O., Kersten, D., Olshausen, B. A., Schrater, P. & Woods, D. L. Shape perception reduces activity in human primary visual cortex. Proc. Natl Acad. Sci. USA 99, 15164–15169 (2002).

-

Garrido, M. I., Kilner, J. M., Kiebel, S. J. & Friston,K. J. Dynamic causal modeling of the response to frequency deviants. J. Neurophysiol. 101, 2620–2631 (2009).

-

Sherman, S. M. & Guillery, R. W. On the actions that one nerve cell can have on another: distinguishing “drivers” from “modulators”. Proc. Natl Acad. Sci. USA 95, 7121–7126 (1998).

-

Angelucci, A. & Bressloff, P. C. Contribution of feedforward, lateral and feedback connections to the classical receptive field center and extra-classical receptive field surround of primate V1 neurons. Prog. Brain Res. 154, 93–120 (2006).

-

Grossberg, S. Towards a unified theory of neocortex: laminar cortical circuits for vision and cognition. Prog. Brain Res. 165, 79–104 (2007).

-

Grossberg, S. & Versace, M. Spikes, synchrony, and attentive learning by laminar thalamocortical circuits. Brain Res. 1218, 278–312 (2008).

-

Barlow, H. in Sensory Communication (ed. Rosenblith, W.) 217–234 (MIT Press, Cambridge, Massachusetts, 1961).

-

Linsker, R. Perceptual neural organisation: some approaches based on network models and information theory. Annu. Rev. Neurosci. 13, 257–281 (1990).

-

Oja, E. Neural networks, principal components, and subspaces. Int. J. Neural Syst. 1, 61–68 (1989).

-

Bell, A. J. & Sejnowski, T. J. An information maximisation approach to blind separation and blind de-convolution. Neural Comput. 7, 1129–1159 (1995).

-

Atick, J. J. & Redlich, A. N. What does the retina know about natural scenes? Neural Comput. 4, 196–210 (1992).

-

Optican, L. & Richmond, B. J. Temporal encoding of two-dimensional patterns by single units in primate inferior cortex. III Information theoretic analysis.J. Neurophysiol. 57, 132–146 (1987).

-

Olshausen, B. A. & Field, D. J. Emergence of simple- cell receptive field properties by learning a sparse code for natural images. Nature 381, 607–609 (1996).

-

Simoncelli, E. P. & Olshausen, B. A. Natural image statistics and neural representation. Annu. Rev. Neurosci. 24, 1193–1216 (2001).A nice review of information theory in visual processing. It covers natural scene statistics and empirical tests of the efficient coding hypothesis in individual neurons and populations of neurons.

-

Friston, K. J. The labile brain. III. Transients and spatio-temporal receptive fields. Philos. Trans. R. Soc. Lond. B Biol. Sci. 355, 253–265 (2000).

-

Bialek, W., Nemenman, I. & Tishby, N. Predictability, complexity, and learning. Neural Comput. 13, 2409–2463 (2001).

-

Lewen, G. D., Bialek, W. & de Ruyter van Steveninck,R. R. Neural coding of naturalistic motion stimuli.Network 12, 317–329 (2001).

-

Laughlin, S. B. Efficiency and complexity in neural coding. Novartis Found. Symp. 239, 177–187 (2001).

-

Tipping, M. E. Sparse Bayesian learning and the Relevance Vector Machine. J. Machine Learn. Res. 1, 211–244 (2001).

-

Paus, T., Keshavan, M. & Giedd, J. N. Why do many psychiatric disorders emerge during adolescence? Nature Rev. Neurosci. 9, 947–957 (2008).

-

Gilestro, G. F., Tononi, G. & Cirelli, C. Widespread changes in synaptic markers as a function of sleep and wakefulness in Drosophila. Science 324, 109–112 (2009).

-

Roweis, S. & Ghahramani, Z. A unifying review of linear Gaussian models. Neural Comput. 11, 305–345 (1999).

-

Hebb, D. O. The Organization of Behaviour (Wiley, New York, 1949).

-

Paulsen, O. & Sejnowski, T. J. Natural patterns of activity and long-term synaptic plasticity. Curr. Opin. Neurobiol. 10, 172–179 (2000).

-

von der Malsburg, C. The Correlation Theory of Brain Function. Internal Report 81–82, Dept. Neurobiology, Max-Planck-Institute for Biophysical Chemistry (1981).

-

Singer, W. & Gray, C. M. Visual feature integration and the temporal correlation hypothesis. Annu. Rev. Neurosci. 18, 555–586 (1995).

-

Bienenstock, E. L., Cooper, L. N. & Munro, P. W. Theory for the development of neuron selectivity: orientation specificity and binocular interaction in visual cortex. J. Neurosci. 2, 32–48 (1982).

-

Abraham, W. C. & Bear, M. F. Metaplasticity: the plasticity of synaptic plasticity. Trends Neurosci. 19, 126–130 (1996).

-

Pareti, G. & De Palma, A. Does the brain oscillate? The dispute on neuronal synchronization. Neurol. Sci. 25, 41–47 (2004).

-

Leutgeb, S., Leutgeb, J. K., Moser, M. B. & Moser, E. I. Place cells, spatial maps and the population code for memory. Curr. Opin. Neurobiol. 15, 738–746(2005).

-

Durstewitz, D. & Seamans, J. K. Beyond bistability: biophysics and temporal dynamics of working memory. Neuroscience 139, 119–133 (2006).

-

Anishchenko, A. & Treves, A. Autoassociative memory retrieval and spontaneous activity bumps in small- world networks of integrate-and-fire neurons.J. Physiol. Paris 100, 225–236 (2006).

-

Abbott, L. F., Varela, J. A., Sen, K. & Nelson, S. B. Synaptic depression and cortical gain control. Science 275, 220–224 (1997).

-

Yu, A. J. & Dayan, P. Uncertainty, neuromodulation and attention. Neuron 46, 681–692 (2005).

-

Doya, K. Metalearning and neuromodulation. Neural Netw. 15, 495–506 (2002).

-

Chawla, D., Lumer, E. D. & Friston, K. J. The relationship between synchronization among neuronal populations and their mean activity levels. Neural Comput. 11, 1389–1411 (1999).

-

Fries, P., Womelsdorf, T., Oostenveld, R. & Desimone, R. The effects of visual stimulation and selective visual attention on rhythmic neuronal synchronization in macaque area V4. J. Neurosci. 28, 4823–4835 (2008).

-

Womelsdorf, T. & Fries, P. Neuronal coherence during selective attentional processing and sensory-motor integration. J. Physiol. Paris 100, 182–193 (2006).

-

Desimone, R. Neural mechanisms for visual memory and their role in attention. Proc. Natl Acad. Sci. USA 93, 13494–13499 (1996).A nice review of mnemonic effects (such as repetition suppression) on neuronal responses and how they bias the competitive interactions between stimulus representations in the cortex. It provides a good perspective on attentional mechanisms in the visual system that is empirically grounded.

-

Treisman, A. Feature binding, attention and object perception. Philos. Trans. R. Soc. Lond. B Biol. Sci. 353, 1295–1306 (1998).

-

Maunsell, J. H. & Treue, S. Feature-based attention in visual cortex. Trends Neurosci. 29, 317–322 (2006).

-

Spratling, M. W. Predictive-coding as a model of biased competition in visual attention. Vision Res. 48, 1391–1408 (2008).

-

Reynolds, J. H. & Heeger, D. J. The normalization model of attention. Neuron 61, 168–185 (2009).

-

Schroeder, C. E., Mehta, A. D. & Foxe, J. J. Determinants and mechanisms of attentional modulation of neural processing. Front. Biosci. 6, D672–D684 (2001).

-

Hirayama, J., Yoshimoto, J. & Ishii, S. Bayesian representation learning in the cortex regulated by acetylcholine. Neural Netw. 17, 1391–1400 (2004).

-

Edelman, G. M. Neural Darwinism: selection and reentrant signaling in higher brain function. Neuron 10, 115–125 (1993).

-

Knobloch, F. Altruism and the hypothesis of meta- selection in human evolution. J. Am. Acad. Psychoanal. 29, 339–354 (2001).

-

Friston, K. J., Tononi, G., Reeke, G. N. Jr, Sporns, O. & Edelman, G. M. Value-dependent selection in the brain: simulation in a synthetic neural model. Neuroscience 59, 229–243 (1994).

-

Sutton, R. S. & Barto, A. G. Toward a modern theory of adaptive networks: expectation and prediction. Psychol. Rev. 88, 135–170 (1981).

-

Montague, P. R., Dayan, P., Person, C. & Sejnowski,T. J. Bee foraging in uncertain environments using predictive Hebbian learning. Nature 377, 725–728 (1995).A computational treatment of behaviour that combines ideas from optimal control theory and dynamic programming with the neurobiology of reward. This provided an early example of value learning in the brain.

-

Schultz, W. Predictive reward signal of dopamine neurons. J. Neurophysiol. 80, 1–27 (1998).

-

Daw, N. D. & Doya, K. The computational neurobiology of learning and reward. Curr. Opin. Neurobiol. 16, 199–204 (2006).

-

Redgrave, P. & Gurney, K. The short-latency dopamine signal: a role in discovering novel actions? Nature Rev. Neurosci. 7, 967–975 (2006).

-

Berridge, K. C. The debate over dopamine’s role in reward: the case for incentive salience. Psychopharmacology (Berl.) 191, 391–431 (2007).

-

Sella, G. & Hirsh, A. E. The application of statistical physics to evolutionary biology. Proc. Natl Acad. Sci. USA 102, 9541–9546 (2005).

-

Rescorla, R. A. & Wagner, A. R. in Classical Conditioning II: Current Research and Theory (eds Black, A. H. & Prokasy, W. F.) 64–99 (Appleton Century Crofts, New York, 1972).

-

Bellman, R. On the Theory of Dynamic Programming.Proc. Natl Acad. Sci. USA 38, 716–719 (1952).

-

Watkins, C. J. C. H. & Dayan, P. Q-learning. Mach. Learn. 8, 279–292 (1992).

-

Todorov, E. in Advances in Neural Information Processing Systems (eds Scholkopf, B., Platt, J. & Hofmann T.) 19, 1369–1376 (MIT Press, 2006).

-

Camerer, C. F. Behavioural studies of strategic thinking in games. Trends Cogn. Sci. 7, 225–231 (2003).

-

Smith, J. M. & Price, G. R. The logic of animal conflict.Nature 246, 15–18 (1973).

-

Nash, J. Equilibrium points in n-person games.Proc. Natl Acad. Sci. USA 36, 48–49 (1950).

-

Wolpert, D. M. & Miall, R. C. Forward models for physiological motor control. Neural Netw. 9, 1265–1279 (1996).

-

Todorov, E. & Jordan, M. I. Smoothness maximization along a predefined path accurately predicts the speed profiles of complex arm movements. J. Neurophysiol. 80, 696–714 (1998).

-

Tseng, Y. W., Diedrichsen, J., Krakauer, J. W., Shadmehr, R. & Bastian, A. J. Sensory prediction- errors drive cerebellum-dependent adaptation of reaching. J. Neurophysiol. 98, 54–62 (2007).

-

Bays, P. M. & Wolpert, D. M. Computational principles of sensorimotor control that minimize uncertainty and variability. J. Physiol. 578, 387–396 (2007).A nice overview of computational principles in motor control. Its focus is on representing uncertainty and optimal estimation when extracting the sensory information required for motor planning.

-

Shadmehr, R. & Krakauer, J. W. A computational neuroanatomy for motor control. Exp. Brain Res. 185, 359–381 (2008).

-

Verschure, P. F., Voegtlin, T. & Douglas, R. J. Environmentally mediated synergy between perception and behaviour in mobile robots. Nature 425, 620–624 (2003).

-

Cohen, J. D., McClure, S. M. & Yu, A. J. Should I stay or should I go? How the human brain manages the trade-off between exploitation and exploration. Philos. Trans. R. Soc. Lond. B Biol. Sci. 362, 933–942 (2007).

-

Ishii, S., Yoshida, W. & Yoshimoto, J. Control of exploitation-exploration meta-parameter in reinforcement learning. Neural Netw. 15, 665–687 (2002).

-

Usher, M., Cohen, J. D., Servan-Schreiber, D., Rajkowski, J. & Aston-Jones, G. The role of locus coeruleus in the regulation of cognitive performance. Science 283, 549–554 (1999).

-

Voigt, C. A., Kauffman, S. & Wang, Z. G. Rational evolutionary design: the theory of in vitro protein evolution. Adv. Protein Chem. 55, 79–160 (2000).

-

Freeman, W. J. Characterization of state transitions in spatially distributed, chaotic, nonlinear, dynamical systems in cerebral cortex. Integr. Physiol. Behav. Sci. 29, 294–306 (1994).

-

Tsuda, I. Toward an interpretation of dynamic neural activity in terms of chaotic dynamical systems. Behav. Brain Sci. 24, 793–810 (2001).

-

Jirsa, V. K., Friedrich, R., Haken, H. & Kelso, J. A.A theoretical model of phase transitions in the human brain. Biol. Cybern. 71, 27–35 (1994).This paper develops a theoretical model (based on synergetics and nonlinear oscillator theory) that reproduces observed dynamics and suggests a formulation of biophysical coupling among brain systems.

-

Breakspear, M. & Stam, C. J. Dynamics of aneural system with a multiscale architecture. Philos. Trans. R. Soc. Lond. B Biol. Sci. 360, 1051–1074 (2005).

-

Bressler, S. L. & Tognoli, E. Operational principles of neurocognitive networks. Int. J. Psychophysiol. 60, 139–148 (2006).

-

Werner, G. Brain dynamics across levels of organization. J. Physiol. Paris 101, 273–279 (2007).

-

Pasquale, V., Massobrio, P., Bologna, L. L., Chiappalone, M. & Martinoia, S. Self-organization and neuronal avalanches in networks of dissociated cortical neurons. Neuroscience 153, 1354–1369 (2008).

-

Kitzbichler, M. G., Smith, M. L., Christensen, S. R. & Bullmore, E. Broadband criticality of human brain network synchronization. PLoS Comput. Biol. 5, e1000314 (2009).

-

Rabinovich, M., Huerta, R. & Laurent, G. Transient dynamics for neural processing. Science 321 48–50 (2008).

-

Tschacher, W. & Hake, H. Intentionality in non- equilibrium systems? The functional aspects of self- organised pattern formation. New Ideas Psychol. 25, 1–15 (2007).

-

Maturana, H. R. & Varela, F. De máquinas y seres vivos (Editorial Universitaria, Santiago, 1972). English translation available in Maturana, H. R. & Varela, F. in Autopoiesis and Cognition (Reidel, Dordrecht, 1980).

-

Fiorillo, C. D., Tobler, P. N. & Schultz, W. Discrete coding of reward probability and uncertainty by dopamine neurons. Science 299, 1898–1902 (2003).

-

Niv, Y., Duff, M. O. & Dayan, P. Dopamine, uncertainty and TD learning. Behav. Brain Funct. 1, 6 (2005).

-

Fletcher, P. C. & Frith, C. D. Perceiving is believing: a Bayesian approach to explaining the positive symptoms of schizophrenia. Nature Rev. Neurosci. 10, 48–58 (2009).

-

Phillips, W. A. & Silverstein, S. M. Convergence of biological and psychological perspectives on cognitive coordination in schizophrenia. Behav. Brain Sci. 26, 65–82 (2003).

-

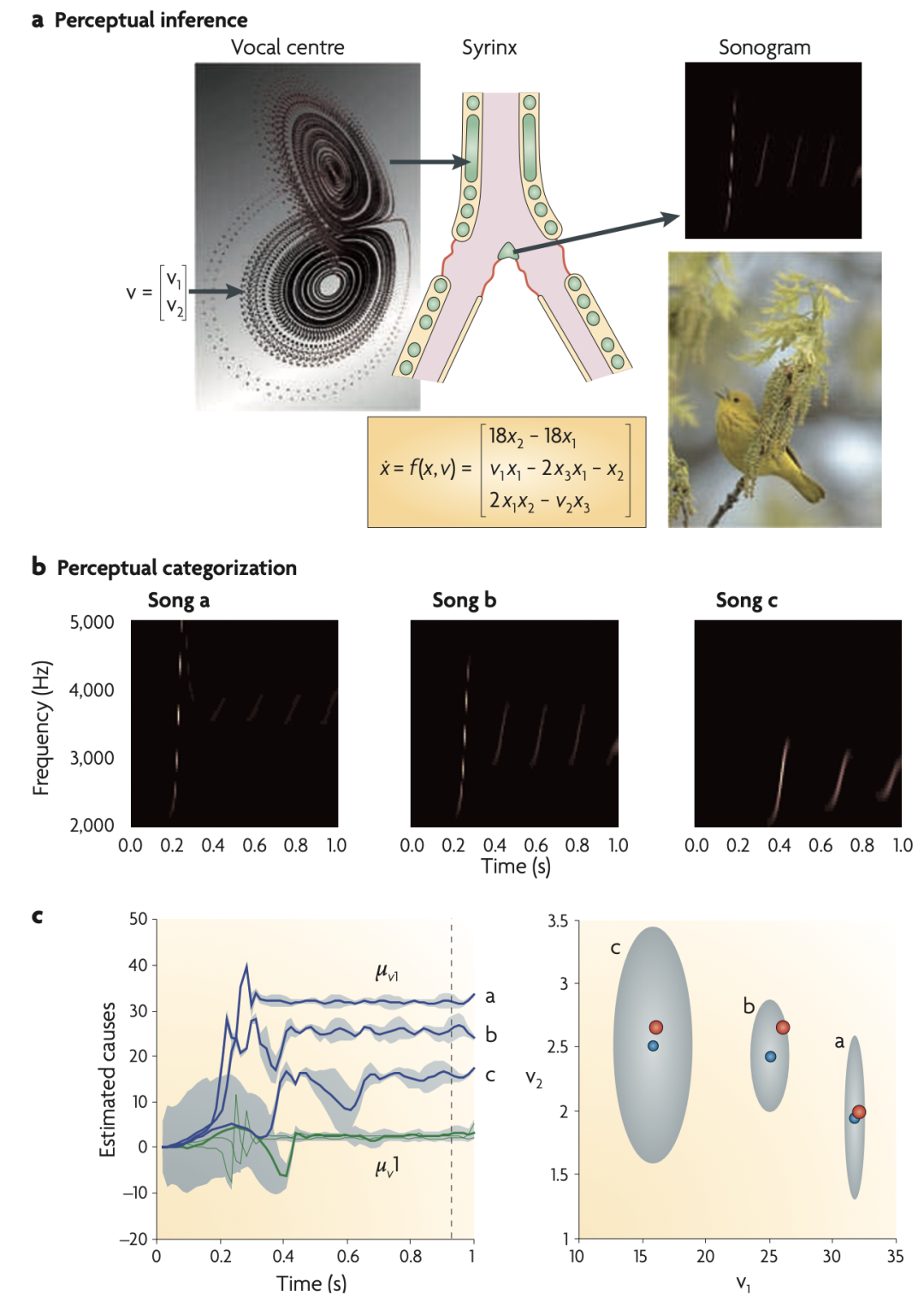

Friston, K. & Kiebel, S. Cortical circuits for perceptual inference. Neural Netw. 22, 1093–1104 (2009).