( tips: 从 Hopfield 模型说起统计物理与深度学习的关系)

—-甄慧玲 理论物理所

提到深度学习和统计物理的关系, 第一个要说的模型就是 Hopfield 模型。 本次笔记的内容就将从 Hopfield 模型说起。 接下来, 我简单的从、统计物理基本模型、 Hopfield 模型中的消息传递算法三个方面说明。

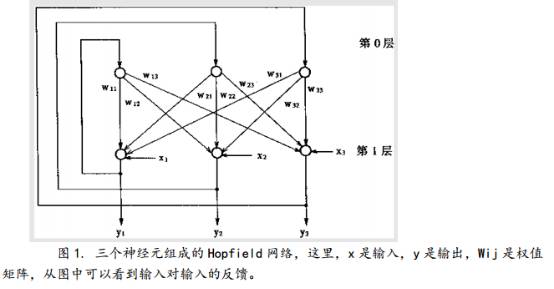

Hopfield 在 1982 年发在 PNAS 上的文章《 Neural networks and physical systems with emergent collective computational abilities》 中提出了可做联想存储器的互联网络, 也就是Hopfield 模型, 当然,这个模型是一个循环神经网络结构, 有输入、 输出和反馈连接。 当然,这个模型分连续型和离散型两种, 但是在这篇文章中他构造的是一个只取 0 和 1 的二值网络, 这里, 0 和 1 分别表示“抑制”和“激活”两种状态。 Hopfield 模型的结构展示在图1在中。

在这里, 稍稍说明一下 Hopfield 模型的工作流程: 由于反馈的作用使得输出端有反馈到其输入端, 所以, Hopfield 网络在输入的激励下,会产生不断的状态变化。当有输入之后,可以求取出 Hopfield 网络的输出,这个输出反馈到输入从而产生新的输出,这个反馈过程一直进行下去。如果网络是一个能收敛的稳定网络,则这个反馈与迭代的计算过程所产生的变化越来越小,一旦到达了稳定平衡状态;那么 Hopfield 网络就会输出一个稳定的恒值。对于一个 Hopfield 网络来说,关键是在于确定它在稳定条件下的权系数。

而后, 从 1984 到 1987 几年间 Hopfield 及其合作者连续在几篇发表在 PNAS 上的文章“Neurons with graded response have collective computational properties like those of two-stateneurons”(PNAS,81,3088-3092)、 “Neural computation by concentrating information in time”(PNAS,84, 1896-1900)和“Learning algorithms and probability distributions in feed-forward and feedback networks”(PNAS, 84, 8429-8433)中讨论了 Hopfield 网络的学习算法。 事实上, 这几篇文章只有最后一篇提到了 Ising 模型, 他认为“Its connection to the physics of a coupled set of two-level units in equilibrium with a thermal bath (like a magnetic system of Ising spins with arbitrary exchange) led it to be termed a Boltzmann network”。 但是,所有的文章,通篇全都从能量函数的角度来提出 update rules…… 更重要的是,从 architecture 的角度来看, Hopfield 网络就是 Ising 模型啊……

事实上, 网上关于 Ising 模型的 materials 很多,例如,

维基百科:

https://en.wikipedia.org/wiki/Ising_model。

集智百科 :

http://wiki.swarma.net/index.php/ISING%E6%A8%A1%E5%9E%8B#ISING.E6.A8.A1.E5.9E.8B.E7.AE.80.E4.BB.8B。

为更清楚的和后面的内容衔接, 我只简单的说明关于 Ising 模型最重要的部分。

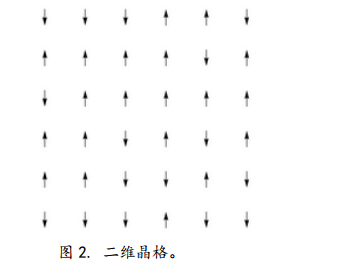

简单的说, 一维 Ising 模型就是 M 个自旋排成一排,每个自旋与其左右两个最近邻的自旋之间有相互作用。 而二维 Ising 模型就是由 N 个相同的自旋排,每个自旋不但与其左右两个最近邻的自旋相互作用,而且与前后相邻的自旋排中两个最近邻的自旋相互作用, 构成了 一个二维的自旋阵列。三维 Ising 模型就是有 L 个相同的二维自旋阵列,每个自旋与其左右、前后、上下六个最近邻的自旋相互作用。不难发现,随着维度的增加,每个自旋的最近邻自旋树木增加,与周围自旋的相互作用也在增强。 因此,截止到目前为止, 只有一维和二维的 Ising模型有精确解。这里所说的自旋在空间有两个量化方向,即向上和向下。

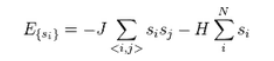

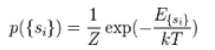

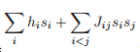

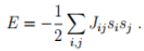

用si来代表每个节点的状态, 很显然,si的取值只有+1 和-1 两种, 方向向上设为+1。这个模型的能量函数是

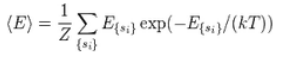

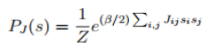

这里, J 是能量耦合常数, H 可以理解为每个自旋上的外场强度( 事实上,如果熟悉Boltzmann Machine 或者 Hopfield 模型的话,就已经可以看出,二维 Ising 模型与这两个模型的关系。 因此, 我非常同意网页上面的一个说法:将小磁针比喻成神经元细胞,向上向下的状态比喻成神经元的激活与抑制,小磁针的相互作用比喻成神经元之间的信号传导,那么,Ising 模型的变种还可以用来建模神经网络系统,从而搭建可适应环境、不断学习的机器; 例如: Hopfield 网络、 Boltzmann 机及其各种 variants)。 而在系统达到平衡时, 其微观构型是{si}的概率为:

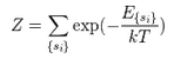

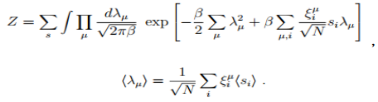

这里, Z 是配分函数, 也有人称之为归一化因子, 其表达式是:

需要多说一句的是,从统计物理的角度来解决深度学习问题,很多时候都会碰到关于配分函

数的计算, 而用不同的统计物理理论所得到的 Z 往往不同, 关于不同的方式的结果的比较,推荐两篇文献:

(1) The Ising Model for Neural Data: Model Quality and Approximate Methods for

Extracting Functional Connectivity, Yasser Roud, Joanna Tyrcha & John Hertz,《 Quantitative Biology》 , 2009, 79(5):711-715.

(2) Mean-field message-passing equations in the Hopfield model and its generalizations, Marc Mezard, 2016.

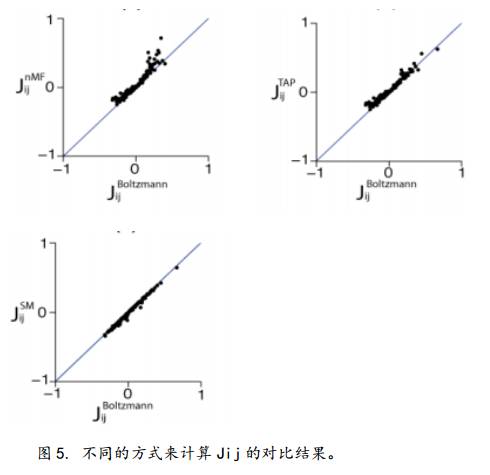

注: 从文献(2)中可以看到,在解决 inverse Ising problem 这个问题上, Thouless-Anderson Palmer 自由能的数值模拟结果优于 naïve mean-field 和 Belief Propagation 这两种方法,而文献(1)中说的是, Sessak-Monasson (SM) Approximation 和 SM 与 TAP 的 hybrid 方法均优于普通的 TAP 自由能。 所谓的 inverse Ising,就是在知道 si的一阶矩和二阶矩的前提下, 来得到H 和 J。 当然,能量 E也可以是这样的结构:

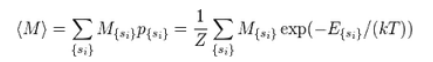

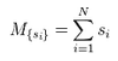

因此,我们可以在这样的一个模型上定义很多物理量: 例如: 系综的平均磁矩:

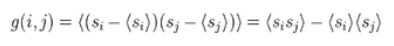

值得一提的是,除了 Ising 模型外, 每个节点取 q 个值的 Potts Model 也值得关注,关于这个模型的基本资料可以参考维基百科: https://en.wikipedia.org/wiki/Potts_model 及其中推荐的经典文献, 这次就不赘述。 而除了 Boltzmann Machine 及其各种 variants 以外, Neural Autoregressive Distribution Estimator 也和统计物理密切相关: 附上这个模型的结构会看的更

清楚(图 3 所示)。 依然推荐阅读文献:

( 1) The Neural Autoregressive Distribution Estimator (模型的构造文献), Hugo Larochelle & Iain Murray, 2011

( 2) Iterative Neural Autoregressive Distribution Estimator (NADE-k), Tapani Raiko Li Yao, KyungHyun Cho & Yoshua Bengio (NADE-k)

( 3) Neural Autoregressive Distribution Estimation, Benigno Uria, Marc-Alexandre Cote, Karol Gregor, Iain Murray & Hugo Larochelle, JMLR, 2016

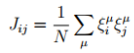

事实上, Hopfield 网络依然可以看成是能量函数为 E 的 energy-based model, 这里, E 的表达式为:

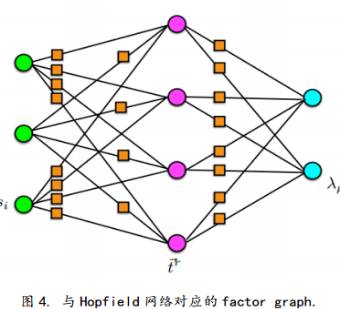

如果用 belief propagation 或者说用 message passing 的方法来研究 Hopfield 网络的话,通常会将 Hopfield 网络转换成 factor graph( 所谓 factor graph,可以理解成之前的节点依然是节点,但是之前的关系变成了关系节点,这样, 在之前的网络中不同的节点之间的消息传递过程,可以看成节点变量和因素变量之间的消息传递过程), 如图 4 所示。

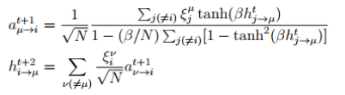

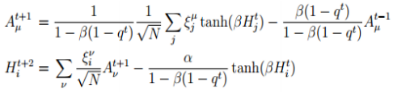

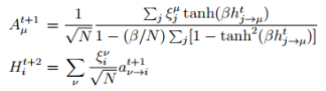

给出因素图以后,就可以利用不同的统计物理方法来给出迭代公式。 例如,如果利用

belief propagation,则有:

而无论是用那种方式来计算配分函数,都是要给出一组迭代关系,迭代收敛时,则可得到我们所需要的配分函数及耦合参数的信息 (这里默认我们可以通过采样知道节点的一阶矩和二阶矩等信息)。 通过对比试验,我们可以看出不同的计算方式结果不同。 具体对比结果如图 5 所示。

更重要的是,相似的思想我们及其国际上其他用统计物理研究深度学习的研究组都用在了 RBM 及其不同的变形的模型训练、 compressed sensing、 encoding-decoding 模型的相关研究中, 相当多的情况下都取得了不错的效果。

让苹果砸得更猛烈些吧!!!

集智著作:《走近2050:注意力、互联网与人工智能》

▼

←识别二维码购买~

←识别二维码购买~

随着人工智能程序AlphaGo以4:1的大比分战胜人类围棋世界冠军李世石,机器将征服人类的担忧正在甚嚣尘上。《走近2050:注意力、互联网与人工智能》则为我们描绘了一幅人机和谐共生、协同演化的全新场景。在看得见的未来,人类将越来越多地沉浸于五花八门的虚拟世界以获取各式体验,与此同时,我们将心甘情愿地将自己的注意力源源不断地输入给机器世界以促使它们进化。

本书从注意力的角度解读了包括互联网、人工智能、众包、人类计算、计算机游戏、虚拟现实在内的技术领域及其对社会生活的影响,还创造性地提出了一系列全新的概念:占意理论、图灵机-参与者模型、“游戏+”时代、意本家、自动游戏设计、自动化创业、占意通货、许愿树,等等。所有这些将为我们理解技术与人类的关系、透视人类社会的未来发展和走向提供深刻的洞察。

长按识别二维码,关注集智Club微信,

让我们离科学探索更近一步。

始发于微信公众号: 集智俱乐部