重磅:我们可以从科学的角度解读意识吗?| Science 综述

机器能否拥有像人类一样的意识?要回答这个问题,首先要探索人类意识是如何产生和存在的。在2017年10月 Science 神经科学特刊的一篇综述中,研究者回顾了三个级别的人类意识:C0 无意识的“自动驾驶模式”,C1 获取信息作出决策,C2 元认知。机器能否达到这三种意识水平?人类意识模式对构建人工智能有何启发?请看这篇长文综述。

作者:Stanislas Dehaene,Hakwan Lau,Sid Kouider

翻译:张锦 (浙江大学行为科学系)

来源:Science

原题:What is consciousness, and could machines have it?

主要内容:

-

意识的多重意义

-

C0 无意识加工

-

C1 总体可用性的相关信息

-

C2 自我监控

-

C1 与 C2 之间的分离状态

摘要

关于机器是否拥有意识,这类具有争议性的问题,必须基于对意识是如何在唯一的物理系统中产生进行认真思考 — 毫无疑问,人类的大脑拥有意识。 因此, 我们建议将“意识”这个词在大脑中合并成两种不同类型的信息加工进行计算:为总体传播选择信息,从而使其灵活地用于计算和报告(C1,第一感觉上的意识),以及有关自我监控的计算,会导致一种主观上的确定感或错误(C2,第二感觉上的意识)。我们认为,尽管, 有关这方面的研究在最近曾取得了成功,但是, 目前的机器主要实施的计算,仍然反映的是人脑的无意识加工过程(C0)。为此, 我们主要回顾了心理学和神经科学中的无意识计算(C0)和有意识计算(C1和C2),并概述它们是如何激发新型的机器架构。

意识的三个维度:

C0:无意识加工 (Unconscious processing)

C1:总体可用性 (Global availability)

C2:自我监控 (Self-monitoring)

我们可以想象,当你正在开车时,突然看到燃油指示灯亮起来了。那么, 这是一个什么样的,复杂的神经元聚合,让你意识到指示灯的闪动?而且, 又是什么让这辆汽车,一个复杂的电子和工程产品,没有意识到这一闪光的警示?这辆汽车会被赋予与我们相似的意识吗?这些问题都能得到科学地解决吗?

现代计算科学的创始人艾伦·图灵(Alan Turing)和约翰·冯·诺依曼(John von Neumann)认为, 机器最终会模仿包括意识在内的大脑的所有能力。人工智能(AI)的最新进展已使这一目标得以实现。在神经生物学的启发下,机器学习的改进导致人工神经网络接近或偶尔超越了人类(1,2)。尽管,这些网络并不能模仿人类大脑实际的生物物理特性,但是, 它们的设计受益于几个神经生物学的见解,包括非线性输入输出函数,具有收敛投射功能的层面和可修改的突触权重(modifiable synaptic weights)。现在, 计算机硬件和训练算法的进展使得这类网络能够对复杂的问题(如机器翻译)进行操作,所获得的成功率, 以前则被认为是一个真正的大脑的特权。那么,机器是否处在意识的边缘呢?

我们认为, 答案是否定的:当前的深度学习网络所实现的计算主要是与人脑中的无意识操作相对应。然而,就像人工神经网络从神经生物学中获得灵感一样,人工意识可能会通过研究人类大脑产生意识的架构而获得进展,然后,再将这些深刻理解转化为计算机算法。我们的目的是, 通过回顾可能与机器相关的, 认知神经科学中意识的各个方面来促进这种进步。

一、意识的多重意义

意识这个词,像许多近代科学以前的术语一样,被广泛赋予不同的意义。在医学方面,它通常指一种非传递性的感觉,被用于评估警觉和清醒度的状态,(如“患者没有意识了”),以充分阐明大脑的警觉机制是一个基本的科学目标,对于我们理解睡眠,麻醉,昏迷或植物人状态等均有重要的影响。由于缺乏篇幅空间,我们在这里就不涉及到这一方面,它对计算的影响似乎也很小:显然,一台机器必须恰当地启动才能正常地运行和计算。

我们认为,区分意识计算的其他两个基本维度是非常有用的。为此,我们使用总体可用性(C1)和自我监控(C2)这样两个术语来标记它们。

C1: 总体可用性

Global availability

这一术语主要是对应于意识的传递意义(如同“司机意识到闪光”)。它指的是,认知系统与特定的思想对象之间的关系,如“油箱指示灯”的心理表征。这一对象似乎被选中要做进一步处理,包括语言和非语言报告。有意识的信息就是在这一意义上成为有机体的总体可用性; 例如,我们可以回想它,并对它采取行动,还可以谈论它。这一感觉与“记住这一信息”具有相同的意义。在一个既定的时间内,将有关思维的,大量的计算机指令变为意识,只有具有总体可用性的信息才能构成了C1意识中的内容。

C2: 自我监控

Self-monitoring

意识的另一个意义是具有反射性。它指的是,认知系统中的一种自我指涉关系(a self-referential relationship),这种关系能够监控自己的加工, 并获得有关自身的信息。人类对自身已经了解了很多,包括诸如身体各器官的布局和位置,他们是否能知道或感知某事,抑或他们是否只是犯了一个错误等各种各样的信息。这种意识通常是与所说的内省introspection相对应,也就是心理学家所说的“元认知”(“meta-cognition”)–即对自己的知识和才能进行内在表征的能力。

我们提出,C1和C2构成了有意识计算的正交维度(orthogonal dimensions)。这并不是说,C1和C2均不涉及重叠的体能基质,事实上,正如我们以下所述,人类的大脑都依赖于前额叶皮质。但是,我们还认为,在经验和概念上,这两者可能也会分开,因为,在没有C2的情况下,还可以有C1,例如,在可报告加工时并没有伴随着准确的元认知;而没有C1的C2, 则是指,在自我监控操作展开时,却没有被有意识地报告。

因此,我们在考虑它们的协同作用之前,就分别考虑这些计算是有益的。此外,还有许多计算既不涉及C1,也不涉及C2,因此,被恰当地称之为“无意识”(简称为C0)。这是图灵的独到见解,即使是复杂的信息加工也可以通过无头脑的自动机来实现。认知神经科学已经证实,那些复杂计算,诸如人脸识别或语音识别,棋类游戏评估,语句解析和意义提取等,都可以在人类大脑中无意识地发生,而上述条件既不具有总体可用性,也不具备自我监控(表1)。

在某种程度上,大脑似乎是将专门的处理器或“模块”并列起来操作,并且我们还认为,这与当前的前馈控制深度学习网络(feedforward deep-learningnetworks)的操作密切对应。接下来,让我们回顾一下人类和动物的大脑是如何加工C0,C1和C2水平计算的实验证据,然后再回到机器上,看它们是如何从对人类大脑结构的理解而获益。

无意识加工(C0):

大部分智能都是无意识的

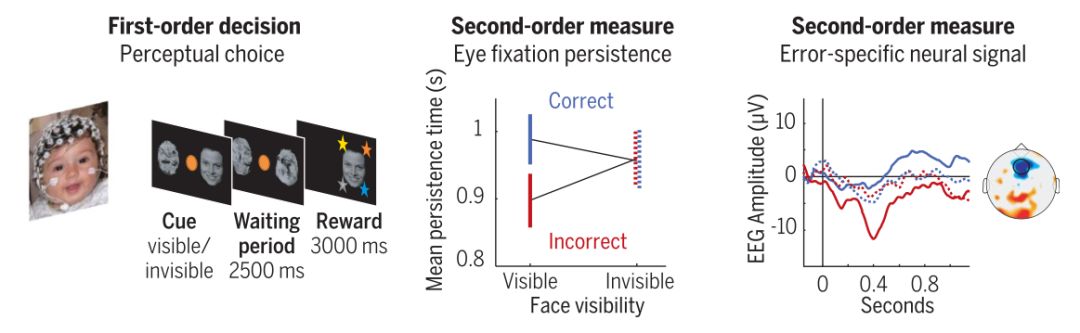

“我们不能察觉我们意识不到的事物”(3),这一真理具有深远的影响。因为,我们对自身无意识的过程还是不了解的,所以,我们倾向于低估自己在心灵生活中的角色。尽管,认知神经科学家们开发了各种呈现图像或声音的方法和手段,但是,依然没有给我们带来任何有意识的体验(图1),后来,这些科学家又使用行为和大脑成像来探测其加工深度。

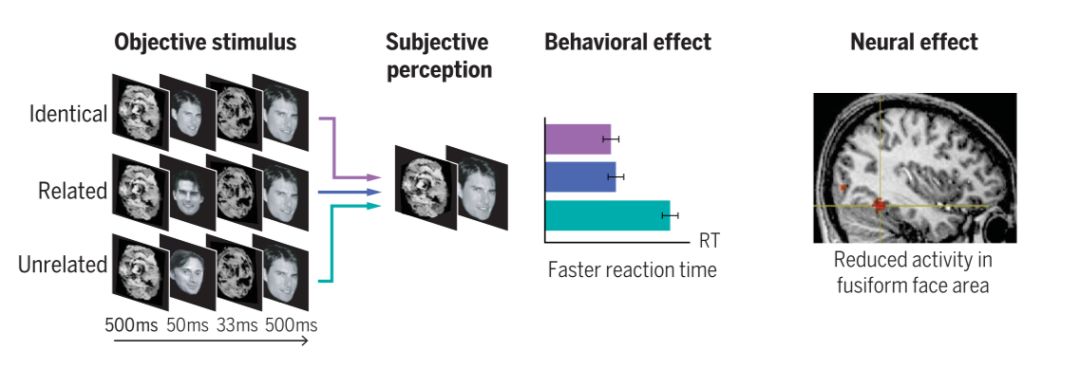

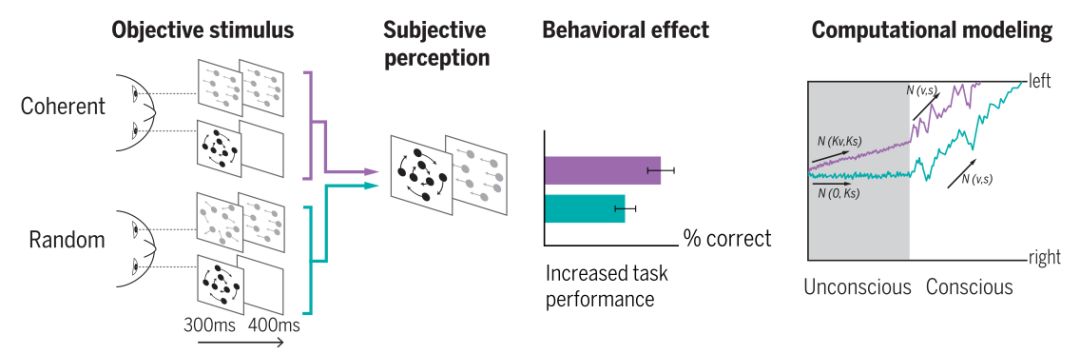

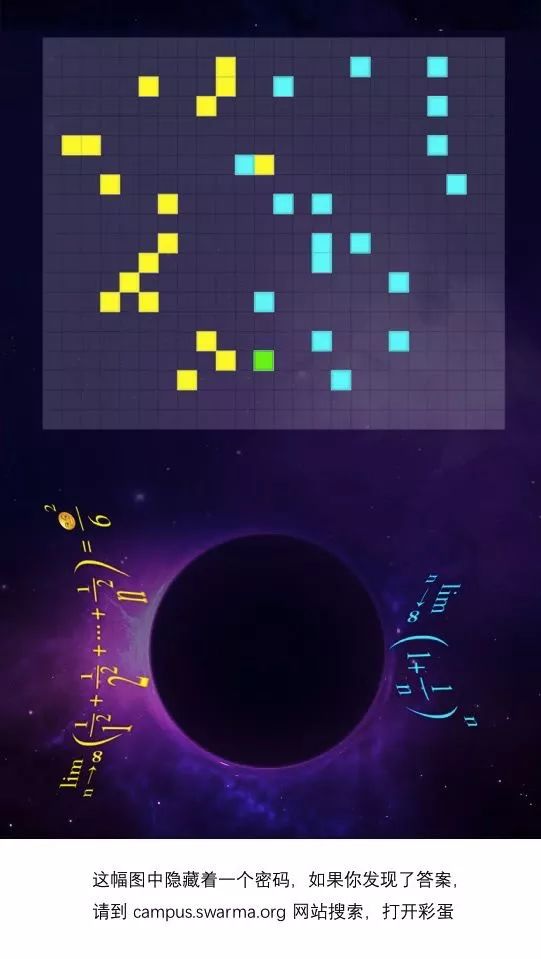

图1探索无意识加工(C0)的实例

(上图)潜意识视图-不变的人脸识别(77)。在每一次试验中,都短暂地呈现一个被面罩遮住的主要面孔(50毫秒),随后是可见的目标面孔(500毫秒)。尽管,主观感知在不同条件下是相同的,但是,无论何时,这两张面孔都代表同一个人,在相同或不同的视图中,加工都得到促进。在行为层面,它体现出,这种视图不变的无意识启动在识别目标人脸时的反应时有所减少。而在神经层面,它则体现出,在人的下颞叶皮质中的纺锤脸面部区域,对目标人脸的皮质反应有所减少(重复抑制)。

(下图)有关双眼抑制期间,证据的潜意识积累(16)。在一只眼睛中所呈现的突出移动点可以防止,在相反的眼睛中灰白的移动点变成有意识的感知。尽管,它们是看不见的,但当它们向同一方向移动时,灰色圆点就会促进性能,作为随后的圆点显示,这是一种与其连贯性的移动量相称的效果。这种促进只影响一个一级任务(判断运动的方向),而不是二级元认知判断(评估第一个反应的信心)。一个证据积累的计算模型提出要将潜意识运动信息添加到有意识的信息中,从而导致决策的偏置和缩短。

总之, 启动现象说明了无意识加工的显著深度。一个高度可见的目标刺激, 诸如书面语“4”, 可先与一个相关的主要刺激,阿拉伯数字“4”之前, 进行更有效的加工,哪怕受试者没有注意到一个主要刺激的存在,也不能可靠地报告其身份。潜意识的数字,话语,人脸或物体可被不变地识别,并影响运动,语义和决策水平的加工(表1)。神经成像方法显示,绝大多数的大脑区域可以被无意识地激活。

人类大脑中无意识的

视图不变性和意义提取

Unconscious view-invariance and meaning extraction in the human brain

最近,人工智能提出许多难度很大的感知计算(perceptual computations),如不变的人脸识别或说话者不变的语音识别,以对应于人脑中的非意识计算(nonconscious computations)(4-6)。例如,在对同一个人完全不同的观点进行潜意识描述之前,加工该人的脸就比较容易,以表明无意识的不变识别(图1)。潜意识启动(Subliminal priming)概括了这种跨视听形式(7,8),从而揭示了人工智能软件(例如,语义向量提取或语音文本)仍然具有挑战性的交叉知觉模式, 同时,也涉及到无意识机制。甚至,感觉输入的语义意义也可以在没有人脑意识的情况下进行加工。与相关词语(例如, 动物-狗)相比较,语义违规(semantic violations)(例如,家具-狗)在颞叶语言网络中的刺激开始发生的400毫秒后,即产生大脑反应,即使,两个单词中的一个不能被有意识地检测到(9, 10)。

无意识的控制和决策

Unconscious control and decision-making

潜意识过程可以达到更深的皮质层次。例如,阈下启动(subliminal primes)可以影响任务选择(11)或运动反应抑制中(12)所涉及的认知控制前额机制。决策的神经机制则包括累积感觉证据,以影响各种选择的概率,直到达到阈值。这种概率性知识的积累, 即使在潜意识刺激下也会持续发生(13-16)。贝叶斯推理和证据累积,是人工智能(2)的基础计算,也是人类基本的无意识机制。

无意识学习

Unconscious learning

强化学习算法(Reinforcement learning algorithms)主要是基于以往的奖励历史, 捕获人类和动物是如何塑造其未来行为,尤其是在玩Go游戏(1)等几个应用程序中已获得了超人类的人工智能性能。值得注意的是,对于人类而言,即使有关线索,奖励或动机信号低于意识阈值(17,18),这种学习似乎也会继续进行。

复杂的无意识计算和推断,通常是在各种大脑区域内并行发生。现在, 许多这样的C0计算已经被人工智能捕获,特别是通过使用前馈卷积神经网络(CNN)。接下来,我们考虑的是,有关有意识加工所需要的附加计算。

C1: 总体可用性的相关信息

对集成和协调的需求

The need for integration and coordination

将大脑组织成专业的计算子系统是卓有成效的,但是, 这种架构也提出了一个具体的计算问题:即整个有机体不能一直坚守多元化的概率解释; 它必须有所行动,从而切断了多重可能性,并决定采取单一的行动方式。要将所有可获得的证据都集成到一个单一的决策中是一种计算要求,我们认为,如此必须面对任何动物或自主的人工智能系统,以符合我们给意识所下的第一个功能定义:总体可用性(C1)。

例如,大象在口渴的时候,总要设法确定离其最近一个水源的位置,并从5到50公里(19)这样的距离直接移动。这样的决策需要一个复杂的架构(i),以更有效地汇集所有可用的信息资源,包括多种感觉器官和记忆线索; (ii)并考虑到这些可用的选项,然后基于这个大型信息库, 最后做出最佳的选择; (iii)同时, 随着时间的推移; (iv)来协调所有内部和外部流程,以实现其目标。

原始生物(primitive organisms),诸如细菌,可能只是通过不协调的感觉运动系统中的,无意识的竞争来实现这种决策。然而,这种解决方案一旦跨越暂时的延迟,并抑制短期倾向,支持长期的制胜策略,就会失败。因此,那种连贯一致的,经过深思熟虑的计划就需要一种特定的C1架构。

进入内部总体工作空间的意识

Consciousness as access to an internal global workspace

我们假设,第一感觉意义中的意识(C1)可演变成为一种解决信息共享问题的信息处理架构(20-23)。在这一观点中,C1的架构逐步打破了无意识计算的模块化和并行性。在专业模块的深层次上,一个容量有限的“总体神经元工作空间”演变成为选择一段信息,然后,随着时间推移,在跨模块间实行分享。我们将此称之为“有意识”,在一个给定的时间内,无论如何,它都能赢得进入这一精神竞技场的竞争,并被选择为总体共享和决策。可见,意识主要表现为,一种念头或一系列念头对心理过程的短暂支配,以便引导各种各样的行为。这些行为不仅包括身体动作,还包括心理活动,例如,提交信息给情景记忆(episodic memory),或按照指定路线将其发送给其它处理器。

意识与注意力之间的关系

Relation between consciousness and attention

威廉·詹姆斯(William James)曾将注意力形容为“一种以清晰而生动的形式从心灵上占有似乎同时可能存在的几个对象或一连串的思想或思路”(24)。这一定义已很接近于我们所说的C1含义:是对进入总体工作空间的单一信息的选择。然而,在最后的步骤,也就是有意识的进入和前注意选择阶段之间有一个明确的区别,即在这个阶段可以无意识地进行操作。

许多实验已经确认,专用的注意力定向机制的存在,并表明,像其他任何处理器一样,它们可以无意识地操作:(i)从自上而下的方向,注意力可以面向对象,增强对其的加工,但却不能使它进入意识(25); (ii) 从自下而上的方向,即使这种刺激最终保持无意识,注意力也能被闪光所吸引(26)。所以,我们所称之的注意力,是一个被无意识操作的分级筛选系统。

在能力有限的系统中

全有或全无选择的证据

Evidence for all-or-none selection in a capacity-limited system

灵长类动物的大脑都包含一个有意识的瓶颈,只能在一次有意识地进入一个单一的项目(表1)。例如,相互竞争的图片或模棱两可的话语被以全有或全无的方式感知着; 在任何给定的时间内,我们在主观上,只能从许多可能的解释中感知到一个单一的解释, [即使其它的解释,仍在被无意识地加工(31,32)]。

集成和发送的证据

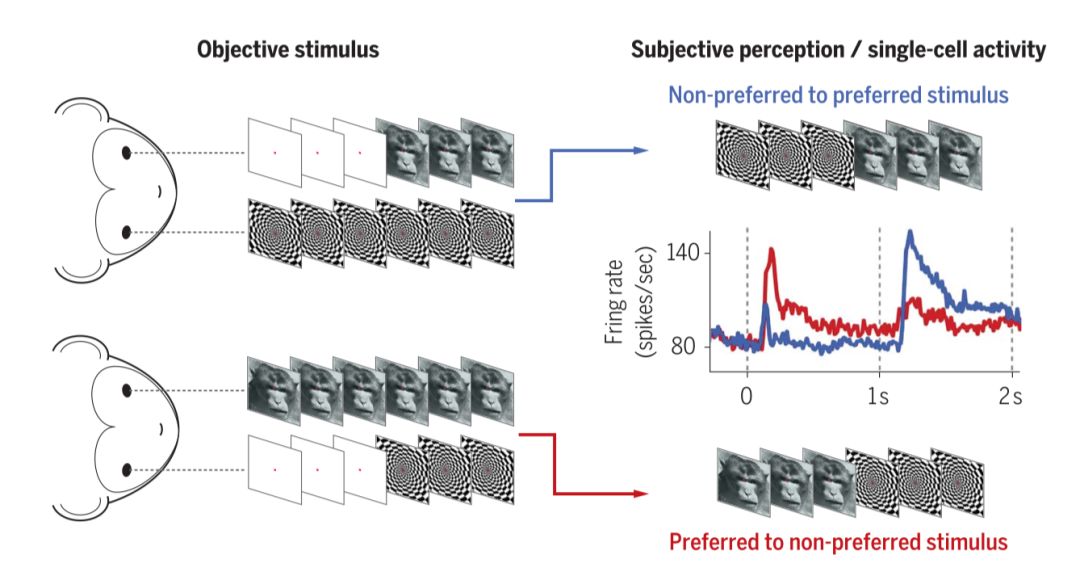

Evidence for integration and broadcasting

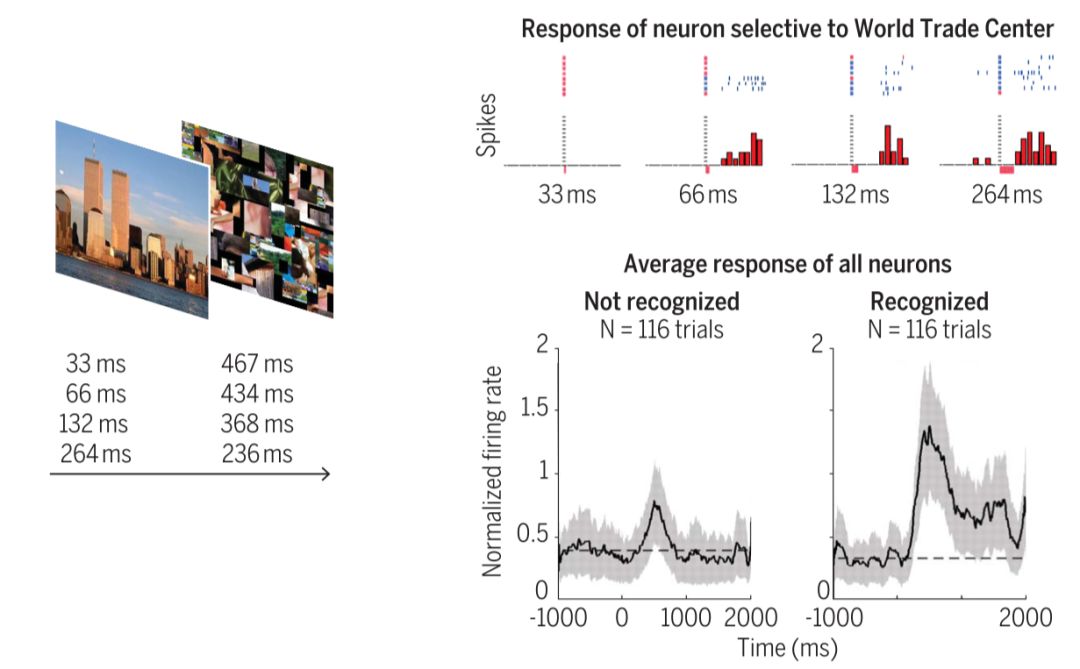

人类的大脑成像和猴子的神经元记录表明,意识的瓶颈是由分布在大脑皮层的神经元网络所造成的,但是, 更着重强调高级的联想区域。表1中所列出的是一些已通过使用各种脑部成像技术,在有意识感知期间已经证实的全有或全无的网络“触燃点”。单细胞记录还表明,每一个特定的意识知觉,如一个人的脸,都是由一组神经元以全有或全无的形式从高水平的颞叶和前额皮质所发出,而其它神经元则保持沉默(图2)(31,32,37,38)。

图2总体可用性:第一感觉意义上的意识(C1)。

有意识的主观感知是被编码在相互连接的高水平大脑皮质区域(包括外侧前额叶皮质,颞叶前皮层和海马体),并为分布在该区域的特定神经刺激群所突然激活。

(上图)在双眼闪光抑制过程中,一张图片对一只眼睛的闪动会抑制第二张图片对另一只眼睛所呈现的,有意识的感知。因此,相同的物理刺激会导致不同的主观感受。这个例子说明,一个对人脸敏感的前额神经元,对跳棋则没有反应,这种激活的喷出与突然爆发的主观面孔感知密切相关(31)。

(下图)在遮蔽过程中,一个闪现的图像,如果时间很短,再戴上一个长“面具”,则可以在主观上保持隐形。如图所示,内嗅皮层中的神经元,有选择地向“世界贸易中心”这一概念实施激活。红色的扫描光栅(Rasters)表示,受试者报告,对试验图片正在识别(蓝色扫描光栅则表示,对图片没有识别)。在遮蔽下,图片只能被呈现33毫秒,此时,已很少或基本没有神经活动; 但是,一旦呈现时间比感知阈值(66毫秒或更多)更长,神经元就会在被识别的尝试中大幅激活。总的来说,即使针对相同的目标输入(相同的持续时间),峰值活动对于那些识别尝试也会越来越高,越来越稳定(38)。

稳定性是意识的特征

Stability as a feature of consciousness

通过直接对比,看见的和看不见的图片或文字, 我们得以证实,这种触发只发生在有意识的知觉上。正如前面所解释的那样,无意识刺激可能会进入深层的皮层网络,并影响到更高层次的加工甚至是中枢执行系统,但是, 这些效应往往是较小的,且易变的和短暂存在, [尽管, 无意识信息的衰减速度比最初的预期要慢许多(39,40]。相比之下,稳定的,可再生的高质量信息在更高级的大脑皮质区, 通过一个分布式活动模式显示出有意识的加工特征(表1)。对于神经系统来说,这种短暂的“元稳定性”(“meta-stability”)似乎需要整合来自各模块的信息,然后再将其发送出来,从而实现灵活的跨模块路径。

人类和非人类动物中的C1意识

C1 consciousness in human and nonhuman animals

C1意识是存在于人类婴儿(41)和动物中的一种基本属性。非人灵长类动物也曾表现出相似的视错觉(31,32),包括注意力眨眼(42)以及如同人类被试者的中枢容量极限(43)。对于人类和非人类灵长类动物而言,前额叶皮质(prefrontal cortex)似乎都做为一种中枢信息共享装置和串行瓶颈[43]。可见,前额叶皮质在人类谱系中的显着扩张可能会导致更大的多模式收敛和集成能力(44-46)。此外,人类的下前额叶皮质还拥有额外的电路,用于口头表示和向其他人报告信息。

通过语言来报告信息的能力被普遍认为是,意识感知最明显的标志之一,因为,一旦信息达到了人类的这种代表性水平,就必然可以在各心理模块间共享,因此,C1感觉是有意识的。虽然, 语言不需要有意识的感知和加工,但是, 人类语言电路的出现可能会导致C1水平信息共享的速度,便捷性和灵活性的显著提高。

C2:自我监控

鉴于C1意识反映了其具有访问外部信息的能力,而第二感觉意义上的意识(C2)则以具有条件反射性地自我表现能力为特征(47-50)。有关认知神经科学和心理学方面的大量研究已经在“元认知”(meta cognition)的术语下提出了自我监控的概念,这一概念被粗略地定义为: 对认知的认知或对认识的认识(cognition about cognition or knowing about knowing)。下面,让我们回顾一下, 灵长类动物大脑自身的监控机制,并侧重它们构建自我反射机器的启示。

信心的概率感

A probabilistic sense of confidence

每当做决定的时候, 人类对自己的选择或多或少都感到一定的自信。信心可以被定义为,是对一个决定或计算是否正确的概率感(51)。人的大脑几乎在任何时候都能感知或做出决定,它还能评估可信度。另外,学习也伴随着一种可量化的信心。人类还会评估他们对自己所学知识的信任程度,并用其来权衡以往的知识与现在的证据(52)。信心可以通过非语言交际的形式进行评估,即通过回顾来测量人类是否坚持自己的最初选择,抑或预期地让自己决定从一项任务中退出,以至连尝试都未曾尝试。这两种测量都曾被用于非人类动物,以表明它们也具有元认知能力(53)。相比之下,现有的大多数神经网络都不具有这一能力:虽然, 它们也可以学习,但它们通常缺乏对所学知识的信度和范围的元常识(meta-knowledge)。

一个明显的例外是依赖贝叶斯机制的生物约束模型(biologically constrained models),用来模拟神经电路中多个概率线索的集成(54)。这些模型在描述神经群体如何自动计算一个指定过程执行的成功概率方面已经取得丰硕的成果。尽管,这些实施仍然很少见,而且也没有像传统的人工智能那样解决相同范围的计算问题,但是,它们毕竟为将不确定的监控结合到深度学习网络中提供了一个有希望的检验场所。

对前额皮质的明确信任

Explicit confidence in prefrontal cortex

根据贝叶斯计算,每个局部皮质电路可以表示和组合概率分布,以评估处理的不确定性(54)。然而,为了明确地提取和操纵信任信号,可能需要额外的神经电路。人类的核磁共振成像(MRI)研究和灵长类动物,甚至包括大鼠身上的生理记录都将这种信任处理与前额皮质(prefrontal cortex)特别地连接在一起(55-57)。前额皮质的失活可以诱发二级(元认知)判断的特定缺陷,同时保留一级任务的表现(56,58)。因此,前额皮质的电路可能已逐步进化到可监控其他大脑处理进程的表现。

误差检测:显示一个人自身的错误

Error detection: Reflecting on one’s own mistakes

误差检测提供了一个特别明显的,有关自我监控的例子; 在收到回应之后,我们有时会意识到,我们犯了错误,因此,改变了主意。误差检测是通过脑电图(EEG)活动的两个组成部分显示出来:误差的负相关性(ERN)和误差正性(Pe),它们在收到任何反馈之前,即一个错误的反应之后,就出现在皮层和前额皮质内侧。

人的大脑怎么会犯错误呢,又是怎样察觉的呢?一种可能性是,在做出决定之后,感觉证据的积累仍在继续进行,而当进一步的证据指向相反的方向时,错误就被推断出来(59)。第二种可能性则是,二个并联电路,即一个低级的感觉电路和一个高级的意图电路,与误差检测的显著速度更加相容,无论其结论是多么不同,均对相同的感觉数据发生作用(60,61)。

元记忆

Meta-memory

人类不只是了解世界上的各种事情,他们实际上也了解,自己可了解的事情或自己不了解的事情。一个熟悉的例子是“在舌尖上”这个词。“元记忆”(Meta-memory)这一术语的创造,就是为了说明人类对自己的记忆有着认识,信任和质疑的感觉。元记忆也被认为是,涉及到二阶系统,可通过监控内部信号(例如,记忆痕迹的强度和质量)来调节行为。元记忆与前额结构有关,其药理作用失活会导致元认知障碍,同时失去了记忆表现本身(56)。元记忆对人类学习和教育至关重要,它允许学习者开发学习策略,诸如增加学习量或调节分配给记忆编码和训练的时间(49)。

现实监控

Reality monitoring

除了监控感觉和记忆再现的质量之外,人类大脑还必须能区分自我生成和外部驱动的表征。事实上,我们可以感知事物,但是,我们也可以通过想象力或记忆联想起它们。而精神分裂症的幻觉则与不能正确区分感知活动是自己产生还是由外部世界生成有关(62)。所谓神经成像(Neuroimaging) 研究已将这种现实监控与前额皮质联系起来(63)。在非人类动物中,前额皮质中的神经元可区分正常的视觉感知和记忆中相同视觉内容的活跃维持(64)。

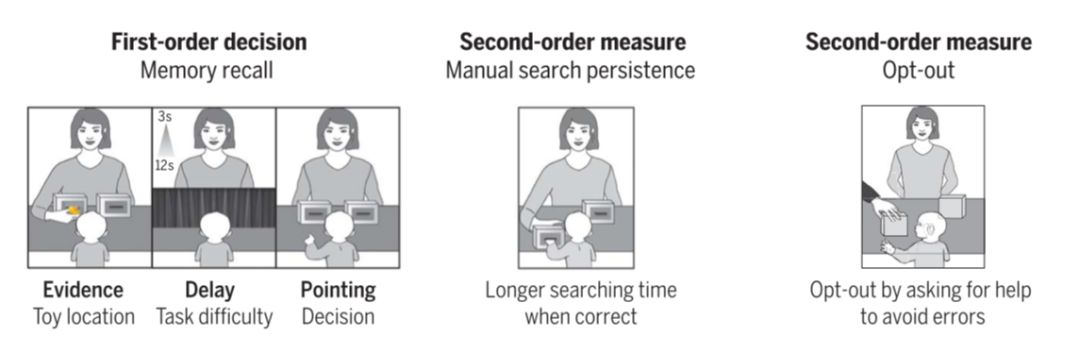

婴儿的C2意识的基础

Foundations of C2 consciousness in infants

自我监控是一种基本能力,它在婴儿期就已经存在(图3)。当1岁的婴儿在一个感知决策任务中做出错误的选择时,我们即会观察到ERN, 即误差监控(65)。同样,一岁半的婴儿为了获得一个隐藏的玩具,在指向两个盒子中的一个后,当他们的初始选择是正确的时候,他们要比做出错误的选择等待更长的时间以获得即将到来的奖励(比如玩具),这表明,他们有可能已监控到自己的决定是正确的(57,65)。此外,如果有机会(以非语言的形式)询问父母的帮助,他们会选择不参加这一选项,特别是在他们有可能出错的尝试中,以展现对他们自身的不确定性的预期估计(66)。

婴儿们还可以把自己的不确定性传达给其他人,这进一步表明,他们能有意识地体验元认知信息(meta-cognitive information)。由此,可以看出,婴儿已经具备监控自己心理状态的能力。面对一个一切仍有待学习和了解的世界,C2机制允许他们积极地定向他们所知和所不知的领域–即一个我们称之为“好奇”的机制。

图3自我监控:第二感觉(C2)上的意识。

自我监控(Self-monitoring)(也称为“元认知”),是反映一个人自身心理状态的一种能力,在婴儿期就可获得。

(上图)一岁半的婴儿在决定指出某个玩具的隐藏位置之后,显示出有关其具有自我监控决定的两种类型的证据。(i) 当他们认为最初的选择是正确的时候,他们在已选择的盒子里搜寻隐藏对象的时间,要比在不正确的时候持续更长。(ii)当他们有机会寻求帮助时,他们会有选择地使用这一选项以减少发生错误的概率。

(下图)向一岁的婴儿展现一种无意义的模式或一张可见或不可见的脸(视其持续时间而定),然后再决定,向左或向右凝视,以期待这张脸再现。对于手动搜索来说,与错误的初始决定相比,在相同的凝视位置等待后决定的时间将更久。此外,当婴儿做出不正确的选择时,脑电图(EEG)信号也揭示了,在额中枢电极上存在着与误差相关的消极性。这些元认知标记是由可见的,而不是由不可见的刺激所引起,这在成人中也是如此(61)。

C1和C2之间的分离状态

根据我们的分析, C1和C2在很大程度上是我们称之为意识的正交和互补维度。在这种双重分离的一方,自我监控可为不可报告的刺激而存在(没有C1的C2)。自动打字为此提供了一个很好的实例:人们在打错之后,会自动慢下来,即使没有有意识地关注这一错误(67)。同样,在神经层面,ERN现象可以在主观尚未检测到错误时就发生了(68)。

在这种分离的另一方,那种有意识地可报告的内容,有时,并不带有足够的信任感(如,没有C2 的C1)。例如,当我们检索一个记忆时,它会突然跳入到意识中(C1),但时常对这种信任(C2)并任何做任何准确的评估,从而导致错误的记忆。正如马文·明斯基(Marvin Minsky)所指出的那样,“我们所谓的意识(在C1感觉上)是部分大脑对正在做的一些事情的一个非常不完美的总结”。这一缺陷,在某种程度上,来自于这样的事实,即总体工作空间在对一个单一的意识样本进行概率计算时减少了复杂的并行感觉流(27-29)。因此,概率信息经常会在途中丢失,而被试对于他们的感知准确性,却感到过于自信。

赋予机器以C1和C2意识

Endowing machines with C1 and C2

机器如何被赋予C1和C2意识以进行计算?让我们再回到汽车燃油指示器的例子。在当前的机器中,“汽油不足灯光显示”是一种典型的无意识模块化信号实例(C0)。当燃油指示灯不断闪烁时,机器中其它的处理器却仍保持不知和不变; 燃料继续注入汽化器中,汽车甚至径直穿过那些加油站而不停(尽管,这些加油站都可能显示在GPS地图上)。

目前的汽车或手机仅仅是特定模块的集合,这些模块在很大程度上,彼此间是不共享信息的。赋予这台机器以总体信息可用性(global information availability)(C1)将允许这些模块共享信息,并协作解决即将发生的问题(很像,人类在意识到灯光闪动时所做或饥渴的大象所做)。

尽管,人工智能在解决具体问题方面已经取得了很大的成功,但在一个单一的系统中实施多个流程,并灵活地协调它们,仍然是一个难题。在20世纪60年代,被称为“黑板系统”(“blackboard systems”)的计算架构是专门用于发布信息,并以一种灵活和可说明的方式提供给其他模块使用,这与当前的总体工作空间就很相似(20)。

最近,一种被称之为Pathnet的架构,即使用遗传算法,并通过其许多专用神经网络来学习,以得出哪条路径最适合一个特定的任务(72)。这一架构展现出强大的,灵活的性能和跨任务模块的泛化,这可能构成机器具有灵长类的灵活性意识的第一步。

为了更好地利用燃油指示器所提供的信息,让汽车拥有可显示自己的油量和极限的数据库将是非常有益的。这样的自我监控(C2)将包括自身的,互相协调的图像–如当前位置和燃料消耗。以及其内部数据库(诸如“知道”它拥有一个可定位加油站的GPS地图)。

当今,大多数机器学习系统都缺乏自我监控; 他们的计算(C0)并不能代表其知识的范围和限度,或者说,他人可能有与其不同的观点。

但也有些例外:贝叶斯网络(Bayesian networks)(54)或程序(73)是通过概率分布进行计算的,那么,怎么能追踪它们的正确性。即使,主要计算由传统的CNN来完成,对内省来说,也是不透明的,所以,我们可以对第二层级较高的神经网络进行训练,以预测第一个人的表现(47)。这种方法声称,在一个系统中重新描述自己会导致“内部模型的出现,而这些模型本质上是元认知的,并且使代理人有可能开发一种(有限的,内隐的和实际的)对自身的理解”(48)。

Pathnet(72)使用一个相关的架构来跟踪在一个特定任务中的内部构形是最成功的,并利用这一知识来指导后续处理。机器人也被编程用来监控其学习进度,并利用它确定有关问题的资源,以最大化地获取信息,从而实现一种好奇心(74)。

较少受到关注的,C2的一个重要功能是现实监控。人工智能的贝叶斯方法(2,73)已经认识到,学习生成模型(learning generative models)的效益,可以共同适用于实际感知(现在),预期计划(未来)和回顾性分析(过去)。在人类中,感知和想象均涉及到相同的感官领域。

因此,我们需要一些机制来区分自我生成和外部触发的活动。一种强大的训练生成模型的方法称之为对抗学习(adversarial learning)(75),这涉及到一个二级网络与一个生成网络的“竞争”,以便批评性地评估自生表征的真实性。当这种现实监控(C2)与C1机制相结合时,由此, 产生的机器可能更接近模仿人类意识,从而在总体范围内获得知觉表征,并直接意识到,其内容是对当前世界现状的真实反映。

结论

我们的立场是基于这样一个简单的假设:我们所说的“意识”来源于特定类型的信息加工计算,从生理上看,这些计算是由大脑的硬件所实现的。它与其他理论所不同的是,其计算是坚决的,执意的; 我们推测,仅靠信息理论量(76)是不足以定义意识,除非,我们也考虑到,正在加工的信息的性质和深度。

我们还认为,一台被赋予C1和C2意识的机器,其表现就如同具有意识; 例如,它会知道,它正在看什么,并表现出一种自信,再向他人报告,当其监督机制崩溃时,它还可能体验到幻觉,甚至会经历与人类相同的那种错觉(perceptual illusions)。尽管如此,给这种意识下一个纯粹的功能性定义,可能,仍然会令某些读者感到不满意。我们是不是可以通过这类假设,一些高级认知功能是否必然要与意识发生联系,从而使意识“过度理性化”?我们能否先不考虑那些经验成分(例如,“什么是有意识的”)?还有,一些主观体验可否避开计算的定义?

虽然,这些哲学问题不在本文的讨论范围内,但是,我们在实证中会注意到,在人类中, C1和C2计算的损失是由于主观经验的丧失而造成的。例如,对于人类而言,对初级视觉皮层的损害可能会导致一种称为“盲视”的神经性病症,在这种情况下,患者会报告,在受影响的视野中失明。值得注意的是,这些患者可以在他们的盲区中定位视觉刺激,却不报告它们(C1),也不能有效地评估其成功的可能性(C2) — 他们认为,他们只是“猜测”。在这个例子中,主观经验似乎与拥有C1和C2有关。虽然,几个世纪的哲学二元论(philosophical dualism)会导致我们把意识看作是不可还原的物理作用,但是,实验证据与意识的可能性则是一致的,即意识只能通过特定的计算而产生。

参考文献

-

D. Silver et al., Nature 529, 484–489 (2016).

-

B. M. Lake, T. D. Ullman, J. B. Tenenbaum, S. J. Gershman, Behav. Brain Sci. 2016, 1–101 (2016).

-

J. Jaynes, The Origin of Consciousness in the Breakdown of the Bicameral Mind (Houghton Mifflin Company, 1976).

-

S. Kouider, E. Dupoux, Psychol. Sci. 16, 617–625 (2005).

-

S. Kouider, S. Dehaene, Philos. Trans. R. Soc. Lond. B Biol. Sci. 362, 857–875 (2007).

-

E. Qiao et al., Neuroimage 49, 1786–1799 (2010).

-

N. Faivre, L. Mudrik, N. Schwartz, C. Koch, Psychol. Sci. 25, 2006–2016 (2014).

-

S. Kouider, S. Dehaene, Exp. Psychol. 56, 418–433 (2009).

-

S. J. Luck, E. K. Vogel, K. L. Shapiro, Nature 383, 616–618 (1996).

-

S. van Gaal et al., Philos. Trans. R. Soc. Lond. B Biol. Sci. 369, 20130212 (2014).

-

H. C. Lau, R. E. Passingham, J. Neurosci. 27, 5805–5811 (2007).

-

S. van Gaal, V. A. Lamme, J. J. Fahrenfort, K. R. Ridderinkhof, J. Cogn. Neurosci. 23, 91–105 (2011).

-

F. P. de Lange, S. van Gaal, V. A. Lamme, S. Dehaene, PLOS Biol. 9, e1001203 (2011).

-

D. Vorberg, U. Mattler, A. Heinecke, T. Schmidt, J. Schwarzbach, Proc. Natl. Acad. Sci. U.S.A. 100, 6275–6280 (2003).

-

S. Dehaene et al., Nature 395, 597–600 (1998).

-

A. Vlassova, C. Donkin, J. Pearson, Proc. Natl. Acad. Sci. U.S.A.111, 16214–16218 (2014).

-

M. Pessiglione et al., Neuron 59, 561–567 (2008).

-

M. Pessiglione et al., Science 316, 904–906 (2007).

-

L. Polansky, W. Kilian, G. Wittemyer, Proc. Biol. Sci. 282, 20143042 (2015).

-

B. Baars, A Cognitive Theory of Consciousness (Cambridge Univ. Press, 1988).

-

S. Dehaene, M. Kerszberg, J. P. Changeux, Proc. Natl. Acad. Sci. U.S.A. 95, 14529–14534 (1998).

-

D. Dennett, Cognition 79, 221–237 (2001).

-

S. Dehaene, L. Naccache, Cognition 79, 1–37 (2001).

-

W. James, The Principles of Psychology (Holt, 1890).

-

L. Naccache, E. Blandin, S. Dehaene, Psychol. Sci. 13, 416–424 (2002).

-

R. W. Kentridge, C. A. Heywood, L. Weiskrantz, Proc. Biol. Sci. 266, 1805–1811 (1999).

-

C. L. Asplund, D. Fougnie, S. Zughni, J. W. Martin, R. Marois, Psychol. Sci. 25, 824–831 (2014).

-

E. Vul, D. Hanus, N. Kanwisher, J. Exp. Psychol. Gen. 138, 546–560 (2009).

-

R. Moreno-Bote, D. C. Knill, A. Pouget, Proc. Natl. Acad. Sci. U.S.A. R. Moreno-Bote, D. C. Knill, A. Pouget, Proc. Natl. Acad. Sci. U.S.A.

-

E. Vul, M. Nieuwenstein, N. Kanwisher, Psychol. Sci. 19, 55–61 (2008).

-

T. I. Panagiotaropoulos, G. Deco, V. Kapoor, N. K. Logothetis, Neuron 74, 924–935 (2012).

-

N. K. Logothetis, Philos. Trans. R. Soc. Lond. B Biol. Sci. 353, 1801–1818 (1998).

-

C. Sergent, S. Baillet, S. Dehaene, Nat. Neurosci. 8, 1391–1400 (2005).

-

S. Marti, M. Sigman, S. Dehaene, Neuroimage 59, 2883–2898 (2012).

-

S. Marti, J.-R. King, S. Dehaene, Neuron 88, 1297–1307 (2015).

-

M. Nieuwenstein, E. Van der Burg, J. Theeuwes, B. Wyble, M. Potter, J. Vis. 9, 1–14 (2009).

-

G. Kreiman, I. Fried, C. Koch, Proc. Natl. Acad. Sci. U.S.A. 99, 8378–8383 (2002).

-

R. Q. Quiroga, R. Mukamel, E. A. Isham, R. Malach, I. Fried, Proc. Natl. Acad. Sci. U.S.A. 105, 3599–3604 (2008).

-

J.-R. King, N. Pescetelli, S. Dehaene, Neuron 92, 1122–1134 (2016).

-

D. Trübutschek et al., eLife 6, e23871 (2017).

-

S. Kouider et al., Science 340, 376–380 (2013).

-

R. T. Maloney, J. Jayakumar, E. V. Levichkina, I. N. Pigarev, T. R. Vidyasagar, Exp. Brain Res. 228, 365–376 (2013).

-

K. Watanabe, S. Funahashi, Nat. Neurosci. 17, 601–611 (2014).

-

G. N. Elston, Cereb. Cortex 13, 1124–1138 (2003).

-

F.-X. Neubert, R. B. Mars, A. G. Thomas, J. Sallet, M. F. S. Rushworth, Neuron 81, 700–713 (2014).

-

L. Wang, L. Uhrig, B. Jarraya, S. Dehaene, Curr. Biol. 25, 1966–1974 (2015).

-

A. Cleeremans, B. Timmermans, A. Pasquali, Neural Netw. 20, 1032–1039 (2007).

-

A. Cleeremans, Cogn. Sci. 38, 1286–1315 (2014).

-

J. Dunlosky, J. Metcalfe, Metacognition (Sage Publications, 2008).

-

A. Clark, A. Karmiloff-Smith, Mind Lang. 8, 487–519 (1993).

-

F. Meyniel, D. Schlunegger, S. Dehaene, PLOS Comput. Biol. 11, e1004305 (2015).

-

F. Meyniel, S. Dehaene, Proc. Natl. Acad. Sci. U.S.A. 114, E3859–E3868 (2017).

-

J. D. Smith, Trends Cogn. Sci. 13, 389–396 (2009).

-

W. J. Ma, J. M. Beck, P. E. Latham, A. Pouget, Nat. Neurosci. 9, 1432–1438 (2006).

-

S. M. Fleming, R. S. Weil, Z. Nagy, R. J. Dolan, G. Rees, Science 329, 1541–1543 (2010).

-

K. Miyamoto et al., Science 355, 188–193 (2017).

-

A. Kepecs, N. Uchida, H. A. Zariwala, Z. F. Mainen, Nature 455, 227–231 (2008).

-

E. Rounis, B. Maniscalco, J. C. Rothwell, R. E. Passingham, H. Lau, Cogn. Neurosci. 1, 165–175 (2010).

-

A. Resulaj, R. Kiani, D. M. Wolpert, M. N. Shadlen, Nature 461, 263–266 (2009).

-

L. Charles, J.-R. King, S. Dehaene, J. Neurosci. 34, 1158–1170 (2014).

-

L. Charles, F. Van Opstal, S. Marti, S. Dehaene, Neuroimage 73, 80–94 (2013).

-

C. D. Frith, The Cognitive Neuropsychology of Schizophrenia (Psychology Press, 1992).

-

J. S. Simons, J. R. Garrison, M. K. Johnson, Trends Cogn. Sci. 21, 462–473 (2017).

-

D. Mendoza-Halliday, J. C. Martinez-Trujillo, Nat. Commun. 10.1038/ncomms15471 (2017).

-

L. Goupil, S. Kouider, Curr. Biol. 26, 3038–3045 (2016).

-

L. Goupil, M. Romand-Monnier, S. Kouider, Proc. Natl. Acad. Sci. U.S.A. 113, 3492–3496 (2016).

-

G. D. Logan, M. J. Crump, Science 330, 683–686 (2010).

-

S. Nieuwenhuis, K. R. Ridderinkhof, J. Blom, G. P. Band, A. Kok, Psychophysiology 38, 752–760 (2001).

-

B. Bahrami et al., Science 329, 1081–1085 (2010).

-

R. S. Siegler, J. Exp. Psychol. Gen. 117, 258–275 (1988).

-

V. de Gardelle, P. Mamassian, Psychol. Sci. 25, 1286–1288 (2014).

-

C. Fernando, D. Banarse, C. Blundell, Y. Zwols, D. Ha, A. A. Rusu, A. Pritzel, D. Wierstra, arXiv:170108734 [cs.NE] (2017).

-

J. B. Tenenbaum, C. Kemp, T. L. Griffiths, N. D. Goodman, Science 331, 1279–1285 (2011).

-

J. Gottlieb, P.-Y. Oudeyer, M. Lopes, A. Baranes, Trends Cogn. Sci. 17, 585–593 (2013).

-

I. J. Goodfellow, J. Pouget-Abadie, M. Mirza, B. Xu, D. Warde-Farley, S. Ozair, A. Courville, Y. Bengio, Generative Adversarial Networks. arXiv:14062661 [stat.ML] (2014).

-

G. Tononi, M. Boly, M. Massimini, C. Koch, Nat. Rev. Neurosci. 17, 450–461 (2016).

-

S. Kouider, E. Eger, R. Dolan, R. N. Henson, Cereb. Cortex 19, 13–23 (2009).

-

S. Dehaene et al., Nat. Neurosci. 4, 752–758 (2001).

-

P. Vuilleumier et al., Proc. Natl. Acad. Sci. U.S.A. 98, 3495–3500 (2001).

-

A. Kiesel, W. Kunde, C. Pohl, M. P. Berner, J. Hoffmann, J. Exp. Psychol. Learn. Mem. Cogn. 35, 292–298 (2009).

-

M. Aly, A. P. Yonelinas, PLOS ONE 7, e30231 (2012).

-

I. M. Harlow, A. P. Yonelinas, Memory 24, 114–127 (2016).

-

H. L. Pincham, H. Bowman, D. Szucs, Cortex 81, 35–49 (2016).

-

C. Sergent, S. Dehaene, Psychol. Sci. 15, 720–728 (2004).

-

A. Del Cul, S. Baillet, S. Dehaene, PLOS Biol. 5, e260 (2007).

-

R. Marois, D. J. Yi, M. M. Chun, Neuron 41, 465–472 (2004).

-

C. Moutard, S. Dehaene, R. Malach, Neuron 88, 194–206 (2015).

-

H. G. Rey, I. Fried, R. Quian Quiroga, Curr. Biol. 24, 299–304 (2014).

-

A. Schurger, I. Sarigiannidis, L. Naccache, J. D. Sitt, S. Dehaene, Proc. Natl. Acad. Sci. U.S.A. 112, E2083–E2092 (2015).

-

C. Sergent et al., Curr. Biol. 23, 150–155 (2013).

-

J. Sackur, S. Dehaene, Cognition 111, 187–211 (2009).

-

R. Marois, J. Ivanoff, Trends Cogn. Sci. 9, 296–305 (2005).

-

P. Barttfeld et al., Proc. Natl. Acad. Sci. U.S.A. 112, 887–892 (2015).

-

W. J. Gehring, B. Goss, M. G. H. Coles, D. E. Meyer, E. Donchin, Psychol. Sci. 4, 385–390 (1993).

编辑:集智小仙女

原文地址:http://science.sciencemag.org/content/358/6362/486

(底部有彩蛋)

推荐阅读

推荐课程

扫码听课

集智QQ群|292641157

商务合作及投稿转载|swarma@swarma.org

◆ ◆ ◆

搜索公众号:集智俱乐部

加入“没有围墙的研究所”

让苹果砸得更猛烈些吧!

始发于微信公众号: 集智俱乐部