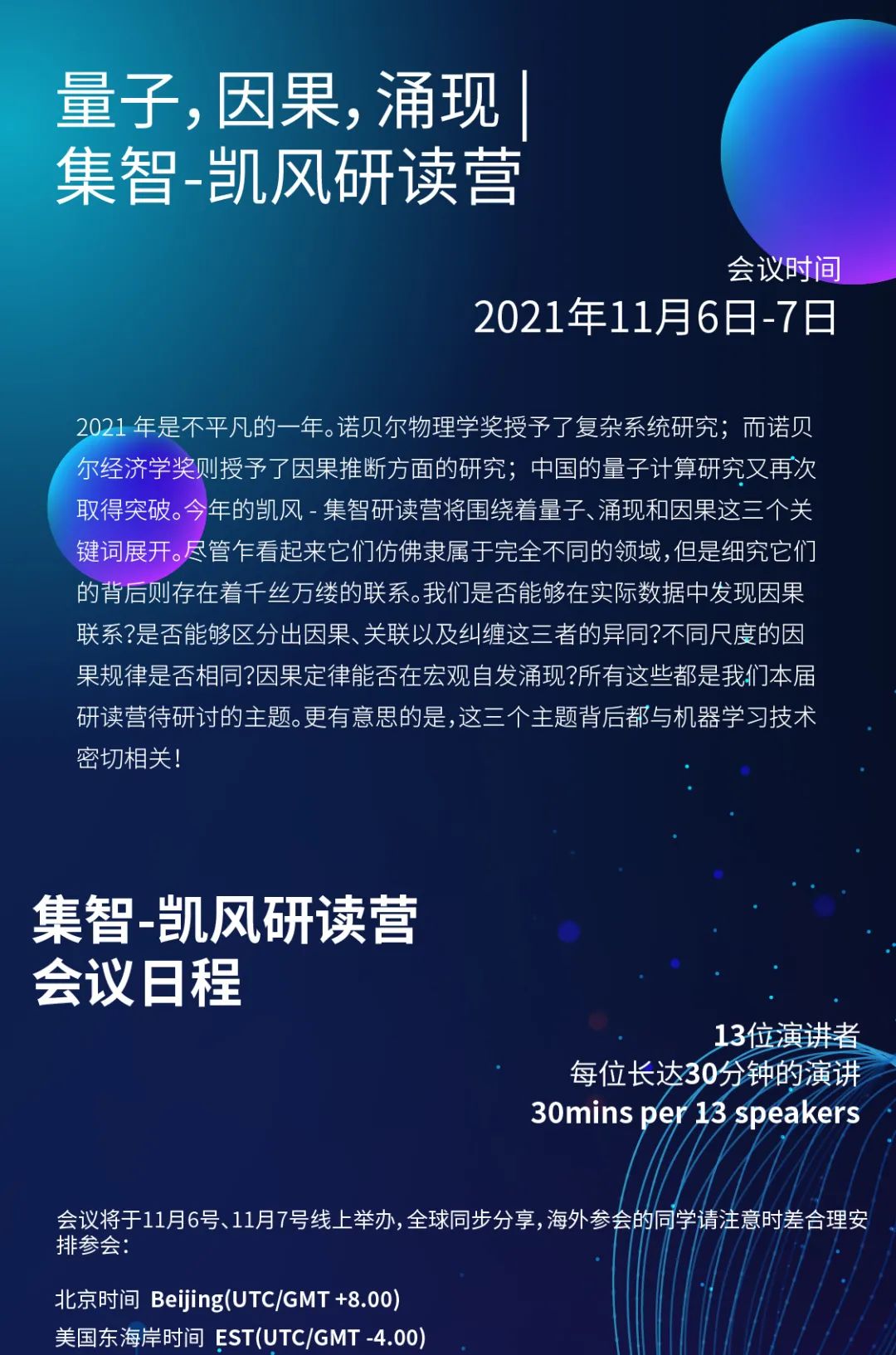

2021年是不平凡的一年。诺贝尔物理学奖授予了复杂系统研究;而诺贝尔经济学奖则授予了因果推断方面的研究;中国的量子计算研究又再次取得突破。今年的凯风-集智研读营将围绕着量子、因果和涌现这三个关键词展开。尽管乍看起来它们仿佛隶属于完全不同的领域,但是细究它们的背后则存在着千丝万缕的联系。我们是否能够在实际数据中发现因果联系?是否能够区分出因果、关联以及纠缠这三者的异同?不同尺度的因果规律是否相同?因果规律能否在宏观自发涌现?所有这些都是我们本届研读营待研讨的主题。更有意思的是,这三个主题背后都与机器学习技术密切相关!

此次研读营围绕“量子,因果,涌现”这三个关键词展开,我们邀请了13位集智-凯风研读营学者,在11月6日,11月7日北京时间的上午和晚上,与我们所有的集智-凯风研读营学者一起探讨这三个主题背后的统一性,这样一次分享,是一次一年一度「见面」的约定,更是为了让大家基于当前的研究问题有更深入碰撞和交流,期待能激发大家更多的研究方向。

集智俱乐部将公开研读营学者部分分享,欢迎感兴趣的朋友预约B站直播。如果你从事相关领域的具体研究,也欢迎报名参与内部在线会议交流。

-

此次分享为内部交流会议,涉及到一些未发表的工作,如果想要加入腾讯会议室讨论,可以提交简历和希望探讨的问题发送到邮箱wangting@swarma.org,经过审核后发送腾讯会议室的链接。

刘金国:图与张量网络

张量网络是科学计算,尤其是物理中常用的技术。在过去的几年,量子计算模拟推动了大规模张量网络收缩技术的发展。之前大家关注的张量网络中,数字是常见的浮点数或者整数。在这个报告中,我将会用这些先进的张量网络技术从图多项式的角度解决图论中的一些重要问题。而这些进展来自对张量网络元素的代数的结构的设计,我将会带大家从抽象代数的角度去理解什么样的代数可以作为被操作的对象。

刘金国,哈佛大学博士后,中国科学院物理研究所博士后,南京大学物理学博士,研究兴趣为量子计算、张量网络、机器学习。

Tropical Tensor Network for Ground States of Spin Glasses.Jin-Guo Liu, Lei Wang, and Pan Zhang

Phys. Rev. Lett. 126, 090506 – Published 5 March 2021

Computing Properties of Independent Sets by Generic Programming Tensor Networks.Jin-Guo Liu, Shengtao Wang, et al. and Xun Gao*unpublished

王磊:科学计算中的微分编程

微分编程是一种新的编程范式,来源于深度学习但是却不仅仅只是训练神经网络。在微分编程中,通过将一些可微分的计算单元组合自适应程序,再通过梯度优化的方法学习程序,使其达到期望的目标。一些机器学习专家认为微分编程是深度学习的未来,认为它是联系深度学习与科学计算的一条纽带,微分编程可以直接基于深度学习引擎应用于科学和工程领域的建模、优化、控制和逆问题。本次我将重点介绍一些在量子物理研究中的例子,并讨论可微科学计算的未来前景。

王磊,中国科学院物理研究所研究员,主要研究兴趣是深度学习和量子多体计算。

1. Nolan J F. Analytical differentiation on a digital computer. Massachusetts Institute of Technology,1953

2. Wengert R E. Communications of the ACM,1964,7:463

3. Jensen D S,Wasserman A. International Journal of Quantum Chemistry,2018,118(1):e25425

4. https://github.com/QuantumBFS/SSSS/blob/master/1_deep_learning/schrodinger.py

5. Chen R T Q,Rubanova Y,Bettencourt J et al. 2018,arXiv:1806.07366

6. Rackauckas C et al. 2020,arXiv:2001.04385

张潘:量子计算机的经典模拟

张潘老师会介绍他们团队的一些最新工作和即将开展的一些研究,在他们最发表的文章中提出了一个通用的用张量网络模拟量子线路的方案,这种方案可以比现有方案更加高效的计算大量的相关联的比特串的概率幅。作为应用,他们研究了谷歌用于展示量子优越性(人们相信无法用任何经典技术模拟)的Sycamore线路。用他们的方法可以针对53量子比特的Sycamore线路进行20个周期的模拟。仅用60个GPU的小型集群就可以生成100万个相关联的的比特串并得到远高于实验中的0.739的XEB保证度。相关的报道可以见:打破谷歌量子霸权!经典计算机扳回一城

Simulating the Sycamore quantum supremacy circuits.Feng Pan, Pan Zhang.arXiv: 2103.03074

张潘,中国科学院理论物理研究所研究员,入选中国科学院“百人计划”。研究方向:统计物理与机器学习的交叉领域。近年的研究兴趣:集中在统计推断问题中的统计物理理论,以及基于量子和统计物理的非监督机器学习新方法。

陆超超:机器学习中的追因问题

机器学习的核心任务是从数据中自动地发现相关性信息以便预测未来。但数据的真相并非来自相关性,而是来自因果性。因此,我们需要进一步对数据追因溯源,考虑数据背后更本质的因果结构。因为因果模型对现实世界中数据的变化更加鲁棒,所以拥有了因果推断能力的机器学习算法可以更好地预测未来。我们将讨论因果推断在机器学习各个方面的前沿进展以及它们在各个实际场景中的具体应用。

陆超超,剑桥大学机器学习组博士生, 由Zoubin Ghahramani教授和José Miguel Hernández-Lobato教授联合培养,Carl Edward Rasmussen教授指导;同时他也是Cambridge-Tübingen 博士奖学金的获得者,由马克斯·普朗克智能系统研究所的Bernhard Schölkopf 教授联合培养。他的主要研究兴趣是机器学习,特别是涉及到如何结合因果推理、贝叶斯推理、强化学习和深度学习各自的优势,并将它们应用在现实领域中解决实际问题,如计算机视觉和医疗等领域。

姚迪:时序数据归因与因果发现

时间序列数据在实际应用中普遍存在,其中时序数据的因果推理和因果发现,对许多时序分析任务都具有非常重要意义。其结果不仅可以提升模型解释性,且可以支撑更多下游任务。本报告以广告-转化序列为例,研究其中广告多触点归因任务,介绍如何通过因果表示学习缓解用户偏好造成观测广告序列中存在的混淆偏差,期望实现无偏反事实预测,并利用反事实预测结果为广告序列中每个广告触点归因。

姚迪,中科院计算所助理研究员,博士毕业于中科院计算所,期间曾在新加坡南洋理工大学访问,研究方向是时空数据挖掘、时序数据因果分析

李嫣然:常识因果在 AI 认知的进展

自然语言作为人类文明的载体之一,其中蕴含了大量经过社会协作及演变后高度抽象出来的常识因果知识及认知行为知识。近年来,研究者们构造了使用文本描述的、包含结构化常识因果知识的数据集,并开始探索如何更好地使用这类结构化知识辅助模型预测、推理及生成。我们将介绍并讨论:(1)有哪些常识因果知识库及其中定义的因果推理维度;(2)如何从超大规模预训练模型中提取常识因果知识;(3)如何结合符号表示的逻辑知识和神经网络表示的因果知识;(4)有哪些常识因果知识在 AI 认知方面的应用进展。

李嫣然,小米人工智能实验室的高级算法工程师,在北京大学获得智能科学本科学位后,前往香港理工大学攻读博士学位。她的研究兴趣主要包括自然语言处理、人机对话系统、常识推理、文本生成、情感计算等。

郭若城:因果机器学习与可解释性和公平性

在机器学习模型被广泛应用于各行各业的今天,对于一些高风险的决策问题,例如AI在判断一个人的信用卡/借贷申请是否应该通过时,或是HR判断一个人的简历是否合格时,人们开始关注机器学习模型的可解释性和公平性问题。可解释性的目的是回答“模型做出预测时利用了哪些信息?哪些信息在预测中更重要?”这样的问题。而公平性则关注机器学习模型做出的预测是否对不同的人群(如性别,年龄,种族)或者个体公平。本期读书会将结合一些近期发表在一流会议和期刊上的论文,介绍几种借助因果推断来提高机器学习可解释性和公平性的方法。

郭若城,亚利桑那州立大学博士,香港城市大学(the City University of Hong Kong)数据科学学院任助理教授。研究方向为因果推理、机器学习、数据挖掘。

[1] Vig, Jesse, et al. “Investigating Gender Bias in Language Models Using Causal Mediation Analysis.” NeurIPS. 2020.

[2] Kusner, Matt, et al. “Counterfactual fairness.” Proceedings of the 31st International Conference on Neural Information Processing Systems. 2017.https://arxiv.org/abs/1703.06856

[3] Kilbertus, Niki, et al. “The sensitivity of counterfactual fairness to unmeasured confounding.” Uncertainty in Artificial Intelligence. PMLR, 2020.http://proceedings.mlr.press/v115/kilbertus20a.html

[4] Chiappa, Silvia. “Path-specific counterfactual fairness.” Proceedings of the AAAI Conference on Artificial Intelligence. Vol. 33. No. 01. 2019.https://ojs.aaai.org//index.php/AAAI/article/view/4777

[5] Feder, Amir, et al. “Causalm: Causal model explanation through counterfactual language models.” Computational Linguistics 47.2 (2021): 333-386.https://arxiv.org/abs/2005.13407

苑明理:从词向量到算术表达式的几何

算术表达式会有几何的表示吗?我们会给出几个例子说明存在算术表达式的不同几何构造,其中有些构造可能有着复杂的图景;同时我们还尝试揭示这种几何构造里表征和计算的相互制约关系。

对算术表达式的此类研究有多重的意义:(一)本身是联系着多个领域的数学问题。(二)在智能求解问题的优化过程中,问题的表征和计算的相互关系制约着我们能看到的很多智能现象的形态;在这个背景下理解,这个算术表达式的研究有可能可以给类似的研究提供数学工具。

苑明理,独立研究者,此前主要在工业界从事工程工作。2015 年在思考词向量技术如何应用到数字的表示时,发现了一个有趣的数学结构,并在第一次集智-凯风研读营中提起过这个结构。此后,经过六年多的思考,理解逐步深入。此次报告可以理解成一个总结。

谢泽柯:理解并改进深度学习动力学

以随机梯度下降为代表的随机优化方法是训练深度神经网络的主流方法,也是深度学习取得成功的重要原因。但是,为什么随机优化对于深度学习如此重要?其背后的理论机制还有待更多探索。首先,我们提出了一种扩散理论框架用于分析深度学习动力学的理论优势。在这个扩散理论的启发下,我们设计新的优化方法还进一步提升了深度学习的训练效果。其次,我们介绍了一个神经科学启发的神经网络训练算法NVRM。并且我们从扩散理论、信息论角度证明了NVRM有助于提高深度神经网络的泛化性能、对抗数据噪音、和对抗灾难性遗忘。

谢泽柯,在东京大学获得机器学习博士学位由Masashi Sugiyama教授和Issei Sato教授的指导。硕士毕业于东京大学,本科毕业于中国科学技术大学。研究兴趣主要包括深度学习理论和AI+科学,在深度学习理论研究上对优化、泛化、鲁棒性和不确定性感兴趣,在AI+科学的研究上对如何将AI连接到物理学、神经科学和生物学感兴趣。

[1] Zeke Xie, Issei Sato, and Masashi Sugiyama. (2021). A Diffusion Theory For Deep Learning Dynamics: Stochastic Gradient Descent Exponentially Favors Flat Minima. In International Conference on Learning Representations. (ICLR 2021)

[2] Zeke Xie, Xinrui Wang, Huishuai Zhang, Issei Sato, and Masashi Sugiyama (2020). Adai: Separating the Effects of Adaptive Learning Rate and Momentum Inertia. arXiv preprint arXiv:2006.15815. (under review)

[3] Zeke Xie, Fengxiang He, Shaopeng Fu, Issei Sato, Dacheng Tao, and Masashi Sugiyama. (2021). Artificial Neural Variability for Deep Learning: On Overfitting, Noise Memorization, and Catastrophic Forgetting. Neural Computation.

杜伟韬:深度学习作为一种有效理论

摘要:本次分享我将从我们最近的一篇利用score-model做分子生成的文章讲起,由此引出一种将深度学习看成学习如何去噪的新的学习范式。将真实数据分布转化为噪音的过程可以看做一种不断将细粒度信息做重整化的过程,在数学上可以写作一个stochastic diffusion equation。而深度学习则试图将他的reverse process去拟合出来。我们可以显示地利用神经网络去建模reverse process,也就是拟合reverse process的梯度场,或者深度网络的层次结构本身可看做是implicit在做重整化。我们将探讨相关的一些未成熟的理论以及他们之间可能的联系。

1. Equivariant vector field network for many-body system modeling, arxiv: 3996549

2. On the Neural Tangent Kernel of Deep Networks with Orthogonal Initialization, IJCAI 2021

3. Scaling Properties of Deep Residual Networks, 2105.12245

4. The Principles of Deep Learning Theory, 2106.10165

杜伟韬:本科在中科大学习理论物理,博士在northwestern和中科大进修基础数学博士学位,研究方向为流形上的随机分析,并在华为诺亚实验室和微软deep learning theory组实习,即将加入中科院马志明院士研究组做博士后。

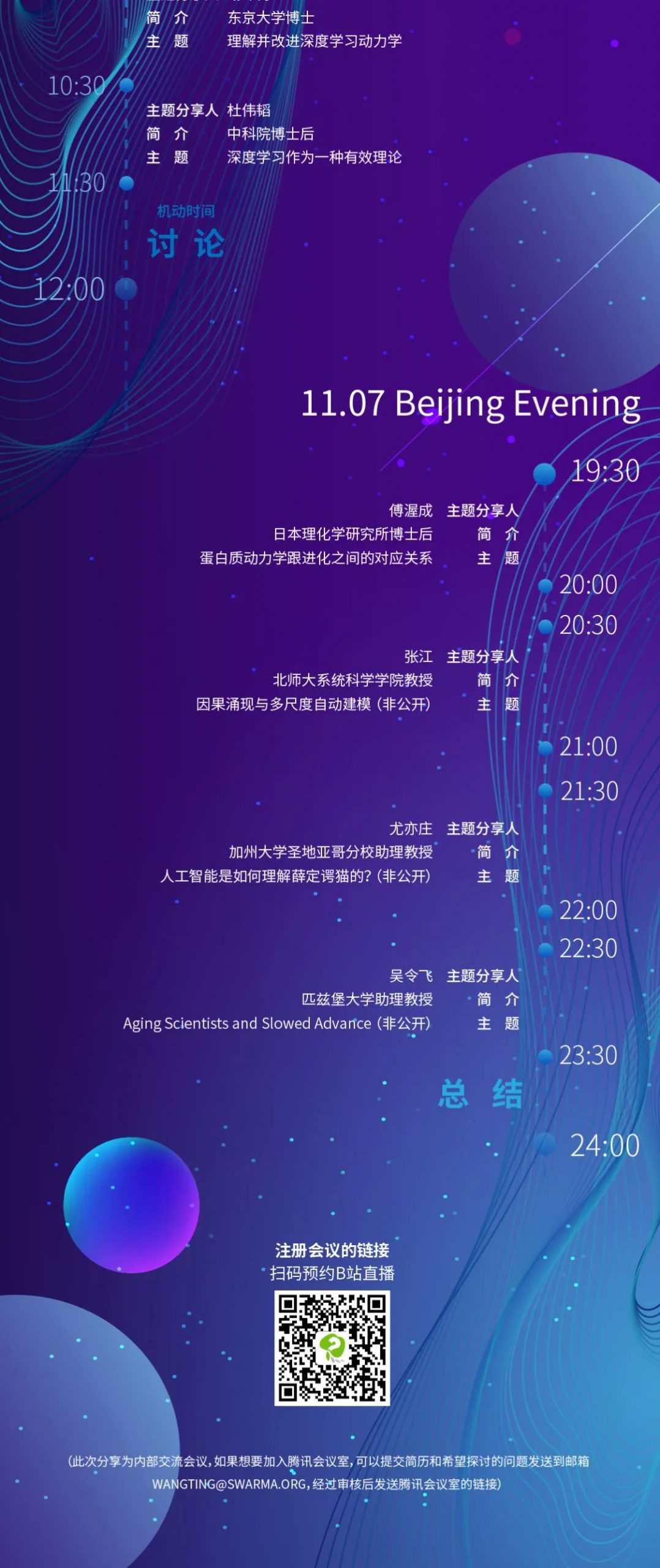

傅渥成:蛋白质动力学跟进化之间的对应关系

蛋白质的动力学和进化是生命科学研究中两个重要的研究主题。动力学和进化分别涉及到了生命现象中两个相差巨大的时间尺度,然而,许多研究表明,蛋白质短时间尺度的动力学和长时间尺度的遗传进化之间存在很高的相似性。我们基于一个简化的理论模型框架,建立起了蛋白质动力学与进化之间的对应关系,并用真实的蛋白质结构数据进行了验证。在这个模型的基础上,我们还进一步分析了生物系统的“功能敏感性”和“突变稳定性”二者之间的关系。研究表明,尽管蛋白质的功能运动涉及到大量的自由度,但构成蛋白质的各个氨基酸却会形成某种集体秩序,倾向于沿着少数几个特定的方向协同运动,以便其发挥功能,而这几个特定的方向是进化稳定的,突变所影响的主要是其它非主导的方向。这种对应关系也对我们研究其它生命系统(例如大脑、生物网络)乃至更一般的复杂系统也具有重大的启发性。

傅渥成(真名:唐乾元),现为日本理化学研究所(RIKEN)脑科学研究中心研究员,南京大学物理学博士。主要研究方向为统计物理在生物分子、大脑和人工智能系统中的应用,在Phys. Rev. Lett.,Phys. Rev. Research,PloS. Comp. Biol. 等杂志发表过多篇论文。科普作者,知乎物理学、生物学领域优秀回答者,曾出版科普书《宇宙从何而来》。

1. Qian-Yuan Tang, Testsuhiro S. Hatakeyama, Kunihiko Kaneko, Functional Sensitivity and Mutational Robustness of Proteins, Physical Review Research 2(3), 033452 (2020).https://journals.aps.org/prresearch/abstract/10.1103/PhysRevResearch.2.033452

2. Qian-Yuan Tang, Kunihiko Kaneko. Dynamics-Evolution Correspondence of Protein Structures. Physical Review Letters, 127, 098103 (2021). https://journals.aps.org/prl/abstract/10.1103/PhysRevLett.127.098103

张江:因果涌现与多尺度自动建模

复杂系统中广泛存在着涌现现象,即在宏观展现出与微观完全不同的现象和规律,其中就包括一个动力学过程之中的因果联系。Erik P. Hoel提出的因果涌现理论通过将不同尺度的动力学放置在一个框架下,从而成功示例了宏观尺度动力学会具有比微观动力学更强的因果特性。然而,Erik的框架是动力学已知的,我们利用机器学习技术,提出了多尺度自动建模的构想,希望能够通过数据驱动的方式,自动构建多尺度的模型,并找到因果涌现现象的最优尺度。

张江,北京师范大学系统科学学院教授、集智俱乐部创始人、集智学园创始人。主要研究领域包括复杂网络与机器学习、复杂系统分析与建模、计算社会科学等。其开创的集智俱乐部是国内外知名的学术社区,致力于复杂系统、人工智能等多领域的跨学科交流与合作。

1. E. P. Hoel, L. Albantakis, and G. Tononi. “Quantifying Causal Emergence Shows That Macro Can Beat Micro.” Proceedings of the National Academy of Sciences 110, no. 49 (December 3, 2013): 19790–95. https://doi.org/10.1073/pnas.1314922110.

2. Li, Shuo-Hui, and Lei Wang. “Neural Network Renormalization Group.” Physical Review Letters 121, no. 26 (December 26, 2018). https://doi.org/10.1103/PhysRevLett.121.260601.

3. Yan Zhang, Yu Guo, Zhang Zhang, Mengyuan Chen, Shuo Wang, Jiang Zhang: Automated Discovery of Interactions and Dynamics for Large Networked Dynamical Systems, https://arxiv.org/abs/2101.00179, 2021

尤亦庄:人工智能是如何理解薛定谔猫的? —— 量子测量中的因果涌现

“量子测量中经典现实的涌现”:神奇的量子世界和经典世界拥有巨大的差异,通常被我们称为反直觉的。量子世界中物体可以存在量子纠缠和物态叠加,然而作为生活在经典世界中宏观物体的我们却难以直接观察到这些神奇的现象。每一次我们对量子物体的测量,得到的都会是经典的数据。那么宏观的经典世界和微观的量子世界究竟有没有明确的分界线呢?宏观的经典现实(reality)是不是可以从对量子体系观测的经典数据中涌现出来呢?本次讨论,尤亦庄教授将从量子测量和人工智能的角度来试图回答这些物理学中的重要问题。

尤亦庄,加州大学圣地亚哥分校助理教授。研究领域为理论凝聚态物理,强关联系统,量子拓扑物态,多体局域化与热化,纠缠,张量网络,以及全息原理与机器学习。

吴令飞:Aging Scientists and Slowed Advance

科学社区的年龄结构与科学进步的特征之间有什么关系?早期的一些研究侧重于讨论明星科学家、他们的职业生涯和成功的概率。通过分析过去40年来4600万论文中的200万学者,我们发现,对于所有领域、不同时期和不同影响力的研究者来说,他们的研究想法和涉及的参考文献均随着职业年龄的增长而老化。老年科学家变得更有可能批判或忽视前沿工作。同时,我们也发现,越早的成功会加速科学家的知识老化,但通过扩充或者改变研究机构和研究领域以及与更年轻的科学家合作会减缓科学家在科研上老化。我们分析了不同领域的研究模式,发现年龄结构老化的科学社区经历了更显著的想法流失和更容易被旧参考文献的吸引,这表明科学老化、科学研究和科学进步之间可能存在普遍联系。

讲者介绍:

吴令飞,匹兹堡大学助理教授,研究方向为计算社会科学、大数据分析、复杂系统建模与分析,对发现科技创新以及加速科技创新中的团队机制感兴趣。

“集智-凯风研读营” 项目是由凯风基金会资助、集智俱乐部发起的,针对量子信息、人工智能、复杂系统、计算社会科学等特定主题的封闭式交流活动。

我们的目标是:汇聚术业有专攻但又视野广阔的青年学者,进行跨学科交流,寻找不同复杂现象背后的统一规律。

我们的愿景是:通过深度研读讨论前沿科学研究,共同界定和审视新的问题,实现跨文化、跨学科、跨领域的学术创新,形成真正具有原创能力的学术小生境。

详情请见:

集智-凯风奖学金计划启动:资助青年学者探索跨学科研究

推荐阅读

点击“阅读原文”,预约直播