研究速递:预测学习——神经元高效运作的最佳策略

摘要

了解大脑如何学习有助于制造具有与人类类似智力水平的机器。之前有理论提出,大脑可能是根据预测编码的原理运行。然而,对于预测系统如何在大脑中实现还没有很好的解释。这项研究证明,单个神经元预测其未来活动的能力可能提供了一个有效的学习机制。有趣的是,这种预测性学习规则可以从新陈代谢原理中推导出来,即神经元需要最小化其自身的突触活动(代价),同时通过笼络其他神经元来最大化对局部血液供应的影响。我们展示了这个数学推导的学习规则如何在不同类型的大脑启发式算法之间提供理论联系,从而推动神经学习的通用理论的发展。我们在神经网络模拟和清醒动物的记录数据中测试了这种预测性学习规则。我们的结果还表明,自发的大脑活动为神经元学习并预测皮质动力学提供了“训练数据”。因此,单个神经元减少意外——即实际活动和预期活动之间的差异——的能力,可能是理解大脑计算的一个重要缺失因素 。

研究领域:神经科学,神经网络,学习算法

袁郭玲、梁金 | 作者

邓一雪 | 编辑

论文题目:

Neurons learn by predicting future activity

论文链接:

https://www.nature.com/articles/s42256-021-00430-

1

1

神经科学的发展阶段正如同生物学在达尔文之前所处的阶段:有无数详细的观察结果,但没有一个理论能解释所有这些观察结果之间的联系。我们甚至不知道关于大脑的理论应该是在分子水平、大脑区域水平,还是中间某个尺度。研究深度神经网络可能为此提供有用的见解。尽管深度神经网络可能有不同的输入和架构,但其令人印象深刻的行为往往归结于“反向传播”(backpropagation)这一底层通用学习算法。

要建立统一的大脑功能理论,更好地理解大脑使用的学习算法可能至为关键。目前主要有两种方法来研究大脑的学习机制:实验和计算。1月25日发表在 Nature Machine Intelligence 的论文“神经元通过预测未来活动来学习”,探索了理论推导这第三种路径。其中学习规则来自基本的细胞原理,即最大化细胞的代谢能量。研究发现,一个神经元为使能量收支最大化,会形成预测性学习规则:调整其突触权重以最小化“意外”,也就是让实际活动和预测活动之间的差异尽可能小。

2

2

现有的多种证据表明,大脑是一个预测系统,但预测编码在大脑中到底是如何实现的呢?鉴于神经元的许多基本属性在进化过程中是高度保守的,作者们假设,在每个神经元中都存在一个内部预测模型,以此为基本单元可以构建各种各样的预测大脑。

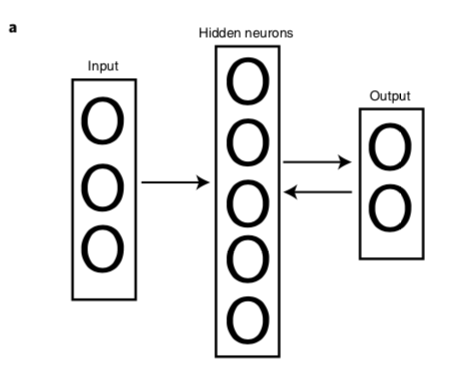

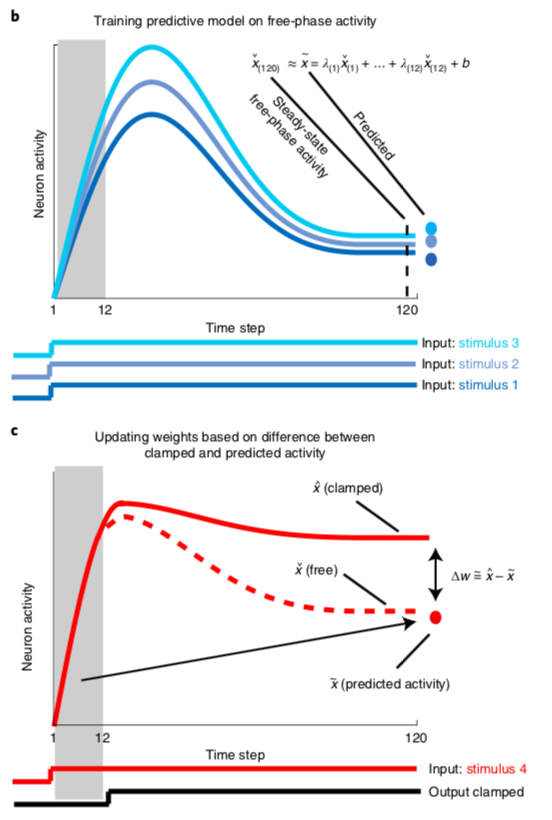

这种衍生的学习规则与一些最有前途的生物启发学习算法有直接关系,比如时间差分学习(temporal difference learning),可以通过修改时间差分学习算法来获得这种预测学习规则。时间差分学习是关于反向传播算法如何在大脑中实现的最有前景的想法之一。一个典型例子是对比 Hebbian 学习(contrastive Hebbian learning),它被证明在某些假设下等价于反向传播算法。对比 Hebbian 学习要求网络在隐藏层和输出层之间相互连接,从而允许神经元活动在两个方向上传播(图1a)。

图1. 网络示意图

这种学习规则由两个阶段组成,即“自由阶段”(free phase)和“夹紧阶段”(clamped phase)。对于每个神经元,这两个阶段的活动差异可以用来修改突触权重,使神经元在自由阶段的活动更接近夹紧阶段所代表的期望活动。这受到皮层感觉处理的启发。比如在视觉区域,当呈现一幅新图片时,最初是由下而上驱动的活动,主要包含刺激的视觉属性(例如轮廓);接着是自上而下的包含更抽象信息的调制,比如“这个对象属于某个类别”。算法首先只运行初始的自由阶段,代表自下而上刺激驱动的活动;接着几步之后,网络输出被夹紧,对应于自上而下的调制。

研究人员在神经网络模拟、生物驱动的网络架构,以及清醒动物中验证了预测学习规则的有效性。对于标准的机器学习任务,具有预测学习规则的网络可以解决具有挑战性的非线性分类任务。对样本神经元的近距离观察表明,神经元能够正确预测未来的自由阶段活动。对清醒大鼠听觉皮层的神经元记录表明,真实的神经元具有可预测的动力学,从最初的神经元反应可以估计其未来活动。此外,作者们还测试发现,自发的大脑活动(并非由任何外部刺激直接引起的活动,比如睡眠)也可以用来预测刺激呈现时的神经元动力学,为神经元提供“训练数据”以建立预测模型。

3

3

有趣的是,这种形式的预测学习规则并非为解决计算问题而特别设计的,而是为使神经元代谢成本最小化而自然出现的结果。神经元为保持能量收支最大化,必须最小化自身的电活动(活跃程度越低越好),但同时需要最大化对下游神经元活动的影响,以增加血液供应(活跃程度越高越好)。因此,神经元必须调整权重,在这两种相反的需求之间取得平衡。而“懒惰的”神经元最大限度利用未来能源的最佳策略,是预测其未来活动。这揭示了一种意想不到的联系,即神经网络中的学习可能源于每个神经元单纯地想要保持能量收支最大化。

复杂科学最新论文

集智斑图顶刊论文速递栏目上线以来,持续收录来自Nature、Science等顶刊的最新论文,追踪复杂系统、网络科学、计算社会科学等领域的前沿进展。现在正式推出订阅功能,每周通过微信服务号「集智斑图」推送论文信息。扫描下方二维码即可一键订阅:

推荐阅读

-

网络神经科学前沿:大脑如何在局部和全局高效处理信息? -

Science:大脑神经元复杂网络连接的新机制 -

研究速递:图神经网络预测复杂网络中的传播现象 -

《张江·复杂科学前沿27讲》完整上线! -

成为集智VIP,解锁全站课程/读书会 -

加入集智,一起复杂!

点击“阅读原文”,追踪复杂科学顶刊论文