集智俱乐部和安远AI联合举办“大模型安全与对齐”读书会,由多位海内外一线研究者联合发起,针对大模型安全与对齐所涉及的核心技术、理论架构、解决路径以及安全治理等交叉课题,展开共读共研活动。读书会自2024年1月27日正式开始,每周六上午举行,为期8-10周。欢迎从事相关研究与应用工作的朋友报名加入!

基于人类反馈的强化学习(RLHF)在前沿大模型中被广泛使用。RLHF为何能成为推进对齐的重要算法之一?当前它都存在哪些根本问题与挑战?在2024年,它与更广泛的人类社会、更加智能的AI、超级对齐又存在哪些联系与最新的探讨?

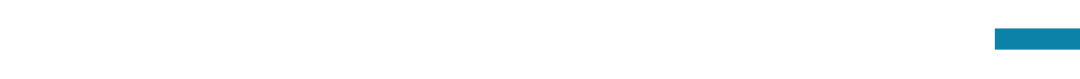

大模型安全与对齐读书会的第二期,我们邀请到苏黎世联邦理工学院(ETH Zurich)计算机系博士生陈欣和天津大学计算机系博士生沈田浩。基于上述问题,陈欣将着重讨论(1)AI对齐与RLHF的产生背景、核心考虑;(2)RLHF存在的主要挑战:基于一些根本问题,RLHF并不足够解决所有的安全与对齐风险;(3)RLHF与人类社会、超级智能的联系与影响。随后,沈田浩将介绍OpenAI目前正在探索的一种对超出人类能力的模型进行监督的方案——超级对齐 (Superalignment),以及目前OpenAI对超级对齐的规划和遇到的挑战。

-

背景:AI对齐的核心考虑

-

RLHF与超级对齐问题

-

RLHF算法简介

-

RLHF的核心挑战

-

背景:探索监督能力的上限

-

超级对齐简介

-

OpenAI对超级对齐的规划

-

实现超级对齐的挑战

陈欣,苏黎世联邦理工学院(ETH Zurich)计算机系在读博士生。她师从Andreas Krause教授进行人工智能对齐研究,也曾在加州大学伯克利分校人类兼容人工智能研究中心(Center for Human-Compatible AI)Stuart Russell教授组进行研究实习。她自2019年起在NeurIPS、AAAI等多个顶会上主办逾10个AI安全与对齐相关的workshop,也是关注AI长期风险与对齐的Vitalik Buterin PhD Fellowship和Open Philanthropy AI Fellowship的2022年获奖者之一。

沈田浩,天津大学自然语言处理实验室(TJUNLP)三年级博士生,导师为熊德意教授,曾获得第九届对话技术挑战赛 (DSTC9) “端到端多领域任务型对话”赛道第一名,在ACL、EMNLP等国际会议上发表多篇学术论文,撰写了大规模语言模型对齐技术的综述(https://arxiv.org/abs/2309.15025),并担任ACL, EMNLP, AACL等会议的审稿人。

[1]Wiener, N. (1960). Some Moral and Technical Consequences of Automation: As machines learn they may develop unforeseen strategies at rates that baffle their programmers. Science, 131(3410), 1355-1358.

[2]Paul Christiano. (2018). Clarifying “AI alignment”.

[3]Di Langosco, L. L., Koch, J., Sharkey, L. D., Pfau, J., & Krueger, D. (2022). Goal misgeneralization in deep reinforcement learning.

[4]Zou, A., Wang, Z., Kolter, J. Z., & Fredrikson, M. (2023). Universal and transferable adversarial attacks on aligned language models.

[5]Pan, A., Bhatia, K., & Steinhardt, J. (2022). The effects of reward misspecification: Mapping and mitigating misaligned models.

[6]Park, P. S., Goldstein, S., O’Gara, A., Chen, M., & Hendrycks, D. (2023). AI Deception: A Survey of Examples, Risks, and Potential Solutions.

[7]Jacob Steinhardt. (2023). Emergent deception and emergent optimization.

[8]Kenton, Z., Shah, R., Lindner, D., Varma, V., Krakovna, V., … & Catt, E. (2022). Clarifying AI X-risk.[11]Ngo, R., Chan, L., & Mindermann, S. (2022). The alignment problem from a deep learning perspective.

[9]Ruiqi, Z. (2023). Getting AI to Do Things I Can’t: Scalable Oversight via Indirect Supervision. (Talk)[10]OpenAI. (2022). AI-written critiques help humans notice flaws.

[11]OpenAI. (2023). Language models can explain neurons in language models.

[12]Molnar, C. (2020). Interpretable machine learning. Lulu. com.

[13]Anthropic. (2023). Anthropic’s Responsible Scaling Policy.

[14]OpenAI. (2023). Introducing Superalignment.

2024年2月5日(周一)晚上20:00-22:00。

扫码参与大模型安全与对齐读书会,加入群聊,获取系列读书会回看权限,成为社区的种子用户,与社区的一线科研工作者与企业实践者沟通交流,共同推动图神经网络社区的发展。

大模型的狂飙突进唤醒了人们对AI技术的热情和憧憬,也引发了对AI技术本身存在的社会伦理风险及其对人类生存构成的潜在威胁的普遍担忧。在此背景下,AI安全与对齐得到广泛关注,这是一个致力于让AI造福人类,避免AI模型失控或被滥用而导致灾难性后果的研究方向。集智俱乐部和安远AI联合举办「大模型安全与对齐」读书会,由多位海内外一线研究者联合发起,旨在深入探讨大模型安全与对齐所涉及的核心技术、理论架构、解决路径以及安全治理等交叉课题。

安远AI是一家位于北京、专注于AI安全与治理的社会企业。我们的使命是引领人机关系走向安全、可信、可靠的未来。我们面向大模型和通用人工智能安全和对齐问题,进行风险研判、建立技术社区、开展治理研究、提供战略咨询以及推动国际交流。

点击“阅读原文”,报名读书会