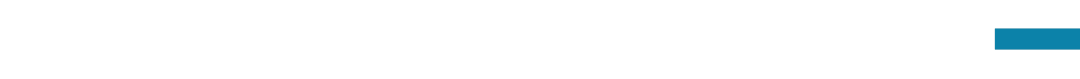

探索大模型安全对齐的泛化挑战,从代码出发丨大模型安全与对齐读书会·周六直播

导语

内容简介

内容简介

大模型安全与对齐的第九期,我们邀请到上海交通大学的任麒冰,他将以代码作为实际案例展示当下安全对齐在非自然语言环境中所面临的普遍的泛化风险。他们提出了红队评测框架CodeAttack,通过把有害指令建模为代码补全任务,在主流的大模型上诸如GPT-4, Claude-2, Llama-2-70B均取得了80%以上的攻击成功率。他们发现拉大代码对抗文本的分布和自然语言文本的分布之间的距离,会进一步提高攻击成功率。他们进一步从(1)预训练偏见和(2)自我评估能力弱 两方面分析了安全对齐泛化难的成因,最后讨论了可能的缓解措施。本次分享希望通过提供对当前安全对齐技术局限性的系统性理解,启发未来工作。

分享内容大纲

分享内容大纲

-

安全对齐工作简介:SFT和RLHF

-

安全对齐泛化风险的前人工作:mismatched generalization假说,CipherChat,etc.

-

CodeAttack:

-

motivation -

方法设计和结果展示 -

分析成因

-

预训练偏见 -

自我评估能力

-

对缓解措施的讨论

主要涉及到的前置知识

主要涉及到的前置知识

Jailbreaking

主讲人介绍

主讲人介绍

圆桌嘉宾介绍

圆桌嘉宾介绍

主持人介绍

主持人介绍

涉及到的参考文献

涉及到的参考文献

-

Qibing Ren and Chang Gao and Jing Shao and Junchi Yan and Xin Tan and Yu Qiao and Wai Lam and Lizhuang Ma. 2024. Exploring Safety Generalization Challenges of Large Language Models via Code. ArXiv, abs/2403.07865.

-

Alexander Wei, Nika Haghtalab, and Jacob Steinhardt. 2023. Jailbroken: How does LLM safety training fail? In Neural Information Processing Systems.

-

Youliang Yuan, Wenxiang Jiao, Wenxuan Wang, Jen tse Huang, Pinjia He, Shuming Shi, and Zhaopeng Tu. 2024. GPT-4 is too smart to be safe: Stealthy chat with LLMs via cipher. In The Twelfth International Conference on Learning Representations.

-

Xiangyu Qi, Yi Zeng, Tinghao Xie, Pin-Yu Chen, Ruoxi Jia, Prateek Mittal, and Peter Henderson. 2024. Fine- tuning aligned language models compromises safety, even when users do not intend to! In The Twelfth In- ternational Conference on Learning Representations.

直播信息

直播信息

2024年4月6日(周六)晚上20:00-21:00

报名成为主讲人

报名成为主讲人

大模型安全与对齐读书会

大模型的狂飙突进唤醒了人们对AI技术的热情和憧憬,也引发了对AI技术本身存在的社会伦理风险及其对人类生存构成的潜在威胁的普遍担忧。在此背景下,AI安全与对齐得到广泛关注,这是一个致力于让AI造福人类,避免AI模型失控或被滥用而导致灾难性后果的研究方向。集智俱乐部和安远AI联合举办「大模型安全与对齐」读书会,由多位海内外一线研究者联合发起,旨在深入探讨大模型安全与对齐所涉及的核心技术、理论架构、解决路径以及安全治理等交叉课题。

点击“阅读原文”,报名读书会