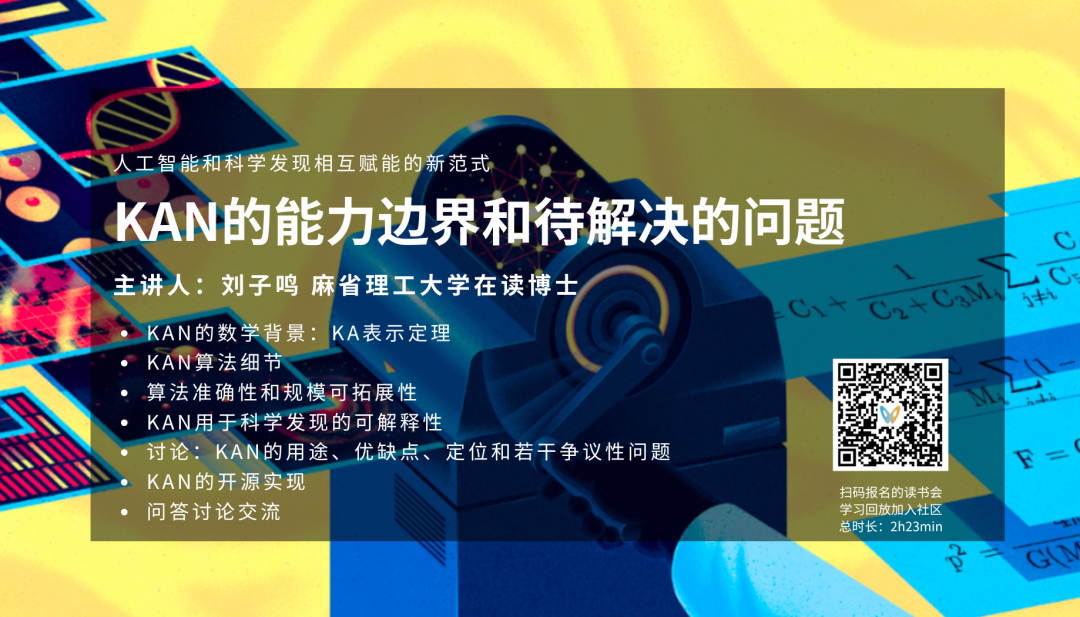

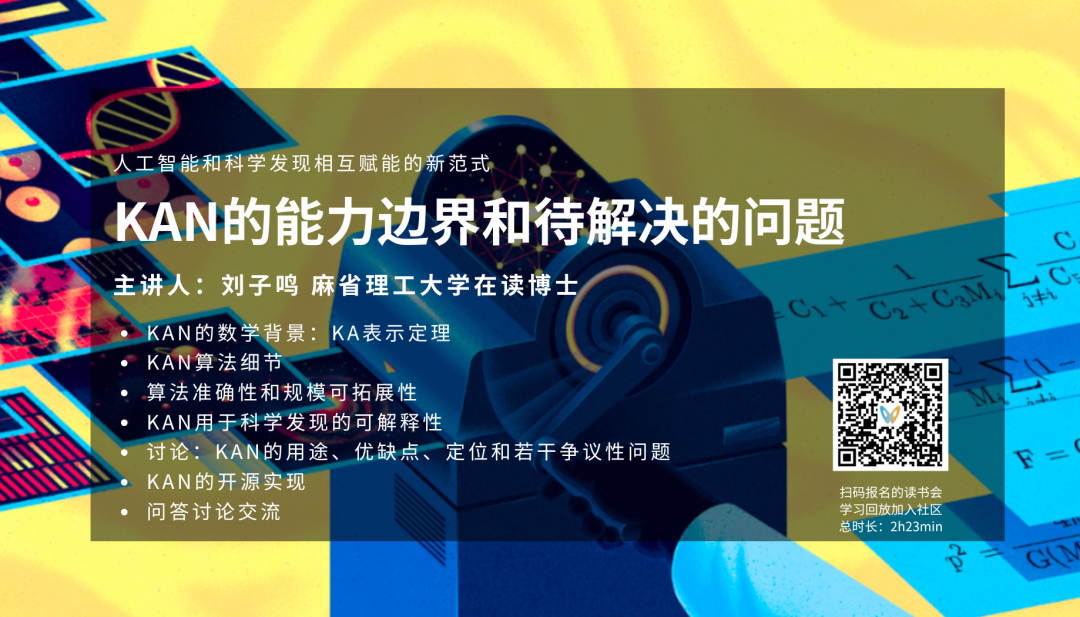

一种崭新的深度学习网络结构 KAN,一经推出就引爆了AI社区。在自媒体的煽风点火下,KAN一夜干翻MLP的爽文在社交媒体上疯传。KAN 到底是什么,它是什么原理,跟 MLP 是什么关系,性能究竟有没有吹的那么好,有哪些局限,作者是怎么发现的——本期读书会由 KAN 的第一作者刘子鸣同学现身说法,为大家带来精彩的第一视角。

报告过程及问答环节,许多AI领域同行提出了各类针对KAN理论、技术、应用、优化的问题,刘子鸣一一详细回应。加入AI+Science读书会即可查看完整视频回放:

• KAN有何特别之处?有何创新?

• KAN的能力边界在哪里?KAN是MLP的替代品吗?

• KAN的思想来源有哪些?延续了怎样的技术脉络?

• 在构建可学习函数时主要采用了样条函数,有没有考虑过使用类似傅立叶变换的方法,如采用不同周期的三角函数进行线性组合?

• KAN论文训练结果展示了一些边的消失,如何表示边的消失的?

• 在使用梯度下降训练B样条(B-spline)时,当样条函数经过零点时,梯度会变为零。如何处理这种情况,例如,当初始化样条函数为正值但目标应为负值时,该如何处理?

• 在KAN模型中使用了一个基于样条函数的激活函数。如果将这个样条函数替换为一个深度神经网络并进行训练,是否能够达到与当前模型相似的效果?

• AlphaFold等基于 Transformer 和扩散模型的方法,似乎结合了符号连接主义和统计方法。在处理 AI for Science 时,它们本质上是微分方程吗?或者除了微分方程之外,还有其他东西在起作用?

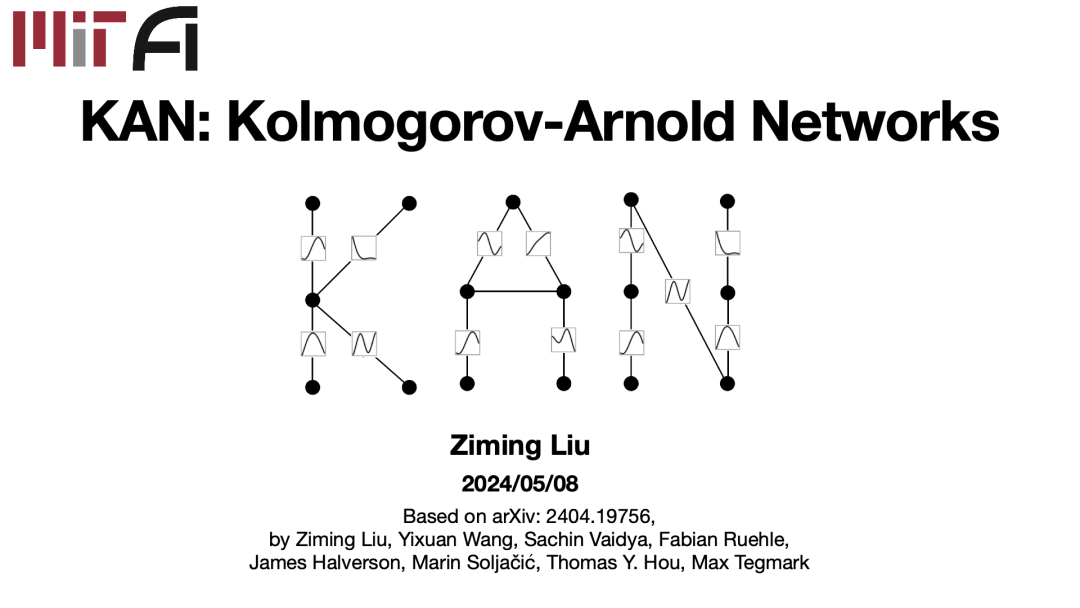

在5月11日的AI+Science读书会中,刘子鸣详细介绍了Max Tegmark团队的最新工作 Kolmogorov-Arnold Network(简称KAN)。自从4月30日预印本发布以来,这一主题引起了广泛关注,令他们感到意外与荣幸。刘子鸣指出,原本以为结合人工智能(AI)与科学的领域较为小众,但实际上却获得了众多人士的热情和认可。

在分享的开始,刘子鸣从数学的背景讲起,接着介绍一些KAN的算法实现,希望提供一个关于KAN所需知识的总体概念。他特别指出了KAN在处理一些小型科学任务时的优势——它不仅精确,其规模化定律相较于多层感知机(MLP)也更优,更具有解释性。对于某些问题,KAN的解释性使得人们可以直接使用训练后的模型进行解释,而MLP可能需要复杂的后处理,有时候甚至难以确定如何进行这些处理。因此,由于其天生的解释性,KAN成为解决科学问题的理想工具。在讲座的最后部分,刘子鸣还轻松地讨论了一些行业内的八卦,增添了讲座的趣味性。此次讲座不仅展示了KAN的潜力和局限,也讨论了它在短期和长期内可能对机器学习领域产生的影响。

以下为讲座主要内容整理:

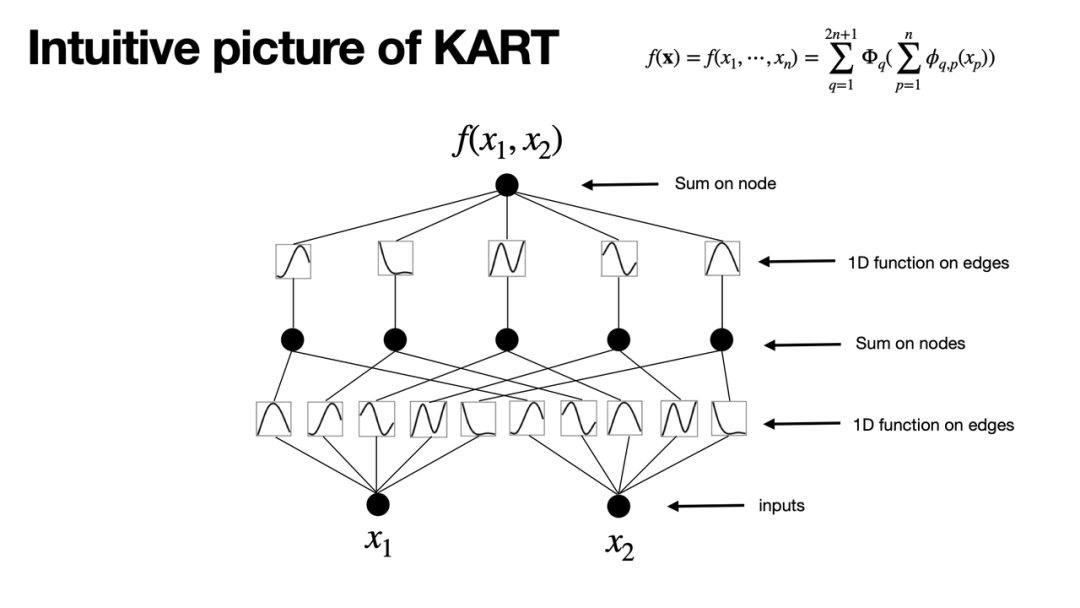

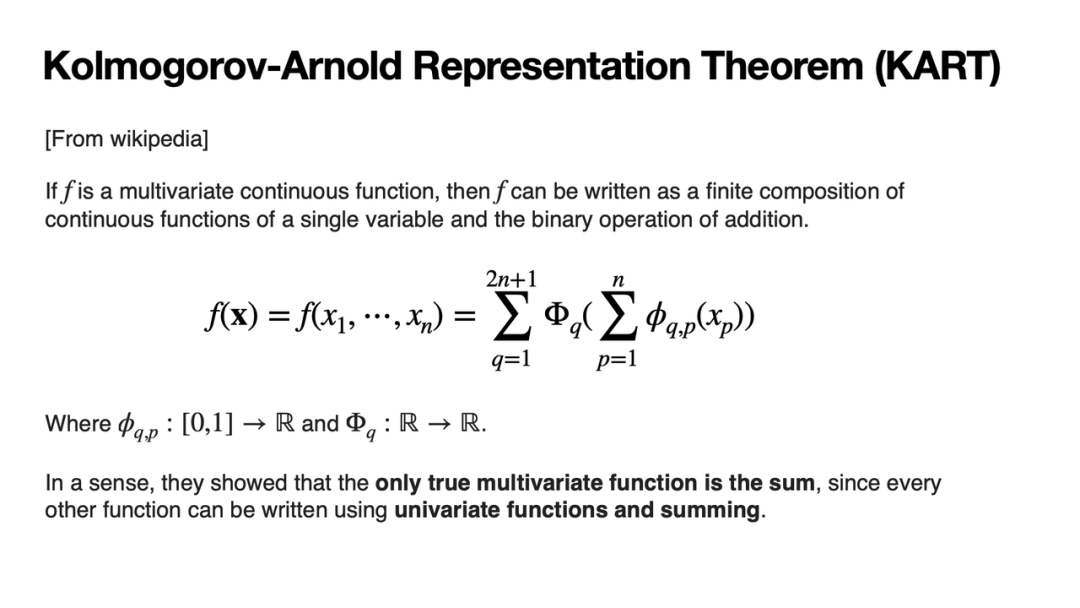

KAN受到Kolmogorov-Arnold Representation Theorem或Kolmogorov-Arnold Superposition Theorem(以下简称KA表示定理)的启发。该定理表明,如果f是一个连续的多元函数,那么f可以表示为有限个单元函数的总和。就像方程所展示的那样。这个定理的关键在于,从某种意义上说,真正的多元函数就是加法,不需要其他多元函数。只需单元函数和加法,就可以构造出乘法。

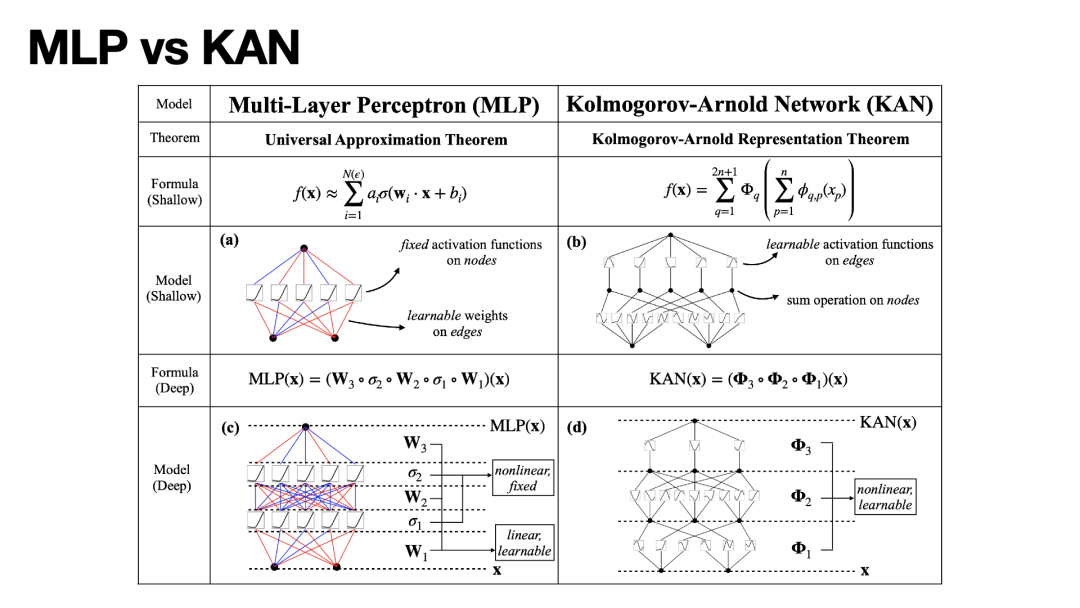

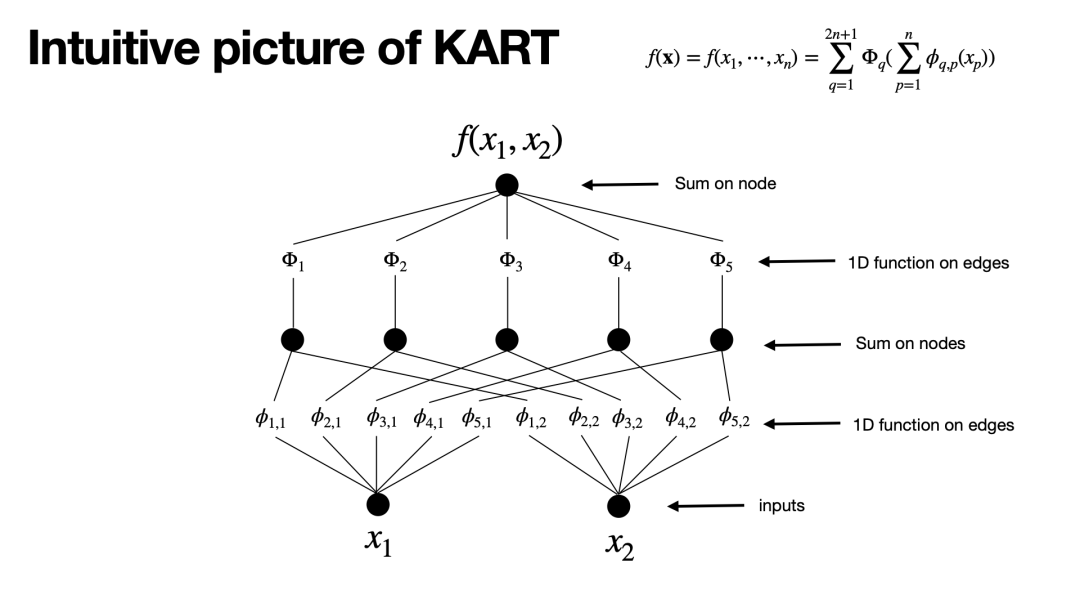

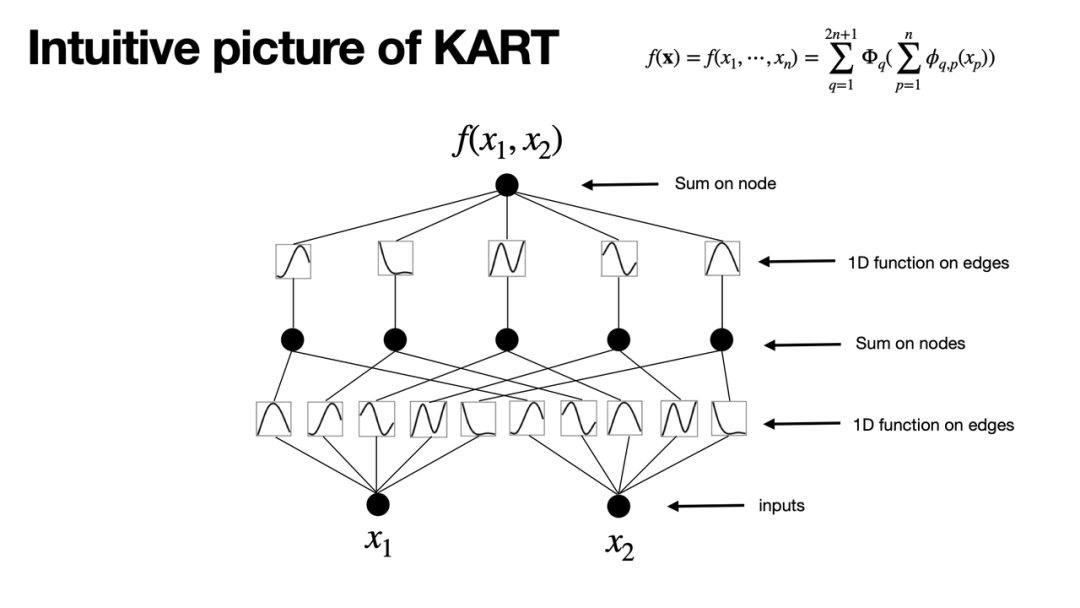

如图所示,Kolmogorov网络是一种特殊的神经网络结构,源于Kolmogorov-Aronld表示定理。在MLP中,神经元的概念是指在节点上有激活,但在Kolmogorov Network中,非线性激活函数不在节点上,而在边上。尽管如此,我们仍把这些图上的节点称为神经元。当我们谈论权重时,对应的是计算图的边。假设我们有一个两层的Kolmogorov网络,它只有两个输入变量,隐藏层有五个神经元。在这个网络中,每个神经元接收两个信号。第一个信号x1经过一个非线性函数φ₁₁进行激活,第二个信号x2经过另一个非线性函数φ₁₂进行激活,然后将这两个结果加起来。其他隐藏神经元也是类似的过程。至于第二层,例如最后的输出,它是由第一个隐藏神经元经过一个非线性变换Φ₁,加上第二个神经元经过非线性变换Φ₂等等,将所有这些隐藏神经元的经过非线性变换的信号加起来,形成最终的输出。

这个过程看起来有些抽象。实际上,我们可以更直观地通过曲线来表示这些函数,因为无论是φ还是Φ,它们都是一元函数。一元函数的好处是可以用曲线来刻画,这样在直观上更有助于理解。

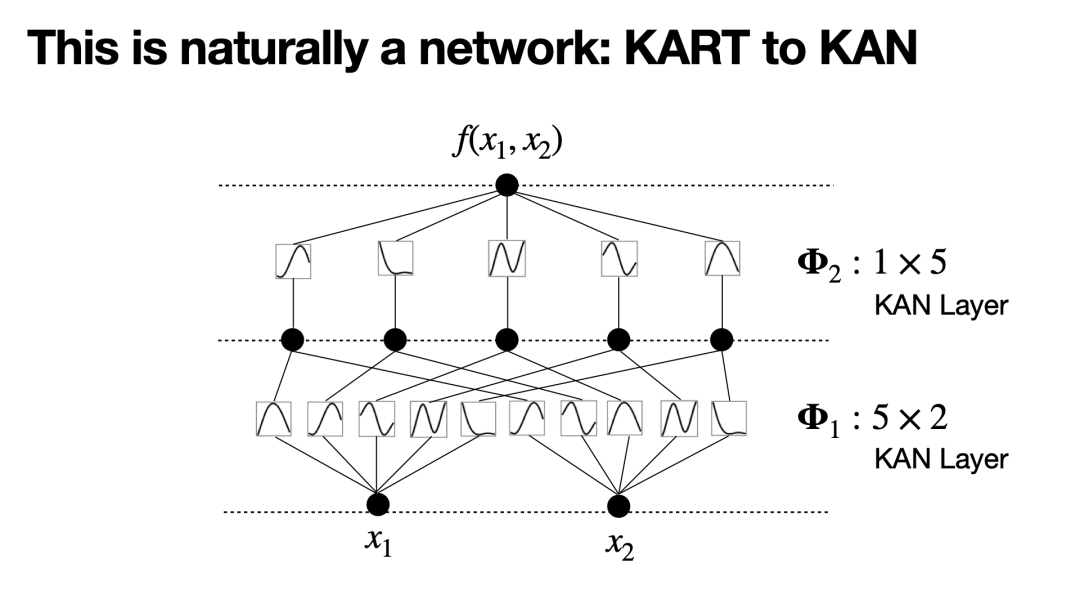

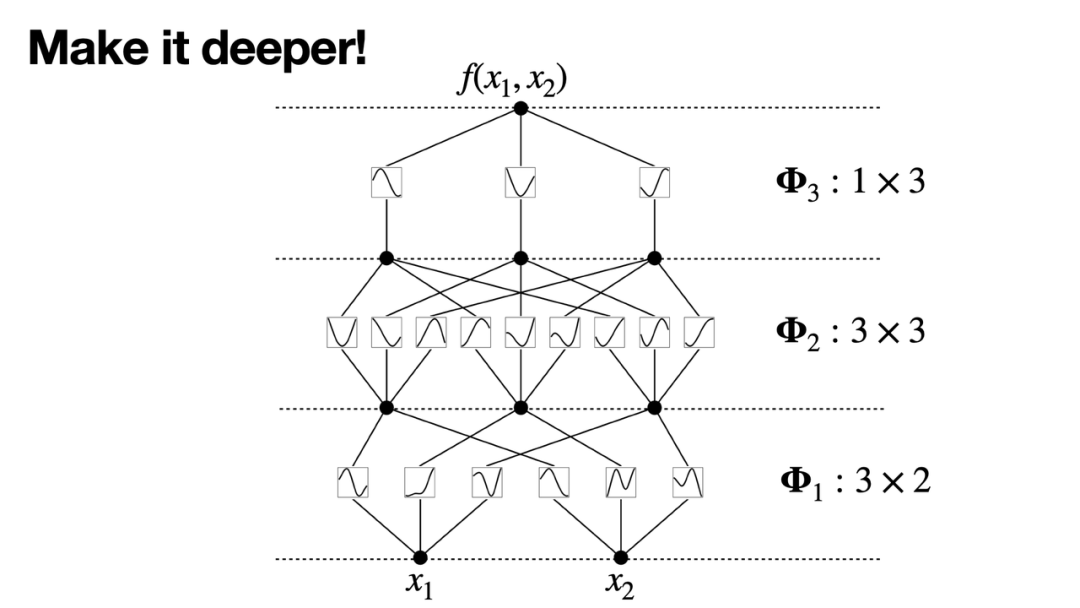

一个重要的观察是,KA方程的方式可以直接转化为一个网络。这不是我们最初发现的。最早的Kolmogorov网络特指的是一个两层且宽度为2n+1的网络。虽然在KA表示定理中,内部函数和外部函数是分开处理的,但如果我们从计算上进行统一,会发现内部函数和外部函数实际上是一样的。它们都可以被抽象成我们现在称为KAN层的结构:第一层实际上是一个5×2的KAN 层,第二层则是一个1×5的KAN 层,与MLP中的线性层相似。

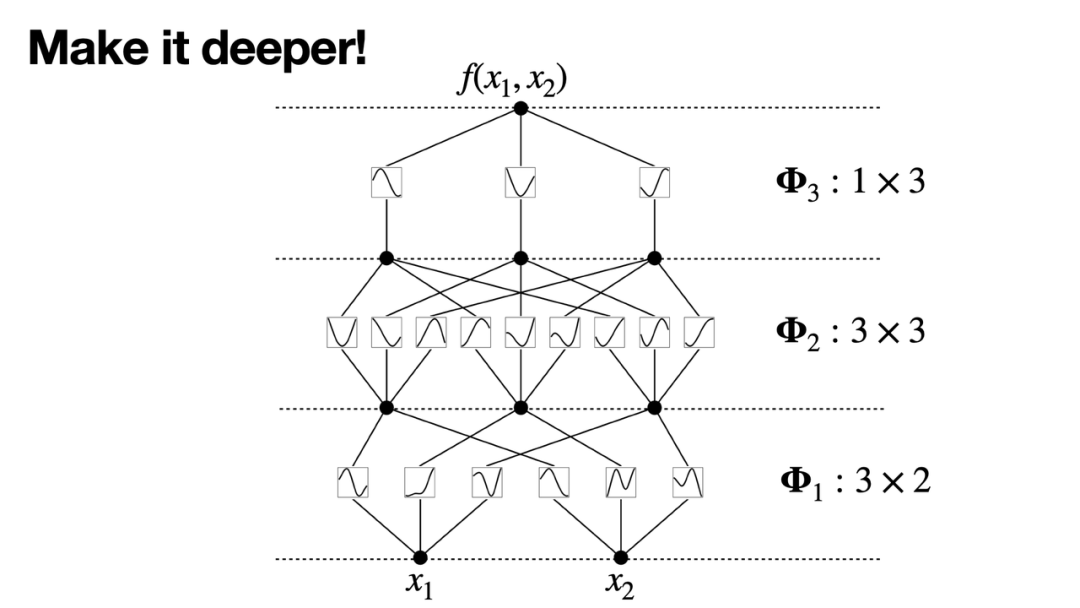

基于这样的类比,我们就可以更容易地构建更深层次的KAN网络。就像构建更深的MLP网络可以通过叠加更多的线性和非线性层来实现一样,堆叠更多的KAN层,就能构造更深的KAN网络。

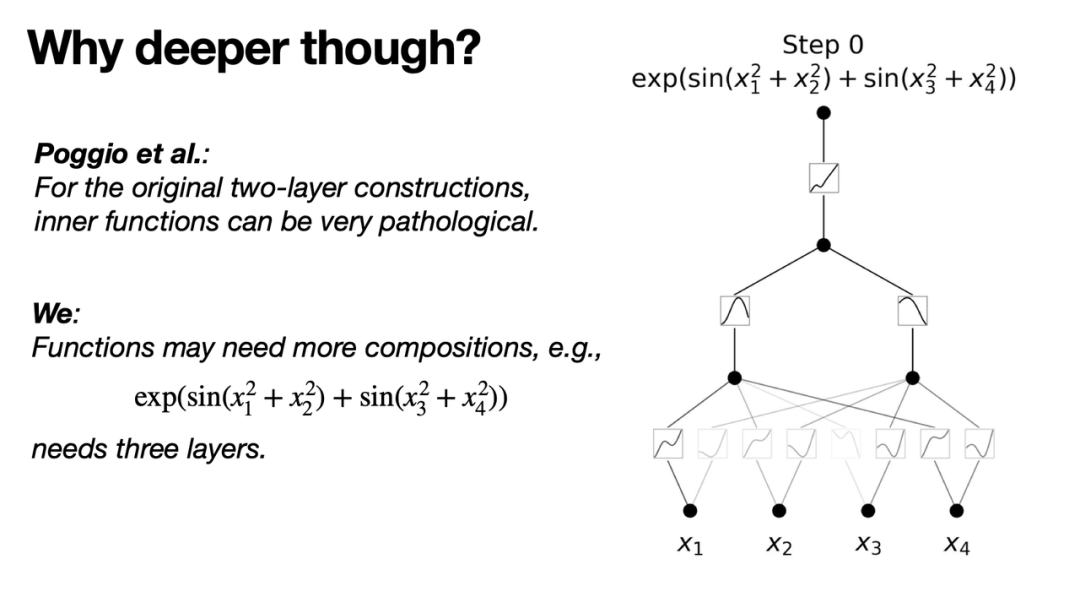

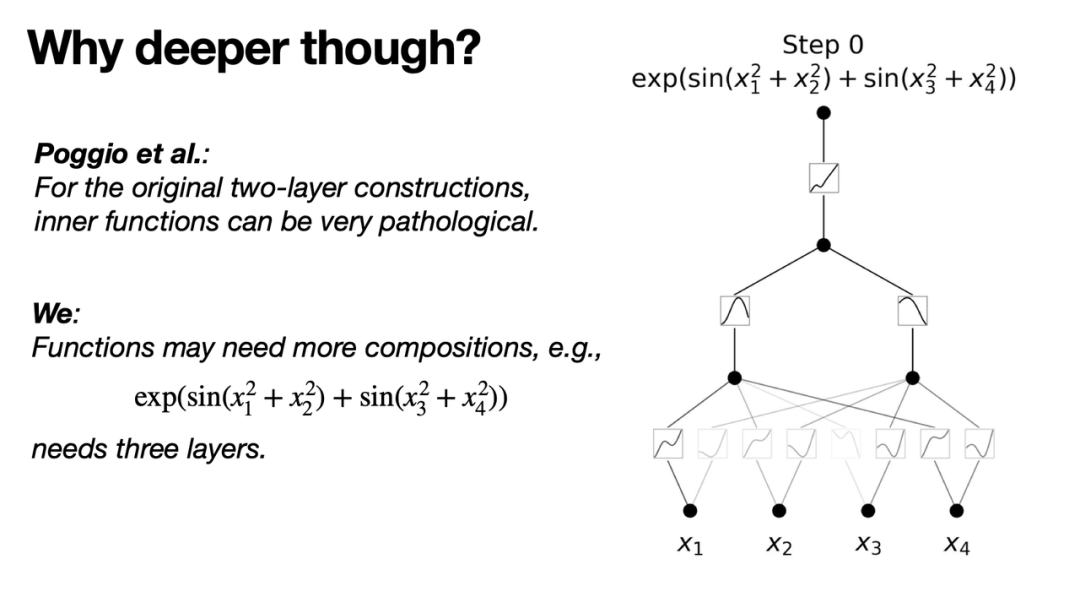

但你可能会问,如果原始的Kolmogorov表示定理说一个两层的网络就可以表示所有光滑函数,为什么还要构建更深层的网络呢?答案是,原始的两层结构并没有限制其激活函数是否光滑。有时,这些激活函数可能需要用到非常非光滑甚至有分形行为的“病态”函数来表达。这就失去了现实意义。这在实际应用中意义不大。因此,加深网络的直观理由是希望那些原本无法被光滑表示的函数能够被光滑地表示。

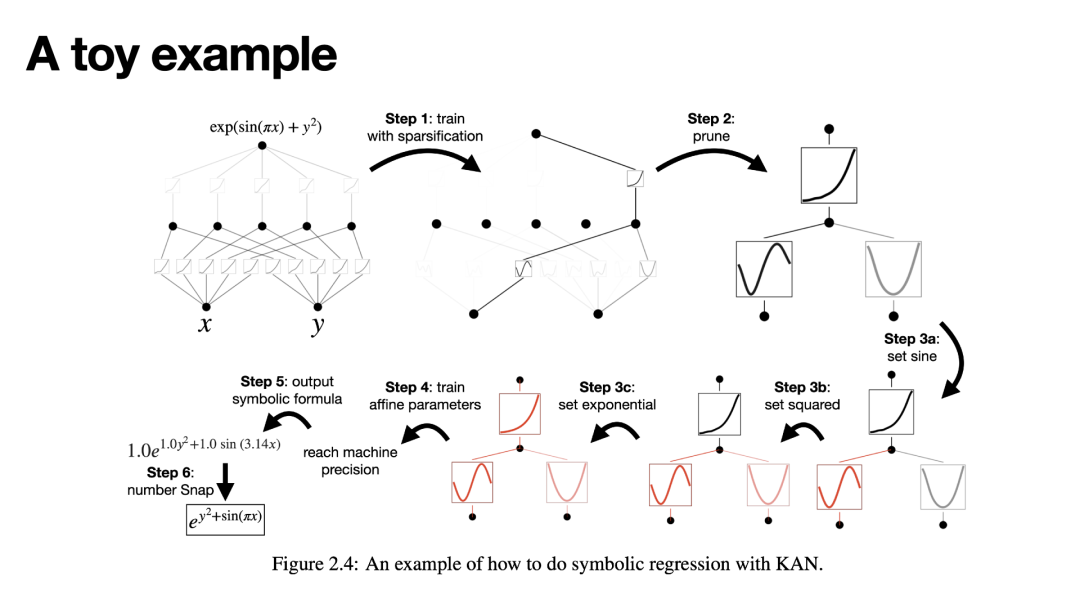

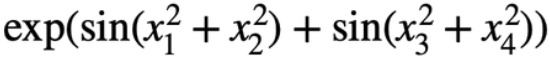

例如,考虑一个函数示例,如指数正弦函数 。如果要建立一个能够表达这个函数的模型,至少需要三层非线性网络:第一层进行平方运算,第二层应用正弦函数,第三层进行指数运算。这表明,即使是简单的几何函数也可能需要复杂的网络结构来精确表达。接下来,我们可以看到,训练过程中网络能够学习并模拟这些基本的数学函数。例如,在三层网络中,第一层学习平方运算,第二层学习正弦函数,第三层学习指数运算。这种方式展示了网络的学习能力和其对复杂函数的逼近能力。

这里展示了MLP和KAN网络在结构上有一定的对应关系。MLP的数学基础是全局逼近定理(universal approximation theorem),而KAN的基础则是KA表示定理。尽管两者都能实现函数逼近,但在它们的实现方式和理论基础上存在显著差异。全局逼近定理指出,一个含有足够多神经元的前馈神经网络可以逼近任何复杂的连续函数,无论这个函数有多少个输入变量。全局逼近定理强调了需要足够宽(n足够大)的网络,才能实现输出与目标函数之间较低的误差,理论上无穷高的精度需要用无穷宽的网络来实现。而KA表示定理则表明,可以用有限大小的网络实现无限精度的逼近,虽然这种逼近可能依赖于非光滑的激活函数。

这不意味着Kolmogorov网络一定优于MLP,因为Kolmogorov网络的激活函数不一定是光滑的,需要看具体情况。例如当一个函数(尤其科学中许多符号函数)能被KA表示定理严格表达,那么KAN网络可能提供比MLP更紧致和更可解释的表达方式。如图(a)和(b)所示,我们比较了两层MLP和两层KAN的结构。对于MLP,激活函数固定在节点上,一些MLP架构的激活函数是可学的;对于KAN,激活函数设置在边上,是可学习的,而节点上的操作则相对简单,就是线性组合,把所有输入加起来。图(c)和(d)则展示了更深层的MLP和KAN的结构。

。如果要建立一个能够表达这个函数的模型,至少需要三层非线性网络:第一层进行平方运算,第二层应用正弦函数,第三层进行指数运算。这表明,即使是简单的几何函数也可能需要复杂的网络结构来精确表达。接下来,我们可以看到,训练过程中网络能够学习并模拟这些基本的数学函数。例如,在三层网络中,第一层学习平方运算,第二层学习正弦函数,第三层学习指数运算。这种方式展示了网络的学习能力和其对复杂函数的逼近能力。

这里展示了MLP和KAN网络在结构上有一定的对应关系。MLP的数学基础是全局逼近定理(universal approximation theorem),而KAN的基础则是KA表示定理。尽管两者都能实现函数逼近,但在它们的实现方式和理论基础上存在显著差异。全局逼近定理指出,一个含有足够多神经元的前馈神经网络可以逼近任何复杂的连续函数,无论这个函数有多少个输入变量。全局逼近定理强调了需要足够宽(n足够大)的网络,才能实现输出与目标函数之间较低的误差,理论上无穷高的精度需要用无穷宽的网络来实现。而KA表示定理则表明,可以用有限大小的网络实现无限精度的逼近,虽然这种逼近可能依赖于非光滑的激活函数。

这不意味着Kolmogorov网络一定优于MLP,因为Kolmogorov网络的激活函数不一定是光滑的,需要看具体情况。例如当一个函数(尤其科学中许多符号函数)能被KA表示定理严格表达,那么KAN网络可能提供比MLP更紧致和更可解释的表达方式。如图(a)和(b)所示,我们比较了两层MLP和两层KAN的结构。对于MLP,激活函数固定在节点上,一些MLP架构的激活函数是可学的;对于KAN,激活函数设置在边上,是可学习的,而节点上的操作则相对简单,就是线性组合,把所有输入加起来。图(c)和(d)则展示了更深层的MLP和KAN的结构。

算法原理是直观的,具体实现有一些技巧性和可能面临的困难,这里具体分享一下。

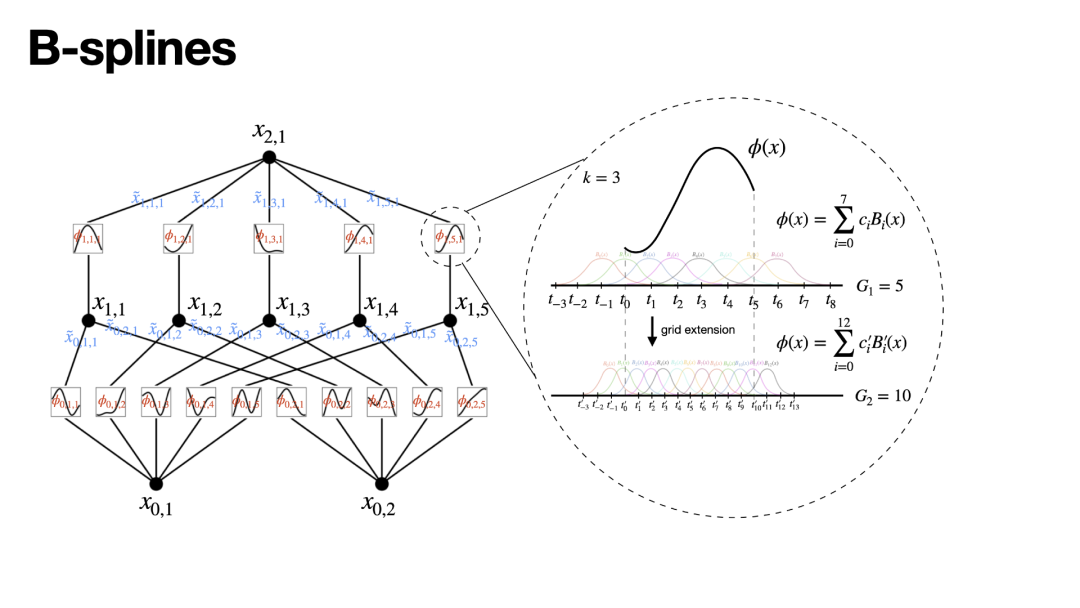

首先,我们面临的一个问题是如何参数化可学习的激活函数。因为这种激活函数是一维的,所以我们选择使用样条函数(Spline)来进行参数化。具体来说,我们采用了B样条。B样条利用一些局部的基函数,最终的样条函数实际上是这些局部基函数的线性组合。真正学习的参数是这些B样条前的系数ci。使用样条函数的一个优势是它允许你在不同的分辨率之间自由切换,例如,分辨率从5个区间的粗糙网格到10个区间的细网格。这意味着当你拥有更多的数据并希望使模型更加精确时,你不需要重新训练网络,只需要细化网格即可。

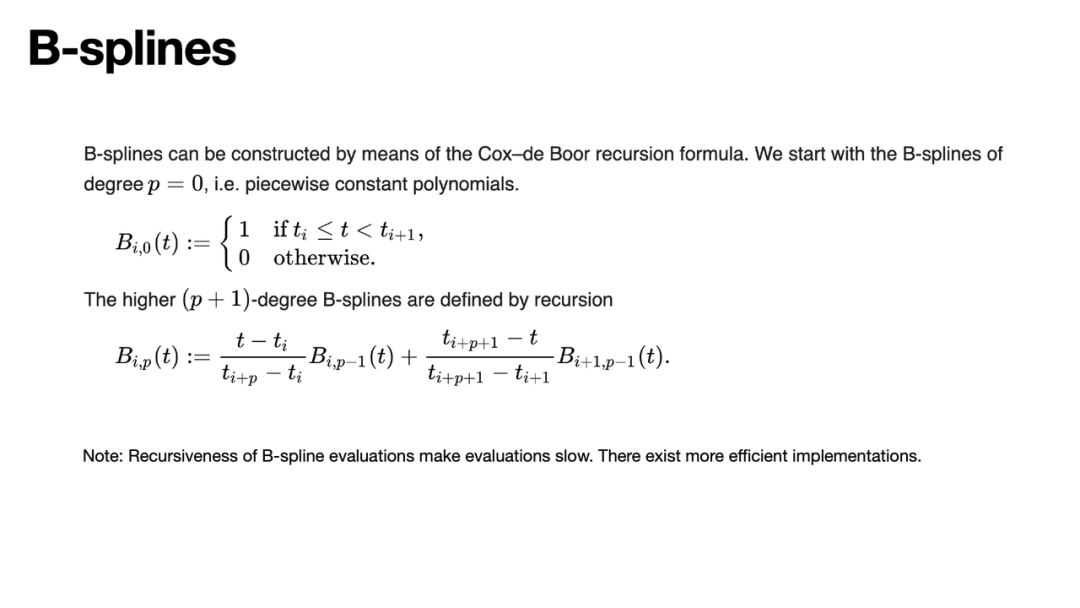

当然,这要求你已经学习到了正确的结构。在具体实现B样条时,常用的方法是采用de Boor递归公式。尽管这种方法看起来很优雅,但它在实现时存在效率问题,因为需要递归计算,这会导致计算成本非常高。最近一些KAN的跟进研究,如Efficient KAN,尝试避免递归计算,以加速KAN的处理。当然,这些都是后续的改进。KAN的原始实现也使用了3个技巧,这些技巧是在进行许多尝试后发现有效的,可能还还不是最优的。

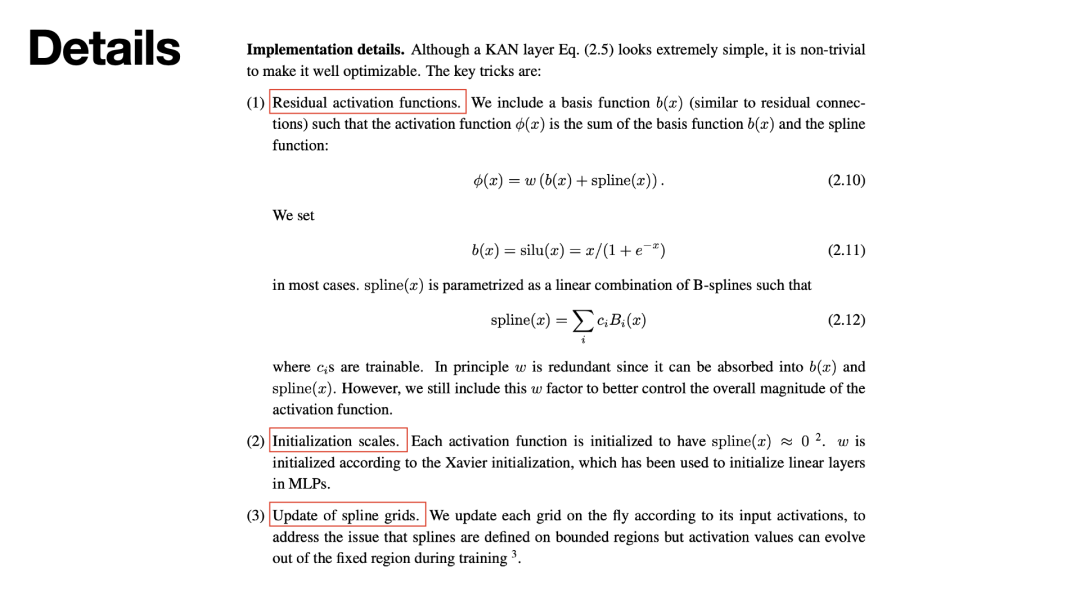

首先,一个关键的技巧称为“残差激活函数”。如果我们仅将激活函数初始化为样条函数,虽然它在局部区域内光滑,但随着网格点的增加,整体将显得震荡且非光滑。这种状态对于损失函数的可微分非常不利。因此,我们的策略是在一个平滑的函数基础上增加一些扰动作为初始化。我们选择了使用Selu作为基础激活函数(缩放指数线性单元,Scaled Exponential Linear Unit),并将样条函数几乎初始化为零。但不能将其完全初始化为零,类似于不能将MLP中的线性层完全初始化为零。

第二个要点是初始化的尺度。这是MLP或任何神经网络共有的问题。我们希望激活函数能够保持在一个合适的运作范围内,因此需要精心选择尺度,以确保激活值处于这个范围。

第三个重要的点是需要对样条的区间和网格进行更新。通常,对于单层样条,数据范围是固定的,这使得设定一个有界区域变得简单。但在KAN中,由于它是多层的,后面层的样条输入实际上是不确定的,会随训练改变。这导致一个问题:样条必须在一个有界区域内工作,所以当区域改变时,需要动态更新这个区域。

尽管尝试了一些其他策略,包括加入规范化层和使网格可学习,但这些尝试并不成功。最后,我们发现通过每训练20步后评估激活函数的工作区间,并根据样本激活分布调整网格,是一种较为有效的方法。当然,也有可能存在更优的方法。

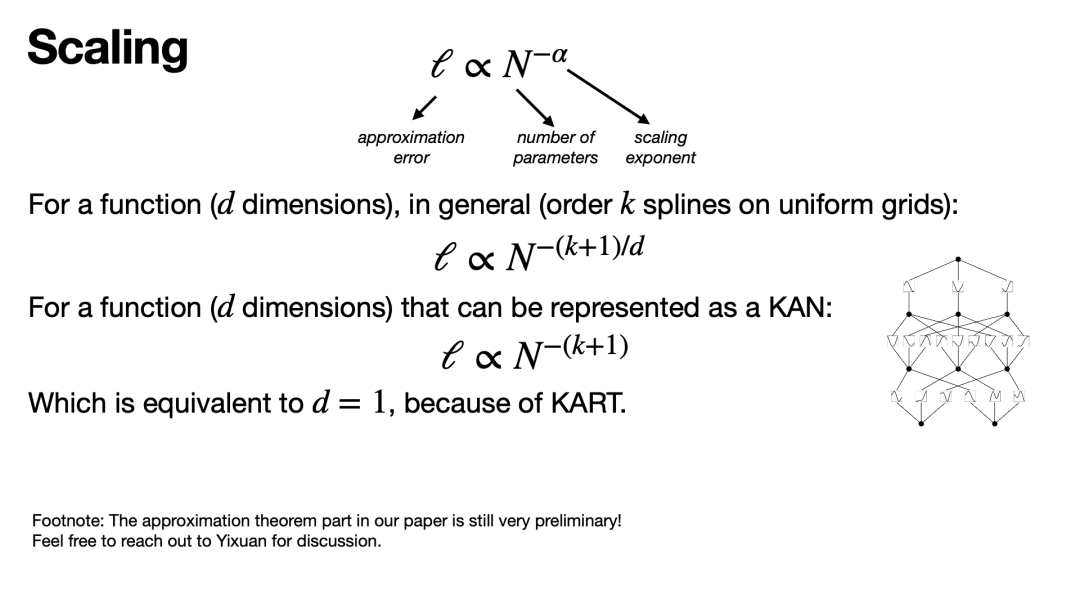

现在,让我们来讨论KAN的一些特性,并进一步探讨它的潜在优势。首先,一个大家可能较为关注的特性是其缩放性能,即所谓的规模定律(Scaling Property)。众所周知,在技术进步中有一些重要的规模定律,例如摩尔定律。特别是在构建大型模型时,常见的观察是模型的参数规模越大,其性能通常会越好。

具体来说,模型的错误率或损失,也就是近似误差,通常会随着参数数量的增加按照幂律减少,其表达式为N-α,其中α是一个表示减少速度的指数。换言之,这个指数直接反映了当参数数量翻倍时,损失函数减少的速度将如何变化。

在传统的函数拟合环境中,如果对函数的具体结构并无了解,我们可能只能在高维空间中绘制非常均匀的网格。这就引发了所谓的“维数灾难”,因为随着维度的增加,每个维度上的网格数量会呈指数级增长,这将导致精确度极度降低。在这种情况下,缩放因子通常表示为(k+1)/d,我们希望α越大越好,因为这意味着损失下降得越快。

然而,如果一个多维函数可以被KAN表示,那么实际的维数d就变成了1,其缩放性能将显著提高。KAN理论指出,一个 d维的函数可以被分解为大约d2个单元函数和加法的组合。因此,要学习这样一个函数,实际上只需要处理d2个量级的一元函数。当使用样条函数进行逼近时,它的性能提升为k+1的缩放。

当然,这里需要提及的是,这种逼近理论还相当初级,它还与函数空间有关。我们的一些合作研究正在讨论如何进一步上完善这个逼近理论。当前的理论假设所有函数都是光滑的,这在物理上通常是没有问题的,但在数学上可能需要更多的探讨,以明确函数空间的确切性质。

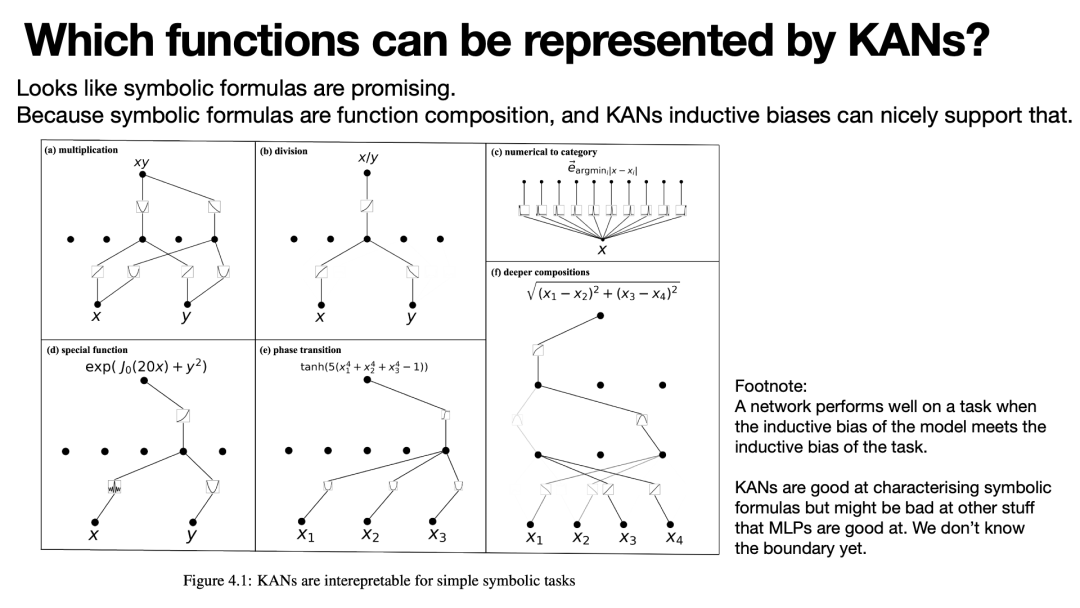

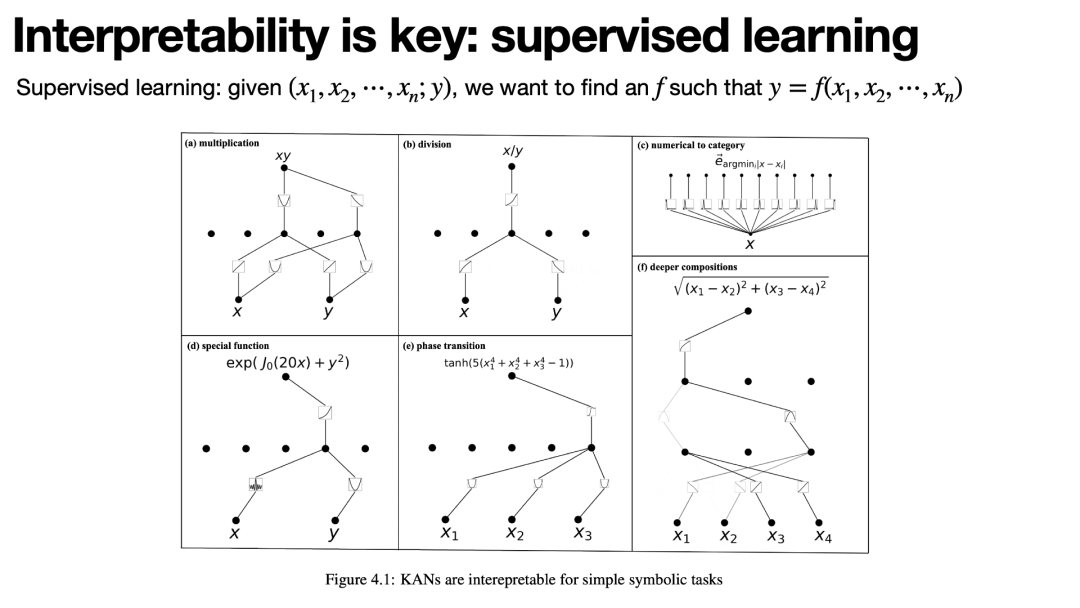

有人可能会担心KAN的实际应用性——即哪些函数是可以被KAN表示的。前面假设函数可以被KAN表示,如果不能,那么即便存在规模定律,它也是无意义的。在这一点上,我们认为虽然没有严格证明,但许多符号函数很可能都可以被KAN表示。这是因为符号函数本质上是函数的复合,而KAN的核心能力就是捕捉这种函数的复合结构。这里有几个例子可以说明这一点:

-

乘法操作:考虑输入 (x) 和 (y),其目标是预测 (x×y) 的结果。在经过训练后,模型能够计算 ( (x+y)2 ) 与 ( x2 + y2 )。进一步,通过 ( (x+y)2 – (x2 + y2) ) 的计算,可以得到 (2xy),从而实现乘法操作。

-

除法操作:为了简化,假设 x 和 y 都是正数。这时,KAN可能学习到一种使用对数的表示方法,即首先对 x 和 y 取对数,然后在对数空间进行减法操作,最后通过指数化返回,从而实现除法。

-

特殊函数:例如,考虑是否可以学习到如贝塞尔函数这样的特殊函数。训练后,KAN可能确实能够学习并模拟出贝塞尔函数的形状。

-

阶段转换模拟:模拟一些复杂的物理现象,如四次方和双曲正切,KAN同样能够学习到并表现出相应的行为。

-

计算距离:对于需要计算二维空间中两点距离的情形,可能需要至少三层网络,包括线性层、平方层和开方层。这显示了KAN在处理这类计算时的适应性和效率。

以上例子表明,KAN不仅能够捕捉简单的算术运算,还能模拟更复杂的数学函数和物理现象,显示出其广泛的应用潜力和表示能力。

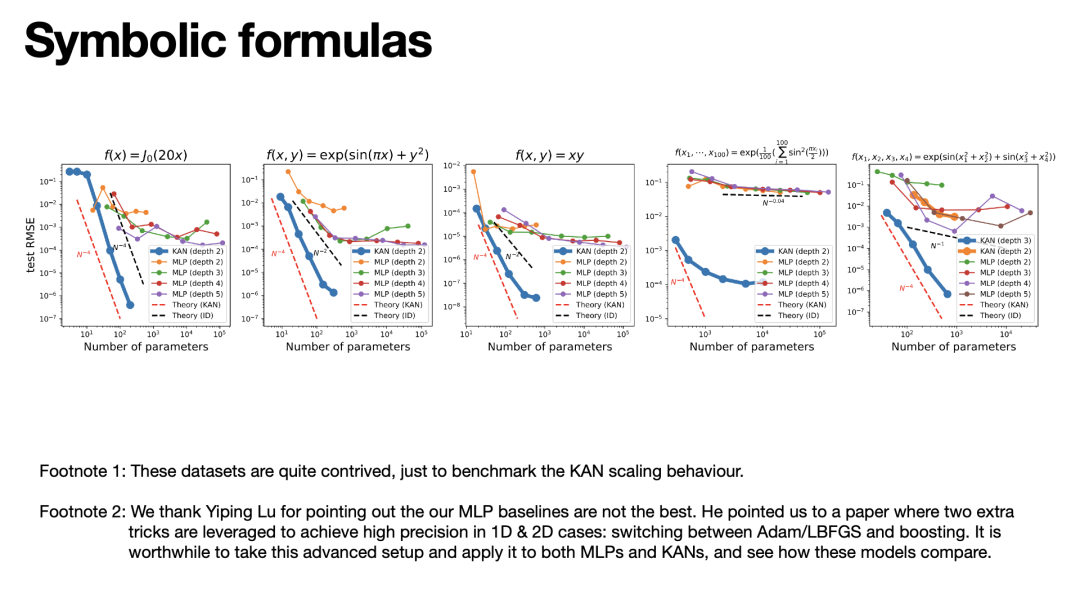

上面提到了符号函数(symbolic formula)是可以通过KAN进行有效表示的。这里,我们通过一系列实验来验证这一点,即比较KAN和MLP在表示这些符号函数上的效能。我们选取了五个例子,这些例子都是经过精心设计的,以确保它们能够被紧致地用KAN表示。

-

贝塞尔函数:这是一个一维函数的例子,虽然相对简单,但我们为了完整性仍然包括了它。在一维情况下,其缩放是 N-4,这是样条函数的典型缩放行为。相比之下,MLP在 10-4后就趋于平稳,表明其学习能力有限。

-

二维案例:这个例子的缩放基本上是 N-2,MLP在初期似乎遵循二次缩放规律,这表明它可能只是在二维平面上简单地划分网格并尝试拟合,而不是真正学习到函数的结构。

-

乘法:这是一个很有趣的例子,通常乘法被认为是二元运算符,但我们展示了它实际上可以通过将其分解为加法和一元函数的组合来计算。

-

100维的例子:这是一个构造的更复杂的例子,将100维的正弦平方值相加后再应用指数函数。理论上,MLP在这种高维情况下的表现会非常差,实际上也确实如此。而KAN虽然最终也达到了平稳状态,但其损失明显低于MLP,显示出其更强的学习能力。

-

更深层次的KAN需求:最后一个例子是为了展示当任务复杂性增加时,更深层次的KAN的必要性。这个例子需要至少三层的KAN来解决,而单层或两层的KAN无法有效学习到函数的结构。

这些实验表明,KAN在处理符号函数时不仅能更准确地捕捉函数的结构,而且通常比MLP有更好的性能,尤其是在高维和复杂的任务中。这证明了KAN在某些情况下比传统的MLP具有明显的优势。

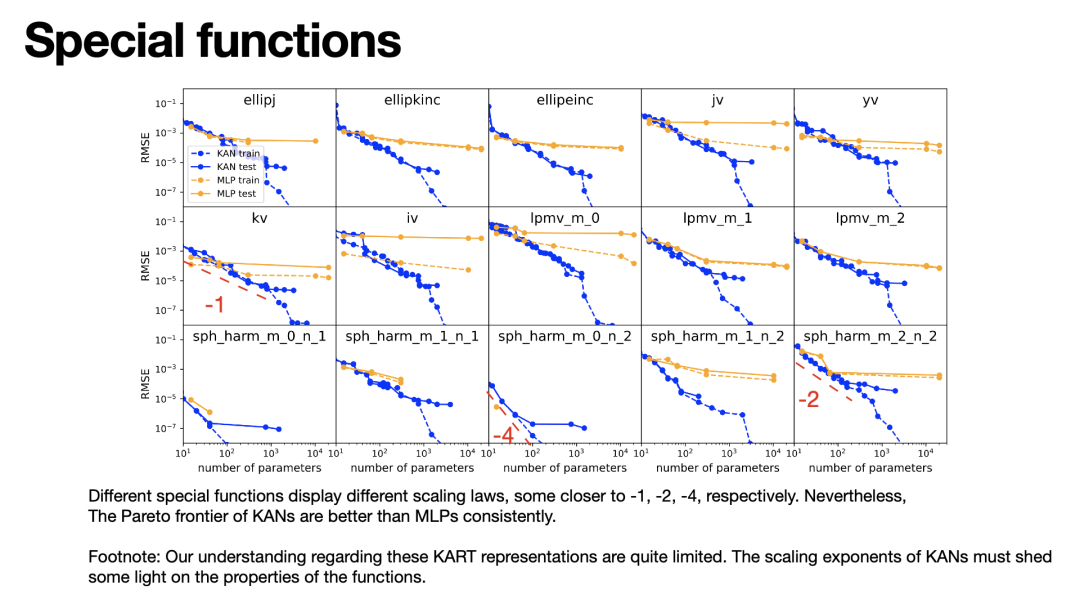

前面提到的例子涉及符号公式,我们知道这些公式通常有较为紧致的KAN表达形式。但如果我们不知道某个任务是否拥有紧致的KAN表示,该怎么办呢?

这实际上是特殊函数的情况,如贝塞尔函数 Jᵥ(x) 。当将 ν 和 x 同时视为输入时,它是一个二元函数,我们不知道是否存在紧致的KAN表示。在这种情况下,虽然KAN可能无法找到一个精确的解决方案,但它仍然能够找到非常好的近似解。我们在15个特定函数的任务上验证了这一理论,其中KAN在所有任务中的表现都优于MLP。我们通过图表形式展示了这些结果,横轴代表参数数量,而纵轴显示了损失表现。我们并没有只运行一个模型;实际上,我们对每个案例都运行了数百个模型,并在二维图上展示了那些处于Pareto前沿的模型(即模型在处理多目标优化问题中达到最优平衡)。显然,KAN在达到最优平衡性能上优于MLP。但在处理低维任务时,KAN的表现有时甚至不如样条函数。这意味着KAN背后仍然存在各种各样的优化问题,这是未来值得继续探索的。

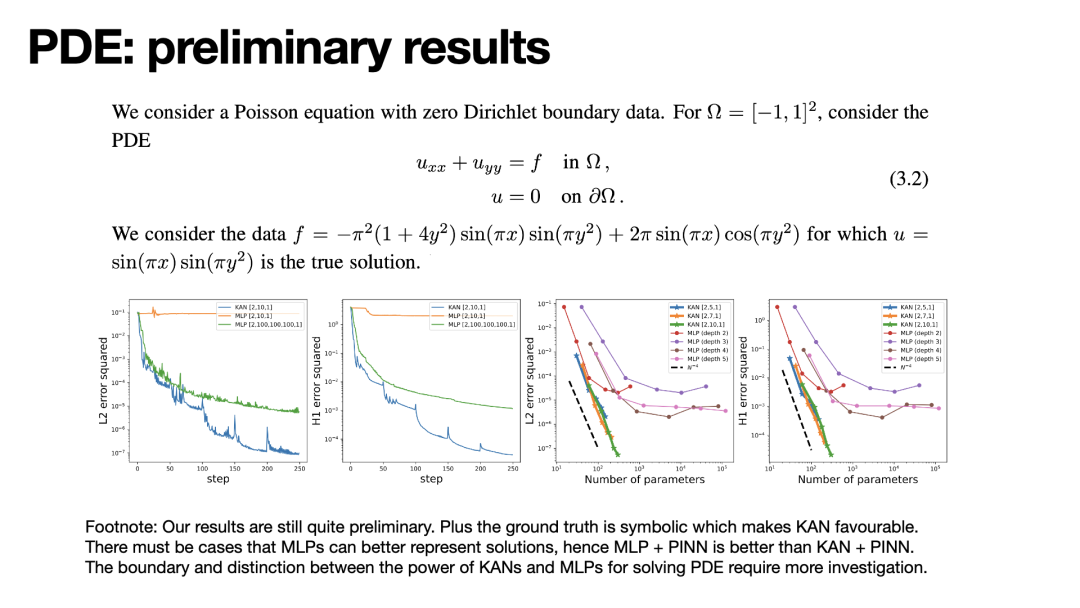

在探索偏微分方程(PDE)的解决方案方面,我们进行了一些基本实验。PDE的解决实际上也属于函数逼近的一部分,它本质上是对PDE解的特定拟合。因此,我们采用了基于物理信息的方法来解决PDE,并发现KAN相较于MLP展示出更优秀的缩放性能。KAN文章的目的更多是提供启示,展示这项技术的潜在应用,例如在PDE的处理上。这些实验结果仍然处于初级阶段,我们只进行了有限的试验。未来,我们计划进一步深入研究,并鼓励学术界参与探索。尤其是在PDE这一领域,尽管我们的实验还很浅显,但已显示出KAN在提高精确性和效率方面的巨大潜力。

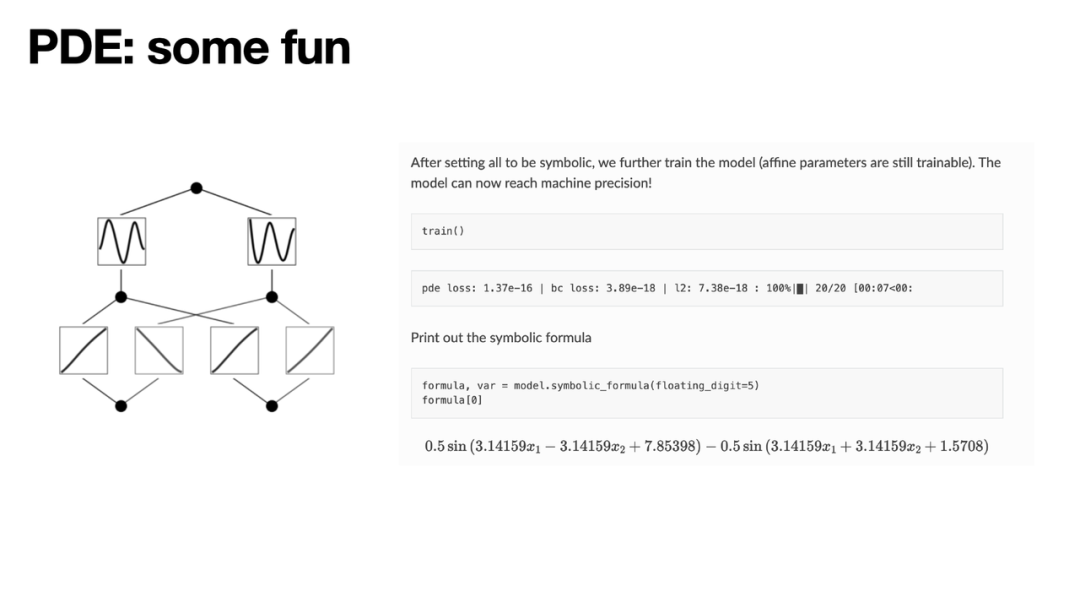

解决偏微分方程(PDE)并非新课题,学术界已经进行了长时间的研究,然而,KAN可能为此带来一些新的、有趣的视角。KAN与MLP的主要区别在于其解释性。例如,完成对一个PDE的训练后,我们可以将该PDE的解绘制出来,从而直观地理解解的结构。进一步地,我们可以进行符号回归,明确化解的符号公式,然后继续进行训练。这样,损失可能达到机器精度。这意味着如果解是符号化的,我们可以严格地求解出这个方程,得到一个精确的解,而不仅仅是一个近似解。这种方法不仅提高了解的精度,也增强了模型的科学价值和应用潜力。

在这一部分,我们将探讨KAN的可解释性。KAN能在多种设置下表现出色并具备可解释性。

首先,让我们考虑监督学习的场景。在这种情况下,存在着n个输入,即x1到xn,以及一个输出y。目标是找到一个映射函数f,它能将输入x1到xn映射到输出y,并能尽可能准确地预测y。这是一个大家都非常熟悉的设置。然而,为了提升模型的可解释性,我们引入了稀疏化技术。这种技术本质上与对神经网络进行L1正则化类似,但是我们在函数层面定义了L1正则化,并将其作为训练目标的惩罚项。此外,我们还开发了一些剪枝技术,以便将网络从较大规模简化为较小规模。

第二个场景是无监督学习。在许多任务中,我们可能不清楚如何合理划分输入和输出,尤其是在面临复杂组合问题时。在无监督学习的框架下,我们拥有一组变量,并对它们进行平等的处理。我们试图找到一个函数f,使其在所有样本点上的值都为0,但函数本身并非零值。这与流形学习类似,我们假设这些变量之间存在某种关系,并尝试发现这种关系的本质约束。在探索无监督学习的过程中,一个重要的挑战是如何避免函数f恒为零,因为如果f为零,那么任务就变得毫无意义。为了解决这个问题,我们采用了对比学习的策略,这使得原本的无监督问题转化为类似监督学习的问题。通过引入对比学习,我们可以将这个无监督问题转换成一个更易处理的形式。这里有一个具体的例子来说明这一点:考虑变量x1到x6,其中x3与x1和x2有关,而x5与x4有关。通过使用不同的随机种子,KAN能够揭示不同的相关变量。例如,第一个种子可能显示x1、x2和x3是相互关联的,而第二个种子则可能揭示x4和x5的关联。这种方法不仅提高了学习的效率,还增强了模型的可解释性,使我们能够直观地理解数据中的隐藏结构。通过这种方式,即使在没有明确监督信号的情况下,我们也能有效地从数据中学习并识别出变量间的复杂关系。

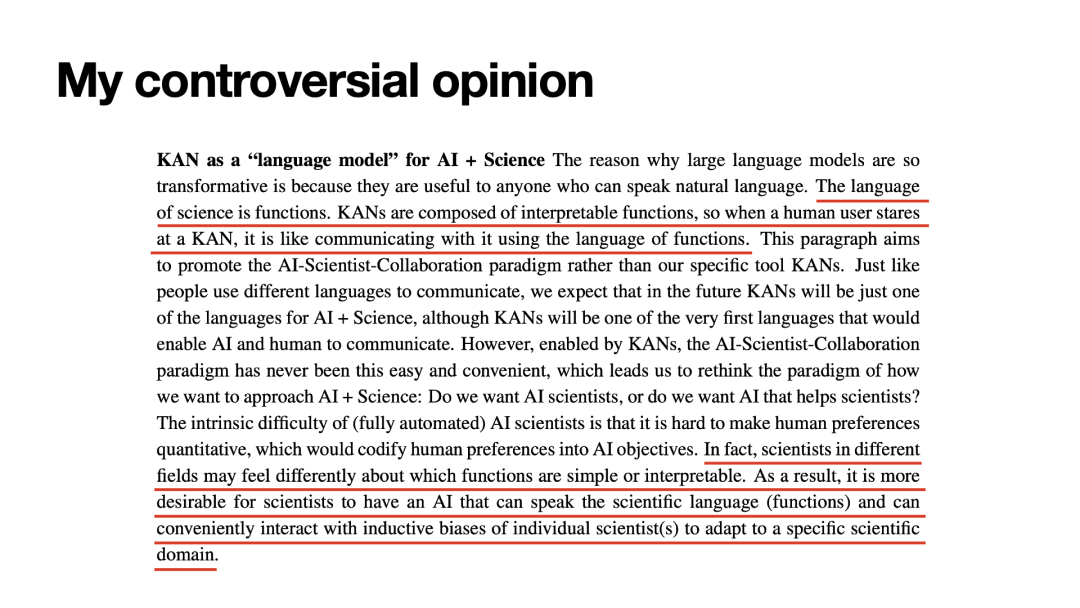

在接下来的部分,我们将探讨一个在社交媒体上引发了广泛讨论和极端观点的话题。我们对此感到非常自豪。KAN与AI领域的语言模型在科学研究中有着相似的作用。正如语言模型因其让任何理解自然语言的人都能与之互动而具有革命性的影响,KAN的“语言”并非自然语言,而是更为严格的数学函数语言。KAN的核心是使用可解释的函数进行构建。因此,当用户查看KAN模型时,就如同在观察一个透明的思考过程,所有的操作和逻辑都清晰地呈现在眼前。这种透明度使得用户仿佛在与模型进行对话,而对话的媒介就是函数——科学的语言。

另一要点是,来自不同领域的科学家对于什么是可解释的、什么是简单的、什么是逻辑清晰的有着各自不同的理解,这反映了他们各自领域的专业知识。因此,我们并不需要一个全能的AI神或AI神谕来提供答案,我们需要的是一个可以互动的工具,只有这样,我们才能真正信任它。从心理学或社会学的角度来看,这也解释了为什么AI在许多由好奇心驱动的科学研究中尚未发挥重要作用。

科学研究大致可以分为两类:一类是应用驱动的,如AlphaFold,其目标明确,主要关注预测的物理含义;另一类则是由好奇心驱动,不仅关注模型的输出,还追求深入理解其内部机制。AI在好奇心驱动的科研中尚未发挥重要作用的一个原因是,当前的AI大多采用连接主义风格,缺乏足够的可解释性。另一个原因是科学家不太愿意信任一个他们无法参与决策过程的系统。我们之所以信任合作伙伴,是因为我们可以与他们进行交流,这种参与感是信任的基础。然而,现有的AI系统往往缺乏这种互动性,这也是科学家难以信任AI结果的一个原因。

因此,要让科学家信任AI的结果,我们需要制作不仅可解释而且互动的AI系统。

符号回归

这里有一个例子可以解释交互性的含义。考虑一个相对简单的符号回归问题,我们有变量(x)和(y),输出则是一个公式。尽管实际的输出是数值,但在训练网络的过程中,我们会施加一些特定的约束。这可能最终导致我们训练出一个相对稀疏的网络。这时我们可以将网络剪枝,使其更小。

在这个阶段,人的作用就显现出来。例如,如果网络输出是一个正弦函数,你可以手动将其固定为sin函数。如果你认为某个输出是抛物线,可以将其设置为抛物线形状。同样,如果是指数函数,也可以相应设置。一旦所有的设定都完成,并且达到了机器精度,你就可以将这个公式具体化。虽然这里强调了人在这个过程中的作用,但实际上,对于这类相对简单的问题,完全自动化的解决方案也是可行的。然而,在更复杂的情况下,可能就需要人类的知识介入,以约束这个强大的表达能力,确保得到合理的结果。

数学:纽结理论

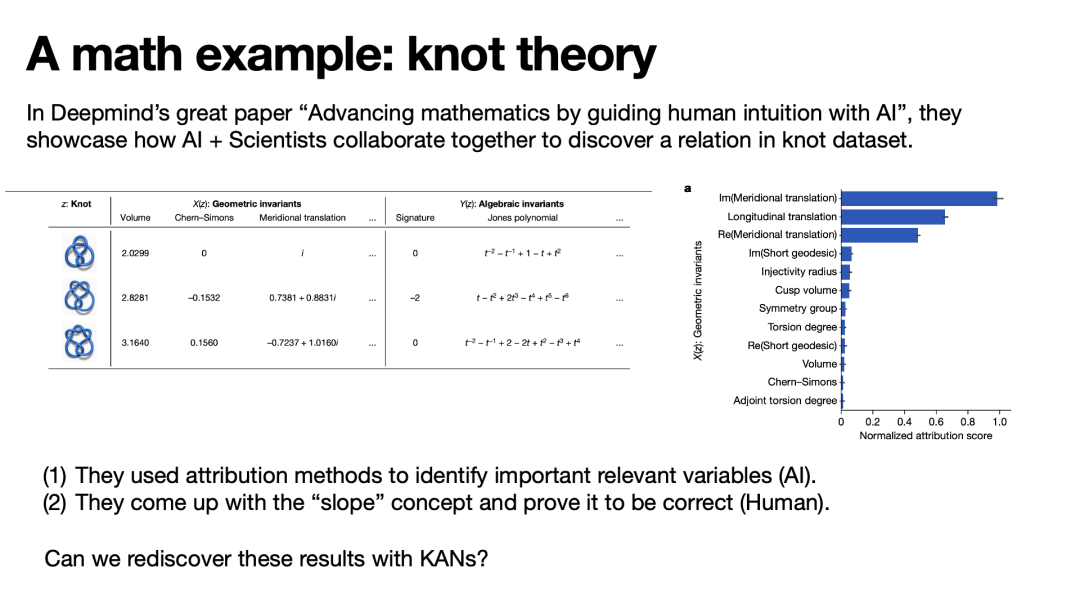

在这个研究路线下,我们尝试了两个案例。其中一个是DeepMind对拓扑不变量关系的研究。在他们的原始论文中,这篇论文发表于两三年前,他们描述了如何通过AI与人类科学家的协作发现一个新的扭结公式。他们的AI采用的是一种基础方法,通过特征归因方法训练一个MLP,以识别哪些变量是重要的。在确定了前三个重要变量后,人类科学家专注于研究这些变量,并定义了一个新的概念“slope”,然后由数学家进行了证明。

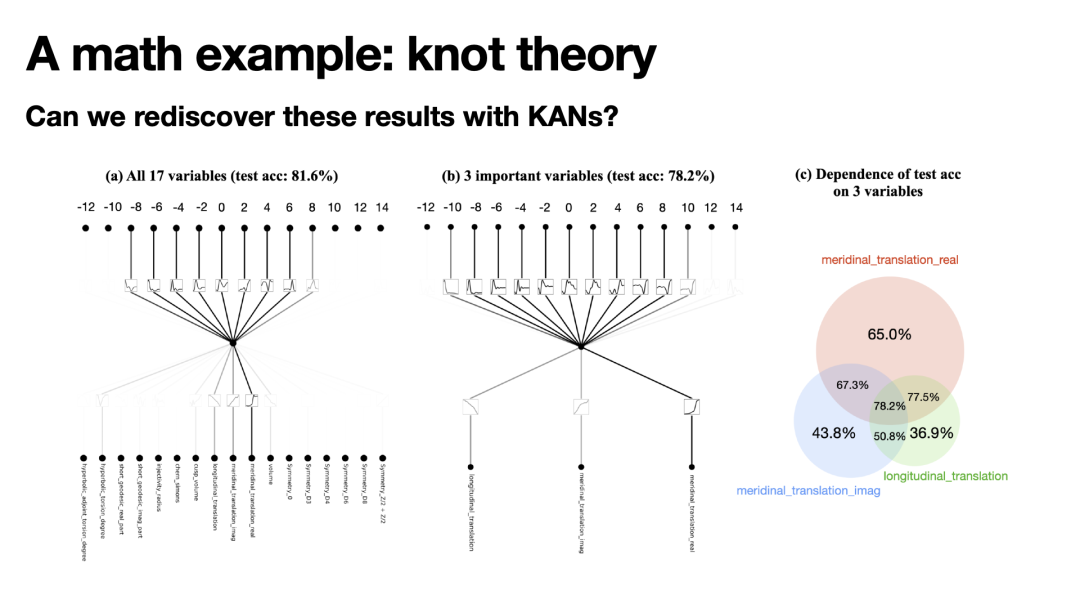

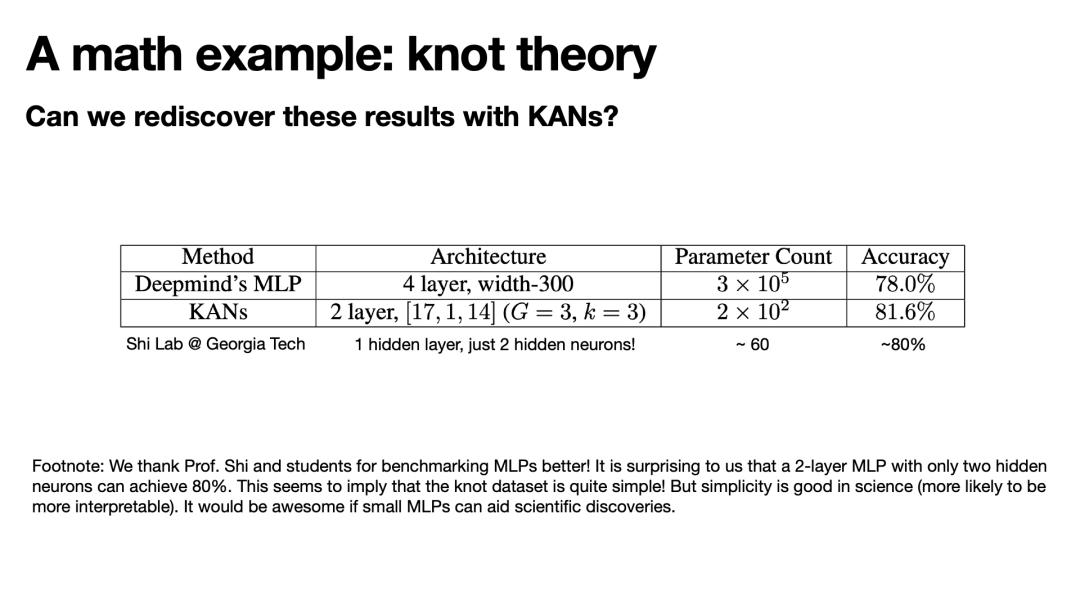

现在的问题是,我们能否使用KAN重新发现这些结果,而不需要人类科学家进行痛苦的探索。第一步是我们是否能重新发现这种变量依赖性。虽然这个任务相对简单,但值得强调的是,MLP也可以完成这项任务,但需要依赖特征归因。相比之下,KAN提供了一个更直观的方法,因为在可视化过程中,我们可以直接展示出变量的重要性和依赖关系,使得一目了然。

后来,Georgia Tech的史建军团队发现,对于特定科学任务,使用大规模的MLP并非总是必要的。他们发现,一个只有两个隐藏层和大约60个参数的简单MLP模型,就能达到与大型模型相似的效果。这个结果出乎意料,因为我们在KAN中并没有详细地基准测试MLP,而是直接使用了DeepMind文章中的数据和模型。因此,一个如此小的MLP也能取得良好的结果,这是一个惊人的发现。这说明,在科学研究中,我们有时并不需要庞大的模型。这与机器学习领域普遍的思维模式不同,后者通常偏向于默认构建具有多个层次和数百个节点宽度的网络。但对于科学任务,一个较小的模型就足以应对,而且可以在本地机器上运行,这是一个显著的优势。此外,较小的模型通常更易于解释,这对于科学研究尤其重要。

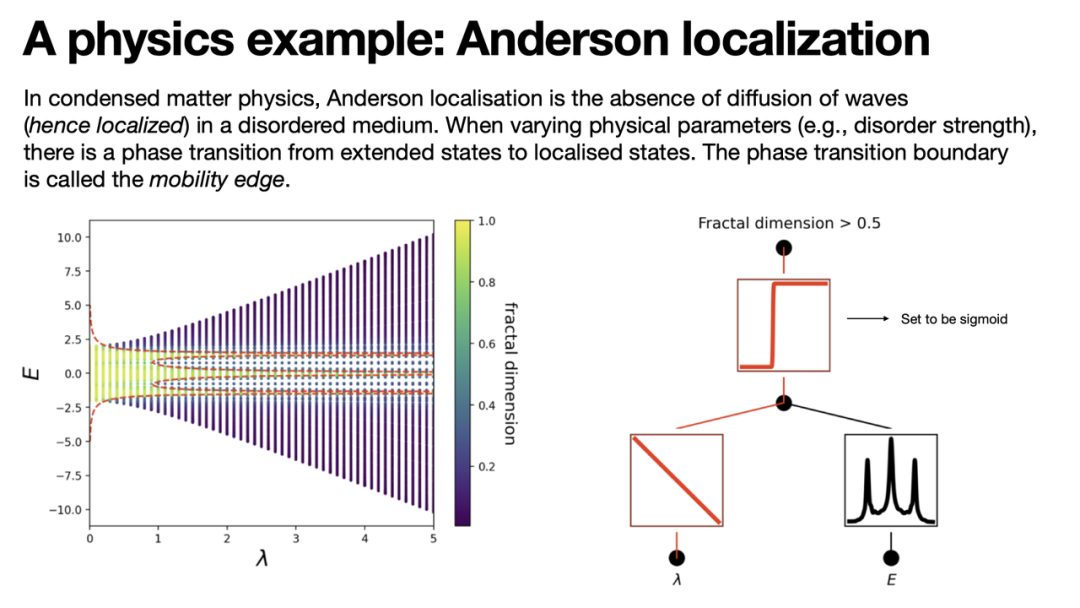

凝聚态物理:Anderson 局域化

我们还有一个关于物理学中凝聚态物理领域的Anderson localization例子。这个例子涉及到相变,特别是如何找到相变的边界甚至导出一个解析表达式。这个例子展示了假设测试的重要性。当存在两个或多个假设时,用户可以尝试设置不同的假设,继续训练模型,观察准确率的变化。最后,根据准确率或简单性(如果两个假设的准确率相当,但一个更为简单)来选择假设。这种方法不仅体现了人工智能的应用,还展示了人与AI之间的互动是如何在解决复杂科学问题中发挥作用的。

KAN有何特别之处?

首先,我们来探索KAN的独特性:KAN的特别之处在哪里?

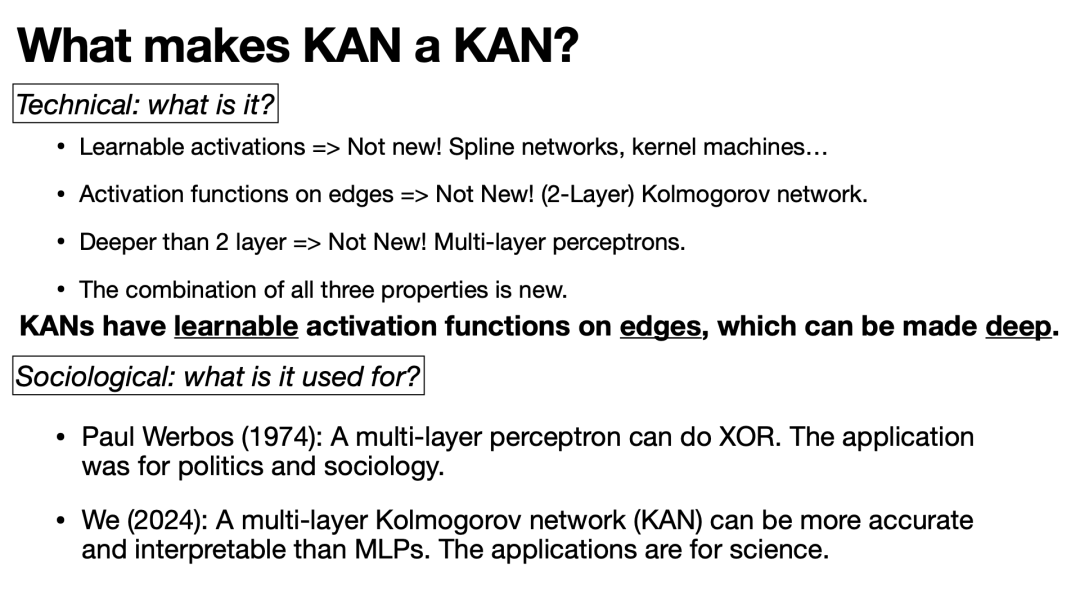

许多人认为,KAN的创新性可能并不如预期那样显著。例如,可学习的激活函数这一概念,在样条网络或是核机器中已有所体现,这并不是全新的概念。同样,将激活函数应用于边而非节点的观念,在二层的Kolmogorov网络中也已经存在。如果说KAN是一个深层网络,那么这同样不是一个新颖的概念;深度学习本身就包含了构建多层深度的网络结构。然而,将这三个概念——可学习的激活函数、激活函数应用于边、以及深层网络结构的结合,确实提供了一种新的视角。技术上,KAN的独特之处在于,它在网络的边上集成了可训练的激活函数,并且可以构建为非常深的网络。然而,仅仅讨论这些技术特性的创新性可能没有太大意义。更重要的是要考虑这些新特性能为我们带来什么实际益处,以及KAN能够完成哪些任务。这是我们评估任何新技术或方法时应当考虑的核心问题。

在此我们可以回顾研究历史。我们认为,我们的一个重要技术贡献是将KAN从两层扩展到三层及更深层次。将两层感知机扩展为MLP的重要里程碑可以追溯到1974年,由Paul Werbos实现。他首次将一个单隐藏层的感知机拓展到了多层,这使得MLP能够解决XOR问题(异或问题)——这是早期对感知机的一大批评。不过,Werbos的这篇论文主要聚焦于政治学和社会学领域,可能因此没有在计算机科学界引起较大反响,再加上当时信息传播的限制,其影响并未立即显现。在我们的工作中,KAN的发展实际上是在类比Werbos的工作,我们将一个两层的Kolmogorov网络扩展为多层结构。虽然我们称之为KAN,它本质上是一个多层的Kolmogorov网络,同时也是向Arnold致敬。

因此,我们展示的多层Kolmogorov网络,即KAN,能够在一些小型科学问题上提供比MLP更高的准确性和更好的可解释性。需要注意的是,我们的应用领域并非传统的机器学习领域,如计算机视觉或自然语言处理,而是科学研究。这与Paul Werbos当时的研究背景相似,尽管他是在政治学和社会学领域工作。唯一的不同可能在于今天的信息传播方式远比过去快速,特别是媒体的炒作效应,使得这些成就迅速为人所知。这是一件好事,尽管人们对此有不同的看法。

KAN的能力边界在哪里?

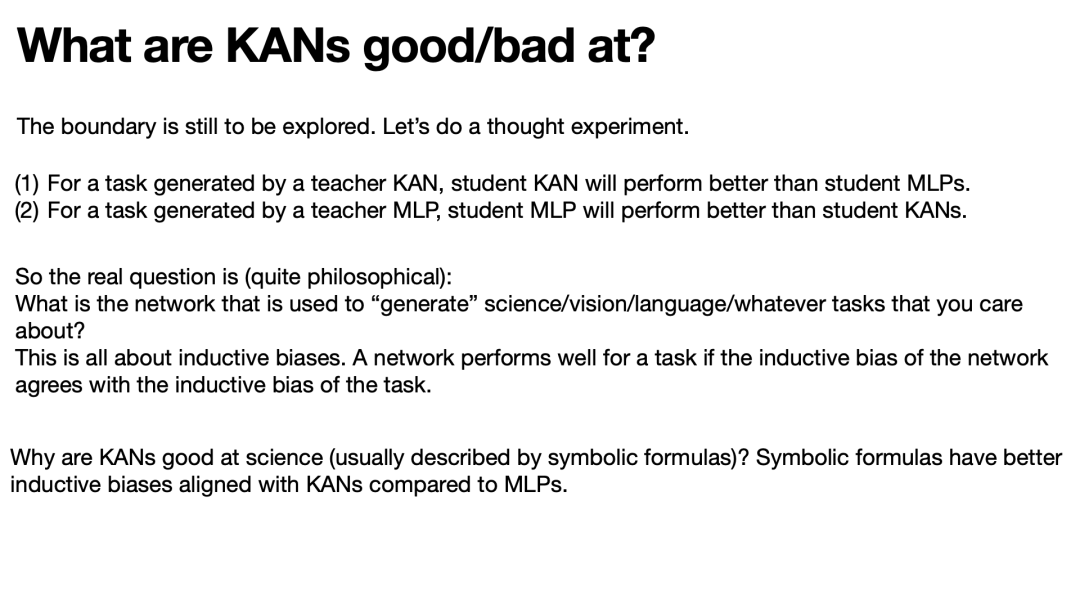

研究KAN的边界是一个我们仍需深入探索的领域。目前,这些边界尚不明确,特别是KAN与MLP之间的具体关系。有观点认为KAN是MLP的一种特例,但从理论角度来看,任何被视为通用逼近器的网络在理论上都是等价的。然而,为了理解这些技术之间的具体关系,我们需要从多个角度审视这些技术,不仅要从函数逼近的角度,还要考虑到优化、泛化和可解释性等更实用的因素。

我们认为,将KAN简单地视为替代MLP的观点是不合理的。例如,通过一个简单的“教师-学生”设置(teacher-student setup)可以揭示这一点:如果教师网络是一个KAN,那么学生的KAN网络应该表现得比学生的MLP更好。相反,如果教师网络是MLP,那么学生的MLP应该表现得比学生的KAN更好。

这种思考方式引发了一些哲学性的问题,例如自然规律是通过何种类型的“网络”来构建世界的。如果存在造物主,他又是使用何种类型的网络来构建这个世界的呢?对于不同的领域,如科学、视觉、语言或其他你关注的测试领域,由于它们的数据来源和生成方式可能不同,因此最适合的网络结构也可能不同。例如,在科学领域,由于函数的组合性可能更为重要,KAN可能表现得更好。而在处理图像等任务时,可能更适合使用类似MLP的结构,因为它们更依赖于随机特征或其他类似的结构。这是一个非常有趣的讨论点,但目前这些问题还难以量化。我们需要更多的实验和理论分析来深入探索这些网络的潜力和限制。

符号主义与连接主义

为了更好地理解符号主义与连接主义之间的动态变化,以及KAN带来的新视角,我们可以回顾一下相关的历史。

早在1957年,Frank Rosenblatt发明了感知机,并证明了它在处理某些线性可分数据和心理学实验中的有效性。然而,到1969年,Minsky和Papert出版了一本批评感知机的书,指出感知机甚至无法处理基本的XOR问题,这被视为其致命的弱点。这本书对Rosenblatt的理论造成了重大打击,甚至有传言称这导致了Rosenblatt的自杀。

1974年,Paul Werbos提出,通过将感知机扩展为多层结构,可以解决异或问题。但这一发现并未引起太大关注,因为它是在政治学和社会学的研究中被提出的,当时的信息传播并不畅通。

1975年,Robert Hecht-Nielsen探索了Kolmogorov表示理论,这是一个关于如何构造一个宽度为2n+1的双层网络的理论。1988年,George发现了两层的Kolmogorov网络能够处理异或问题。

这些年的发展揭示了感知机理论的兴起和对其的批评,导致了连接主义的暂时衰退,符号主义成为了主流。随着Kolmogorov表示理论的发现,连接主义又重新获得了关注。然而,进入1990年代,连接主义再次遭遇冷遇,如MIT教授Thomas Poggio在1989年指出,Kolmogorov的表示理论对神经网络是无关的,主要是因为在仅有两层的情况下,网络的激活函数可以非常不光滑,这不仅缺乏可解释性,而且表达能力也很差。

从2012年开始,现代深度学习的兴起标志着连接主义的复兴,这是一个以大型模型和广泛连接为特征的时代,虽然这些系统通常被视为“黑盒”,因为它们的可解释性较差。

这段历史概述不仅帮助我们理解KAN的技术背景,还揭示了科技发展中周期性的理论兴衰和科学社区的观点变迁。

KAN是连接主义与符号主义之间的产物。它的全连接结构与MLP非常相似。然而,我们可以将KAN缩小并赋予其符号化的特性,这反映了KAN与符号之间的联系。因此我们认为,KAN构成了连接主义与符号主义之间的一座桥梁,可能更有效地连接这两个世界。

在大语言模型的讨论中,我们经常探讨它们是否真正理解了物理规律。这需要一个同时具备符号主义和连接主义特性的模型。如何让连接主义学习,如何让符号主义精通其领域,这些都是我们需要考虑的问题。最终,我们探索的是符号主义中的物理学规律,而不仅仅是整个网络可能带来的不可解释性。

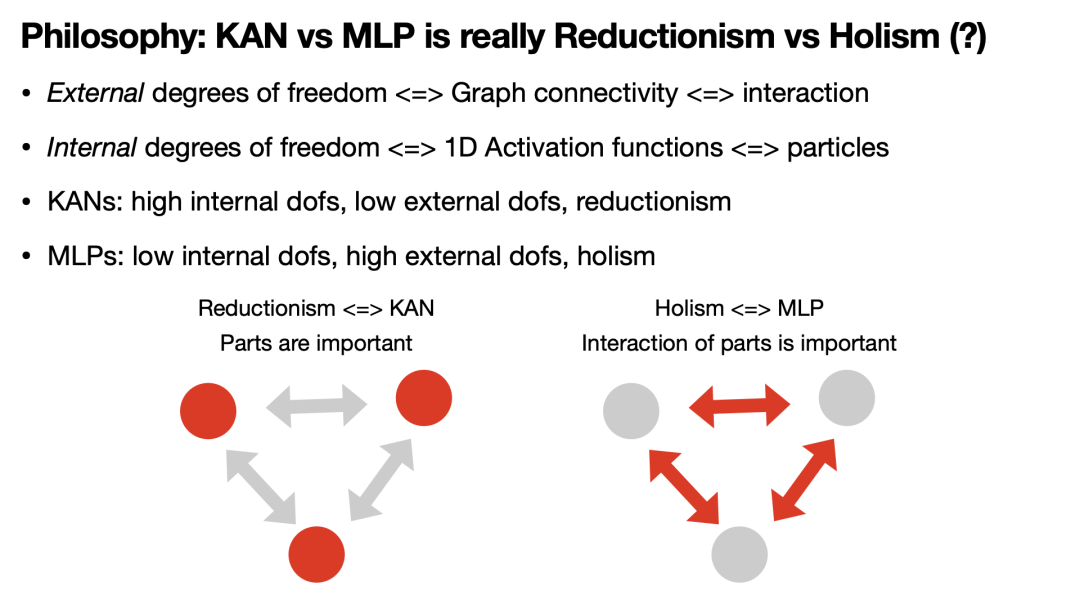

KAN vs. MLP 是还原论相对于整体论?

我们也刚刚意识到,MLP与KAN的主要区别在于它们对内部和外部自由度的处理方式。例如,基本粒子内部可能具有自旋等自由度,这是内部自由度。外部自由度则涉及其与外界的相互作用。在社会学中,人可以从内在品性或外部社会关系来定义。

KAN在MLP的基础上引入了新概念和更复杂的功能。它不仅关注连接,还关注部件的内部复杂性。MLP作为一个整体出现,不关心内部发生的具体过程,而是依靠复杂的连接来显现能力。而KAN则需要精细地设计每一部分,确保每个部分的重要性,从而简化部件之间的连接。

从哲学角度看,这体现了还原论与整体论的区别。还原论试图将复杂世界分解为简单的基本部分,而整体论则认为某些东西作为一个整体来工作,不能简单分解。这也解释了为什么KAN在科学领域特别有用,因为许多科学思想基于还原论,而整体论则在现代科学中逐渐流行。

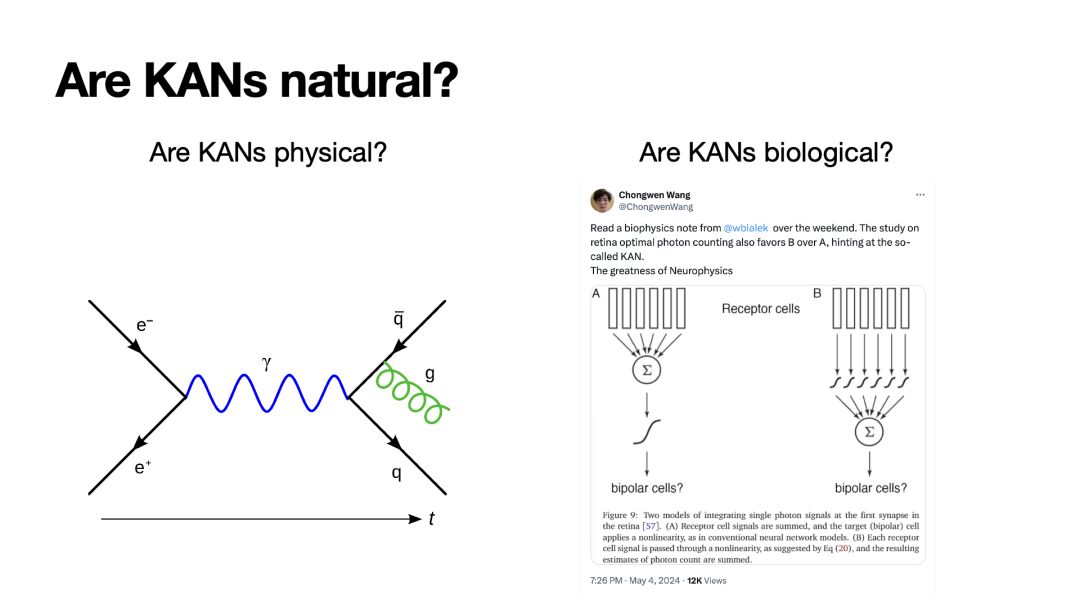

我们所讨论的KAN是一个人工神经网络,那么它到底有多“自然”呢?

首先,这是一个引人入胜的问题:它有多“物理”?考虑到费曼图,它实际上更像是MLP。在费曼图中,粒子在边缘部分自由传播,而在节点上则发生复杂的相互作用,这与MLP的非线性激活函数相似。我们也在探讨是否存在一些物理过程,这些过程可能更接近KAN而不是MLP,尽管这种类比可能粗糙。

其次,是关于KAN是否具有生物学特性。有一种观点认为,类似MLP的网络受到人脑的启发,而视网膜上的神经元则更像KAN。这表明,自然界中确实存在类似的机制,尽管这些机制并不是大脑中的主导机制。

想法来源

这项研究的发现其实是一个较长的故事。最初的想法产生在大约两三年前,目标是提高科学的可解释性,并尝试进行符号回归。那时,我们在自然神经网络的框架下进行思考,希望使节点上的激活函数变得可学习。初步实验显示,这种方法对于极其简单的例子是有效的,但对于稍微复杂一点的例子就无法应对。有兴趣的朋友可以查看附录中名为“learnable activation networks”的相关实验。

今年年初,我们重新审视了这个未解决的问题,意识到将函数放在边上可能使结果更具解释性。关于这一点的启示来自于导师Max和其他许多人的讨论,他们曾提到Kolmogorov-Arnold表示跟机器学习没有关联,因为它涉及的激活函数是非光滑的。这激发了一种叛逆想法:如果你说这个理论无用,那我就要创造一个有用的东西。那么问题就在于如何合理地设计Kolmogorov网络,使其具有实际应用价值。

在这个探索过程中,我们最初在两层网络上就遇到了困难,尤其是在如何设定宽度方面。尽管理论上说输入的隐藏层应该是2n+1,我们花了很长时间在这个设置上调整,后来才意识到这个设置可以更灵活。最终,我们注意到原始的Kolmogorov-Arnold表示法是基于两层的网络,我们可以自然地将这些层堆叠起来,形成更深的网络。这种外推的逻辑不是一开始就明显的,因为内层函数和外层函数的指标不同。但当我们意识到所有层都是两个指标后,就像堆叠线性层或MLP那样变得简单。

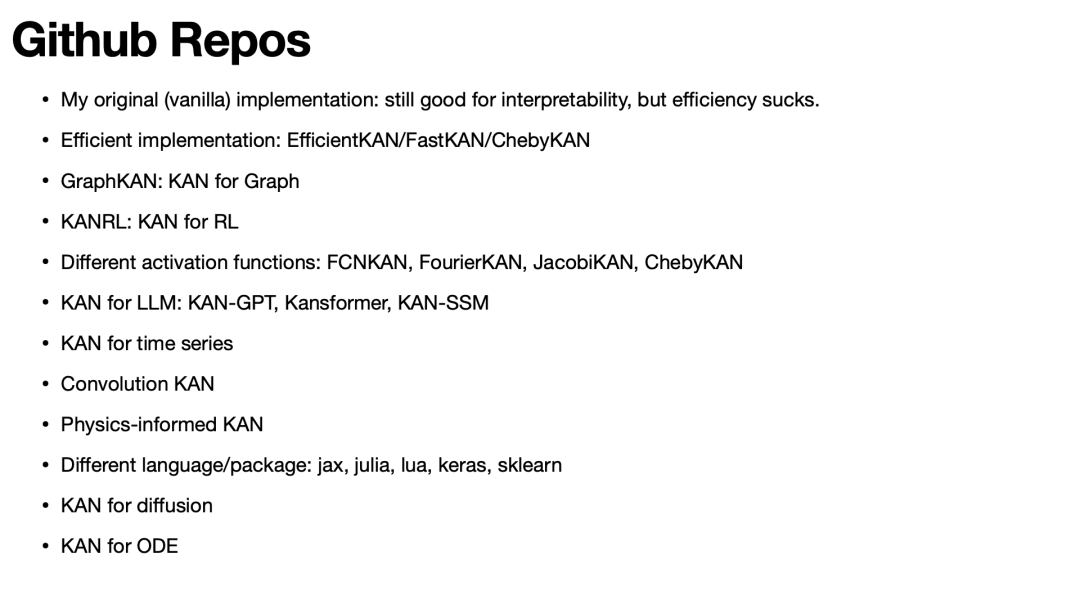

KAN的未来发展

GitHub开发者社区对KAN的发展非常迅速。在一周时间内,一些原本计划的后续研究几乎都被他人先行一步完成了。这既令人兴奋又显示出这个领域的活跃度。现在,如果你关心可解释性,我们建议使用原始KAN版本;如果你更关心效率或准确性,那么可以选择其他更高效的KAN变体。

我们对KAN的未来角色还不太清楚。实践是检验真理的唯一标准。我们需要更多的实验来探索KAN的界限。目前不需要特别依赖于KAN,因为它应该是一个更广阔框架的一部分,可能需要将符号和数值部分分离开来。从长远来看,我们希望能继续将KAN用于AI与科学的交叉研究,这可能是一个相对较小众的方向。期待与大家讨论,探讨怎样将KAN应用到其他更广泛的领域。

李颂元(Shaun),目前是中山大学的在站博士后,目前的研究兴趣是具身智能。

AI+Science 是近年兴起的将人工智能和科学相结合的一种趋势。一方面是 AI for Science,机器学习和其他 AI 技术可以用来解决科学研究中的问题,从预测天气和蛋白质结构,到模拟星系碰撞、设计优化核聚变反应堆,甚至像科学家一样进行科学发现,被称为科学发现的“第五范式”。另一方面是 Science for AI,科学尤其是物理学中的规律和思想启发机器学习理论,为人工智能的发展提供全新的视角和方法。

集智俱乐部联合斯坦福大学计算机科学系博士后研究员吴泰霖(Jure Leskovec 教授指导)、哈佛量子计划研究员扈鸿业、麻省理工学院物理系博士生刘子鸣(Max Tegmark 教授指导),共同发起以“AI+Science”为主题的读书会,探讨该领域的重要问题,共学共研相关文献。读书会已完结,现在报名可加入社群并解锁回放视频权限。

![]()

数十年来,人工智能的理论发展和技术实践一直与科学探索相伴而生,尤其在以大模型为代表的人工智能技术应用集中爆发的当下,人工智能正在加速物理、化学、生物等基础科学的革新,而这些学科也在反过来启发人工智能技术创新。在此过程中,数学作为兼具理论属性与工具属性的重要基础学科,与人工智能关系甚密,相辅相成。一方面,人工智能在解决数学领域的诸多工程问题、理论问题乃至圣杯难题上屡创记录。另一方面,数学持续为人工智能构筑理论基石并拓展其未来空间。这两个关键领域的交叉融合,正在揭开下个时代的科学之幕。

为了探索数学与人工智能深度融合的可能性,集智俱乐部联合同济大学特聘研究员陈小杨、清华大学交叉信息学院助理教授袁洋、南洋理工大学副教授夏克林三位老师,共同发起“人工智能与数学”读书会,希望从 AI for Math,Math for AI 两个方面深入探讨人工智能与数学的密切联系。读书会已完结,现在报名可加入社群并解锁回放视频权限。

详情请见:

人工智能与数学读书会启动:AI for Math,Math for AI

。如果要建立一个能够表达这个函数的模型,至少需要三层非线性网络:第一层进行平方运算,第二层应用正弦函数,第三层进行指数运算。这表明,即使是简单的几何函数也可能需要复杂的网络结构来精确表达。接下来,我们可以看到,训练过程中网络能够学习并模拟这些基本的数学函数。例如,在三层网络中,第一层学习平方运算,第二层学习正弦函数,第三层学习指数运算。这种方式展示了网络的学习能力和其对复杂函数的逼近能力。

。如果要建立一个能够表达这个函数的模型,至少需要三层非线性网络:第一层进行平方运算,第二层应用正弦函数,第三层进行指数运算。这表明,即使是简单的几何函数也可能需要复杂的网络结构来精确表达。接下来,我们可以看到,训练过程中网络能够学习并模拟这些基本的数学函数。例如,在三层网络中,第一层学习平方运算,第二层学习正弦函数,第三层学习指数运算。这种方式展示了网络的学习能力和其对复杂函数的逼近能力。