科学领域中的分子、蛋白质、抗体、晶体等物质以及宏观物理世界中不同形状的物体,均具有特定的空间几何结构,构成了一类重要的数据形态——几何图。与社交网络中的拓扑图不同,几何图中的节点占据了一定的空间位置,需要满足某些内蕴的物理性质,比如对称性,导致传统的图神经网络难以处理几何图。近年来,等变图神经网络由于有效嵌入了对称性,具有良好的解释性、泛化性和通用性,在分子系统表示上得到了广泛应用。与此同时,纯数据驱动大语言模型成功的今天,几何等先验知识的嵌入是否还有必要?

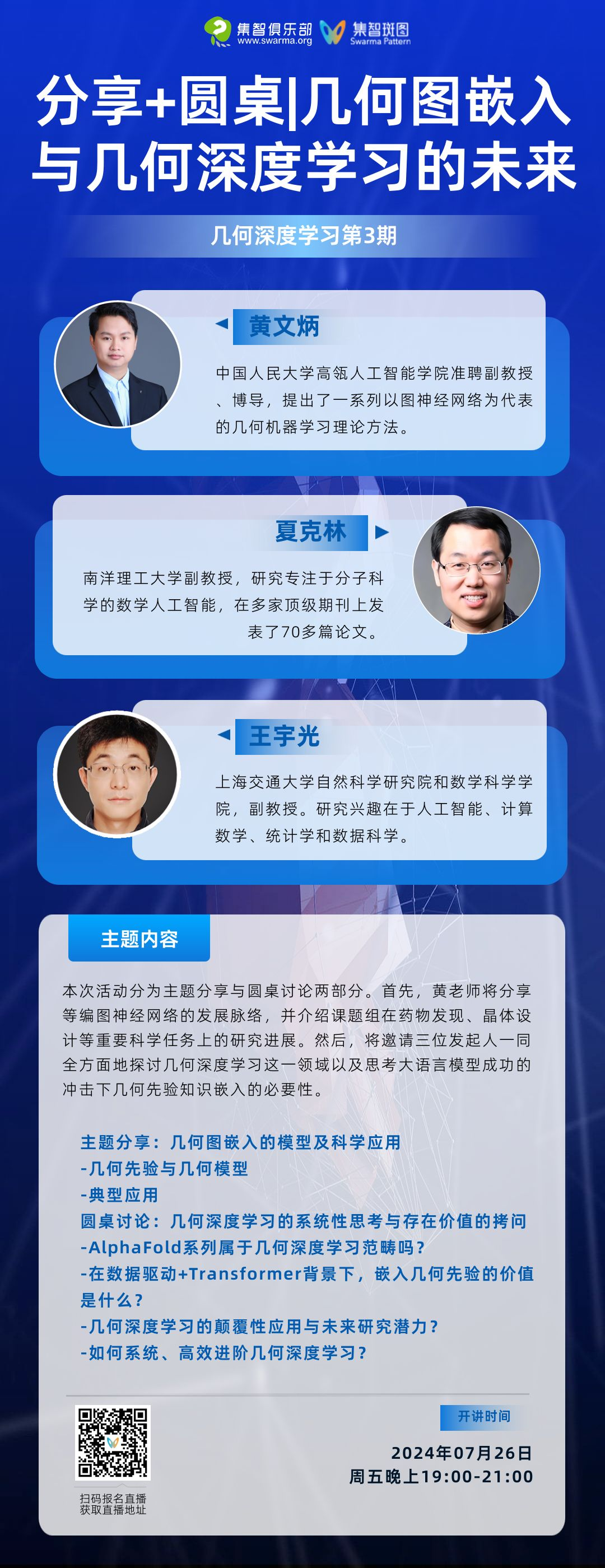

「几何深度学习」读书会第三期将由发起人之一中国人民大学副教授黄文炳,带领大家回顾等变图神经网络的演进历程,并揭示这一技术如何助力科学研究的深入发展。特别地,本期三位发起人老师开启圆桌,将共同讨论几何深度学习的基本定义、挑战、发展与未来,以及如何系统性学习相关知识。读书会将于周五晚(7月26日)19:00-21:00进行,欢迎感兴趣的朋友参与讨论交流!

主题分享—几何图嵌入的模型及科学应用

黄老师将梳理等变图神经网络的发展概况,并且介绍课题组近期在药物发现、晶体设计等重要科学任务上的应用情况。此前,黄老师在「图神经网络与组合优化」读书会简要介绍了等变图神经网络及其在微观分子空间以及宏观具身空间的应用例子,该分享已整理为笔记,供成员快速学习。相较之前的分享,本次分享黄老师将更深入全面地介绍几何先验知识嵌入的理论和模型,以及课题组最新的成果。

圆桌讨论—几何深度学习的系统性思考与其存在价值的拷问

包括本期在内的前三期对拓扑/几何深度学习的背景、理论、基础模型,尤其是单纯复形消息传递网络、双曲几何神经网络以及等变图神经网络有全面深入的介绍。几何深度学习领域内学者不断利用几何先验知识设计新的模型,从而捕捉数据更深的结构特征。与此同时,大语言模型的成功使得部分研究者倾向于相信纯数据驱动就能高效完成目标任务。

基于已有的分享和研究者们对几何深度学习的反思,三位发起人将与社区成员共同开展圆桌讨论,面向初学者和探索者,对几何深度学习的基本定义、应用与未来、以及高效学习办法进行系统性的研讨;对大语言模型冲击下几何深度学习的存在价值进行探讨。

Part 1 :主题分享

Part 2 :圆桌讨论

1. 几何深度学习的定义是什么?与传统深度学习有什么不同?Alphafold系列算几何深度学习吗?

2. 随着大语言模型的成功,很多人开始认为只要有足够多的数据、足够大的模型就能在很多任务上取得很好的效果。那么,嵌入几何先验或者其他知识是否还有必要?纯数据驱动+Transformer是否就足够了?

5. 几何深度学习涉及的知识和研究领域很多,如何能系统、高效地学习几何深度学习相关知识?

-

图神经网络 (Graph Neural Network)

-

表示对称性(Representation Symmetry)

-

结构对称性(Structural Symmetry)

-

抗体设计 (Antibody Design)

-

中国人民大学高瓴人工智能学院副教授。入选北京科技新星、腾讯犀牛鸟学者、微软铸星学者等称号。博士毕业于清华大学,曾担任清华大学智能产业研究院助理研究员、腾讯AI Lab高级研究员。在NeurIPS,ICML,ICLR等人工智能领域顶级会议或期刊发表论文60余篇,谷歌学术引用9000多次,单篇最高1000余次。主持国家自然基金项目2项。曾获ICLR 2023 杰出论文提名奖,NeurIPS 2022 Open Catalyst 比赛冠军,2020/2022年度腾讯犀牛鸟专项研究卓越奖,多篇论文入选美国PaperDigest最有影响力论文榜单。担任NeurIPS等会议领域主席,AAAI、IJCAI等会议高级程序委员。

研究方向:几何深度学习、AI for Science。

https://pattern.swarma.org/user/117789

上海交通大学自然科学研究院和数学科学学院,副教授。上海应用数学中心、上海人工智能实验室和新南威尔士大学担任兼职副教授,前马克斯·普朗克研究所的研究科学家。在新南威尔士大学取得数学博士。在图神经网络和大型模型等领域已发表60多篇顶刊顶会,包括Appl Comput Harmon Anal、SINUM、FoCM、JMLR、Cell Reports Medicine,以及ICML、NeurIPS、ICLR,其中三篇论文被选为AI顶会亮点文章。2024年,其团队发布了中国首个TourSynbio蛋白大模型。

研究方向:人工智能、计算数学、统计学和数据科学。目前正在研究几何深度学习、图神经网络、应用调和分析、贝叶斯推理、信息几何、数值分析以及在生物医学和蛋白质设计中的应用。

https://pattern.swarma.org/master/1220

南洋理工大学副教授。2013年1月获得中国科学院博士学位,于2009年12月至2012年12月在美国密歇根州立大学数学系作为访问学者。从2013年1月至2016年5月,在密歇根州立大学担任访问助理教授。2016年6月,加入南洋理工大学,并于2023年3月晋升为副教授。夏克林的研究专注于分子科学的数学人工智能,在《SIAM Review》、《Science Advances》、《npj Computational Materials》、《ACS nano》等期刊上发表了70多篇论文。

https://pattern.swarma.org/user/124174

• 推荐语:对称性是指物体在某种变换上保持不变的性质,既是数学形式简约性的必要因素、也是物理规律均匀性的必然结果。这篇文章是最早将旋转对称性加入到卷积神经网络的开创工作之一,从群等变的角度对传统卷积算子进行了简单而深刻的改造。

Cohen T, Welling M. Group equivariant convolutional networks[C]//International conference on machine learning. PMLR, 2016: 2990-2999.

• 推荐语:这篇文章基于物理规律必须满足SE(3)对称性的重要假设,从群表示论中引入球谐函数、Wigner-D矩阵、CG张量积等概念,嵌入到图神经网络中,提出了张量场网络TFN。这是最早将具有对称性的图神经网络引入到三维物理系统建模中的开创性工作。

Thomas N, Smidt T, Kearnes S, et al. Tensor field networks: Rotation-and translation-equivariant neural networks for 3d point clouds[J]. arXiv preprint arXiv:1802.08219, 2018.

• 推荐语:这篇文章摒弃了前一篇论文TFN中的高阶表示量,只利用向量之间的内积构建了具有对称性的图神经网络EGNN,极大提升了模型的效率,并且在许多实际任务中打败了传统数学形式更完备但计算更复杂的模型。

Satorras V G, Hoogeboom E, Welling M. E (n) equivariant graph neural networks[C]//International conference on machine learning. PMLR, 2021: 9323-9332.

• 推荐语:这是一篇综述性论文(两个版本),从数据结构、模型、任务等多个维度总结了几何图神经网络的发展历程和重要应用例子。

Han J, Cen J, Wu L, et al. A Survey of Geometric Graph Neural Networks: Data Structures, Models and Applications[J]. arXiv preprint arXiv:2403.00485, 2024.

Han J, Rong Y, Xu T, et al. Geometrically equivariant graph neural networks: A survey[J]. arXiv preprint arXiv:2202.07230, 2022.

时间:2024年7月26日(本周五)晚19:00-21:00

https://pattern.swarma.org/study_group_issue/723?from=wechat

扫码参与几何深度学习读书会,加入群聊,获取系列读书会回看权限,加入图神经网络与几何深度学习社区,与社区的一线科研工作者沟通交流,共同推动几何深度学习这一前沿领域的发展。

拓扑编织着复杂世界,机器学习孕育着技术奇点。一个维度,其中拓扑理论与深度学习模型交织共鸣;一个领域,它跨越了数学的严谨与本质以及人工智能的无限可能,开辟着通往科学新纪元的航道。让我们携手在几何深度学习的起点出发,一路探索如何走向AI for Science的无限未来。

集智俱乐部联合中国人民大学黄文炳副教授、上海交通大学王宇光副教授和南洋理工大学夏克林副教授发起「几何深度学习」读书会。从2024年7月11日开始,每周四19:00-21:00进行,持续时间预计 8-10 周,社区成员将一起系统性地学习几何深度学习相关知识、模型、算法,深入梳理相关文献、激发跨学科的学术火花、共同打造国内首个几何深度学习社区!欢迎加入社区与发起人老师一起探索!

现实世界中大量问题的解决依赖于算法的设计与求解。传统算法由人类专家设计,而随着人工智能技术不断发展,算法自动学习算法的案例日益增多,如以神经网络为代表的的人工智能算法,这是算法神经化求解的缘由。在算法神经化求解方向上,图神经网络是一个强有力的工具,能够充分利用图结构的特性,实现对高复杂度算法的高效近似求解。基于图神经网络的复杂系统优化与控制将会是大模型热潮之后新的未来方向。

为了探讨图神经网络在算法神经化求解的发展与现实应用,集智俱乐部联合国防科技大学系统工程学院副教授范长俊、中国人民大学高瓴人工智能学院副教授黄文炳,共同发起「图神经网络与组合优化」读书会。读书会将聚焦于图神经网络与算法神经化求解的相关领域,包括神经算法推理、组合优化问题求解、几何图神经网络,以及算法神经化求解在 AI for Science 中的应用等方面。读书会已完结,现在报名可加入社群并解锁回放视频权限。

数十年来,人工智能的理论发展和技术实践一直与科学探索相伴而生,尤其在以大模型为代表的人工智能技术应用集中爆发的当下,人工智能正在加速物理、化学、生物等基础科学的革新,而这些学科也在反过来启发人工智能技术创新。在此过程中,数学作为兼具理论属性与工具属性的重要基础学科,与人工智能关系甚密,相辅相成。一方面,人工智能在解决数学领域的诸多工程问题、理论问题乃至圣杯难题上屡创记录。另一方面,数学持续为人工智能构筑理论基石并拓展其未来空间。这两个关键领域的交叉融合,正在揭开下个时代的科学之幕。

为了探索数学与人工智能深度融合的可能性,集智俱乐部联合同济大学特聘研究员陈小杨、清华大学交叉信息学院助理教授袁洋、南洋理工大学副教授夏克林三位老师,共同发起“人工智能与数学”读书会,希望从 AI for Math,Math for AI 两个方面深入探讨人工智能与数学的密切联系。读书会已完结,现在报名可加入社群并解锁回放视频权限。

详情请见:

人工智能与数学读书会启动:AI for Math,Math for AI