自然语言理解与深度学习课堂笔记1: Word2Vec

https://swarma.github.io

▲ All resources (syllabus,slides,suggested readings,homework) are shared via

Password: j7hu

(可点击文末阅读原文下载)

传统自然语言处理的表达,一般以词为单位。自然语言字符表达成计算机能处理的信息,采取离散表达。假设有个词表,可以理解为字典,如何在这一万个字中表达这一个字。用一万维的向量表达这个字,某个字只可能在某一维地方为1,其他位置都为0。

这种方法特点:根据词表大小决定向量长度。很占空间,即使稀疏表示。缺乏泛化性,即lack of generalization。这种表示没法表达相似(cos函数)。所以希望能够有一种方式计算这种泛化性,稠密向量。

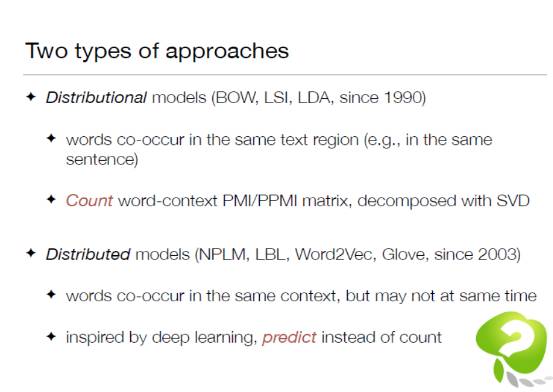

“You shall know a word by the company it keeps.”–J.R. Firth(1957)基于同一种思想,生出很多方法,主要有两种假说。

假说一:the distributional hypothesis 分布式假说

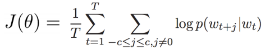

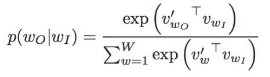

一个词由周围词来推断。相似的词会出现在相似的语境里。由词跟语境的关系来判断相似度。下面是由这种假说,产生的很多种方法来计算这个实值向量。1954年BOW模型不考虑语序,出现一次加1。2003年LDA模型,是主题模型中的某一个特例。

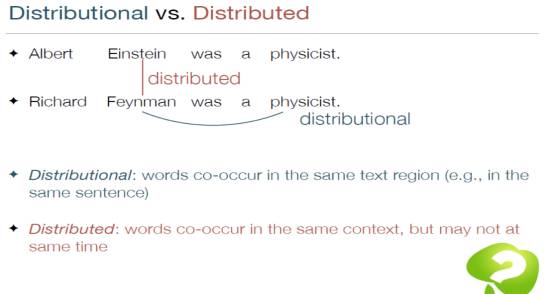

Distributional models 基于那个假设,细化到自己的模型中,意思是相关的词出现在相同的句子里面。例如今晚的天空有很多星星。句子中天空和星星相关,横向。共现,相关词共同出现几次,svd矩阵分解方式拆除实值向量结果。

假说二:Distributed models

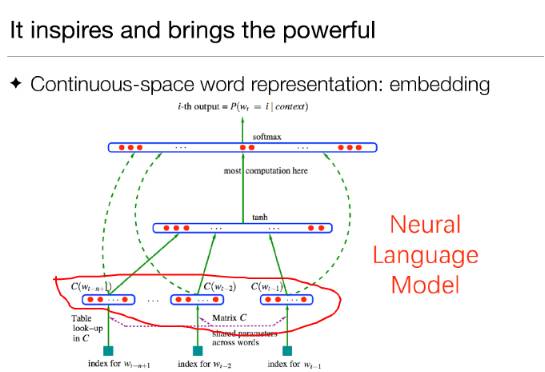

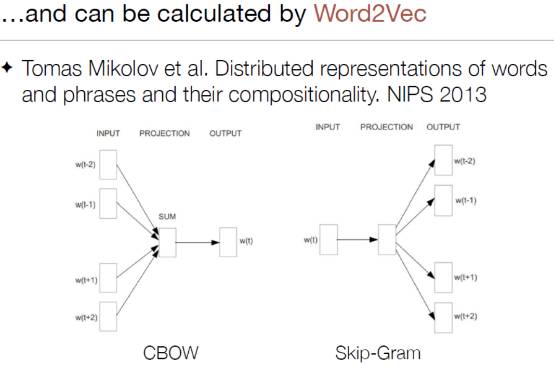

相似词在相似语境contex下。例如今天天空有很多星星。今天天空有个太阳。这两个句子中的星星和太阳这两个词。纵向相似性。由神经网络语言模型得出的副产物,深度学习副产物,深度学习中基于错误传导的预测方式。

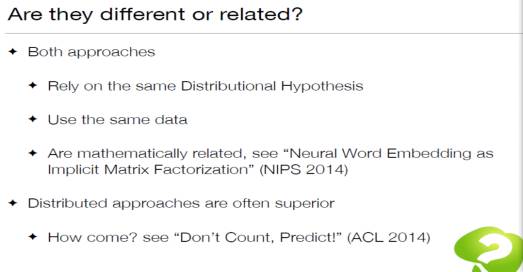

Context 可以同一个句子,也可以纵向。这两者的区别和联系如下图:

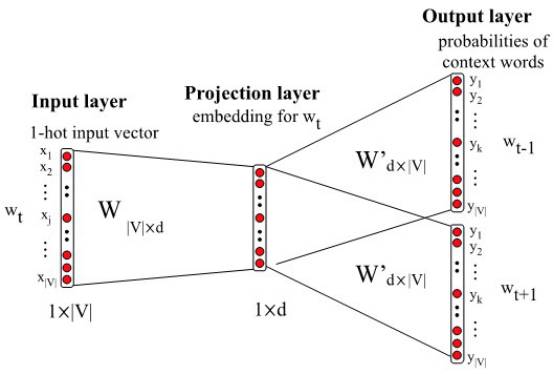

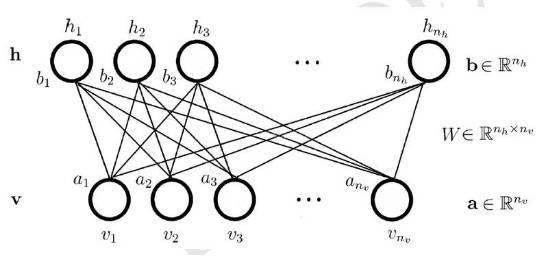

这里,W 是连接隐藏层和显层之间的权值矩阵。

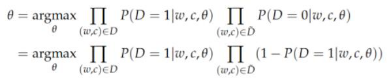

通过上面的整理我们看出,无论是 word2vec 训练过程中的目标函数,还是目前工业界多用于分类的 RBM(当然包括 DBN,DBM),还是 planted 自旋玻璃模型,最后都可以归结到统计推断问题上面来。所以,是不是可以将大家的分析方式进行相互借鉴?将统计物理中求解配分函数的方式用到(1)式中,而将这里的负采样的想法用到配分函数的数值模拟中,当然,这里,如果定义“负”才是问题的核心。

(END)

关于《走近2050:注意力、互联网与人工智能》

▼

随着人工智能程序AlphaGo以4:1的大比分战胜人类围棋世界冠军李世石,机器将征服人类的担忧正在甚嚣尘上。《走近2050:注意力、互联网与人工智能》则为我们描绘了一幅人机和谐共生、协同演化的全新场景。在看得见的未来,人类将越来越多地沉浸于五花八门的虚拟世界以获取各式体验,与此同时,我们将心甘情愿地将自己的注意力源源不断地输入给机器世界以促使它们进化。

本书从注意力的角度解读了包括互联网、人工智能、众包、人类计算、计算机游戏、虚拟现实在内的技术领域及其对社会生活的影响,还创造性地提出了一系列全新的概念:占意理论、图灵机-参与者模型、“游戏+”时代、意本家、自动游戏设计、自动化创业、占意通货、许愿树,等等。所有这些将为我们理解技术与人类的关系、透视人类社会的未来发展和走向提供深刻的洞察。

让苹果砸得更猛烈些吧!!!

长按识别二维码,关注集智Club,

让我们离科学探索更近一步。

▼点此下载云端资料,密码:j7hu

始发于微信公众号: 集智俱乐部