当标记样本有限时,作为一种利用大量未标记样本的新范式, 自监督学习(Self-Supervised Learning,SSL)正在兴起。SSL在自然语言和图像学习任务上取得了很好的性能。最近,有一种趋势是使用图神经网络将这种成功扩展到图数据。

近年来,关于图的深度学习已经越来越受研究界的欢迎,因为图结构数据在许多领域中无处不在。一般来说,大多数关于图的深度学习工作都集中在(半)监督学习场景上,其中模型由带有手动标签的特定下游任务来训练。尽管(半)监督图学习取得了成功,但由于其对标签的严重依赖,它仍然存在几个缺点:获取标签的成本过高,过度拟合导致的泛化能力差,以及在标签相关的攻击下鲁棒性弱。

自监督学习是解决(半)监督学习缺点的一种学习范式。SSL帮助模型从未标记的数据中学习更多的一般化表示,因此它可以在下游任务上实现更好的性能和一般化。继SSL在计算机视觉(CV)和自然语言处理(NLP)方面取得巨大成功之后,最近,人们对将SSL应用于图结构数据越来越感兴趣。

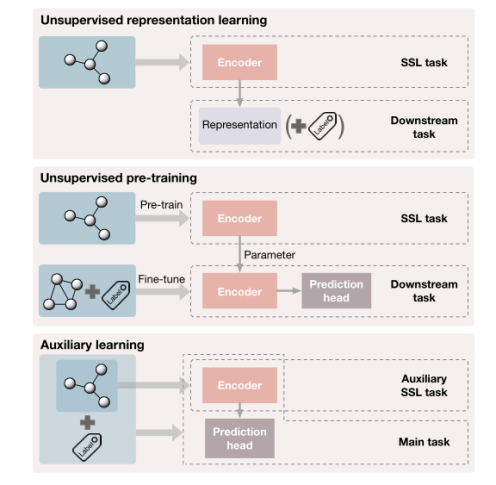

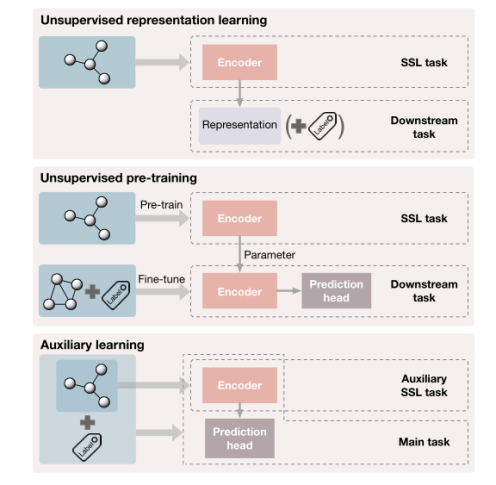

图1. 自监督学习范式

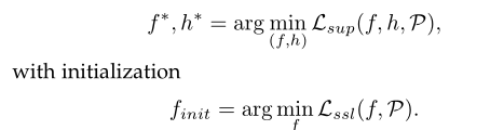

在整个训练过程中,只有未标记图的分布P是可用的。学习给定图数据(A,X)~P的表示的问题被公式化为

通常分两个阶段进行:1.用未标记的图训练编码器f 2.预训练得到的编码器f在下游任务进行微调

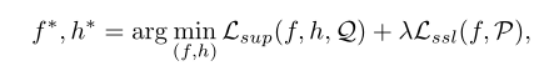

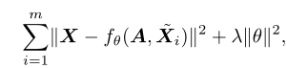

编码器是通过自监督和下游任务联合训练的。损失函数由自监督和下游任务损失函数组成,其中权衡超参数λ控制它们的贡献

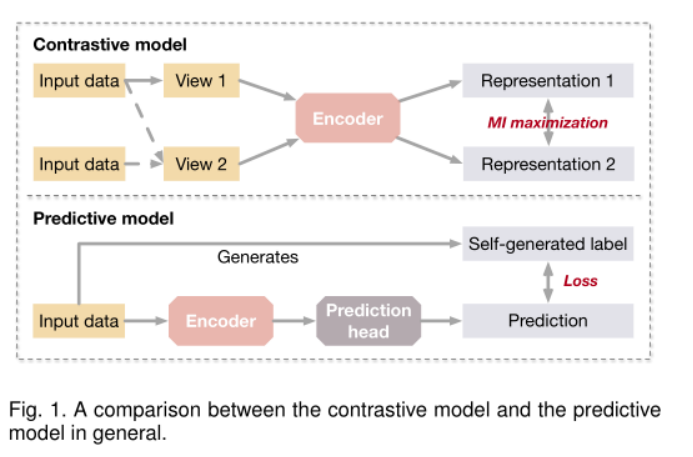

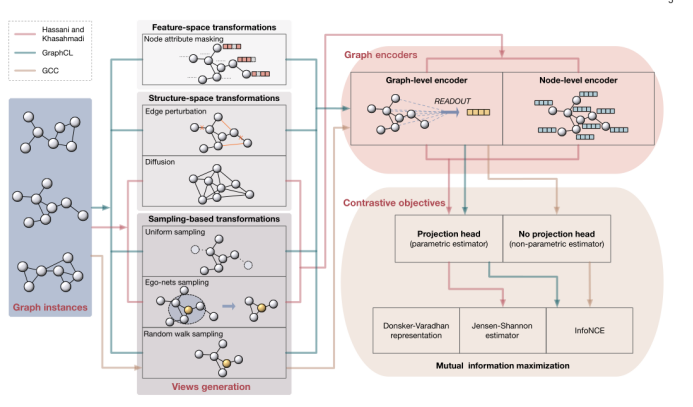

SSL方法可以分为两类;即对比模型和预测模型。这两个类别之间的主要区别是对比模型需要数据-数据对来进行训练,而预测模型需要数据-标签对,其中标签是从数据中自行生成的。

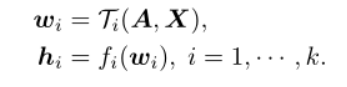

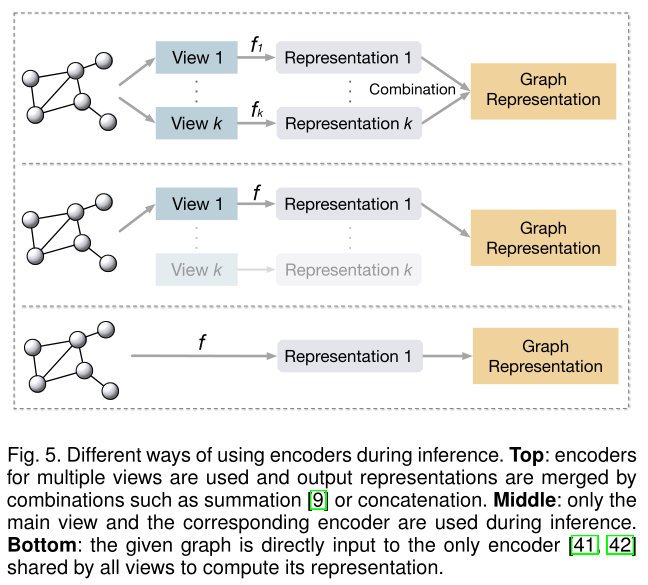

给定图(A,X),应用多个变换T1,…,Tk以获得该图的不同视图w1,…,wk。然后,一组编码网络f1,…,fk将相应的视图作为它们的输入,并从每个视图输出图的表示h1,…,hk。

训练期间,目标旨在训练编码器,以最大化从同一图实例得到的视图表示之间的一致性。通常用互信息I(hi,hj)来衡量两个视图表示间的一致性。

在推理过程中,可以使用单个经过训练的编码器来计算表示,也可以使用多个视图表示的组合,如线性组合或级联,作为给定图的最终表示。

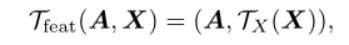

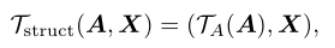

我们将应用于图数据的现有转换归纳为三类,特征转换、结构转换和基于采样的转换。特征转换可以表示为:

M表示具有掩蔽值的矩阵,1m表示掩蔽位置指示矩阵。给定掩蔽比r,1m中的元素分别设置为概率为r的1和概率为1-r的0。M中的值指定了不同的掩蔽策略。例如,M = 0应用常数掩蔽,M~N(0,σ)用高斯噪声替换原始值,M~N(X,σ)将高斯噪声添加到原始值。

思想和上面说的node attribute masking相同,就是对象变成了邻接矩阵。

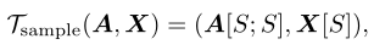

Uniform Sampling:从全部节点中均匀采样相应数量的节点和对应的边来构成子图

Ego-nets sampling:采样某个节点的L阶邻居和相应的边

Random walk sampling:从初始节点开始,迭代地进行采样。每一次迭代中,都有pij的概率从当前节点vi游走到下一节点vj,并有pr=0.8的概率返回到初始节点。

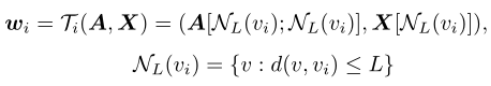

图编码器通常基于图神经网络(GNNs)构建,遵循邻域聚合策略,其中节点的表示通过将其自身的表示与其邻居的聚合表示相结合来迭代更新。GNN的第k层是:

不同的GNN中AGGREGATE()和COMBINE()不同,例如GCN、GAT等。

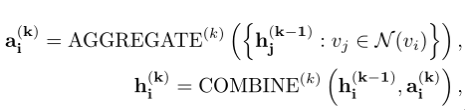

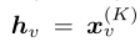

节点层次:获得节点v的节点级表示hv的最简单的做法是直接使用encoder最后一层产生的节点特征

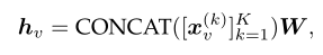

也可通过连接所有层的节点特征得到节点级表示,并用一个线性变换控制其维度。

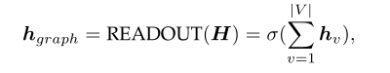

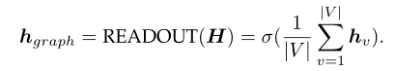

图层次:通常在得到图的节点级表示后,用一个readout函数得到图级表示。求和和平均是最常用的readout函数

图重构为图神经网络的训练提供了自监督。图重建通过decoder预测图的某些部分,例如节点子集的属性或一对节点之间的边的存在。

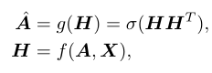

GAE:它假设一条边上的两个节点应该有相似的表示,根据输入图(A,X)对邻接矩阵A进行重构

MGAE:采用了去噪自编码器的思想。给定一个图(A,X),MGAE使用单层自动编码器fθ和物镜对多个随机损坏的特征矩阵执行重建。

可堆叠多个类似的单层自编码器以达到更好的效果,最后一层得到的表示被用作下游任务。

Attribute masking:是在图自编码器框架下通过重构屏蔽的节点属性来预训练图编码器f的另一种策略。给定节点属性被随机屏蔽的图,编码器f计算节点级表示H。并且将线性投影作为解码器g,以重构屏蔽属性。当边属性也可用时,也可以对屏蔽的边属性执行重建。

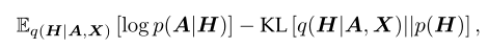

VGAE:采用了变分自编码器的思想,用已知的图经过编码(图卷积)学到节点向量表示的分布,在分布中采样得到节点的向量表示,然后进行解码重新构建图。其损失为:

ARGA/ARVGA:使用对抗网络来规范自编码器,该网络强制潜变量的分布以匹配高斯先验。除了编码器和解码器之外,鉴别器被训练来区分由编码器产生的假数据和从高斯分布采样的真实数据。由于对抗性正则化可证明是潜变量分布和高斯先验之间的JS-散度的等价性,ARGA/ARVGA可获得与VGAE相似的效果,但正则化更强。

除了重建之外,执行自监督预测学习的有效方法是基于图数据中没有明确提供的信息图属性来设计预测任务。

S2GRL:两个节点间的交互不仅仅限于它们的直接连接,为此,S2GRL将邻接矩阵重构任务推广到预测两个给定节点的k跳连通性(k-hop connectivity prediction)。给定任何节点对的编码表示,预测头执行分类。S2GRL训练编码器和预测头来分类这对节点之间的跳数。

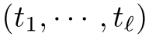

Meta-path prediction:该方法适用于异构图,例如分子中有不同种类的节点和边。长度为l的元路径由下面序列定义:

ti表示路径中第i条边的种类。给定异构图中的两个节点和K个元路径,编码器f和预测头gi(i = 1,…,K)被训练来预测这两个节点是否由各个元路径连接。

GROVER:编码器和预测头被训练来预测给定节点(原子)的k跳邻域内的“原子-键-计数”关系,例如,如果有两个原子“0”通过双键连接到给定原子,则为“0-双键-2”。

预测目标不是从输入图中获得的标签,而是从前一阶段的预测中获得的伪标签。

在节点级半监督设置下,多级自训练利用标记节点来指导对未标记节点的训练。具体地,给定标记节点集和未标记节点集,首先在标记集上训练图神经网络。训练结束后,对未标记集进行预测,预测出的高可信度标签被视为伪标签,移动到标记节点集。然后,在更新后的标记集上训练新的图神经网络,并多次执行上述操作。

M3S 应用深度聚类和对齐机制在多阶段自训练的基础上生成伪标签。特别地,在每个阶段对节点级表示执行K均值聚类,然后将从聚类获得的标签与给定的真实标签对齐。只有当具有聚类伪标签的节点与当前阶段分类器的预测相匹配时,该节点才会被添加到标签集中,以便在下一阶段进行自训练。与基本的多阶段自训练相比,M3S认为深度集群和调整机制是一种自我检查机制,因此提供了更强的自监督。

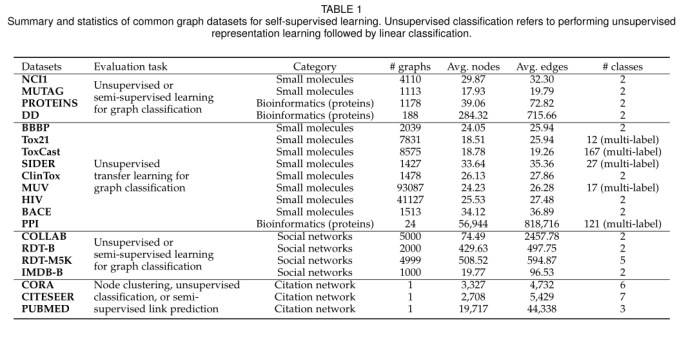

图级学习任务是作为归纳学习任务在多个图上执行的。用于图级学习任务的常用数据集可分为三种类型,化学分子数据集、蛋白质数据集和社交网络数据集。

化学分子性质预测:在分子图中,每个节点代表分子中的一个原子,其中原子指数由节点属性表示,每个边代表分子中的一个键。用于化学分子性质预测的数据集在TUDataset中也被归类为小分子数据集。传统的分子分类数据集,如NCI1 和MUTAG ,是自监督相关研究中无监督图表示学习最常用的数据集。

蛋白质生物功能预测:蛋白质是一种特殊类型的分子,但用图数据表示的方式不同。在蛋白质图中,节点代表氨基酸,边表示两个相连的节点之间的距离小于6埃。用于化学分子性质预测的数据集在TUDataset中也被归类为生物信息学数据集。

社交网络属性预测:社交网络图数据集将每个实体(例如,用户或作者)视为一个节点,将它们的社交连接视为边。由于不同数据集中的社交网络表现不同,社交网络图数据集通常不用于迁移学习。最近的自监督研究中使用的社交网络图数据集是图分类的典型数据集,如COLLAB、REDIT-B和IMDBB。

节点级学习任务在大型图上作为直推学习任务执行。目前,大多数节点级学习任务是在引文网络数据集上执行的,包括CORA ,CITECER和PUBMED

尽管最近在自然语言处理和计算机视觉方面取得了成功,但应用于图数据的自监督学习仍然是一个新兴领域,面临着巨大的挑战。图数据上的自监督学习仍然缺乏理论基础,现有的方法大多是凭直觉设计的,其性能增益是通过经验实验来评估的,迫切需要为图上的SSL建立坚实的理论基础。无论如何,我们有理由相信图SSL将继续是一个活跃而有前途的研究领域,具有广泛的潜在应用。

[1] Yaochen Xie, Zhao Xu, Jingtun Zhang, Zhengyang Wang, Shuiwang Ji, “Self-Supervised Learning of Graph Neural Networks: A Unified Review”, https://arxiv.org/abs/2102.10757

[2] Yixin Liu, Shirui Pan, Ming Jin, Chuan Zhou, Feng Xia, Philip S. Yu, “Graph Self-Supervised Learning: A Survey”, https://arxiv.org/abs/2103.00111

集智斑图顶刊论文速递栏目上线以来,持续收录来自Nature、Science等顶刊的最新论文,追踪复杂系统、网络科学、计算社会科学等领域的前沿进展。现在正式推出订阅功能,每周通过微信服务号「集智斑图」推送论文信息。扫描下方二维码即可一键订阅:

点击“阅读原文”,追踪复杂科学顶刊论文