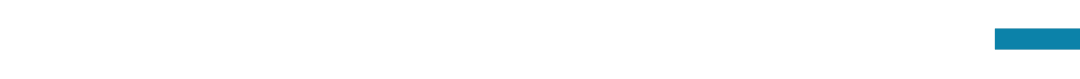

周日直播·大模型安全与对齐读书会收官圆桌:人工智能风险红线声明

导语

内容简介

内容简介

分享大纲

分享大纲

-

大模型安全与对齐读书会回顾与总结(段雅文, 5 mins)

-

人工智能安全国际对话与人工智能风险红线宣言(陈欣,5-10 mins)

-

人工智能安全国际对话

-

Ditchley宣言

-

北京宣言

-

AI 欺骗(Deception)能力红线的挑战与应对(陈奕群,5-10 mins)

-

Honesty

-

Incosistency

-

Deception

-

圆桌讨论(沈田浩、吉嘉铭、刘东瑞、任麒冰)

-

AI系统有哪些不应该被研发的危险能力?

-

AI系统的部署使用有哪些不该被触及的底线?

-

当前安全和对齐的方法对于降低风险存在什么样的进步空间?

主要涉及到的前置知识

主要涉及到的前置知识

-

AI Alignment

-

AI Safety

-

AI Honesty

主讲人介绍

主讲人介绍

圆桌嘉宾介绍

圆桌嘉宾介绍

主持人介绍

主持人介绍

涉及到的参考文献

涉及到的参考文献

-

Wei J, Huang D, Lu Y, et al. Simple synthetic data reduces sycophancy in large language models[J]. arXiv preprint arXiv:2308.03958, 2023.

-

Park P S, Goldstein S, O’Gara A, et al. AI deception: A survey of examples, risks, and potential solutions[J]. arXiv preprint arXiv:2308.14752, 2023.

-

Joshi N, Rando J, Saparov A, et al. Personas as a way to model truthfulness in language models[J]. arXiv preprint arXiv:2310.18168, 2023.

-

Pacchiardi L, Chan A J, Mindermann S, et al. How to catch an ai liar: Lie detection in black-box llms by asking unrelated questions[J]. arXiv preprint arXiv:2309.15840, 2023.

直播信息

直播信息

报名成为主讲人

报名成为主讲人

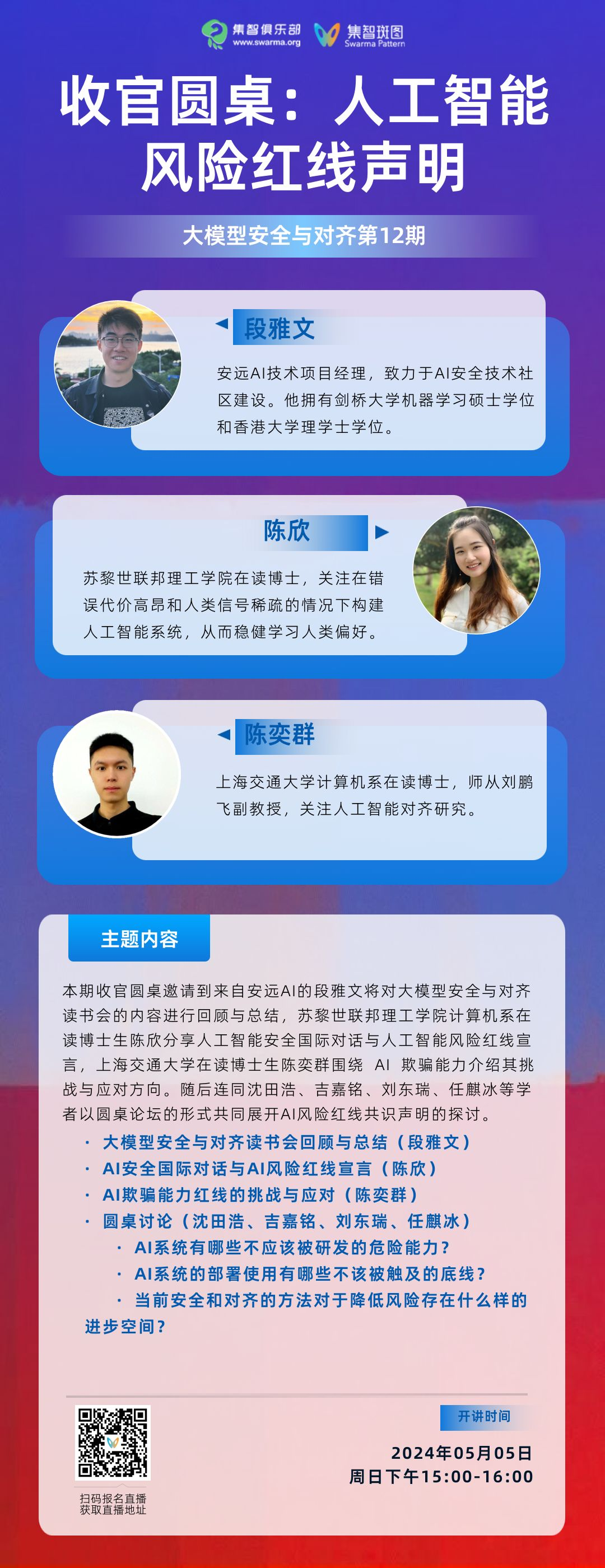

大模型安全与对齐读书会

大模型的狂飙突进唤醒了人们对AI技术的热情和憧憬,也引发了对AI技术本身存在的社会伦理风险及其对人类生存构成的潜在威胁的普遍担忧。在此背景下,AI安全与对齐得到广泛关注,这是一个致力于让AI造福人类,避免AI模型失控或被滥用而导致灾难性后果的研究方向。集智俱乐部和安远AI联合举办「大模型安全与对齐」读书会,由多位海内外一线研究者联合发起,旨在深入探讨大模型安全与对齐所涉及的核心技术、理论架构、解决路径以及安全治理等交叉课题。

点击“阅读原文”,报名读书会