偏微分方程与科学和工程形影不离,无论是建模流体运动的Navier-Stokes方程,还是描述电磁场相互作用的麦克斯韦方程等,都可以用偏微分方程建模。高度的非线性特征使得这些方程难以解析求解,有限差分法、有限体积法和谱方法等数值方法成为求解偏微分方程的重要手段,支撑着模拟实验、工程仿真和业务预报等方方面面。然而,连续方程被数值方法离散化后带来了网格解析和数值不稳定等诸多问题,解决这些问题往往依赖更精细的高分辨率网格和更复杂的数值格式,这使得对算力的需求节节攀升。为了打破计算精度和计算效率的取舍,近日发表于Journal of Computational Physics的一项最新研究提出了一种名为Koopman神经算子的模型,该模型能够在观测空间下线性表征偏微分方程解的时间演化关系。除此之外,该文章推提出了一个基于动力系统理论来描述偏微分方程求解的数学框架,并探讨了建模非自治动力系统的时间演化问题。

研究领域:偏微分方程,动力系统,流体力学,Koopman理论,神经算子

熊巍 | 作者

Koopman neural operator as a mesh-free solver of non-linear partial differential equations

https://doi.org/10.1016/j.jcp.2024.113194

https://doi.org/10.1063/5.0157763

https://github.com/Koopman-Laboratory/KoopmanLab

算子学习是研究深度学习求解偏微分方程的重要方法,其核心是使用神经网络结构来学习用于描述无限维Banach空间的算子,而偏微分方程求解可以在数学上转化为算子学习问题。不同于深度学习的其他问题,算子学习模型需要具备在Banach空间中泛化的能力,即训练好的模型需要能泛化不同的初始条件、物理参数或分辨率网格等。然而,如何使用有限的数据和有限参数的神经网络结构去学习描述无限维映射的算子,是这一领域需要解决的重要问题。对于这一任务,前人的研究进行了诸多探索,比如DeepONet模型基于通用近似定理(Universal approximation theorem)探讨了如何对函数空间采样来使模型收敛于目标算子,傅里叶神经算子(Fourier Neural Operator)等模型探究了如何使用神经网络将格林函数法扩展到求解非线性偏微分方程。本文将从动力系统、Koopman理论和算子学习视角提出一种新的偏微分方程求解框架,使用Koopman神经算子学习非线性的观测函数、Koopman不变子空间和Koopman算子的线性表征矩阵,用来求解偏微分方程和预测真实世界的动力演化。

2. Koopman 理论和动力系统视角下的

偏微分方程求解问题

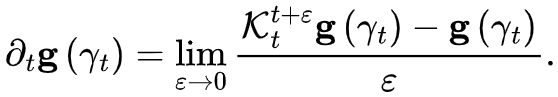

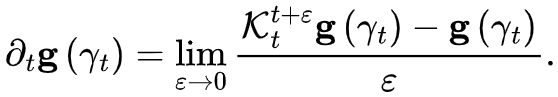

Koopman在1931年提出了一种新的用于研究非线性动力系统的理论,认为存在一个观测空间,使得非线性系统的演化可以被无限维线性算子所表征。如果将偏微分方程的视作一个非线性的非自治动力系统。那么则可以通过找到所对应的观测函数与Koopman算子来描述其时间演化问题,进而通过其定解条件来求得未来时刻解的值。在动力系统的视角下,偏微分方程解的时间演化关系可被无限维流映射所表示。因此,在Koopman理论的视角下则可以转化成如下形式,

那么,我们可以将Koopman算子控制下的随时间变化的线性演化流定义为

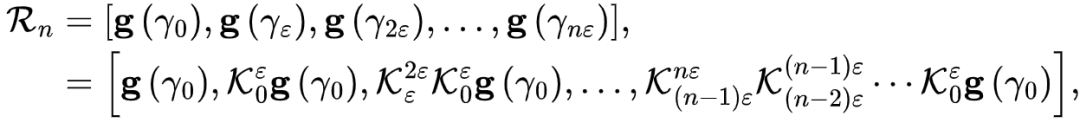

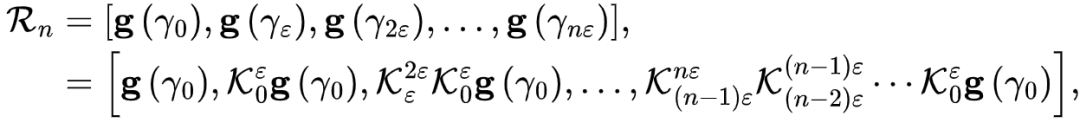

接下来,将详细展开Koopman神经算子是如何实现对这一问题的求解。首先,将该偏微分方程解的观测(如模拟或观测的数据集)展成 Krylov 序列形式,

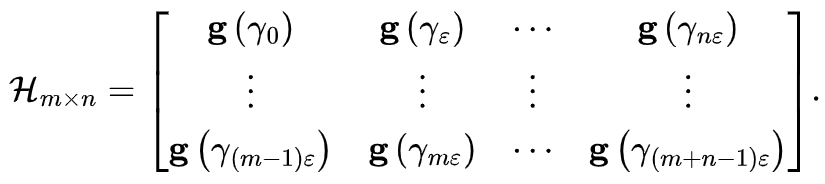

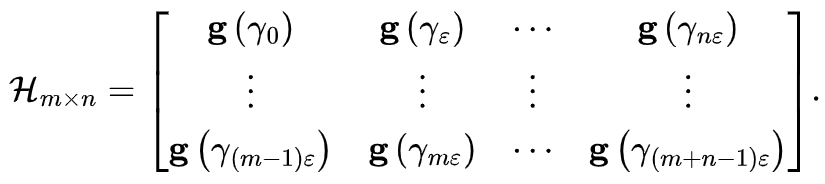

因此,Koopman算子的学习被转化为如下的优化问题,

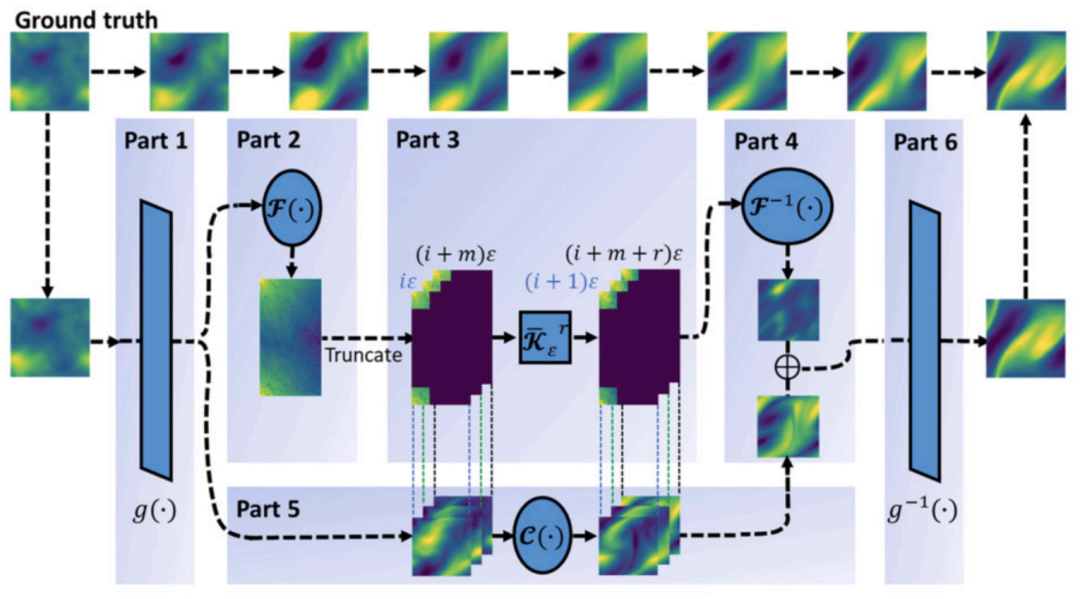

为了实现这一优化问题,我们建立了如图所示的模型结构,使用简单的编码器和解码器架构(单层的MLP或CNN)通过重建约束来学习观测函数g和g-1(Part 1和Part 2),使用纯线性结构(Part 3)来实现用于线性表征Koopman算子,由于在Part 3中引入了Fourier变换并对其高频模态进行截断,因此Part 5使用了捕捉高频的结构来实现。模型将采使用重建目标和预测目标进行多目标优化,来实现模型的训练,即

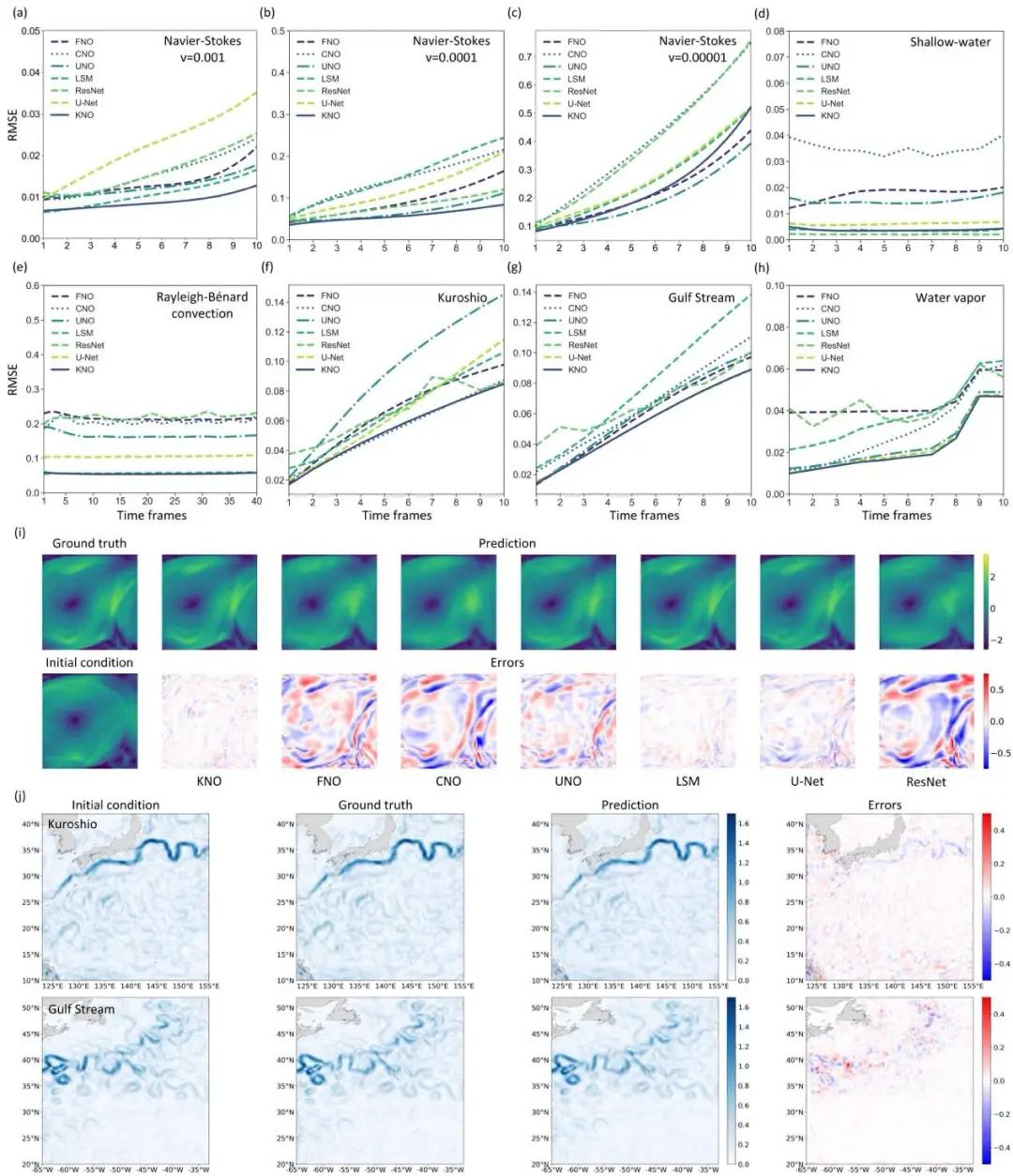

为了检验理论的正确性,我们测试了Navier-Stokes方程(三个不同的粘性系数)、浅水方程、瑞利-贝纳德对流、海洋西边界流(黑潮和湾流)和水汽遥感等场景下的模型表现,其效果如下图所示。

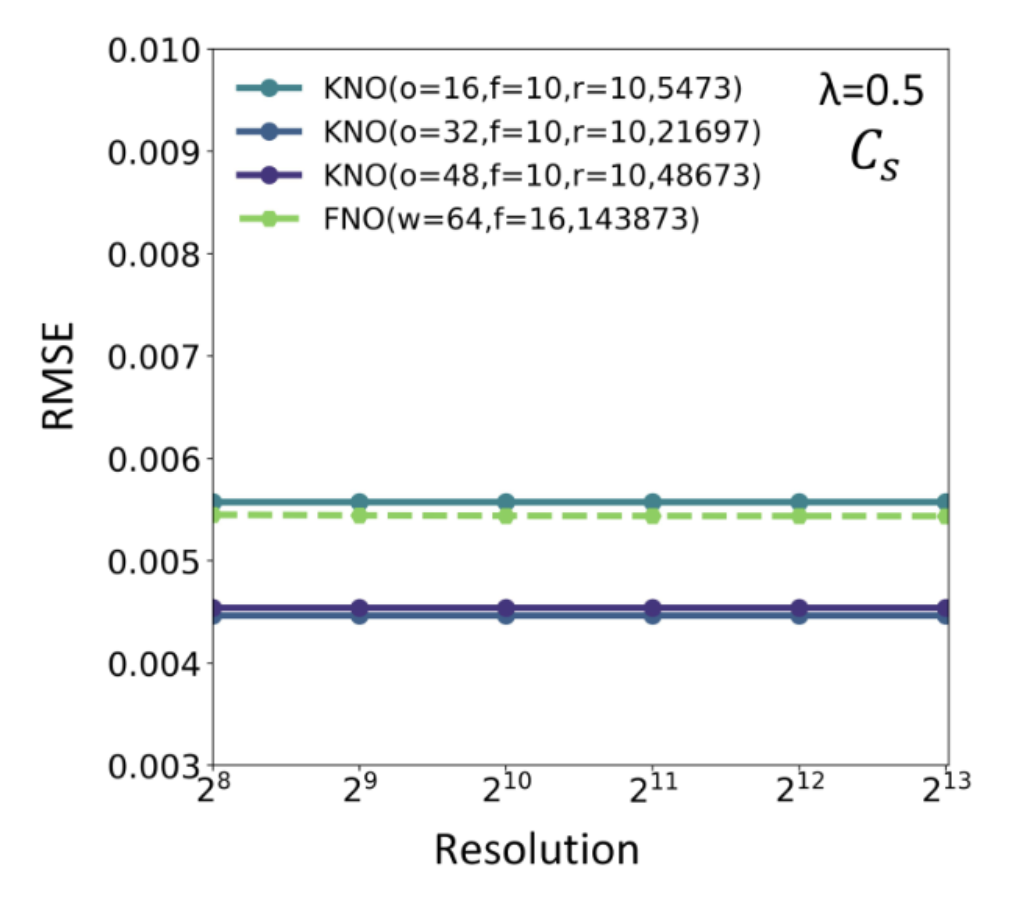

分辨率不变性:Koopman神经算子具有分辨率不变性,这一性质不仅需要模型在推理时能接受不同的网格分辨率,还要在推理时的误差表现不随着网格分辨率的改变而改变。如下图所示,Koopman算子在建模Burger’s方程时,使用网格下的数值解驱动训练,在更高分辨率网格下推理时的误差表现。本文还探究了使用复杂卷积结构实现高频捕捉模块对分辨率不变性破坏的实验。

Zero-shot预测:Koopman神经算子具有时间外推和内插的能力。图x展示了Koopman神经算子在建模瑞利-贝纳德对流时的zero-shot实验的效果,其中(a-b)展示了时间内插的实验结果,模型在训练时分别使用相隔2个或4个时间步的物理场监督训练,对未来40个时间步的推理,以此检验时间步内插的效果。(c-d)展示了时间外推的实验结果,分别使用前20个和10个时间步进行监督,对未来40个时间步的推理,以此检验时间步外推的效果。

综上,我们提出一种用于求解偏微分方程的神经算子模型,具有建模偏微分方程或真实动力系统长程时间演化的能力,同时具有分辨率不变性等性质。这一性质使其在有潜力在低分辨率数据上进行训练,并用于高分辨率推理。这些特性对未来的多分辨率训练、多尺度建模和无网格方法等研究方向展现了更多可潜在的能性。

除此之外,我们开发了名为KoopmanLab的计算库,将Koopman算子和其衍生模型在GitHub开源。

[1] Xiong W, Huang X, Zhang Z, Deng R, Sun P, Tian Y. Koopman neural operator as a mesh-free solver of non-linear partial differential equations. Journal of Computational Physics. 2024 Jun 13:113194.

[2] Xiong W, Ma M, Huang X, Zhang Z, Sun P, Tian Y. Koopmanlab: machine learning for solving complex physics equations. APL Machine Learning. 2023 Sep 1;1(3).

[3] Lu L, Jin P, Pang G, Zhang Z, Karniadakis GE. Learning nonlinear operators via DeepONet based on the universal approximation theorem of operators. Nature Machine Intelligence. 2021 Mar;3(3):218-29.

[4] Kovachki N, Li Z, Liu B, Azizzadenesheli K, Bhattacharya K, Stuart A, Anandkumar A. Neural operator: Learning maps between function spaces with applications to PDEs. Journal of Machine Learning Research. 2023;24(89):1-97.

[5] Koopman BO. Hamiltonian systems and transformation in Hilbert space. Proceedings of the National Academy of Sciences. 1931 May;17(5):315-8.

大模型、多模态、多智能体层出不穷,各种各样的神经网络变体在AI大舞台各显身手。复杂系统领域对于涌现、层级、鲁棒性、非线性、演化等问题的探索也在持续推进。而优秀的AI系统、创新性的神经网络,往往在一定程度上具备优秀复杂系统的特征。因此,发展中的复杂系统理论方法如何指导未来AI的设计,正在成为备受关注的问题。

集智俱乐部联合加利福尼亚大学圣迭戈分校助理教授尤亦庄、北京师范大学副教授刘宇、北京师范大学系统科学学院在读博士张章、牟牧云和在读硕士杨明哲、清华大学在读博士田洋共同发起「AI By Complexity」读书会,探究如何度量复杂系统的“好坏”?如何理解复杂系统的机制?这些理解是否可以启发我们设计更好的AI模型?在本质上帮助我们设计更好的AI系统。读书会于6月10日开始,每周一晚上20:00-22:00举办。欢迎从事相关领域研究、对AI+Complexity感兴趣的朋友们报名读书会交流!

![]()

6. 加入集智,一起复杂!

点击“阅读原文”,报名读书会