大脑是由几百亿个神经元结合而成的复杂系统,涌现出复杂的神经动力学。大脑的结构和动力学特征如何帮助实现高效的信息处理和计算功能,涌现出高度的智能?大脑作为演化过程中受到多种限制的生物智能系统,如何启发实现更先进的人工智能?模仿大脑的人工神经网络如何反过来帮助理解大脑的神经表征和计算原理?

在集智俱乐部「计算神经科学」读书会,香港浸会大学物理系教授周昌松做了主题为《神经科学与机器学习交叉路线图》的分享,解读了神经科学与人工智能交叉方向的一系列研究,认为复杂性是实现高级智能的关键,真正的高级智能可能隐藏在复杂性之中,希望神经动力学、物理科学和学习理论等多学科的研究可以帮助促进这一领域的发展,从生物神经系统中汲取灵感,突破现有人工智能面临的挑战,基于神经复杂性实现更高级的智能。读书会回放视频现已上线,希望深入了解的朋友请参看文末读书会详情。

关键词:神经科学,复杂神经动力学,神经网络,机器学习,类脑人工智能

2. 大脑可被认为是训练/学习过的网络:复杂的结构-功能-行为关系

我们可以把大脑看作是一个信息处理的机器,它在不断地进化或是在成长过程中经过不断地学习和训练,具有很多突出的复杂“结构-功能-行为”的关系。从这种角度为理解人类的智能打下一定的基础。神经科学和人工智能的发展相辅相成,神经科学启发了人工智能一些模型和算法,而人工智能可以作为工具在神经科学中进行数据的分析和特征的抓取,另外作为模型来理解大脑运作的一些原理。有关这最后一点,本次读书会主要介绍如何运用机器学习方法来理解人类对于时间处理的特征,最后简要地介绍了未来的研究发展方向。

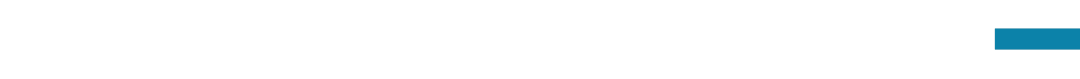

大脑具有两种物质,即灰质(皱褶的皮层表面,大部分是神经元,还有局部的一些树突和轴突)和白质(连接不同脑区的长轴),这两种物质构成一个计算的功能性系统。根据功能可以把大脑划分成不同的系统:视觉系统、感觉运动系统、前额叶系统等。大脑的功耗大约占据人体功耗的20%,就其功能而言,大脑是一个非常高效的系统。大脑中的皮层通过皱褶的方式,在有限的空间内容纳了大量的神经元,同时也缩短了脑区间的连接距离。研究表明,大脑灰质和白质之间存在标度关系,实际上反映了大脑作为一个生物体的智能系统,在空间和能量的限制下通过优化保持了高效的计算能力,这是类脑计算学科可以参考的。

图1. 大脑连接在空间和能量限制下通过优化保持了高效的计算能力

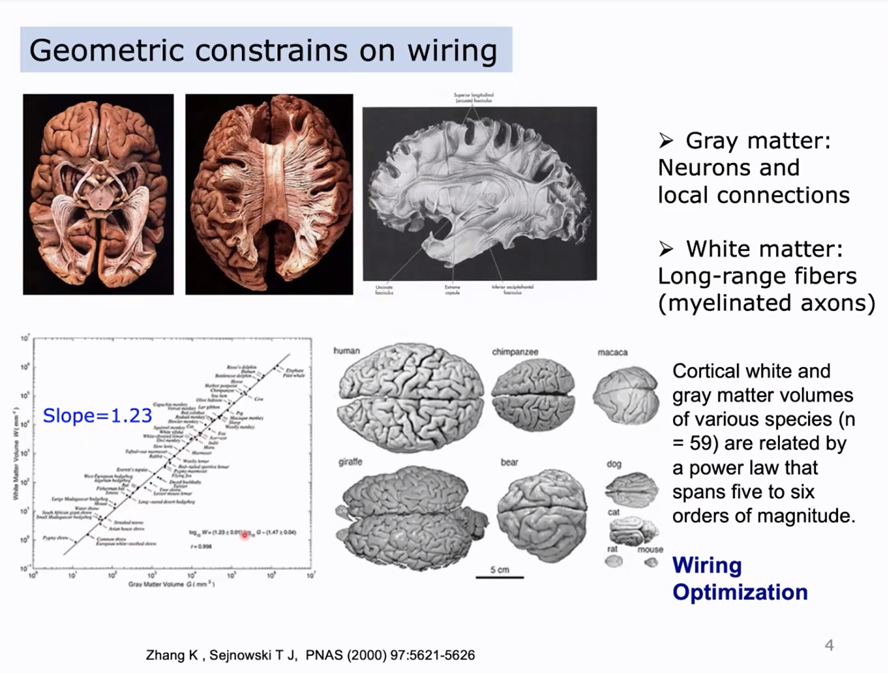

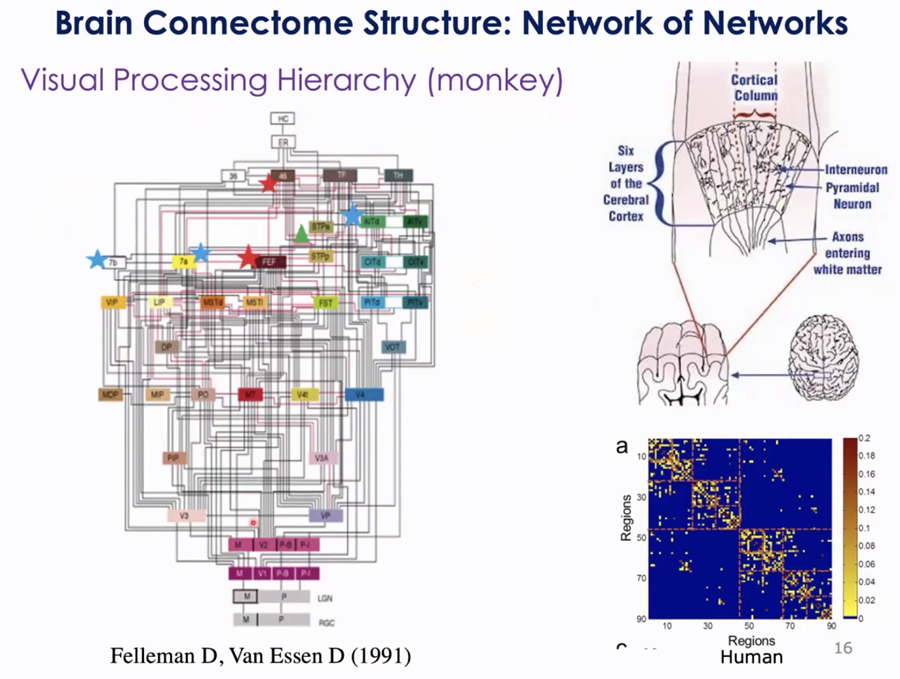

神经元是神经系统基本的计算单元。一个神经元包括细胞体,轴突和树突,不同神经元之间的通讯通过化学突触和神经递质的释放来实现。从结构上来看,局部的大脑回路相当于一种随机网络,从更大尺度上我们可以看到大脑还有其他的柱、层的组织结构。人类成年大脑含有将近860亿个神经元,每个神经元与上万个其他的神经元线连接,形成一个非常复杂的计算网络。

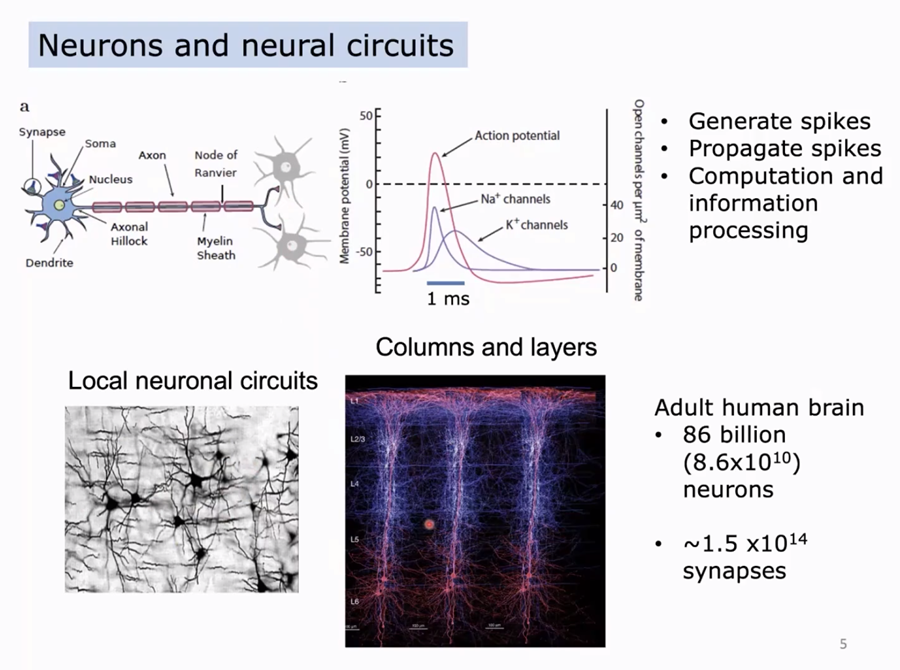

那么,我们如何采集数据来得到大脑的网络结构?在动物模型里,通过注射追踪剂,研究者观察试剂分子如何从一个脑区到底另外一个脑区,以此得到脑区间的连接结构。比如,研究者通过这样的方式发现小鼠的大脑可以被划分为很多的脑区,不同脑区之间有许多复杂的连接。对于人类而言,由于无法使用这种有创的研究方式,研究者替代使用影像学的方法来检验脑区之间的连接,比如磁共振研究中的扩散影像技术DTI。这种技术利用磁场检验水分子在大脑组织中的扩散速率不同,通过间接的方式来估计大脑之间的连接结构,得到人脑的结构网络。

2. 大脑可被认为是训练/学习过的网络:

复杂的结构-功能-行为关系

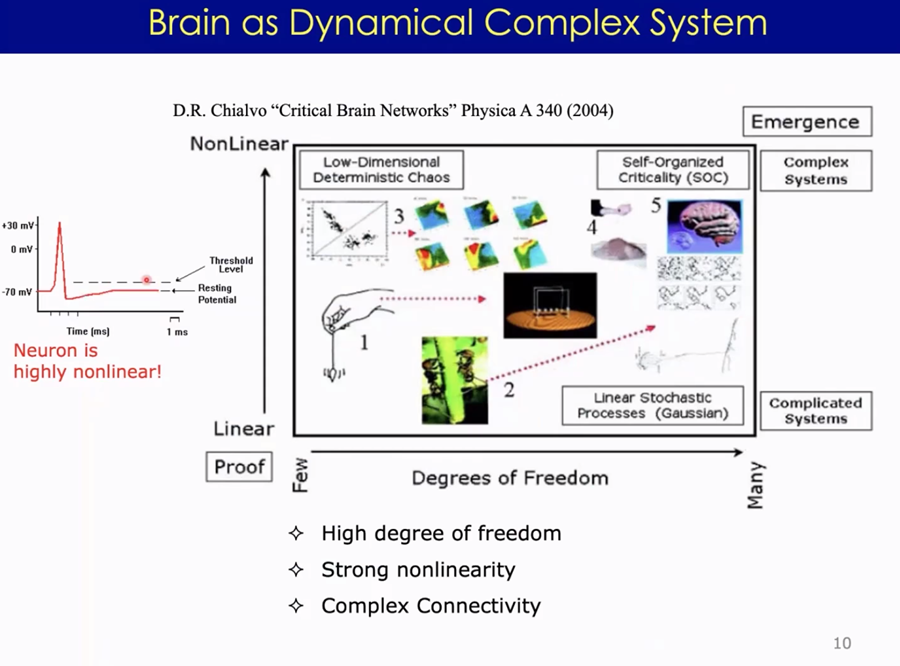

神经系统是一个非常强的非线性系统,我们可以把神经系统的运作看作将输入进行非线性转换得到输出的一个过程。对于神经元而言,输入要达到一定的阈值才能发生反应,产生神经发放。大脑中的几百亿个神经元的大量结合,构成了一个复杂系统,可以涌现出许多复杂的动力学,比如多个神经元无规则的发放形成了大脑在不同频率上震荡的信号。大脑的这些动力学特征如何参与信息处理和计算形成智能,以及大脑如何通过不断进化学习来实现其功能,都将启发和促进人工智能的发展。

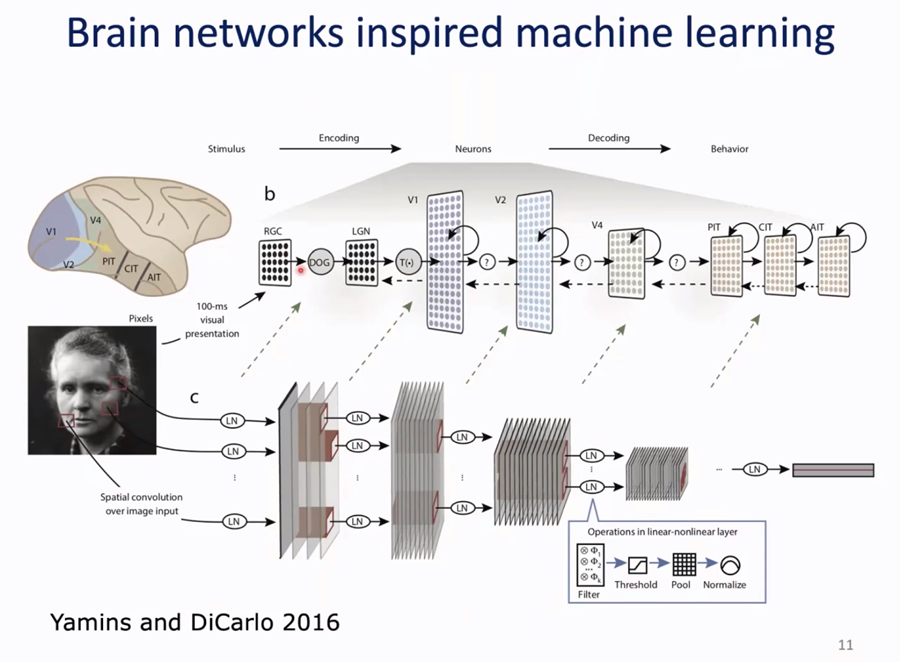

近年来,神经科学与智能系统的交叉引发了人们对大脑的深入思考。我们已经将大脑视为一种智能系统,这种观念源于对大脑内部多层次结构的启发,如视觉系统等。人工智能的第四波,尤其是深度网络,直接受到了大脑多层次组织的影响,尽管存在简化。在多层次的视觉系统中,内部连接复杂,存在前馈和反馈,这两者不仅仅在两层之间,而是可跨越多层次。相比之下,真实的生物智能系统比人工智能系统更为复杂。

现今,人们广泛讨论大型模型如GPT,但其训练代价巨大。以前几年训练亿级参数神经网络为例,其消耗相当于一辆美国汽车一辈子的能量的几倍。因此,人工智能的大量训练可能对能源和环境产生巨大影响。

值得强调的是,大脑可以从多个角度来看待,它是一个复杂的系统,也是一个功能丰富的器官。在自然演化过程中,大脑受到多种限制的制约,如能量和功能的限制。这种平衡体现在结构、动力学和功能输出上。类脑的研究正是基于对大脑本质的思考,以及我们可以从中学到的东西。大脑作为生物智能系统,其限制非常强,但如果对能量和功能的限制放松,可能会找到比大脑更优越的运作方式。然而,机器不会感到疲惫,因此可以不断训练学习,超越人类,这值得我们反思。

神经科学与人工智能的交叉研究,揭示了大脑结构、动力学和功能之间复杂的关系。在研究大脑结构时,我们关注神经元之间的连接方式,包括树突轴突连接以及不同脑区之间的网络连接。这些连接呈现出多层次、模块化的特点,揭示了大脑内部的复杂结构。

Wang, R., Lin, P., Liu, M., Wu, Y., Zhou, T., & Zhou, C. (2019). Hierarchical connectome modes and critical state jointly maximize human brain functional diversity. Physical review letters, 123(3), 038301.

Wang, R., Liu, M., Cheng, X., Wu, Y., Hildebrandt, A., & Zhou, C. (2021). Segregation, integration, and balance of large-scale resting brain networks configure different cognitive abilities. Proceedings of the National Academy of Sciences, 118(23), e2022288118.

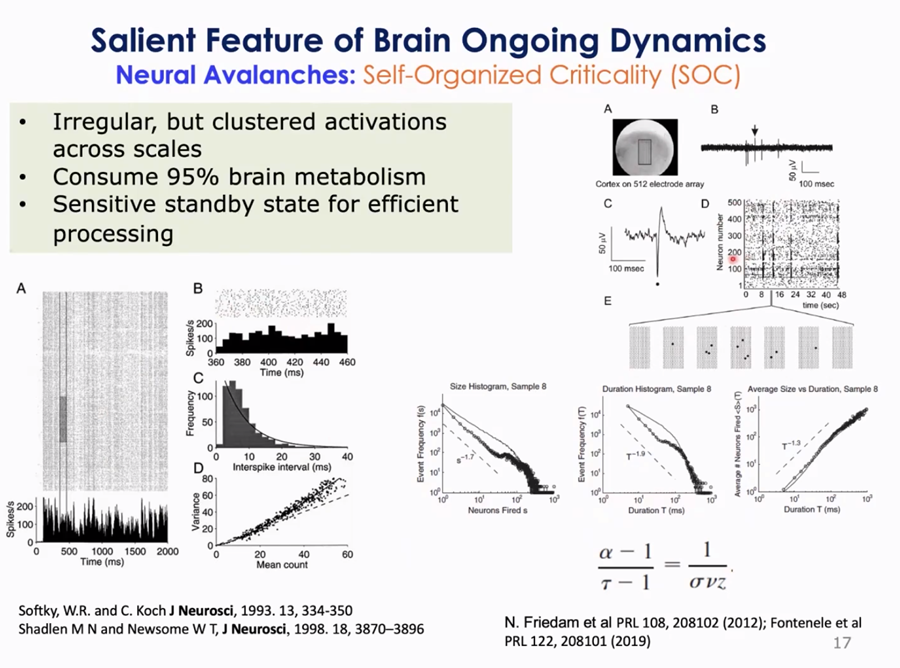

神经动力学方面的研究发现,神经元的活动具有自组织涌现的特征,表现为神经雪崩现象。这种现象在不同尺度上都存在,从单个电极到整个大脑,都可以观察到神经元群体的集群发放行为,表现出一种临界活动状态。这种状态使得大脑对外界刺激非常敏感,能够随时做出响应,实现各种功能,而且消耗能量较少(Friedman et al., 2012; Softky & Koch, 1993)。

Friedman, N., Ito, S., Brinkman, B. A., Shimono, M., DeVille, R. L., Dahmen, K. A., . . . Butler, T. C. (2012). Universal critical dynamics in high resolution neuronal avalanche data. Physical review letters, 108(20), 208102.

Softky, W. R., & Koch, C. (1993). The highly irregular firing of cortical cells is inconsistent with temporal integration of random EPSPs. Journal of neuroscience, 13(1), 334-350.

人工智能系统的运作也受到神经动力学的启发,尤其是在处理任务时的自发状态和任务状态之间的关系。通过分析大脑活动的波传播模式,可以预测大脑的表现和反应,从而更好地理解其运作机制。这种研究为我们提供了深入了解大脑与人工智能之间关系的新视角。

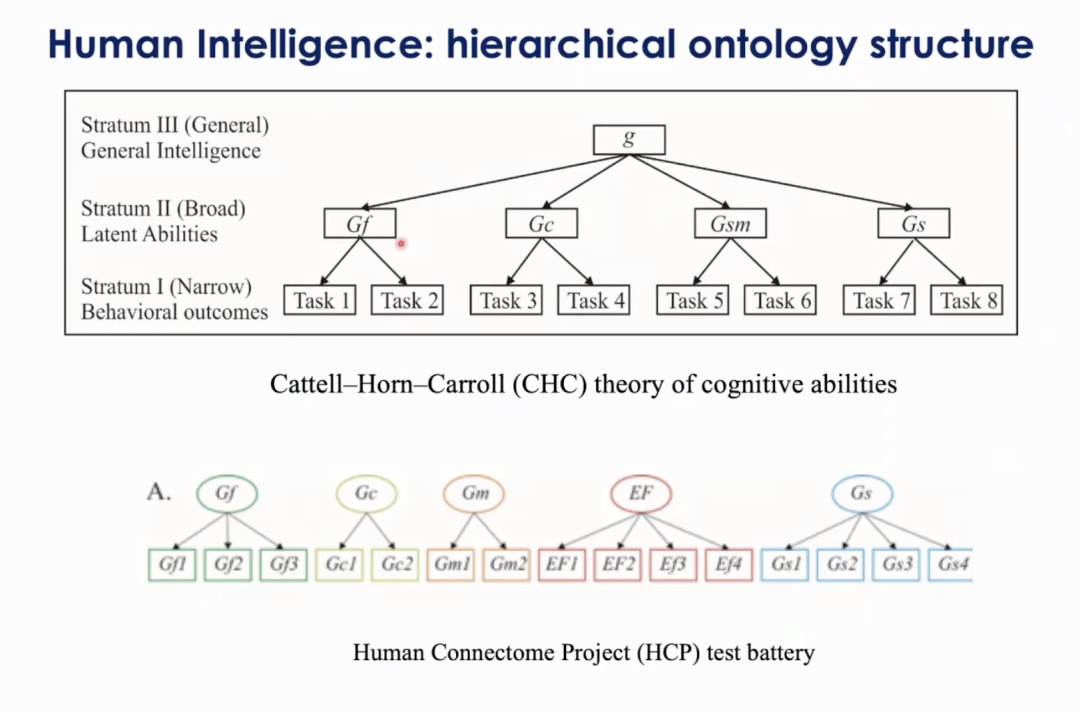

近期的研究趋向于从复杂性角度理解大脑的运作。复杂系统理论以及能量限制等角度被运用于解释大脑的复杂连接和活动模式。大脑被视为一个网络,其组织形式与个体的认知能力以及不同尺度下的局部回路动力学有关。在认知心理科学中,智力常被讨论,涵盖了诸如自由流体智力和晶体智力等不同的功能,例如语言。流体智力,如推理和反应速度,并非直接可测量,而是通过任务表征。举例来说,一位理科生在数理化方面表现优异,而文科生可能在历史、语文或地理等科目表现更佳。通过在人群中对这些任务表现进行协方差共变分析,可以得出其能力水平。这些能力之间存在相关性,因此可以通过测量某种智能来了解这种相关性。有趣的是,人类智力体现了处理多个能力的多任务总体能力,这对于评估智能系统的行为具有重要意义。

在探讨大脑神经突触的复杂性时,我们需要了解其多层次的结构和动态特性。大脑的结构网络具有多个层次,这些层次与其动态特性相互交织,以实现最优的组织排列。我们利用DTI技术获得大脑的结构网络,将大脑划分为200多个脑区,并量化了它们之间的连接强度。这种连接强度矩阵通过模式分解,类似于量子力学中的能级分解,揭示了大脑的激发和抑制模式。这些模式反映了不同脑区之间的相互作用,如左右脑或前后脑等。通过进一步分析,我们发现大脑的连接形成了多层次的模块化结构,其中包括左右脑和前后脑等更细分的层次。这种多层次的结构突显了大脑神经网络的复杂性和精妙性,为我们理解大脑功能的复杂性提供了新的视角。

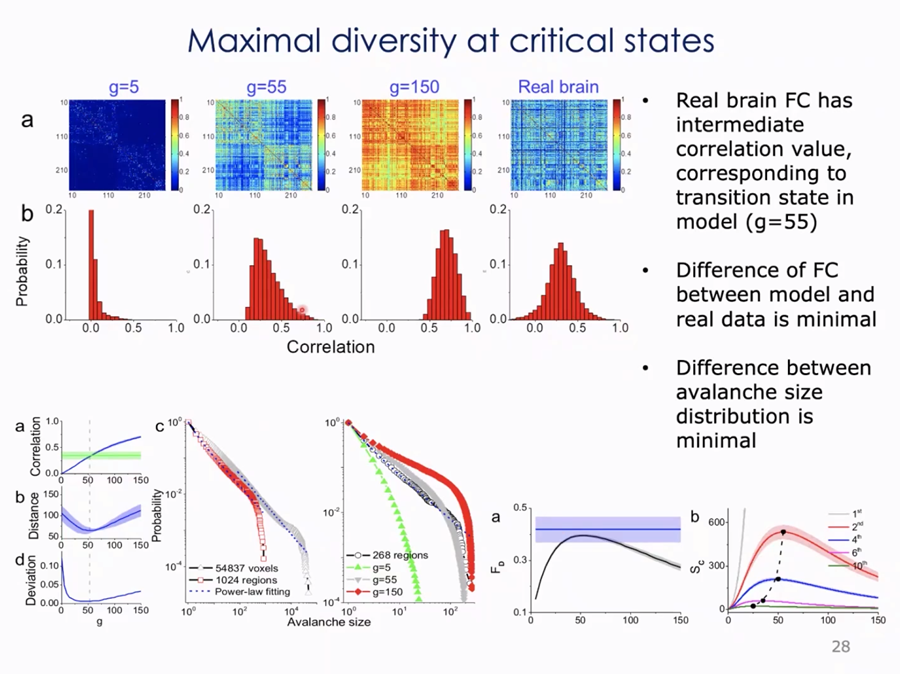

大脑可以被视为一个网络,其中动态过程被描绘为连接局部并受到激发的动力学模型。这种激发引发了所谓的功能连接,即不同脑区之间的神经活动关联性。随着连接的耦合强度增加,脑区之间的关联也随之增强。实际上,真实大脑的平均关联度约为0.4,与模型数据相符。在动态状态下,脑区之间的连接强度会不断变化,表现出丰富的动态特性。大脑结构具有多层次,破坏其中一些层次会导致不同模块的形成。这种多层次结构和动态特性使大脑处于最优状态,为其作为智能系统的功能提供了基础。功能网络的分析表明,大脑系统具有整合和分化的特性,其特征值反映了整合与分离的强度。

Wang, R., Lin, P., Liu, M., Wu, Y., Zhou, T., & Zhou, C. (2019). Hierarchical connectome modes and critical state jointly maximize human brain functional diversity. Physical review letters, 123(3), 038301.

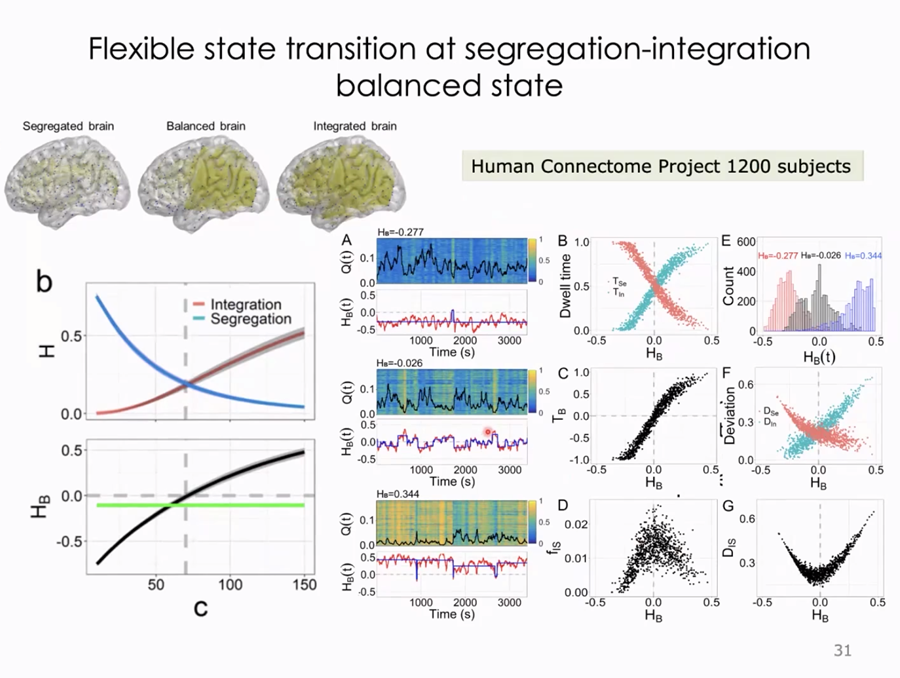

在研究中,我们发现大脑的整合程度与耦合程度正相关,而分化程度与耦合强度呈负相关,而且这种关系正好在一个临界点达到平衡。通过使用1200多名个体的磁共振数据,我们发现大脑的整合和分化相差程度接近于零,表明大多数人的大脑处于平衡状态。这种平衡状态在不同任务下可能会发生变化,但对于处理各种任务至关重要。

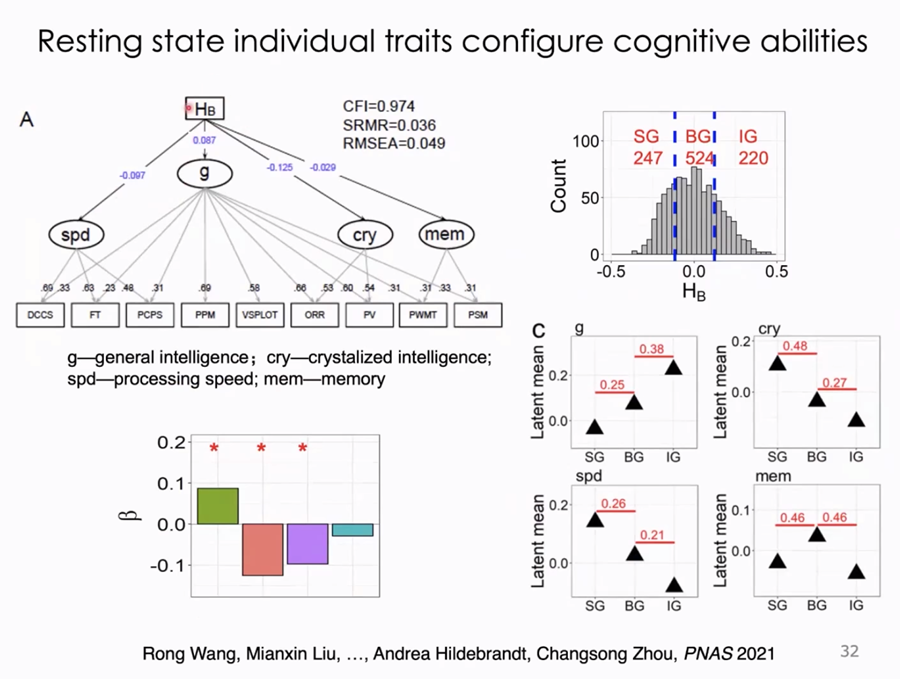

我们认为个体的大脑特质可能会影响其能力。一些人更倾向于分化,而另一些人更倾向于整合,这可能会反映在其处理任务的方式上。我们发现处于平衡状态的大脑可能更有利于满足不同任务的要求,因为它可以灵活地进行分化和整合。相反,如果大脑一开始就处于过度分化或过度整合的状态,可能会在处理某些任务时遇到困难。

通过对大脑和行为的研究,我们发现大脑的平衡特点与智能有关。我们的数据显示,大脑整体平衡与一般能力呈正相关,而与一些特定能力(如晶体智力和反应速度)呈负相关。进一步的分析表明,不同的大脑平衡类型可能与特定智力需求相关,这对于构建更符合人类智能的人工智能系统可能具有启发意义。

Wang, R., Liu, M., Cheng, X., Wu, Y., Hildebrandt, A., & Zhou, C. (2021). Segregation, integration, and balance of large-scale resting brain networks configure different cognitive abilities. Proceedings of the National Academy of Sciences, 118(23), e2022288118.

图11. 大脑功能网络分化和整合的个体差异影响个体的认知能力

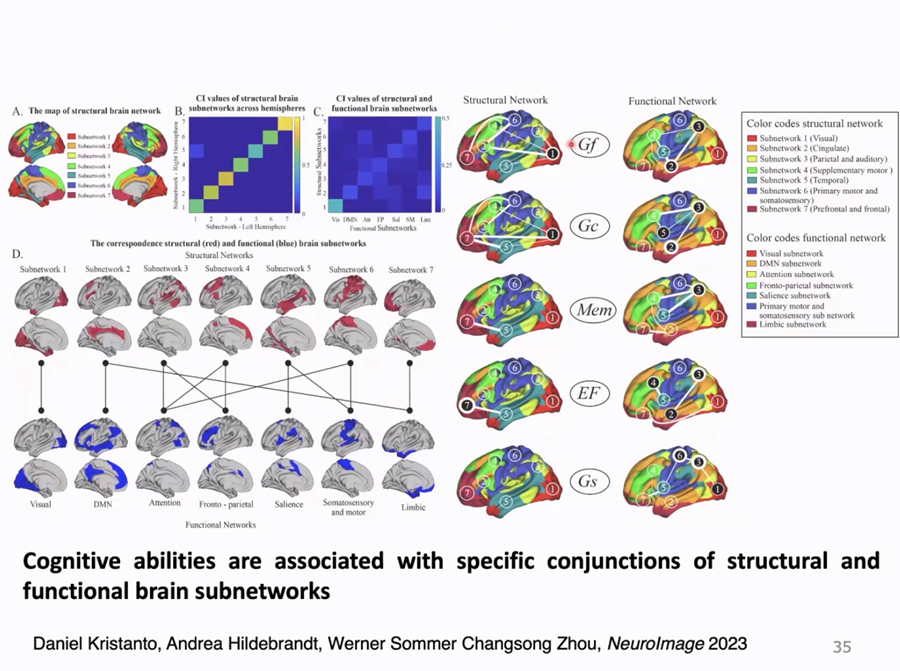

通过磁共振成像等技术,我们可以深入了解大脑的结构特征。灰质皮层的厚度反映了神经元的密度,而树突的多变性则影响了大脑的功能多样性。大脑的功能系统因个体差异而异,使用机器学习等方法可以将大脑划分为不同的子网络系统,这有助于理解智能的实现方式。

然而,我们发现大脑结构和功能之间的关系并不简单。尽管某些网络与特定功能(如视觉系统)相关联良好,但其他功能与结构网络之间的对应关系并不明确。实际上,每种能力似乎都涉及多个子系统的参与,但它们的组合方式却是独特的。

我们的研究成果表明,构建更大型的模型以实现多功能灵活性可能并不简单。在智能系统设计中,从结构到动力学再到功能的安排具有重要意义,这为未来的人工智能系统提供了有价值的启示。

大脑的结构和功能之间存在着复杂而微妙的关系。从生物学的角度来看,大脑是一个在成本和效益之间进行权衡的系统。尽管其结构受到能量限制的制约,但其功能的实现却相当有效。例如,大脑的神经元连接是局部的,但在功能上却能够表征空间的关联信息。此外,大脑的动力学特征也具有一定的稳定性,与其结构相一致,不像神经网络那样随着运作过程而不断变化。这种稳定性使得大脑既能够学习又能够保持稳定状态,满足了矛盾的要求。

Chen, Y., Wang, S., Hilgetag, C. C., & Zhou, C. (2017). Features of spatial and functional segregation and integration of the primate connectome revealed by trade-off between wiring cost and efficiency. PLoS computational biology, 13(9), e1005776.

图13. 大脑的结构和动力学特性使得能够以较少的代价实现高效的功能

从生物学的角度出发,我们可以更好地理解大脑结构、动力学和功能之间的关系,并从中汲取启示。研究表明,大脑的连接结构在实现功能传输的同时,也需要满足一定的约束条件。此外,大脑的动力学特征在完成任务时能够以较少的代价实现高效的组合。因此,我们可以通过降低大脑系统的整体能量消耗,以及优化能量消耗大的连接部分,来实现更低成本的智能系统。

此外,作为一个生物系统,大脑需要消耗大量能量,但也会产生代谢产物。这些代谢产物的积累与大脑退化相关,如淀粉样蛋白的堆积可能导致神经退行性疾病。因此,大脑需要尽可能优化其能量消耗,特别是在能量消耗较大的连接部分。这样不仅能够减少整体代谢需求,还可以减少代谢产物的积累,降低疾病风险,使大脑在受到能量限制的情况下保持良好的运作。

大脑的动力学特征与其结构密切相关。在生物神经网络中,神经元之间的连接形成了局部回路,这些连接对于信息传输至关重要。每个神经元通过释放神经递质将信息传递给下一个神经元,但这个过程的时间非常短暂,通常只有几毫秒。神经元之间的连接具有节奏性,形成了整个系统的节律,如Gamma波,这在记忆和学习中经常出现。通过从智能和代谢的角度观察,我们发现大脑的神经元发放非常稀疏,但通过不同神经元的组合,可以实现有效的信息表征,这种方式能够以最少的代价实现最优的信息传输。

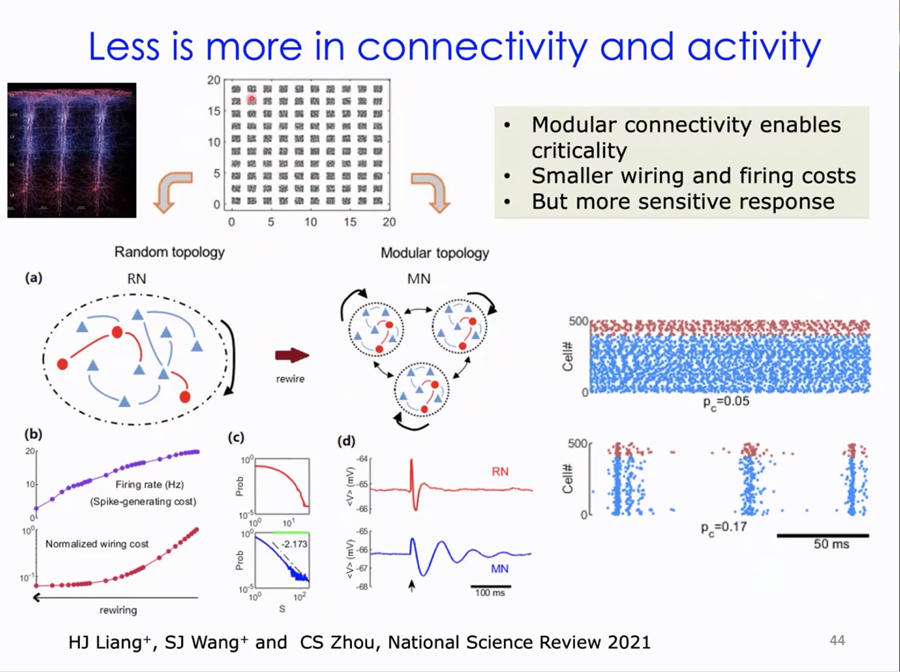

大脑的结构也与其功能密切相关。实际的大脑结构中,神经元通常分布在团簇中,并通过空间中的连接形成模块化的特征。模块化结构可以使得连接随着距离的增加而衰减,从而形成模块化特征。然而,在完全打乱的连接中,形成了稀疏的随机网络,每个神经元的发放都是无规律的,这样的网络神经元的发放频率可以达到20赫兹,而真实的脑网络神经元的发放频率是1-2赫兹。相比于随机网络,大脑这种优化的连接方式使得它能够以更少的代价实现更高效的信息传输,体现了“less is more”的原则。

Liang, J., Wang, S.-J., & Zhou, C. (2022). Less is more: wiring-economical modular networks support self-sustained firing-economical neural avalanches for efficient processing. National Science Review, 9(3), nwab102.

图14. 大脑的连接和活动体现了“less is more”的原则

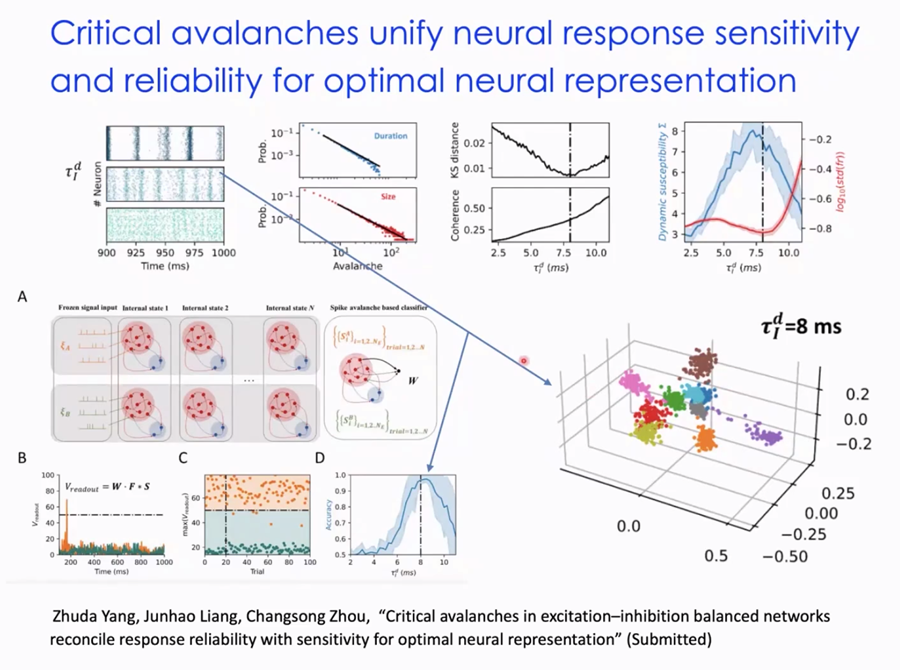

最近的研究发现了一种有趣的生物局部网络,其动力学特征表现为无规则的发放,以及一种称为“雪崩”的现象,即在临界状态下神经元发放的数量可能会剧烈变化。相比于物理科学中的随机临界性模型,生物神经系统中的临界性表现出更大的灵活性和可重复性,即使在小刺激和大刺激下都能做出响应,并且在不同信号之间能够产生可重复的内部表征。这种动力学特征与大脑内部的结构密切相关,使得大脑能够以更少的能量实现更优越的信息处理。

图15. 大脑网络的临界雪崩协调响应的可靠性和敏感性以实现最优的神经表征

最近我们撰写了一篇综述论文,总结了神经动力学平衡、临界性以及它们之间的内在统一。这篇综述包括了数十篇相关论文。大脑被视为一个复杂的系统,它利用涌现的复杂动力学进行计算,并通过模块的不同组合实现多种功能。在能量有限的情况下,大脑通过优化其结构和动力学特征来实现高效的信息处理。因此,我们相信人工智能可以从大脑中学习,并且在某些方面甚至可以超越其限制,实现更优异的功能。

Liang, J., Yang, Z., & Zhou, C. (2024). Excitation–Inhibition Balance, Neural Criticality, and Activities in Neuronal Circuits. The Neuroscientist, 10738584231221766.

大脑作为一个智能系统,启发了许多人工智能领域的发展。最初的神经网络模型在上个世纪90年代达到巅峰,但后来随着深度学习的兴起,特别是卷积神经网络在图像处理领域的成功,再次引发了AI领域的热潮。除了视觉系统,还有处理语言的神经网络,它们的设计与处理任务密切相关。汪小京老师和杨光宇等学者对人工神经网络进行了深入的研究和介绍。

Yang, G. R., & Wang, X.-J. (2020). Artificial neural networks for neuroscientists: a primer. Neuron, 107(6), 1048-1070.

刘健老师则专注于脉冲神经网络的研究,这种网络使用脉冲而非速率进行信息传递,更接近生物神经系统的工作方式,并具有低能耗的优势。强化学习是另一个受到大脑启发的领域,它可以将动物实验中的奖赏机制转化为机器学习模型,从而实现更智能的学习策略。虽然已有许多相关研究和应用,但对于新进入这个领域的人来说,仍需深入研究现有文献,寻找前沿领域并探索新的研究方向。因此,对于生物神经网络结构、动力学和学习算法等方面的深入思考是非常有意义的。

在神经科学领域,机器学习技术的应用正在逐渐成为研究的重要组成部分。神经科学研究者们面对着神经系统复杂性的挑战,如何从中提取结构和动力学信息成为了一个重要课题。大数据时代的到来使得神经科学进入了一个数据丰富的时代,这也促使着研究者们开始思考如何利用机器学习技术来处理这些海量数据。

举例来说,医学领域的研究者们利用MRI等影像技术进行肿瘤分类识别,并通过机器学习技术来进行脑区划分和mapping。在神经动力学研究中,寻找与任务、年龄和疾病相关的特征成为了一项重要任务,这些特征的提取常常需要借助人工神经网络和深度学习模型。例如,通过融合深度学习和影像学技术,可以预测一个人的年龄,这种应用对医学诊断和疾病监测具有重要意义 (Cole & Franke, 2017)。此外,图神经网络在认知研究中也发挥着重要作用,它可以分析脑电信号和脑结构之间的关系,为神经科学研究提供了新的视角 (Klepl et al., 2024)。尽管机器学习技术在神经科学领域的应用正在迅速增长,但其中仍然存在着一些挑战,如特征的可解释性等问题,这需要结合领域专业知识进行深入研究。随着机器学习技术在神经科学领域的不断发展,相信未来将会有更多的创新和突破。

Cole, J. H., & Franke, K. (2017). Predicting age using neuroimaging: innovative brain ageing biomarkers. Trends in neurosciences, 40(12), 681-690.

Klepl, D., Wu, M., & He, F. (2024). Graph neural network-based eeg classification: A survey. IEEE Transactions on Neural Systems and Rehabilitation Engineering.

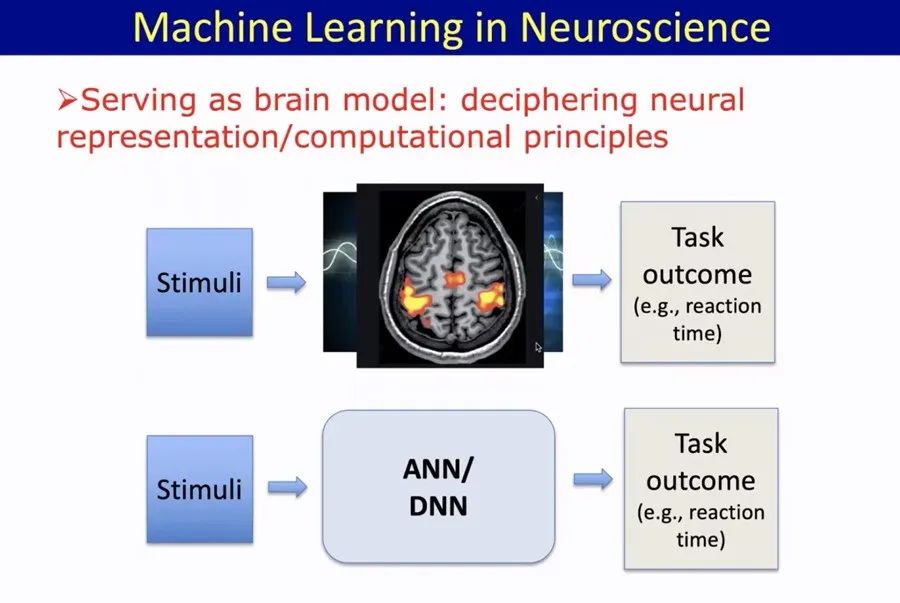

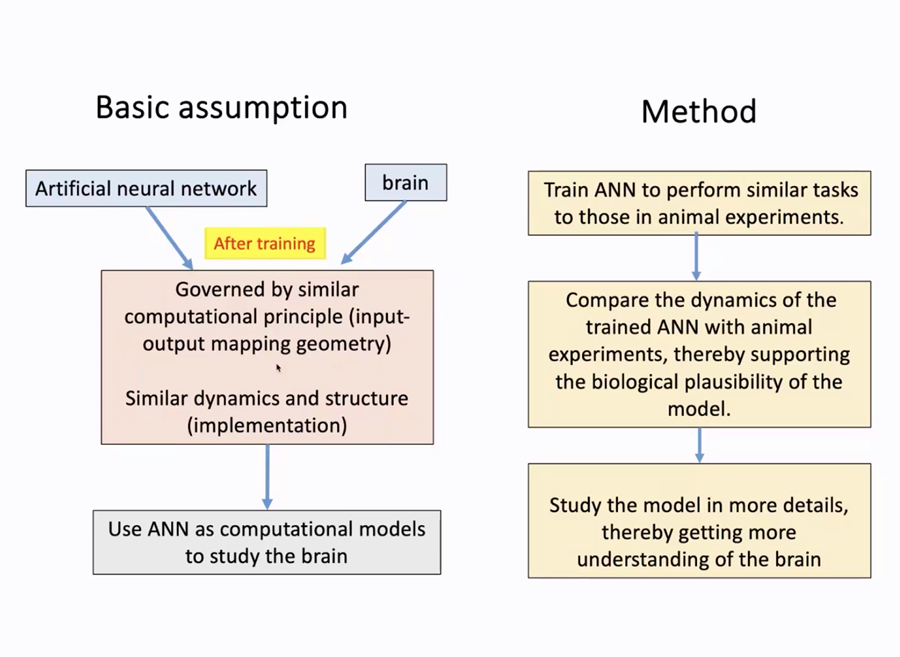

最近,一个新兴且引人注目的方向是将机器学习应用于神经科学领域。机器学习本身源自于对人类大脑的模仿,但现在,我们可以将机器学习作为一种模型来理解大脑的神经表征和计算原理。想象一下,我们可以将输入给大脑的图像输入到人工智能系统中,然后观察其特征。就像人类接收外界刺激后产生行为一样,人工神经网络也可以通过模拟类似的任务输出类似的行为。例如,我们可以使用人工神经网络模拟工作记忆的任务,测试其在识别颜色和保持颜色信息方面的表现。

通过人工神经网络的表征,我们希望能够理解刺激与行为之间的映射关系,从而揭示大脑计算和表征的原理。这种研究方法对于神经科学的发展具有重要意义,因为它提供了一个逻辑上的框架,可以比较不同模型之间的相似性。尽管不同模型的实现方式可能不同,但它们在某种程度上可能会共享相似的动力学和结构原理。

图16. 我们可以将机器学习作为模型来理解大脑的神经表征和计算原理

这种方法的优势在于我们可以通过训练人工神经网络执行类似于动物或人类的任务,然后比较其表征方式。与动物实验相比,人工神经网络模型更容易解释,因此可以为神经科学研究提供更多的启发。此外,这种方法还可以帮助我们理解大脑的基本原则,从而推动神经科学领域的进步。

最近的研究表明,我们可以通过比较大脑和人工智能模型的表征来理解它们之间的相似性。在机器学习中,我们经常使用表征空间中的相似性来对不同对象进行分类。例如,当我们刺激大脑观察手的图片时,不同手势在表征空间中可能会聚集在一起,形成相似性群。然而,不同的手势之间在表征空间中的距离会随着它们的不同而变化,从而使得我们可以通过表征空间的距离来区分刺激信号。

这种相似性表示的概念也可以应用于大脑研究中。当大脑产生特定活动模式时,不同刺激可能会引发类似的响应模式,这被称为相似性表征。通过比较模型生成的相似度矩阵和大脑的相似度矩阵,我们可以确定它们之间是否存在相似性。这种方法可以帮助我们理解大脑的抽象表征空间,以及它们如何影响行为表现。

Kriegeskorte, N., & Kievit, R. A. (2013). Representational geometry: integrating cognition, computation, and the brain. Trends in cognitive sciences, 17(8), 401-412.

图18. 通过比较大脑和人工智能模型的表征来理解它们之间的相似性

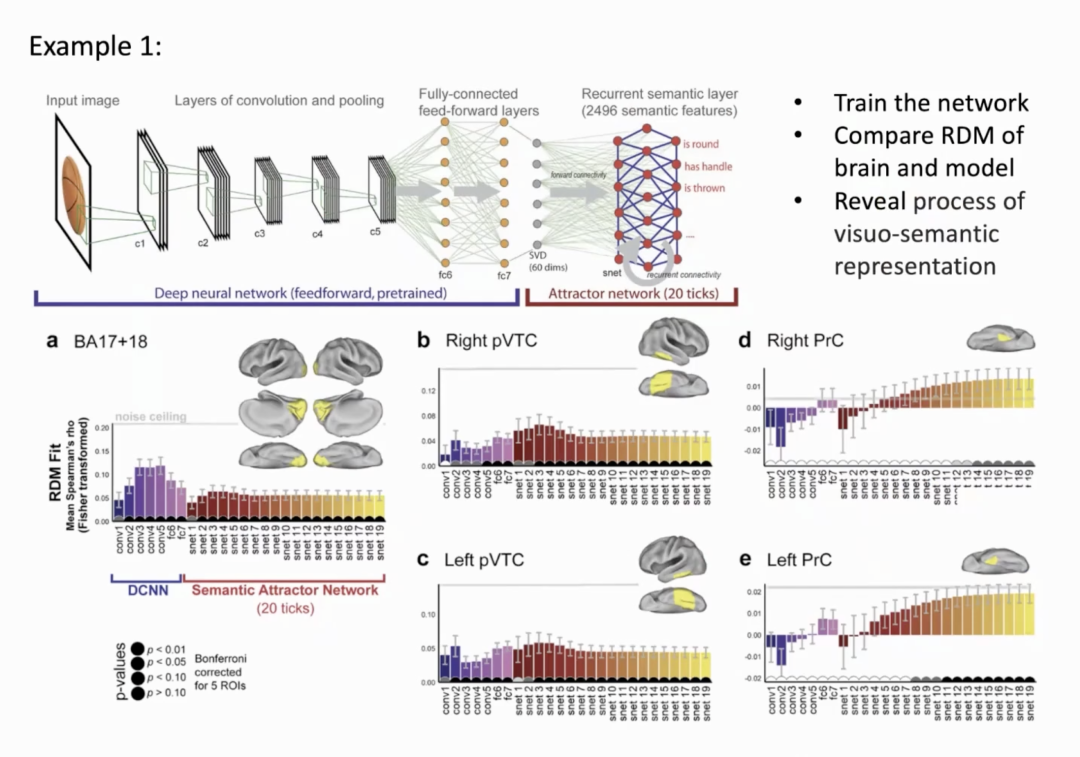

举个例子,研究人员通过训练卷积神经网络来理解大脑视觉系统的层次处理过程。他们发现,在网络的不同层次中,隐含的表征会逐渐聚集成群。通过与测量大脑活动的数据进行比较,他们发现大脑的初级视觉皮层与深度神经网络的前几层的相似性较高。这表明大脑可能采用了类似于深度网络的表征方式来进行信息处理。

Devereux, B. J., Clarke, A., & Tyler, L. K. (2018). Integrated deep visual and semantic attractor neural networks predict fMRI pattern-information along the ventral object processing pathway. Scientific reports, 8(1), 10636.

图19. 通过训练卷积神经网络来理解大脑视觉系统的层次处理过程

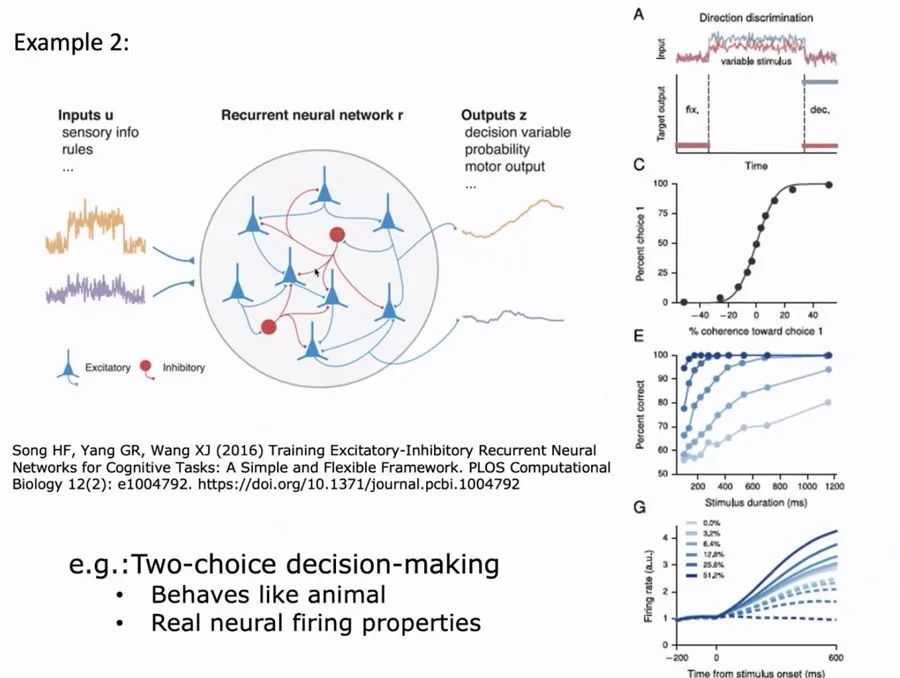

最近的研究表明,通过建立循环神经网络,我们可以模拟汪小京老师等研究人员在决策领域的重要发现。这种网络能够根据输入的刺激,如信号a或信号b,做出决策,并且与生物大脑的行为表现非常相似。通过在网络中引入生物学特征,如稀疏化或神经元抑制,我们可以更好地理解决策信息的积累过程,以及大脑是如何处理这些信息的。

Song, H. F., Yang, G. R., & Wang, X.-J. (2016). Training excitatory-inhibitory recurrent neural networks for cognitive tasks: a simple and flexible framework. PLoS computational biology, 12(2), e1004792.

另一个重要的研究方向是多任务学习,汪小京老师等人在这方面也取得了一些突破。他们训练了多个任务,并观察到在网络中某些神经元的发放形成了对应于特定任务类别的模式。这些研究揭示了大脑在不同任务之间分化和整合的基本特征,并且通过机器学习模型的分析可以更好地理解这一过程。

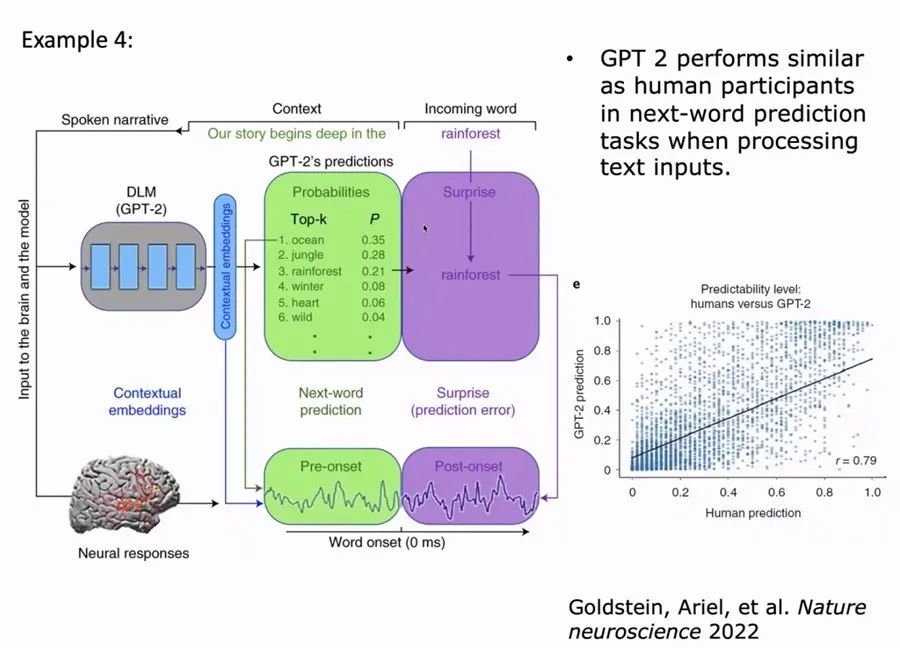

此外,语言模型也成为了研究的热点之一。它们具有强大的语言生成能力,并且能够预测下一个词出现的概率,类似于人类的语言处理能力。通过研究模型的内部表征和大脑在处理语言上下文时的特征,我们可以更深入地了解大脑是如何实现类似功能的。这些研究不仅可以帮助我们理解大脑的工作机制,还可以启发我们设计更加智能的人工系统。

Goldstein, A., Zada, Z., Buchnik, E., Schain, M., Price, A., Aubrey, B., … Cohen, A. (2022). Shared computational principles for language processing in humans and deep language models. Nature neuroscience, 25(3), 369-380.

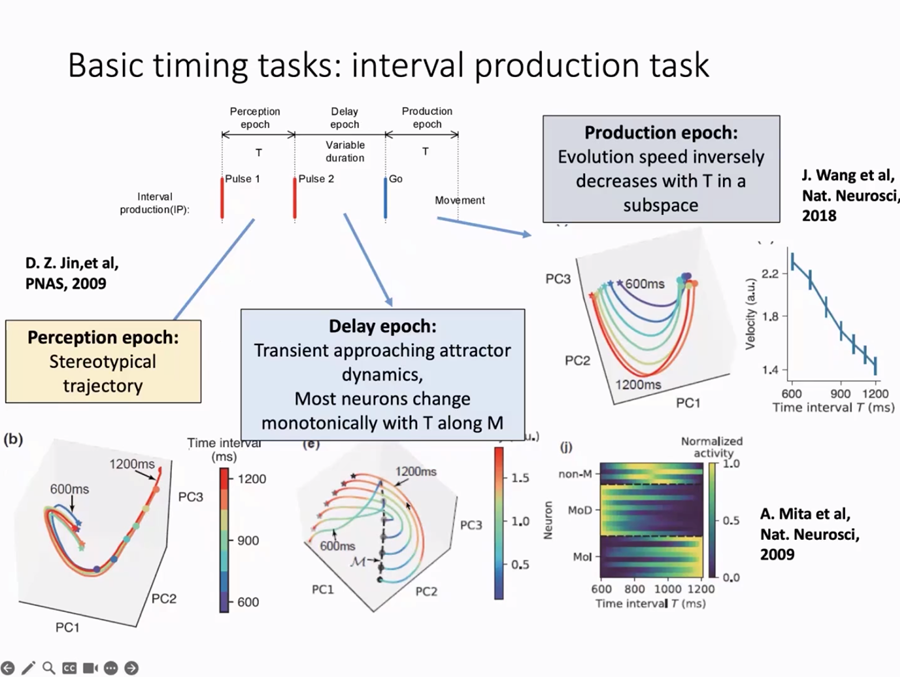

我们通过机器学习的训练来理解大脑如何处理时间信息。这涉及到在工作记忆中维持时间、跳舞时的时间记忆与空间记忆的关系,以及神经元活动与时间感知的关联。毕刚栋老师(目前在上海临港实验室)的研究成果,取得了一些重要进展。

Bi, Z., & Zhou, C. (2020). Understanding the computation of time using neural network models. Proceedings of the National Academy of Sciences, 117(19), 10530-10540.

通过人工神经网络的训练,我们可以模拟动物实验中关于时间的工作记忆。神经元的活动模式与持续时间相关,并且通过神经元活动的变化速度来表征时间信息。此外,我们通过对神经元活动的分析发现,时间表征与空间表征在大脑中是相对独立的,这为我们理解时间处理的神经机制提供了重要线索。

图22. 通过人工神经网络模拟动物实验中关于时间的工作记忆

在神经科学领域,研究人员一直在探索大脑如何处理时间信息。通过对神经元活动的研究,我们可以了解到神经元在时间维度上的动态变化。研究发现,神经元的活动呈现出一种持续的演化轨迹,这种轨迹可以用来表征时间的流逝。但是,一个关键的问题是,在一个全连接的神经网络中,为什么会出现这种持续的时间变化呢?

我们发现,神经元之间存在着一种连锁反应的机制。当一组神经元发放信号时,会引发另一组神经元的活动,并抑制之前组的活动,形成了一种序列传递的模式。这种连锁反应的存在,使得神经元的活动呈现出一种序列性的特征。

在进行多个任务时,我们也可以观察到类似的模式。不同的空间任务会激发不同的序列,而一旦某个序列被激活,它会抑制其他序列的活动,从而保持动作的连贯性。

总的来说,通过对神经动力学的研究,我们可以更好地理解大脑是如何处理时间信息的。这种研究不仅可以帮助我们理解基本的神经机制,还可以为我们解释复杂任务中的时间处理过程提供新的线索。

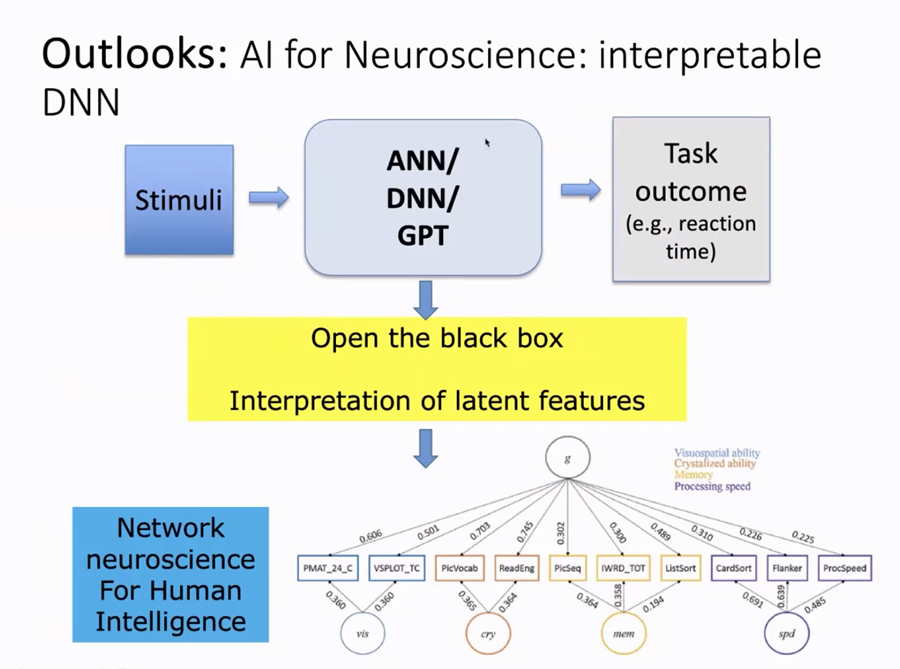

在神经科学和人工智能的交叉领域,我们努力理解大脑的结构、动力学和功能,并将这些知识应用于人工智能系统的设计和解释。可解释的人工智能成为了一个关键问题,即如何打开黑箱,理解其中隐藏的潜在特征。通过将从数据中获得的信息与解释相结合,我们可以更清晰地理解科学现象。

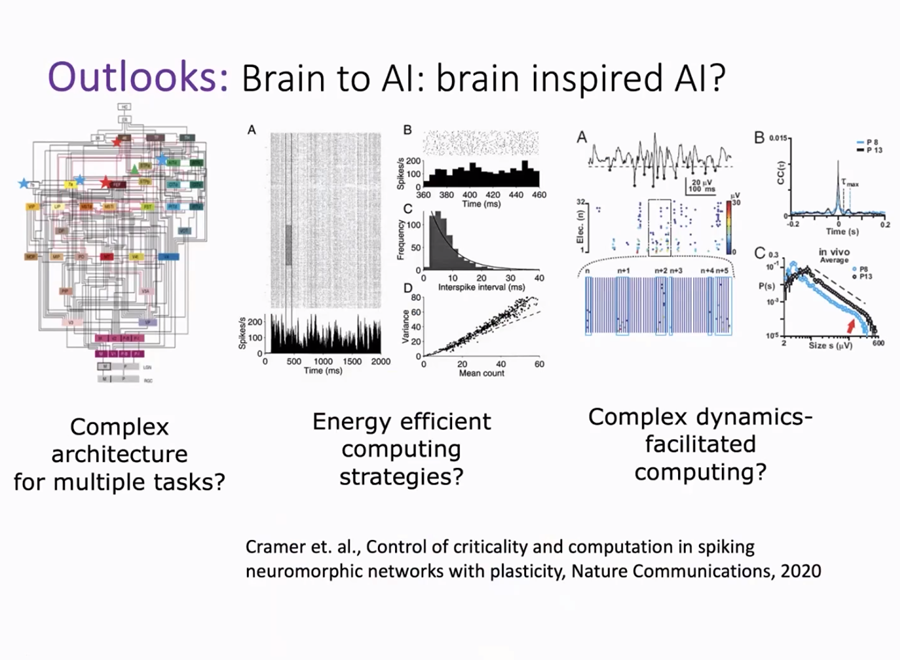

同时,我们也受到人类大脑的启发,探索生物神经系统中复杂结构、动力学和能量利用等方面的机制,以期解决人工智能面临的挑战。我们试图从生物神经系统中汲取灵感,将复杂性转化为智能,并探索复杂性与智能之间的关系。

图24. 生物神经系统研究帮助解决人工智能面临的挑战

在研究过程中,我们发现复杂性是实现高级智能的关键,但同时也是一个挑战。然而,真正的高级智能可能隐藏在复杂性之中,因此我们需要深入研究动力学、物理科学和学习理论等多个领域,以促进该领域的进一步发展。

因此,我们鼓励不同背景的研究人员之间的合作与交流,共同推动神经科学和人工智能领域的发展。这次读书会的讨论只是一个开始,我们期待着未来的更多合作与探索。

[1] Joshua I.Glaser, Ari S.Benjamin, RoozbehFarhoodi, et al. The Roles of Supervised Machine Learning in Systems Neuroscience, 2019

[2] Cole H.J., Franke K.. Predicting Aging Using Neuroimaging: Innovative Brain Ageing Biomarkers, 2017

[3] Barry J. Devereux, Alex Clarke, Lorraine K. Tyler. Integrated deep visual and semantic attractor neural networks predict fMRI pattern-information along the ventral object processing pathway. scientific reports, 2018, 8(1): 1-12

[4] Yang G.R., Joglekar M.R., Song H.F.. Task representations in neural networks trained to perform many cognitive tasks. Nat Neurosci, 2019, 22: 297–306

[5] Song H.F., Yang G.R., Wang X.J.. Training excitatory-inhibitory recurrent neural networks for cognitive tasks: a simple and flexible framework, 2016, 12(2): 1004792

[6] Guangyu Robert Yang, Xiao-Jing Wang. Artificial Neural Networks for Neuroscientists: A Primer. neuron, 2020, 107(6): 1048-1070

[7] Bi Z., Zhou C.. Understanding the computation of time using neural network models[J]. Proceedings of the National Academy of Sciences, 2020, 117(19): 10530–10540

Bi, Z., & Zhou, C. (2020). Understanding the computation of time using neural network models. Proceedings of the National Academy of Sciences, 117(19), 10530-10540.

Chen, Y., Wang, S., Hilgetag, C. C., & Zhou, C. (2017). Features of spatial and functional segregation and integration of the primate connectome revealed by trade-off between wiring cost and efficiency. PLoS computational biology, 13(9), e1005776.

Cole, J. H., & Franke, K. (2017). Predicting age using neuroimaging: innovative brain ageing biomarkers. Trends in neurosciences, 40(12), 681-690.

Devereux, B. J., Clarke, A., & Tyler, L. K. (2018). Integrated deep visual and semantic attractor neural networks predict fMRI pattern-information along the ventral object processing pathway. Scientific reports, 8(1), 10636.

Friedman, N., Ito, S., Brinkman, B. A., Shimono, M., DeVille, R. L., Dahmen, K. A., . . . Butler, T. C. (2012). Universal critical dynamics in high resolution neuronal avalanche data. Physical review letters, 108(20), 208102.

Goldstein, A., Zada, Z., Buchnik, E., Schain, M., Price, A., Aubrey, B., . . . Cohen, A. (2022). Shared computational principles for language processing in humans and deep language models. Nature neuroscience, 25(3), 369-380.

Klepl, D., Wu, M., & He, F. (2024). Graph neural network-based eeg classification: A survey. IEEE Transactions on Neural Systems and Rehabilitation Engineering.

Kriegeskorte, N., & Kievit, R. A. (2013). Representational geometry: integrating cognition, computation, and the brain. Trends in cognitive sciences, 17(8), 401-412.

Liang, J., Wang, S.-J., & Zhou, C. (2022). Less is more: wiring-economical modular networks support self-sustained firing-economical neural avalanches for efficient processing. National Science Review, 9(3), nwab102.

Liang, J., Yang, Z., & Zhou, C. (2024). Excitation–Inhibition Balance, Neural Criticality, and Activities in Neuronal Circuits. The Neuroscientist, 10738584231221766.

Softky, W. R., & Koch, C. (1993). The highly irregular firing of cortical cells is inconsistent with temporal integration of random EPSPs. Journal of neuroscience, 13(1), 334-350.

Song, H. F., Yang, G. R., & Wang, X.-J. (2016). Training excitatory-inhibitory recurrent neural networks for cognitive tasks: a simple and flexible framework. PLoS computational biology, 12(2), e1004792.

Wang, R., Lin, P., Liu, M., Wu, Y., Zhou, T., & Zhou, C. (2019). Hierarchical connectome modes and critical state jointly maximize human brain functional diversity. Physical review letters, 123(3), 038301.

Wang, R., Liu, M., Cheng, X., Wu, Y., Hildebrandt, A., & Zhou, C. (2021). Segregation, integration, and balance of large-scale resting brain networks configure different cognitive abilities. Proceedings of the National Academy of Sciences, 118(23), e2022288118.

Yang, G. R., & Wang, X.-J. (2020). Artificial neural networks for neuroscientists: a primer. Neuron, 107(6), 1048-1070.

斑图地址:https://pattern.swarma.org/study_group_issue/602

人类大脑是一个由数以百亿计的神经元相互连接所构成的复杂系统,被认为是「已知宇宙中最复杂的物体」。本着促进来自神经科学、系统科学、信息科学、物理学、数学以及计算机科学等不同领域,对脑科学、类脑智能与计算、人工智能感兴趣的学术工作者的交流与合作,集智俱乐部联合国内外多所知名高校的专家学者发起神经、认知、智能系列读书会第三季——「计算神经科学」读书会,涵盖复杂神经动力学、神经元建模与计算、跨尺度神经动力学、计算神经科学与AI的融合四大模块,并希望探讨计算神经科学对类脑智能和人工智能的启发。读书会从2024年2月22日开始,每周四19:00-21:00进行,持续时间预计10-15周,欢迎感兴趣的朋友报名参与,深入梳理相关文献、激发跨学科的学术火花!

详情请见:计算神经科学读书会启动:从复杂神经动力学到类脑人工智能